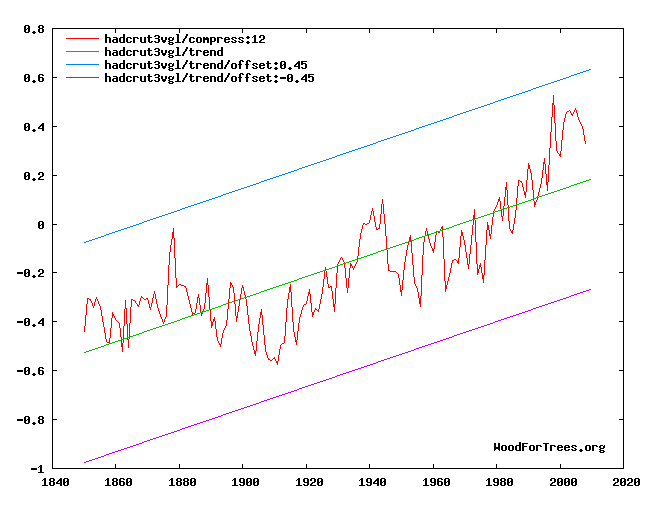

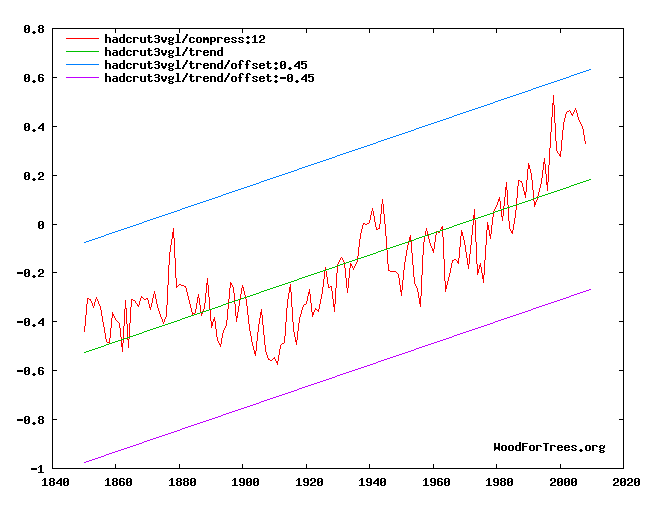

Fangen wir mit den Daten an. Die Abbildung unten zeigt die mittlere globale Temperaturanomalie in Grad Celsius vom britischen Hadley Center von 1850 bis 2008.

Abbildung 1: Die Entwicklung der mittleren Globaltemperatur nach dem Hadley Center In der Abbildung ist der lineare Erwärmungstrend dargestellt. Dieser fogt der Gleichung:

Linearer Erwärmungstrend ( °C) = 0,44*(2008-1850) /100 – 0,52

Betrachtet man die Grafik dann fällt einem auf, dass der lineare Erwärmungstrend der Globaltemperatur von der realen Temperaturentwicklung als „Oszillierendem Trend“ überlagert ist. Diese Oszillierende Temperaturanomalie bewegt sich oberhalb und unterhalb der linearen Anomalie und kann mit folgender Gleichung beschrieben werden:

Oszillierende Anomalie = Anomalie – Lineare Anomalie

Jetzt muss die Frage beantwortet werden, ob nach dem signifikanten Anstieg der CO2 Emissionen auch die Daten für die Temperaturanomalie einen Anstieg im Verlauf des letzten Jahrhunderts zeigen. Zur Beantwortung wenden wir uns zunächst den folgenden drei Fragen zu:

1. Wie sieht die lineare Erwärmung des letzten Jahrhunderts von 0,44 °C in 100 Jahren verglichen mit der linearen Erwärmung von vor 2 Jahrhunderten aus?

2. Ist die oszillierende Anomalie im letzten Jahrhundert, nach der Ausweitung des Gebrauchs fossiler Brennstoffe, ungewöhnlich?

3. Was ist der aktuelle Trend der globalen Temperaturanomalie?

1.) Wie sieht die lineare Erwärmung des letzten Jahrhunderts von 0,44 °C in 100 Jahren verglichen mit der linearen Erwärmung von vor 2 Jahrhunderten aus?

Direkte Temperaturmessungen vor 1850 sind nicht verfügbar. Daher werden Proxy-Daten herangezogen um die Erwärmung von 1810 bis 1910 wie in nachstehender Grafik aufzuzeichnen.

Abbildung 2: Die Temperaturanomalie vor 1910 nach Moberg et al. 2005

Der lineare Temperaturanstieg aus dieser Abbildung errechnet sich nach der Gleichung:

Linearer Erwärmungstrend ( °C) = 0,47(1910-1810)/100 – 0,63

Der lineare Temperaturanstieg von 0,47 °C in 100 Jahren von vor zwei Jahrhunderten ist also von ähnlicher Größenordnung wie die 0,44 °C in den letzten 100 Jahren. Es gab keine signifikante Änderung des linearen Trends in den letzten zwei Jahrhunderten. Ein Signal für CO2 als Ursache für den Temperaturanstieg kann demnach darin nicht gefunden werden.

2.) Ist die oszillierende Anomalie im letzten Jahrhundert, nach der Ausweitung der Nutzung fossiler Brennstoffe, ungewöhnlich?

Die lineare Erwärmung im letzten Jahrhundert zeigte kein Signal eines CO2-Einflusses. Wie sieht es aber mit der oszillierenden Anomalie aus? Gab es hier eine Veränderung, die durch CO2 Emissionen hervorgerufen wurde?

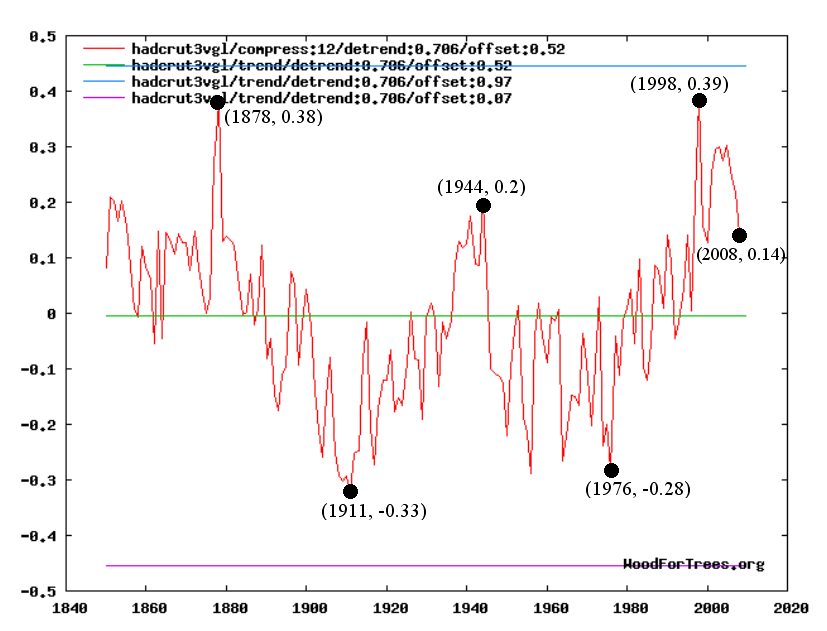

Um das zu untersuchen, entfernt man den linearen Erwärmungstrend aus der Auftragung der Temperaturanomalie durch die Funktion „Detrend“ (etwa in der Online-Software WoodForTrees.org). Ein Wert von DETREND=0,706 lässt diesen Trend verschwinden, was sich darin äußert, dass die Grafik im Uhrzeigersinn gedreht wird, so dass die lineare Steigung als flache Linie erscheint.

Abbildung 3 Oszillierende Temperaturanomalie in °C nach Daten des Hadley Centers

Diese Grafik zeigt die folgenden globalen Temperaturveränderungen:

• Abkühlung von 0,71 °C von 1878 bis 1911 (33 Jahre)

• Erwärmung von 0,53 °C von 1911 bis 1944 (33 Jahre)

• Abkühlung von 0,48 °C von 1944 bis 1976 (32 Jahre)

• Erwärmung von 0m67 °C von 1976 bis 1998 (22 Jahre)

Zusätzlich zu den oben angeführten Daten existieren auch in den Medien Berichte, welche die dargestellten Erwärmungs- und Abkühlphasen jeweils begleitet haben:

Globale Abkühlung 1878 bis 1911 New York Times (24. 02. 1895): Prospects of another Glacial Period Globale Erwärmung 1911 bis 1944:

New York Times (15. 05. 1932): Melting Polar Ice Caps to Raise the Level of Seas and Flood the Continents

Globale Abkühlung 1944 bis 1976: Newsweek (28. 04. 1975): The Cooling World.

Globale Erwärmung 1976 bis 1998 (Um nur eine Publikation stellvertretend zu nennen): Der Spiegel (11. 08. 1986): Das Weltklima gerät aus den Fugen (Mit dem mittlerweile legendären Kölner Dom unter Wasser)

Die hier angeführten globalen Abkühl- und Erwärmungs-Phasen werden auch in der wissenschaftlichen Literatur beschrieben, wie in folgendem Artikel von Dr. Nathan Mantua:

Several independent studies find evidence for just two full PDO [Pacific Decadal Oscillating] cycles in the past century: "cool" PDO regimes prevailed from 1890-1924 and again from 1947-1976, while "warm" PDO regimes dominated from 1925-1946 and from 1977 through (at least) the mid-1990’s (Mantua et al. 1997, Minobe 1997).

Abbildung 3 zeigt die oszillierende Anomalie von 0,39 °C für 1998 (das Super-El-Nino Jahr). Das ist die gleiche Größenordnung wie die im Jahr 1878 ermittelten 0,38 °C. Das zeigt deutlich, dass das Temperaturmaximum 1998, trotz der weiterverbreiteten Nutzung fossiler Brennstoffe, keine Ungewöhnlichkeit darstellt.

Um herauszufinden ob eine Verschiebung der globalen Durchschnittstemperaturen vorliegt, kann man einen Normalverteilungs-Plot für die oszillierende Temperaturanomalie aufzeichnen. Wenn in einem solchen Graphen die meisten Datenpunkte für die oszillierende Temperatur auf einer Geraden liegen, dann kann man von einer Normalverteilung sprechen.

Abbildung 4: Normalverteiluns-Analyse für die oszillierende Temperaturanomalie

Wie diese Abbildung zeigt, liegen die meisten Datenpunkte der oszillierenden Temperaturanomalie auf einer geraden Linie, und das mit einem äußerst guten Korrelationsfaktor von 0,9923. Nur zwei Datenpunkte, 1911 und 1909, sind Ausreißer die eine Verschiebung der Temperatur von der Normalverteilung zeigen. Allerdings liegt diese Verschiebung weit vor der Zeit, bevor die Nutzung fossiler Brennstoffe überhaupt richtig begann und eine ähnliche Abkühlung fand auch in den 70er Jahren statt. Diese Abweichung hat somit höchstwahrscheinlich nichts mit einem CO2-Einfluss zu tun.

Bei der beobachteten Normalverteilung der oszillierenden Temperaturanomalie ist es möglich, die obere und untere Grenze der Normalverteilung zu errechnen. Die Umkehrfunktion der Steigung der Gerade in der Normalverteilung entspricht dabei der Standardabweichung s. Daraus ergibt sich aus Abbildung 4: s = 1/6,6 = 0,15 °C. Bei der oszillierenden Temperaturanomalie bewegen sich 99,73% aller Daten innerhalb von ± 3 s = ± 0,45 °C. Dieser obere und untere Grenzwert schließt sämtliche Werte für Temperaturanomalien von 1850 bis 2008 ein, wie Abbildung 3 eindeutig zeigt.

Wie man der Temperaturentwicklung von 159 Jahren in Abbildung 3 entnehmen kann, bewegt sich die Globaltemperatur zwischen -0,32 °C und +0,4 °C, was einer Differenz von 0,72 °C entspricht. Als Ergebnis daraus stellt eine Erhöhung der Temperatur von -0,32 °C auf +0,4 °C oder eine Abkühlung um den gleichen Betrag die natürliche Variabilität der globalen Durschnittstemperaturen dar. Zusätzlich zu diesen oszillierenden Temperaturen gibt es eine lineare globale Erwärmung von

0,44 °C in 100 Jahren.

In Abbildung 4 befinden sich sämtliche Temperaturen auf der rechten Seite (diese bedeuten globale Erwärmung) auf einer geraden Linie. Demnach gibt es keine Veränderung in der globalen Erwärmung. Kein CO2-Signal ist auszumachen.

3.) Was ist der aktuelle Trend der globalen Temperaturanomalie?

Bei der hier gezeigten Normalverteilung der oszillierenden Temperaturanomalien beträgt die Wahrscheinlichkeit für einen Wert über dem Maximalwert von 1998 weniger als 1%. Der weitaus wahrscheinlichere Fall ist das Beibehalten des historischen Musters und des gegenwärtigen Trends. Sollte sich der in Abbildung 3 gezeigte Trend einer 33 jährigen Abkühlung (nach 1878 und 1944) auch diesmal wiederholen, wäre eine Fortsetzung der Abkühlung für die nächsten 22 Jahre, also bis 2031, zu erwarten. Dabei würden die Temperaturen wieder auf Werte ähnlich denen in den 70er Jahren zurückgehen, also den Anstieg der letzten drei Jahrzehnte weitestgehend rückgängig machen.

Das das Maximum der Oszillation gerade 1998, also am Ende des Jahrhunderts auftrat, kann man durchaus als unglücklichen Zufall bezeichnen. Hätte sich die Oszillation 1998 auf einem Minimum befunden wie im Jahr 1911 (mit -0,33 °C) befunden, wäre kein signifikanter Anstieg der Temperatur über das Jahrhundert beobachtbar gewesen (0,44 °C – 0,33 °C = +0,11 °C). Je nachdem, ob wir uns am Ende eines Jahrhunderts in einer Maximum oder Minimum Phase der Oszillation befinden, können wir also +0,83 °C (0,44 °C + 0,39 °C) beobachten, oder kaum irgendeine Erwärmung.

In der Wissenschaft geht es um die Daten, Wissenschaft ist nicht Konsens oder Autorität.

Die lineare globale Erwärmung im letzten Jahrhundert war absolut vergleichbar mit der Erwärmung im vorletzten Jahrhundert. Die oszillierende Erwärmung von 0,67 °C zwischen 1976 und 1998 ist ebenso natürlich wie die Abkühlung von 1878 bis 1911, die einen ähnlichen Wert (0,71 °C) erreichte. Abbildung 4 zeigt keine außergewöhnliche Erhöhung der globalen Durchschnittstemperatur die man auf CO2 zurückführen könnte. Es gibt sie nicht. Eine CO2-induzierte globale Erwärmung kann durch die Daten nicht gezeigt werden.

Girma Orssengo, MASc, Ph.D. für American Thinker – Die Bearbeitung und Übersetzung besorgte Rudolf Kipp EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Die Klimakatastrophe gibt es nicht!

sie ist seit 9 jahren beendet, es wird wieder kälter!

Hallo Herr Hess,

gucken Sie im IPCC Ar4 WG1 report. Da gibt es ein paar Bilder mit den Vergleichen (inkl. 5%-95%- Bereichen) mit und ohne anthropogenes Signal. Die Referenzen dazu müssen auch aufgelistet sein. Da wird jedoch viel modelliert. Ob nun auch viele Modelle mit/ohne ausschließlichem anthropogenen CO2 gerechnet wurden, weiß ich nicht. Meistens läßt man auch noch das anthropogene SO4 weg.

Zweitens ist die Frage, wie Sie die Abweichungen mit/ohne quantitizieren. Sie hätten ja gerne den linearen Trend ausgedröselt. Aber dies ist ja eine schlechte Näherung an den Temperaturverlauf über 150 Jahre. Eigentlich müssten Sie sowas wie die spektrale Temperaturamplitude mit/ohne vergleichen, da die Klimaprozesse ja auf unterschiedlichen Zeitskalen wirken.

Lieber Herr NB,

sie schreiben als Antwort auf Herrn Kowatsch #1:

„Das folgt jedoch nicht logisch auf den obigen experimentellen Feststellungen. Ich wie schon öfter betont, basiert das wissenschaftliche Argument auf sehr viel mehr, als nur ein Demoversuch und ein paar Formeln.“

Können sie den die Hauptargumente skizzieren, die diese Frage beantworten:

Wie groß war der Anteil des CO2, gemessen in Kelvin, an der Temperaturerhöhung von ca. 0.8K im 20 Jahrhundert? Ich würde aber gerne die Zahl in Kelvin mit Fehlerbalken wissen und ein „Peer-Reviewed“ paper, dass die Methode erklärt, wie diese Zahl zustande kommt.

Mit freundlichen Grüßen

Günter Heß

Lieber Herr NB,

das Paper von Lean und Rind (GRL 08) hat man mir bisher als einziges Paper zitiert auf meine Frage:

—Wie groß war der Anteil des Menschen, gemessen in Kelvin, an der Temperaturerhöhung von ca. 0.8K im 20 Jahrhundert? Ich würde aber gerne die Zahl in Kelvin mit Fehlerbalken wissen und ein „Peer-Reviewed“ paper, dass die Methode erklärt, wie diese Zahl zustande kommt.—

Das Paper von Hegerl et al ist dasjenige auf das sich Prof. Latif in seinem Buch: Klimawandel und Klimadynamik auch hauptsächlich bezieht, als eines von 3 Argumenten, wenn es darum geht den anthropogenen Anteil an der Erwärmung zu zeigen.

JHetzt schreiben sie nicht besonders aussagekräftig. Argument 2 ist die Aussage, dass die Klimamodelle ohne anthropogenen Einfluß nicht die Erwärmung im 20. jahrhundert simulieren können.

Und Argument 3, dass sich die Stratosphäre abkühlt.

Ob das nun aussagekräftiger ist lasse ich dahingestellt.

Wo soll denn der Laie noch überall nachlesen? Wo hat den die Klimawissenschaft ihre Argumente und Methoden versteckt?

Können sie mir bitte sagen welche Paper oder Bücher aussagekräftig sind? Eigentlich müssten sie ja welche haben?

Mit freundlichen Grüßen

Günter Heß

Hallo Herr Kowatsch,

„Die Schlußfolgerung bleibt immer dieselbe: Den Treibhauseffekt gibt es, er ist rechnerisch nachvollziehbar, im Langzeitversuch jedoch nur bei 100%C02 im Vergleich zu Luft beweisbar. “

Ergänzung: als Demoversuch mit einfachen Instrumenten.

„Er führt jedoch bei den irdischen Konzentrationsverhältnissen zu keinem Effekt,…“

Das folgt jedoch nicht logisch auf den obigen experimentellen Feststellungen. Ich wie schon öfter betont, basiert das wissenschaftliche Argument auf sehr viel mehr, als nur ein Demoversuch und ein paar Formeln.

Ich kann es immer noch nicht nachvollziehen, warum es so schwierig ist, zu akzeptieren, dass manche Wissenschaft schwierig ist und eben nicht ohne weiteres „demonstrierbar“ ist. Oder ist das Ihr Motto, alles abzulehnen, was nicht auf einem Experimentiertisch gezeigt werden kann? Überlegen Sie mal, was Sie dann alles als Nichtexistent oder Nichtrelevant einordnen müssten. Ich denke, so würden Sie noch nicht mal die Existenz des Planeten Pluto akzeptieren können.

Hallo Herr Hess,

die von Ihnen genannten paper von Hegerl und Lean/Rind finde ich alleine betrachtet auch nicht besonders aussagekräfig. Wobei bei diesen papern ja noch die Physik eine gewisse „Mustervorlage“ bietet.

Lieber Herr NB,

Da #2 ist meines Erachtens mit zweierlei Maß gemessen.

Was machen den Lean und Rind (GRL 2008) anders als mit einem „Statistik Programm rumspielen“ wenn sie ihre Korrelationsmethode anwenden. Oder was haben Hegerl e al 1997 mit ihrer „Optimal Fingerprint“ Methode gemacht als sie statistisch den anthropogenen Treibhauseffekt nachgewiesen haben?

Das können sie immer mit ihrem Satz diskreditieren. Steve McIntyre zeigt übrigens sehr schön, dass einige Wissenschaftler eben auch nur mit Statistikprogrammen rumspielen, wie sie das so schön ausdrücken.

Mit freundlichen Grüßen

Günter Heß

„Eine CO2-induzierte globale Erwärmung kann durch die Daten nicht gezeigt werden.“

Richtig, aber das behauptet ja auch keiner, der sich damit auskennt.

Dazu ist schon ein bisschen mehr know-how nötig als nur mit einem Statistik-Programm zu herumzuspielen. Ich kenne das, da kann man schön mit Daten spielen, und wenn man dann noch über mathematische Kenntnisse zur Statistik verfügt, kann man die Ergebnisse auch noch interpretieren. Das reicht jedoch nicht, um Ergebnisse zu wiederlegen, die auf ganz anderen Analysen beruhen und viel mehr auf Details der physikalischen Prozesse basieren.

„Eine durch C02-induzierte globale Erwärmung kann durch die Daten nicht gezeigt werden,“ lautet der Schlußsatz des obigen Reports.

Doch ergänzen wir den Artikel. Eine durch C02-induzierte Erwärmung kann durch keinen realistischen Langzeitversuch gezeigt werden. Ich kenne auch keinen größeren Feldversuch, wahrscheinlich wurde er schon durchgeführt, brachte aber auch keine Erwärmung bei Verdopplung der C02-Konzentration auf über 700ppm.

Die Schlußfolgerung bleibt immer dieselbe: Den Treibhauseffekt gibt es, er ist rechnerisch nachvollziehbar, im Langzeitversuch jedoch nur bei 100%C02 im Vergleich zu Luft beweisbar. Er führt jedoch bei den irdischen Konzentrationsverhältnissen zu keinem Effekt, deswegen wird der Treibhauseffekt als Hauptursache einer globalen Erwärmung überbewertet. Die Erwärmungen der letzten 25 Jahre haben somit andere Hauptursachen. Ganz egal welche, Hauptsache es wird wärmer, denn die Kleine Eiszeit war die Klimakatastrophe.