Sie machen genau das, was der Journalist H. L. Mencken zu Beginn des vorigen Jahrhunderts geschrieben hatte: „Der gesamte Sinn der Politik ist es, die Öffentlichkeit in Furcht zu halten (und in ihr folglich den Wunsch zu wecken, in Sicherheit gebracht zu werden). Erreicht werden soll dies mit einer endlosen Reihe von Klabautermännern – allesamt imaginär“.

Die Angstmache vor der vom Menschen verursachten Klimaänderung kann gut und gern der beste Klabautermann sein, der je erweckt worden ist. Sie hat in der Hälfte der Welt den Wunsch geweckt, in Sicherheit gebracht zu werden – vor einer Bedrohung, für die es nicht den geringsten physikalischen Beweis gibt! Absolut nichts spricht dafür, dass Klima-Fluktuationen und Wetterereignisse von heute anders geartet oder schlimmer sind als das, womit es unsere Vorfahren zu tun hatten – und auch nicht für den Menschen als Ursache.

Viele der Aussagen zur Stützung dieser Angst erzeugenden Behauptungen finden sich im U.S. Fourth National Climate Assessment, einem 1656 Seiten starken Report, veröffentlicht Ende November. Keine einzige der dort erhobenen Behauptungen hat irgendeinen Bezug zu Beobachtungen in der realen Welt. Alles, was diese Behauptungen stützt, sind mathematische Gleichungen, welche als exakt präsentiert werden, als zuverlässige Modelle des Klimas der Erde.

Es ist wichtig, diese Modelle vollständig zu verstehen, sind sie doch die einzige Grundlage für die Klima-Angst!

Vor der Konstruktion von Gebäuden oder Flugzeugen werden physikalische, kleinmaßstäbliche Modelle entwickelt, um sie Stress- und anderen Tests zu unterziehen, welchem sie nach dem tatsächlichen Bau ausgesetzt sind. Hat man es mit Systemen zu tun, die großenteils (oder gänzlich) außerhalb unserer Kontrolle liegen – wie etwa Klima – versuchen wir, diese mit mathematischen Gleichungen zu beschreiben. Mittels Veränderung der Variablen in diesen Gleichungen kann man erkennen, wie sehr sich diese Veränderungen auf das Ergebnis auswirken. Das nennt man Sensitivitäts-Test, die beste Anwendung mathematischer Modelle.

Allerdings beschreiben die heutigen Klimamodelle nur eine Handvoll der hunderte von Variablen, von welchen man weiß, dass sie sich auf das Erdklima auswirken, und viele der für die Variablen eingesetzten Werte sind kaum mehr als Raten. Dr. Willie Soon vom Harvard-Smithsonian Astrophysics Laboratory listet die sechs bedeutendsten Variablen in jedwedem Klimamodell:

1) Orbitale Dynamik des Systems Sonne ↔ Erde sowie deren relative Stellungen und Bewegungen hinsichtlich der anderen Planeten des Sonnensystems

2) Abstrahlung geladener Partikel von der Sonne (Sonnenwind) und Modulation der einfallenden kosmische Strahlung aus der Galaxie als Ganzes

3) Das Klima beeinflussende Wolken, welche sowohl einfallende Sonnenstrahlung blockieren als auch einen geringen Teil der Wärme einfangen

4) Verteilung des von der Atmosphäre und nahe der Erdoberfläche empfangenen Sonnenlichtes

5) Die Art und Weise, mit der Ozeane und Landmassen die einfallende Sonnenstrahlung speichern, beeinflussen und verteilen

6) Die Reaktion der Biosphäre auf all diese verschiedenen Klimatreiber.

Soon folgert, dass selbst wenn die Gleichungen zur Beschreibung dieser interaktiven Systeme bekannt und angemessen in den Computermodellen enthalten wären (was sie nicht sind), diese auch dann immer noch nicht in der Lage sind, die Zukunft in irgendeiner bedeutenden Weise zu simulieren. Grund hierfür ist, dass selbst die besten Super-Computer der Welt viel zu lange brauchen würden, das zukünftige Klima zu berechnen als es sich in der realen Welt aufzeigen würde.

Das heißt, wir könnten das Klima (oder die vielen Sub-Klimate der Erde) für 40 Jahre von heute an in die Zukunft berechnen, aber es würde über 40 Jahre dauern, bis die Modelle mit diesen Berechnungen fertig wären.

Obwohl Regierungen über hundert Bemühungen finanziert haben, das Klima über drei Jahrzehnte zu modellieren, hat nicht eines dieser Modelle die bekannte Vergangenheit korrekt „prophezeit“ (nachhergesagt). Ausnahme ist ein russisches Modell, welches vollständig „frisiert“ war, um zu den gemessenen Daten zu passen, was zufällig dann auch der Fall war. Die mittlere Prophezeiung liegt jetzt ein ganzes Grad Fahrenheit über dem, was Satelliten und Wetterballone tatsächlich gemessen haben.

In seiner Anhörung vor dem Committee on Science, Space & Technology des Repräsentantenhauses am 2. Februar 2016 verglich der Klimatologe Dr. John Christy von der University of Alabama-Huntsville die Ergebnisse der atmosphärischen Temperaturen, wie sie im Mittel von 102 Klimamodellen berechnet worden waren, mit Messungen von Satelliten und Ballonen. Er sagte: „Diese Modelle scheiterten schon bei dem einfachen Test, uns zu sagen, was bereits geschehen ist, und sind folglich nicht in der Lage, uns eine vertrauenswürdige Antwort zu geben auf die Frage, was in Zukunft passieren könnte und warum. Als solche sind die Modelle also von höchst fragwürdigem Wert als Grundlage für weit reichende politische Entscheidungen, die doch abhängig sein sollten von einem halbwegs sicheren Verständnis, wie das Klimasystem funktioniert“.

Als Christopher Monckton das IPCC-Verfahren einer Nachprüfung unterzog, zeigte er in einer im Bulletin of the Chinese Academy of Sciences* veröffentlichten Studie im Jahre 2015 überzeugend, dass die offiziellen Prophezeiungen bzgl. globaler Erwärmung um das Dreifache übertrieben worden waren. (Monckton ist mehrfach für seine Arbeiten bzgl. Klima ausgezeichnet worden).

[*Dieses chinesische Journal war anders als alle angesprochenen Journale in der westlichen Welt bereit, die Studie zu veröffentlichen! Anm. d. Übers.]

Die Studie ist 12 mal öfter heruntergeladen worden als jede andere Studie in der gesamten, 60 Jahre umfassenden Historie jenes angesehenen Journals. Moncktons Team bedeutender Klimawissenschaftler legt jetzt letzte Hand an eine Studie, welche definitiv beweist, dass es – entgegen der offiziell prophezeiten Erwärmung um 3,3°C pro Verdoppelung des CO2-Gehaltes – lediglich zu einer solchen von 1,1°C kommen würde. An einem entscheidenden Punkt ihrer Berechnungen haben die offiziellen Klimatologen schlicht und ergreifend die Tatsache außen vor gelassen, dass die Sonne scheint!

Alle Probleme können als 5-phasig betrachtet werden: Beobachtung, Modellierung, Prognose, Verifikation und Validierung. Der Meteorologe Tom Wysmuller vom Apollo Team erklärt: „Zur Verifikation gehört es zu überprüfen, ob die Prognosen tatsächlich eintreffen, und zur Validierung gehört es zu überprüfen, ob die Prognose irgendetwas anderes ist als eine zufällige Korrelation. Die jüngste CO2-Zunahme, die mit der Erwärmung des industriellen Zeitalters korreliert, ist ein Beispiel für eine Zufalls-Korrelation, das einem sofort in den Sinn kommt“.

Der Präsident des Science and Environmental Policy Project (SEPP) Ken Haapala schreibt: „Die globalen Klimamodelle, auf die sich das IPCC und das USGCRP (United States Global Change Research Program) verlassen, sind weder verifiziert noch validiert“.

In kein Klimamodell, auf das sich das IPCC stützt, hat man die Ausgangsbedingungen des Jahres 1900 eingegeben und die ,Staubschüssel-Jahre‘ der dreißiger Jahre in den USA vorhergesagt – geschweige denn eine genaue Prognose des Klimas im Jahre 2000 oder 2015. Angesichts des vollständigen Fehlens überprüfbarer Ergebnisse müssen wir folgern, dass diese Modelle mehr mit dem Spiel „Magic 8 Ball“ gemeinsam haben als mit irgendeinem Prozess auf wissenschaftlicher Grundlage.

Nun ist eines der aktivsten Bereiche mathematischer Modellierungen der Aktienmarkt, aber niemand hat jemals dessen Entwicklung genau vorhersagen können. Viele Jahre lang wählte das Wall Street Journal fünf bedeutende Ökonomie-Analysten, die eine Aktie wählen sollten, welche ihrer Ansicht nach im folgenden Monat im Wert steigen würde. Dann ließ das Journal einen Schimpansen fünf Pfeile auf eine Wand werfen, die überzogen war mit den Ergebnissen des Aktienmarktes an jenem Tag. Einen Monat später wurde ausgewertet, wer besser war: Analysten oder Schimpanse. Gewöhnlich gewann der Schimpanse.

Aus diesem und anderen Gründen waren die meisten Menschen bis vor Kurzem dumm genug, um Entscheidungen zu treffen auf der Grundlage von Prophezeiungen, welche abgeleitet waren aus Gleichungen, die vermeintlich beschrieben, wie die Natur oder die Wirtschaft funktionieren.

Und doch behaupten die Computer-Modellierer unserer Tage, dass sie das Klima modellieren können – wobei weitaus mehr Variablen eine Rolle spielen als in der Wirtschaft oder beim Aktienmarkt – und dass sie das Jahrzehnte oder sogar ein Jahrhundert in die Zukunft können. Dann sagen sie Regierungen, politische Entscheidungen im Wert von Billionen Dollar zu treffen, welche jeden Aspekt unseres Lebens berühren – nur aufgrund der Ergebnisse ihrer Modelle. Unglaublicherweise folgen die UN und Regierungen in aller Welt diesen Forderungen. Wir sind verrückt und dumm, wenn wir sie damit davonkommen lassen!

Dr. Jay Lehr is the Science Director of The Heartland Institute which is based in Arlington Heights, Illinois. Tom Harris is Executive Director of the Ottawa, Canada-based International Climate Science Coalition.

Link: https://wattsupwiththat.com/2019/01/29/mathematical-modeling-illusions/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"@ Rico Schrage:

Wer lesen kann ist klar im Vorteil: Dr. Jay Lehr und Tom Harris sind die Autoren des Artikels. Chris Frey hat den Artikel übersetzt.

Uran reicht noch für mehrere 1000 Jahre, siehe hier. Von Thorium ganz zu schweigen.

Die Quellen sind zwischen 8 und 12 Jahren alt. Zudem sind die Verbrauchszahlen veraltet. Dadurch lassen sich mindestens schon mal 20 Jahre abziehen. Andere Studien kommen zu noch kürzeren Ergebnissen.

Das Problem wird nicht die Rohstoffmenge sein, sondern deren Abbau. Aktuell wird nur halb so viel gefördert wie verbraucht. Wiederaufbereitung macht vielleicht 6% des Gesamtbedarfs aus, weitere Anlagen zur Kapazitätssteigerung gibt es nicht. Innerhalb der nächsten 4 Jahre müssen sich die Bergbaukapazitäten verdoppeln, was bereits eine immense Leistung wäre.

Kugelhaufenreaktor ist gescheitert, Thoriumreaktoren gibt es noch nicht einmal einen Prototypen. Einen effektiv arbeitenden Schnellen Brüter gibt es nur in Russland, alle anderen Ländern ihre Projekte wegen gravierender Sicherheitsproblemen beendet. Zu was ein AKW in russischen Händen fähig ist, kennen wir seit 1986. Was passiert, wenn ein Schneller Brüter mit Plutonium als Brennstoff auf die gleiche Weise hochgeht, möchte ich mir nicht ausmalen.

Lieber Herr Schrage,

Merke: Der Mix der Weltenergienutzung – Stand 2017 – zeigt:

Kohle, Erdöl, Erdgas: 85,..%; Wasserkraft: 7,..%; Kernenergie: 4,..%; Wind, Sonne: 2,..%; Geothermie, Biomasse: 1,..%.

Fracking nimmt zum Glück den Zeitdruck vom stetig fortschreitenden Ausbau der Kernenergie.

Ein Tsunami in Fukushima hat sehr viele Menschen getötet, drei völlig zerstörte KKW haben dazu nicht beigetragen!

Der bedauerliche Unfall in Tschernobyl konnte nur deshalb in einer zur Herstellung von Plutonium für Bomben (daher unverzichtbar ohne Sicherheitseinschluss) konstruierten Maschine geschehen, weil ohne erforderliche Umrüstung die Herstellung von Plutonium eingestellt worden war! (Stromerzeugung diente ursprünglich primär der Senkung der Bombenkosten!)

MfG

Mit der Modellierbarkeit des Klimas mittels mathematisch-physikalischer Klimamodelle ist es noch wesentlich schlimmer als im Beitrag beschrieben. Es ist prinzipiell unmöglich, die zukünftige Entwicklung des Klimas zu modellieren, d.h. es ist nicht primär eine Frage der Rechenleistung. Auch die Rechner der Zukunft werden dazu nicht in der Lage sein! Das wird auch in einem Anhang eines IPCC-Berichtes ausgesagt, wird aber gern ignoriert. Schon bei historischen Versuchen mußte man feststellen, daß es nicht geht: In den 1960er Jahren hat Edvard N. Lorenz bei der Untersuchung von Strömungsproblemen die Chaostheorie wesentlich vorangebracht (siehe Lorenz-Attraktor). Er mußte feststellen, daß eine sehr geringfügige Änderung der Anfangsbedingungen oder der Rechengenauigkeit zu völlig anderen Ergebnissen führt (berühmter Schmetterlingschlag in Australien, der ausreicht, ein anderes Wetter zu provozieren). Aus diesem Grunde ist auch eine Wettervorhersage für mehr als etwa 3 Tage im voraus nicht möglich, oft ist der zuverlässige Vorhersagezeitraum noch kürzer. Übrigens ist unsere physikalische Welt in fast allen Bereichen chaotisch. Auch die Planetenbewegung ist streng genommen chaotisch, aber erst nach vielen Millionen Jahren schlägt das Chaos unerbittlich zu, d.h. es sind dann keine sinnvollen Berechnungen mehr möglich. Obwohl über einen Zeitraum von mehreren tausend Jahren noch sehr genaue Berechnungen möglich sind. Das hat übrigens bereits Henri Poncaré Ende des 19. Jahundert postuliert, obwohl ihm noch keine Computer zur Verfügung standen. Er ist somit der Urvater der Chaostheorie. Wie groß der zuverlässige Vorhersagezeitraum für ein physikalisches System ist hängt von der Stärke der (nichtlinearen) Rückkopplungen ab. Aber ich will die Entwickler von Klimamodellen nicht um ihr Brot bringen…

Mit anderen Worten: Je mehr sich die Realität nach mathematischen Modellen zu richten hat, desto mehr Energie wird dafür benötigt. Steigt deshalb der Energiebedarf der Mensch kontinuierlich an?

Eine Frage, die ich mangels Wissen nicht beantwortet kann: Laut Klimamodelberechnung führt eine Verdoppelung des CO2 zu einem Temperaturanstieg von 3,3 Grad, das heißt, ein exponentieller Anstieg des CO2 bewirkt eine lineare Temperaturerhöhung. Wenn ich das so richtig verstanden habe, würde eine 5malige Verdopplung des CO2 zu einem Temperaturanstieg von 16,5 Grad führen. Einer 5maligen Verdopplung eines CO2 von 300 ppm entspricht ein Wert von 9.600 ppm. Nach meinen Kenntnis war die CO2-Konzentration in der Urathmosphäre 10.000. War damals die Erdtemperatur 16,5 Grad wärmer als heute? Hat es in der Vergangenheit einen linearen Temperaturabfall bei Halbierung der CO2-Konzentration gegeben?

10.000 Po entsprechen 1%, die Urathmoshäre hatte 15%, also 150.000 ppm. Da müsste die Erde schon so warm gewesen sein wie die Venus.

Reiner Unsinn der lineare Anstieg durch Verdoppelung. Es kann mir auch keiner weiss machen, dass eine Verdoppelung von 1auf 2 ppm die gleiche Wirkung haben soll, wie die Verdoppelung von 50% auf 100%.

„Es ist wichtig, diese Modelle vollständig zu verstehen, sind sie doch die einzige Grundlage für die Klima-Angst!“

Ist das Kind dann nicht bereits in den Brunnen gefallen? – Die Statistik der Geschichte des beobachteten Wetters definiert das Klima. Modelle, die wahrscheinliche Wetteränderung für wenige Tage liefern können, erfordern eine Kombination von Beobachtung und Mathematik. – Dem Physiker genügt dieser Sachverhalt, um die sog. Klimamodelle in die „Science Fiction“ Literatur einzuordnen.

Einige Hinweise erklären beispielhaft die Gründe.

Naturgesetze gelten nicht für Mittelwerte: – Aus zwei flächengleichen Wolken in unterschiedlicher Höhe emittieren z.B. H2O Partikel bei -30 Grad C 198 W/m^2 und bei +10 Grad C 364 W/m^2, im Mittel also eine korrekt ermittelte Gegenstrahlung von 281 W/m^2. Rechnet dagegen das Modell mit der mittleren Temperatur von -10 Grad C sind es nur 271 W/m^2.

Das energetische Gleichgewicht gab es noch nie in der Klimageschichte. Auch während der letzten 12000 Jahren sorgt (immer noch) eine positive Energiebilanz für steigende Temperaturen und Meeresspiegel!

Den dominanten Einfluss der Speicherzeit der Solarenergie sucht man ohnehin vergeblich:

https://de.scribd.com/document/391176117/Erderwarmung-Treibhauseffekt-und-Zeit-CO2-ist-klimaneutral?fbclid=IwAR3BcwG4ENNxnqFUqybsUEQgeNBpbXe9KkW7FVU2ntykgJo1hR4wkdFMKZo

Der Autor legt eine Studie vor, die einen Temperaturanstieg um 1,1°C durch die Verdopplung des CO2 beweist. Kann man nun annehmen, dass der Autor im Grunde nach zustimmt, dass CO2 als Treibhausgas wirkt? 😉

… und was „würde“ uns das sagen? Europa steuert bis 2050 sagenhafte 0,1° bei, falls:

alle ADO´s, NAO´s, El Ninio´s u. El Nina´s, PDO´s, Vortex, Kältewellen, Hitzewellen, Jetstreams, Wolken, Sonnenzyklen, Permafrostböden, angeblich gespeicherte Ozeanwärme ala Resplandy, Eisbedeckungen der Arktis, einschlafende Golfströme, kosmische Strahlungen, sinkende Inseln, zitternde CO2 Doppelbindungen, Wasserdampf-Konzentrationen, Evaporationen, Konvektionen, Albedos, negative u. positive Rückkopplungen, Wärme-Insel-Effekte, Vulkanausbrüche, schmelzende Eispanzer auf Grönland, abbrechende Eisschilde der Ostantarktis, Zirkumpolarströme, Rekordwinter u. Dürresommer, zunehmende Starkniederschläge und alles zermalmende Stürme, alles 100%ig menschengemachte, zu 97% kommittede, von Klimaleugnern geleugnete, peer reviewedte, bald in Gesetze gegossene, von theoretischen Physikern erdachte, von Programmen erschaffene, die Menschheit verschlingende

Klimakatastrophe sich an das hält, woran wir glauben sollen! Und wenn nicht, dann..

„…haben sie dich genauso belogen, wie sie es heute mit uns bereits tun.

Und du hast ihnen alles gegeben, deine Kraft, deine Jugend, dein Leben!“

Dass EIKE einräumt, dass CO2 effektiv ein Treibhausgas ist, welches in der Lage ist, die Erde zu erwärmen.

Man würde wenigstens diesen unsäglichen „2. Hauptsatz der Thermodynamik“ Spinnen den Wind aus den Segeln nehmen, die felsenfest behaupten, es könne keinen CO2 geriebenen Treibhauseffekt geben, weil es angeblich keinerlei Energieübertragubg von kalten zu warmen Objekten gibt.

Herr Schrage, mir scheint, Sie haben nicht ansatzweise verstanden, was unabhängige Wissenschaft bedeutet. Im Gegensatz zur offiziellen Klimawissenschaft, vertritt EIKE keine bestimmte Ideologie. Es gibt bei EIKE Wissenschaftler, die glauben, dass CO2 ein Treibhausgas ist, andere meinen, es hat keine Wirkung auf die Temperatur, während wiederum andere behaupten, dass CO2 kühlt. EIKE ist eine heterogene Gruppe von Wissenschaftlern, die alle frei ihre Meinung äußern dürfen. Insofern kann EIKE auch nichts einräumen, sondern höchstens einzelne Wissenschaftler.

Der Irrsinn bei dieser ganzen Problematik ist doch, dass selbst wenn CO2 temperaturerhöhend wirken würde, dies alles andere als bedrohlich wäre und selbst wenn es bedrohlich wäre, die geforderten Maßnahmen (Wind und PV) nicht ansatzweise eine nennenswerte CO2-Reduktion bewirken würden. Vielmehr müsste man massiv auf Kernenergie setzen.

Das klingt nicht danach, als wenn EIKE ideologiefrei ist, oder? Der Autor dieses Artikels ist Chris Frey, ein Schriftsteller und Übersetzer, der sich in seinem Blog selbst als „Laie“ bezeichnet. Kein Wissenschaftler.

Nicht möglich. Und zwar nicht aus moralischen Gründen, sondern ganz praktisch gesehen. Aktuell beträgt der Uranbedarf 68.000t, die Förderung aber nur 35.000t, der Rest wird aus Lagerbeständen und Wiederanreicherung beschafft, die allerdings 2023 aufgebraucht sind. Wenn alle Kohlekraftwerke durch Atomkraftwerke ersetzt werden, müsste man die Anzahl der Atomkraftwerke verdreifachen, den Abbau von Uran versechsfachen. Das ist einfach nicht drin. Zudem wäre dann so gut wie sämtliches verwertbares Uran bis 2045 aufgebraucht.

Rico Schrage schrieb am7. Februar 2019 um 23:36

Das ist die Position des Fachbeirates, die hier von den Kommentatoren hier gern ignoriert wird. Das entbehrt vor allem dann nicht einer gewissen Ironie, wenn die Kommentatoren Leute, die das auch denken, als unfähig oder schlimmeres darstellen.

„Vor der Konstruktion von Gebäuden oder Flugzeugen werden physikalische, kleinmaßstäbliche Modelle entwickelt, um sie Stress- und anderen Tests zu unterziehen, welchem sie nach dem tatsächlichen Bau ausgesetzt sind. Hat man es mit Systemen zu tun, die großenteils (oder gänzlich) außerhalb unserer Kontrolle liegen – wie etwa Klima – versuchen wir, diese mit mathematischen Gleichungen zu beschreiben. “

Auch im Flugzeugbau wird mit Simulationen gearbeitet. Die Aerodynamik von jedem Teil wird durch Simulation überprüft, um Zeit und Kosten für den Windkanal zu sparen. Damit wird aber nur „eine Entwicklung in einer ungünstigen Richtung“ im Voraus aussortiert. Kein Teil geht in Serienproduktion, dass nicht vorher in der Wirklichkeit des Windkanals überprüft wurde.

Es ist grundsätzlich, dass eine Simulation immer eine virtuelle Umschreibung ohne reellen Wert ist. relevant werden Simulationen nur dann, wenn die Simulationen regelmäßig mit der Wirklichkeit überprüft werden. Bei Klimasimulationen ausgeschlossen, man erlebt das Ergebnis nicht.

Der Fehler liegt, neben den beschriebenen fehlenden Variablen, sondern auch im Auge des Betrachters: Eine Simulation ohne Wirklichkeitsvergleich ist eine reine Spekulation!

Mathematik soll ja die Sprache sein, die die ganze Welt versteht. Blöd nur, dass Natur schon immer ganz ohne Mathematik und Zahlenspielereien ausgekommen ist. Das Problem der Mathematik zeigt sich schon in der einfachsten aller Rechnungen: 1 + 1 = 2

Wo gibt es von Natur aus exakt zwei gleiche Dinge, die zugleich den exakt selben Platz belegen, damit die Rechnung stimmt? Ergo führt jede Rechnung zu Missverständnissen. Umso mehr, je mehr gerechnet und je größer die Zahlen. Ganz einfach. Deshalb erscheint uns Natur so komplex, weil Komplexität die Ansammlung von derart Missverständnissen ist.

Es ist wie das Streben nach Perfektion. Was ist perfekt? Die letzte Ziffer einer irrationalen Zahl. Ergo – unerreichbar.

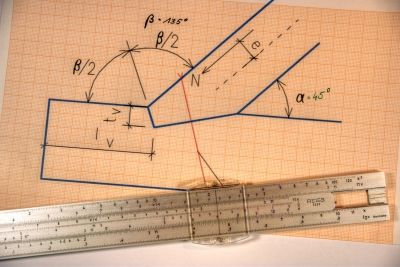

Im Aufmacherbild ist noch ein Rechenschieber zu sehen.

Damals mussten die Benutzer noch selbst mitdenken, Computer und Tastatur gab es noch nicht.

Trotzdem habe ich das Gefühl, dass die Ergebnisse damals eher besser waren als heute.

Das Bild stellt die Situation am Fußpunkt eines Kehlbalkendaches dar, an dem zu ermitteln ist, bei welchem Lasteintrag (N) welche Vorholzlänge lv erforderlich wird, damit das Holz unter der Belastung nicht einreißt und die Konstruktion versagen würde. Sehr überschaubar, was die Variablen und Eingangsgrößen angeht…. und: Jederzeit in der Praxis prüfbar! Feine Sache!