Ein Schmuddelthema der Klimadiskussion ist die nachträgliche Veränderung von Messdaten in den offiziellen Temperaturzeitreihen. Während die entsprechenden Forscher ihren regelmäßigen Eingriff in die Datenbanken als “Korrektur” und “notwendige Anpassung” bezeichnen, sehen einige Skeptiker darin plumpe Manipulation. Wie so immer im Leben, findet sich die Wahrheit wohl irgendwo in der Mitte. Wir haben bereits mehrfach über die Problematik hier im Blog berichtet. Im heutigen Beitrag wollen wir neue Analysen und Publikationen aus diesem hochsensiblen Bereich vorstellen.

Im Juni 2017 fasste eine Gruppe um James Wallace III ihre Untersuchungsergebnisse zu Datenveränderungen in den wichtigsten Temperaturdatenbanken zusammen. Dabei erkannten sie, dass im Laufe der Zeit natürliche Zyklen in der Temperaturentwicklung der letzten 150 Jahre systematisch händisch abgemildert wurden, was das Vertrauen in die Daten untergräbt. Das pdf der Studie finden Sie hier. Die Bedenken der Wallace-Gruppe bekräftigen Kritikpunkte, die Ross McKitrick bereits 2010 auf SSRN vorbrachte.

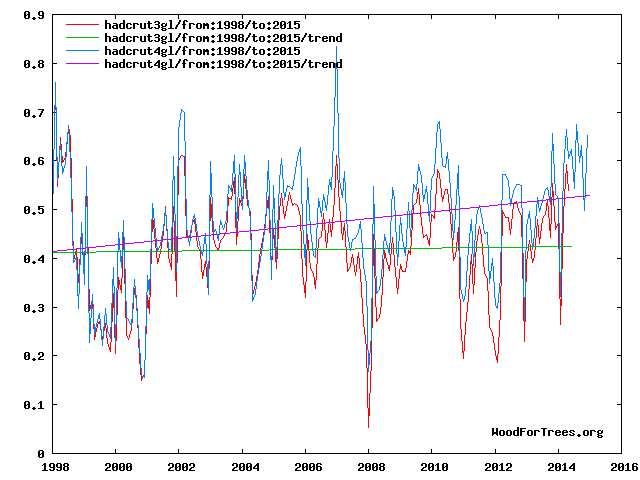

Der HadCRUT-Datensatz wird vom Hadley Centre des UK Met Office sowie der Climatic Research Unit (CRU) of the University of East Anglia und bezieht sich auf die globale Temperaturentwiclung de letzten 150 Jahre. Immer wieder werden neue Versionen erstellt, mittlerweile ist man bei HadCRUT4 angelangt. Die Tendenz der nachträglichen Datenveränderungen wird in einem direkten Vergleich von HadCRUT3 und HadCRUT4 deutlich (via Woodfortrees) (Abb. 1):

Abb. 1: Entwicklung der globalen Temperaturen gemäß früherer Version HadCRUT3 im Vergleich zum aktuellen HadCRUT4-Datensatz. Graphik: Woodfortrees.

Gut zu sehen: Die nachträglichen Veränderungen der Archivdaten haben den “Hiatus” der letzten 15 Jahre in eine Phase leichter Erwärmung von etwa 0,1°C verwandelt. Nicht gerade die feine englische Art, um die unbequeme Erwärmungspause aus der Welt zu schaffen. Leider enden die HadCRUT-Daten im Jahr 2015, so dass man den Vergleich nicht bis heute (2017) verlängern kann. Im Jahr 2012 brachte die IPCC-nahe Plattform Realclimate einen weiter zurückreichenden Vergleich von HadCRUT3 und HadCRUT4 (Abb. 2):

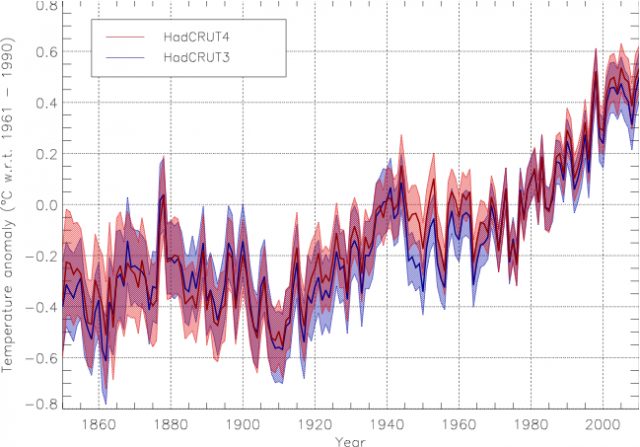

Abb. 2: Entwicklung der globalen Temperaturen gemäß früherer Version HadCRUT3 im Vergleich zum aktuellen HadCRUT4-Datensatz. Graphik: Realclimate.

Zu erkennen: Die modernen Temperaturen wurden um etwa ein Zehntel Grad hochgesetzt, während die Temperaturen um 1900 nahezu unverändert blieben. Unterm Strich führte dies zu einer nachträglich produzierten Versteilung der Erwärmung, sozusagen “anthropogen”, denn von Wissenschaftlern selber am Schreibtisch erzeugt.

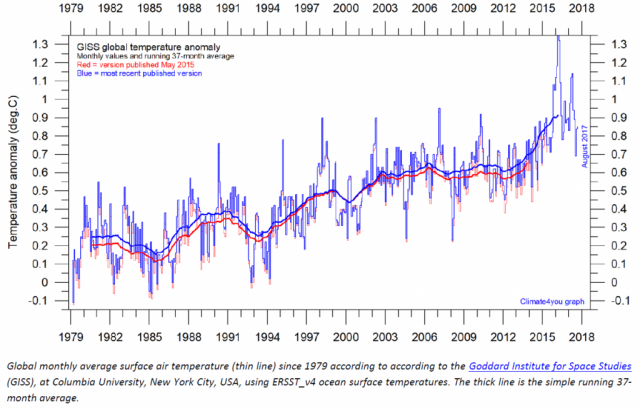

Die Datenveränderungen gehen unterdessen weiter, auch nach 2015. Im Stil der Salamitaktik wird die Erwärmung immer weiter künstlich versteilt. Ole Humlum bringt in seinem monatlichen Newsletter Climate4You die jeweils aktuellen Klimadaten. Unter anderem vergleicht er die verschiedenen Versionen der Datensätze miteinander. Hier die kürzlichen Veränderungen des GISS-Datensatzes, der vom bekennenden Klimaaktivisten Gavin Schmidt verantwortet werden. In rot die Vorversion aus dem Mai 2015, in blau die aktuellen Daten (Abb. 3). Ergebnis: Wieder eine Salamischeibe: Erwärmung um ein halbes Zehntelgrad versteilt.

Abb. 3: Entwicklung der globalen Temperaturen gemäß früherer GISS-Version aus dem Mai 2015 (rot) im Vergleich zum aktuellen GISS-Datensatz (blau). Graphik: Climate4You.

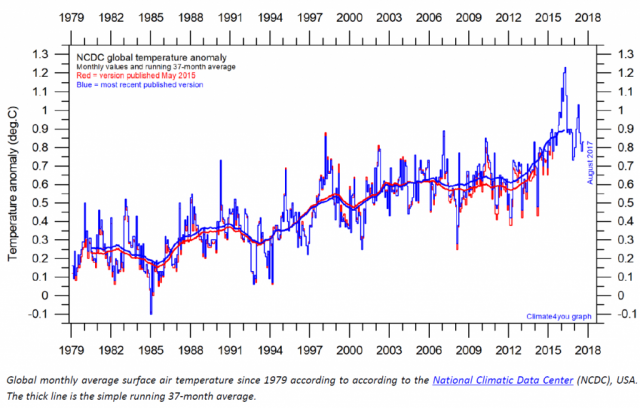

Nächstes Beispiel: NCDC-Datensatz, wo sich das gleiche Bild bietet (Abb. 4).

Abb. 4: Entwicklung der globalen Temperaturen gemäß früherer NCDC-Version aus dem Mai 2015 (rot) im Vergleich zum aktuellen NCDC-Datensatz (blau). Graphik: Climate4You.

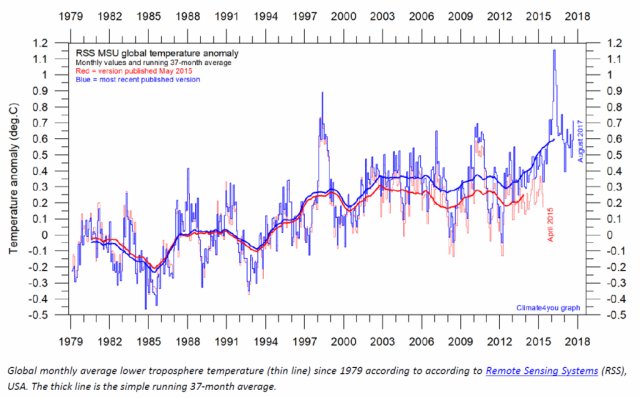

Lange galten die Satellitendatensätze UAH und RSS als zuverlässiger als die Bodendatensätze, die ständig nachjustiert werden. Zumindest für die RSS-Daten gilt dies mittlerweile nicht mehr, denn auch hier hat man nun mit dem Verändern der Daten begonnen (Abb. 5). Auch hier beträgt die künstliche Versteilung jetzt 0,1°C. Man wundert sich, dass ähnliche Korrekturen durchgeführt wurden, obwohl die Messverfahren und Begründungen äußerst unterschiedlich sein sollten. Die RSS-Änderungen wurden in einem Paper von Mears & Wentz (2017) u.a. mit dem Absinken der Satellitenbahn begründet.

Abb. 5: Entwicklung der globalen Temperaturen gemäß früherer RSS-Version aus dem Mai 2015 (rot) im Vergleich zum aktuellen RSS-Datensatz (blau). Graphik: Climate4You.

Die RSS-Datenveränderungen kommen nicht ganz unerwartet. Der UAH-Satellitendatenexperte Roy Spencer hatte bereits zu Jahresbeginn 2017 vermutet, dass RSS auf Druck der anderen Temperaturdatenbanken Änderungen durchführen würde. Um die Unabhängigkeit der verschiedenen Temperaturdatensysteme ist es offenbar nicht gut bestellt. Vielmehr herrscht Gruppendenken vor. In einem unaufgeregten, lesenswerten Blogbeitrag kommentierte Roy Spencer die RSS-Veränderungen und erläuterte, weshalb er ihnen kritisch gegenübersteht.

Die Temperaturdatenveränderungen der verschiedenen Systeme ist bedenklich. Letztendlich handelt es sich um einen Änderungsbetrag von vielleicht ein oder maximal zwei Zehntelgrad. Irgendwann werden die Justierungen aufhören müssen. Bei einer von den Modellen prognostizierten Erwärmung von zwei Zehntelgrad pro Jahrzehnt wird der Zeitpunkt kommen, wo der Spielraum der Datenmassage voll ausgereizt ist. Bis dahin sollten wir die Vorgänge kritisch begleiten, die in den Medien unbeachtet bleiben.

Dieser Beitrag ist zuerst im Blog „die Kalte Sonne“ erschienen.

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Danke für den guten Artikel. Messdaten nachträglich verändern ist die eine Möglichkeit, die 2.te wäre, die Stationen einfach an wärmere Plätze stellen. Auch davon wurde in der Vergangenheit reichlich Gebrauch gemacht. Die dritte Möglichkeit geschieht noch heute: die Wärmeinseln breiten sich aus, die Wetterstationen messen die Temperaturen der sich vergrößernden Wärmeinseln.

Da die Daten von GISS und Hadley auf dem Datensatz von NCDC beruhen , werden diese Daten also zweimal verändert. Ein Stück aus dem Tollhaus.