Diese Art Herausforderung taucht immer wieder auf; hier z. B. hinsichtlich Kreationismus.

Das Problem mit der Herausforderung des Klimawandels ist, dass kein Mensch leugnet, dass es wahrscheinlich ein anthropogenes Signal gibt. Die Frage lautet lediglich, wie groß dieses Signal ist.

Dieser Artikel in der Washington Post bringt vielleicht eine der besten Übersichten zu diesem Thema.

Man kann in einem Laboratorium zeigen, dass CO2 IR-Wellen absorbiert, und zwar innerhalb der gleichen Bandbreite, wie sie von der Erde ausgehen. Die Daten zeigen, dass es auf der Nordhemisphäre eine Verschiebung der mittleren Temperatur seit Beginn der industriellen Revolution gegeben hat.

Die weitaus meisten Menschen, die dieses Thema propagieren, versuchen die Skeptiker einzuengen, indem sie das Thema als Alles-oder-Nichts-These präsentieren, und all jene, die skeptische Statements nicht lesen, glauben daran. In der Realität gibt es auf Seiten der Skeptiker eine viel größere Bandbreite von Standpunkten zu diesem Thema; im Folgenden habe ich versucht, diese in Fettdruck hervorzuheben. Es gibt einige Leute, die lächerlich dumme Behauptungen von sich geben, dass es kein anthropogenes Signal gibt, aber das ist nur eine sehr kleine Minderheit. Viele Skeptiker sehen diese Leute als Internet-Trolle, die wir nicht füttern wollen.

Ein besserer Weg, die [Aussagen der] Skeptiker zu untersuchen ist es, sie als wissenschaftliche Kritiker zu betrachten und spezifischer diese Kritik zu evaluieren als Gegenstand, der mit jedem Schritt der wissenschaftlichen Methode folgt. Diese wissenschaftliche Standard-Methode geht so:

Beobachtungen à Hypothese à Experiment à Analyse. Würden wir bis in die neunziger Jahre zurückgehen, könnten wir feststellen, dass dies sparsam ausgeteilt worden ist als…

Beobachtungen: Eine Korrelation zwischen Erwärmung und CO2 und dass CO2 Infrarot absorbiert. In Eisbohrkernen existierte der gleiche Trend,

Hypothese: Emissionen verursachen globale Erwärmung

Experiment: Das Klimamodell

Analyse: eine genaue Untersuchung als Nachhersage, statistisch signifikanter Erwärmungen, Hockeyschläger usw. Die von Ende der neunziger Jahre bis zu Beginn dieses Jahrhunderts ausgerufene Schlussfolgerung, dass die globale Erwärmung real sei, war wissenschaftlich akzeptierbar. Der nächste Schritt wäre normalerweise die Begutachtung und die Sorgfalt, und ab hier geriet die Theorie in Schwierigkeiten.

Die Probleme:

Die Beobachtungen sind vor Ende der siebziger Jahre nicht besonders gut und werden immer schlechter, wenn man bis zu den ersten Aufzeichnungen zurückgeht. Wir haben nicht nach Trends in Zehntelgrad Celsius gesucht und wir haben unsere Instrumente dazu nicht kontrolliert. Stationen wurden verlagert, Städte sind gewachsen usw. All das würde eine Warm-Verzerrung an jenen Stationen hervorrufen. Klar gesagt, die Daten sind von schlechter Qualität. Aber auch andere Probleme tauchten auf. Die Daten aus Eisbohrkernen, gewonnen mit besseren Instrumenten, zeigen in der Tat, dass CO2-Änderungen Temperaturänderungen hinterher laufen (hier). Noch wichtiger, in allen Datensätzen hat die Temperatur aufgehört zu steigen, wohingegen das CO2-Niveau seinen Aufwärtstrend unvermindert fortsetzt. Auch haben wir noch nicht den „Hot Spot“ entdeckt, der ein sicherer Beweis für den anthropogenen Beitrag sein sollte.

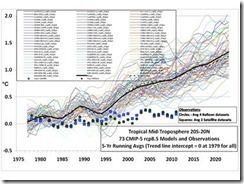

Unsere Hypothese, wie das Klimasystem funktioniert, ist im Wesentlichen in den Klimamodellen kodiert. Es gibt davon 114, die vom IPCC benutzt werden, und in allen zeigt sich ein Aufwärtstrend, und zwar schneller als die Messungen hergeben, und die meisten von ihnen sind falsifiziert worden. Aber die Arbeit, sie zu falsifizieren, machte man erst vor sehr kurzer Zeit.

In dieser Studie werden die letzten 20 Jahre Simulationen mit einem Vertrauensintervall bei 90% falsifiziert. Innerhalb des Blogs gibt es eine andere Studie, in der Simulationen mit einem Vertrauensintervall bei 98% falsifiziert werden (hier). Jene Studie verweist auf eine dritte Studie, wo Gleiches beim 95%-Vertrauensintervall gemacht wird. Das bedeutet, die Chance, dass die Wahrscheinlichkeit, dass die Modelle lediglich zufällig falsch liegen, 10%, 2% oder 5% beträgt.

Da die Modelle mathematische Repräsentationen dessen sind, was wir über die Funktionsweise des Klimasystems zu wissen glauben, bedeutet dies, dass die Klimawissenschaftler falsch lagen. Als Reaktion gab es hektische Aktivitäten, mit denen versucht worden ist, den Stillstand mit irgendetwas zu begründen und zu erklären, aber die Erklärung eines Problems mit mathematischen Modellen im Nachhinein und der Behauptung, dass unsere Hypothese immer noch gültig ist, erfordert einen eigenen Zeitraum zur Validierung.

Es gibt bis heute deutlich über 10 unterschiedliche Erklärungen für den Stillstand, wobei die meisten davon ihn einfach hinweg erklären. Dies bedeutet, dass der Stillstand in seinem gegenwärtigen Stadium übererklärt ist und dass mehr als eine jener Studien falsch sein muss. In der Wissenschaft ist es unsere Absicht, zu höchstens 5% falsch zu liegen, aber offensichtlich gilt das nicht für die Klimawissenschaft.

Diese Divergenz hat auch die unter dem Begriff Klimasensitivität bekannte Metrik beeinflusst. Klimasensitivitäten weisen eine thermische Zunahme von 1,2 bis 1,5°C pro Verdoppelung des CO2-Gehaltes auf, das heißt, falls wir von einer Verdoppelung des gegenwärtigen Wertes von 400 ppm ausgehen, würden die Temperaturen etwa um 1,2 bis 1,5°C steigen. Klimasimulationen erzeugen jedoch viel höhere Ergebnisse, nehmen sie doch typischerweise eine Erwärmung zwischen 3 und 4,5°C pro Verdoppelung an [siehe Bild oben rechts]

Schaut man noch tiefer, gibt es weitere wesentliche Probleme um die Modelle, nämlich unsere Experimente selbst. Abhängig vom Compiler, von Betriebssystemen und sogar Hardware kann sich der Modelloutput durch Rundungsfehler verändern (hier). Sie können keine Wolken vorhersagen. Auch haben sie nicht die Auflösung, um viele der Wärme transportierenden Prozesse in der Atmosphäre abzubilden. Aber das sind nur die Klimamodelle selbst. Die beeinflussenden Modelle [impact models] oder integrierte Modelle der Zustandsbeschreibung [integrated assessment models] verfügen über fast keine Daten, auf denen sie ihre Behauptungen basieren können. Das ist der Grund für die Feststellung des IPCC, dass die Kosten der Klimaänderung für eine Erwärmung um 2,5°C etwa 0,2% bis 2% des globalen BIP ausmachen. Auch dies gilt für Vorhersagen für fast 100 Jahre in der Zukunft, die derzeit weder getestet noch falsifiziert werden können.

Wenn man die Kosten der Emission von einer Tonne CO2 evaluiert, hängen die ‚integrated assessment models‘ sehr stark vom Zinsfaktor [discount rate] ab. Die gegenwärtige Administration nennt einen Zinsfaktor von 3% bei 37 Dollar pro Tonne, aber der angemessenste Zinsfaktor, der auch der langzeitliche ist, liegt vermutlich bei 7%. Das bedeutet, die tatsächlichen sozialen Kosten von Kohlenstoff betragen etwa 4 bis 5 Dollar pro Tonne. Wie in einer EPW-Senatsanhörung diskutiert worden ist, hat es die gegenwärtige Administration nicht vermocht, den Zinsfaktor von 7% zu erschaffen, wie es erforderlich ist, sondern stattdessen Raten von 5%, 3% und 2.5% erschaffen. Der Grund für diese so stark variierenden Kosten ist teilweise der Unsicherheit der integrated assessment models geschuldet, denen man die Ergebnisse der GCMs eingibt. Eine allgemein verbreitete Redensart hierzu ist GIGO (Garbage in, Garbage out [zu deutsch MRMR – Müll rein, Müll raus]).

Aber am schlimmsten ist es um die Analyse bestellt. Als Teil der Versuche, die Theorie zu retten, hatte man hier einige sehr grobe statistische Praktiken und Daten-Vergewaltigungen durchgeführt. Die erste hier zu nennende Monstrosität war Michael Manns Hockeyschläger. Er verwendete einen speziellen Algorithmus, um seine Baumringdaten auszuwerten. Dies wurde von Steve McIntyre zerlegt, einem Statistiker, der nicht nur die völlig falsche Wichtung nachweisen konnte, sondern auch den Zeitpunkt der Nahtstelle herausgefunden hatte, an dem die Thermometer- und die Baumringdaten auseinanderliefen.

Seitdem hat es viele weitere Hockeyschläger gegeben, die allesamt als riesige Müllhaufen zugrunde gingen. Trenberths Hockeyschläger, ebenfalls aus Baumringdaten, verschwand in der Versenkung, als offenbar wurde, dass er eine ganz spezielle Auswahl von nur 12 Bäumen herangezogen hatte und dass bei Verwendung des gesamten Datensatzes der Hockeyschläger verschwinden würde. Im Jahre 2013 haben Marcott et al. einen Hockeyschläger veröffentlicht, der multiple Proxydaten gemittelt hatte, außer dass beim Blatt des Hockeyschlägers nur drei dieser Proxys Verwendung fanden. Diese waren statistisch völlig unsicher und wiesen einige Proxy-Re-Arrangements auf, die zufällig mit der industriellen Revolution zusammenfielen.

Man hat die 97% Konsens-Studien erwähnt, die es wirklich gibt, die aber grauenhaft sind. Cook et al. wurden schon sehr oft widerlegt, und tatsächlich empfehle ich dringend, auch einige der Dinge zu lesen, auf die Brandon Schollenberger hingewiesen hat, obwohl dies nicht begutachtet ist. Die frühere 97%-Studie von Doran und Zimmerman war genauso dumm. Das wallstreet journal hat beide angesprochen, aber ich empfehle diese Site für eine ausgewogene Kritik. Tatsächlich ist die Anzahl der Abstracts und Methoden, die ich gelesen habe und die komplett Müll sind, so erstaunlich, dass ich sie hier nicht alle verlinkt habe.

So wird die Frage immer ultimativer: Welcher Beweise bedarf es, bevor man einräumt, dass das Klima nicht so sensitiv auf anthropogene Emissionen reagieren könnte wie ursprünglich gedacht?

Unabhängig von den Problemen ihrer wissenschaftlichen Methodik scheinen auch einige ethische Tatbestände aufzutauchen. Einem Statistiker in Diensten einer linksgerichteten Denkfabrik wurde jüngst gekündigt, nachdem er etwas über die statistischen Schwächen hinsichtlich der anthropogenen Erwärmung geschrieben hatte. Etwa einen Monat zuvor hat der Klimawissenschaftler Lennart Bengtsson versucht, einer konservativeren und klimaskeptischen Denkfabrik beizutreten. Er musste sich bald darauf aber wieder zurückziehen aufgrund von Drohungen, seine Arbeiten zu entfernen und allgemein seiner Sicherheit und seines Wohlbefindens.

Eine seiner Studien, die sich auf die Diskrepanzen zwischen Modellen und Messungen bezog, wurde zurückgewiesen mit der Begründung, dass sie nur teilweise empfohlen werden könnte, weil man das Gefühl hatte, dass andere Teile schädlich seien. Die Begutachter erwähnten auch, dass man Klimamodelle nicht mit beobachteten Daten validieren sollte. Einige Jahre zuvor war es Klimagate.

Eine psychologische Studie versuchte, Skeptiker als Verschwörungstheoretiker hinzustellen, als man angeblich aus ethischen Gründen einen Rückzieher machte. Die Forscher und ihre Gemeinschaft betrachteten das als vollkommen in Ordnung, um Gegner zu erniedrigen, und dass der Rückzieher aufgrund juristischer Einsprüche erfolgt ist. Die wüste Verteidigung geriet so antagonistisch, dass der Herausgeber die Zurückweisung als aufgrund der Verletzung der Ethik in diesen Studien erfolgt begründen musste. Weitere vermeintliche Gründe sollen der Tonfall und der Unwillen oder die Unfähigkeit der Autoren gewesen sein, Änderungen vorzunehmen. Und es gibt die Studie, der zufolge Lügen und Übertreibungen hinsichtlich der Ergebnisse in Ordnung seien.

Falls man bei Skeptical Science hineinschaut, kann man sehen, dass man dort versucht, skeptische Behauptungen zu widerlegen, aber in neun von zehn Fällen benutzt man dafür Strohmänner, Beleidigungen oder Trugschlüsse. Nehmen wir zum Beispiel das gute Argument, dass billige fossile Energie die ärmsten Nationen der Welt erheblich voranbringen könnte und dass es sehr schädlich ist, ihnen den Zugang dazu zu verweigern. Sie bestreiten das mit dem Hinweis, dass projizierte Klimaschäden die ärmsten Länder am meisten betreffen würden. Das kann zwar stimmen, ist aber nicht das gleiche Argument. Wenn man armen Ländern die Energie vorenthält, die sie zum Wachstum brauchen und die sie unabhängiger von Energieimporten macht, damit diese Länder von weniger Stürmen in der Zukunft betroffen werden, ist das schlicht idiotisch.

Aber nehmen wir an, man ist nicht skeptisch hinsichtlich der Ethik oder ihrer methodischen Schummeleien. Nehmen wir an, man beschließt, ab jetzt das Risiko in der Zukunft verhindern zu wollen. Dann kann man immer noch skeptisch sein hinsichtlich der vorgeschlagenen Lösungen. Schauen wir zum Beispiel auf die Energiepolitik. Die billigste, effektivste und einfachste Energiepolitik wäre eine Kohlenstoff-Steuer. 4 Dollar pro Tonne sind genau der Preis für zukünftige Schäden. Sie erlaubt es den Ländern und Märkten auch zu arbeiten anstatt darauf zu hoffen, dass die Bürokraten nicht alles durcheinanderbringen. Im Wesentlichen bestraft eine Kohlenstoff-Steuer den Kohlenstoff für seine aktuellen Kosten anstatt nicht gewählten Funktionären enorme Macht zu verleihen wie jüngst der EPA.

Aber vielleicht glauben Sie nicht an Märkte, vielleicht glauben Sie, dass die Regierung nicht ganz so inkompetent ist, wie sie ständig zu beweisen versucht. Das ist in Ordnung, kann man doch dann immer noch skeptisch sein, wie das Geld ausgegeben wird. In den USA bekommen Solarpaneele eine unglaubliche Markt-Bevorzugung in Gestalt eines Steuernachlasses von 40% auf jede Installation. Außerdem, während alle Sektoren ihre Kapital-Investitionen durch das Abschreiben von Gewinnen mit der Zeit ausgleichen, gleichen sich die Kosten für Solarpaneele innerhalb von 5 Jahren zu 100% aus, das ist weniger Zeit als für einen Bürosessel. Mit diesen Vergünstigungen ist Solarenergie immer noch die teuerste Form der Stromerzeugung (hier).

Wenn man den Anstieg der Kosten für Solarenergie nur um die Steuernachlässe korrigiert, kommt man auf Kosten in Höhe von 140 Dollar pro Megawattstunde für Standard-Installationen. Die gleiche Korrektur angebracht hinsichtlich der Windenergie würde dessen Kosten auf 88 Dollar pro Megawattstunde steigen lassen. Die Periodizität für das Netz ist ein externer Effekt, den man ins Kalkül ziehen sollte. Davon ausgehend muss man den Faktor Abwertung von Wind und Solar als Kostenfaktor berücksichtigen. Integriert man diesen in die Lebensspanne von Wind und Solar, multiplizieren sich die Kosten um fast das 4,5-fache.

Kernkraft mit Kosten von näherungsweise 96 Dollar pro Megawattstunde ist substantiell billiger, bringt viel weniger Kohlenstoff-Emissionen, hat eine längere Lebensdauer und ist sicherer. Aber wir hören ausschließlich von den Beiträgen durch Erneuerbare, obwohl diese buchstäblich in jeder Hinsicht schlechter sind.

All dies sind Dinge, die uns hinsichtlich der Authentizität der Theorie begegnen. Der nächste Schritt wäre die Falsifikation, aber es ist schwierig, ein falsifizierendes Beweisstück zu finden. Egal was derzeit oder in Zukunft hinsichtlich globaler Erwärmung bzw. Klimaänderung passiert – man scheint es vorhergesagt zu haben. Wir erleben sowohl wärmere als auch kältere Frühjahre/Sommer/Herbst/Winter. Es gibt Dürren und Überschwemmungen, kalt und heiß. Im Winter 2009/2010 haben wir gehört, wie der Klimawandel insgesamt zu mehr Schnee im Winter führen wird, wohingegen wenige Jahre zuvor das Ende von winterlichem Schneefall verkündet worden war. Zum Teufel, das war vor vier Jahren, und dennoch macht man in diesem Jahr immer noch immer wildere crappy [hier steht beim LEO die Übersetzung!] Behauptungen zur globalen Erwärmung, wobei man vollständig ignoriert [leugnet?], dass die mittlere Temperatur in jenem Teil Russlands im Februar während des gesamten Aufzeichnungs-Zeitraumes über dem Gefrierpunkt liegt [?]

Inzwischen sind fast zwei Jahrzehnte ohne Temperaturtrend vergangen, und seit etwas über einem Jahrzehnt ist der Trend sogar leicht negativ. Das reicht offensichtlich noch nicht. Es gibt Perioden innerhalb dieser Zwischeneiszeit, in denen es wärmer war, und solche, in denen es kälter war. Was also ist die Referenzperiode für ein klimatisches Normal? Vor ein paar hundert Jahren erreichte die Temperatur eine Wärmespitze ohne Treibhausgas-Emissionen, der Zeitraum von 1914 bis 1940 zeigte einen ähnlichen Trend wie der Zeitraum von 1980 bis 2000 – warum ist letzterer anthropogen und ersterer nicht? Wie kann das CO2 diesmal die treibende Kraft sein, wenn es kaum oder gar keine Beweise gibt, dass es jemals in der Vergangenheit der Haupttreiber war?

Warum sollten wir den Erklärungen oder Korrekturen des Stillstands glauben, wenn die gleichen Individuen noch vor ein paar Jahren darauf verwiesen, wie perfekt die Modelle seien? Es gibt keinen Mechanismus, der Wärme aus der unteren Troposphäre auf magische Weise in die Tiefsee absinken lässt. Messungen aus der Tiefsee haben wir erst seit ein paar Jahren, und sie sind immer noch nicht zuverlässig. Außerdem wird diese Zone begrenzt durch wärmere obere Ozeanschichten und ist außerdem Schauplatz geothermische Erwärmung. Wie soll die Wärme dorthin gelangen, ohne in der oberen, der unteren Atmosphäre oder den oberen Ozeanschichten aufspürbar zu sein? Auch gibt es keinen Mechanismus, der beschreiben könnte, warum sich die gesamte Wärme in der Arktis konzentrieren soll, von wo wir auch keine Messungen haben.

Wo ziehen wir die wissenschaftliche Grenze zwischen natürlichen und künstlichen Trends, und woher wissen wir, dass diese Grenze akkurat ist? Warum ist es in der Klimawissenschaft nicht erforderlich, validiert zu werden? Was falsifiziert die Beweise? Angesichts des Berges von Problemen um die Unsicherheiten, die mangelhafte Methodik und schrecklicher Analysen bezeichnen die meisten Skeptiker einschließlich ich selbst das ganze Theater als Bullshit.

Link: http://wattsupwiththat.com/2014/07/06/about-that-30000-to-disprove-global-warming-contest/

Übersetzt von Chris Frey EIKE

Über diese 30.000 Dollar-Wette, um die globale Erwärmung zu widerlegen

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Eine gute Zusammenfassung … nur ein Schönheitsfehler:

————-

Es gibt einige Leute, die lächerlich dumme Behauptungen von sich geben, dass es kein anthropogenes Signal gibt, aber das ist nur eine sehr kleine Minderheit. Viele Skeptiker sehen diese Leute als Internet-Trolle, die wir nicht füttern wollen.

————–

Dies Ausgrenzerei erscheint mir als schädlich. Sicher gibt es Leute, deren Argumente ich für unhaltbar halte. Aber es gibt vielleicht auch Leute, die das von meinen Argumenten denken. Ich stimme auch dem Stil einiger Leute nicht zu … aber vielleicht glauben die das auch von meinen.

Ich denke da an die Goldene Regel – in der positiven Formulierung der Bergpredigt: Was ihr von den Menschen erwartet, dass sie euch tun sollen, so tut auch ihnen.

Ich beobachte, dass sich hier und vor allem auf Science Sceptical Stimmen mehren, die meinen, man müsse eben jene, deren Meinung man für schädlich hält, ausgrenzen. Bei allem Verständnis, dass es auch grenzwertige Beiträge gibt, ist es bedenklich. Ich denke, dass derartige Distanzierungen zu weit gehen.

Wenn Andere etwas darstellen, was ich so für falsch halte, gehe ich auch argumentativ darauf ein. Ich muss den Meinungsgegner darum noch lange nicht für einen Troll halten, auch wenn er meine besseren Argumente nicht akzeptiert.

Wenn ich der Ansicht bin, dass eine Diskussion zu einem Punkt sich auf einen Grabenkampf geschränkt, muss ich auch nicht weiter darauf eingehen. Auf keinen fall geht es mir um die Wahre Lehre und ein Glaubensbekenntnis, dass mein Meinungsgegner teilen muss.

Mir reicht ein Minimalkonsens in den wichtigen Dingen, um meinen Meinungsgegner als ‚Freund‘ ansehe. So gibt es viele hier, die die Klimahysterie für grundfalsch halten, die Energiewendepolitik für schädlich etc. Auch wenn ich nicht alle Argumente für hilfreich halte, so ist es doch ein Streit unter Freunden, wenn es um die Details geht. Das sollte man nie aus den Augen verlieren.

Da kann man gleich die Wette dazu benutzen um „Wenn der Hahn kräht auf dem Mist ändert sich das Wetter, oder es bleibt, wie es ist.“ zu widerlegen.

Die AGW’ler haben doch alles abgedackt was ein möglicher Beweis oder Gegenbeweis wäre. Dieselben sind auch die sogenanten Hüter der Daten.

Abwarten und Tee drinken. Die Natur wird schon die Wahrheit zeigen. Oder die Gruene Idee wird sich so stark verfranzen, dass jeder „Des Kaisers neue Kleider“ sieht.

Steven Burnett: „Das Problem mit der Herausforderung des Klimawandels ist, dass kein Mensch leugnet, dass es wahrscheinlich ein anthropogenes Signal gibt.“

========================================

Vielen Dank an die EIKE-Redaktion.

Der Autor lügt unverfroren (wahrscheinlich).

Leider ein typischer WUWT-Artikel (wahrscheinlich).

Zitat: „Es gibt einige Leute, die lächerlich dumme Behauptungen von sich geben, dass es kein anthropogenes Signal gibt, aber das ist nur eine sehr kleine Minderheit. Viele Skeptiker sehen diese Leute als Internet-Trolle, die wir nicht füttern wollen.“

Meines Wissens gibt es kein einziges Experiment, das auf der Erde im Gravitationsfeld den Treibhauseffekt beweisen könnte. Die Kindergarten- und Schulversuche zum „Treibhaus“ sind barer Unsinn. In der zweifelsfrei stattgefundenen leichten Erwärmung wurde bisher kein anthropogenes Signal gefunden. Die Rolle von „anthropogenem“ CO2 auf das Klima ist daher völlig offen: Es könnte minimal wärmen, kühlen oder gar nichts tun. Der Stillstand der „globalen Erwärmung“ seit rund 18 Jahren lässt am ehesten den Schluss zu, dass CO2 gar keinen Effekt hat oder, wie Herr Stehlik immer wieder erwähnt, kühlt. Glücklicherweise bin ich jung genug, dass ich das Jahr 2050 erleben könnte. Bis dahin werden wie vielleicht wissen, welche Rolle CO2 spielt.

Aber, zweifelsfrei ändert der Mensch seine Umgebung, und der städtische Wärmeinseleffekt ist bekannt. So gesehen gibt es in der Tat im lokalen Klima ein anthropogenes Signal.

Die Abhandlungen zum Aspekt Energie halte ich für gelungen. Die Deutschen sind aber so doof, dass sie die Kernkraftwerke abschalten anstatt sie weiter zu entwickeln, und es gibt genügend Leute an entscheidenden Stellen, die das Stromnetz aus ideologischen Gründen komplett kaputt schlagen wollen. Und die Mehrzahl der Deutschen klatscht auch noch Beifall. Das muss ich wohl nicht verstehen.