Bild rechts: Graphik von Dr. Roy Spencer

Zunehmende mathematische Unsicherheiten der Startbedingungen sind der Hauptgrund. Aber einiges davon könnte der Tatsache geschuldet sein, dass einige Modelle trotz des gleichen Codes nicht die gleichen Ergebnisse zeigen, wenn die Rechenoperationen an verschiedenen CPUs, Betriebs-Systemen und Compilern durchgeführt werden. Mit dieser Studie können wir nun Software-Unsicherheiten der Liste von Unsicherheiten hinzufügen, die hinsichtlich des Klimas und seiner Modellierung bekannt sind.

Mir ist diese Studie gestern vor Augen gekommen, und deren Ergebnisse sind ziemlich aufschlussreich.

Die Studie wurde am 26. Juli 2013 im Monthly Weather Review veröffentlicht, also einem Journal der American Meteorological Society. Sie kommt zu dem Ergebnis, dass das gleiche Vorhersagemodell (eines für die geopotentielle Höhe) zu unterschiedlichen Ergebnissen kommt, wenn man es auf verschiedener Computer-Hardware und Operationssystemen laufen lässt, ohne sonst irgendwelche Änderungen vorzunehmen.

Sie sagen, dass die Unterschiede hauptsächlich durch Rundungsfehler der verschiedenen Software-Systeme auftreten und dass diese Fehler mit der Zeit zunehmen, das heißt sie akkumulieren sich.

Die Autoren:

„Wir behandeln die Toleranzfrage und verwenden dafür die 500-hPa-Fläche für die mittelfristige Vorhersage sowie den Ensemble-Spread für jahreszeitliche Klimasimulationen“.

…

„Die Abhängigkeit (von Hardware & Software), also die Standardabweichung der 500-hPa-Geopotentialfläche (Gebiete mit hohem und tiefem Druck) gemittelt über den Globus nimmt mit der Zeit zu“.

Die Autoren kommen zu dem Ergebnis:

„Der Ensemble-Spread infolge der Unterschiede in den Software-Systemen ist vergleichbar mit dem Ensemble-Spread infolge von Unterschieden der Anfangsbedingungen, die für die traditionelle Vorhersage von Ensembles verwendet werden“.

Schon viele Studien haben gezeigt, dass kleine Änderungen der Anfangsbedingungen von Klimamodellen signifikant unterschiedliche Projektionen des Klimas erzeugen.

Man fragt sich, ob einige der katastrophalen Zukunfts-Projektionen vielleicht nur aufgrund eines Rundungsfehlers simuliert werden.

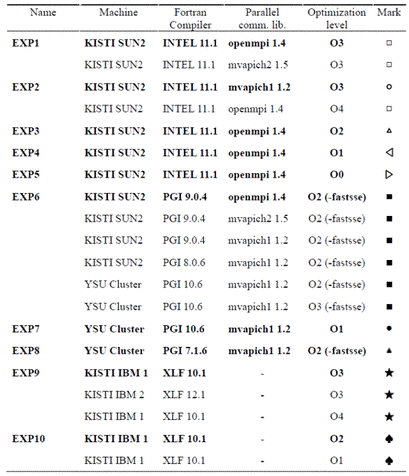

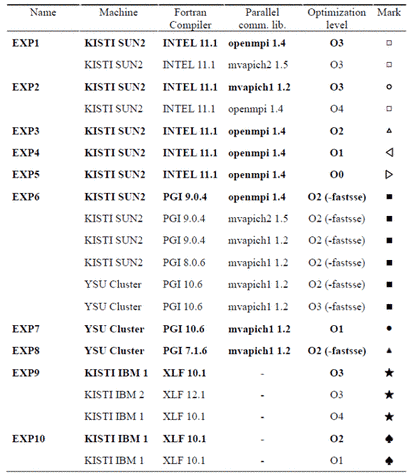

Die Software/Hardware-Tests haben sie folgendermaßen durchgeführt:

Tabelle 1 zeigt die 20 Computersysteme einschließlich Fortran-Compiler, Parallel-communication libraries und optimierte Levels des Compilers. Der Linux-Cluster der Yonsei University (YSU) ist mit 12 Intel Xeon CPUs pro Node ausgestattet (Modellname: X5650) und unterstützt die PGI und Intel Fortran Compiler. Das Korea Institute of Science and Technology Information (KISTI, http://www.kisti.re.kr) verfügt über eine Computer-Ausrüstung mit High Performance IBM und SUN-Platttformen. Jede Plattform ist ausgerüstet mit verschiedenen CPUs: Intel Xeon X5570 for KISTI-SUN2 platform, Power5+ processor of Power 595 server for KISTI-IBM1 platform, and Power6 dual-core processor of p5 595 server for KISTI-IBM2 platform. Jede Maschine hat eine unterschiedliche Architektur und etwa fünfhundert bis zwanzigtausend CPUs.*

[*Ich verstehe hier nur Bahnhof. Sorry! A. d. Übers.

Im Original lautet dieser Absatz: Table 1 shows the 20 computing environments including Fortran compilers, parallel communication libraries, and optimization levels of the compilers. The Yonsei University (YSU) Linux cluster is equipped with 12 Intel Xeon CPUs (model name: X5650) per node and supports the PGI and Intel Fortran compilers. The Korea Institute of Science and Technology Information (KISTI; http://www.kisti.re.kr) provides a computing environment with high-performance IBM and SUN platforms. Each platform is equipped with different CPU: Intel Xeon X5570 for KISTI-SUN2 platform, Power5+ processor of Power 595 server for KISTI-IBM1 platform, and Power6 dual-core processor of p5 595 server for KISTI-IBM2 platform. Each machine has a different architecture and approximately five hundred to twenty thousand CPUs.]

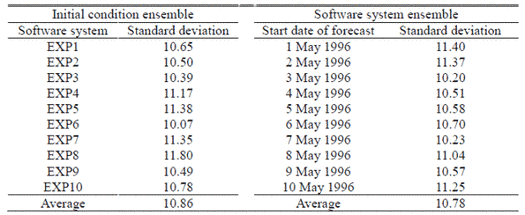

Und hier sind die Ergebnisse:

Tabelle 2: Global gemittelte Standardabweichung der 500 hPa-Fläche aus dem 10-Mitglieder-Ensemble mit unterschiedlichen Anfangsbedingungen in einem gegebenen Software-System 383 (d. h. Ensemble der Anfangsbedingungen) und der korrespondierenden Standardabweichung des 10-Mitglieder-Ensembles mit unterschiedlichen Software-Systemen für einen gegebenen Anfangszustand (d. h. Ensemble der Software-Systeme).

Einigen mögen diese Unterschiede gering vorkommen, aber man sollte im Auge behalten, dass diese Standardabweichungen nur für Modellierungen von 10 Tagen im Voraus durch globale Wettervorhersage-Systeme gelten, und nicht für Jahrzehnte durch Klimamodelle.*

*Siehe hierzu den Anhang der EIKE-Redaktion unten!

Eindeutig wird hier eine Evaluierung dieses Effektes gebraucht, wenn es um viele der GCMs geht, die verwendet werden, um das zukünftige Klima zu projizieren. Beeinflusst dieser Effekt die Modelle, und wenn ja, wie viel von deren Output ist real, und wie viel des Outputs beruht lediglich auf akkumulierten Rundungsfehlern?

Die Studie:

An Evaluation of the Software System Dependency of a Global Atmospheric Model

Song-You Hong, Myung-Seo Koo,Jihyeon Jang, Jung-Eun Esther Kim, Hoon Park, Min-Su Joh, Ji-Hoon Kang, and Tae-Jin Oh Monthly Weather Review 2013 ; e-Viewdoi: http://dx.doi.org/10.1175/MWR-D-12-00352.1

Abstract

Diese Studie präsentiert die Abhängigkeit von Simulationsergebnissen eines globalen numerischen Modells, das auf Rechnern mit unterschiedlichen Hardware- und Software-Systemen gerechnet wird. Das Global Model Program (GMP) des Global/Regional Integrated Model Systems (GRIMs) wird auf 10 verschiedenen Computersystemen getestet mit unterschiedlichen Prozessor-Einheiten (CPU) oder Compilern. Es gibt Unterschiede in den Ergebnissen verschiedener Compiler, parallel libraries und Optimierungs-Niveaus, hauptsächlich durch die Behandlung von Rundungsfehlern durch die verschiedenen Software-Systeme. Die Abhängigkeit des Systems, also die Standardabweichung der 500 hPa-Fläche gemittelt über den Globus nimmt mit der Zeit zu. Allerdings verharrt die fractional Tendency [?], also die Änderung der Standardabweichung relativ zum Wert selbst, mit der Zeit bei nahe Null. Im Rahmen einer jahreszeitlichen Vorhersage ist der Ensemble-Spread aufgrund der Unterschiede in den Software-Systemen vergleichbar mit dem Ensemble-Spread aufgrund unterschiedlicher Anfangsbedingungen, die für die traditionelle Vorhersagen von Ensembles verwendet werden.

h/t to The Hockey Schtick

Übersetzt von Chris Frey EIKE

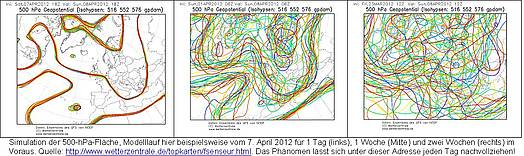

Anhang: Die in diesem Artikel angesprochene Problematik globaler Wettervorhersage-Systeme kann jeder täglich selbst nachvollziehen (und zwar hier: http://www.wetterzentrale.de/topkarten/fsenseur.html). Beispielhaft seien hier die folgenden drei Abbildungen gezeigt:

Dipl.-Met. Hans-Dieter Schmidt, EIKE-Redaktion

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Abgesehen von den Rundungsfehlern:

Wer einer langfristigen Klima-Computersimulation irgend einer, auch noch so geringen Aussagekraft unterstellt, bestätigt damit, dass a) das im Vergleich zur unendlichen Komplexität der Natur relativ einfach aufgebaute menschliche Gehirn alle Wechselwirkungen in der Natur verinnerlicht hat, und b) dass im Vergleich zur Komplexität des Gehirns sehr primitive Chip menschliches Wissen wiederspiegeln kann.

Oder anders: Aufgrund der rasenden Verdummung der Wohlstandgesellschaft wächst die Computergläubigkeit, durch die „anerzogene“ Denkfaulheit der Internetgesellschaft wird eine eigene Analyse durch Bildschirminhalt als Quelle des Wissens ersetzt. Dabei wird vergessen, dass der Computer die Intelligenz einer Dampfmaschine besitzt: Energie wird auf Befehl des Menschen in exakt definierten Zahlenkolonnen umgewandelt.

Damit ist nicht gesagt, dass Simulationen grundsätzlich überflüssig sind. Anstatt jede aerodynamische Neukonstruktion im Windkanal zu testen, wird in der Simulation eine Vorauswahl getroffen. Das Entscheidende ist, dass keine Fertigung aufgrund von Simulationen beginnt, sondern immer erst nach den ECHTEN Tests. Einen Wirklichkeitstest von Klimasimulationen ist ausgeschlossen.

Ich hoffe, dass alle EIKE-Mitstreiter sattelfest die reelle Welt von der virtuellen trennen können!

Ich habe mir Gedanken gemacht uber die Aussage:

„Man fragt sich, ob einige der katastrophalen Zukunfts-Projektionen vielleicht nur aufgrund eines Rundungsfehlers simuliert werden.“

Ich denke das die Frage nicht das Wort „einige“ enthalten sollte sondern das Wort „alle“.

Warum? Wenn es von der Computer-Hardware und Software abhängt, dann ist das Programm als die Basis nicht ohne Fehler. Das Vertrauen das ein Programm ohne Fehler ist wird wohl hier sehr deutlich. Die Industrie hat normalerweise eine Qualitätssicherung um die meisten Fehler frühzeitig zu erkennen. Ich denke mal das dies in der Wissenschaft wohl nicht der Fall ist.

Obwohl die Industrie eine Qualitätssicherung benutzt wird es vorkommen das Programmfehler nicht gefunden werden.

Wie ich schon in meinem vorherigen Kommentar gezeigt habe, das auch Excel noch immer Fehler hat, zeigt das nichts wirklich 100% ist.

Anderes Beispiel: Auch die besten Computerspiele zeigen es hin und wieder, wie z.B. Assassin’s Creed III, wo ich viele Fehler gefunden habe. Man muss auch sagen das Computerspiele sehr viel getestet werden bevor sie auf den Markt kommen.

Ich bin der Meinung, dass mehrere Kartenleger, Astrologen und einige Kristallkugeln zu ähnlichen Ergebnissen kommen würden. Die Massenproduktion von Modellen, Szenarien oder Prognosen scheint eine Art „wissenschaftliche“ Lotterie zu sein. Das Motto: schaun wir mal wer zuerst in 100 Jahren recht hat.

Wenn das wirklich der Grund ist – dann gute Nacht.

Mein kennt doch diese Ungenauigkeit mindestens seit den Anfängen von den Taschenrechnern.

1/3/3/3*3*3*3 und heraus kam 0.99999999

Auch Excel zeigt Probleme.

Beispiel auf meinem Computer:

=1*(0.5-0.4-0.1) und das Ergebnis ist -2.77556E-17

=1*(0.5-0.1-0.4) und das Ergebnis ist 0 und damit richtig

Wie kann man sich von Ungenaugikeiten sichern. Man rundet die Zahl und und zwar so das man die Präzision im floating point Bereich etwas reduziert. Man will ja Genauigkeit und die eventuellen Ungenaugkeiten eliminieren.

Beispiel:

=ROUND(1*(0.5-0.4-0.1),17) und das Erbnis ist -3E-17

=ROUND(1*(0.5-0.4-0.1),16) und das Ergebnis ist 0

Vieleicht braucht man nur 3 Stellen nach dem Komma dann sollte man es auch so runden.

Java type example (IEEE 754 floating-point standard):

float: 4 bytes, Covers a range from 1.40129846432481707e-45 to 3.40282346638528860e+38 (positive or negative).

double: 8 bytes, Covers a range from 4.94065645841246544e-324d to 1.79769313486231570e+308d (positive or negative).

Ich frage mich schon wie man das nicht im Griff hat.

Ach ja, Computer sind auch nur Menschen.

Operationssystemen ? Gaengig ist die Bezeichnung entweder auf englisch (operating system) oder deutsch (Betriebssystem).

… haben wir damals schon in der Schule gelernt, Beispielsweise zu Maschinenbauen, das Simulationen “ungenau“ vor allem beispielsweise bei Anwenden der FEM( Finite Element Methode) also aus der “Pivotierung“ zur Investierung einer Matrix werden können.

Aber da man ja ein “Werkzeug“ benutzt welches ohnehin für seine Ergebnisse keine Haftung übernimmt, sondern “nur“ Spielraum für Interpretationen liefert, ist das manchen ja egal.

Schlimmer wird es dann noch, wenn man für die ohnehin physiklalische Vorgänge einer falschen Vorstellung unterliegt, wie denn dieser Zusammenhänge überhaupt von statten gehen, zu berechnen sind :zu ausreichender Aussagekraft zur Realität überhaupt haben.

Wie das halt so ist, manche benutzen einen Zollstock oder ein gewöhnliches Feuerzeug zum öffnen von Bierflaschen mit “Kronenkorken“ wegen des “Plopp“ Geräusch; – andere machen damit lediglich Feuer und wiederum andere drehen am – jedoch nur ersten Augenscheins – so eigentlich aussehenden Kronenkorken um eine Bierflasche zu öffnen.

Wiederrum andere studieren Chemie, oder Geo-Science, oder Umweltwissenschaften oder Medizin gar Psychologie vor Theologie zu Klima modellieren mit Computern: vor nichtmal wissen wollen was Physik – der Quanten Vorkommens Mechanik Bewegens – dazu erklärt?

Es kommt halt darauf an wie man das was man ersten Augenscheins nicht sehen kann – und doch geschieht – in Vorstellung hat zu erklären.

… es dann doch makroskopisch wie mikroskopisch selber Vorgang ist: Schwingens darstellen von sowohl Volumen als auch Energie.

Aber dazu hab ich ja schon so einiges geschrieben, wie beisielsweise das Bilden einer Wolke meiner Vorstellung nach geschieht

:

http://tinyurl.com/nwmtm7t

:

klar auch unter Berücksichtigen der Zeit für diesen Vorgang.

… und nichtmal neu ist das: meine ich wenigstens.

Aus meinem Erkunden was denn Menschen vor Jahren bereits erdacht und gefunden haben in einer Sprache dokumentiert haben, die damals vielleicht vielen geläufig war, vielleicht aus dem Latein stammend, worüber dann heute – also derzeit – wir alle auch nur meinen können was andere zu dieser Zeit bereits gewusst haben wie denn Dinge vor sich gehen können, nunmal erklärt per Atom, also endlich unteilbaren Teilchen, heute dann halt eben anerkannt “Higgs“ genannt.