Das vorgeschlagene astronomisch basierte empirische Modell präsentiert eine alternative Methode, um Klimaänderungen zu rekonstruieren und vorherzusagen (derzeit im globalen Maßstab); und zwar alternativ zu der analytischen Methode, die in den allgemeinen Zirkulationsmodellen des IPCC enthalten ist. In meiner Studie habe ich bewiesen, dass alle Modelle des IPCC dabei versagt haben, alle dekadischen und multidekadischen Zyklen zu rekonstruieren, die in den Temperaturaufzeichnungen seit 1850 beobachtet worden waren. Für Details siehe meine unten gelisteten Veröffentlichungen.

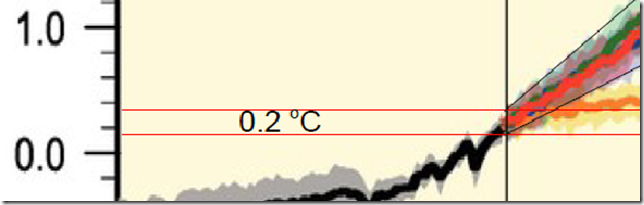

Wie die Abbildung (rechts) zeigt, betrug die Temperatur im Januar 2012 0,218°C, was verglichen mit der Temperatur von Dezember 2011 eine Abkühlung darstellt. Außerdem liegt der Wert um 0,5°C unter dem Wert der mittleren IPCC-Projektion (der dünnen Kurve in der Mitte der grünen Zone). Man beachte, dass dies eine sehr signifikante Diskrepanz zwischen den Daten und der IPCC-Projektion ist.

Im Gegensatz dazu sind die Daten weiterhin in guter Übereinstimmung mit meinem empirischen Modell, was, wie ich erinnern möchte, als eine vollständige Vorhersage seit Januar 2000 konstruiert worden ist.

Tatsächlich werden die Amplituden und Phasen der vier Zyklen wesentlich auf der Basis von Daten von 1850 bis 2000 bestimmt, und die Phasen befinden sich in angemessener Übereinstimmung mit astronomischen Orbitaldaten und Zyklen, während die korrigierte Projektion der anthropogenen Erwärmung abgeschätzt wird durch den Vergleich des harmonischen Modells mit den Temperaturdaten und den IPCC-Modellen von 1970 bis 2000. Letzteres impliziert, dass die allgemeinen Zirkulationsmodelle des IPCC die Komponente der anthropogenen Erwärmung um den Faktor 2,6 überschätzt haben, mit einer Bandbreite von 2 bis 4. Siehe die Originalstudien und den Blogbeitrag (unten).

Das Widget zog auch manche Kritik einiger Leser von WUWT sowie von skepticalscience auf sich.

Anthony Watts fragte mich, ob ich auf diese Kritiken antworten wolle, und das mache ich sehr gern. Ich möchte auf fünf Punkte eingehen.

1. Kritik von Leif Svalgaard

Wie viele Leser dieses Blogs bemerkt haben, hat Leif Svalgaard immer wieder meine Forschungen und Studien kritisiert. Seiner Meinung nach ist nichts von dem, was ich mache, auch nur eine Überlegung wert.

Über mein Widget behauptete Svalgaard wiederholt, dass die Daten schon jetzt klar meinem Modell widersprechen, siehe hier: 1, 2, 3 usw.

In jedem Falle, wie ich schon oft gesagt habe, scheint Leifs Kritik darauf zu beruhen, dass er die Zeiträume und die vielen Verteilungen in den Daten durcheinander bringt. Die Daten zeigen einen harmonischen dekadischen Trend plus schnellere Fluktuationen wegen der El Nino/La Nina-Oszillationen, die einen Zeitmaßstab von einigen Jahren haben. Die durch die ENSO ausgelösten Oszillationen sind ziemlich ausgeprägt und tauchen in den Daten mit Perioden starker Erwärmung auf, gefolgt von Perioden mit starker Abkühlung. Zum Beispiel liegt die Temperatur im Januar 2012 in der Abbildung oben außerhalb meiner türkisfarbenen Zone. Dies bedeutet nicht, dass mein Modell falsch ist, wie es Leif fehlinterpretiert. Tatsächlich ist dies eine Folge des gegenwärtigen kühlenden La Nina-Ereignisses. In einigen Monaten wird die Temperatur wieder steigen, wenn die El Nino-Warmphase wieder einsetzt.

Mein Modell ist nicht dazu gedacht, dass es die schnellen ENSO-Oszillationen abbildet, sondern nur die geglätteten dekadischen Komponenten durch ein vierjähriges gleitendes Mittel, wie ich in meiner Originalstudie gezeigt habe: dort erkennt man die volle Rekonstruktion seit 1850, welche meine Modelle (blaue und schwarze Linien) das 4-Jahres-Mittel gut rekonstruieren (graue Linie). Die Abbildung zeigt auch eindeutig die schnellen und großen ENSO-Temperaturoszillationen (rot), die in meinem Modell abzubilden nicht vorgesehen ist.

Wie das Widget zeigt, sagt mein Modell für die nahe Zukunft einen leichten Erwärmungstrend von 2011 bis 2016 voraus. Diese Modulation ist zurückzuführen auf den 9,1-jährigen (lunaren/solaren) und den 10 bis 11-jährigen (solaren/planetarischen) Zyklus, die beide gerade in ihre Warmphase getreten sind. Diese dekadische Verteilung sollte von den schnellen ENSO-Oszillationen überlagert werden, von denen erwartet wird, dass sie schnelle Perioden der Erwärmung und der Abkühlung während dieser fünf Jahre bringen, wie es von 2000 bis 2012 der Fall war. Folglich kann die Temperatur während der kühlenden La Nina-Phase (gegenwärtig im Gange) tatsächlich zurückgehen, aber das ist kein „Beweis“ dafür, dass mein Modell „falsch“ ist, wie Leif behauptet.

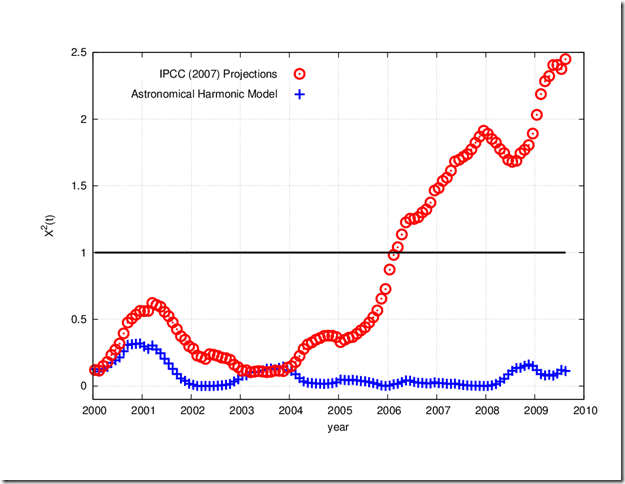

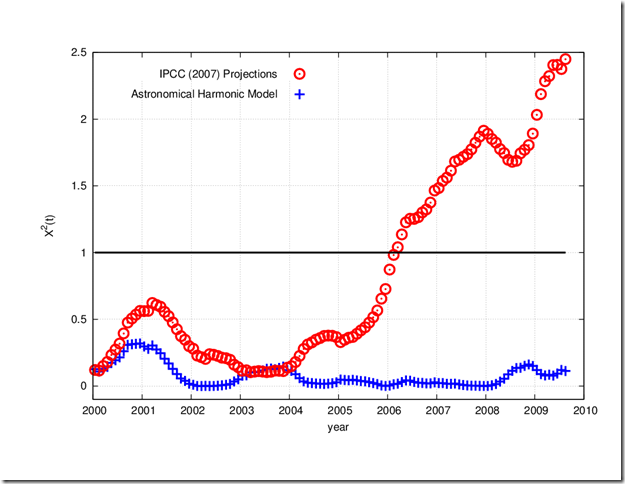

Zusätzlich zu den zahlreichen Tatsachenverdrehungen hat Leif natürlich auch in seinen Kommentaren niemals die gewaltige Diskrepanz zwischen den Daten und den IPCC-Projektionen angesprochen, um die es in diesem Widget geht. In meiner veröffentlichten Studie (1) habe ich in Abbildung 6 mit dem geeigneten statistischen Test mein Modell mit der Projektion des IPCC hinsichtlich der Temperatur verglichen. Diese Abbildung 6 folgt hier:

Die Abbildung zeigt eine Art statistischen Chi-Anpassungstest [?] zwischen den Modellen und der 4-jährigen geglätteten Temperaturkomponente mit der Zeit. Werte nahe 0 deuten darauf hin, dass das Modell sehr gut zu den Temperaturdaten passt, die sich innerhalb ihrer Fehlergrenze bewegt; Werte über 1 zeigen eine statistisch signifikante Abweichung vom Trend der Temperatur. Aus der Abbildung geht eindeutig hervor, dass mein Modell (blaue Kurve) sehr gut mit dieser Temperaturkomponente übereinstimmt, während die IPCC-Projektion immer schlechter wird und statistisch seit 2006 von der tatsächlichen Temperatur abweicht.

Ich erwarte nicht, dass Leif sein Verhalten mir und meiner Forschung gegenüber demnächst ändert. Ich möchte den Lesern dieses Blogs lediglich raten, vor allem jenen mit nur geringen wissenschaftlichen Kenntnissen, seine unfairen und unprofessionellen Kommentare mit gesundem Skeptizismus aufzunehmen.

2. Kritik am Abgleich der Basislinie zwischen den Daten und der IPCC-Projektion

Ein Leser dana1981 behauptet: „Ich glaube, dass Scafettas Plot zusätzlich verfälscht ist, weil er eine nicht korrekte Basislinie für HadCRUT3 benutzt. Das IPCC verwendet eine Basislinie von 1980 bis 1999, also sollte HadCRUT das auch tun!“

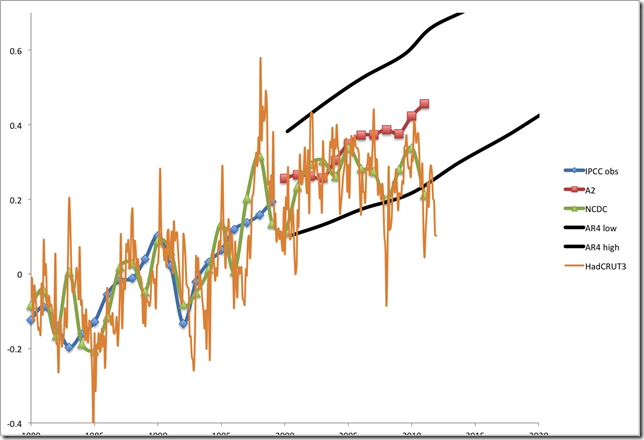

Dieser Leser bezog sich auch auf eine Abbildung bei skepticalscience, die hier der Bequemlichkeit halber folgt

Sie zeigt eine etwas niedrigere Basislinie für die Modellprojektion des IPCC relativ zur Temperaturaufzeichnung, was den Eindruck einer besseren Übereinstimmung zwischen den Daten und dem IPCC-Modell vermittelt.

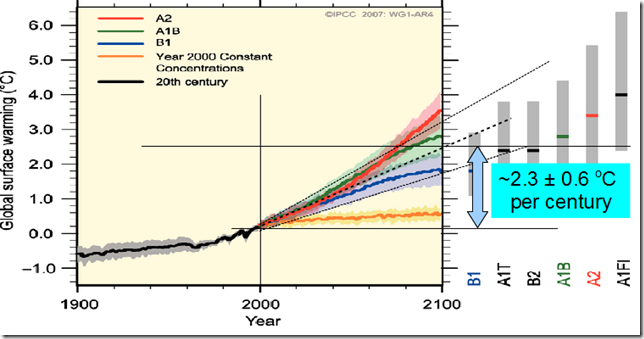

Die Position der Basislinie ist irrelevant, weil die IPCC-Modelle eine stetige Erwärmung mit einer Rate von 2,3°C pro Jahrhundert von 2000 bis 2020 angenommen haben, siehe die IPCC-Abbildung SPM.5. Siehe hier, mit meinen hinzu gefügten Zeilen und Kommentaren:

Im Gegenteil, der Temperaturtrend seit dem Jahr 2000 verlief fast flach, wie die Abbildung im Widget zeigt. Offensichtlich verändert eine Änderung der Basislinie nicht die Neigung des dekadischen Trends! Wenn man also die Basislinie der IPCC-Projektion nach unten verlegt, um die Illusion einer besseren Übereinstimmung mit den Daten zu vermitteln, ist das nichts als ein Trick.

In jedem Falle ist die in meinem Widget verwendete Basislinie die Richtige, während die Basislinie in der Abbildung bei skepticalscience falsch ist. Tatsächlich sind die IPCC-Modelle sorgfältig kalibriert worden, um den Trend von 1900 bis 2000 zu rekonstruieren. Folglich ist die korrekte Basislinie diejenige von 1900 bis 2000, und genau diese habe ich verwendet.

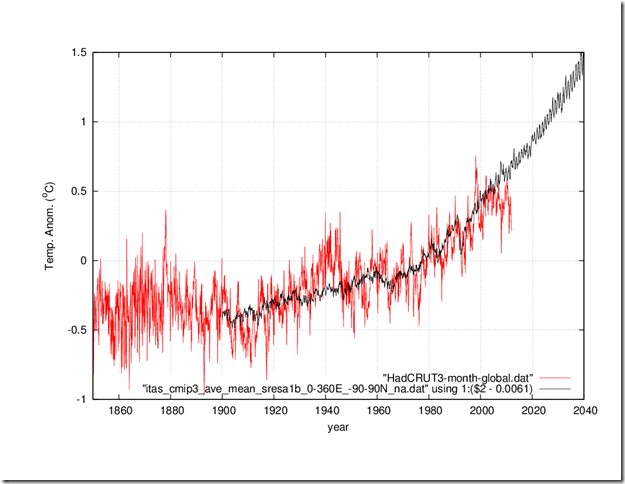

Um den Lesern dieses Blogs dabei zu helfen, selbst zu einem Urteil zu kommen, habe ich Anthony Watts die originalen HadCRUT3-Daten sowie diese IPCC-Rekonstruktion übermittelt. Sie sind in den folgenden beiden Dateien enthalten:

itas_cmip3_ave_mean_sresa1b_0-360E_-90-90N_na-data

Wie jedermann aus den beiden Datensätzen berechnen kann, beträgt das Temperaturmittel von 1900 bis 2000 -0,1402, während nach dem IPCC-Modell ein Wert bei -0,1341 zu erwarten ist.

Dies bedeutet, dass man, um die beiden Aufzeichnungen zu plotten, die folgende Programmzeile in das gnuplot-Programm einfügen muss:

plot “HadCRUT3-month-global.dat”, “itas_cmip3_ave_mean_sresa1b_0-360E_-90-90N_na.dat” using 1:($2 – 0.0061)

was von 1850 bis 2040 den folgenden Graphen ergibt:

Der Zeitraum seit dem Jahr 2000 zeigt exakt das, was auch mein Widget ergeben hat.

Die Abbildung oben beleuchtet auch die starken Abweichungen zwischen dem IPCC-Modell und der Temperatur, die ich explizit in meinen Studien untersucht habe, und in denen ich beweise, dass das IPCC-Modell nicht in der Lage ist, irgendeinen der in verschiedenen Zeiträumen beobachteten natürlichen Oszillationen zu rekonstruieren. Man schaue zum Beispiel auf den 60-jährigen Zyklus, den ich in meinen Studien ausführlich betrachte: von 1910 bis 1940 zeigen die Daten einen starken Erwärmungstrend, aber der Erwärmungstrend in den Modellen ist viel geringer; von 1940 bis 1970 zeigt sich in den Daten eine Abkühlung, während beim IPCC immer noch eine Erwärmung erkennbar ist; von 1970 bis 2000 zeigen beide Aufzeichnungen einen ähnlichen Trend (diese Periode ist diejenige, die ursprünglich verwendet worden ist, um die Sensitivitäten der Modelle zu kalibrieren); die starke Abweichung von 1940 bis 1970 sowie nach 2000, wobei das IPCC-Modell eine stetige Erwärmung um 2,3°C pro Jahrhundert annimmt, während die Temperatur einen stetigen schwingungsmodulierten Trend zeigt, den ich in meinem Widget und meinem Modell beleuchtet habe.

Wie ich in meiner Studie ausgeführt habe, hat das Scheitern des Modells hinsichtlich der Rekonstruktion des 60-Jahre-Zyklus’ große Konsequenzen bei der angemessenen Interpretation des anthropogenen Erwärmungseffektes beim Klima. Tatsächlich nehmen die IPCC-Modelle an, dass die Erwärmung zwischen 1970 und 200 zu 100% aus einem anthropogenen Antrieb resultiert (vergleiche die Abbildungen 9.5a und 9.5b im IPCC-Bericht), während der 60-jährige natürliche Zyklus (plus die anderen Zyklen) mindestens 2/3 zur Erwärmung von 1970 bis 2000 beigetragen haben, wie ich in meinen Studien nachgewiesen habe.

Schlussfolgernd lässt sich feststellen, dass die Basislinie in meinem Widget die Richtige ist (Basislinie 1900 bis 2000). Meine Kritiker bei skepticalscience versuchen einfach, das Scheitern der IPCC-Modelle bei der 60-jährigen Temperaturmodulation zu verstecken, indem lediglich die IPCC-Simulation seit 2000 geplottet wird, sowie durch das Absenken der Basislinie auf den Zeitraum 1960 bis 1990, welches nicht der ist, der es sein sollte, weil das Modell die Periode von 1900 bis 2000 hypothetisch rekonstruieren soll.

Es ist offensichtlich, dass ein Absenken der Basislinie eine größere Abweichung zu den Temperaturdaten vor 1960 erzeugt! Also hat sich skepticalscience eines kindischen Tricks bedient, um eine zu kleine Bettdecke von einem zu großen Bett zu ziehen. Wie auch immer, wenn wir die Basislinie 1961 bis 1990 benutzen, sollte deren Position im Originalmodell des IPCC um 0,0282 nach unten gezogen werden. Dann liegt sie um 0,0221°C unter der in der obigen Abbildung gezeigten Position, was nicht wirklich umwerfend ist.

In jedem Falle ist die Position der Basislinie nicht der Punkt; sondern das ist der dekadische Trend. Aber meine Basislinie 1900 bis 2000 liegt in der optimalen Position.

3. Kritik an den gewählten Rändern oben und unten im IPCC-Modell der mittleren Projektion (meine Bandbreite der grünen Zone im Widget)

Weitere Kritik, vor allem bei skepticalscience betrachtet die Bandbreite der Grenzen (grüne Zone im Widget), die ich verwendet habe. Sie argumentieren:

„Die meisten Leser würden den grünen Bereich in Scafettas Widget interpretieren als eine Region, in der das IPCC vertrauensvoll Beobachtungen erwartet, die nicht wirklich durch ein 1-sigma-Intervall eingehüllt werden, welches nur 68,2% der Daten überdeckt (unter Voraussetzung einer Gauss-Verteilung). Ein 2-sigma-Umschlag würde etwa 95% dieser Beobachtungen überdecken, und sollten die Beobachtungen noch außerhalb dieses größeren Bereichs liegen, wäre dies ein echter Grund zur Sorge. Folglich wäre es eine geeignetere Wahl für Scafettas grüne Einhüllende“.

Es gibt zahlreiche Probleme in dem Kommentar oben von skepticalscience.

Erstens, die Breite meiner grünen Zone (die eine Startphase von etwa ±0,1°C im Jahr 2000 hat), gleicht genau dem, was das IPCC in seiner Abbildung SPM.5 geplottet hat. Hier zeige ich eine Vergrößerung dieser Abbildung:

Die beiden von mir hinzugefügten roten Linien zeigen die Bandbreite im Jahr 2000 (schwarze vertikale Linie). Die Bandbreite zwischen den beiden horizontalen roten Linien beträgt im Jahr 2000 etwa 0,2°C, wie es auch im grünen Bereich in meinem Widget geplottet ist. … Mein grüner Bereich repräsentiert genau das, was das IPCC in seiner Abbildung zeigt, wie ich übrigens explizit in meiner Studie feststelle und zeige.

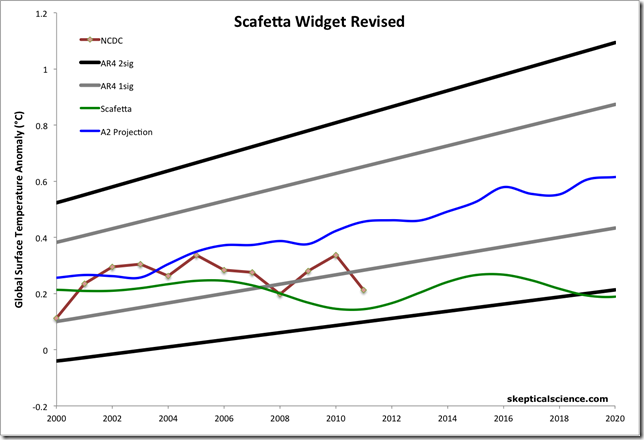

Zweitens, skepticalscience behauptet, dass man für einen korrekten Vergleich eine 2-Sigma-Einhüllung braucht [?], und sie haben die folgende Abbildung hinzu gefügt, um ihre Behauptung zu stützen:

Das von skepticalscience hoch gehaltene Argument lautet, weil die Temperaturwerte innerhalb ihrer 2-sigma-Einhüllung des IPCC-Modells liegen, dass die IPCC-Modelle nicht widerlegt sind, wie es aus meinem Widget hervorgeht. Man beachte, dass die grüne Kurve keine gute Rekonstruktion meines Modells ist und zu tief liegt: vergleiche mit meinem Widget.

Allerdings ist es ein Trick zu behaupten, um Leute ohne statistisches Hintergrundwissen zu täuschen, dass die Festlegung einer sehr großen Fehlergrenze in einem Modell bedeutet, dass dieses Modell gültig ist.

Übrigens, im Gegensatz zu der Behauptung bei skepticalscience wird in der Statistik die 1-sigma-Einhüllung verwendet; nicht 2-sigma oder 3-sigma. Mehr noch, das gute Modell ist dasjenige mit dem kleinsten Fehler, nicht das mit dem größten Fehler.

Wie ich in meiner Studie nachgewiesen habe, hat tatsächlich das von mir vorgeschlagene harmonische Modell eine statistische Genauigkeit von ±0,05°C, innerhalb der es sehr gut die dekadische und multidekadische Modulation der Temperatur rekonstruiert: siehe hier.

Im Gegenteil, wenn wir die oben gezeigte Abbildung von skepticalscience benutzen, haben wir im Jahr 2000 einen 1-sigma-Fehler von ±0,15°C und einen 2-sigma-Fehler von ±0,3°C. Diese erhebliche und dicke Fehlerbreiten sind 3 bis 6 mal größer als in meinem harmonischen Modell. Folglich wird aus den Behauptungen von skepticalscience selbst klar, dass mein Modell viel genauer ist als das, was die Modelle des IPCC garantieren können.

Weiter, die Behauptung von skepticalscience, dass wir eine 2-sigma-Fehlereinhüllung brauchen, beweist indirekt auch, dass die IPCC-Modelle nicht der wissenschaftlichen Methode entsprechend validiert werden können und daher nicht in das Umfeld der Wissenschaft gehören. Tatsächlich muss die Validierung einer Modellstrategie einen ausreichend kleinen Fehler aufweisen, um in der Lage zu sein zu testen, ob das Modell die sichtbaren Verteilungen in den Daten identifizieren und rekonstruieren kann. Diese Verteilungen sind gegeben durch die gefundenen dekadischen und multidekadischen Zyklen, die eine Amplitude unter ±0,15°C haben; siehe hier. Folglich wird die Amplitude der erkannten Zyklen deutlich unterhalb der 2-sigma-einhüllenden Amplitude von ±0,3°C bei skepticalscience liegen (sie würde sogar noch unter der 1-sigma-einhüllenden Amplitude von ±0,15°C liegen).

Wie ich ebenfalls ausführlich in meiner Studie bewiesen habe, ist die Einhüllende des IPCC-Modells viel größer als die Amplitude der Temperaturverteilungen, die die Modelle rekonstruieren sollen. Folglich können diese Modelle nicht angemessen validiert werden und sind daher nutzlos für jede brauchbare dekadische und multidekadische Vorhersage/Projektion für praktische Zwecke, weil ihr mit ihnen verbundene Fehler viel zu groß ist, als selbst skepticalscience zulassen würde.

Solange die Modelle nicht eine Präzision von mindestens ±0,05°C garantieren und die dekadischen Verteilungen rekonstruieren können, wie es bei meinem Modell der Fall ist, können sie dagegen nicht bestehen und sind unbrauchbar, und zwar alle.

4. Kritik an der demnächst kommenden Aufzeichnung von HadCRUT4.

Skepticalscience hat auch behauptet, dass „drittens Scafetta die HadCRUT3-Daten verwendet hat, die bekanntlich einen großen Bias aufweisen und die in Kürze durch die Daten von HadCRUT4 ersetzt werden“ (hier).

Die Daten von HadCRUT4 sind noch nicht verfügbar. Wir werden sehen was passiert, wenn das schließlich der Fall ist. Aus den Abbildungen hier geht nicht hervor, dass sie die Dinge drastisch verändern werden: die Differenz zu den HadCRUT3-Daten seit 2000 scheint lediglich bei 0,02°C zu liegen.

Für optimal passende Amplituden der Schwingungen in meinem Modell könnte in jedem Fall eine leichte Neukalibrierung erforderlich sein, aber HadCRUT4 zeigt eine klarere Abkühlung von 1940 bis 1970, die weiterhin einen 60-jährigen natürlichen Zyklus in meinem Modell stützt und weiterhin den IPCC-Modellen widerspricht. Siehe auch meine Studie zusammen mit Mazzarella, in der wir die HadSST3-Aufzeichnung bereits untersucht haben.

5. Kritik am langzeitlichen Trend

Es wurde dargelegt, dass der aufwärts gerichtete Trend wichtig ist, um die IPCC-Modelle und deren anthropogene Erwärmungstheorie zu stützen.

Wie ich jedoch in meiner Studie erklärt habe, ist 2/3 der Erwärmung zwischen 1970 und 2000 auf einen natürlichen Zyklus solaren/astronomischen Ursprungs zurückzuführen (oder sogar nur auf einen internen Ozeanzyklus allein). Daher ist der von den Modellen reproduzierte anthropogene Erwärmungstrend falsch und stark übertrieben. Dies lässt das meiste des langzeitlichen Erwärmungstrends von 1850 bis 2012 als Folge natürlicher Jahrhunderte langer Zyklen erscheinen, die auch in der Literatur gut bekannt sind.

Wie ich hier klar zum Ausdruck gebracht habe, sind in meinen veröffentlichten Studien die langzeitlichen und tausendjährigen Zyklen formal nicht enthalten, und zwar aus dem einfachen Grund, dass diese Zyklen erst genau identifiziert werden müssen: man kann sie nicht einfach irgendwo platzieren, und die globale Temperatur ist erst seit 1850 verfügbar, was ein zu kurzer Zeitraum ist, um diese längeren Zyklen genau zu lokalisieren und zu identifizieren.

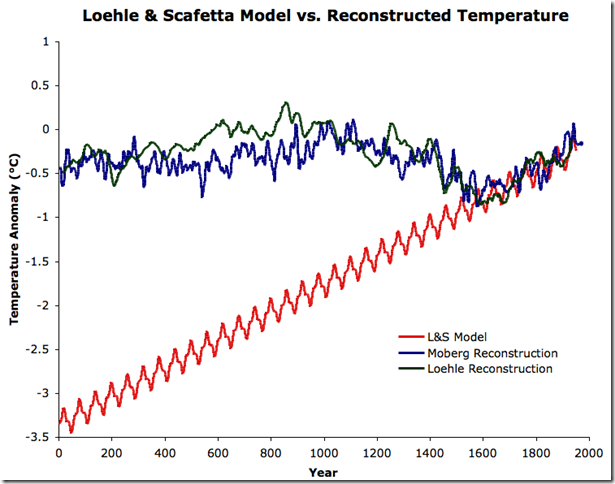

Im Einzelnen hat skepticalscience argumentiert, dass das vorgeschlagene Modell (von Loehle und Scafetta), das nur auf den 60-jährigen und den 20-jährigen Zyklen basiert plus einem linearen Trend von 1850 bis 1950 und extrapoliert bis höchstens 2100, falsch sein muss, weil es bei einer Extrapolation von 2000 Jahren klar von sinnvollen Verteilungen abweicht, die man aus Temperaturrekonstruktionen aus Proxy-Daten gewonnen hat. Ihre Abbildung findet sich hier und wird hier reproduziert:

Jeder smarte Mensch würde sofort verstehen, dass dies ein weiterer Trick von skepticalscience ist, die Ignoranten zu täuschen.

Wie wir in unserer Studie klar festgestellt haben, ist es offensichtlich, dass wir die langzeitlichen und tausendjährigen Zyklen ignorieren und den natürlichen tausendjährigen harmonischen Trend lediglich approximieren mit einer linearen Approximation erster Ordnung, von der wir annehmen, dass sie sinnvoll auf 100 Jahre ausgedehnt werden kann, aber nicht länger. Es ist offensichtlich, dass es eine Dummheit ist, wenn man nicht unehrlich ist, dies für 2000 Jahre zu extrapolieren und zu behaupten, dass die Daten unseren Ergebnissen widersprechen. Siehe den ausführlichen Kommentar von Loehle und Scafetta.

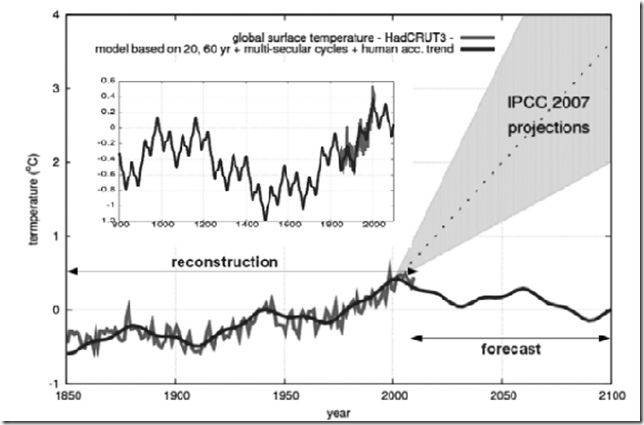

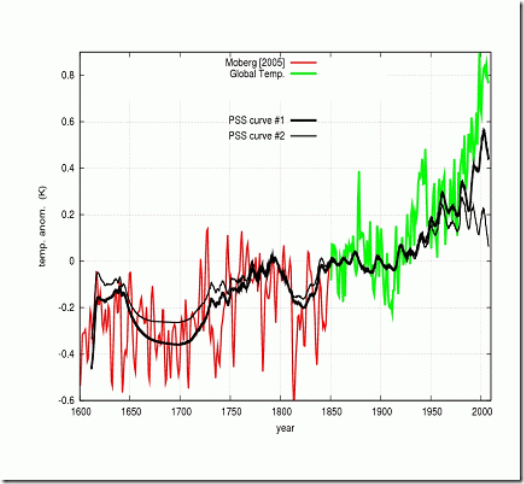

Wie oben dargelegt wurden die langzeitlichen und tausendjährigen Zyklen absichtlich ausgeschlossen. Allerdings habe ich schon in einer vorläufigen Rekonstruktion 2010 mit diesen längeren Zyklen eingeschlossen veröffentlicht (leider nur in italienisch). Die Abbildung 6 aus dieser Studie ist diese:

Allerdings sind die Zyklen im obigen Modell nicht optimiert, was in Zukunft nachgeholt wird. Aber es ist ausreichend um zu zeigen, wie ideologisch naiv (und falsch) die Behauptung von skepticalscience ist.

In jedem Falle behandle ich den langzeitlichen Trend und seine Verbindung mit der solaren Modulation ausführlich in meinen früheren Studien seit 2005. Die letzte Studie, die sich auf diesen Punkt konzentriert, wird hier und noch ausführlicher hier besprochen. Die relevante Abbildung daraus folgt hier:

Die schwarzen Kurven repräsentieren die empirische Rekonstruktion der solaren Signatur im langzeitlichen Trend seit 1600. Die Kurve mit dem aufwärts gerichteten Trend seit 1970 wurde erstellt durch Verwendung des ACRIM TSI-Komposits (welches mit dem 60-jährigen Zyklus kompatibel ist). Die anderen Signaturen verwenden das PMOD TSI-Komposit, welche durch Manipulation von einigen Satellitenaufzeichnungen zustande gekommen ist mit der Entschuldigung, dass diese falsch seien.

Solange also die langzeitlichen und tausendjährigen Zyklen nicht akkurat identifiziert und angemessen in die harmonischen Modelle eingebaut sind, muss man die Studien mit den langzeitlichen TSI-Proxy-Rekonstruktionen verwenden, um den Vergleich mit langzeitlichen Trends zu verstehen, wie in meinen Veröffentlichungen von 2005 bis 2010. Deren Ergebnisse stehen in perfekter Übereinstimmung mit dem, was wir den jüngsten Studien entnehmen können, die sich auf astronomische Schwingungen konzentrieren und implizieren, dass nicht mehr als 0,2°C bis 0,3°C der seit 1850 beobachteten Erwärmung von 0,8°C mit anthropogenen Aktivitäten in Verbindung gebracht werden können. (Man lasse sich nicht durch die Kritik von Benestad und Schmidt 2009 täuschen, die mit empörenden mathematischen Fehlern gespickt ist und dessen Performanz des GISS-ModellsE in meinen letzten Studien stark in Frage gestellt worden ist, zusammen mit jenen der IPCC-Modelle).

Ich danke Anthony Watts für die Einladung, und ich entschuldige mich für die Übersetzungsfehler, die der obige Artikel sicher enthält*

N. Scarfetta

weiterführender Link hier

*Kursiv vom Übersetzer, der sich der Entschuldigung des Autors hinsichtlich seiner Übersetzung vom Italienischen ins Englische nur anschließen kann

Relevante Studien:

[1] Nicola Scafetta, “Testing an astronomically based decadal-scale empirical harmonic climate model versus the IPCC (2007) general circulation climate models.” Journal of Atmospheric and Solar-Terrestrial Physics, (2012). DOI: 10.1016/j.jastp.2011.12.005

[2] Adriano Mazzarella and Nicola Scafetta, “Evidences for a quasi 60-year North Atlantic Oscillation since 1700 and its meaning for global climate change.” Theor. Appl. Climatol. (2011). DOI: 10.1007/s00704-011-0499-4

[3] Craig Loehle and Nicola Scafetta, “Climate Change Attribution Using Empirical Decomposition of Climatic Data.” The Open Atmospheric Science Journal 5, 74-86 (2011). DOI: 10.2174/1874282301105010074

[4] Nicola Scafetta, “A shared frequency set between the historical mid-latitude aurora records and the global surface temperature.” Journal of Atmospheric and Solar-Terrestrial Physics 74, 145-163 (2012). DOI: 10.1016/j.jastp.2011.10.013

[5] Nicola Scafetta, “Empirical evidence for a celestial origin of the climate oscillations and its implications.” Journal of Atmospheric and Solar-Terrestrial Physics 72, 951–970 (2010). DOI: 10.1016/j.jastp.2010.04.015

Zusätzliche Mitteilungen und interessante Links:

Global Warming? No, Natural, Predictable Climate Change, Larry Bell

http://scienceandpublicpolicy.org/images/stories/papers/reprint/astronomical_harmonics.pd

Link: http://wattsupwiththat.com/2012/03/11/scafetta-prediction-widget-update/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Das absolut Neue+Signifikanz von Scafetta liegt in einer ERSTMALIGEN Darstellung des Planetenumlaufes, dem 20 +60 Jahr-planetarischem Zyklus im Verhaeltnis zum Klima („eine Astro-Climate Connection“). Diese wurde bislang immer abgestritten. Alle heutigen Klima-alarmisten, sei es Latif, Rahmstorf, Stocker…egal wie sie heissen…. haben hoechste ANGST, dass die

Beziehung: planetarischer Umlauf und Klima ueberhaupt angesprochen wird: Alle diese reagieren sofort unwirsch, ablehnend, versteckend: „Da gaebe es keine Zyklen, da ist keine Klimawirkung…..“ Reine Erfindung… und nur Alarmistenluege wie immer.

Dagegen zeigt Scafetta hier den mittelfristigen 20/60 Jahr-Zyklus, hat allerdings vorerst den langfristigen Jahrhundertezyklus zur Seite gestellt fuer dann spaeter im Jahr… Den Jahrhundertezyklus gibts uebrigens in ISBN 978-3-86805-604-4 bei Amazon.de. Und wenn dann beide zusammen dargestellt sind als Einheit, dann koennen alle Alarmisten einpacken (ich habe sie informiert, und sie wissen bereits: ihre Uhr laeuft ab, es ist schon 5 vor 12…)

JS

Es besteht also KEIN ZWEIFEL,

dass Scarfetta´s Prognosen besser waren als die des IPCC

“ … dass nicht mehr als 0,2°C bis 0,3°C der seit 1850 beobachteten Erwärmung ..“

womit wir allmälig bei 0,0 für den „antropogenen Anteil“ angelangt sind 🙂

Mit den „Harmonien“ ist das so eine Sache … ,

Chaos (Wetter) bringt auch stabile (dynamische) Zustände hervor (Attraktoren), harmonisch würde ich sie trotzdem nicht nennen

und leider auch nicht vorhersagbar.

Eine ganz wesentliche Kritik an dem IPCC ist also die Behauptung der „sicheren“ Vorhersage, die sich bisher als falsch herausgestellt hat

und an der trotzdem weiter festgehalten wird, schmerzhaft festgehalten wird mit unbegründbaren Sanktionen für die Menschheit.

mfG

EIKE kann einpacken! 🙂

Nobelpreis für Leipzig!

entnommen aus „Achse des Guten“, von M. Miersch (als Fundstück).

Aufschlussreich ist die Erkenntnis: CO2 löst die Ozonschicht auf.

Auch interessant das der Link zum Strategiepapier der Bunderegierung von 2008.

http://tinyurl.com/2wpv28z

http://tinyurl.com/8xt7y5o

Scafettas Theorie erinnert mich etwas an die mathematischen Methoden der 70er Jahre für Kernmodelle. Die mathematische Überlagerung verschiedener Schwingungen mit unterschiedlichen Gewichtungsfaktoren und Frequenzen ergibt in der Tat eine gelungenes Abbild der bekannten Temperaturgänge der letzten 1500 Jahren. Das ist faszinierend, allerdings fehlt mir die Physik dahinter, d.h. die vermutlich solaren Einflüsse und natürlich auch der CO2 Absorptionseffekt einschließlich anderer absorbierender Spurengase in der Atmosphäre. Falls es möglich sein wird, Physik der Sonne und der Atmosphäre und Scafettas Mathematik zu verbinden, dann dürfte der Weg zu einer glaubwürdigen Zukunftsvorhersage der Temperatur nicht mehr weit sein.

Ob diese Bemerkungen wohl stimmen?

Ich will mir hier kein Urteil über Mr. Scafettas Theorie erlauben, denn dazu müßte ich mich sehr viel intensiver damit beschäftigen und diese Zeit fehlt mir. Aber ein oberflächliches Lesen erinnert mich doch sehr an die die Theorien von Th. Landscheidt, dem es nach meiner Erinnerung u. a. sehr gut gelungen ist El Ninos sehr genau vorherzusagen.

MfG

H. Urbahn