Ganz offensichtlich wird die Wirkung des anthropogenen Treibhauseffekts weit überschätzt, denn insbesondere der CO2-Treibhauseffekt war im wesentlichem schon zu Zeiten Goethes ausgereizt. Dies zeigen eigene quantitative Untersuchungen der IR-Absorption von Kohlendioxid mittels eines FT-IR-Spektrometers. Außerdem gibt es Äußerungen hierzu in der anerkannten Literatur, die offiziell allerdings heruntergespielt werden (23). Wegen des weitgehenden Sättigungseffekts ist der anthropogene Anteil der Treibhausgase für die gegenwärtige Klimaänderung von untergeordneter Bedeutung. Vielmehr geht die Varianz der Erdoberflächentemperatur mit der Wolkenbedeckung einher, die wiederum von der Fluktuation des solaren Magnetfelds abhängt. Mit anderen Worten: ähnlich wie ein offenes Kaminfeuers durch einen Paravent mehr oder weniger abgeschirmt wird, so steuert die Wolkendichte die Erdoberflächentemperatur weit stärker als der Treibhauseffekt. Der Einfluss der Wolkenbedeckung lässt sich aber mit den Klimamodellen des IPCC nur äußerst unzulänglich abbilden. Auch sind Klimamodelle möglicherweise auch deshalb ein spektroskopisches Artefakt, weil sie mit gewillkürten Flusskorrekturen arbeiten müssen, deren Beträge den des anthropogenen Treibhauseffekts um ein Vielfaches übersteigen.

Einleitung

Oftmals wird fälschlicherweise angenommen, der Treibhauseffekt sei mit der Absorption von Infrarotstrahlung (IR-Strahlung) durch atmosphärische Spurengase (CO2, CH4, Wasserdampf u. a.) identisch. Dadurch würde sich die Luft erwärmen, die dann ihre Wärmeenergie auf die Erdoberfläche übertrage. Es verhält sich genau umgekehrt: Die Erdoberfläche wird fast ausschließlich durch Bestrahlung erwärmt und die Atmosphäre nimmt ihre Wärmeenergie durch direkten Kontakt mit dem Erdboden auf.

Die Bestrahlung der Erdoberfläche setzt sich aber aus zwei Teilen zusammen:

1. Die direkte Solareinstrahlung (abhängig von der Wolkenbedeckung)

2. Der atmosphärische Treibhauseffekt (im wesentlichem ausgereizt)

Die Existenz einer atmosphärischen Gegenstrahlung, die den Treibhauseffekt charakterisiert, lässt sich zwar leicht nachweisen, aber bereits die Größenordnung des natürlichen Treibhauseffekts kann nur berechnet werden und die ihm zugeschriebene Auswirkung auf das Klima entzieht sich vollkommen der Falsifikation (18). Zum Verständnis des CO2-Treibhauseffekts ist es dennoch nützlich, sich zunächst einmal die „ganz normale“ Infrarot-Absorption atmosphärischer Spurengases zu betrachten (1).

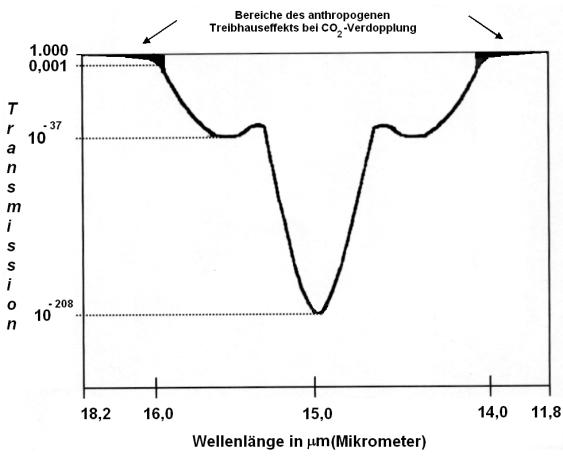

Nimmt man einmal an, die auf der IR-Absorption beruhende Extinktion (E) würde innerhalb der Troposphäre (bis ca. 10 km Höhe) bei heutiger CO2-Konzentration in der Größenordnung von E = 2 im Maximum des Absorptionspeaks liegen, d.h. die Transmission T = I/I0 = 10-E wäre auf 0,01 reduziert, dann wäre es für jeden, der mit den Grundlagen der quantitativen IR-Spektroskopie vertraut ist, offensichtlich, dass eine Verdopplung des CO2 zu einer merklichenTemperaturerhöhung führen müsste. Tatsächlich liegt aber die Extinktion um viele Zehnerpotenzen höher. Deshalb ist nach einer einfachen Abschätzung von Jack Barrett (2) der maximal mögliche Treibhauseffekt schon nach einem Weg von 100 m über dem Erdboden erreicht. Tatsächlich liegt eine weitestgehende Sättigung aber keine Komplettsättigung vor. Die gibt es nicht aus quantenmechanischen Gründen.

In der Literatur werden vielfach Emissionsspektren (3) oder gelegentlich auch Absorptionsspektren (4) des CO2 gezeigt. Was einen Chemiker aber besonders interessiert, ist eine Abschätzung der Sättigung des Effekts mit Hilfe molarer Extinktionskoeffizienten der einzelnen Absorptionsbanden. CO2 ist zwar das mit am intensivsten untersuchte Molekül, weshalb man auch genügend quantitative Angaben aus der Literatur beziehen kann und natürlich gibt es die HITRAN-Spektren (5). Dennoch existieren offensichtlich unterschiedliche Vorstellungen. Auch unterliegt die prophezeite Klimaerwärmung großen Schwankungen, wobei in der Vergangenheit Angaben von 1,2 °C bis 11,5 °C bei CO2-Verdopplung genannt wurden. Dies war Anlass zu eigenen überschlagsmäßigen Messungen (6).

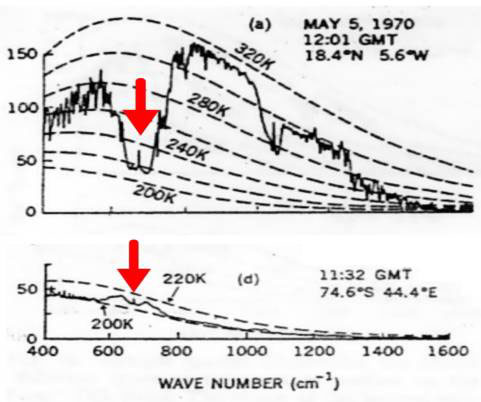

Zunächst muss aber geklärt werden, welche der Absorptions-/Emissionsbande des CO2 von Bedeutung ist. Hierüber geben Satellitenspektren Auskunft (3).

|

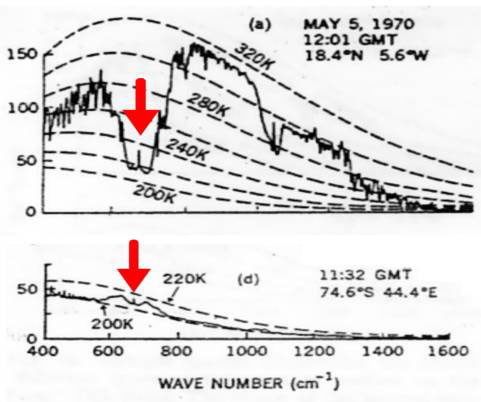

Bild 1: Satellitenspektren, oben über der Sahara, unten über der Antarktis

Die gestrichelten Linien im Bild 1 ist die ideale Planck-Strahlungskurve der Erdoberfläche berechnet bei unterschiedlichen Temperaturen in K. Die „gezackte Linien“ repräsentieren neben der ungehinderten Emission der Erdoberfläche (ca. 800 – 1000 cm-1 und ca. 1050 – 1300 cm-1) die Emissionsgraphen der atmosphärischen Treibhausgase. Die roten Pfeile im Bild 1 kennzeichnen die n2-Bande um 15 mm (667 cm-1). Deshalb ist nur diese relativ schwache von Bedeutung und nicht die wesentlich stärkere n3-Bande um 4,2 mm (2349 cm-1). Außerdem erkennt man, die Atmosphäre emittiert tatsächlich IR-Strahlung („Treibhauseffekt“) Dies sieht man ganz deutlich im Satellitenspektrum über der Arktis (unterer Teil im Bild 1). Die Bodentemperatur beträgt dort nämlich ca. 200 K (-73 °C), während die Atmosphäre in etwa 10 km Höhe eine höhere Temperatur von ca. 210 K (-63 °C) aufweist. Dies ist aber ein erster Hinweis darauf, dass der den IPCC-Computermodellen zugrunde liegende Strahlungstransport eine Fiktion ist. Es handelt sich vielmehr um einenEnergietransport. Dabei gelangt wärmere Luft zur Arktis und gibt ihre Energie oberhalb einer Höhe von 10 km als „ungestörte Emission“ ins Weltall ab.

1. Die Meßmethode

Zunächst soll die eigene Messung der Absorption des Kohlendioxids beschrieben werden. Eine 10 cm-Küvette mit IR-durchlässigem Fenster wurde mit synthetischer CO2-freier und wasserfreier Luft gefüllt. Danach wurde soviel CO2 mit einer Mikroliterspritze zugegeben, dass 357 ppm CO2 zugegen waren (Konzentration von 1993). Weiter wurden 2,6 % Wasserdampf zugegeben. Als IR-Strahlungsquelle diente ein Globar, ein elektrisch auf 1000-1200 ºC geheizter Siliziumkarbid-Stab mit nachgeschaltetem variablen Interferenzfilter. Nach der Aufnahme dieses Spektrums wurde mit CO2 aufgestockt, so dass 714 ppm enthalten waren. Die Messung erfolgte mit einem FT-IR-Spektrometer „Bruker IFS 48“. Als Auswertungssoftware diente das Programm OPUS. Ein Nullwert wurde ebenfalls aufgenommen und entsprechend subtrahiert.

1.1 Messung und Auswertung

Bild 2 zeigt das unbearbeitete Spektrum der 15 µm-Bande für 357 ppm CO2 und 2.6% H2O.

|

Bild 2: Unbearbeitetes Spektrum der 15 µm-Bande (n2-Bande)

Deutlich sind der R- (DJ = + 1) und der P- (DJ = – 1) sowie der Q-Zweig (DJ = +/- 0) der n2-Bande zu erkennen. Der Extinktionskoeffizient im Maximum ergab sich zu:

e = 20,2 m2 mol-1 (n2 bei 667 cm-1)

Um die Absorption zu berechnen, wurde der durchschnittliche CO2-Gehalt der Atmosphäre mit c = 1,03.10-3 mol/m3angenommen (aus der Gesamtstoffmenge und dem Volumen der Homosphäre). Setzt man die oben gemessenen molaren Extinktionen nebst der Konzentration und der Schichtdicke der Troposphäre (h = 10 km = 104 m) in das Lambert-Beer’sche-Gesetz ein, so erhält man

E(n2) = 20,2 m2 mol-1 × 1,03.10-3 mol/m3 × 104 m = 208

Dies bedeutet, dass die Transmissionen in der Mitte der Absorptionsbande bei den um 1997 gegebenen 357 ppm CO2 beiT(n2) = 10-208 liegt (Bild 3).

|

Bild 3: Spektrales Auswertungsschema

Dies ist ein extrem geringer Transmissionswert, der eine Steigerung des Treibhauseffektes bei Verdopplung des klimawirksamen Spurengases in diesem Bereich vollkommen ausschließt. Ähnliche Ergebnisse hat Jack Barrett anhand spektroskopischer und kinetischer Überlegungen (2) gefunden und damit prompt in ein Wespennest gestochen, weshalb 1995 von ihm eine äußerst heftige Diskussion angefacht wurde (7 – 10).

Setzt man den molaren Extinktionskoeffizient e für die n2-Bande sowie die Volumenkonzentration in mol/m3 (357 ppm CO2) in das Lambert-Beersche-Gesetz ein und nimmt eine Schichtdicke von 10 m an, resultiert eine Extinktion von

E = 20,2 m2 mol-1 × 0,0159 mol/m3× 10 m = 3,21

Dies entspricht einer Transmission von T = 10-3.21 = 0,6 Promille. Mit anderen Worten: Bereits nach 10 m sind 1 – T = 99,94% der IR-Strahlung absorbiert.

Bei der Absorption an den Peakflanken ist die Extinktion naturgemäß kleiner. Deshalb schreibt das IPCC1990 „The effect of added carbon dioxide molecules is, however, significant at the edges of the 15 µm band, and in particular around 13,7 and 16 µm (13)“. Natürlich existieren diese Ränder, denn die Rotationsquantenzahl J geht von J = + 1 bis J = + ¥ und vonJ = – 1 bis J = – ¥. Bedauerlicherweise werden aber die ungesättigten Bereiche an den Rändern immer schwächer. Die Besetzung der Rotationsniveaus gehorcht nämlich einer Boltzmann-Verteilung, weshalb immer weniger der vorliegenden CO2-Moleküle zu einem gegebenen Zeitpunkt in diesem Bereich absorbieren.

Um die Absorption an den Peakflanken abzuschätzen, wurde als Arbeitshypothese angenommen, die Extinktion soll sich bei Verdopplung des CO2-Gehalts um die Größenordnung E = 3 (T = 10-3) erhöhen. Hierzu wurde das Gesamtintegral der Banden bis zu den auslaufenden Enden des R- und P-Zweiges bei E = 0 ermittelt (s. Bild. 3). Anschließend wurden die digital abgespeicherten Spektren ab einer Extinktion, die dem Wert E = 3 (auf den Gesamtweg innerhalb der Troposphäre bezogen) entsprachen bis zu den auslaufenden Enden (E = 0) des R- und P-Zweiges integriert. Damit waren die „edges„ annähernd erfasst. Diese „edges„ begannen beim P-Zweig bei 14,00 µm und beim R-Zweig bei 15,80 µm und liefen jeweils bis zur Grundlinie E = 0. IPCC lässt die Banden an den Rändern bei 13,7 und 16 µm beginnen (13). Für die n2-Bande ergab sich folgendes:

| 15 µm-Bande | 357 ppm | 714 ppm |

| Gesamtintegral 624,04 cm -1 von 703,84 cm -1 | 0,5171/cm | 1,4678/cm |

| Summe der Flanken-Integrale | 1,11.10-4/cm | 9,79.10-4/cm |

Tabelle: 15 µm-Bande (Gesamtintegral und Flankenintegrale E = 0 bis E = 3)

Der relative Zuwachs des Treibhauseffekts bezogen auf das Gesamtintegral ist entscheidend. Er entspricht der Differenz der Flankenintegrale bei 714 ppm und 357 ppm im Verhältnis zum Gesamtintegral bei 357 ppm.

(9,79.10-4/cm – 1.11.10-4/cm) / 0,5171/cm = 0,17 %

Weil man mit der Planck-Strahlungsgleichung arbeiten muss, sind Extinktionen weniger geeignet, den Treibhauseffekt zu quantifizieren, dennoch zeigen sie sehr gut die Relationen, um die es beim anthropogenen Treibhauseffekt geht (Bild 3). Auch sind die oben angegebenen Messwerte relativ ungenau; sie werden aber durch die Aussage des Nobelpreisträges Paul Crutzen gestützt. Dieser schrieb1993 in einem Lehrbuch (20): „Es gibt bereits so viel CO2 in der Atmosphäre, dass in vielen Spektralbereichen die Aufnahme durch CO2 fast vollständig ist, und zusätzliches CO2 spielt keine große Rolle mehr.“ Man kann es auch so ausdrücken: Ein Treibhaus heizt sich bestenfalls geringfügig (Spureneffekt!) stärker auf, wenn man das normale Fensterglas gegen ein zehn Zentimeter dickes Panzerglas austauscht!

2. Vergleich mit den offiziellen Daten des IPCC

Das zur Messung verwendete und in der Chemie übliche FT-IR-Spektrometer besitzt nur einen Spiegelweg von 5 cm. Dies ergibt eine Auflösung der IR-Banden von 0,2 cm-1. Da die „ungesättigten“ Spektralbereiche ungewöhnlich schwache IR-Banden betrifft, benötigt man Spektrometer, die eine Auflösung von 0,0004 cm-1 erbringen (5). Hierzu muss man ein FT-IR-Spektrometer bauen, das theoretisch über einen Spiegelweg von 25.000 cm (25 m!) verfügt. Nur dann lassen sich dieäußerst schwachen IR-Banden messen, auf die sich die Klimamodellierer des IPCC stützen. Es sind Banden, mit einer „Absorptionsstärke“ von nur 0,05 % der 15 mm CO2-Hauptbande! Da Spiegelwege von 25 m technisch schwierig realisierbar sind, misst man reines CO2 unter höheren Druck und mit käuflichen Geräten, die über Spiegelwege bis zu 10 m verfügen. Die derart gewonnenen Extinktionskoeffizienten sind in der HITRAN-Datenbank abgelegt, welche zur Berechnung des Strahlungsantriebs („radiative forcing“) bei weiterer Steigerung der Treibhausgase (CO2, CH4 usw.) dient. Nimmt man die offiziellen Zahlen (IPCC), dann beträgt der „natürliche“ Treibhauseffekt“ 324 W/m2 (21). Bei Verdopplung des CO2 (100 % Steigerung!) wird nach Übereinkunft („best guess“ aus Computermodellrechnungen) angenommen, dass sich der Strahlungsantrieb um 3,7 W/m2 erhöht (22, 23). Im Bild 4 sind die Verhältnisse dargestellt.

|

Bild 4: Prozentuale Erhöhung des Treibhauseffekts bei Verdopplung des atmosphärischen CO2-Gehalts gemäß der offiziellen Angaben des IPCC

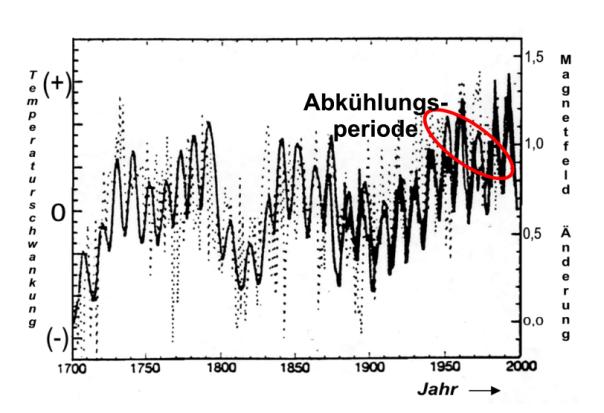

Auch das Bild 4 belegt eindeutig die oben beschriebene weitestgehende Sättigung denn die Steigerung des Treibhauseffekts bei CO2-Verdopplung beträgt nur geringfügige 1,2 %. Dies ist in der Klimaforschung bekannt. Deshalb wird versucht, den „Sättigungscharakter mit dem Argument zu entkräften, das Klima sei ein so empfindliches System, dass es bereits von kleinsten Änderungen des Strahlungsantriebs aus dem Gleichgewicht gebracht werden kann. So wird behauptet, die Abkühlung zwischen 1930 und 1970 sei durch die Staubbelastung der Industriegesellschaft verursacht. Dies ist falsch. Die Abkühlung war durch das geänderte Magnetfeld der Sonne verursacht, wie aus dem Bild 11 (rot eingekreist) hervorgeht.

3. Erdoberflächentemperatur, Treibhauseffekt und CO2-Konzentration

Zur Berechnung der irdischen Oberflächentemperatur ohne Treibhausgasatmosphäre benutzt man eine einfache Gleichung, die auf dem Stefan-Boltzmann- Gesetz beruht.

|

(Gleichung 1)

A ist dabei die Albedo – das durchschnittliche „Rückstrahlvermögen“ der Erde. Sie wird mit A= 0,3 angenommen. Tatsächlich existierten in der Vergangenheit auch andere Angaben. Die Solarkonstante, die in Wirklichkeit gar nicht so konstant ist, hat den Wert Fs = 1368 W/m2. Weiterhin enthält die Gleichung die Stefan-Boltzmann-Konstante s = 5,67 .10-8 W.m-2.K-4.

Rechnet man mit diesen Angaben, so resultiert für die Oberflächentemperatur der Erde:

|

Dieses Ergebnis ist fragwürdig, weil die Erde kein wasserloser Gesteinshaufen im Weltall ist. Sehr wahrscheinlich liegt die irdische Mitteltemperatur ohne Treibhausgase um einiges höher! Aber bleibt man zunächst einmal dabei, dann beträgt die spezifische Ausstrahlung der Erdoberfläche bei dieser Temperatur (Formelzeichen M nach DIN 5031, Teil 1):

M1 = (1-0,7) . 0,25 . 1368 W/m2 = 239 W/m2

Für die Klimanormalperiode bezeichnet, hat man sich vor Jahren unter Konsensbildung auf eine Mitteltemperatur von + 15 °C (T = 288 K) geeinigt. Benutzt man jetzt das „unveränderte“ Stefan-Boltzmann-Gesetz

M2 = s . T4 (Gleichung 2)

und berechnet damit die spezifische Ausstrahlung der Eroberfläche erneut, resultiert:

M2 = s . T4 = 5,67 . 10-8 W.m-2.K-4 . (288 K)4 = 390,0 W.m-2

Folglich erhöht der „natürliche“ Treibhauseffekt, mit einer hypothetische Erwärmung von DT = 288 K – 225 K = 33 K(33 °C), die spezifische Ausstrahlung der Erdoberfläche um

DM = M2 – M1 = 390,0 W/m2 – 239,0 W/m2 = 151 W/m2

Wie bereits oben erläutert, wird bei Verdopplung des CO2 (100 %ige Steigerung) ein zusätzlicher Strahlungsantrieb von 3,7 W.m-2 angenommen (die Größenordnung entzieht sich der Falsifikation und beruht auf Konsens – „best guess“!). Dadurch steigt die spezifische Ausstrahlung der Eroberfläche von 390,0 W.m-2 auf 393,7 W.m-2. Setzt man diesen Wert in die Stefan-Boltzmann-Gleichung (Gleichung 2) ein, resultiert als Erdoberflächentemperatur:

|

Demnach erhöht sich die Temperatur bei CO2-Verdopplung (100 % mehr CO2!) von 288,0 K auf 288,7 K. Das entspricht gerade einmal DT = 288,7 K – 288,0 K = 0,7 K (0,7 °C) und nicht mehr. Die Klimamodellierung hätte keinerlei politische Beachtung gefunden, wenn man nicht die Hypothese der Wasserdampfverstärkung in die Diskussion eingebracht hätte. Dies lässt sich jedoch glücklicherweise falsifizieren, wie im nächsten Absatz dargelegt wird.

4. Die Wasserdampfverstärkung

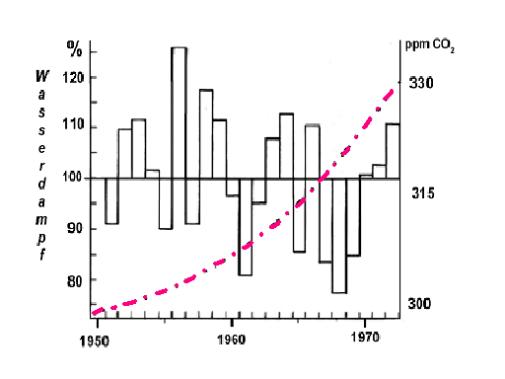

Da eine Erwärmung von lediglich 0,7 °C bei 100 % mehr CO2 zu wenig erscheint, hat man sich vor Jahren darauf geeinigt, dass diese geringfügige Temperaturerhöhung gemäß der altbekannten Clausius-Clapeyronschen-Gleichungdeutlich mehr Wasser aus den Ozeanen verdunsten lasse. Da Wasserdampf selbst ein Treibhausgas sei, fällt dadurch die von CO2 verursachte Temperaturerhöhung wesentlich höher aus. Originalton IPCC (24): „Der Wasserdampf-Feedback’ ist nach wie vor der durchweg wichtigste Rückkopplungseffekt, der die von den allgemeinen Zirkulationsmodellen als Reaktion auf eine CO2-Verdopplung vorhergesagte globale Erwärmung verursacht.“ Wenn dies richtig ist, muss besonders in einer kälteren Periode, während der die direkte Solarstrahlung nicht so viel Wasser verdunsten lässt, der Wasserdampfgehalt über den Ozeanen mit dem atmosphärischen CO2-Gehalt ansteigen. Dies ist eindeutig nicht der Fall, wie das Bild 5 belegt (31). Deshalb können sich die Klimamodellierer auf keinen Fall auf den durchaus einleuchtenden, hypothetischen Wasserdampfverstärkungsmechanismus berufen, der eine viel zu große Temperatursteigerung prophezeit.

|

Bild 5: Prozentuale Abweichung des Wasserdampfgehalts über dem Atlantik (33)

Um Missverständnissen vorzubeugen: Mit der Prozentangabe im Bild 5 ist natürlich nicht die relative Luftfeuchte gemeint, die niemals höher als 100 % sein kann, sondern vielmehr die Abweichung des Wasserdampfgehalts nach oben und nach unten um den Messwert von 1950. So liegt der absolute Wasserdampfgehalt 1956 um 25 % höher als 1950. 1968 liegt der Wasserdampfgehalt um ca. 45 % niedriger, obwohl der CO2-Gehalt weiter angestiegen ist!

5. Die Strahlungstransportgleichung

Bei der Berechnung des Treibhauseffekts wird ein „Schicht- oder Kaskadenmodell“ zugrunde gelegt nach dem innerhalb der Atmosphäre eine ständige Absorption (I) und Emission (L) stattfindet. Diesem fiktiven Strahlungstransport liegt dieSchwarzschildgleichung zugrunde (11). Bei einem infinitesimalen Weg dz, dem Absorptionskoeffizienten sa und der Teilchenzahl n gilt hierfür im lokalen thermodynamischen Strahlungsgleichgewicht (LTE):

![]()

(Gleichung 3)

Die Größe L ist hierbei die Strahldichte (vgl. DIN 5031, Teil 1), welche die Emission gemäß der temperaturabhängigenPlanck-Strahlungsgleichung angibt.

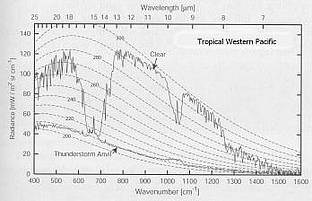

Dass innerhalb der Atmosphäre ein Strahlungstransport stattfindet, meint man belegen zu können, indem man die gemessenen Satellitenspektren mit den berechneten vergleicht. Das Ergebnis ist verblüffend, wie das Bild 6 belegt.

|

Bild 6: Links das gemessene Emissionsspektrum der Erde (Satellitenspektrum); rechts das mit Hilfe der Strahlungstransportgleichung berechnete Emissionsspektrum

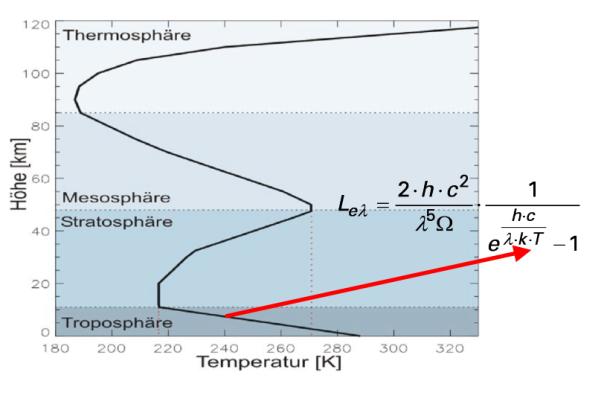

Das lokale thermodynamische Strahlungsgleichgewicht (LTE) begründet man mit dem Kirchhoff’schen Gesetz der Wärmestrahlung. Danach ist das Emissionsvermögen eines Körpers genau so groß wie sein Absorptionsvermögen. Das Ganze hat nur einen Haken. Es existiert kein „Strahlungsenergieerhaltungssatz“, wie er beim lokalen thermodynamischen Strahlungsgleichgewicht stillschweigend vorausgesetzt wird. Tatsächlich gibt man bei der „nachvollziehenden“ Berechnung der Satellitenspektren das gemessene atmosphärische Temperaturprofil in die Plank-Strahlungsgleichung ein, wie aus dem Bild 7 hervorgeht.

|

Bild 7: Strahlungstransport, Planck-Gleichung und gemessener Temperaturgradient

Zur Erinnerung: Beim Treibhauseffekt geht es auch um den Temperaturgradienten ( „Temperaturprofil“), den die Atmosphäre im Kontakt mit dem Erdboden unter adiabatischer Expansion annimmt. Lässt man sich dies durch den Kopf gehen, dann wird das Ergebnis – der Temperaturgradient – in die Rechnung eingesetzt (vgl. Bild 7), um dann daraus das temperaturabhängige Emissionsspektrum der Atmosphäre und des Erdkörpers zu erhalten (vgl. auch Bild 1). Deshalb ist die Übereinstimmung der im Bild 6 gezeigten Spektren kein Beweis für das dem Strahlungstransport zugrunde liegende hypothetische „lokale thermodynamische Strahlungsgleichgewicht“ innerhalb der Atmosphäre. Es ist vielmehr ein Beweis, dass man im Kreis herumrechnet und sich dann über den mathematisch „bewiesenen“ Treibhauseffekt freut.

Experimentelle Untersuchungen und die allgemein akzeptierte Theorie belegen eindeutig, dass die Molekülfluoreszenz anders funktioniert wie die Atomfluoreszenz, bei der die absorbierte Strahlung zu 100 % wieder emittiert wird (25, 26). Das LTE setzt aber eine „100%ige Molekülfluoreszenz“ voraus, die nicht existiert – auch nicht im IR-Bereich. Während angeregte Atome nur unter Emission von Strahlung in den Grundzustand zurückkehren können, erfolgt die Relaxation bei Molekülen wegen der Rotations- und Schwingungsfreiheitsgrade meist strahlungslos gemäß den Prinzipien des Jablonski-Diagramms (27). Deshalb reichte es eigentlich vollkommen aus, wenn man den „theoretischen“ Treibhauseffekt ohne jegliche Absorption nur mit der – temperaturabhängigen – Planck-Gleichung beschreibt, die man mit den jeweiligen Bandenstärken „klimawirksamer“ Spurengase und der „Anzahl IR-aktiver Moleküle in einem Luftvolumen“ multipliziert. Dann erhält man die thermische Emission der Atmosphäre unter Berücksichtigung des Raumwinkels.

Fazit: Dass eine atmosphärische Wärmestrahlung gemäß dem Planck-Gesetz gegeben ist, ist eine Selbstverständlichkeit. Solange aber ein atmosphärisches Temperaturprofil (oben kälter – unten wärmer) existiert und die Konvektion erheblich zum Energietransport beiträgt, solange ist die Hypothese in dem offenen System Atmosphäre existiere ein lokales thermodynamischen Gleichgewichts (LTE) falsch. Denn es gibt nämlich keinen „Strahlungsenergieerhaltungssatz“. Vielmehr übertragen „Treibhausgasmoleküle“ nach der Absorption von IR-Strahlung ihre Energie auf die nicht IR-aktiven Hauptbestandteile des Atmosphäre. Deshalb wird dem Strahlungsgeschehen bei der Klimamodellierung ein viel zu starkes Gewicht beigemessen.

6. Was Klimamodelle nicht können

Klimamodelle sind Computeralgorithmen (sprich: „Rechenvorschriften“, welche die meinungsabhängigen Vorgaben der Programmierung widerspiegeln) und nicht die Realität. Weil die Komplexität des Klimageschehens gegenwärtig und auch in absehbarer Zukunft mit keinem Computer realitätsorientiert erfassbar sein dürfte, handelt es sich mehr um politische Instrumentarien, denn um exakte Naturwissenschaft.

6. 1 Die Flusskorrekturen

Der Hypothese nach soll der „natürliche“ Treibeffekt den Globus um 33 °C aufheizen. Irrigerweise wird dabei angenommen, die Erde, die zu 70 % mit Wasser bedeckt ist, würde sich ähnlich verhalten wie der vollkommen wasserloseMond. Nimmt man an, nur die ersten 10 m Wassertiefe der Ozeane würden die mittlere Erdtemperatur thermostatisch regeln, ergibt die Rechnung, dass die Ozeane im Temperaturbereich von –18 °C bis +15 °C eine Energiemenge von 1,57.1018 MJ speichern. Hierzu die Gegenrechnung: In 24 Stunden werden durch den irdischen Treibhauseffekt 1,43.1016MJ umgeschlagen (22). Der gesamte natürliche Treibhauseffekt macht somit nur 0,9 % der Energie aus, die in den Ozeanen bei einer Wassertiefe bis zu 10 m gespeichert ist. Die Folge sind erhebliche Schwierigkeiten bei der Kopplung atmosphärischer Zirkulationsmodelle („General Circulation Atmospheric Models“) mit ozeanischen Zirkulationsmodellen („General Circulation Oceanic Models“). Diese Probleme lassen sich nur mit Hilfe so genannter „Flusskorrekturen“ überwinden, deren Beträge, wie das Bild 8 belegt, um ein Vielfaches größer sind als der anthropogene Treibhauseffekt. Die rechte Säule in Bild 8 stellt den Strahlungsantrieb des CO2 bei Verdopplung dar. Danach ist allein schon die 100 W/m2-Flusskorrektur zur Kopplung Ozeanoberfläche-Atmosphäre rund 27-mal (!) größer als der anthropogene Treibhauseffekt bei CO2-Verdopplung (3,7 W/m2).

|

Bild 8: Anthropogener Treibhauseffekt (rechte kleine Säule) im Verhältnis zu den bei der Klimamodellierung angewandten Flusskorrekturen

Es soll nicht unerwähnt bleiben, dass von einschlägigen Instituten in neuerer Zeit verlautbart wird, man benötige keine Flusskorrekturen mehr. Tatsächlich kommen Klimamodelle nach wie vor nicht ohne sie aus.

6. 2 Die Wolkendichte

Bei der Abschätzung des Strahlungsantriebs der Wolken kommen Klimamodelle zu äußerst unterschiedlichen Ergebnissen. So findet das „Bureau of Meteorology Research Center“ (BMRC) von Australien, dass die Wolken eine Abkühlung von ca. 1 W/m2 erbringen, während das Labaratoire de Météologie Dynamic (LMD) aus Frankreich meint, Wolken würden eine Erwärmung von ca. 1,7 W/m2 bewirken (Bild 9). Das ist beachtenswert!

|

Bild 9: Strahlungsantrieb der Wolken mit unterschiedlichen Klimamodellen gerechnet

6. 3 Die Vergangenheit

Beispielsweise können bis heute Klimamodelle nicht die im Bild 10 gezeigte Abkühlung zwischen 1930 und 1975 ohne Zuhilfenahme von Kunstgriffen (atmosphärischer Staubeintrag durch die Industriegesellschaft!) nachvollziehen.

|

Bild 10: CO2-Gehalt und Temperaturverlauf (vgl. a. Bild 11)

7. Die Alternative

Da treibhausgasfixierte Computer-Klimamodelle nicht nur im Zeitraum zwischen 1930 bis 1970 versagen sondern auch die kleine Eiszeit (14. bis 18. Jh.) und das mittelalterliche Klimaoptimum (11. – 13. Jh.) nicht nachbilden können, muss es einen anderen entscheidenden Mechanismus geben. Sehr viel spricht dafür, dass dies die Wolkendichte ist, die von der kosmischen Strahlung beeinflusst wird. Diese besteht überwiegend aus Protonen, die als Echo des Urknalls in unser Sonnensystem eindringen. Gelangen diese positiv geladenen Kernbausteine in die Atmosphäre, so führen sie über einen noch nicht restlos geklärten Mechanismus zur Kondensation von Wasserdampf – Wolken entstehen. Erhöht sich dasMagnetfeld der Sonne bei höherer Solaraktivität, dann werden die Protonen stärker abgeschirmt. In der Folge entstehenweniger Wolken und die erwärmende Sonnenstrahlung kann den Globus stärker aufheizen. Deshalb folgt der globale Temperaturverlauf der Schwankung des solaren Magnetfelds (Bild 11).

|

Bild 11: Solares Magnetfeld und Globaltemperatur (abgewandelt nach 28)

Wie Messungen zeigen, war im übrigen die Solaraktivität seit dem Jahr 850 noch nie so hoch wie nach 1940 (29). Auch im Wärmehaushalt der Weltmeere macht sich die wolkenbedeckungsabhängige Schwankung der solaren Einstrahlung stärker bemerkbar. Somit dürfte der anthropogene Treibhauseffekt eine kleine, aufgesetzte Größe auf einer natürlichen Klimaschwankung sein.

Abgesehen davon erscheint die unter Punkt 3 vorgerechnete Temperatur von – 18 °C, welche die Erde ohne Treibhausgase angeblich hätte, viel zu niedrig angesetzt sein. Sie entspricht aber der offiziellen Doktrin, die – und das muss betont werden – eine Hypothese ist. Weil, wie bereits hervorgehoben, die Erde kein wasserloser Gesteinshaufen im Weltall ist, sondern zu 70 % mit Wasser bedeckt ist, muss die direkte Absorption im nahen Infrarotgebiet (NIR) und die sehr verzögerte Strahlungsemission von Ozeanwasser stärker berücksichtigt werden.

</hug/img>

Bild 12: Wolkenbedeckung (Wolkendichte) und globale Temperatur

Aus dem Bild 12 geht hervor, dass sich die globale Wolkenbedeckung zwischen 1986 und 2000 von 69 % auf 65 % reduzierte (linke Ordinate, „fallend“ aufgetragen). Parallel hierzu stieg die globale Mitteltemperatur (rechte Ordinate, „steigend“ aufgetragen).

Während die Temperaturschwankungen in der Sahara im Tagesverlauf ohne weiteres bis zu 50 °C betragen können, verhalten sich Meere wesentlich träger. Der Gesamtwärmeumsatz (Wärmeenergie nicht Wärmeleistung!) eines Meeres ist die Summe vieler Größen:

Qges = (QS – QA) – QK – QV – QT + QC + QE + QF + QR

QS = im Meer absorbierte Sonnen- und Himmelsstrahlung (= „Treibhauseffekt“)

QA = effektive Ausstrahlung

QK = „fühlbarer“ Wärmeübergang Luft-Wasser

QV = latenter Wärmeübergang Luft-Wasser (Verdunstung, Kondensation)

QT = Wärmetransport durch Strömung

QC = chemisch-biologische Prozesse

QE = Wärmezufuhr aus dem Erdinnern

QF = Reibungswärme

QR = radioaktiver Zerfall

Da die Speicherfähigkeit des Wassers erheblich über der von Gesteinen liegt, ist es ausgeschlossen, dass sich die Erde bei einer Trägheit des Systems Wasser-Luft nachts schlagartig um 50 °C herunterkühlen. Denn insbesondere die Abstrahlungsleistung dQA/dt unterscheidet sich wegen der wesentlich höheren Wärmespeicherungsfähigkeit von Meerwasser deutlich von jener der Sahara. Gemäß der Stefan-Boltzmann-Gleichung (Gleichung 2) hängt nämlich die spezifische Ausstrahlung der Erdoberfläche mit der Temperatur unmittelbar zusammen. Je höher die letztere ist, desto größer ist auch die Abstrahlung.

Aus der obigen Aufzählung geht aber hervor, dass der Energiegehalt des Meerwassers auch auf der Wärmezufuhr aus dem Erdinnern, auf chemisch-biologischen Prozessen, auf radioaktiven Zerfall und auf Reibungswärme beruht. Die Größe QF (Reibungswärme) in der obigen Aufzählung hängt von der Windgeschwindigkeit ab. Wie H. Volz auf einer Tagung der Bayerischen Akademie der Wissenschaften berichtete, differiert die spezifischen Ausstrahlung bei den Windstärken 0 und 7 in einer Größenordnung von DM = 11,1 W/m2 (30). Die Ein- und Ausstrahlungsbilanz geht aber von einer ruhenden See aus. Addiert man diese Größe zur spezifischen Ausstrahlung bei 15 °C, so erhält man:

M = 239,0 W/m2 + 11,1 W/m2 = 250,1 W/m2

Eingesetzt in die Gleichung 2 resultiert für die Temperatur T = 257,7 K (- 15,3 °C). Diese Temperatur liegt um 2,7 °C höher, als die besagten – 18 °C. Die Treibhausgase erhöhen dann die Mitteltemperatur nicht um 33 °C sondern „nur“ um 30,3 °C, insofern die These richtig ist, die „normale“ Mitteltemperatur der Erde beträgt + 15 °C. Wie hoch war diese eigentlich während des mittelalterlichen Klimaoptimums (11. – 13. Jh. ) und während der „kleinen Eiszeit“ (14. bis 18. Jh)?

Ein weiteres kommt hinzu. Etwa 50 % der Sonneneinstrahlung, die den Erdboden erreicht, ist Wärmestrahlung (nahes und mittleres IR). Diese wird vom Meerwasser absorbiert. Die strahlungsfixierte Treibhausgastheorie saldiert nur die Einstrahlung und Ausstrahlung im Tagesverlauf als könnten sich die Weltmeere auf der Nachtsseite schlagartig auf – 18 °C abkühlen. Die Trägheit der Ozeane ist aber mit einer Relaxationszeit bis zu 200 Jahren sehr hoch. Folglich dürfte die mittlere globale Gleichgewichtstemperatur der Ozeane ohne atmosphärische Treibhausgase eher um + 4 °C (Wasser höchster Dichte am Grunde eines zugefrorenen Gewässers) denn bei – 18 °C liegen. Als ich vor einiger Zeit einmal mit einem ehemaligen Leiter eines Klimarechenzentrums korrespondierte und ihn fragte, wie hoch die irdische Mitteltemperatur ohne Ozeane anzusetzen sei aber mit dem gegenwärtigen atmosphärischen Treibhausgasgehalt, erhielt ich zur Antwort, dies sei eine interessante Frage, die man aber bislang nicht durchgerechnet habe.

Zusammenfassung

· Der anthropogene Treibhauseffekt ist im wesentlichem ausgereizt, wie die Messung der Transmission von IR-Strahlung belegt. Eine globale Klimakatastrophe ist daher selbst bei einer CO2-Verdoppelung nicht zu erwarten.

· Die Steigerung des Treibhauseffekt um 1,2 % bei 100 % mehr CO2 ist eine Bagatelle, die man nur mit Hilfe des Wasserdampfverstärkungsmechanismus vergrößern kann.

· Zweifellos enthält die Atmosphäre gemäß der Clausius-Clapeyronschen-Gleichung mehr Wasserdampf, wenn es wärmer wird. Jedoch lässt sich der hypothetische Wasserdampfverstärkungsmechanismus, ohne den Klimamodelle nicht zu einem merklichen Temperaturanstieg kommen, in der Realität nicht nachzuweisen. Weil sich somit der atmosphärische Wasserdampfgehalt nicht an der Konzentration der Treibhausgase orientiert, erhöht sich die globale Mitteltemperatur bei 100 % mehr CO2 in der Atmosphäre bestenfalls um 0,7 K (0,7 °C).

· Computerklimamodelle kommen u. a. deshalb zu falschen Ergebnissen, weil der hypothetische Wasserdampfverstärkungsmechanismus vollkommen überwertet wird.

· Der atmosphärische Temperaturgradient beruht auf einem Energietransport und nicht auf einem Strahlungstransportmechanismus mit dem fiktiven LTE. Deshalb wird der atmosphärischen Rückstrahlung – dem Treibhauseffekt – eine zu große Bedeutung zugemessen.

· Klimamodelle müssen mit – gewillkürten – Flusskorrekturen arbeiten, deren Größenordnung den des anthropogenen Treibhauseffekts um ein Vielfaches übertreffen. Im anderen Fall „hat (man) als Modellierer … die Wahl, entweder ohne Flusskorrektur mit einem unrealistischen Klimazustand zu operieren, oder die Flusskorrektur mit ihren Schwächen zu akzeptieren, dafür aber ein realistisches Klima zu erhalten.“(32)

· Die Abbildung des Klimas in der Vergangenheit mit Computeralgorithmen gelingt nicht ohne massive Korrekturgrößen.

· Die globale Mitteltemperatur ohne Treibhauseffekt dürfte um einiges höher als bei 255 K (-18 °C) liegen.

· Das Klima wird hängt stärker von der Variation der Wolkenbedeckung ab als vom Gehalt atmosphärischer Treibhausgase.

· Das IPCC ist eine politische Organisation, die sich eines Wissenschaftlergremiums bedient, um volkspädagogische Lernziele durchzusetzen.

Abschließend möchte ich die Leser darauf aufmerksam machen, dass dem gegenwärtigen CO2-Gehalt je nach Literaturstelle ein unterschiedlicher Temperatureffekt zugeordnet wird. In dem von von J.T. Houghton herausgegebenen Buch „The Global Climate“ geben Kondratjew und Moskalenko 7,2 K an (14). Die Autoren zitieren sich dabei selbst (15). Besorgt man sich das in Kyrillisch geschriebene Buch und schaut auf der angegebenen Seite nach, so landet man im Sachwortverzeichnisses. Auch die weitere Suche in dem Buch bringt kein Ergebnis. Andererseits scheint man sich doch recht sicher zu sein, denn die Angaben der Autoren werden gerne zitiert (16). Allerdings gibt es Widersprüche, denn K.P. Shine gibt einen anderen Wert an, nämlich 12 K (17) und R. Lindzen (18) geht davon aus, dass dem CO2 nur etwa 5% des natürlichen Treibhauseffekts zuzuordnen sind. Das wären 1,65 K und damit weniger als ein Viertel des bei IPCC benutzten Werts von 7,2 K.

Literatur

[1] R. Revelle, Scientific American, 247, No.2, Aug. 1982, 33-41

[2] J. Barrett, Spectrochim. Acta Part A, 51, 415 (1995)

[3] R.A. Hanel et al. Journal of Geophysical Research, 77, 2629-2641 (1972)

[4] H. Flohn, Nachr. Chem.Tech.Lab, 32, 305-309 (1984)

[5] L.S.Rothman et al., Appl.Opt. 26, 4058 (1987)

[6] H. Hug, Chemische Rundschau, 20. Febr., p. 9 (1998)

[7] P. S. Braterman, Spectrochim. Acta Part A, 52, 1565 (1996)

[8] K. Shine, Spectrochim. Acta Part A, 51, 1393 (1995)

[9] J. Houghton, Spectrochim. Acta Part A, 51, 1391 (1995)

[10] R. S. Courtney, Spectrochim. Acta Part A, 53, 1601 (1997)

[11] R. P. Wayne, Chemistry of Atmospheres, Oxford University Press,

2nd. Edition, 44-49 (1991),

[12] Murry L. Salby, Fundamentals of Atmospheric Physics, Academic Press, 198-257 (1996)

[13] Climate Change 1990. The IPCC Scientific Assessment, p. 49

[14] K.Ya. Kondratyev, N.I. Moskalenko in J.T.Houghton, The Global Climate, Cambridge

Universitiy Press, 225-233 (1984)

[15] K.Ya. Kondratyev,N.I. Moskalenko, Thermal Emission of Planets, Gidrometeoizdat,

263 pp (1977) (Russisch)

[16] C.D. Schönwiese, Klimaänderungen, Springer-Verlag Berlin Heidelberg, p. 135 (1995)

[17] K. P. Shine, A. Sinha, Nature 354, 382 (1991)

[18] R. S. Lindzen, Proc. Nat. Acad. of Sciences, 94, 8335 (1997)

[19] R. Raschke, R. Hollman, Strahlungsübertragung in der Atmosphäre, Modellierung und Messung, Preprint zum CO2-Kolloquium der DECHEMA in Frankfurt/Main am 11.10.2001

[20] T. E. Graedel, Paul J. Crutzen, Chemie der Atmosphäre, Spektrum Akademischer Verlag, Heidelberg, Berlin, Oxford 1993, S. 414

[21] IPCC, Climate Change 2001, Chap. 1.2.1 Natural Forcing of the Climate System

[22] J. T. Kiehl, K. E. Trendberth, Bull. Amer. Meteor. Soc., 78 (1997) 197

[23] IPCC, Climate Change 1994, Radiative Forcing of Climate Change and Evaluation of the IPCC IS92 Emission Scenarios, Cambridge University Press, S. 174

[24] IPCC, Climate Change 2001, Working Group I: The Scientific Basis. Contribution of Working Group I to the Third Assessment Report of the Intergovernmental Panal on Climate Change, Chap. 7.2.1.1

[25] H. Hug, Energy & Environment, 11, 631, (2000)

[26] N. D. Coggeshall and E. L. Saier, J. Chem. Phys., 15, 65, (1947), Fig. 1

[27] Matthias Otto, Analytische Chemie, Wiley-VCH Verlag, Weinheim (2000), S. 280 ff

[28] S. Solanki, M Schüssler, M Fligge, Nature, 408 (2000) 445

[29] I. G. Usoskin, S. K. Solanki, M. Schüssler, K. Mursula, K. Alanako, Phys. Rev. Let., 91 (2003) 211101-1

[30] Rundgespräche der Kommission für Ökologie, Klimawandel im 20. und 21. Jahrhundert: „Welche Rolle spielen Kohlendioxid, Wasser und Treibhausgase wirklich?“ Bayerische Akademie der Wissenschaften, Verlag Dr. Friedrich Pfeil, Müchen, April 2005, S. 93

[31] Wasserdampfgraphik nach H. Flohn, BdW 12/1978, S. 132

[32] U. Cubasch, Phys. Bl. 51 (1995) 269

[33] H. Hug, Die Angsttrompeter, Signum Verlag, München, 2006, S. 227

Heinz Hug, Wiesbaden Juni 2007

Den Aufsatz können Sie auch als pdf Datei aus dem Anhang herunterladen

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"#216: „Man kann einen natürlichen Prozess mit einer Simulation nur dann wirklichkeitsnah abbilden, wenn a) der Prozess vollständig erforscht ist und b) der Prozess mathematisch exakt beschreibbar ist. Beides gilt fürs Klima nicht. nicht. Aus den kilometerlangen Diskussionen über Gegenstrahlungen und Rückkopplungen stellt man als Nichtphysiker eins auf jeden Fall fest: Das Thema ist höchst umstritten. Drei Wissenschaftler mit vier Meinungen.“

@Peter Georgiev, das über Inhalte in der Wissenschaft viel gestritten wird, ist nichts neues. Mich würde es nur wundern, wenn dem nicht so wäre. Bei Simulationen ist man oft schon froh, wenn man annähernd genau seine Beobachtungen abbilden kann. Man wird bzgl. der Genauigkeit immer an Grenzen stoßen. Die Frage ist, ob man im jeweiligen Fall mit der erreichten Vorhersagegenauigkeit leben kann oder nicht. Wie genau wollen Sie denn die Vorhersage der Durchschnittstemperaturen eigentlich haben?

„Weiter sind chaotische Prozesse mathematisch nicht exakt abbildbar. Wenn Sie heute den Wetterverlauf von September 2013 oder Januar 2016 modellieren, wissen Sie, dass Sie reine Spekulation betreiben. Beim Klima trifft es im noch höheren Maße zu, Sie wollen es aber aus Unwissenheit oder ideologischer Verblendung nicht wahrhaben. Den Temperaturverlauf der nächsten Jahrzehnte können Sie mit dem Würfel bestimmen, es ist ehrlicher.“

Sie betreiben hier ein folgenreichen Analogieschluss. Wenn Sie dem Wetter ein chaotisches Verhalten zuordnen, warum sollte das Klima im selben Umfang chaotisch sein? Nehmen Sie mal das Verhalten eines Gasmoleküls oder eines Urankerns. Deren Verlauf sind praktisch nicht vorhersagbar. Das Gasmolekül bewegt sich von uns aus gesehen vollkommen zufällig. Der Urankern zerfällt irgendwann, aber wir würden selbst eine Sekunde vorher nichts davon ahnen. Kann man aus deren unverhersagbaren, chaotischen Verhalten schlussfolgern, dass sich 1 Liter Gas oder 10g Uran genauso chaotisch verhalten? Genau das sugeriert die Behauptung, dass das Klima sich genauso chaotisch wie das Wetter verhält.

Aus der Statistik weiss man, dass man den Mittelwert eines Ereignisses stets genauer vorhersagen kann als das Ereignis selbst. Das statistische Rauschen des arithmetischen Mittels ist kleiner als das eines einzelnen Meßwertes. Das chaotische Verhalten des Wetters wird nicht dazu führen, dass wir in eine Entwicklung reinkommen, wo bei fast identischen Bedingungen der 30-Jahres-Durchschnitt plötzlich um 1K ansteigt. Wenn dem so wäre, dann hätte sich dieses chaotische Verhalten in dieser Größenordnung in vergangenen Klimadaten wiedergefunden, die man nicht mit dem gängigen Größen Treibhausgase, Sonnenaktivität, Aerosole, Vulkanismus, Milankovic-Zyklen, Meeresströmungen hätte man erklären können. Oder waren beispielsweise die Eiszeiten das Ergebnis chaotischer Wetterereignisse die zu einem chaotischen Klimawandel geführt haben?

Dann zu ihrem obligatorischen Informatik-Gimmick. Will jetzt nur mal auf den letzten Teil eingehen: „Ich kann nur jedem empfehlen, Computersimulationen nicht als Blackboxen zu betrachten, in denen die reine physikalische Wahrheit integriert ist“

Die Vorstellung, dass Computersimulationen nur dann sinnvoll wären, wenn sie die reine physikalische Wahrheit integriert hätten, höre ich nur von Ihnen. Das ein Abbild der physikalischen Wahrheit für unsere Zwecke ebenso sinnvoll ist, um Aussagen über unsere Welt zu treffen, wird hingegen in der Jahrhunderte langen Wissenschaftsgeschichte tagtäglich unter Beweis gestellt.

Lieber Herr Georgiev, #215

„Was machen denn die Entwickler der Klimasimulationen? Den Algorithmus so lange trimmen, bis die Klimaereignisse der Vergangenheit angezeigt werden.“

Das glauben Sie, weil Sie es glauben wollen und offenbar keine Ahnung haben, was physikalische Modellierung ist.

# 212

„Nur was hat letzteres mit der Wirklichkeit zu tun? Nichts!“ Sie haben vollkommen Recht, lieber Herr Hader, dies gilt für meine Beispiele sowie für alle Klimamodelle.

Man kann einen natürlichen Prozess mit einer Simulation nur dann wirklichkeitsnah abbilden, wenn a) der Prozess vollständig erforscht ist und b) der Prozess mathematisch exakt beschreibbar ist. Beides gilt fürs Klima nicht. Aus den kilometerlangen Diskussionen über Gegenstrahlungen und Rückkopplungen stellt man als Nichtphysiker eins auf jeden Fall fest: Das Thema ist höchst umstritten. Drei Wissenschaftler mit vier Meinungen. Was soll dann ins Modell einfließen? Weiter sind chaotische Prozesse mathematisch nicht exakt abbildbar. Wenn Sie heute den Wetterverlauf von September 2013 oder Januar 2016 modellieren, wissen Sie, dass Sie reine Spekulation betreiben. Beim Klima trifft es im noch höheren Maße zu, Sie wollen es aber aus Unwissenheit oder ideologischer Verblendung nicht wahrhaben. Den Temperaturverlauf der nächsten Jahrzehnte können Sie mit dem Würfel bestimmen, es ist ehrlicher.

Zu Algorithmenentwicklungen: Ich habe schon ausgedruckte Quellcodes betrachtet. Nicht das ich etwas auslesen kann. Nein. Aber es hilft manchmal, sich ein Bild über die Fähigkeiten des Informatikers zu machen. Wenn ein Script mit gleicher Auswirkung bei einem auf vier A4 Seiten passt und beim anderen 13 Seiten ausgedruckt werden, ist es eine Aussage. Wenn man lange genug im Geschäft ist, weis man, das bei komplexen Algorithmen die gleiche Vorgabe auf höchst interschiedlicher Weise erzielt werden kann, die dann unter anderen Bedingungen anders reagieren können. Bezogen auf Klimamodelle: Wenn das PIK 10 Firmen für die Klimamodellcodeentwicklung beauftragen würde, würde es 10 völlig unterschiedliche Programme erhalten, die die CO2-Sensibilität und die Klimaverläufe der Vergangenheit mehr oder weniger gleich abbilden und die Zukunft unterschiedlich voraussagen. Die Natur hat aber nicht 10 Ausführungen, sondern ist einzigartig.

Ich kann nur jedem empfehlen, Computersimulationen nicht als Blackboxen zu betrachten, in denen die reine physikalische Wahrheit integriert ist, sondern eher als Zeichentrickfilme, die je nach Aufwand und Talent der Erschaffer der Wirklichkeit sehr ähnlich sein können.

Ihre persönliche Meinung kenne ich Herr Hader, der letzte Satz ist nicht für Sie bestimmt.

# 214

„Blöder Job, suchen Sie sich was neues.

Programme trimmen, um vorgegebene Ergebnisse zu erzielen, hat nichts mit Modellierung zu tun, sondern ist ödes Anfitten“

Ein Glück, dass wir das schlaue Baeckerchen haben! Was machen denn die Entwickler der Klimasimulationen? Den Algorithmus so lange trimmen, bis die Klimaereignisse der Vergangenheit angezeigt werden. Damit sich zum Schluß Rahmstorf und NB wie Kolumbus bestätigt fühlen. Viel Spaß beim Feiern!

Lieber Herr Georgiev, #208

„Ich selbst mache das nicht, gebe nur vor, welches Berechnungsergebnis der Kunde erwartet und meine Mannschaft bekommt es hin. “

Blöder Job, suchen Sie sich was neues.

Programme trimmen, um vorgegebene Ergebnisse zu erzielen, hat nichts mit Modellierung zu tun, sondern ist ödes Anfitten.

Lieber Herr Heinzow, #211

„denn das, was Sie geschrieben haben, sind Nullsätze und haltlose Unterstellungen.“

Wenn Sie sich nicht die Mühe machen, sie zu überprüfen, mag das Ihnen auch weiter so erscheinen.

„Wo habe ich was von „Ozeantemperaturen“ als „externem Forcing“ geschrieben?“

Haben Sie nicht, Sie haben insgesamt nicht verstanden, dass man zwischen externem und internem forcing unterschieden muss. In dem von Ihhnen verlinkten Cook-paper wurden ein interne forcing durch SST vorgegeben, das geht aber nur, wenn man einen Zeitraum modelliert, in dem die SST auch bekannt ist, also gemessen wurde.

Ich bezog mich auf Ihr #206, in dem Sie schrieben:

„Schön, nur sind die realen Forcings während der Kleinen Eiszeit nicht bekannt. Kennt man die Ozeanwassertemperaturen oder die Windströmungen

über den Ozeanen?“

Nein, man kennt sie nicht. Und daher werden sie auch nicht als forcings verwendet, sondern sind Teil der Modellierung. Jetzt verstanden?

Hallo Peter Georgiev, Freitag Vormittag und es gibt wieder von Ihnen ein nettes Gimmick zu Fragen der Softwareentwicklung zu lesen, so gefällt mir der Einstieg ins Wochenende. :o)

„Etwas anderes macht die Mannschaft, die die CO2-Klima-Simulationen entwickelt hat, auch nicht. Mit gleicher Leichtigkeit könnte diese Mannschaft heute eine Simulation entwickeln, bei der das Klima ausschließlich von der Sonne abhängt.“

Sie scheinen das Prinzip der Modellbildung noch nicht so ganz verinnerlicht zu haben. Sie können mit allen möglichen Eingangsgrößen versuchen das Klima vorherzusagen. Sie können sogar die Hufgröße der Schwarzfersenantilope zur Vorhersage der globalen Temperaturen heranziehen. Der entscheidende Punkt ist, wie gut kann das Modell die bisherigen ungenutzen Beobachtungen abbilden. In dem Punkt werden sich gute von schlechten Modellen unterscheiden. Es steht Ihnen und der gesamten Wissenschaft frei, Klimamodelle aufzustellen, die nur die Sonne als Bezugsgröße nehmen. Entscheidend wird sein, wie gut kann dieses Modell die Wirklichkeit beschreiben.

„Und übermorgen eine, bei der beim steigenden CO2 die Temperatur sinkt. Und überübermorgen…u.s.w. Eins hätten alle Simulationen gemeinsam, sie haben mit der Natur und der Physik nichts zu tun, egal wie perfekt sie Naturereignisse vorgaukeln.“

Ich bezweifle ehrlich gesagt, dass Sie mit einem Modell mit negativer CO2-Gewichtung reale Naturereignisse vorgaukeln könnten.

„In einer Computersimulation fällt ein Gegenstand nach unten nicht aufgrund der richtig programmierten Schwerkraft, sondern es wird die Wirkung einer Kraft vorgegaukelt. Der Gegenstand könnte genauso gut schweben oder nach oben fallen.“

Nur was hat letzteres mit der Wirklichkeit zu tun? Nichts! Und genau das würde man feststellen.

„Mir brauchen Sie nicht erläutern, was zu Codeentwicklung dazugehört, Prof. Hader.“

Mal nicht übertreiben. In der akademischen Hierarchie bin ich beiweiten nicht so hoch gestiegen. ;o)

„P.S. Lieber Herr Heinzow, ich zweifle nicht daran, dass es exzellent programmierte Forschungsinstrumente gibt. Es ist aber unmöglich, unerforschten Prozessen auf die Spur zu kommen, in dem man das Ergebnis am Computer „nachspielt“ und daraus Rückschlüsse auf die Ursachen der Entstehung zieht. Das halte ich für puren Selbstbetrug, auch wenn die Daten manchmal übereinstimmen.“

Das ist nunmal die gängige Praxis, für diejenigen, die sich täglich mit Finite-Elemente-Simulation, Multi-Agenten-Simulation oder Molekulare Modellierung beschäftigen. Und es funktioniert. :o) Auch wenn Sie vom Gegenteil überzeugt sind, diese Simulationen helfen, neue Rückschlüsse zu ziehen und vor allem auch eine Menge Geld einzusparen, weil man deutlich weniger auf mechanische und chemische Experimente angewiesen ist.

@ NicoBaecker #207

Typisch Baecker: „sie koennen nicht lesen und haben immer noch nicht verstanden“

Ihre Methode des Verdrehens und Hinzuerfindens von Aussagen zieht bei mir nicht.

Und das hier ist schlichtweg Unfug: „Ich habe es geschrieben, denn wenn man diese mit ihrem beobachteten Verlauf einbaut …“

denn das, was Sie geschrieben haben, sind Nullsätze und haltlose Unterstellungen. Hier ein besonders schönes Exemplar: „Ozeantemperaturen nicht zu den externen forcings zaehlen, sondern output des Modells sind, output, wissen sie was das ist? das ist nicht input, verstanden?“

Wo habe ich was von „Ozeantemperaturen“ als „externem Forcing“ geschrieben?

Allerdings kann man von Ihnen, der ja meint mit variabler linearer Regression die zweite Ableitung einer Funktion bilden zu können, nichts anderes erwarten.

Lieber Herr Heinzow,

„Und eben deshalb sind die GCM nicht geeignet irgendwelche sinnvollen Vorhersagen zu machen. Ein Modell, welches die in der Vergangenheit liegenden natürlichen Schwingungen des Ozean-, Land- und Atmosphäresystems (z.B. NAO, PDO, AMO, El Nino, La NINA) nicht nachbilden kann, ist als Vorhersageinstrument untauglich. Die Dürren und Fluten in Nordamerika sind Teil und Ausprägung dieser Schwingungen. “

Fuer die Vorhersage vom Zeitverlauf interner Klimavariabilitaet gebe ich Ihnen ja schon oben vollkommen Recht. Die ECHAM Simulation bei konstanten forcing z.B. diente dazu, zu testen, ob wenigstens das Amplituden-Spektrum der internen Klimavariation zwischen Modell und Wirklichkeit passt. Ich sagte ja schon, dass man nur mit externen forcings noch keine akzeptable Simulation des NAO oder ENSO Verlaufs hinbekommt. Sie sehen ja selber, dass die beobachteten und modellierten globalen Jahres-Temperaturen immer so einige Zehntelgrad umeinanderschwanken. Dies sind die Auswirkungen der Abweichungen der Fehler, die die Modelle haben, die regional natuerlich moch viel ausgepraegter sind als global.

# 203

Mogeln geht beim programmieren nicht Bäckerchen, entweder es stimmt das Ergebnis, oder der Code ist für die Tonne.

Ich selbst mache das nicht, gebe nur vor, welches Berechnungsergebnis der Kunde erwartet und meine Mannschaft bekommt es hin. Wird von heute auf morgen genau das Gegenteil erwartet, so hätte ich keinen Zweifel, meine Mannschaft würde es auch hinkriegen. Etwas anderes macht die Mannschaft, die die CO2-Klima-Simulationen entwickelt hat, auch nicht. Mit gleicher Leichtigkeit könnte diese Mannschaft heute eine Simulation entwickeln, bei der das Klima ausschließlich von der Sonne abhängt. Und übermorgen eine, bei der beim steigenden CO2 die Temperatur sinkt. Und überübermorgen…u.s.w. Eins hätten alle Simulationen gemeinsam, sie haben mit der Natur und der Physik nichts zu tun, egal wie perfekt sie Naturereignisse vorgaukeln.

In einer Computersimulation fällt ein Gegenstand nach unten nicht aufgrund der richtig programmierten Schwerkraft, sondern es wird die Wirkung einer Kraft vorgegaukelt. Der Gegenstand könnte genauso gut schweben oder nach oben fallen. Physik existiert eben in keiner Simulation, nur die Kreativität des Programmierers beim Versuch, die Erwartung des Auftraggebers zu treffen.

# 202

Mir brauchen Sie nicht erläutern, was zu Codeentwicklung dazugehört, Prof. Hader. Wie ich schon erwähnte, ernähre ich mit dieser Tätigkeit über Steuern u.a. das PIK. Alle Test überprüfen schlussendlich nur das Ergebnis, ob der Stein nach unten oder nach oben fällt. Was im Code wirklich steckt, weis außer der Autor niemand.

Ihre spannende Frage kann ich beantworten, welche der o.g. Simulationen den quantitativen Ereignissen der Vergangenheit am nächsten nachvollzieht: Alle im gleichen Maße! Näher dran kommt man nur dann, wenn die Mannschaft kreativer ist. Der Ansatz, ob über CO2, Sonne, CO2-Rückwärts oder andere ist Nebensache.

Die Diagnose bleibt, reale und virtuelle Welt werden nicht scharf genug getrennt.

P.S. Lieber Herr Heinzow, ich zweifle nicht daran, dass es exzellent programmierte Forschungsinstrumente gibt. Es ist aber unmöglich, unerforschten Prozessen auf die Spur zu kommen, in dem man das Ergebnis am Computer „nachspielt“ und daraus Rückschlüsse auf die Ursachen der Entstehung zieht. Das halte ich für puren Selbstbetrug, auch wenn die Daten manchmal übereinstimmen.

Lieber Herr Heinzow,

sie koennen nicht lesen und haben immer noch nicht verstanden, dass

„Ich habe es geschrieben, denn wenn man diese mit ihrem beobachteten Verlauf einbaut, so wird damit die kleine Eiszeit schon gut erklärt.“

„Schön, nur sind die realen Forcings während der Kleinen Eiszeit nicht bekannt. Kennt man die Ozeanwassertemperaturen oder die Windströmungen

über den Ozeanen?“

Ozeantemperaturen nicht zu den externen forcings zaehlen, sondern output des Modells sind, output, wissen sie was das ist? das ist nicht input, verstanden?

@ NicoBaecker #201

„Ich denke, es ist dieses paper, was Sie verwirrt hat.“

Mich hat noch nie ein Paper verwirrt. Für Sie ist es verständlicherweise peinlich zugeben zu müssen, daß die GCM nur aufgrund speziellen Forcings die seit Jahrtausenden bekannten natürlichen Dürreperioden in Nordamerika nachbilden können, aber eben nicht von sich aus.

„Haben Sie schon mal ein Modell gesehen, was nur mit first principles die US droughts und Klimaanomaliene mit ähnlicher Auflösung hinbekommen? Ich nicht.“

Und eben deshalb sind die GCM nicht geeignet irgendwelche sinnvollen Vorhersagen zu machen. Ein Modell, welches die in der Vergangenheit liegenden natürlichen Schwingungen des Ozean-, Land- und Atmosphäresystems (z.B. NAO, PDO, AMO, El Nino, La NINA) nicht nachbilden kann, ist als Vorhersageinstrument untauglich. Die Dürren und Fluten in Nordamerika sind Teil und Ausprägung dieser Schwingungen.

„In der Mathematik von part. DGLs unterscheidet man Anfangswert-/Startbedingungen und Randbedingungen, nicht verwechseln!“

Ich rede nicht über Mathe sondern Meteorologie. Thermikmodellierung ist z.B. deshalb kein Problem der Randbedingunen, sondern der Anfangswerte.

„Ich habe es geschrieben, denn wenn man diese mit ihrem beobachteten Verlauf einbaut, so wird damit die kleine Eiszeit schon gut erklärt.“ Schön, nur sind die realen Forcings während der Kleinen Eiszeit nicht bekannt. Kennt man die Ozeanwassertemperaturen oder die Windströmungen über den Ozeanen? Es gibt Schiffstagebücher, aber die hat bisher niemand vollständig ausgewertet.

„Wenn das so wäre, wäre das kaum sinnvoll.“ Das Basteln an den Stellschrauben ist schon sinnvoll. Oder nehmen Sie ernsthaft an, daß die Routinevorhersagemodelle der Wetterdienste ohne dieses Basteln bessere Ergebnisse zeitigen würden?

„Meinen Sie da die ERIK-Simulationen? Da wurden die forcings absichtlich konstant gehalten, um die interne Variabilität des Klimas wie ENSO, NAO und andere interne Zyklen und Telekonnektionen zu untersuchen.“

Nö, ich verweise auf die Publikationen des MPI-met zur Kaltstartfähigkeit der GCM-Familie ECHAM und wie z.B. die Anfangsbedingungen für die Kontrolläufe gesetzt wurden.

„Macht nichts, ich denke, dass modellierte SST statt Messwerte der SST die droughts mit heutigen GAOGCMs (noch) nicht so gut wiedergäben.“

Sie meinen die mit den Ozeanmodellen gekoppelten GCM? M.W. können die die US-Dürren der Vergangenheit derzeit nicht abbilden.

Lieber Herr Heinzow, #201

„Mir ist kein GCM (vulgär Klimamodell) bekannt, welches ohne „spezielles Forcing“ das Maunder-Minimum und das Dalton-Minimum nachgebilden hat können.“

Mir auch nicht.“

Das heißt, dass ich die von mir genannten forcings Sonne und Vulkanismus, die einen Gutteil der kleinen Eiszeit erklären, nicht als „speziell“ ansehe, denn von denen weiß man ja, dass sie auf der Zeitskala von Jahrzehnten -Jahrhunderten relevant sind und baut ihre Verläufe (Beobachtung oder proxys) ein.

„Heißt doch, daß ohne Drehen an den Stellschrauben der GCM die GCM, wie übrigens vom MPI in HH in einer Broschüre publiziert, nach dem Einschwingen nach dem „Kaltstart“, die GCM nur konstantes Einheitswetter in allen möglichen Variationen abliefern.“

Meinen Sie da die ERIK-Simulationen? Da wurden die forcings absichtlich konstant gehalten, um die interne Variabilität des Klimas wie ENSO, NAO und andere interne Zyklen und Telekonnektionen zu untersuchen.

„Das Einheitswetter stimmt aber über klimatisch (WMO-Definition) relevante Zeiträume ab einer Startzeit des gewählten Modellaufs nicht mit den „gemessenen“ Realitäten im Bereich des Niederschlags und der Min-Max-Temperaturen nicht überein. „

Kein Wunder, wenn man wie in diesem Fall die de facto stattgefundene Variabilität der forcings (Sonne, Vulkanismus, Treibhausgase, ..) konstant gesetzt hat, kann kaum das de facto Klima rauskommen…

„“Sonne und Vulkanismus nun „spezielle Forcings“ zu benennen, finde ich komisch.“

Ich kann nicht feststellen, daß ich was von „Sonne und Vulkanismus“ in Bezug auf Forcings“ geschrieben habe. „

Ich habe es geschrieben, denn wenn man diese mit ihrem beobachteten Verlauf einbaut, so wird damit die kleine Eiszeit schon gut erklärt. „Spezielle“ forcings braucht man nicht, und oder „geheime“ forcings wären Verarschung.

„Wie und wo die Modellierer die „Forcings“ in die GCM einbauen, ist deren Geheimnis. Wenn das „Forcing“ das gewünschte Ergebnis erbringt oder eben auch nicht, wird das auch publiziert. Nicht sehr gerne, aber es geschieht.„

Wenn das so wäre, wäre das kaum sinnvoll. Aber Sie glauben das ja auch nur.

„Zu Ihrer Information: Den Dust Bowl haben GCM-Modellierer nachbilden können. Wie, das können Sie hier lesen: http://tinyurl.com/ch8nkq7.“

Danke fürs paper. Ich denke, es ist dieses paper, was Sie verwirrt hat.

Denn die Autoren machen dort ja keine Klimamodellierung aus first principles, von der wir sprachen, sondern „forcen“ das Modell zusätzlich mit einem internen Parameter (SST) und dem Landforcing.

Das kann man natürlich nur machen wie in dem Fall, wenn der SST-Verlauf gemessen wurde und das Modell über diesen Zeitraum läuft.

Klimamodellierung aus first principles machen das nicht, denn dort wird nur mit externen forcings wie Treibhausgase, Vulkanismus, Sonne geforced und die SST gehört dann zum zu berechnetem Modelloutput!

Haben Sie schon mal ein Modell gesehen, was nur mit first principles die US droughts und Klimaanomaliene mit ähnlicher Auflösung hinbekommen? Ich nicht.

„Die Dürren umfassen größere Räume als die eines Gitterpunktes eines GCM mit T63-Auflösung“

Macht nichts, ich denke, dass modellierte SST statt Messwerte der SST die droughts mit heutigen GAOGCMs (noch) nicht so gut wiedergäben.

„Randbedingungen? Sind denn die Startbedingungen (Randbedingungen) z.B. zum Jahr 1974 nicht bekannt?“

In der Mathematik von part. DGLs unterscheidet man Anfangswert-/Startbedingungen und Randbedingungen, nicht verwechseln!

@ NicoBaecker #198

“ … welche forcings in modernen GCMs …“

Oh, das tut richtig weh, denn GCM können nie modern sein.

Lieber Herr Georgiev,

ich denke nicht, dass man ihre Gaukeleien Ihren Chefs gegenueber als Vorbild fuers Programmieren nehmen sollte, ichnglaube auch micht, dass Ihre Art generell verbreitet ist, wenn Sie mogeln, so heisst das nicht, dass es andere ebenso machen.

Lieber Peter Georgiev, bzgl. #192 möchte ich folgendes sagen, wenn Sie Codeentwicklung betreiben ohne entsprechende Softwaretests durchzuführen und auch sonstige Schritte zur Qualitätssicherung wie Spezifikationsphase, Code-Reviews, Integrationstests usw. weglassen, dann tun mir Ihre Auftrag- bzw. Arbeitgeber leid. Zur Aufgabe der Projektverantwortlichen gehört es natürlich dazu, diese notwendigen Schritte der Softwareentwicklung zu begleiten und entsprechende Code-Reviews und Tests durchzuführen. Dass das eine andere und aufwendigere Art des Programmierens ist als wenn Studenten für ihre Arbeit mal schnell was zusammenhacken, ist selbsterklärend.

„Wenn ich genügend Geld beisammen haben, werde ich die CO2-Klimamodellierer beauftragen, Klimamodelle zu entwickeln, bei denen ausschließlich die Sonne die Schwankungen steuert.“

Jo, ist halt Ihre Sache, was Sie mit Ihrem Geld anstellen wollen. Ich glaube aber nicht mal, dass das nötig ist, weil schon andere Wissenschaftler auf die Idee gekommen sind, ob man die Klimaentwicklung allein durch die Sonnenaktivität erklären kann. Modelle können Sie jede Menge erstellen. Da besteht kein Mangel. Die Frage ist nur, wo gut sie quantitativ vergangene Ereignisse erklären können. Das ist doch die spannende Frage.

„Meine exzellente Mannschaft könnte es auch locker, sie hat aber wichtigeres zu tun, Steuergelder zu verdienen, damit Sie und das PIK nicht verhungern.“

Ich verdiene kein Geld mit Klimamodellen oder Klimawissenschaft, wie kommen Sie wieder auf dieses schmale Brett?

Ansonsten lese ich gerne Ihre Laienvorstellungen zur Softwareentwicklung, ich finde die immer sehr erheiternd. Und ich antworte Ihnen auch gerne darauf, scheinbar bin ich da aber wohl der Einzige.

@ NicoBaecker #199

Einigkeit macht stark: „“Mir ist kein GCM (vulgär Klimamodell) bekannt, welches ohne „spezielles Forcing“ das Maunder-Minimum und das Dalton-Minimum nachgebilden hat können.“

Mir auch nicht.“

Heißt doch, daß ohne Drehen an den Stellschrauben der GCM die GCM, wie übrigens vom MPI in HH in einer Broschüre publiziert, nach dem Einschwingen nach dem „Kaltstart“, die GCM nur konstantes Einheitswetter in allen möglichen Variationen abliefern. Das Einheitswetter stimmt aber über klimatisch (WMO-Definition) relevante Zeiträume ab einer Startzeit des gewählten Modellaufs nicht mit den „gemessenen“ Realitäten im Bereich des Niederschlags und der Min-Max-Temperaturen nicht überein.

„Sonne und Vulkanismus nun „spezielle Forcings“ zu benennen, finde ich komisch.“

Ich kann nicht feststellen, daß ich was von „Sonne und Vulkanismus“ in Bezug auf Forcings“ geschrieben habe. Wie und wo die Modellierer die „Forcings“ in die GCM einbauen, ist deren Geheimnis. Wenn das „Forcing“ das gewünschte Ergebnis erbringt oder eben auch nicht, wird das auch publiziert. Nicht sehr gerne, aber es geschieht.

Unterlassen Sie doch bitte Ihre unsubstantiierten und durchsichtigen Unterstellungen.

„Zu Ihrer Information: Den Dust Bowl haben GCM-Modellierer nachbilden können. Wie, das können Sie hier lesen: http://tinyurl.com/ch8nkq7.“

„Würde mich auch wundern, bekanntlich reicht die regionale Auslösung nicht für jedes Detail. Und ob man dies in 10 Jahren hinbekäme, wage ich zu bezweifeln.“

Und KLAPP sitzen Sie in der Falle.

Es hilft Ihnen auch nicht, daß Sie sich den Fluchtweg „… regionale Auslösung nicht für jedes Detail“ offen zu halten suchen.

Die Dürren umfassen größere Räume als die eines Gitterpunktes eines GCM mit T63-Auflösung. Auf kleinräumige „Details“ kommt es nicht an.

„Szenarien abhängig von möglichen Randbedingungen.“

Randbedingungen? Sind denn die Startbedingungen (Randbedingungen) z.B. zum Jahr 1974 nicht bekannt?

„Natürlich nicht des Wetters, nur des Klimas und das eben zeitlich und räumlich verschmiert.“

Falsch, (ich drück mich mal da bewußt etwas unpräzise aus, damit z.B. Dr. Paul eventuell intellektuell folgen kann) denn das „Modellwetter“ muß statistisch mindestens über eine WMO-Klimaperiode eine akzeptable Übereinstimmung abliefern. Und genau das liefern die GCM in den wesentlichen Parametern wie Niederschlag und Min-, Max-Temperatur eben nicht.

„Welche sich tatsächlich dann einstellen, ist aber zu einem nicht unbedeutenden Anteil manipulierbar. Das ist er eigentliche Punkt.“

Hmmm?

Meinten Sie nicht, daß die Herstellung der Szenarien manipulierbar ist und tatsächlich manipuliert erfolgt (weil niemand es überprüfen kann oder will)?

Sehr geehrter Herr Zuber, @ 133

ein ausgezeichneter Beitrag, sie haben es einfach die Geisteshaltung und Verhalten einiger Herren hier auf dem Punkt gebracht und was diese so antreibt.

Das verwerfliche an diese Herren ist, sie wissen ganz genau was sie tun und erfüllen für Geld wider besseren Wissens hier lediglich einen propagandistischen Auftrag: Verdummung und Irreführung von Lesern, die aus vielerlei Gründen, nicht so tief in dieser doch sehr komplexen Materie stecken.

Dabei ist es schon erstaunlich, mit welcher Schäbigkeit und betrügerischer Schläue sie sich ständig zu neuen Gipfeln der Arroganz hin aufschwingen.

Lieber Herr Heinzow, #198

„Mir ist kein GCM (vulgär Klimamodell) bekannt, welches ohne „spezielles Forcing“ das Maunder-Minimum und das Dalton-Minimum nachgebilden hat können.“

Mir auch nicht.

„Aber Sie behaupten ja mehr darüber zu wissen.“

Ja, gucken Sie mal, welche forcings in modernen GCMs fürs Klima der letzten Jahrhunderte angesetzt werden. Neben Treibhausgasen sind dies immer TSI und Sulphate durch Vulkanismus und inzwischen auch schon weitere geringer wirkende forcings.

Sonne und Vulkanismus nun „spezielle Forcings“ zu benennen, finde ich komisch.

„Zu Ihrer Information: Den Dust Bowl haben GCM-Modellierer nachbilden können.“

Würde mich auch wundern, bekanntlich reicht die regionale Auslösung nicht für jedes Detail. Und ob man dies in 10 Jahren hinbekäme, wage ich zu bezweifeln. Aber den „dust bowl“ und ähnliche regionale Klimaanomalien muss man nicht modellieren können, um zu wissen, was CO2-Verdopplung generell bewirkt, gell? 😉

„GCM sind mächtige Forschungsinstrumente, taugen aber m.E. nicht zur Vorhersage der Wetterzukunft. “

Natürlich nicht des Wetters, nur des Klimas und das eben zeitlich und räumlich verschmiert.

„Sie produzieren nur eine mögliche Zukunft von vielen Zukünften.“

Szenarien abhängig von möglichen Randbedingungen. Welche sich tatsächlich dann einstellen, ist aber zu einem nicht unbedeutenden Anteil manipulierbar. Das ist er eigentliche Punkt.

@ NicoBaecker # 195

Sie schrieben unter anderem: „Die kleine Eiszeit und ihre Erwärmung danach wird auch ohne CO2 in Klimamodellen erklärbar.“

Mir ist kein GCM (vulgär Klimamodell) bekannt, welches ohne „spezielles Forcing“ das Maunder-Minimum und das Dalton-Minimum nachgebilden hat können. Aber Sie behaupten ja mehr darüber zu wissen.

Lassen Sie mich und die anderen Leser an Ihrem behaupteten Wissensvorsprung teilhaben.

Zu Ihrer Information: Den Dust Bowl haben GCM-Modellierer nachbilden können. Wie, das können Sie hier lesen: http://tinyurl.com/ch8nkq7

GCM sind mächtige Forschungsinstrumente, taugen aber m.E. nicht zur Vorhersage der Wetterzukunft. Sie produzieren nur eine mögliche Zukunft von vielen Zukünften. Was allerdings nicht heißt, daß man sich diese Zukünfte nicht anschauen sollte.

Lieber Herr Baecker

Frage W:„Warum probieren Sie den Leuten hier einzureden man könne chaotische Prozesse der Zukunft durch Simulation ebensolcher chaotischer Prozesse voraussagen.“

Antwort B:“Ganz einfach, weil es nicht so primitiv abläuft, wie Sie es sich wünschen.“ Beurteilung B:“Ihnen fehlt die notwendige Konkretheit in der Sache. Mit platten Sprüchen werden Sie nie die naturgesetzliche Zusammenhänge verstehen und damit auch nicht, ein diskussionswürdiges Urteil über die Konsequenzen zu bilden.“ passt so rum viel besser. Nennt man Autodisqualifkation.

Auch wenn Sie es nicht kapieren können. Svensmark Mörner usw wollen kein Chaos bändigen und keine Zukunft vorhersagen, sondern sie wollen Prozesse verstehen lernen. Im Unterschied zum IPCC, PIK und Ihnen, den Klimapropagandisten. Besonders dankbar bin ich Ihnen, weil Sie wieder perfekt demonstrieren wie Sie und Ihresgleichen mit unangenehmen Fragen umgehen. Einfach neu formulieren. Daß der Sinn abhanden kommt spielt keine Rolle. Zukunft und Vergangenheit darf man nach Belieben vertauschen ist ja fast dasselbe wenn man das „richtige Prgramm“ benutzt.

MfG

Michael Weber

@ NicoBaecker #193

Ihre Behauptung: „Das ist falsch, die Klimamodellierung zeigt, dass die in der Vergangenheit gemessenen Vorgänge in der Atmosphäre mit mathematischen Modellen im Computer nachgebildet werden können.“ ist unzutreffend, wie bisher jeder Validierungsversuch der unterschiedlichen GCM gezeigt hat. Dies ist übrigens keine Abwertung der Leistungen der Modellierer, sondern eine Tatsachenfeststellung, deren zugrundeliegenden Tatsachen von Ihnen und den Medien unterdrückt werden.

Die GCM sind ohne Zweifel excellent programmierte Forschungsinstrumente, die bestimmte langfristige Vorgänge im Ozean-Land und Atmosphäresystem erklären konnten und je nach Implementierung – mit steigender Rechenleistung der sog. Numberchruncher – weiterer physikalische-chemisch-Prozesse, die bisher nur parametrisiert werden konnten, eventuell weiter erklären können.

Die GCM sind bisher nicht in der Lage die NAO, AO, AMO, PDO und andere periodisch im System auftretende „Schwingungen“ nachzubilden.

Auf die systematischen Abweichungen der Niederschläge zwischen 300 und 50% vom statistischen Mittel je nach ahreszeit und die systematisch zu niedrigen bzw. zu hohen Maximum- und Minimumtemperaturen habe ich bereits hingewiesen.

Ihre oben zitierte Behauptung hält einer näheren Überprüfung nicht stand.

Lieber Herr Weber, #194

Ihnen fehlt die notwendige Konkretheit in der Sache. Mit platten Sprüchen werden Sie nie die naturgesetzliche Zusammenhänge verstehen und damit auch nicht, ein diskussionswürdiges Urteil über die Konsequenzen zu bilden.

„Warum probieren Sie den Leuten hier einzureden man könne chaotische Prozesse der Zukunft durch Simulation ebensolcher chaotischer Prozesse voraussagen.“

Ganz einfach, weil es nicht so primitiv abläuft, wie Sie es sich wünschen.

„Wer versucht denn die Forschungsergebnisse von Svensmark, Mörner, Mangini, Schlüchter etc zu umgehen. Der Propagandawissenschaftler Baecker!“

Mal süffisant im gleichen Stil zurückgefragt: Sie meinen also, diese Forschungsergebnisse von Svensmark, Mörner, Mangini, Schlüchter würden das Chaos der Natur bändigen und die Zukunft vorhersagbar machen?

„Der behauptet nämlich noch immer, die einzige relevante „Randbedingung“ sei das „CO-2“ mit dessen Hilfe man das zukünftige Klima temperaturmässig steuern könne und müsse.“

Hören Sie auf zu lügen, Sie diskreditieren ernsthafte Skeptiker. Sie wissen genau, dass ich dies nicht behaupte! Das Klimasystem hat viele Randbedingungen.

„Politsxxxxxxxx unterschlagen Sie auch immer die Tatsache, daß eine Erwärmung nach einer kleinen Eiszeit auf diesem Planeten keineswegs ungewöhnlich ist.“

Die kleine Eiszeit und ihre Erwärmung danach wird auch ohne CO2 in Klimamodellen erklärbar. Nur stimmt die Erwärmung quantitativ nicht und weicht mit der Zeit zunehmend von den Beobachtungen ab. Also der klassische Fall von „da fehlt noch Physik im ModelL“.

Lieber Herr Baecker

„Sie koennen die Naturgesetze nicht umgehen. Haben Sie das nun endlich mal verstanden?“ Klar doch! Warum probieren Sie es eigentlich die ganze Zeit? Warum probieren Sie den Leuten hier einzureden man könne chaotische Prozesse der Zukunft durch Simulation ebensolcher chaotischer Prozesse voraussagen. Wer versucht denn die Forschungsergebnisse von Svensmark, Mörner, Mangini, Schlüchter etc zu umgehen. Der Propagandawissenschaftler Baecker! Der behauptet nämlich noch immer, die einzige relevante „Randbedingung“ sei das „CO-2“ mit dessen Hilfe man das zukünftige Klima temperaturmässig steuern könne und müsse. Herr Leistenschneider hat aufgezeigt, wie man den gegenwärtigen Temperaturzustand der Erde mit Hilfe der bekannten Physik erklären kann. CO-2 kam darin nicht einmal vor. Dazu haben Sie geschwiegen. Als Politsxxxxxxxx unterschlagen Sie auch immer die Tatsache, daß eine Erwärmung nach einer kleinen Eiszeit auf diesem Planeten keineswegs ungewöhnlich ist. Wissenschaftlich nachweisbar! Bevor Sie sich weiter in Behauptungen und Vermutungen ergehen beantworten Sie doch einfach mal Frage 3 und 3a.

MfG

Michael Weber

Lieber Herr Weber, #190

„Davon werden sie auch nicht richtiger.“

Bevor Sie etwas beurteilen können, müssen Sie es erst mal verstanden haben, und davon sind Sie noch weit entfernt.

„Ihre Antwort zu Frage drei sind zwei Konditionalsätze, die mit „wenn“ anfangen. “

Logisch. Denn die Zukunft ist nun mal noch nicht faktisch. Nur Hellseher glauben, die Randbedingungen des Klimasystems der Zukunft heute schon zu kennen, die Wissenschaft macht hingegen Szenarien für potentielle Randbedingungen.

Ihre Zusatzfragen können Sie einem Deutsch Grammatikkurs stellen. Da der Konditionalsatz nun mal durch die Ungewissheit der Zukunft bedingt ist und Sie darüber gestolpert sind, stelle ich Ihre Behauptung 3 um:

„Das Computer-Generieren von vergangenen Wetterdaten kann kein vergangenes Klima abbilden.“

Das ist falsch, die Klimamodellierung zeigt, dass die in der Vergangenheit gemessenen Vorgänge in der Atmosphäre mit mathematischen Modellen im Computer nachgebildet werden können.

„Und dann beantworten Sie noch einmal die Frage 5 ob man aus Computerkunstwetter reales gemessenes Klima machen kann.“

Die Antwort lautet „nein“. Denn man MACHT aus Computerkunstwetter KEIN reales gemessenes Klima, sondern VERGLEICHT es damit!!!!!!! Es gibt IMMER ZWEI Dinge in den Naturwissenschaften: Nämlich empirische Messung und die Theorie dazu!!

Zu letzten Mal: Lesen Sie oder geben Sie gleich zu, dass Sie Naturwissenschaften in den Wind schreiben!!! Ich kann respektieren, wenn man Naturwissenschaften ablehnt, nur Verlogenheit respektiere ich nicht! Sie haben die Wahl.

Bäckerchen, hören Sie auf Ihre Computerspiele als Physik zu verkaufen. Haderchen darf gleich mitlesen:

Meine unzureichende Kenntnisse in Physik und Informatik hindern mich nicht daran, sehr komplexe Algorithmen zu entwickeln. Bei solchen Entwicklungen ist immer unmittelbar klar, dass weder die technische Leitung (bei sehr komplexen Algorithmen mit Sicherheit ein Vollblutinformatiker, der keine Gehirnwindung für die Physik frei hat), und schon gar nicht die fachliche Leitung (meistens ein Physiker, auch bei anderen Inhalten, da bei dieser Ausbildung offensichtlich das abstrakte Denken überentwickelt ist), wissen, was die einzelnen Codezeilen beinhalten und was sie genau bewirken. Sie tragen ausschließlich die Handschrift der Codezeileschreiber (denken Sie daran, bei der Suche nach den Virenentwicklern wird zuerst die „Handschrift“ verglichen), und haben mit der Natur nichts, aber auch gar nichts gemeinsam. Auf dem Niveau der Codeentwicklung hat die Arbeit auch nichts mehr mit Wissenschaft zu tun, die Codezeileschreiber kreieren gegen Bezahlung Formeln, die die vorgegebenen inhaltlichen Auswirkungen erreichen, z.B. der CO2-Temperaturzusammenhang. Wenn ich genügend Geld beisammen haben, werde ich die CO2-Klimamodellierer beauftragen, Klimamodelle zu entwickeln, bei denen ausschließlich die Sonne die Schwankungen steuert. Einfach aus Spaß! Meine exzellente Mannschaft könnte es auch locker, sie hat aber wichtigeres zu tun, Steuergelder zu verdienen, damit Sie und das PIK nicht verhungern.

Ähnlichkeiten der Simulationen mit vergangenen Klimaereignisse sind gewollt und letztendlich mit anderen Mitteln erreicht. So wie die Glühbirne gewollte Ähnlichkeiten mit der Sonne hat, es kommt aber niemand auf die Idee, die Kernfusion in der Glühbirne „wissenschaftlich“ zu beweisen.

Vergleiche mit der Wettervorhersage sind unangebracht, da aufgrund 4 entscheidender Systemunterschiede aus dem reinen „würfeln“ hierbei eine gewisse Annäherung erzielt wird:

1. Die Prozesse der Wetterbildung sind gegenüber der Klimaschwankungen deutlich weniger komplex, Sonnenflecken, Magnetfeld und und und…. kann man ignorieren.

2. Die Prozesse der Wetterbildung sind erforscht.

3. Die Schnittstelle zu Natur, die ständige Korrektur der im voraus falsch vorhergesagten Wetterdaten mit den neu exakt ermittelten Werten von tausenden Wetterstationen. Wenn auf Basis der falsch vorhergesagten Temperaturen von nächster Woche dann weitergerechnet würde, würde es immer fälscher. Damit ist auch der Sinn der computergestützte Vorhersage erschöpft, nicht dass diese Modelle die Natur „besser wiederspiegeln“ als die Bauernregeln, sondern dass durch die permanente Datenkorrektur die Fehlertoleranz reduziert wird.

4. Die Berechnungsfehler werden täglich aufgezeigt und damit kann man Algorithmuskorrekturen vornehmen, wenngleich auch diese keine Wiederholung der Schöpfung sind.

Virtuelle Klimamodelle gaukeln nur etwas vor, dem der es glauben will.

Frage 4: “ Wetter ist ein chaotischer Prozess“. Wetter ist ein deterministisch chaotischer Prozess, war das Ihre Frage, so lautet die Antwort „richtig“. Aber wir waren bei seiner Statisitik, dem Klima. Und wie ich bereits mit den Wuerfeln erklaert haben, kann der Einzelprozess nicht bestimmt vorhersagbar ablaufen, aber seine Haufigkeit ist vorhersagbar. Also auch wenn die genaue Wettersequenz nicht bestimmbar ist, so ist denoch klar, dass diese Wettersequenz die Eigenschaften hat, die zu den herrschenden Randbedingungen gehoeren, das ist nunmal Physik. Sie koennen die Naturgesetze nicht umgehen. Haben Sie das nun endlich mal verstanden?

Lieber Herr Baecker

Wieso sollte ich Ihren pseudowissenschaftlichen Erklärungen folgen. Davon werden sie auch nicht richtiger. Ihre Antwort zu Frage drei sind zwei