Nein, wir befinden uns derzeit nicht in einem Massenaussterben, auch wenn manche Wissenschaftler und Organisationen von einem sechsten Massensterben berichten. Im Gegenteil: Wir leben in einer ruhigen, ja geradezu langweiligen Epoche der Erdgeschichte.

von Uta Böttcher

Es gab in der Geschichte des Lebens auf der Erde, dem Phanerozoikum, fünf große Massensterbe. Also betrachten wir diese fünf Einschnitte in das Leben der Erde genauer und beleuchten die Ursachen, die tatsächlich zu solchen lebensbedrohenden Katastrophen geführt haben. Im ersten Teil dieses Artikels betrachteten wir die drei ersten Massenaussterben auf der Erde und die Umstände, wie es dazu kommen konnte, analytisch. In diesem zweiten Teil schauen wir uns die zwei späteren Massenaussterbeereignisse genauer an und – im Vergleich dazu – unsere heutige Situation.

Um zu prüfen, ob der CO2-Gehalt in der Atmosphäre die Hauptursache für massive Krisen für das Leben auf der Erde war, sind in der Grafik oben die Daten der globalen Temperatur als rote Kurve und des CO2-Gehalts als blaue Kurve über die vergangenen 485 Millionen Jahre in einer Grafik vereint. Dazu kommt eine grüne Kurve, die die Aussterberaten in Prozent der Gesamtpopulation auf der Erde darstellt: Die fünf großen Massenaussterben in der Geschichte des Lebens sind mit einem schwarzen Kreuz gekennzeichnet. Temperatur und Aussterberate sind linear und der CO2-Gehalt halblogarithmisch dargestellt, um diesen kompakt zeigen zu können.

Das Ende der Trias-Zeit vor 201 Millionen Jahren: Der Superkontinent Pangäa zerbricht

Zum Ende der Trias-Zeit vor 201 Millionen Jahren begann der Superkontinent Pangäa zu zerbrechen. Es bildete sich der Grabenbruch im Zentrum des Kontinents – ähnlich dem heutigen Rift Valley in Ostafrika – nur viel großräumiger, verbunden mit massiver vulkanischer Aktivität. Aus diesem Bruch ist der Atlantische Ozean entstanden, von dessen Mittelatlantischem Rücken aus Nord- und Südamerika auf der einen Seite und Afrika und Eurasien auf der anderen Seite nach wie vor auseinanderdriften.

Das Massenaussterben am Ende der Trias-Zeit wurde durch die damit verbundenen massiven Vulkanausbrüche verursacht: Es entstand die Zentralatlantische Magmatische Provinz (CAMP). Der ganze Riesenkontinent Pangäa zerbrach in die uns heute bekannten Kontinentalmassen. Es entstand das, was wir heute als Atlantischen Ozean kennen, und dessen Riss in der Mitte (Mittelatlantischer Rücken), immer noch unentwegt mit Lava „geflickt“ wird.

Der massive Vulkanismus dauerte etwa 600 000 Jahre an, es wurden bis zu 4.000.000 Millionen Kubikmeter Lava frei und 100.000 Gigatonnen an Gasen. Kaum hatte sich die Erde von einer größeren Eruptionsphase erholt, folgte die nächste, über mehr als eine halbe Millionen Jahre hinweg. Es kam zu Versauerung und der Entstehung von sauerstoffarmen Zonen in den Ozeanen, was dort den Meereslebewesen die Lebensgrundlage entzog. Diese Kaskade verursachte eine Destabiliserung der Ökosysteme insgesamt, besonders in den äquatornahen, tropischen Regionen.

Die massiven Eruptionen begannen zwischen 10.000 und 20.000 Jahre vor dem Aussterben. Obwohl dieses Massenaussterben nicht so gravierend war wie das zum Ende der Perm-Zeit, verloren dadurch viele Arten an Vielfalt und manche starben aus. Betroffen waren zahlreiche marine Arten. An Land waren frühe Reptilien und Amphibien betroffen. Krokodile und die frühen Dinosaurier überlebten, was ihnen die Gelegenheit gab, sich in der darauf folgenden Jura-Zeit zu diversifizieren und auszubreiten.

Diese Eruptionen in der CAMP-Provinz produzierten riesige Basaltlavaströme und setzten gewaltige Mengen an Schwefeldioxid, Wasserdampf, Kohlendioxid und anderen Gasen frei, die das Klima beeinflussten. In der Trias-Zeit war die globale Temperatur eher warm, mit einer globalen Durchschnittstemperatur von 25 Grad Celsius, und die Pole waren eisfrei. Das durch die Eruptionen freigesetzte Schwefeldioxid sorgte zunächst für eine Abkühlung des Klimas, von 25 auf 22 Grad Celsius, einem vulkanischen Winter. Danach stiegen die globalen Temperaturen langsam wieder an auf moderate 25 Grad Celsius an. Durch den langanhaltenden massiven Vulkanismus herrschte ein Klimachaos und durch vulkanisches Gas entstanden lebensfeindliche Zonen in den Meeren.

Der Kohlendioxidgehalt war zur Zeit des Massenaussterbens zum Ende der Trias-Zeit im Vergleich zu vorher leicht erhöht und lag bei maximal 0,11 Prozent oder 1100 ppm. Der massive Vulkanismus verursachte zuerst eine Abkühlung von 25 auf 22 Grad, dann eine moderate Wiedererwärmung um 3-4 Grad auf die Temperaturen, die vor der Abkühlung herrschten, bei gleichzeitigem Abfall der CO2-Konzentration auf 0,08 Prozent oder 800 ppm.

Derzeit wird von Klimamodellen eine Klimasensibilität von 8 Grad Celsius bei einer Verdopplung des CO2-Gehaltes in der Atmosphäre berechnet: Das bedeutet, ausgehend von unseren rezenten gut 400 ppm CO2 und 15 Grad Celsius globaler Temperatur sollte demnach eine Erhöhung auf 800 ppm CO2 zu einer globalen Temperatur von 23 Grad Celsius führen. Das deckt sich aber in keiner Weise mit den Temperatur- und CO2-Daten im Verlauf der Erdgeschichte. Offenbar gibt es einen solchen simplen Zusammenhang nicht. Die Vorgänge sind weit komplexer und werden offensichtlich noch nicht vollständig verstanden, geschweige denn von den Klimamodellen abgebildet.

Dinosauriersterben am Ende der Kreidezeit vor 66 Millionen Jahren – Ein Asteroideneinschlag und Vulkanismus

Das vielleicht bekannteste Massenaussterben ereignete sich am Ende der Kreidezeit vor 66 Millionen Jahren. Alle Dinosaurier verschwanden, ebenso wie viele andere große Reptiliengruppen wie Flugsaurier, Plesiosaurier und Mosasaurier. Auch Landpflanzen und pflanzenfressende Insekten erlitten große Verluste. Hauptursache war ein gewaltiger Meteoriteneinschlag im heutigen Mexiko. Dennoch war das Massenaussterben vor 66 Millionen Jahren das Ergebnis einer Verknüpfung aus mehreren Umweltkatastrophen, die innerhalb eines kurzen Zeitraums zusammenwirkten.

Auf der heutigen Yucatán-Halbinsel in Mexiko schlug ein Asteroid mit einem Durchmesser von 10 bis 15 km ein. Weltweit lässt sich in der Kreide-Paläogen-Grenzschicht eine Iridium-Anomalie messen (z. B. in Gubbio, Italien); Iridium ist auf der Erde selten, jedoch enthalten manche Asteroiden große Mengen davon. Dadurch ließ sich die extraterrestrische Ursache und dessen weltweite Auswirkung bestätigen.

Der Einschlag verursachte erdumfassend Brände, organische Materie entzündete sich: Rußschichten in Sedimenten belegen dies. Er verursachte auch seismische Wellen und riesige Tsunamis, die Küstenregionen zerstörten. Es kam zu einem Impact-Winter: Staub und Schwefel-Aerosole blockierten das Sonnenlicht, und dadurch zu einer plötzlichen globalen Abkühlung von 10 Grad Celsius, die über Jahre anhielt. Die Photosynthese der Pflanzen wurde für bis zu zwei Jahren blockiert und Nahrungsketten brachen zusammen.

Parallel dazu entstanden die Deccan-Trapps in Indien: Über 500.000 Jahre hinweg entstanden immer neue Flutbasalt-Schichten, und mit der Lava wurden enorme Mengen an Wasserdampf, Methan (CH4), Kohlendioxid (CO2), und Schwefeldioxid (SO2) in die Atmosphäre abgegeben. Quecksilber-Peaks in den Gesteinsschichten dieser Zeit belegen die weltweiten Auswirkungen dieser enormen vulkanischen Tätigkeit. Die Hauptphase der Deccan-Eruptionen fand kurz vor und während des Einschlags statt (Die Zeiten wurden radiometrisch gemessen mit Hilfe von U-Pb-Datierungen von Zirkonen in Deccan-Laven). Dadurch verschärfte sich die Klimakrise noch. Es kam zu Ozeanversauerung und Schädigung der Kalkbildner. Der Vulkanismus wirkte demnach als Belastung vor dem Einschlag und verlängerte die Erholungszeit durch längerfristige Erwärmung und Versauerung der Ozeane.

Das Kreide-Paläogen-Massenaussterben traf sowohl marine als auch terrestrische Ökosysteme, wobei tropische und große Arten besonders stark betroffen waren. Alle terrestrischen Dinosaurier starben aus, vermutlich vorwiegend durch den Nahrungskollaps nach dem Impact-Winter. Kleinere, wie die Vorfahren unserer heutigen Vögel, überlebten. Auch frühe, anpassungsfähige Säugetiere überstanden die Krise und konnten sich im darauffolgenden Paläogen entfalten. Diesem Umstand verdanken wir also auch unsere eigene Existenz.

An der Kreide-Paläogen-Grenze lag der CO2-Wert bei 0,01 Prozent oder 1000 ppm. Es ist kein direkter Zusammenhang zwischen den Temperaturschwankungen und der CO2-Konzentration in der Atmosphäre festzustellen. Der Temperaturrückgang wurde vielmehr durch den Einschlag eines großen Asteroiden verursacht, der darauf folgende Anstieg durch die riesigen Vulkaneruptionen im heutigen Indien.

Haben wir es heute mit dem sechsten großen Massenaussterben zu tun?

Was ein einzelner außergewöhnlichen Vulkanausbruch bereits mit dem globalen Klima anrichten kann, dessen Zeuge wir Menschen kürzlich werden durften – Geologen freuen sich über so etwas – konnten wir im Jahr 2022 selbst erleben:

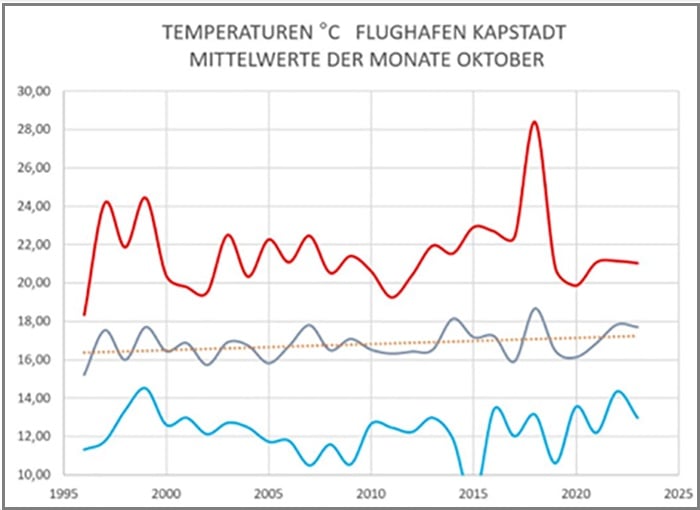

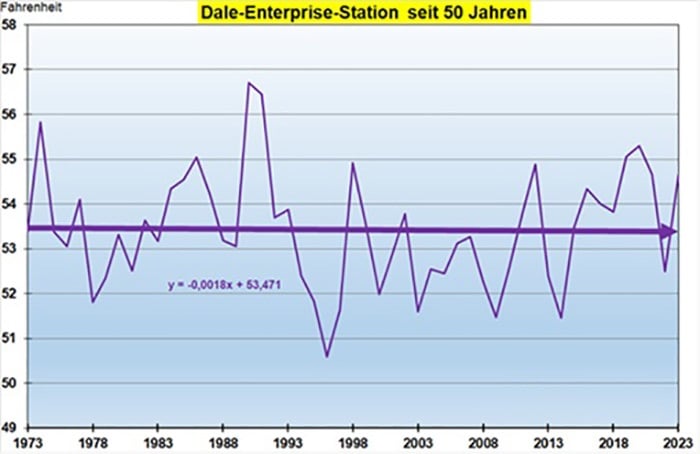

Seit wir Menschen das Wetter aufzeichnen, beobachten wir, wie sich unser Planet langsam von der letzten Kaltzeit erholt und es wieder wärmer wird. Aber im Jahr 2023 gab es tatsächlich eine Klimaanomalie: Der gesamte Globus war überdurchschnittlich warm, der Großteil der Erwärmung fand auf der Nordhalbkugel statt. Die Temperaturerhöhung war größer als im Rahmen des normalen Trends erwartet, nämlich 0,17 Grad Celsius. Dies ließ sich nicht mit dem El Niño begründen, denn der Anstieg trat Monate vor dessen Einsetzen auf. Die Erwärmung ist auch nicht durch die gestiegene CO₂-Konzentration in der Atmosphäre zu erklären, denn diese hat sich von 2022 bis 2023 nur um etwa 2,5 ppm auf 412 ppm erhöht, was diesen Anstieg nicht verursachen kann.

Der Rückgang der Schwefelemissionen seit Ende der 1970er Jahre wird als bedeutender Erwärmungsfaktor angesehen, da er die Emissionen der von der Atmosphäre reflektierten Kurzwellenstrahlung verringert. Der Rückgang der Schwefeldioxid-Emissionen aus Schiffskraftstoffen wird auf 14 Prozent der Gesamtemissionen seit 2020 geschätzt. Aber dies kann nur eine globale Erwärmung von 0,02 Grad Celsius verursachen.

Dagegen fand im Januar 2022 in Tonga im Südpazifik ein ungewöhnlicher Vulkanausbruch statt: Der Vulkan Hunga Tonga-Hunga Ha‘apai explodierte in einer äußerst starken Eruption – eine, die die Stratosphäre erreichen kann. Es handelte sich um eine submarine Explosion, etwa 150 Meter unter der Meeresoberfläche: 150 Millionen Tonnen Wasser wurden als Dampf in die Stratosphäre geschleudert.

Wasserdampf ist ein äußerst wirksames Treibhausgas, und Veränderungen der Wasserdampfmenge hat besonders in der Stratosphäre einen starken Einfluss auf das Klima: Nach dem Tonga-Ausbruch stieg der Wasserdampfgehalt in der Stratosphäre um 10 Prozent. Das Wasser verteilte sich durch die Stratosphärenzirkulation, die Wirkung setzte um mehr als ein Jahr verzögert ein, und verursachte ab 2023 die beobachtete gravierende weltweite Temperaturerhöhung. Diese Eruption wird das Klima noch für mehrere Jahre verändern. Der Wasserdampf der Tonga-Eruption kehrt bereits langsam wieder in die Troposphäre zurück, im Jahr 2023 taten dies etwa 20 Millionen Tonnen, entsprechend 13 Prozent der Gesamtmenge. Derzeit ist ein Vulkanausbruch wie die des Tonga zum Glück etwas, das maximal alle 200 Jahre auftritt, wahrscheinlich sogar nur einmal in einem Jahrtausend.

Es gibt weitere historische Beispiele:

Ein gewaltiger Vulkanausbruch zerriss im Jahr 1815 den indonesischen Mount Tambora, mit Auswirkungen auf das globale Klima. Der Vulkan schleuderte riesige Mengen an Asche und Schwefelgase bis in die Stratosphäre. Diese verteilten sich global, und die Sulfataerosole schatteten das Sonnenlicht so stark ab, dass sie für das sommerlose Jahr 1816 sorgten mit Kälte, Frost und Missernten auf der Nordhalbkugel.

Durch den Ausbruch des Pinatubo auf den Philippinen im Jahr 1991 gerieten etwa 20 Millionen Tonnen Schwefeldioxid (SO₂) in die Stratosphäre. Daraus bildeten sich Sulfataerosole, die das Sonnenlicht streuten und reflektierten: Die Sonneneinstrahlung reduzierte sich um etwa 10 Prozent, was zu einer weltweiten Abkühlung von durchschnittlich 0,4 bis 0,6 Grad Celsius in den Jahren 1991 bis 1993 führte. Besonders 1992 war dies deutlich spürbar.

Es schlummern mehrere Vulkane verborgen unter dem Vatnajökull-Gletscher in Island. Einer davon, der Grímsvötn, hatte im Mai 2011 seinen stärksten Ausbruch seit über 100 Jahren. Er schleuderte seine Asche bis zu 20 km, diese verteilte sich über Nordeuropa, Skandinavien, Großbritannien und Teile Mitteleuropas. Die Asche und Schwefel-Aerosole störten den europäischen Luftverkehr und führten zu einer leichten, temporären Reduktion der Sonneneinstrahlung in den betroffenen Regionen.

Zusammengefasst kann unsere aktuelle Klimasituation folgendermaßen beschrieben werden: In gut 90 Prozent des Phanerozoikums war es auf der Erde wärmer als jetzt, in rund 70 Prozent gab es keine Gletscher und keine Eiskappen an den Polen. Die meiste Zeit herrschte eine mittlere globale Temperatur von über 20 Grad Celsius, und unter diesen Bedingungen entwickelte sich das Leben auf der Erde. Wir Menschen leben derzeit in einem Eiszeitalter und zwar in einer etwas wärmeren Zwischenperiode, Holozän genannt (vgl. Hurra, wir retten die Eiszeit)

Das Narrativ über den eindeutigen Zusammenhang zwischen CO2-Konzentration und Erdtemperatur gilt als verbindliche Doktrin unserer Zeit und politisch gesetzt. Im Verlauf der Erdgeschichte gab es lang andauernde Zeitabschnitte und gravierende einzelne Events, wo kein Zusammenhang zwischen globaler Durchschnittstemperatur und einer hohen oder niedrigen CO2-Konzentration festzustellen ist. Dennoch wird alarmistisch behauptet, dass eine Erhöhung der CO2-Konzentration unser aller Untergang sein wird. Die Menschheit wird in Panik versetzt, und unzählige – wahrscheinlich bestenfalls sinnlose – Maßnahmen werden von der Politik eingeleitet, um das CO2 zu reduzieren. (vgl. CO2 und Temperatur: Unbotmäßige CO2-Kurven)

Nein, wir befinden uns derzeit nicht in einem Massenaussterben, auch wenn manche Wissenschaftler und Organisationen von einem rezenten sechsten Massensterben berichten. Und es soll noch dazu ausschließlich auf menschliche Aktivitäten zurückzuführen sein. Im Gegenteil: Wir können froh sein, dass wir in dieser äußerst ruhigen und ereignislosen, ja geradezu langweiligen Epoche der Erdgeschichte leben.

In lebensbedrohliche Zustände geriet die Erde in ihrer Geschichte entweder durch gigantische Vulkanausbrüche, die über hundertausende von Jahren andauerten und deren komplexen Auswirkungen auf Lebensräume und Klima, durch eine Eiszeit mitten auf einem riesigen Kontinent, durch den Einschlag eines großen Asteroiden oder den Tod eines massereichen Sterns, eine Supernova, in Erdnähe. Aber kein einziges Mal in der Erdgeschichte führte die simple Erhöhung des CO2-Gehaltes zu einer Krise für das Leben auf der Erde.

Teil eins finden Sie hier.

Alle Fotos: Imago

Anhang für Interessierte: Wissenschaftliche Fachartikel zum Thema:

MacLeod, N. 2003: The causes of Phanerozoic extinctions. In: L.J. Rothschild & A.M. Lister: Evolution on Planet Earth. Academic Press, Amsterdam, 253-277.

E. J. Judd et al.: A 485-million-year history of Earth’s surface temperature.

In: Science 385, eadk3705 (2024). DOI: 10.1126/science.adk3705

Smart, M.S., Filippelli, G., Gilhooly, W.P. et al.: The expansion of land plants during the Late Devonian contributed to the marine mass extinction. Commun Earth Environ 4, 449 (2023), 29. November 2023, https://www.nature.com/articles/s43247-023-01087-8 , https://doi.org/10.1038/s43247-023-01087-8

Adrian L. Melott, Brian C. Thomas, et al.: Supernova triggers for end-Devonian extinctions.

In: Proceedings of the National Academy of Sciences (PNAS), Vol. 117, No. 35,

18. August 2020, DOI: 10.1073/pnas.2013774117, https://doi.org/10.1073/pnas.2013774117, https://www.pnas.org/doi/10.1073/pnas.2013774117

Sam Tonkin, Dr. Robert Massey: Violent Supernova triggered at least two Earth extinctions. IN: Royal Astronomical Society (MNRAS), Keele University-Pressemitteilung vom 13. März 2025, https://ras.ac.uk/news-and-press/research-highlights/violent-supernovae-triggered-least-two-earth-extinctions

Alexis L. Quintana, Nicholas J. Wright, Juan Martínez García: A census of OB stars within 1 kpc and the star formation and core collapse supernova rates of the Milky Way. Monthly Notices of the Royal Astronomical Society, Volume 538, Issue 3, April 2025, Pages 1367–1383, 18. März 2025, https://doi.org/10.1093/mnras/staf083, https://academic.oup.com/mnras/article/538/3/1367/8024142?login=false

Jurikova, H., Gutjahr, M., Wallmann, K. et al.: Permian-Triassic mass extinction pulses driven by major marine carbon cycle perturbations. Nat. Geosci. 13, 745–750 (2020). https://doi.org/10.1038/s41561-020-00646-4, 19. October 2020

Hier zusammengefasst auf Deutsch: https://www.geomar.de/news/article/ausloeser-fuer-groesstes-massenaussterben-der-erdgeschichte-identifiziert

Jennifer Chu: Huge and widespread volcanic eruptions triggered the end-Triassic extinction. MIT News Office, 21. März 2013, https://news.mit.edu/2013/volcanic-eruptions-triggered-end-triassic-extinction-0321

Devin Voss, School of Science at IUPUI, News at IU Indiana University: Study reshapes understanding of mass extinction in Late Devonian era. 6. Dezember 2023, https://news.iu.edu/live/news/33770-study-reshapes-understanding-of-mass-extinction-in

Senel, C.B., Kaskes, P., Temel, O. et al.: Chicxulub impact winter sustained by fine silicate dust. Nat. Geosci. 16, 1033–1040 (2023). https://doi.org/10.1038/s41561-023-01290-4, 30. Oktober 2023, https://www.nature.com/articles/s41561-023-01290-4

Alfio Alessandro Chiarenza et al.: Asteroid impact, not volcanism, caused the end-Cretaceous dinosaur extinction. In: Proceedings of the National Academy of Sciences (PNAS), Vol. 117, No. 29, 17084-17093, 29. Juni 2020, https://doi.org/10.1073/pnas.2006087117, https://www.pnas.org/doi/10.1073/pnas.2006087117

J. C. McElwain, D. J. Beerling and F. I. Woodward: Fossil Plants and Global Warming at the Triassic-Jurassic Boundary. Science, Vol 285, Issue 5432, pp. 1386-1390, 27. Aug 1999, DOI: 10.1126/science.285.5432.1386

Capriolo, Manfredo et al.: Massive methane fluxing from magma-sediment interaction in the end-Triassic Central Atlantic Magmatic Province. Nature Communications. 12. 5534. DOI: 10.1038/s41467-021-25510-w, September 2021 https://www.researchgate.net/publication/354697257_Massive_methane_fluxing_from_magma-sediment_interaction_in_the_end-Triassic_Central_Atlantic_Magmatic_Province

Jane J. Lee / Andrew Wang: Tonga Eruption Blasted Unprecedented Amount of Water Into Stratosphere. Jet Propulsion Laboratory, Pasadena, Calif., 2. August 2022, https://www.nasa.gov/earth/tonga-eruption-blasted-unprecedented-amount-of-water-into-stratosphere/

Javier Vinós: Hunga Tonga volcano: Impact on record warming. www.wattsupwiththat.com, 9. Juli 2024, https://wattsupwiththat.com/2024/07/09/hunga-tonga-volcano-impact-on-record-warming/

Auf Deutsch übersetzt: Der Hunga Tonga Vulkan: Auswirkung auf Rekord-Erwärmung. www.eike-klima-ernergie.eu, 11. Juli 2024, https://eike-klima-energie.eu/2024/07/11/der-hunga-tonga-vulkan-auswirkung-auf-rekord-erwaermung/

Zhou, X., Dhomse, S. S., Feng, W., Mann,G., Heddell, S., Pumphrey, H. et al.: Antarctic vortex dehydration in 2023 as a substantial removal pathway for Hunga Tonga‐Hunga Ha’apai water vapor. Geophysical Research Letters, 51, e2023GL107630, 20. März 2024, https://doi.org/10.1029/2023GL107630

Yoshioka, M. et al.: Warming effects of reduced sulfur emissions from shipping, EGUsphere, 2024, pp.1-19., https://doi.org/10.5194/egusphere-2024-1428, 17. Mai 2024, https://egusphere.copernicus.org/preprints/2024/egusphere-2024-1428/

Uta Böttcher Uta Böttcher ist Diplom-Geologin mit dem Fachbereich angewandte Geologie, speziell Hydrogeologie. MEHR

Der Beitrag erschien zuerst bei ACHGUT hier

(Bild: privat)

(Bild: privat) (Grafik: Kowatsch)

(Grafik: Kowatsch)