von Uli Weber

Der Startbildschirm von MS EDGE poppte am 5. Juli 2024 mit einer interessanten Meldung von StarsInsider hoch, die dort bereits vom 31. Jan. 2024 datiert. In der MSN-Überschrift heißt es, „Wie 22 Atombomben: Der Asteroid, der auf der Erde einschlagen wird, heißt Bennu“:

Abbildung: Screenschot der MS EDGE-Meldung vom 5. Juli 2024

Nun stolpert der physikalisch vorbelastete Betrachter aber sofort über die dort angegebene Einschlagenergie von 22 Atombomben für einen extraterrestrischen Körper, der sich ja mit Geschwindigkeiten im Bereich von 10-er Kilometern pro Sekunde fortzubewegen pflegt. So soll beispielsweise vor 66 Millionen Jahren ein etwa 14 km großer Kumpel von Bennu die Dino-Familie ausgelöscht haben. Zwar hat Bennu nur einen mittleren Durchmesser von einem halben Kilometer, aber trotzdem erscheint eine niedrige 2-stellige Anzahl von Atombomben, die üblicherweise in Hiroshima-Stärke ausgedrückt werden, für den Einschlag eines extraterrestrischen Körpers auf der Erde extrem mickerig.

Also schaunmermalgenauerhin:

Die Energie der Hiroshima-Bombe wird mit 56 Terajoule angegeben, 22 davon haben dann also 1.232 Terrajoule.

Laut Wikipedia hat Bennu eine mittlere Geschwindigkeit V von 27,75 Kilometern pro Sekunde und ein Gewicht M von etwa 70 Millionen Tonnen.

Die Physik liefert die Formel für die Energie: E = (M/2) * V² und das Ergebnis lautet dann auf eine Energie von 27.000.000 Terrajoule.

Und 27.000.000 TJ geteilt durch 1.232 TJ ergibt dann mal eben das 21.916-fache der Energie von den 22 Atombomben in der Überschrift.

Im Ergebnis hatten sich die dort zitierten „F_orscher“ nur mal eben um einen Multiplikator von 22×103 verrechnet, denn Bennus Einschlagenergie entspricht vielmehr 22.000 x 22 Hiroshimabomben. Auf der anderen Seite spielen in unseren MINT-fernen postwissenschaftlich-hochemotionalen Zeiten drei Zehnerpotenzen auch nicht mehr die gleiche Rolle wie noch zu alten D-Mark-Zeiten. So wird heute beispielsweise ausgabentechnisch der Unterschied zwischen Millionen und Milliarden nur noch als marginal empfunden – jedenfalls solange es sich dabei „nur“ um unsere Steuergelder handelt. Nennen wir solche Steuerleute unter Beibehaltung der obigen Schreibweise also einfach mal „P_olitiker“, um auch diese Art von Potenzschwäche einmal klar und deutlich hervorzuheben…

Man könnte diesen Text jetzt mit ein paar lustigen Worten beenden, beispielsweise: Der berechnete Multiplikator von 22×103 gilt für 22 Atombomben von Hiroshimastärke, was am Ende bedeutet, dass wir bei Bennu mit einer Einschlagenergie von etwa 500.000 Hiroshima-Bomben zu rechnen haben – was immer sich die oben zitierten MINT-fernen „F_orscher“ auch zusammengerechnet haben mögen; vielleicht waren es ja 22 „F_orscher“ , dann bekommt immerhin jeder von denen seine eigene…

Allerdings haben dieselben „F_orscher“ dazu auch noch das genaue Einschlagdatum ermittelt, Zitat:

„Die Wissenschaftler glauben jedoch, dass der 24. September 2182 das Datum sein könnte, an dem ein echtes Risiko einer Kollision zwischen der Erde und dem Asteroiden besteht.“

Kann es vielleicht sein, dass die besagten Wissenschaftler Bennus mögliches Einschlagdatum richtig und seine Einschlagenergie falsch berechnet haben? – Wohl eher nicht!

Aber noch vor Bennus Einschlagdatum liegt ein epochaler zwangsgesteuerter Umbruch in der Menschheitsgeschichte, nämlich die Dekarbonisierung der ganzen Welt bis zum Jahre 2100. Erstmalig in der Geschichte der Menschheit wird der freie Wettbewerb der landwirtschaftlich-technischen und der zivilisatorisch-kulturellen Entwicklung vorsätzlich über menschengemachte Gesetze zurückentwickelt, im Grunde von zuverlässiger industrieller Bereitstellung einer pro Kopf Energiemenge vom 90-fachen des menschlichen Grundbedarfs, vergleichbar mit einem römischen Kaiser, hin zu einer volatilen Energieversorgung mit dem spätmittelalterlichen 30-fachen des menschlichen Grundbedarfs. Der Grund dafür ist die panische Angst vor einer Selbstverbrennung unserer Erde durch den industriellen CO2-Ausstoß bei der Nutzung fossiler Energiequellen. Und diesem hehren Ziel darf nach einer grenzdebilen Zieldefinition nichts, aber auch gar nichts entgegenstehen; denn heute ist man ja bereits im irrealen Endstadium des festen Glaubens, in landschaftlichen Schutzgebieten die Natur schützen und dort gleichzeitig klimafreundliche Energie aus Sonne und Wind erzeugen zu können. Es interessiert auch keinen Menschen mehr, dass alle Beweise für die sogenannte Klimakatastrophe menschengemacht sind. Nicht nur, dass man den Klimawahn von seinen physikalischen Grundlagen her auch ganz anders sehen kann, selbst die vorgeblichen Beweise halten einer wissenschaftlichen Überprüfung nicht stand. Und die vorgeblich beweisträchtigen Temperaturreihen sind schlecht gemachte Manipulationen unzureichender Daten von Glaubenseiferern, denen längst abgebaute Temperaturstationen bis heute Temperaturwerte zuliefern, die dann in solche Berechnungen eingehen. Kluge Klimarealisten lehnen es daher grundsätzlich ab, überhaupt auf die sogenannte „globale Durchschnittstemperatur“ einzugehen. Das hilft nur leider gar nix, denn hunderte Millionen Menschen werden ständig mittels dieser herbeiphantasierten Kunstgröße in Angst und Schrecken versetzt, und deshalb muss deren Sinnfälligkeit nun einmal für alle nachvollziehbar in Frage gestellt werden.

Ein Exkurs zur „globalen Durchschnittstemperatur“:

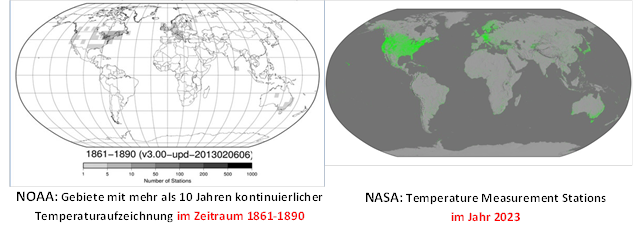

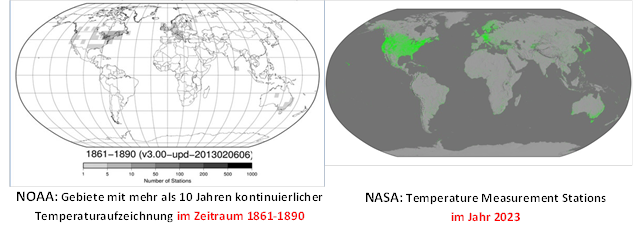

Abbildung: Vergleich der globalen Temperaturstationen zum Ende des 19. Jahrhunderts und heute

Abbildung: Vergleich der globalen Temperaturstationen zum Ende des 19. Jahrhunderts und heute

Wenn wir einmal die beiden Abbildungen für die globalen Temperaturstationen „1861-1890“ und „2023“ vergleichen, so hat sich in den vergangenen 130 Jahren also nicht wirklich viel verändert. Wo im 19. Jahrhundert bereits kontinuierliche Temperaturaufzeichnungen durchgeführt worden waren, ist deren Dichte noch weiter angewachsen. In der restlichen Welt ist ein dünnes Stationsnetz entstanden und auf den Ozeanen schwimmen jetzt zusätzlich noch ein paar tausend Argo-Bojen herum, das war’s auch schon. Noch immer geht es nicht um den direkt berechneten Mittelwert aus Temperaturmessungen, die zur selben Weltzeit über Tag&Nacht, Sommer&Winter, Frühling&Herbst auf der Nord- und Südhalbkugel gemessen werden. Nein, es geht immer noch darum, mit statistischen Computerprogrammen aus einem sporadisch verteilten globalen Stationsnetz mit Riesenlücken ein globales Temperaturgrid zu interpolieren, wobei den individuellen geografischen Gegebenheiten der jeweiligen Ortslagen eine ganz wesentliche Rolle zukommen dürfte. Erst aus dieser Kunstfigur lässt sich dann wiederum die sogenannte Globaltemperatur herleiten. Gegenüber den eigentlichen Temperaturmessungen spielen also die eingesetzten statistischen Verfahren die entscheidende Rolle für diese Berechnung und man kann sich leicht vorstellen, dass der Wechsel von Gridgröße und statistischer Rechenmethode einen wesentlich größeren Einfluss auf die sogenannte „Globaltemperatur“ ausüben dürfte als ein kapitaler Vulkanausbruch.

Die eigentlichen Beweise für die befürchtete Klimakatastrophe werden also lediglich mit High-Tech-Computerspielen hergestellt, bei denen CO2 als fest vorgegebener „Klimakiller“ einprogrammiert ist. Solche High-Tech-Computer erfordern für ihren Betrieb wiederum eine zuverlässige Energieversorgung, wie wir sie im Moment ja meist noch haben, und auch alle arbeitsteiligen Prozesse unserer Hochtechnologie hängen davon ab. Denn keine Einzelperson, kein Unternehmen und kein Firmenkonglomerat ist heute noch in der Lage, ohne die Zulieferung von Fremdunternehmen mit Rohstoffen definierter Reinheit und/oder Halbfertig- und Fertigprodukten von definierter Qualität noch irgendein Hochtechnologieprodukt allein aus eigener Kraft herzustellen. Erinnern Sie Sich vielleicht noch an die Corona-Lockdowns, in denen auch die nationalen und internationalen Lieferketten auseinander gerissen worden waren und wichtige Zulieferer einfach aufgehört hatten zu produzieren? Es heißt dem Hörensagen nach, führende Regierungspolitiker seien höchst pikiert darüber gewesen, dass Letztere nach den Lockdowns nicht einfach dort weiterproduziert hatten, wo sie noch vor Corona wirtschaftlich gestanden hatten – so kann’s den nassforschen Adepten der Klimareligion bei fehlender Wirtschaftskompetenz halt schon mal gehen.

Und das Ende der fossilen Energieerzeugung im Jahre 2100 bedeutet dann natürlich auch das Ende unserer High-Tech-Industrie.

Im Jahr 2100 ist dann also auch die Hochtechnologie der Industrienationen Geschichte, während der Asteroid Bennu unseren Nachkommen schon sehr viel näher auf die Pelle gerückt ist, denn es verbleiben dann nur noch 82 Jahre bis zum möglichen großen Knall – aber das nötige Geld für Gegenmaßnahmen ist ja dann zusammen mit der erforderlichen Hochtechnologie bereits für den Klimawahn verbrannt worden. Und was machen unsere Nachfahren im Jahr 2100? – Sie leben in einer spätmittelalterlich-ökologischen Zwei-Erden-Agrarlandschaft* mit volatiler Energieerzeugung, essen ihr Brot im Schweiße Ihres Angesichts und beten zur fröhlichen Mutter Gaia.

Ist da noch irgendwas zu retten? – Wohl eher nicht, denn dazu leben inzwischen viel zu viele Menschen und Organisationen von den Brosamen klimawahnbedingter Steuern in Saus und Braus. Und jede neue menschengemachte Katastrophe, sei es aus Dummheit, Ignoranz oder Absicht, bringt weitere Scharen von Flachmänner:innen gegen den Klimawandel in Lohn und Brot. Der Klimawahn ist viel zu weit fortgeschritten, viele zu viele Menschen verdienen damit heute ihren Lebensunterhalt, und Regierungen gründen darauf Macht und Einfluss. Man stelle sich nur einmal vor, man würde wegen Bennu weltweit plötzlich hunderttausende von Kernphysikern und Raketeningenieuren benötigen, was würde dann wohl mit den MINT-fernen Klima-Mietmäulern aus den brotlosen Geschwätzkünsten geschehen?

Kann also vor dem Hintergrund höchst pekuniärer CO2-Interessen von UN, EU, Regierungen, Klimareligion sowie deren NGO-Adepten und Mietmäulern irgendjemand ernsthaft die mainstream-mediale Schlagzeile erwarten: „Am 24. September 2182 könnte der Asteroid Bennu mit der Kraft von 500.000 Atombomben auf unserer Erde einschlagen“? – Nein, das geht doch nun wirklich nicht!

*) Zwei-Erden-Agrarlandschaft: Der Bioanbau von Lebensmitteln führt zu deutlich verringerten Flächenerträgen, sodass die aktuelle Weltbevölkerung die Anbaufläche von zwei Erden für eine bioalimentierte Ernährung benötigen würde. Wenn wir jetzt einmal die weltweite Anbaufläche für Nahrungsmittel und die gegenwärtige Weltbevölkerung auf eine einzige Erde herunterrechnen, erhalten wir einen sehr nachhaltigen Einblick in die unterlegte hinterhältig-elitäre Zielsetzung…

Abbildung: Vergleich der globalen Temperaturstationen zum Ende des 19. Jahrhunderts und heute

Abbildung: Vergleich der globalen Temperaturstationen zum Ende des 19. Jahrhunderts und heute