Uli Weber

Ein 24h-Tagesdurchschnitt für ein Feuerwerk macht wenig Sinn. Und der Ablauf von zeitabhängigen Vorgängen auf einem rotierenden dreidimensionalen Planeten, der sich zudem noch mit geneigter Rotationsachse um sein Zentralgestirn bewegt, ist weder leicht zu beschreiben noch einfach zu verstehen. Dieses Problem kann aber auch nicht dadurch gelöst werden, dass man einen solchen Ablauf hinter einem eindimensionalen Durchschnittswert versteckt und damit dann mutwillig eine globale Klimakatastrophe ausruft. Denn ein Modell von irgendetwas sollte dieses Irgendwas zumindest in seinen grundlegenden Prinzipien zutreffend abbilden und dabei dem Original möglichst nahe kommen. Ein vorgebliches Modell aber, das unter Verletzung der thermodynamischen Hauptsätze eine physikalisch nicht nachweis- und technisch nicht reproduzierbare Hilfskonstruktion benötigt, ohne sich dem zu beschreibenden Original auch nur ansatzweise nähern zu können, ist von vorn herein für die Tonne. Nun, der eingefleischte EIKE-Leser wird an Titel und Autor längst erkannt haben, dass es hier wieder einmal um die hemisphärische Sichtweise auf die terrestrische Temperaturgenese geht. Und die üblichen Verdächtigen können an dieser Stelle schon mal spontan ihre Tastaturen quälen und ihren Frust in die Kommentarfunktion einhacken. Denn selbstverständlich hat es der Autor auch diesmal nicht geschafft, sein hemisphärisches Konvektionsmodell mit ein paar wenigen Sätzen und einem eindimensionalen Durchschnittswert zu erklären. Vielmehr folgt hier ein erneuter Versuch, dem interessierten Leser die prinzipielle hemisphärische Betrachtung über das Stefan-Boltzmann-Gesetz – in dem bekanntermaßen die Zeit überhaupt nicht vorkommt, und das damit auch nicht auf einen zeitabhängigen Durchschnittswert aus [sek/sek] anwendbar ist – aus einem veränderten Blickwinkel erneut nahe zu bringen.

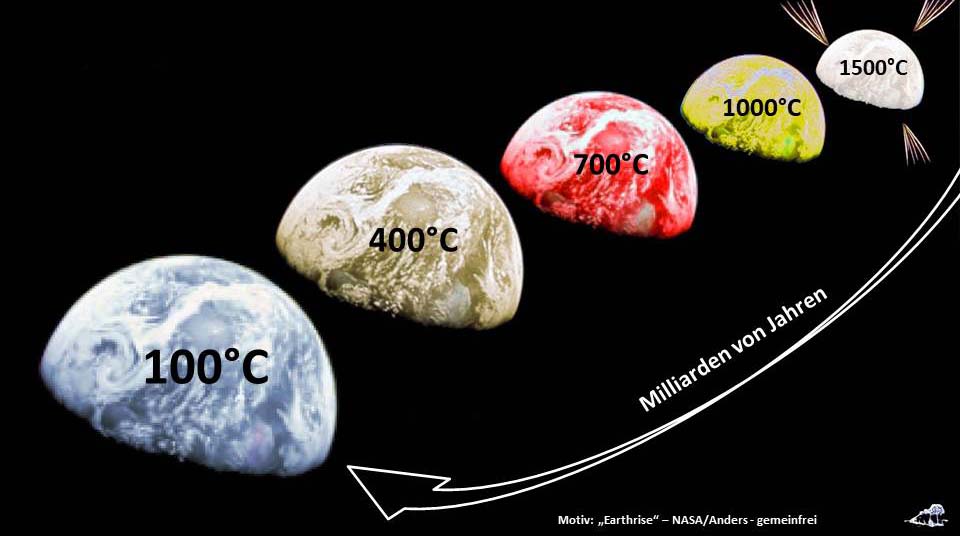

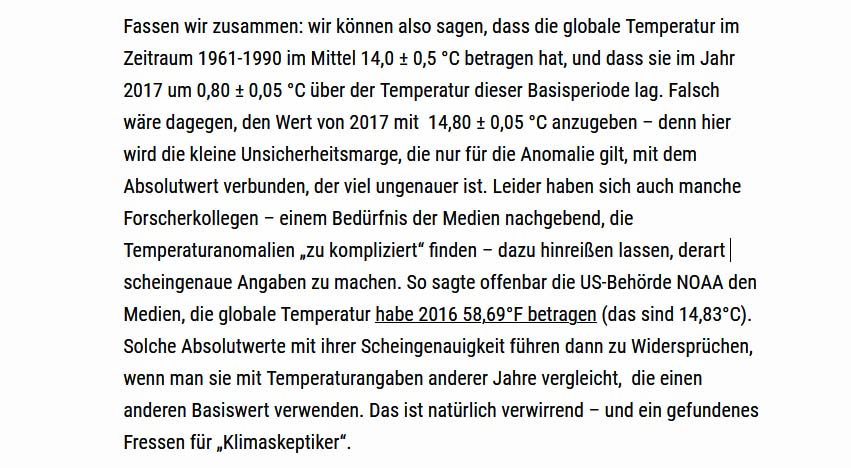

Fangen wir einmal mit den Ozeanen unserer Erde an, die gut zwei Drittel ihrer Oberfläche bedecken. Diese Ozeane sind niemals kalt gewesen, sondern sollen sich nach gängiger Theorie aus den Einschlägen von Eiskometen gebildet haben, die unsere Erde vor Milliarden von Jahren in ihrer „heißen“ Phase „aufgesammelt“ hatte. Mit Abkühlung der Erde von der Weißglut auf unter 100°C kondensierte dann auch zunehmend der Wasserdampf und bildete schließlich unsere Ozeane:

Abbildung 1: Entstehung der Weltmeere (aus dem Titelbild meines aktuellen Buches abgeleitet)

Abbildung 1: Entstehung der Weltmeere (aus dem Titelbild meines aktuellen Buches abgeleitet)

In den Ozeanen ist bis heute eine gewaltige Menge an Energie gespeichert, nach sehr vorsichtiger Schätzung ein Äquivalent von etwa 50.000 Tagen globaler Sonneneinstrahlung. Aus diesem Wärmereservoir wird der nächtliche – und winterliche – Temperaturabfall abgemildert, denn nur auf kontinentalen Landmassen unterscheiden sich Tag- und Nachttemperatur um zweistellige Celsiuswerte, während die durchschnittliche globale Temperatur der Ozeane dauerhaft um etwa 20°C liegt.

HINWEIS: Der Autor hatte sich in dem Artikel „Machen wir mal ein Gedankenexperiment: Es gibt gar keine Erde!“ einmal Gedanken über die Entwicklung einer tiefgekühlten „Laborerde“ hin zu ihrem aktuellen eingeschwungenen Ist-Zustand gemacht. Die Rolle der Ozeane für die Nachttemperatur wird in dem Artikel „Die sogenannte ‚gemessene globale Durchschnittstemperatur‘ wird von den Ozeanen bestimmt“ beschrieben. Zusätzliche Informationen sind in den Artikeln „Sprechen wir mal über die Schneeball-Erde“ – Teil 1 und Teil 2 zu finden.

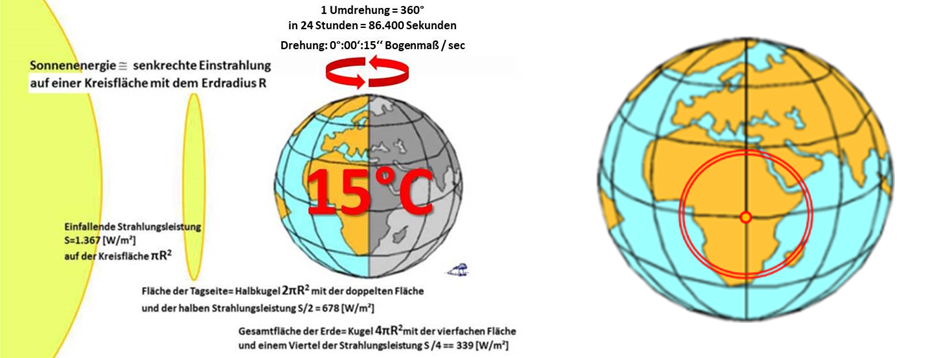

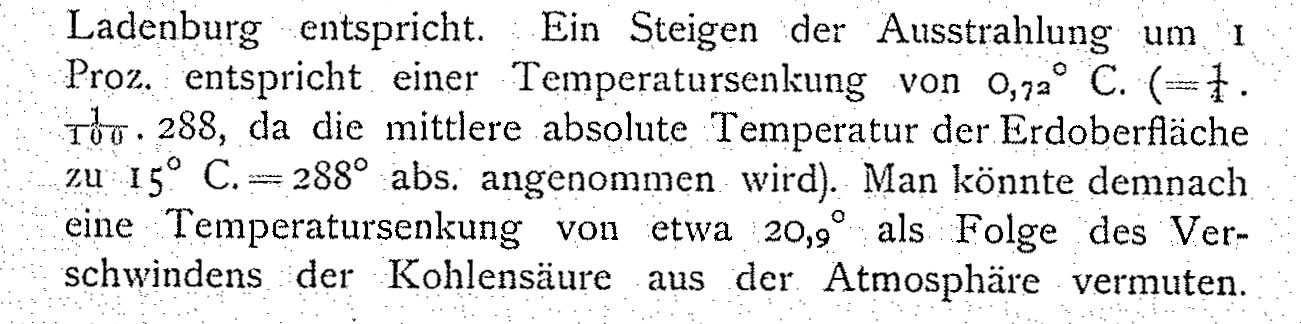

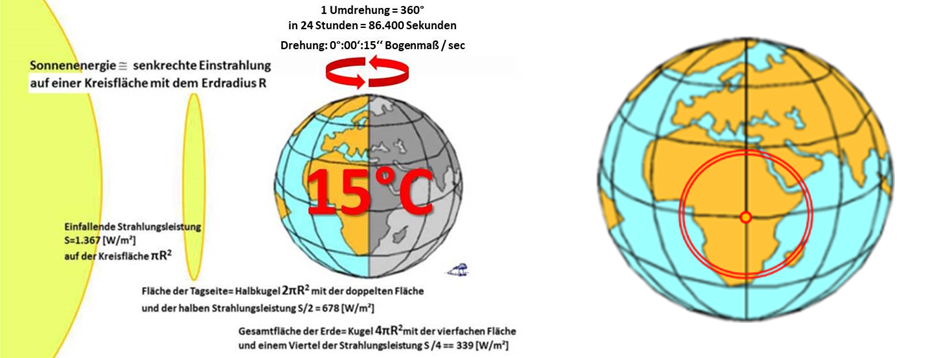

Wir haben jetzt also zunächst einmal den Warmwasserspeicher unserer Erde kennengelernt, der mit etwa 20°C deutlich wärmer ist, als es die ominöse „gemessene globale Durchschnittstemperatur“ von etwa 15°C vorgibt. Daraus lässt sich schon einmal ableiten, dass die Durchschnittstemperatur über alle Landmassen unserer Erde etwa 3°C betragen muss, um global wieder auf diese ominösen 15°C zu kommen. Der wesentliche Unterschied zwischen Landmassen und Ozeanen besteht in der unterschiedlichen Art des meridionalen Wärmetransports entlang der Längenkreise von warm nach kalt. Die Landmassen speichern relativ wenig Energie und der Abfluss von Wärme geschieht über atmosphärische Konvektion sowie Verdunstung. Die Ozeane nehmen dagegen relativ viel Energie auf und der Wärmetransport erfolgt über die globale thermohaline Zirkulation sowie ebenfalls über Verdunstung; eine atmosphärische Konvektion findet über den Ozeanen dagegen nicht statt. Generell erfolgt also auf den Landmassen ein schneller Wärmetransport, während die Ozeane durch einen langsamen Wärmetransport gekennzeichnet sind. Bis hier hin unterscheiden sich das hemisphärische Konvektionsmodell und das Faktor4-THE-Paradigma noch nicht, weil beide behaupten, die gegenwärtige Temperatur unserer Erde aus der eigenen Modellvorstellung heraus erklären zu können. Das Faktor4-THE-Paradigma kann allerdings unter Umgehung der thermodynamischen Hauptsätze lediglich einen ominösen Globaldurchschnitt darstellen, indem es dafür seinen eindimensionalen „natürlichen atmosphärischen Treibhauseffekt“ konstruiert. Das hemisphärische Konvektionsmodell kann dagegen, wie wir später noch sehen werden, aus sich heraus nicht nur ganz zwanglos eine tages- und jahreszeitliche Temperaturverteilung über alle Breitenkreise unserer Erde herleiten, sondern auch deren sogenannte „gemessene globale Durchschnittstemperatur“:  Abbildung 2: Geometrie und Rechenweg im Äquinoktium mit Sonnenstand über dem Äquator

Abbildung 2: Geometrie und Rechenweg im Äquinoktium mit Sonnenstand über dem Äquator

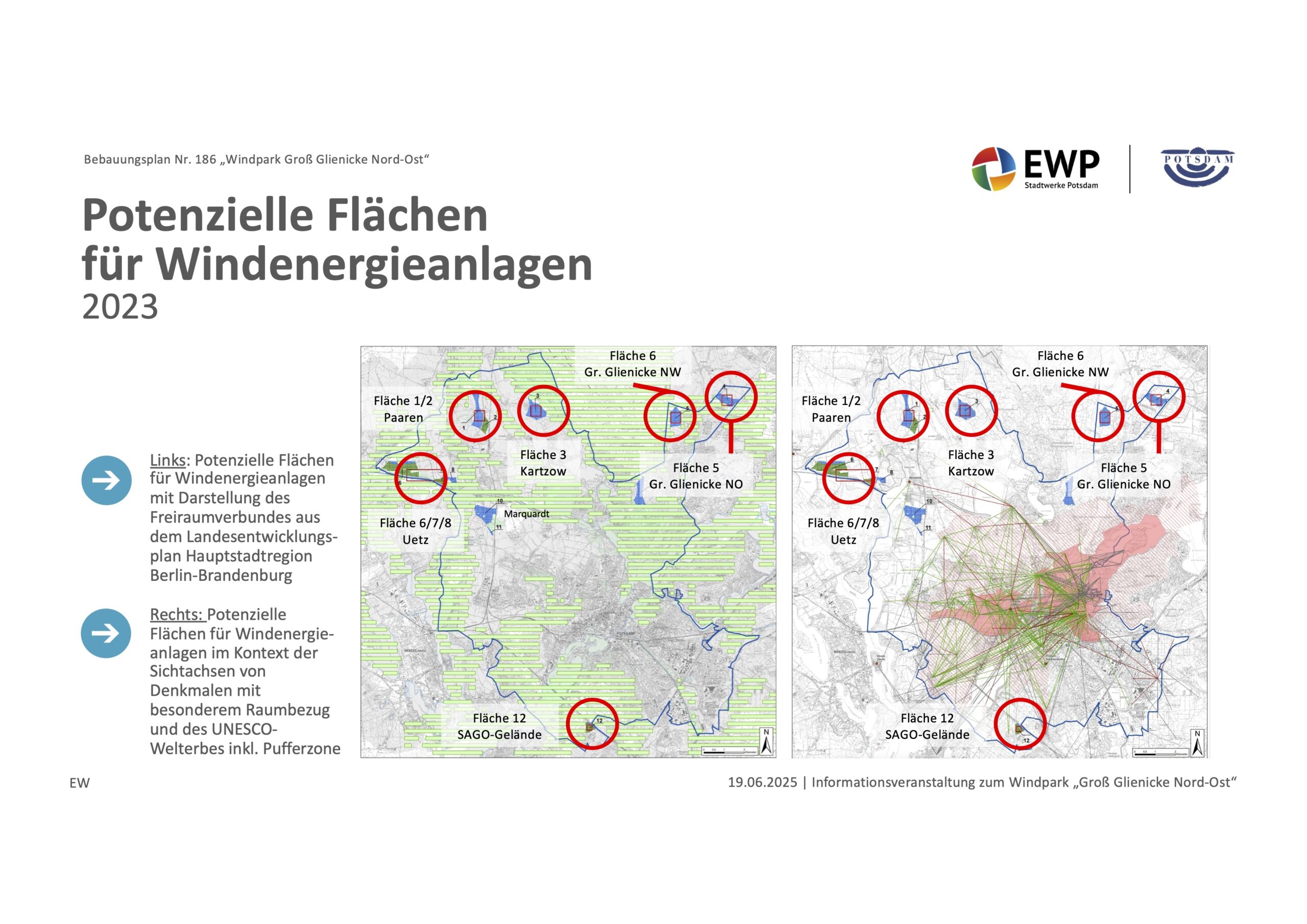

Links: Die geometrischen Verhältnisse auf der sonnenbestrahlten Erde mit der sogenannten „gemessenen globalen NST“, die beim Faktor4-Modell einen sogenannten THE erfordert

Rechts: Summation von S-B-Inversionen für konzentrische Mantelringe von 1° geografischer Breite von 0°-90° als Grundlage für einen flächennormierten Temperaturdurchschnitt von 14°C

Vielfach wird jetzt argumentiert, im hemisphärischen Konvektionsmodell würde die Erde ja gar nicht rotieren und dieses Modell benötige zwei Sonnen, weil die Nachtseite ewig dunkel bliebe. Das ist natürlich völliger Bullfish, denn im Stefan-Boltzmann-Gesetz kommt die Zeit nun einmal gar nicht vor, und das muss natürlich genauso für eine Inversion dieses Gesetzes gelten.

HINWEIS: Die S-B-Inversion wird in dem EIKE-Artikel „Handreichung zum besseren Verständnis der Stefan-Boltzmann-Inversion“ ausführlich beschrieben.

Von daher stellt die obige Grafik lediglich eine Momentaufnahme für die rotierende Erde dar, und wenn Sie so wollen, dann können Sie diese Grafik auch als Schnappschuss aus der Abfolge von 86.400 Sekunden des 24h-Tages verstehen. Denn dieses Rechenschema dreht sich mit dem Fußpunkt der Sonne bei 12h auf dem Äquator kontinuierlich über den 24h-Tag einmal 360° um die gesamte Erde.

HINWEIS: Die Details dieser hemisphärischen Berechnung sind in dem EIKE-Artikel „Anmerkungen zur hemisphärischen Mittelwertbildung mit dem Stefan-Boltzmann-Gesetz“ zu finden. Dort wird auch nachgewiesen, dass diese Berechnung implizit von Gerlich und Tscheuschner (2009) mit 15°C bestätigt wird, wenn man deren Faktor4-Widerspruchsbeweis auf die Tageshemisphäre zurückrechnet.

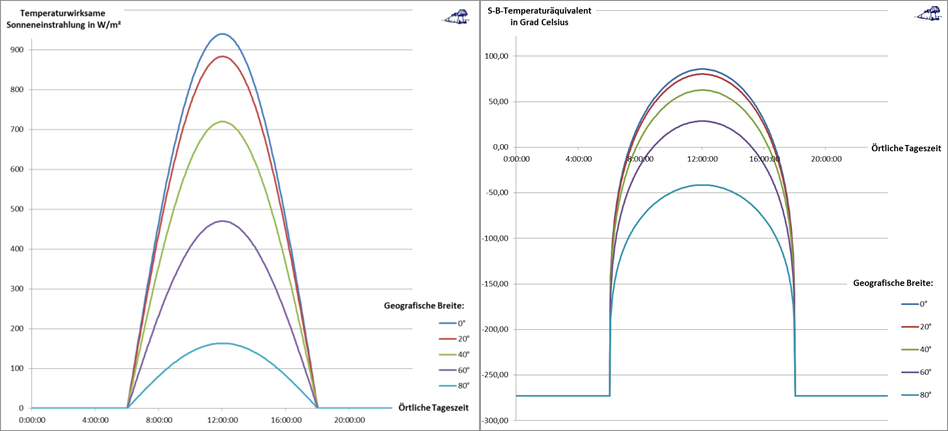

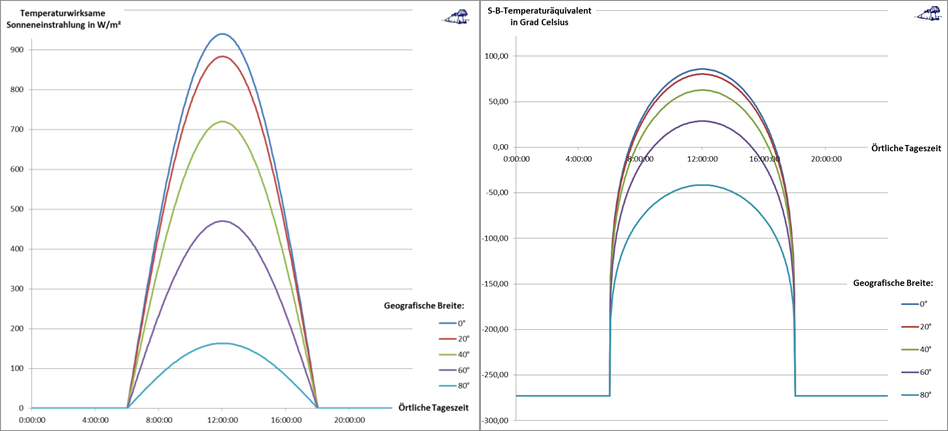

Die nachstehende Abbildung dokumentiert das 24h-Ergebnis dieser Berechnung im Äquinoktium für Ortslagen auf der rotierenden Erde. Sie können sich dieses Ergebnis als eine Abfolge von 86.400 aufeinanderfolgenden Einzelaufnahmen für die Schnittpunkte der oben abgebildeten konzentrischen Mantelringe mit den Breitenkreisen 0°-20°-40°-60°-80° vorstellen. Und zwischen diesen Einzelaufnahmen dreht sich die Erde in jeder Sekunde des 24h-Tages jeweils um 15 Bogensekunden weiter:

Abbildung 3: Die örtliche Temperaturgenese im Äquinoktium in Abhängigkeit von Tageszeit und geogr. Breite (gilt für N und S) bei einem Sonnenstand @12h für alle 86.400 Sekunden des 24h-Tages.

Die 12h-Zentrierung der Grafik läuft mit dem Sonnenstand über die gesamte 24h-Erdrotation mit.

Links: Der tageszeitliche örtliche Verlauf des temperaturwirksamen Anteils der örtlichen Sonneneinstrahlung

Rechts: Das örtliche S-B-Temperaturäquivalent aus einer S-B Inversion der tageszeitlichen temperaturwirksamen örtlichen Sonneneinstrahlung

Hinweis: Alle Berechnungen der solaren Einstrahlung und die S-B-Inversion für das S-B Temperaturäquivalent wurden, passend zur jeweiligen Aufgabenstellung, mit der Solarkonstanten, der Albedo, der S-B-Konstanten, dem Sinus für den Azimut und dem Cosinus für den Zenitwinkel durchgeführt.

Wie G&T (2009) bereits nachgewiesen hatten, kann das Faktor4-THE-Paradigma die Temperaturgenese auf unserer Erde aus sich heraus gar nicht erklären. Vielmehr müsste der sogenannte „natürliche atmosphärische Treibhauseffekt“ von vorgeblich eindimensionalen 33 Kelvin nach der Integrallösung von G&T sogar 144 K betragen. Hier also trennen sich die Wege des hemisphärischen Konvektionsmodells und des Faktor4-THE-Paradigmas endgültig – allein das hemisphärische Konvektionsmodell hat vor der Realität der terrestrischen Temperaturgenese Bestand.

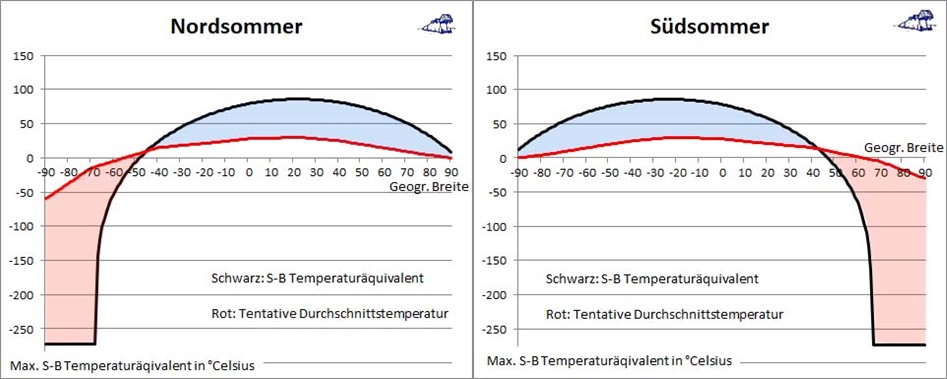

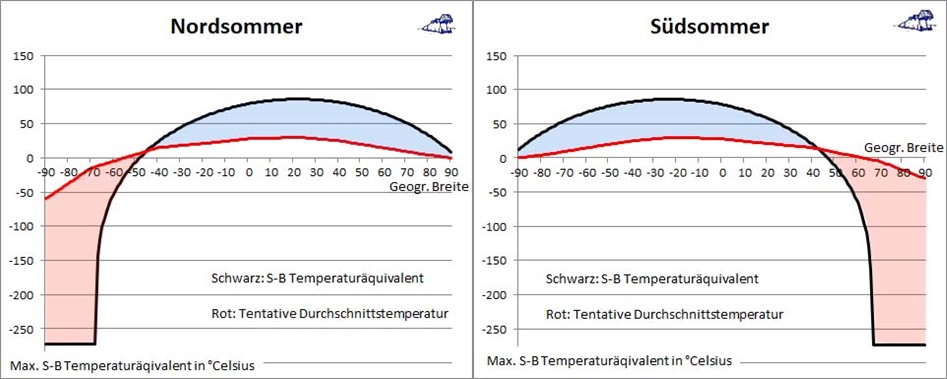

Die nachfolgende Abbildung zeigt den Unterschied zwischen Nordsommer und Südsommer und wurde aus dem hemisphärischen Konvektionsmodell hergeleitet:  Abbildung 4: Breitenabhängiger Verlauf des maximalen S-B Temperaturäquivalents (schwarze Kurve) und einer tentativen Durchschnittstemperatur zum Zeitpunkt der jeweiligen Sonnenwenden (rote Linie) mit farblich unterlegten Differenzen

Abbildung 4: Breitenabhängiger Verlauf des maximalen S-B Temperaturäquivalents (schwarze Kurve) und einer tentativen Durchschnittstemperatur zum Zeitpunkt der jeweiligen Sonnenwenden (rote Linie) mit farblich unterlegten Differenzen

Links: Sommersonnenwende = Nordsommer Rechts: Wintersonnenwende = Südsommer

Blau: Konvektiv und durch Verdunstung in die globalen Strömungssysteme abgeführte Wärme

Rot: Advektiv und durch Kondensation aus den globalen Strömungssystemen zugeführte Wärme

Wie wir weiter oben bereits gesehen haben, bestimmt der Wärmeinhalt der Ozeane die Nachttemperatur unserer Erde. Das gilt aber nicht nur für die Nacht des 24h-Tages, sondern auch für die Polarnacht. Das Nordpolarmeer und das Südpolarmeer sind mit marinem Oberflächeneis und kontinentalem Gletschereis bedeckt, während der Permafrost auf den das Nordpolarmeer umgebenden Landflächen bis in Tiefen von über 1.000 Meter reicht. Zumindest das Nordpolarmeer hätte also ohne einen permanenten Zufluss von Wärme aus mittleren und niederen geografischen Breiten eine gute Chance, in der Abfolge der Nordwinter bis auf den Meeresgrund durchzufrieren. Die nachstehende Abbildung verdeutlicht nochmals die große Variabilität der Sonneneinstrahlung im Verlauf des Jahres über alle geografischen Breiten:  Abbildung 5: Der Jahresverlauf des maximalen S-B Temperaturäquivalents für die geografischen Breitenkreise von 80° Nord bis 80° Süd aus einer Inversion der maximalen Albedo bereinigten örtlichen Sonneneinstrahlung

Abbildung 5: Der Jahresverlauf des maximalen S-B Temperaturäquivalents für die geografischen Breitenkreise von 80° Nord bis 80° Süd aus einer Inversion der maximalen Albedo bereinigten örtlichen Sonneneinstrahlung

Die eindimensionalen Temperaturvorgaben des THE-Paradigmas sind als rote Linien eingezeichnet

Diese Abbildung verdeutlicht für den Jahresverlauf die Konstanz der Sonneneinstrahlung in den Tropen als Klimamotor unserer Erde. Daran anschließend steigen die jahreszeitlichen Einstrahlungsunterschiede mit wachsender geografischer Breite immer weiter an und gipfeln in hohen Breiten schließlich in Polartag und Polarnacht. Die zum Vergleich als rote Linien eingezeichneten eindimensionalen Temperaturangaben des Faktor4-THE-Paradigmas vermitteln dagegen keinerlei jahreszeitliche oder geografische Orientierung – und schon gar keinen Erkenntnisgewinn – sondern sind in ihrem erbarmungswürdig miserablen Modellbezug zur Klimagenese auf unserer Erde wirklich nicht mehr zu toppen. Denn trotz intensiver Suche ist keinerlei grafisches Material zur räumlichen und zeitlichen Verbreitung des sogenannten „natürlichen atmosphärischen Treibhauseffektes“ im Internet aufzufinden, nicht einmal für die Polarnacht ohne Sonneneinstrahlung. Das Faktor4-THE-Paradigma vermittelt also keinerlei Bezug zur Realität in Zeit und Raum, sondern ignoriert mit seinem klimareligiösen Glaubensbekenntnis, ‘minus 18°C „Normaltemperatur“ plus 33 Kelvin THE ergäbe die gemessene globale Durchschnittstemperatur von 15°C‘, die Realität auf unserer Erde völlig:

- Das eindimensionale Faktor4-THE-Paradigma ignoriert den stetigen Wechsel von Tag und Nacht auf unserer Erde.

- Das eindimensionale Faktor4-THE-Paradigma ignoriert die Breitenabhängigkeit der solaren Einstrahlung [altgriechisch „κλίμα“ (=Klima)] auf unserer Erde.

- Das eindimensionale Faktor4-THE-Paradigma ignoriert den permanenten Wechsel der Jahreszeiten auf dem Weg unserer Erde um ihr Zentralgestirn.

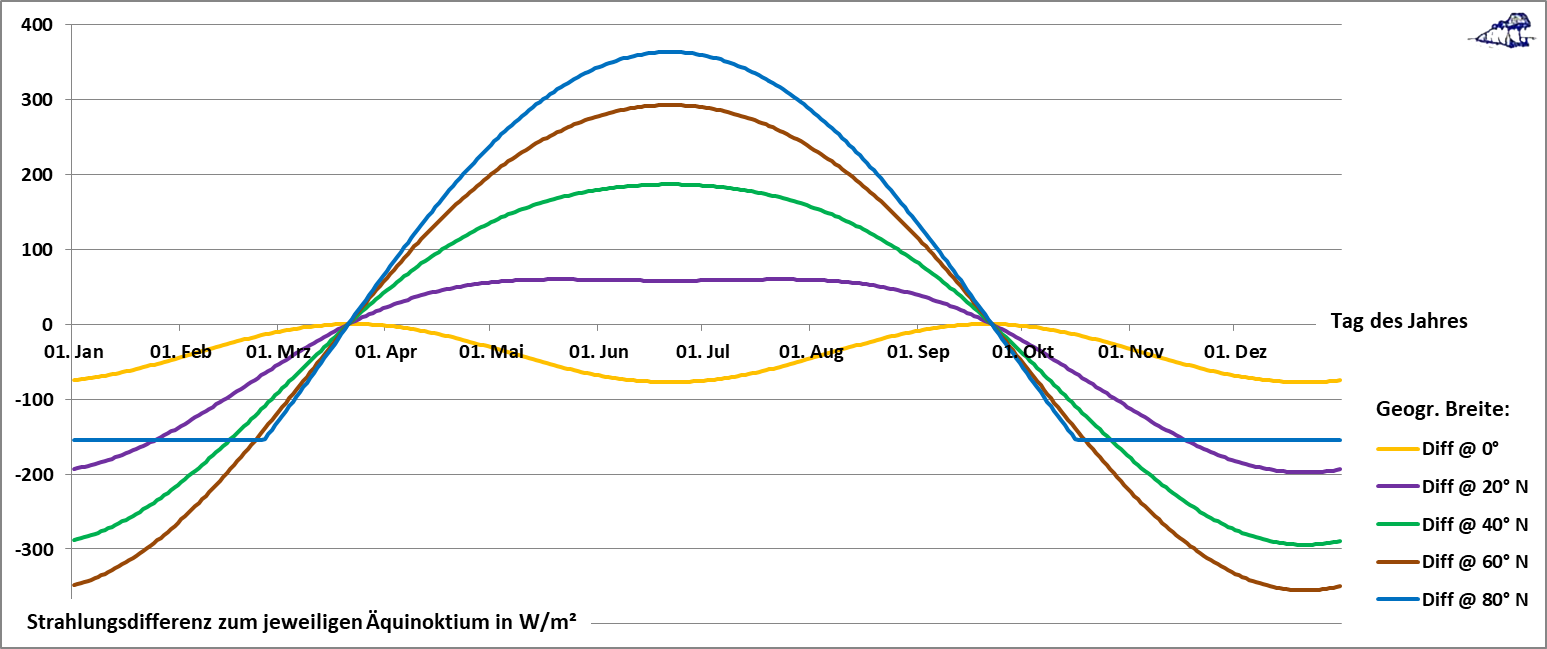

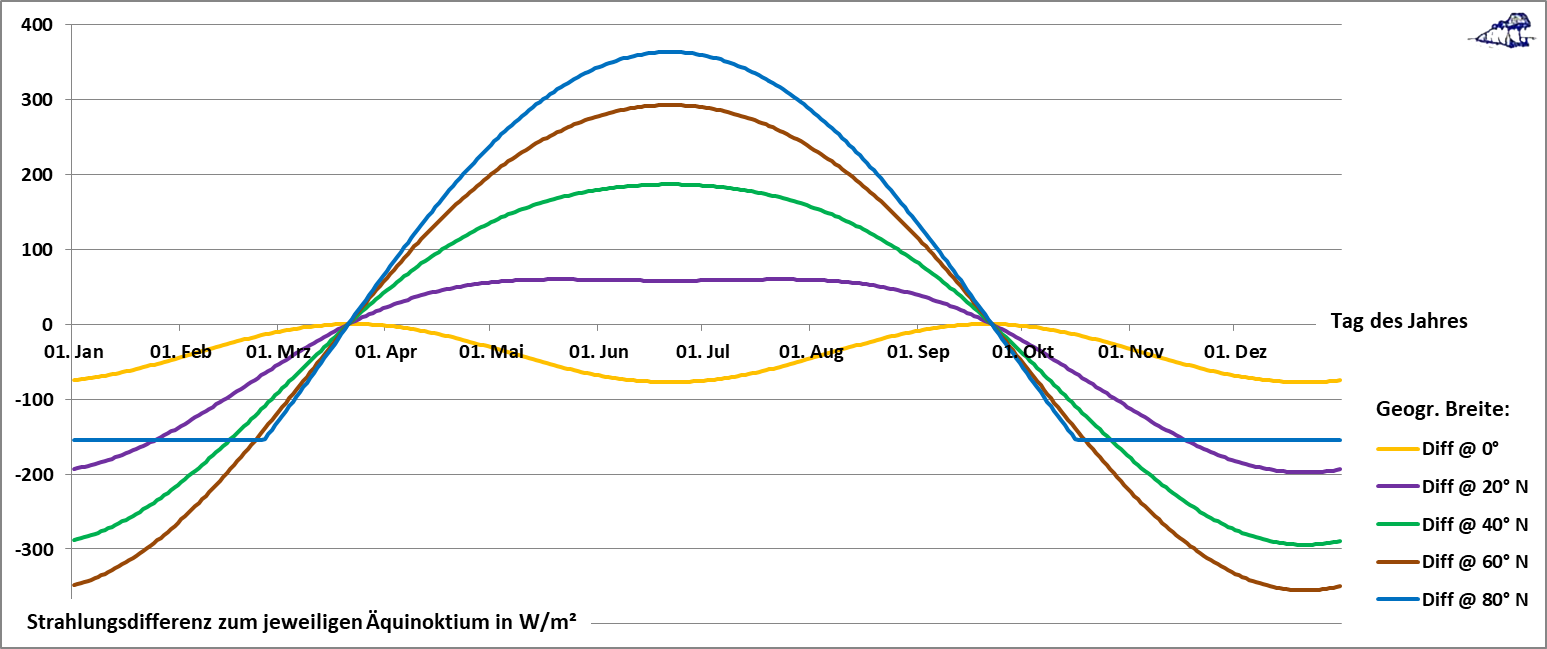

Und während dieses eindimensionale Faktor4-THE-Paradigma interessierten Kreisen dabei hilft, Angst und Schrecken zu verbreiten, um uns in ein dekarbonisiertes neues Mittelalter zu zwingen, lassen sich mit dem hemisphärischen Konvektionsmodell die tatsächlichen Abläufe der terrestrischen Temperaturgenese sogar noch tiefergreifender analysieren, wie die nachfolgende Abbildung beweist:  Abbildung 6: Jahresverlauf der Differenz zwischen täglicher maximaler temperaturwirksamer solarer Einstrahlung in W/m² und dem zugehörigen Strahlungswert im Äquinoktium auf der Nordhalbkugel

Abbildung 6: Jahresverlauf der Differenz zwischen täglicher maximaler temperaturwirksamer solarer Einstrahlung in W/m² und dem zugehörigen Strahlungswert im Äquinoktium auf der Nordhalbkugel

Das Kurvenbündel [Diff @ 0°-80°N] macht deutlich, dass die größte Veränderung der solaren Einstrahlung um die Äquinoktien des Frühlings- und des Herbstpunktes erfolgt. In diesem Zeitabschnitt ist die Veränderung der örtlichen solaren Strahlungsleistung etwa doppelt so groß wie um die Sommer- und Wintersonnenwende. Und deshalb ist das Wettergeschehen um die Äquinoktien herum auch so intensiv, man denke nur einmal an die Frühjahrs- und Herbststürme.

Die Abbildungen 3 bis 6 zeigen Tages- bzw. Jahresverläufe der solaren Einstrahlung sowie deren Breitenabhängigkeit, der Einfachheit halber oft im Äquinoktium. Denn der Arbeitsaufwand für die Einbeziehung der Achsneigung unserer Erde in solche Berechnungen verhält sich umgekehrt proportional zu Verständnisstiftung der resultierenden Grafiken. Die Grundlagen für das hemisphärische Konvektionsmodell bestehen aus der Solarkonstanten, der Albedo, dem Stefan-Boltzmann-Gesetz sowie den trigonometrischen Winkelfunktionen für die geometrischen Abläufe bei der solaren Bestrahlung unserer Erde – und das isses auch schon! Das Faktor4-THE-Paradigma steht dagegen mit drei jeweils eindimensionalen Zahlenwerten sehr viel schlechter da:

Abbildung 7: Die Grundlagen des CO2-Klimaglaubens bestehen aus 3 eindimensionalen Zahlenwerten

Abbildung 7: Die Grundlagen des CO2-Klimaglaubens bestehen aus 3 eindimensionalen Zahlenwerten

Wir können den CO2-Glaubenssatz aus Abbildung 7 [-18°C + 33K = 15°C] auch umkehren, um den Glaubenseffekt im Faktor4-THE-Paradigma noch deutlicher herauszuarbeiten:

Trotz der offensichtlichen Abhängigkeit der temperaturbestimmenden solaren Einstrahlung auf unserer Erde von Tages- und Jahreszeit sowie der örtlichen geografischen Breite liefert das Faktor4-THE-Paradigma lediglich 3 eindimensionale Zahlenwerte. Diese eindimensionalen Zahlenwerte behalten dann ihre universal-globale Gültigkeit bis hinein in die Polarnacht.

Folgerichtig sind trotz intensiver Suche im Internet nirgendwo irgendwelche Grafiken über die räumliche und zeitliche Verteilung des sogenannten „natürlichen atmosphärischen Treibhauseffektes“ aufzufinden. So, und nun wenden wir uns abschließend noch einmal dem hemisphärischen Konvektionsmodell zu. Die nachfolgende Abbildung stellt 4 charakteristische Zeitpunkte des 24h-Tages im Äquinoktium dar, nämlich Sonnenaufgang, Mittag, Sonnenuntergang und Mitternacht:

Abbildung 8: Die Beleuchtung der Erde über die 86.400 Sekunden des 24-h-Tages im Äquinoktium

Anmerkung: Diese ungewöhnliche grafische Darstellung für die Eigenrotation der Erde wurde gewählt, um insbesondere das Berechnungsschema auf 12 Uhr aus Abb. 2R in seinem Verhältnis zur Sonne verständlich abzubilden. Dabei entspricht dieser 24h=360°-Umlauf einer starr stehenden Erde im Uhrzeigersinn um die Sonne, allein auf die Beleuchtung der Erde bezogen und von oben (N) gesehen, genau der 24h=360°-Eigenrotation unserer Erde gegen den Uhrzeiger in Abb.2L.

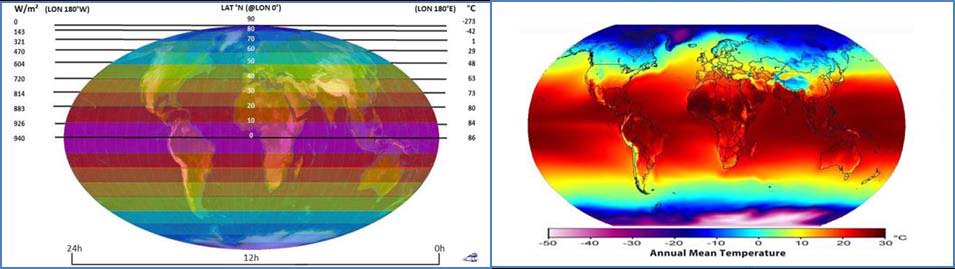

Auf 12 Uhr finden wir das bekannte Berechnungsschema aus Abbildung 2R. Dort ist die solare Einstrahlung umgekehrt proportional zum Radius der Mantelringe für die Tempertaturberechnung, Das heißt, am Fußpunkt der Sonne auf dem Äquator ist die Einstrahlung mit der kleinsten Mantelringfläche am größten und reduziert sich dann sukzessive zum randlichen Übergang zur Nachtseite mit der größten Mantelringfläche gegen Null. Aus Abbildung 8 wird also unmittelbar deutlich, dass dieses Berechnungsschema für die augenblickliche Sonneneinstrahlung im Äquinoktium, das für sich allein bereits ein flächennormiertes S-B-Temperaturäquivalent von 14°C liefert, tatsächlich nur einen Augenblickswert aus den 86.400 Sekunden des 24h-Tagesablaufs darstellt, während der tatsächliche Verlauf über 24h ganz anders aussieht:  Abbildung 9: Vergleich des maximalen S-B-Temperaturäquivalents mit gemessenen Temperaturen

Abbildung 9: Vergleich des maximalen S-B-Temperaturäquivalents mit gemessenen Temperaturen

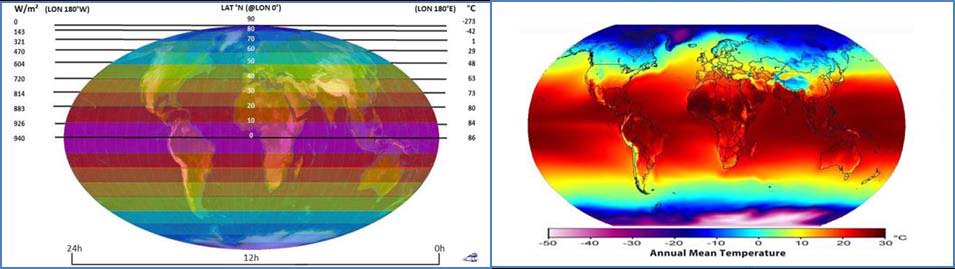

Links: Die solare Einstrahlung über einen ganzen 24-Stunden-Tag im Äquinoktium (2020) mit farblich unterlegter Mollweide-Projektion (Copyright L. Rohwedder – Lizenz CC BY-SA 3.0)

Linke Skala: Maximale breitenabhängige temperaturwirksame solare Strahlungsleistung

Rechte Skala: Maximales breitenabhängiges S-B-Temperazuräquivalent

Rechts: Annual Mean Temperature – Quelle: Wikipedia – Autor: Robert A. Rohde – Lizenz GFDL

Kombination von 10′ CRU CL 2.0 archive copy mit den 1° NOAA OISST version 2 archive copy und den 2.5° NCEP/NCAR Reanalysis version 1 archive copy sowie kleineren Verbesserungen für 1961-1990

Die beiden Grafiken in Abbildung 9 stimmen in der flächenmäßigen Farbverteilung recht ordentlich überein, auch wenn das maximale S-B-Temperaturäquivalent (links) deutlich höher ist als die durchschnittlich gemessene Ortstemperatur (rechts). Über den 24h-Tagesverlauf kehrt sich das in Abbildung 2 (rechts) beschriebene Flächenverhältnis für das konzentrische Berechnungsschema um. Denn die maximale solare Einstrahlung fällt entlang der Längenkreise zu höheren geografischen Breiten ab, während sie mit dem Fußpunkt des solaren Zenits über den 24h-Tagesverlauf wandert.

Das Faktor4-THE-Paradigma arbeitet entgegen den beiden Grafiken in Abb. 9 mit einer global universellen Anwendung von drei eindimensionalen Zahlenwerten über alle Zeiten und Räume bis hin in die finstere Polarnacht, bei dem alle Unterschiede durch den Mixer gehen. Da nun aber die Missionare des Klimawahns mit solchen Durchschnittswerten hausieren zu gehen pflegen und sich diese Durchschnittswerte tief in das Verständnis ihrer Opfer eingegraben haben, macht eine generelle Diskussion über die Sinnfälligkeit solcher Durchschnittswerte wenig Sinn – denn da muss man schon dagegenhalten. Denn auch Durchschnittswerte haben durchaus ihre Berechtigung, sind aber eine Einbahnstraße für die tiefere Erkenntnis, weil von dort aus nun einmal kein Weg zu irgendeiner Originalverteilung zurückführt. Denn mit dem Weg von Ortslage zu Region, über Staat und Kontinent hinweg bis zur gesamten Erde verlieren sich zunehmend die direkten Bezüge und die physikalischen Gesetzmäßigkeiten.

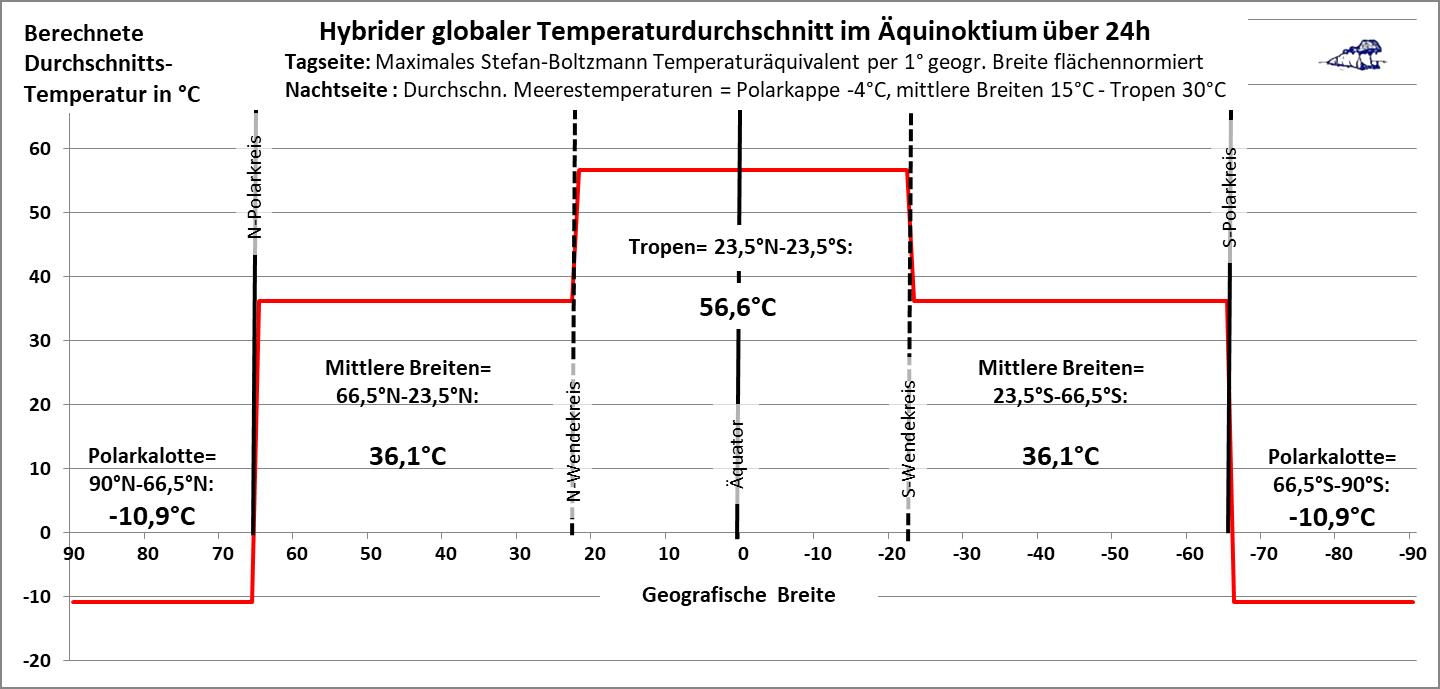

Auch auf die Gefahr hin, erneut eine unsägliche Durchschnittsdiskussion loszutreten, werde ich nachfolgend ein Beispiel dafür zeigen, was allein mit dem hemisphärischen Konvektionsmodell durch eine Durchschnittsbildung über die Solarkonstante, die Albedo, das Stefan-Boltzmann-Gesetz sowie die trigonometrischen Winkelfunktionen möglich ist:

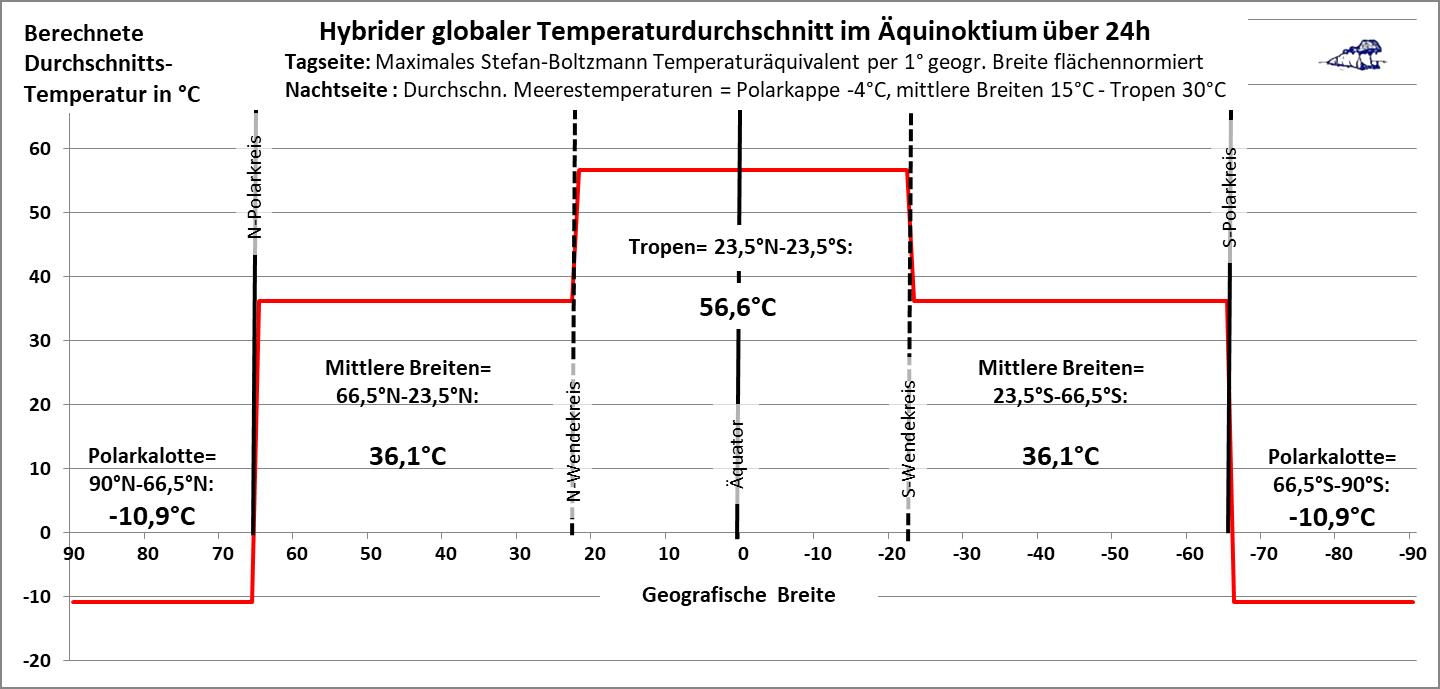

Abbildung 10: Flächennormiertes hybrides S-B-Temperaturmodell im Äquinoktium

Abbildung 10: Flächennormiertes hybrides S-B-Temperaturmodell im Äquinoktium

Temperatur Tagseite: Durchschnittstemperatur aus breitenparallelen und flächennormierten Mantelring-Hälften mit dem maximalen S-B-Temperaturäquivalent analog zu Abb. 9 (links)

Temperatur Nachtseite: Flächennormierte mittlere Meerestemperaturen, tentativ aufgeteilt auf Polarkalotten (=-4°C), mittlere Breiten (=15°C) und Tropen (=30°C) mit der Begründung, dass etwa 70% der Erdoberfläche von Meeren bedeckt sind

Dieser flächennormierte hybride globale Ansatz ist ein erster Versuch, eine hemisphärische Globaltemperatur inklusive der Nachtseite zu formulierten. Das rein rechnerische Ergebnis von 39,9°C sollte man daher nicht allzu ernst nehmen, zumal bei der örtlichen solaren Temperaturgenese ständig Wärme in die globalen Zirkulationssysteme abfließt. Allerdings beträgt das zugehörige S-B-Leistungsäquivalent für diese 39,9°C etwa 544 W/m². Bezüglich der „gemessenen globalen Durchschnittstemperatur“ von 15°C mit 390 W/m² stehen also etwa 154 W/m² echte physikalische Leistung (x Zeit) für den Wärmeabfluss in die globalen Strömungssysteme zur Verfügung. Dies ist ein recht befriedigendes Ergebnis für eine erste grobe Annäherung meines hemisphärischen Konvektionsmodells an die globale Verteilung der Temperatur.

Ein Vergleich mit Abbildung 9 rechts zeigt, dass die klare Trennung zwischen Tropen und mittleren Breiten im hybriden Modell nicht der Realität entspricht. Vielmehr reichen in der Realität hohe Durchschnittstemperaturen nach Norden und Süden über den 45. Breitenkreis hinaus und gehen dann erst später auf negative Werte zurück. Beide Darstellungen vermittelt jedenfalls sehr eindrücklich, dass die Tropen mit der stärksten solaren Einstrahlung als Klimamotor unserer Erde fungieren, während sich die Polkalotten als Wärmesenken erweisen. Damit ist dann auch die Richtung des globalen Energietransports aus den Tropen zu den Polkalotten physikalisch zwingend vorgegeben. Dort wird nämlich umgekehrt das S-B-Temperaturäquivalent meist gar nicht erreicht, sodass die Ortstemperatur durch Advektion von Wärme aus mittleren Breiten und den Tropen gestützt werden muss. Im Abgleich mit dem THE-Schamdreieck aus Abbildung 7 ist dies eine weiterer Beweis dafür, dass unsere Erde zur Aufrechterhaltung der sogenannten „gemessenen globalen Durchschnittstemperatur“ von etwa 15°C keinerlei Unterstützung von irgendwelchen Ignoranten der thermodynamischen Hauptsätze benötigt.

ERKENNTNIS: Das eindimensionale Faktor4-THE-Paradigma wurde der Temperaturgenese auf unserer Erde willkürlich übergestülpt und verschleiert deren natürliche Mechanismen zugunsten der CO2-Klimareligion. Wer also tatsächlich glaubt, dieses antiphysikalische Paradigma sei ein zutreffendes Klimamodell für unsere Erde, der muss auch zwangsläufig an die vom Klimavatikan IPCC geweissagte menschengemachte Klimakatastrophe glauben – denn beide sind nun einmal rein klimareligiöse Glaubensbekenntnisse und haben mit seriöser Physik überhaupt nichts zu tun.

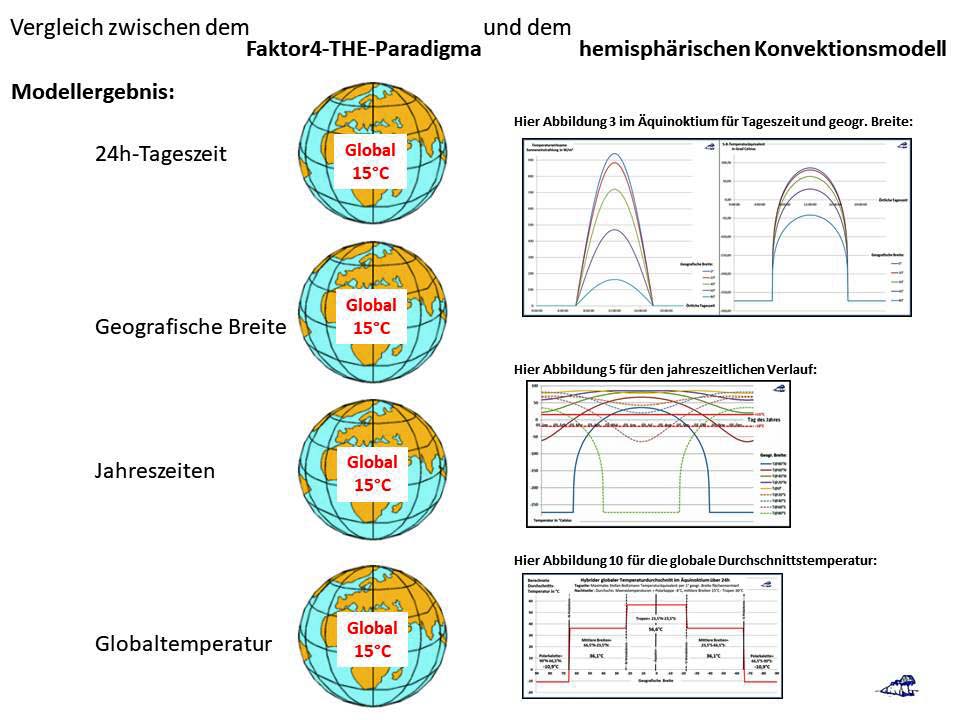

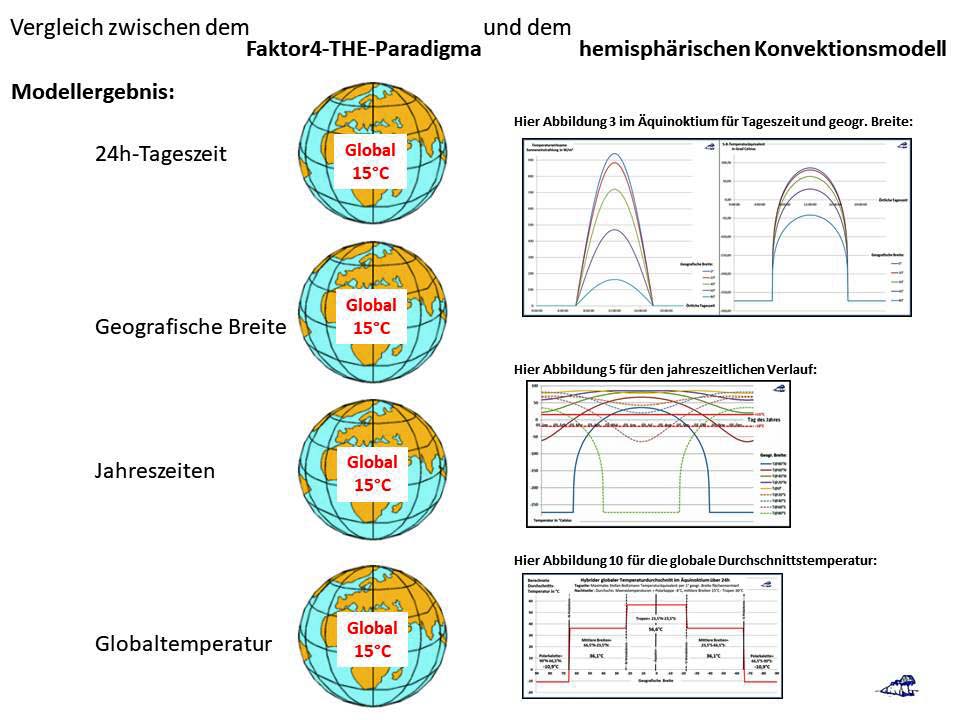

Es ist nicht möglich, eingefleischte Anhänger des CO2-Aberglaubens von der antiphysikalischen Natur dieses sogenannten THE zu überzeugen. Der interessierte Leser hingegen, der sich von der Klimakirche keine „designte Wirklichkeit“ verkaufen lässt, mag in der nachfolgenden selbst erklärenden Gegenüberstellung der beiden konkurrierenden Modelle vielleicht einige neue Erkenntnisse finden:  Abbildung 11: Vergleich von Faktor4-THE-Paradigma und hemisphärischem Konvektionsmodell

Abbildung 11: Vergleich von Faktor4-THE-Paradigma und hemisphärischem Konvektionsmodell

Das Faktor4-THE-Paradigma beruht auf einer Falschanwendung des physikalischen Stefan-Boltzmann-Gesetzes [Temperatur=>Strahlungsleistung] als mathematische Formel. Die Verwendung eines 24h-Leistungsdurchschnitts (Faktor4= ein Viertel der Solarkonstanten) bei der Inversion des S-B-T^4-Augenblicksgesetzes [Strahlungsleistung=>Temperatur] verlässt unwiderruflich die Grenzen der Physik und ist reine – und physikalisch falsche – Mathematik. Die Details dieser physikalisch falschen Berechnung werden in dem EIKE-Artikel „Schwarzschild und die Lösung der Strahlungstransfergleichung – ein physikalischer Hütchentrick?“ dargestellt. Der physikalisch falsche Faktor4 für die Solarkonstante geht nämlich als Randbedingung in die Lösung der Strahlungstransfergleichung ein und führt damit zwangsläufig zu dem ominösen THE als Konstante zur Angleichung der physikalisch falsch berechneten „natürlichen“ Temperatur unserer Erde an die sogenannte gemessene globale Durchschnittstemperatur.

ANHANG: Anmerkungen zur sogenannten Globaltemperatur

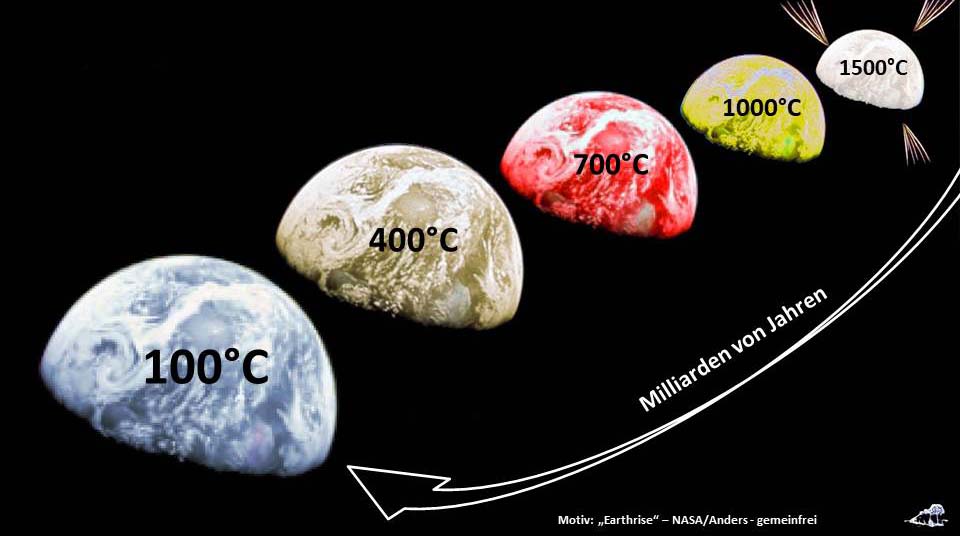

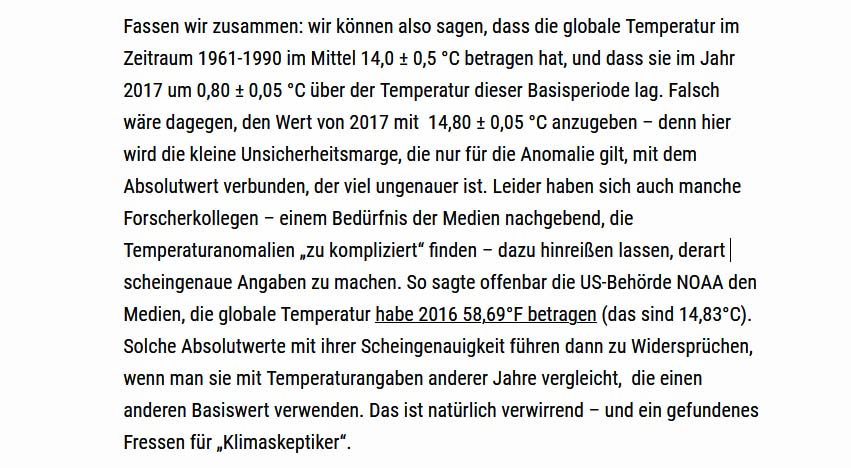

Da die sogenannte „gemessene globale Durchschnittstemperatur“ (NST) von etwa 15°C die Prophezeiungen aus den Computermodellen des Klimavatikans IPCC nicht zu erfüllen beliebt, zeitnah bis hin zur Selbstverbrennung unserer Erde anzusteigen, musste man sich in den aktivistisch-alimentierten Klimawissenschaften zunächst mit einer unqualifizierten Absenkung der historischen Temperaturdaten behelfen, um die Differenz zu heute gemessenen Temperaturen entsprechend zu vergrößern. Dagegen erfordert eine wissenschaftlich korrekte Angleichung zwischen zwei unterschiedlichen Instrumentierungen einen jahre- oder gar jahrzehntelangen Parallelbetrieb beider Systeme am selben Ort, um daraus dann eine seriöse Transferfunktion ableiten zu können. Das war bei den historischen Temperaturmessungen natürlich unmöglich, hätte aber der Umstellung von Analogmessungen auf Digitalinstrumente Ende des vergangenen Jahrhunderts sehr wohl angestanden – ist aber auch da nicht erfolgt und war gleichzeitig sogar mit sporadischen Wechseln der Ortslage verbunden. Am Ende resultiert eine solche willkürliche Absenkung von echten Messwerten natürlich auch zwangsläufig in der Reduzierung des zugehörigen Durchschnittswertes, der vom DWD für den „Referenzzeitraum (1951- 1980)“ inzwischen mit 14°C angegeben wird. Stefan Rahmstorf hatte diese Sichtweise am 12. Februar 2018 auf SciLogs zu begründen versucht:

Abbildung 12: Textausschnitt Rahmstorf auf SciLogs (2018) zum 14°C#15°C-Problem

Abbildung 12: Textausschnitt Rahmstorf auf SciLogs (2018) zum 14°C#15°C-Problem

Halten wir daraus fest: NOAA hatte die Globaltemperatur noch für 2016 mit 14,83°C angegeben.

Und selbst die Deutsche Akademie der Wissenschaften (Leopoldina), zu deren ehemaligen Mitgliedern auch Milutin Milanković zählt, der Entdecker der erdbahnbedingten Eiszeitzyklen, hat sich dieser Globaltemperatur von 14°C angeschlossen. Der Autor erinnert sich aber, dass bei Drucklegung seines ersten Klimabuchs „Klimahysterie“ (2012-Farbe/SW) die NST noch generell mit 14,8°C angegeben worden war. Auch für die erste Hälfte des 20. Jahrhunderts, also 50 bis 100 Jahre nach dem Ende der kleinen Eiszeit, das gemeinhin mit dem Jahr 1850 angegeben wird, sind deutlich höhere Werte als 14°C für die Globaltemperatur überliefert:

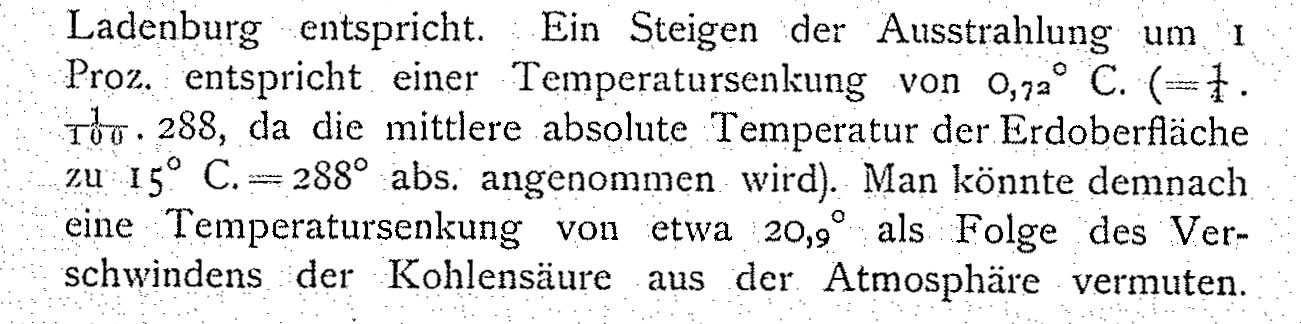

Bei Svante Arrhenius wird in der Veröffentlichung „Die vermutliche Ursache der Klimaschwankungen“ (1906) die gemessene Globaltemperatur mit 15°C benannt:

Abbildung 13: Die Globaltemperatur bei Arrhenius „Die vermutliche Ursache der Klimaschwankungen“ (1906) auf Seite 3

Und auch Milutin Milanković gibt in seinem Werk „Kanon der Erdbestrahlung und seine Anwendung auf das Eiszeitproblem“ (1941) die globale Durchschnittstemperatur mit 15°C an:

Abbildung 14: Die Globaltemperatur bei Milanković „Kanon der Erdbestrahlung“ (1941)

Wir stehen also vor dem Paradoxon, dass die sogenannte „gemessene globale Durchschnittstemperatur“ von anerkannten Wissenschaftlern noch bis ein Jahrhundert nach der Kleinen Eiszeit mit etwa 15°C angegeben worden war. Erst in neuester Zeit taucht mit den ominösen 14°C eine niedrigere Temperatur für die historische Globaltemperatur in der wissenschaftlich-medialen Darstellung auf und stellt sich damit in Widerspruch zu den wissenschaftlichen Erkenntnissen des 20-sten Jahrhunderts und bis in das 21-ste Jahrhundert hinein. Als einzige Erklärung für diesen Widerspruch bleibt die Vermutung, dass die pekuniär abhängigen Klimawissenschaften damit ihren dringend erforderlichen 1°C-Beitrag zur globalpolitisch gewollten Großen Transformation ins wirtschaftliche Mittelalter geliefert haben. Denn anders würde die UN-Globalpolitik wohl kaum zu den erforderlichen Pariser 1,5°C (2015) kommen, um im Klimawahn endlich so richtig loslegen zu können…

Bleiben wir also mit einer gemessenen durchschnittlichen Globaltemperatur von etwa 15°C bei den schriftlich niedergelegten Temperaturwerten von Arrhenius und Milanković sowie der Erinnerung des Autors und dem Rahmstorf’schen Sekundärzitat auf die NOAA. Und auch die hemisphärische Herleitung der Durchschnittstemperatur für die Tagseite unserer Erde hatte diese Temperatur (für die selbstverständlich rotierende Erde!) zu 15°C ermittelt und wird durch die Berechnungen von Milanković (Abb. 14) bestätigt; mein Rechenschema ist in Abbildung 2 (rechts) dargestellt. Diese Globaltemperatur unserer Erde ist bis heute also über mehr als ein Jahrhundert unverändert geblieben. Sie stellt damit den ultimativen wissenschaftlichen Beweis dar, dass die Energiebilanz unserer Erde im zeitlichen Durchschnitt der WMO-Klimadefinition über diesen gesamten Zeitraum von mehr als einem Jahrhundert unverändert geblieben ist. Diese gleichbleibende Globaltemperatur widerlegt den religiösen Klimaalarmismus; denn wäre es in diesem Zeitraum auf unserer Erde wärmer oder kälter geworden, hätte die Globaltemperatur steigen oder sinken müssen. Und durch CO2 erfolgt klimaphysikalisch überhaupt nix – nämlich kein antiphysikalischer zusätzlicher Energieeintrag in unsere Atmosphäre entgegen den Hauptsätzen der Thermodynamik.

Abbildung 1: Entstehung der Weltmeere (aus dem Titelbild

Abbildung 1: Entstehung der Weltmeere (aus dem Titelbild  Abbildung 2: Geometrie und Rechenweg im Äquinoktium mit Sonnenstand über dem Äquator

Abbildung 2: Geometrie und Rechenweg im Äquinoktium mit Sonnenstand über dem Äquator

Abbildung 4: Breitenabhängiger Verlauf des maximalen S-B Temperaturäquivalents (schwarze Kurve) und einer tentativen Durchschnittstemperatur zum Zeitpunkt der jeweiligen Sonnenwenden (rote Linie) mit farblich unterlegten Differenzen

Abbildung 4: Breitenabhängiger Verlauf des maximalen S-B Temperaturäquivalents (schwarze Kurve) und einer tentativen Durchschnittstemperatur zum Zeitpunkt der jeweiligen Sonnenwenden (rote Linie) mit farblich unterlegten Differenzen Abbildung 5: Der Jahresverlauf des maximalen S-B Temperaturäquivalents für die geografischen Breitenkreise von 80° Nord bis 80° Süd aus einer Inversion der maximalen Albedo bereinigten örtlichen Sonneneinstrahlung

Abbildung 5: Der Jahresverlauf des maximalen S-B Temperaturäquivalents für die geografischen Breitenkreise von 80° Nord bis 80° Süd aus einer Inversion der maximalen Albedo bereinigten örtlichen Sonneneinstrahlung Abbildung 6: Jahresverlauf der Differenz zwischen täglicher maximaler temperaturwirksamer solarer Einstrahlung in W/m² und dem zugehörigen Strahlungswert im Äquinoktium auf der Nordhalbkugel

Abbildung 6: Jahresverlauf der Differenz zwischen täglicher maximaler temperaturwirksamer solarer Einstrahlung in W/m² und dem zugehörigen Strahlungswert im Äquinoktium auf der Nordhalbkugel Abbildung 7: Die Grundlagen des CO2-Klimaglaubens bestehen aus 3 eindimensionalen Zahlenwerten

Abbildung 7: Die Grundlagen des CO2-Klimaglaubens bestehen aus 3 eindimensionalen Zahlenwerten

Abbildung 9: Vergleich des maximalen S-B-Temperaturäquivalents mit gemessenen Temperaturen

Abbildung 9: Vergleich des maximalen S-B-Temperaturäquivalents mit gemessenen Temperaturen Abbildung 10: Flächennormiertes hybrides S-B-Temperaturmodell im Äquinoktium

Abbildung 10: Flächennormiertes hybrides S-B-Temperaturmodell im Äquinoktium Abbildung 11: Vergleich von Faktor4-THE-Paradigma und hemisphärischem Konvektionsmodell

Abbildung 11: Vergleich von Faktor4-THE-Paradigma und hemisphärischem Konvektionsmodell Abbildung 12: Textausschnitt Rahmstorf auf

Abbildung 12: Textausschnitt Rahmstorf auf