Die globalen Temperaturen steigen und steigen – oder etwa nicht? Teil 3

Teil 3: Die wissenschaftliche Freiheit scheint grenzenlos – Wir gehen weiteren, vom Menschen verursachten Temperaturrekorden entgegen

Raimund Leistenschneider

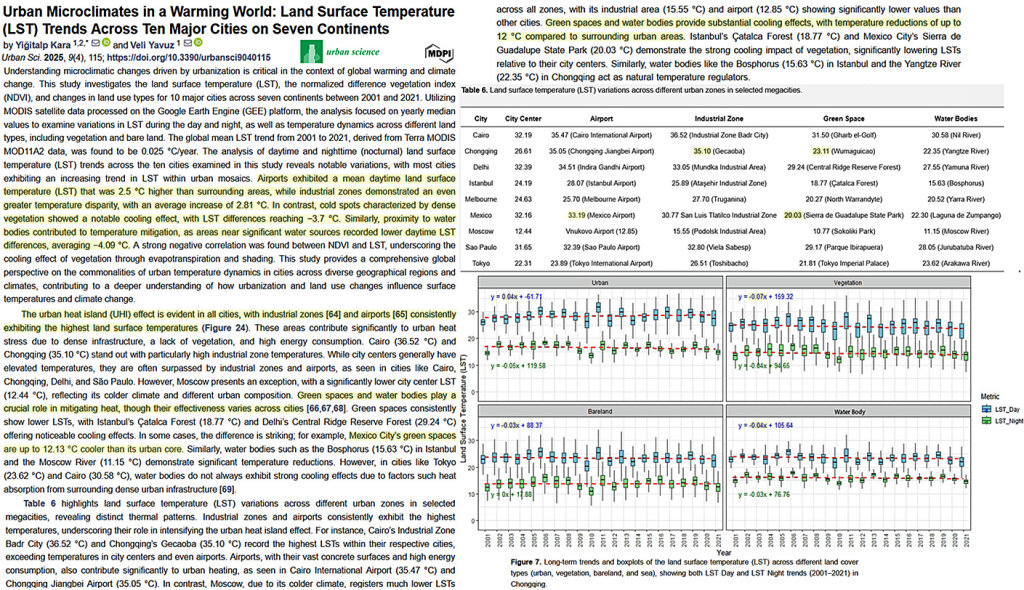

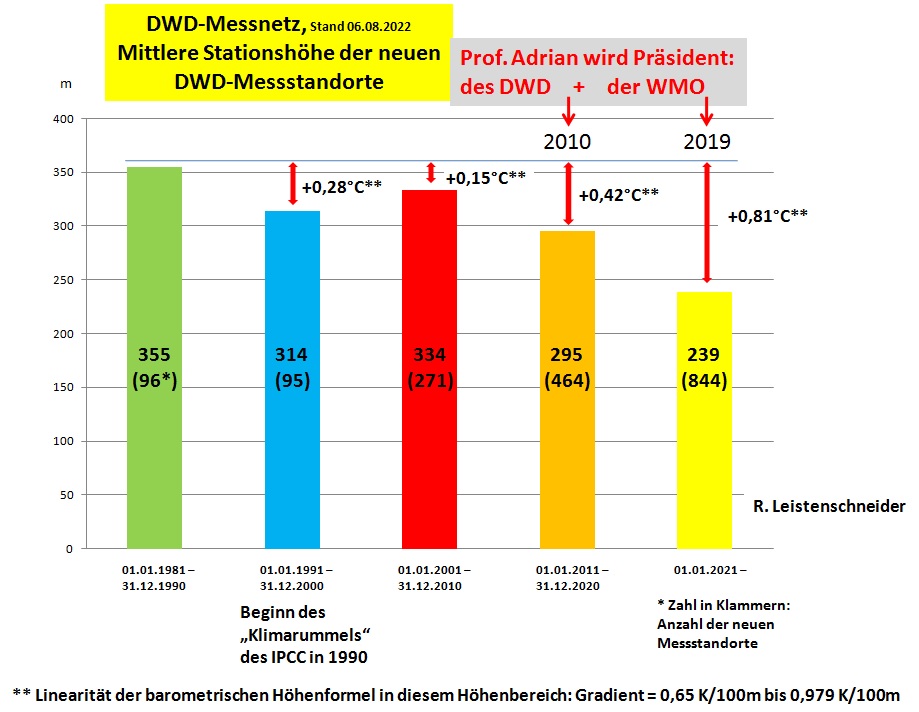

Abb.18, Quelle: R. Leistenschneider, nach Daten des DWD, zeigt die Stationshöhe im Durchschnitt von den neu aufgenommenen Messstandorte des DWD in dessen Messnetz. Also jeweils die mittlere Höhe aller Stationen einer Dekade, im Vergleich, vor den Aktivitäten des IPCC.

Der in Abb.18 genannte obere Wert des Temperaturgradienten von 0,979 K/100m gilt streng genommen nur für trockene Luft, die kein gasförmiges Wasser gebunden hat. Folgerichtig wird er daher trockenadiabatischen Temperaturgradient genannt.

Der vertikale Temperaturgradient beträgt in trockener Luft etwa 0,979 K pro 100 m, in feuchter Luft bei Kondensation etwa bei 0,6 K pro 100m. Dies gilt jedoch nur in der freien Atmosphäre. Über festen Oberflächen kommt der Effekt der „hoch gelegenen Heizfläche“ zum Tragen. Soll heißen, dass bei gleicher Luftmasse die Temperatur 2 m über Grund höher ist als in der freien Atmosphäre auf gleicher Höhe über einem Gebiet, dass deutlich tiefer liegt. Der ehemalige Mitarbeiter des DWD Christian Freuer hat während seiner Tätigkeit beim DWD diesen Effekt privat untersucht, im Vergleich der Städte München (550 m ü. NN) und Berlin (ca. 50 m ü. NN). Ergebnis: Es ergab sich eine vertikale Temperaturabnahme um etwa 0,4 K pro 100 m bei labil geschichteten Luftmassen, bei stabiler Schichtung war es entsprechend weniger.“

Durch die Verringerung der mittleren Gesamtstationshöhe, steigen die statistischen Deutschlandmitteltemperaturen, im Vergleich zu früheren Jahresmittelwerten.

Siehe hierzu auch den Artikel „Die Falschmesser vom Deutschen Wetter Dienst oder, wie der DWD die Deutschlandtemperatur um +1,4°C zu hoch angibt – Teil 3“ der Autoren Leistenschneider, Baritz und Kowatsch.

Doch damit immer noch nicht genug!

Nachträgliche Messwertveränderungen durch den DWD

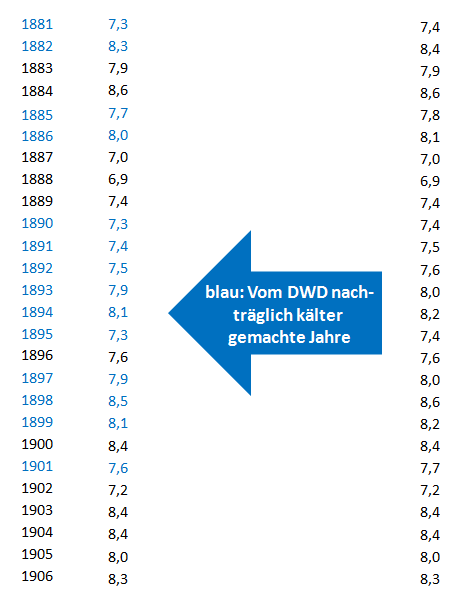

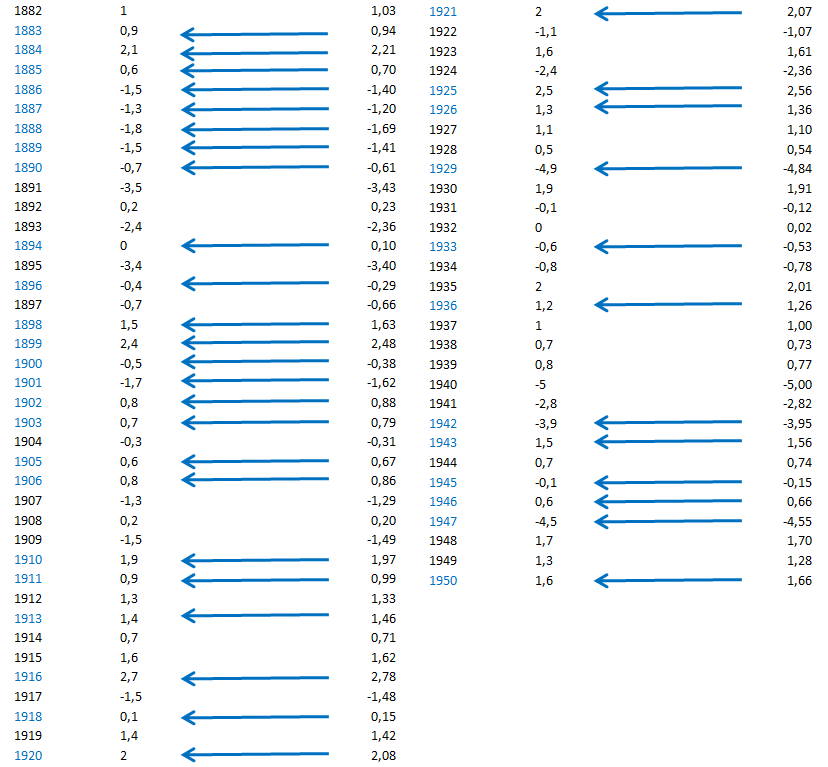

Josef Kowatsch hat aus den DWD-Daten ermittelt, dass der DWD ganz gezielt die Temperaturjahresdaten für Deutschland nachträglich dahin verändert, dass er die Jahrestemperaturen zu Beginn seiner Messreihe ab 1881 kälter macht, um dadurch die heutigen wärmer erscheinen zu lassen (Abb.19).

Abb.19, Quelle: Josef Kowatsch, nach Daten des DWD, zeigt die vom DWD nachträglich kälter gemachten Jahre zu Beginn seiner Vergleichstemperaturen für Deutschland-Jahresmittel. Durch solche DWD-Tricks wird es auf wundersame Weise in Deutschland immer wärmer und wärmer.

Gleiche Manipulationen hat der DWD bei den Wintertemperaturen für Deutschland angewendet (Abb.20).

Abb.20, Quelle: Josef Kowatsch, nach Daten des DWD, zeigt die Jahre und die vom DWD nachträglich veränderten Temperaturmittelwerte für Deutschland-Winter, hin zu kälteren Temperaturen, zu Beginn seiner Vergleichsmessungen. Auch hier mit dem Ziel: Die heutigen Temperaturen im Vergleich wärmer darstellen zu können, wenn die historischen Temperaturen nachträglich kälter gemacht werden. Ab 1951 fanden keine nachträglichen Veränderungen vom DWD statt.

Fehlerhöhe bei den Jahresmitteltemperaturen für Deutschland

Der Autor hat mit zwei gänzlich unterschiedlichen Lösungswegen ermittelt, wie groß, aufgrund der vorgenannten Paradigmen, der Fehler bei den Jahres(vergleichs)temperaturen ist, die der DWD jährlich veröffentlicht. In 2024 waren dies nach dem ersten Lösungsweg:

+ 1,42°C und nach dem zweiten Lösungsweg:

+ 1,40°C, was identische Ergebnisse sind.

Der erste Lösungsweg basiert auf dem Steigungsvergleich der DWD-Jahrestemperaturen seiner – nach eigenen Angaben – Referenzstation Hohenpeißenberg, mit der DWD-Jahrestemperaturreihe für Deutschland. Beides für den Zeitraum von 1881 – 2023.

Dabei werden grobe Unregelmäßigkeiten (Sprünge) in den Steigungen der beiden Messreihen ausgewertet und daraus die Temperaturabweichung ermittelt. Dass es sich bei den genannten Unregelmäßigkeiten, werden beide Messreihen in Relation zueinander gesetzt, um Fehler handelt, die nicht auftreten dürfen, basiert auf den Strahlungsgesetzen nach Planck und sind durch diese abgesichert. Denn berechnen lässt sich so manches, aber allein die Physik bestimmt, ob eine Rechnung sinnvoll ist, oder ob nicht*).

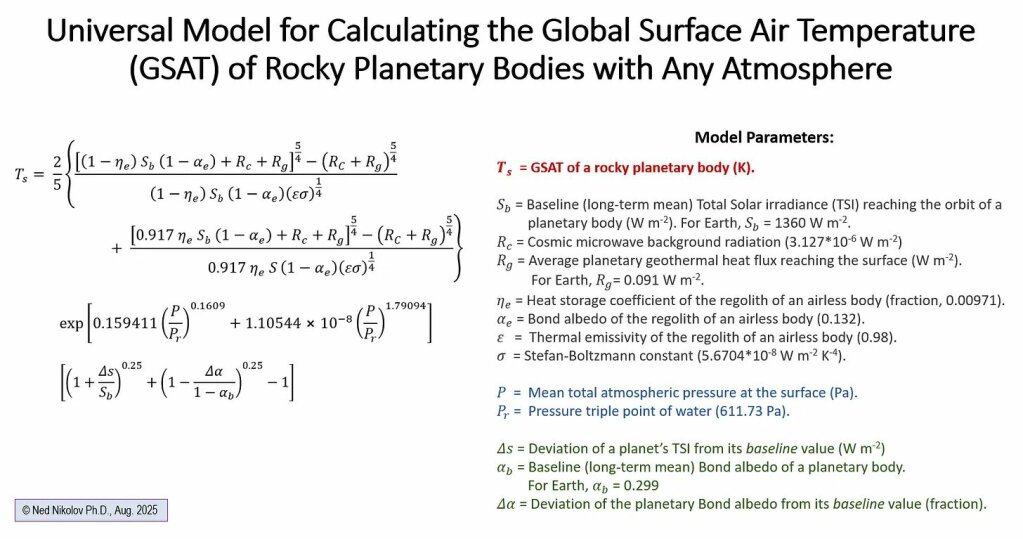

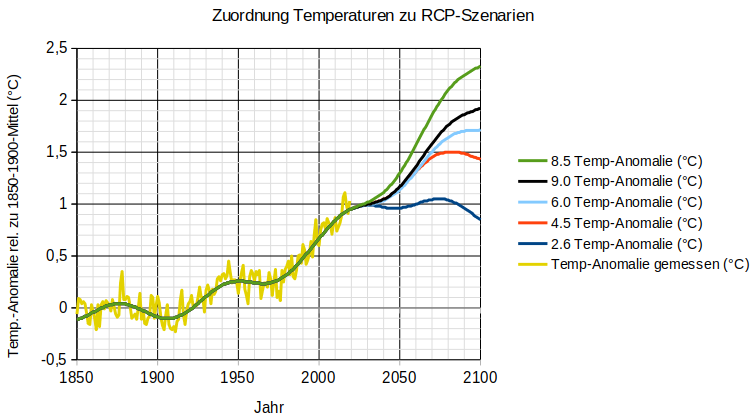

*) Klassisches Beispiel einer sinnlosen Berechnung zeigt Abb.21:

Abb.21 zeigt die RCP-Szenarien (Klimaszenarien) der Zukunft. Sinnlose und äußerst kostspielige Berechnungen für unser Klima der Zukunft. Berechnungen, die nichts mit der Wirklichkeit zu tun haben, sondern reine Phantasieprodukte oder sollte der Autor besser sagen, Spinnereien sind, die mit unseren Steuer- und Abgabengeldern finanziert werden.

Der zweite Lösungsweg basiert auf der Diplomarbeit beim DWD, die sich damit befasst, wie groß die Temperaturabweichungen bei den Tagesmaximaltemperaturen sind, zwischen der neuen Messmethode, Messung elektronisch mit Fühler Pt 100 und den bisherigen Messungen mittels Quecksilberthermometer. Die Beobachtungsreihen belaufen sich dabei auf einen Zeitraum von rund 8½ Jahren.

Temperarturerhöhung durch veränderte Messmethoden beim DWD

In Fachkreisen bekannt ist die Vergleichsverzerrung durch die Umstellung der Messsysteme und zwar von manueller Ablesung von Quecksilberthermometer, zu elektronischer Messung mit Pt 100-Messfühler.

Dazu der Fachmann Prof. Malberg, FU Met Inst. von 2010:

„Mit den Auswirkungen auf die Klimatemperatur durch die Umstellung von Quecksilberthermometermessungen auf elektronische Messverfahren Ende der 1980er/Anfang der 1990er Jahre hat sich W. Wehry (Beiträge zur BWK SO 22/09) befasst. Auch dieser (Fort-)Schritt hatte offensichtlich eine gewisse scheinbare Erhöhung der Mitteltemperatur zur Folge, da die elektronischen Messungen in der Regel höhere Maxima als die trägen Quecksilbermessungen ergeben. Der Effekt wirkt sich vor allem dort aus, wo die Mitteltemperatur aus Maximum und Minimum gebildet wird, u. a. in den USA.“

„Die Verlagerung von Klimastationen an neue Standorte führt in der Regel zu sprunghaften Änderungen der Klimawerte. Wird die neue Station nicht auf die bisherige Messreihe (oder umgekehrt) mittels vieljähriger Parallelbeobachtungen reduziert, so kann der Bruch so groß sein, dass die Klimareihe für die Analyse des langfristigen Klimawandels unbrauchbar wird.“

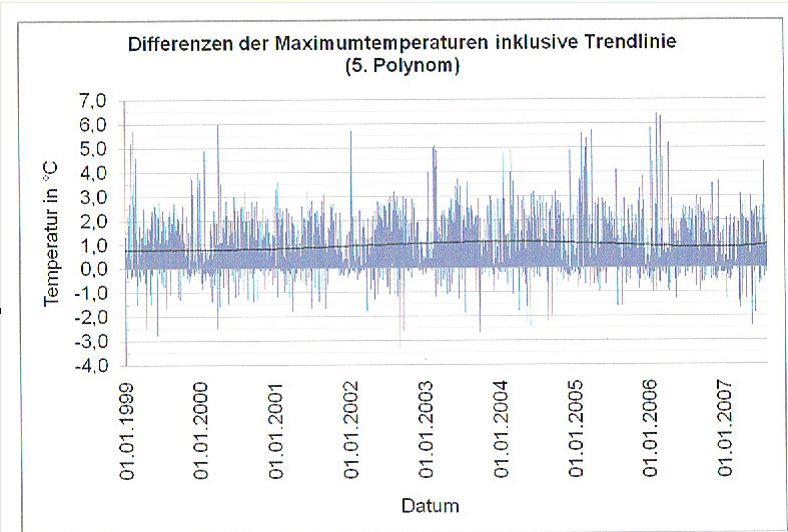

Wie groß die gemessenen Temperaturabweichungen sind, zeigt Abb.22.

Abb.22, Quelle: Beilage zur Berliner Wetterkarte 44/13, „Vor- und Nachteile durch die Automatisierung der Wetterbeobachtungen und deren Einfluss auf vieljährige Klimareihen“, Klaus Hager.

Abb. 22 zeigt den Unterschied der Messungen mit einem Quecksilberthermometer und der heutigen elektronischen Messungen über einen Zeitraum von 8 1/2 Jahren. Sehr gut zu sehen, dass die elektronische Messung deutlich höhere Werte ergibt und zwar um +0,93°C höher! Dazu der Text des Verfassers Klaus Hager:

„An den 3144 Tagen ergab sich eine mittlere Differenz von + 0,93 Grad – Pt 100 höher als Quecksilber. Die maximal erfasste Tagesdifferenz betrug gar 6,4 Grad! An 41% der Tage war die Differenz 0 bis 1 Grad, an 26% der Tage 1 bis 3 Grad und an 18% der Tage größer als 2 Grad, an 15% der Tage waren die Quecksilberwerte höher als die mit Pt 100 gewonnenen Höchstwerte.“

„Ursachen hierfür können der Grad der Wolkenbedeckung und die Sonnenscheindauer, aber auch Windgeschwindigkeit und Luftmassenwechsel sowie die Bodenbedeckung mit einer Schneedecke sein. Somit kann man nicht mit generellen Korrekturwerten arbeiten, sondern muss lapidar feststellen, dass die früher gewonnenen Messwerte nicht mit den heutig erfassten für eine lange Temperaturreihe verwendet werden dürfen, ohne dass Brüche in den langen Reihen entstehen, die nicht real sind.“

Da es sich um Maximalwerte handelt, für uns aber die Tagesmittelwerte interessant sind, hatten die Autoren Leistenschneider, Kowatsch und Baritz ein Referenz-Messnetz aus 50 DWD-Messstandorten gewählt, welches das gesamte DWD-Messnetz, aus dem der DWD sein Deutschlandjahresmittel bei den Temperaturen bestimmt, mit einer Genauigkeit von 2,5% 98% exakt abbildet. Siehe den Beitrag „Die Falschmesser vom Deutschen Wetterdienst oder, wie der DWD die Deutschlandtemperatur um +1,4°C zu hoch angibt, Teil 2“.

Ergebnis

Die vom DWD veröffentlichte Jahresvergleichstemperatur für Deutschland ist um +1,4°C zu hoch und steigt an.

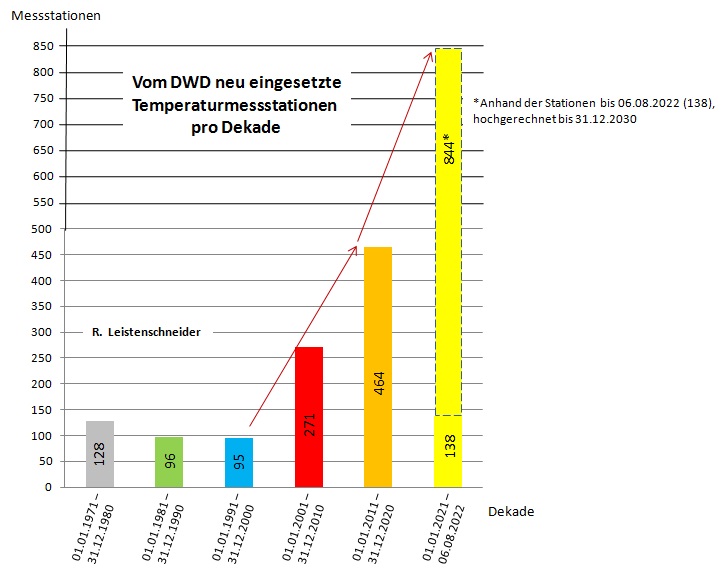

Der Autor erwähnte eingangs, in 2024, also für den Jahres(vergleichs)temperaturmittelwert 2023. Die Abweichung zur tatsächlichen Vergleichstemperatur mit früheren Jahren wird jedoch von Jahr zu Jahr immer größer, da der DWD sein Messnetz weiter, nach der im Teil 2 beschriebenen Methodik, ändert (Abb.23). Wir dürfen uns also auf weiter steigende Jahres(vergleichs)temperaturen freuen, zumindest, wird der DWD uns solche „verkaufen“ wollen. Es wird also immer wärmer und wärmer…..

Abb.23, Quelle: R. Leistenschneider, nach Daten des DWD zeigt, wie viele neue Temperaturmessstationen (Standorte) der DWD in den letzten Jahrzehnten in sein Messnetz aufgenommen hat. Schon gravierend, wie sehr der DWD ab der Jahrhundertwende neue Messstationen aufnimmt. In den 2 Jahrzehnten ab der Jahrhundertwende 735 neue Messstationen. Dies sind etwa 4-mal so viele, wie in den 2 Jahrzehnten davor. Nicht nur das, ab 2021 beschleunigt der DWD nochmals rapide die Aufnahme neuer Messstationen und zwar um annähernd das 10-fache (!), wie in den Jahrzehnten des ausgehenden 20.Jahrhunderts. Siehe hierzu auch hier und hier.

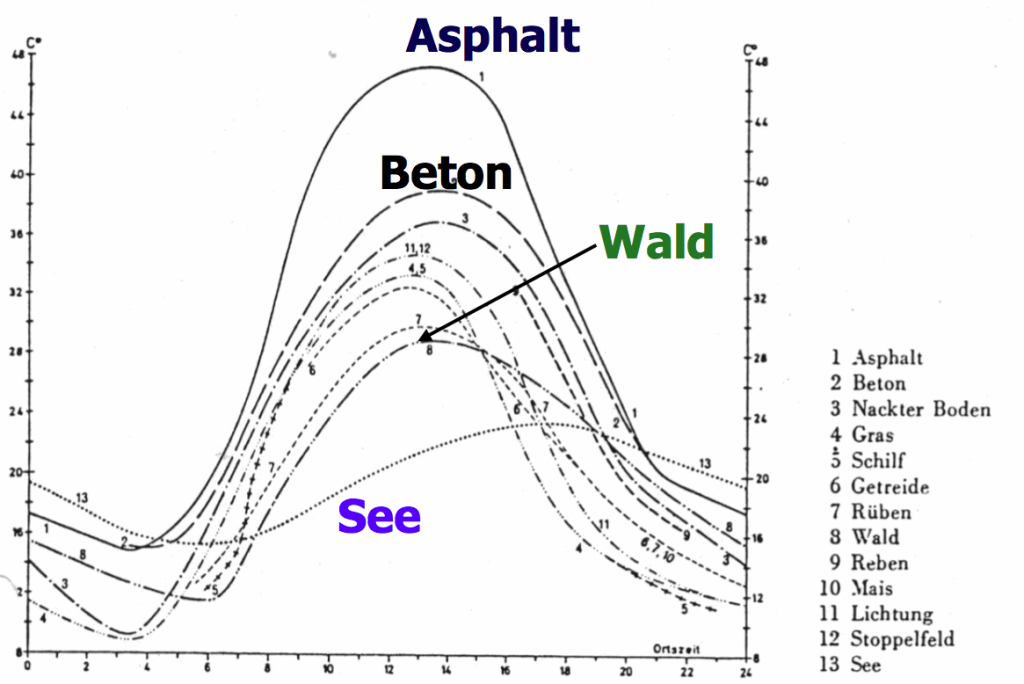

Wie groß die gemessenen Temperaturunterschiede, in Abhängigkeit des gewählten Standortes sind, zeigt Abb.24:

Abb.24 zeigt den Tagesgang der Temperatur an einem sonnigen Sommertag in Bodenhöhe für verschiedene Böden, nach Fezer 1975. Nicht nur, dass über Beton und insbesondere Asphalt die Temperaturen z.B. sehr stark über denen des Waldbodens liegen, sondern, auch ein deutlicher Temperaturunterschied von mehreren °C zwischen Gras, Wald oder landwirtschaftlichen Flächen vorliegt. Messstationen, die ursprünglich auf freiem Feld standen und zwischenzeitlich in einer Gras, Hecken oder offenen Waldlandschaft stehen (oder umgekehrt), weil sich das Landschaftsbild über die Jahrzehnte änderte, was nicht wirklich verwundern kann, geben somit deutlich veränderte Temperaturwerte wieder und verzerren jeglichen Temperaturvergleich.

Wie bereits geschildert: Beim DWD-Ausbau seines Messnetzes ist auffällig, dass gerade die neu hinzugenommen Messstationen die Messstationen sind, die Allzeitrekorde bei den Deutschlandtemperaturen messen, wie die Station in Duisburg-Baerl (ab 01.06.2007 im DWD-Messnetz) oder in Lingen (ab dem 25.09.2008 im DWD-Messnetz). Wie bereits geschildert, hat diese „Manipulation“, hin zu scheinbar höheren Temperaturen, Methode und wird nicht nur vom DWD, sondern auch in anderen Ländern, wie den USA, angewendet, siehe den Bericht des Heartland Instituts.

Im Artikel „Teil 2: Nicht der menschengemachte Klimawandel, sondern, die menschengemachte Klimamanipulation“ von Leistenschneider / Kowatsch, hatte der Autor folgendes Erkennungsbild als Collage gezeigt:

Abb.25, Collage: R. Leistenschneider. DWD und WMO bei ihrer Klimaarbeit….In der Tat ein menschengemachter Klimawandel und nicht nur beim DWD.

Die offensichtlich von der Politik beauftragte Panikmache, um einen angeblich menschgemachten Klimawandel, basieren auf sog. THG, als unerschöpfliche Geldquelle, bleibt für unser Land und seine Bürger nicht ohne Folgen. Da ist von Energiewende, Transformation und vieles mehr die Rede.

Eine unsinnige Energiewende, die Deutschland die höchsten Strompreise weltweit beschert hat. Oder eine sog. Transformation von diesem und jenes, die unsere Industrie, Wirtschaft, Arbeitsplätze… ruiniert. Was ist aus unserem Land, seit der unseligen Klimahype, die nur Lug- und Betrug ist, geworden? Diese Karikatur zeigt dies anschaulich. Können wir urheberrechtlich nicht direkt zeigen, daher nur der Link.

Und die Abzocke für die Potemkinsche Dörfer einer sog. Klimakatastrophe geht weiter, wie Bild jüngst berichtete:

Regierung plant neue Strom-Abgabe

Der Autor ist der Meinung: Es reicht. Money for Nothing ist sicherlich ein hervorragender Pop-Song der Dire Straits, für unser Land jedoch kein Beispiel und schon gar nicht der Weg in die Zukunft.

Es liegt an uns, unser Land aus der selbstgewählten Isolierung, die in Abb. 25 skizziert ist, zu führen….Ob wir z.B. solchen „Propheten“ und dessen Richtung folgen, von dem die folgenden Zitate stammen:

„Deutschland ist ein Problem, weil die Deutschen fleißiger, disziplinierter und begabter als der Rest Europas (und der Welt) sind. Das wird immer wieder zu ´Ungleichgewichten´ führen. Dem kann aber gegengesteuert werden, indem so viel Geld wie nur möglich aus Deutschland herausgeleitet wird. Es ist vollkommen egal wofür, es kann auch radikal verschwendet werden – Hauptsache, die Deutschen haben es nicht. Schon ist die Welt gerettet.“ oder „Deutsche Helden müsste die Welt, tollwütigen Hunden gleich, einfach totschlagen.“

Beide Zitate stammen von Joschka Fischer, Die Grünen. Offensichtlich wird dort Abb.26 das Wort geredet.

Abb.26, Quelle, zeigt anschaulich die deutschen Formeln höherer Mathematik und angewandter Physik, wie sie von all jenen, die sich auf die Fahnen geschrieben haben „weiter wie bisher“ propagiert wird.

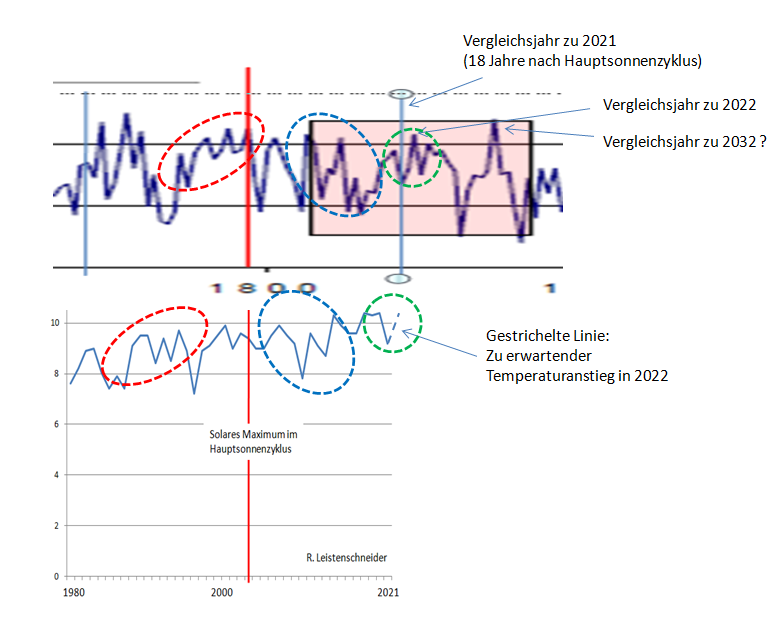

Der Autor hat u.a. im Juli 2021 folgende Abbildung veröffentlicht:

Abb.27, Quelle: Leistenschneider, zeigt den Vergleich der Temperaturgänge 20 Jahre vor und 18 Jahre nach einem Hauptsonnenzyklus (dem im Mittel 208 jährigen de Vriess/Suess-Zyklus) von Deutschland (heute) nach Daten des DWD und Berlin-Dahlem (um 1800, Ausschnitt oben). Um 1800 gab es kein Deutschland noch keine flächendeckenden Temperaturmessungen. Daher auch hier kein Vergleich der Absolutwerte, aber durchaus der Temperaturmuster (Wechsel).

Deutlich sind starke Ähnlichkeiten im Temperaturmuster zu erkennen. Auch um 1800 stiegen im 19. Jahr nach einem Hauptsonnenzyklus die Temperaturen deutlich an, nachdem sie das Jahr zuvor gefallen waren. Dass die Temperaturmuster sich ähneln, liegt aus Sicht des Autors am Jetstream, genauer, dem Polarfrontjet (PFJ), der für die Hochs und Tiefs in unserem Wettergeschehen verantwortlich ist (diese steuert) und von der Sonne abhängig ist. Diese bestimmt seine mittlere geographische Lage durch den Energiegehalt in der Atmosphäre und seine Ausprägung. Siehe auch hier. Dort ab Abb.9.

Dass heutige Wettergeschehen und dessen statistischer Mittelwert, das Klima, sind also nichts Außergewöhnliches und fügen sich in natürliche Zyklen ein. Wir leben aktuell nicht etwa in einer Warmzeit, sondern in einer Kaltzeit mit einem „Zwischenhoch“, welches uns moderate Temperaturen beschert (Abb.9 und Abb.2 im Teil 1).

Fazit:

Die Klimahype, mit ihrer gegenwärtigen Steigerung einer sog. Klimakatastrophe, ist nichts anderes als Dummenfängerei (https://www.dwds.de/wb/Dummenfang ), wie dies der Volksmund, bei ähnlich gelagerten Dingen, so trefflich formuliert.

Unter dem Link ist zu lesen:

„Versuch, leichtgläubige Menschen durch plumpe Verlockungen für eine (zweifelhafte) Sache zu gewinnen.“

Dem ist nichts hinzuzufügen!

Raimund Leistenschneider – EIKE