Michael Schnell, Hermann Harde

Einleitung

Dass IR-aktive Gase (TH-Gase) Wärmestrahlung absorbieren können, ist unbestreitbar, denn dies wird durch unzählige Infrarotspektren nachgewiesen. Man ist sich auch weitgehend einig, dass auch für TH-Gase in großer Höhe das Kirchhoff‘sche Strahlungsgesetz gilt, wonach die spektrale Absorption gleich der spektralen Emission ist (hier, hier). Angesichts der hohen Stoßraten der Gasmoleküle bei Normaldruck wird jedoch von einigen Autoren angenommen, dass TH-Gase in der unteren Atmosphäre keine Emitter sind und auch keine Gegen- oder Rückstrahlung erzeugen (hier, hier). Demnach würden angeregte TH-Gase bei einer Kollision durch strahlungslose Deaktivierung ausschließlich Wärme erzeugen (Thermalisierung). Um die These der Thermalisierung zu überprüfen und gegebenenfalls im Sinne von K. Popper zu widerlegen, wurde eine spezielle Apparatur entwickelt, die das Prinzip des negativen Treibhauseffektes simuliert (siehe Teil 1).

In einem früheren Versuchsaufbau wurden eine geheizte und eine gekühlte Platte gemeinsam in einem thermisch isolierten Container untergebracht. Experimente mit dieser Apparatur konnten nachweisen, dass TH-Gase die Rückstrahlung vergrößern, so dass bei konstanter Heizung die Temperatur der warmen Platte (stellvertretend für die Erde) anstieg [1]. Ein Einfluss der TH-Gase auf die Lufttemperaturen konnte nicht ermittelt werden, da es hier kaum Veränderungen gab. Auch ließen sich die Auswirkungen von Wasserdampf nicht untersuchen, da dieses Gas entfernt werden musste, um eine Kondensation an der kalten Platte zu verhindern.

Diese Nachteile werden durch eine Zweikammer-Anordnung behoben. Im Mittelpunkt steht auch nicht mehr die Temperatur der Erde, sondern die Temperatur der Atmosphäre. In den Experimenten wird die Erdatmosphäre durch eine Schicht warmer Luft dargestellt, die sich über einer gekühlten Platte befindet. Luft und Platte sind durch eine PE-Folie voneinander getrennt, wodurch mechanische Wärmeströme unterdrückt werden. Außerdem können nun auch die Auswirkungen von Wasserdampf untersucht werden, da die PE-Folie direkten Kontakt mit der kalten Platte verhindert. Als Strahlungsempfänger ermöglicht die kalte Platte einen Energiestrom, der als Simulation des Wärmetransportes sowohl von der Atmosphäre in Richtung kälterer Erdoberfläche als auch in Richtung Weltall interpretiert werden kann.

Die Versuche zeigen, dass bereits geringe Mengen eines TH-Gases ausreichen, um die Wärmestrahlung der Luft deutlich zu erhöhen, während gleichzeitig ihre Temperatur sinkt. Damit ist ein negativer Treibhauseffekt nachgewiesen, der das Gegenteil bewirkt, was üblicherweise erwartet wird. Es konnte im Labormaßstab und bei dem Luftdruck der unteren Atmosphäre gezeigt werden, dass TH-Gase die kinetische Energie ihrer Umgebung aufnehmen und durch nachfolgende Emission in Wärmestrahlung umwandeln können.

Dieser Nachweis ist alles andere als einfach, denn eine Messung an Gasen benötigt einen Zylinder als Container. Und hier beginnen die Probleme, denn wie alle festen Körper emittiert der Zylinder Wärmestrahlung. Diese sogenannte Hintergrundstrahlung des Zylinders überlagert die Emissionen der TH-Gase. Dadurch wird nur die Spitze der Gasstrahlung sichtbar, ähnlich wie bei einem Eisberg (siehe Teil 1). Das ist auch der Grund, warum ausgefeilte, optimale Versuchsbedingungen erforderlich sind, um diesen Effekt nachzuweisen und warum so viele Versuche an diesen strengen Bedingungen gescheitert sind. Eine horizontal aufgestellte Styroporbox scheint auf den ersten Blick eine bequeme Lösung zu sein, da sie kommerziell verfügbar ist und sich leicht verarbeiten lässt. Wie in [2] beschrieben, ist ein solcher Versuchsaufbau für den Nachweis der Gasstrahlung aus verschiedenen Gründen, aber vor allem wegen ihrer intensiven Hintergrundstrahlung, nicht geeignet.

1. Der Versuchsaufbau

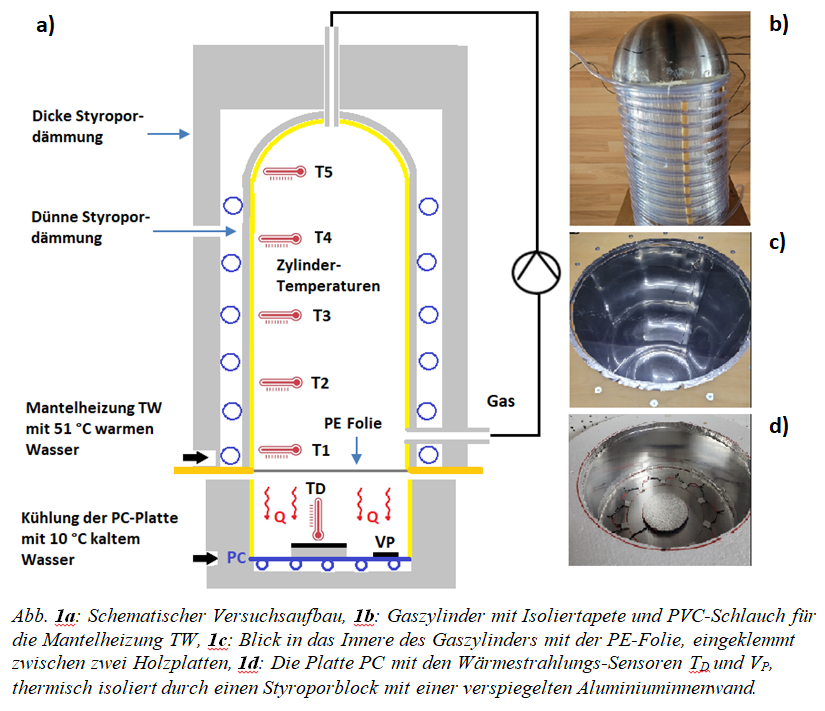

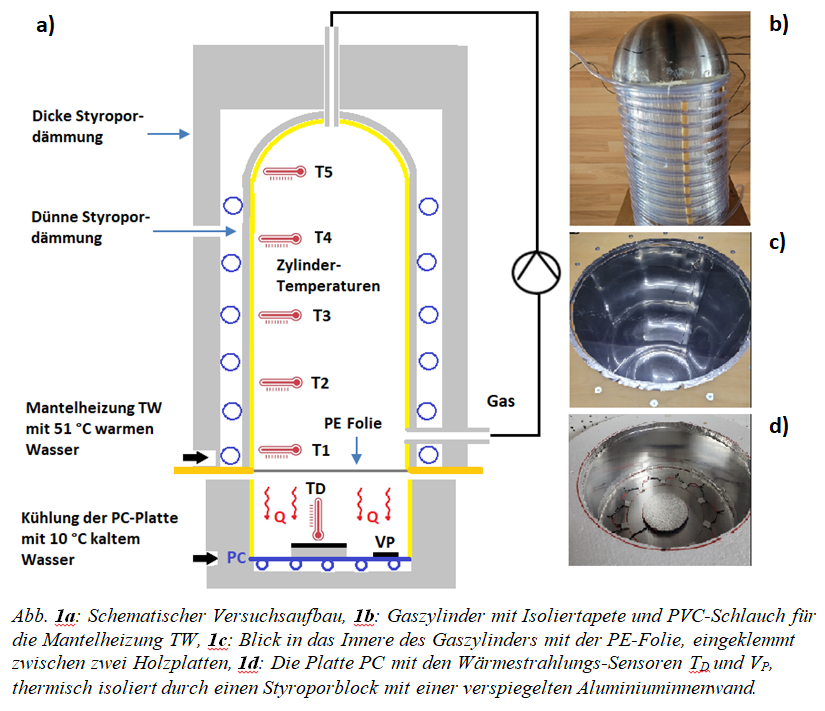

Um zu überprüfen wie sich Treibhausgase auf die IR-Emission und Temperatur eines Luftpaketes auswirken, braucht man zunächst nur einen beheizten Zylinder und eine geschwärzte und gekühlte Platte (PC). Konvektion ist ein sehr effektives Mittel des Wärmetransports. Um dies zu verhindern, müssen der warme Zylinder und die kalte PC-Platte senkrecht übereinandergestellt werden. Dabei wird der warme Zylinder oben und die kalte PC-Platte unten platziert, sodass eine stabile Schichtung entsteht. (siehe Abb. 1).

Die eigentliche Herausforderung besteht in der Reduzierung der Hintergrundstrahlung des Zylinders. Zu diesem Zweck wurde poliertes Aluminium mit einem geringen Emissionsgrad von ε ~ 5 % als Zylinderoberfläche verwendet (Abb. 1c). Das mag nach wenig klingen, doch die Innenfläche des Zylinders ist rund zehnmal so groß wie die Austrittsfläche zur PC-Platte und erzeugt eine Hintergrundstrahlung von 78 W/m2, während die Strahlungsdichte von CO₂ rund zehnmal geringer ausfällt.

Die abgegebene IR-Strahlung, allgemein als Wärmestrom Q zur Platte PC bezeichnet, wird durch zwei unabhängige Detektoren nachgewiesen: eine kleine, geschwärzte Scheibe auf einer Isolierschicht (Detektor TD) sowie zehn Mini-Peltier-Elemente (Detektor VP), die sich direkt auf der PC-Platte befinden (Abb. 1d).

Wie in Teil 1 beschrieben werden beim luftgefüllten Zylinder rund 94 % der Wärme durch Strahlungstransfer I0 und 6 % durch mechanische Wärmeleitung WL abgeführt. Zur Vereinfachung wird dieser Wärmestrom Q im Folgenden als Hintergrundstrahlung Iₒ bezeichnet, obwohl er einen geringen Anteil Wärmeleitung enthält.

Demgegenüber besteht der zusätzliche Wärmestrom bei Zugabe von TH-Gasen ausschließlich aus Infrarotstrahlung des TH-Gases. Diese Aussage lässt sich aus den Änderungen der Temperaturdifferenzen ΔT1 – ΔTC ableiten, die bei Zugabe der TH-Gase negativ werden. Für eine Zunahme der mechanischen Wärmeleitung wäre ein positiver Anstieg dieser Differenz zwingend erforderlich (Gleichung 1, Teil 1), was jedoch nicht beobachtet wird (siehe Tabelle 2b ff.). Die Differenzmessung des Wärmestroms vor und nach Zugabe des Treibhausgases misst somit die reine Gasstrahlung IGas. Diese wird allerdings durch Überlagerungen und Übertragungsverluste geschwächt, bevor sie die PC-Platte erreicht (Kap. 3).

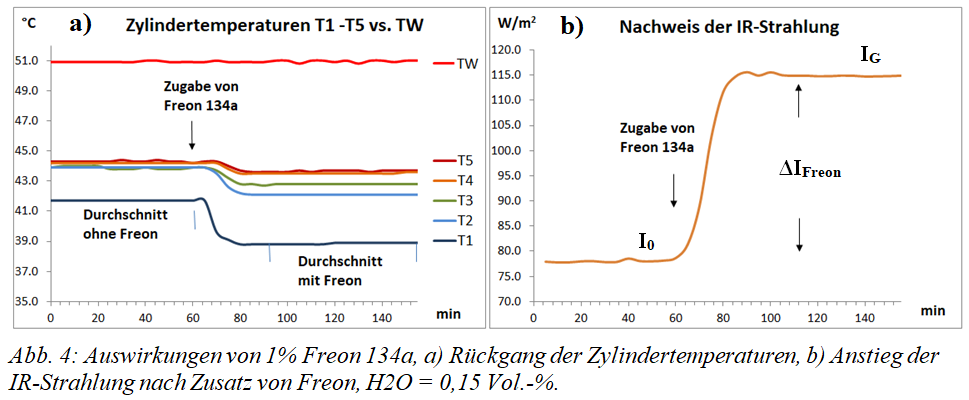

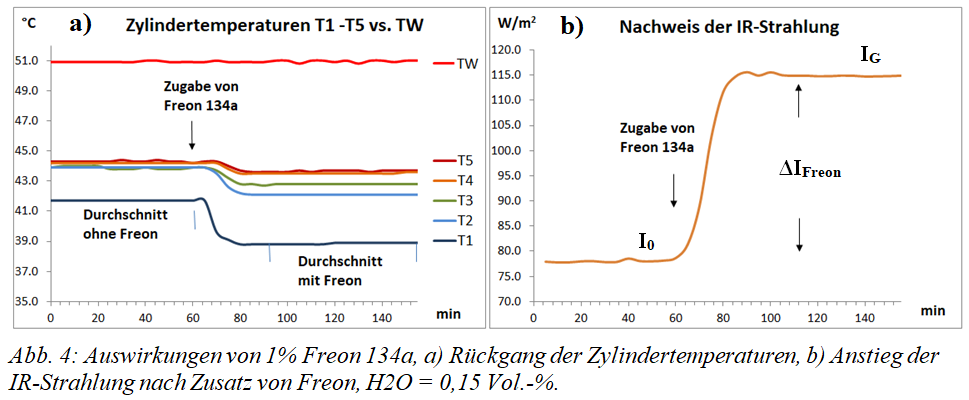

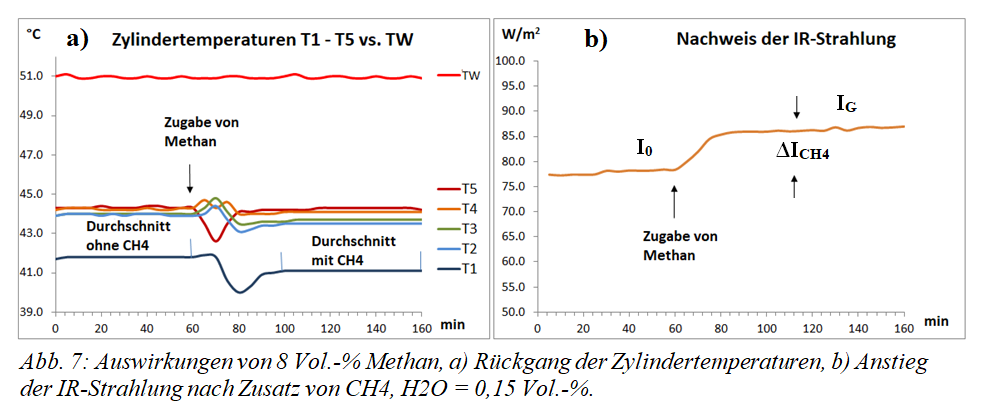

Die Temperaturen T1 bis T5 werden mithilfe von Temperatur-Datenloggern (Elitech) ermittelt. Da sich deren Messspitze nur 5 cm von der Zylinderwand entfernt befindet, wird eine Mischung aus Luft- und Wandtemperatur gemessen, die als Zylindertemperatur bezeichnet wird. Bei der Untersuchung geht es um diese Zylindertemperaturen und ihre Änderungen, deshalb wird der Zylinder – im Gegensatz zur Vorgänger-Apparatur [1] – nicht elektrisch beheizt, sondern mit thermostatisiertem Wasser von 51 ± 0,1 °C erwärmt. Hierzu wird das warme Wasser TW kontinuierlich durch den PVC-Schlauch der Mantelheizung geleitet. Ohne ausgehenden Wärmestrom Q müssten Zylinder- und Heizwassertemperaturen annähernd gleich sein. Aufgrund des Wärmestroms ergeben sich jedoch Differenzen zwischen den Zylindertemperaturen und der Heizwassertemperatur TW (siehe Teil 1). Um diesen Effekt noch zu verstärken, wurde zwischen dem PVC-Schlauch und der Zylinderwand eine 2 mm dünne Styroporisolierung angebracht. Diese schwächt den Wärmefluss vom Wasser zum Zylinder ab. Mithilfe dieser Maßnahme lässt sich die Gasstrahlung IGas auch an der Temperaturabnahme nach Zusatz von TH-Gasen gut nachweisen (siehe Abb. 4 ff.).

Die PC-Platte besteht aus geschwärztem Aluminiumblech, das auf ein spiralförmig gebogenes Kupferrohr in einem Betonbett geklebt ist. Durch dieses Rohr strömt thermostatisiertes Wasser mit einer Temperatur von 10 ± 0,1 °C, wodurch die aufgenommene Wärme kontinuierlich abgeführt wird.

2. Vorbereitende Studien

Es bedarf umfangreicher Vorbereitungen, um sicher zu sein, dass die gefundenen Effekte tatsächlich durch die Gasstrahlung der IR-aktiven Gase verursacht werden und nicht durch andere Einflüsse.

Für den Nachweis der Gasstrahlung von Treibhausgasen ist ein stationärer Zustand mit konstanten Temperaturen erforderlich. Um dies zu erreichen, wird das Heizwasser viele Stunden vor Beginn des Versuchs durch den Zylindermantel geleitet und so lange gewartet, bis sich ein stationärer Zustand eingestellt hat. Zur Auswertung wird ein Durchschnittswert von je einer Stunde vor und nach Zugabe des Probegases ermittelt.

Wenn ein Probegas zugeführt wird, das natürlich kälter als der Zylinder ist, sinken die Zylindertemperaturen kurzzeitig, insbesondere im T1-Bereich (siehe Abb. 4 ff.). Durch Blindversuche mit Luft als Probegas, kann gezeigt werden, dass schon nach 20 Minuten das thermische Gleichgewicht mit den ursprünglichen Temperaturen wieder erreicht ist [3].

Die Wärmeleitfähigkeit der Gase im Zylinder spielt keine Rolle wie Versuche mit den Edelgasen Argon bzw. Helium zeigen [3].

Durch Kalibrierung mit einer externen Strahlungsquelle bekannter Intensität erhält man einen streng linearen Zusammenhang für die beiden Sensoren TD und VP mit einem identischen Korrelationskoeffizienten von R^2 = 0,999 [3].

Aus den TD- bzw. VP-Werten und der Austrittsfläche A = 0,0855 m2 kann die jeweilige Strahlungsintensität berechnet werden, wobei zur Erhöhung der Genauigkeit der Durchschnitt beider Werte verwendet wird.

3. Der Einfluss von Wasserdampf auf die Hintergrundstrahlung

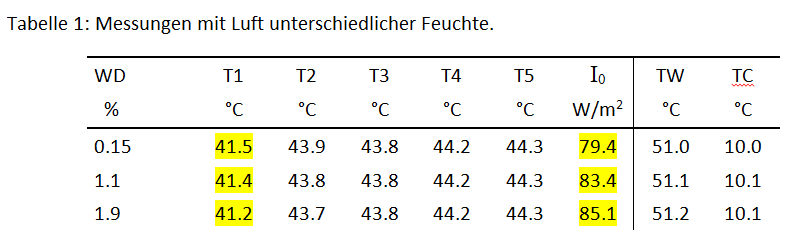

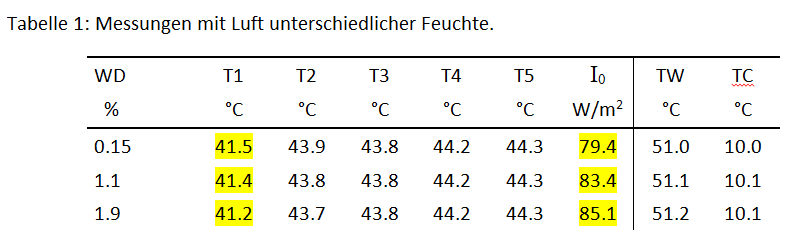

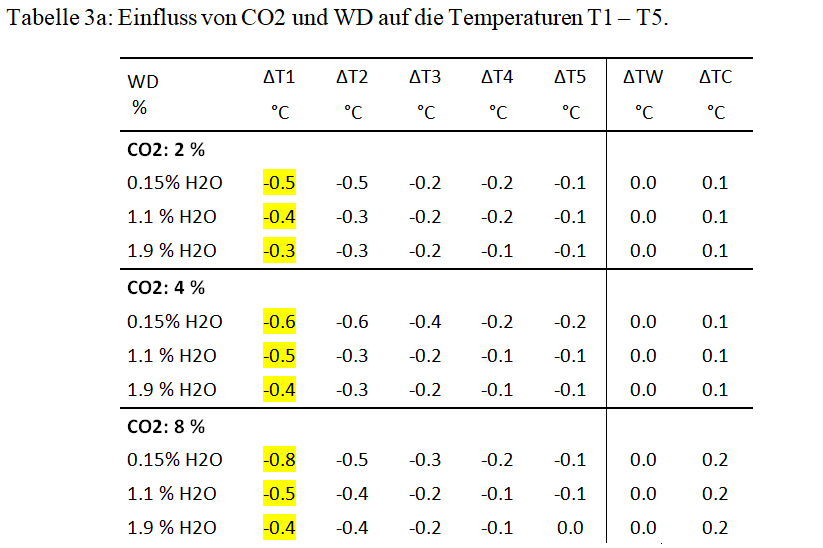

Um den Einfluss von Wasserdampf nachzuweisen, werden bei drei verschiedenen WD-Konzentrationen die Zylindertemperaturen T1 bis T5 sowie die ausgehende Emission I0 gemessen. Die Heiz- und Kühl-Temperaturen (TW und TC) sind dieselben, die auch bei den späteren Messungen von Treibhausgasen verwendet werden.

Die unterschiedlichen WD-Konzentrationen haben, abgesehen von der T1-Messstelle, nur einen minimalen oder keinen Einfluss auf die Zylindertemperaturen. Das liegt an der im Vergleich zu den anderen atmosphärischen TH-Gasen (die bei Konzentrationen bis zu 8 Vol.-% untersucht wurden) sehr geringen, maximalen WD-Konzentration von nur 1,9 Vol.-% (siehe Teil 1).

Deutliche Änderungen zeigen sich jedoch bei der Hintergrundstrahlung I0, die mit steigender Luftfeuchte von 79,4 auf 85,1 W/m2 ansteigt (Tab. 1).

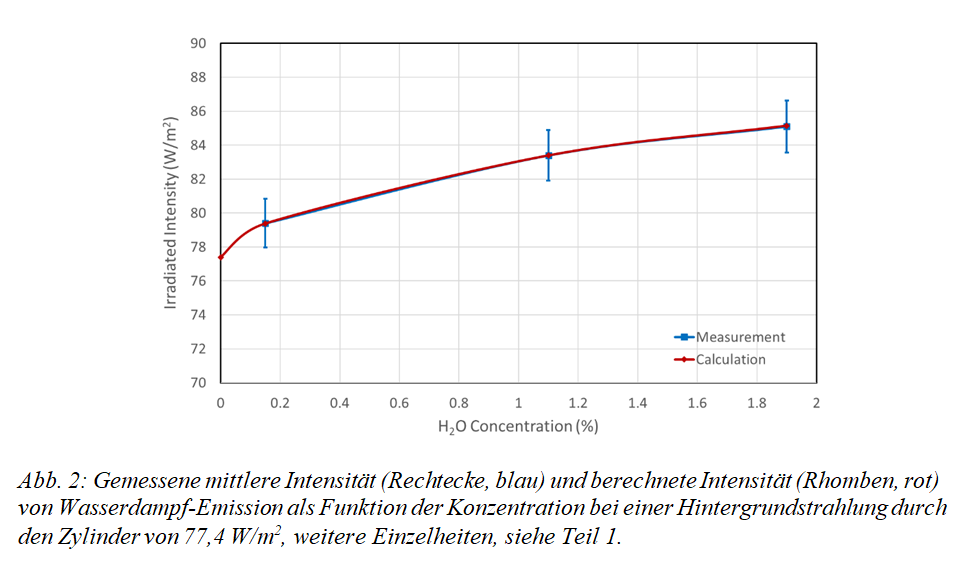

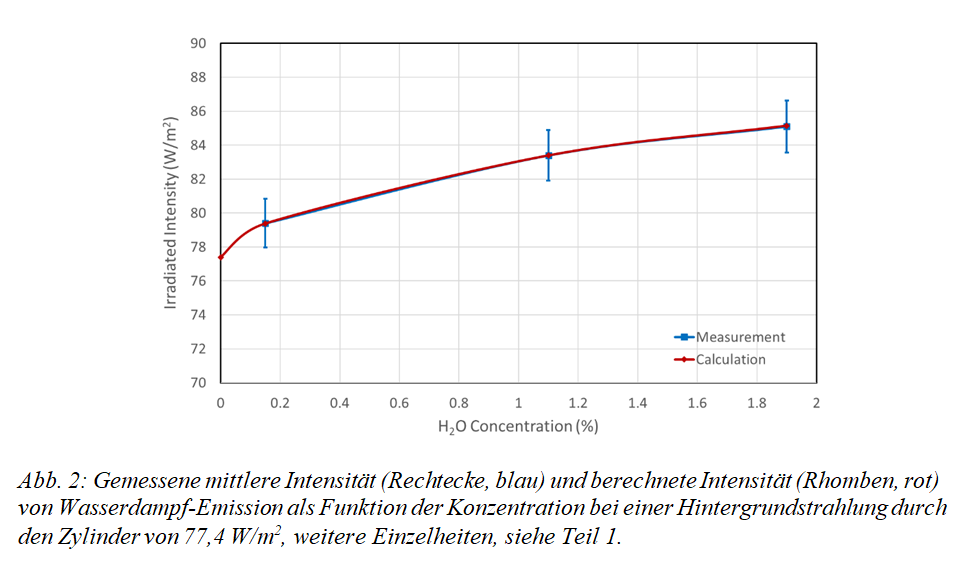

Die gemessenen Werte für die Hintergrundstrahlung I0 können durch Strahlungstransfer-Rechnungen sehr gut reproduziert werden, wenn Hintergrundstrahlung der Zylinderwände und Übertragungsverluste berücksichtigt werden (Abb. 2).

Nach diesen Rechnungen erzeugen 0,15 Vol.-% Wasserdampf im Inneren des Zylinders eine zusätzliche Strahlungsintensität von 10,5 W/m2. Beim Erreichen der PC-Platte reduziert sich dieser Wert jedoch auf 2,0 W/m2. Im Falle von 1,9 % Wasserdampf bleiben von 41,3 W/m2 nur noch 7,7 W/m2 übrig.

Diese Verluste entstehen durch die Überlagerung der WD-Strahlung durch die Infrarotstrahlung der Zylinderwände sowie durch Übertragungsverluste zur PC-Platte. Die starken Abschwächungen offenbaren die Schwierigkeiten, die Gasstrahlung von Treibhausgasen experimentell nachzuweisen. In Abb. 3 wird gezeigt, dass die WD-Banden (blaue Linien) die gleichen Wellenzahlen beanspruchen, die auch von der Hintergrundstrahlung der Zylinderwände (grau gestrichelte Linie) einschließlich der Absorptionslinien der PE-Folie bei 750 und 1500 cm-1 besetzt werden. Durch diese Überlagerungen sind nur die WD-Intensitäten wirksam, die über die graue Linie hinausgehen.

Die gegenseitige Überlagerung der verschiedenen Treibhausgase untereinander, insbesondere durch Wasserdampf erfolgt nach dem gleichen allgemeinen Prinzip:

Die gemeinsame Strahlung mehrerer Treibhausgase ist stets kleiner als die Summe der einzelnen Anteile.

Innerhalb der Atmosphäre gibt es noch weitere Überlagerungen, die durch Aerosole und Wolken verursacht werden. Als Planck-Strahler mit einem kontinuierlichen Strahlungsspektrum können diese festen und flüssigen Partikeln die Emissionen sämtlicher Treibhausgase beeinflussen. Daher ist der CO₂-Treibhauseffekt bei hoher Luftfeuchte und bedecktem Himmel deutlich geringer als bei klarem Himmel und geringer Feuchte.

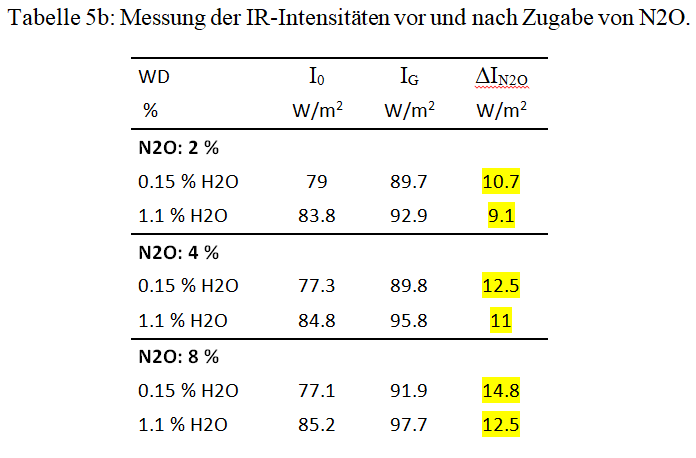

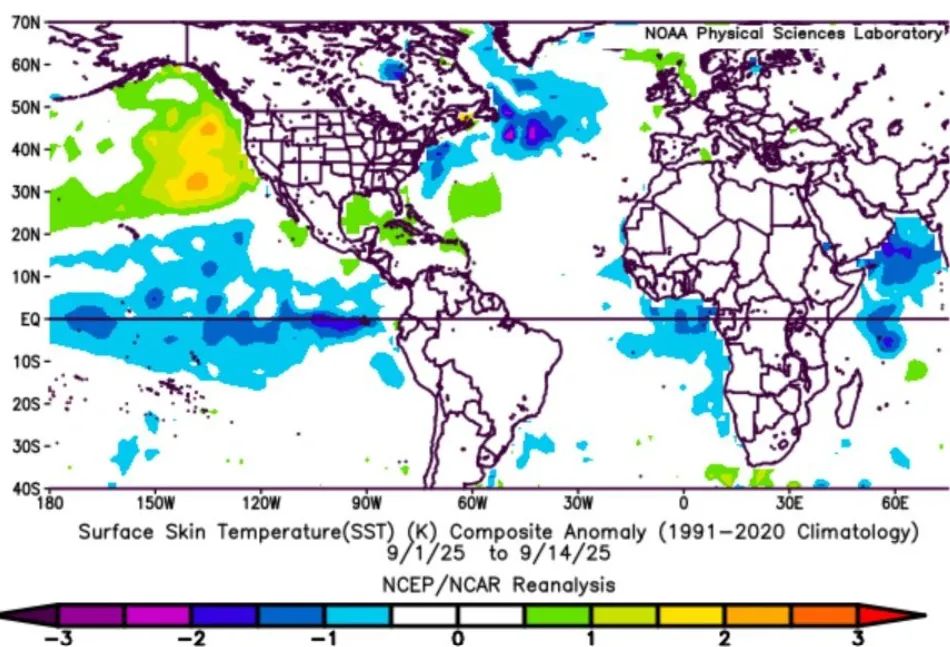

Die Überlagerung der WD-Strahlungen mit der Strahlung der anderen atmosphärischen Treibhausgase führt zu einer deutlich reduzierten Wasserdampf-Rückkopplung. Das IPCC geht von einer positiven Rückkopplung um einen Faktor 2 – 3 aus, um die Auswirkungen von CO₂ aufzublähen und bildet so das Rückgrat des Klimaalarmismus (hier). Ohne diese Hypothese würde sich die Erde bei einer Verdopplung der CO₂-Konzentration lediglich um harmlose 0,6 bis 1 °C erwärmen (Harde 2013, 2017 [4, 7]). Modell-Rechnungen mit einer „Wasserdampf-Rückkopplung“ unterstellen sogenannte Troposphären-Hotspots, eine Zunahme von Wasserdampf und Temperatur in der höheren Troposphäre, zwischen dem Äquator und dem 30. Breitengrad. Für diese Hypothese gibt es jedoch keine Bestätigung, denn Satellitenmessungen zeigen das genaue Gegenteil, eine Abnahme des Wasserdampfes und einen Temperaturrückgang in den mittleren und oberen Schichten der Troposphäre (hier). Der größte Teil der Erwärmung seit den 1970er Jahren fand in der Nähe der Oberfläche statt (hier).

4. Die IR-Emissionen der Treibhausgase

In diesem Abschnitt sind die Messungen und entsprechende Rechnungen zur IR-Emissionen der Treibhausgase CO₂, Methan, Lachgas und Freon 134a zusammengestellt. Alle Untersuchungen werden bei Normaldruck und bei konstanten Anfangs-Temperaturen durchgeführt. Neben dem Nachweis der IR-Strahlung wird auch die Abkühlung der Gase als Folge dieser Emissionen erfasst.

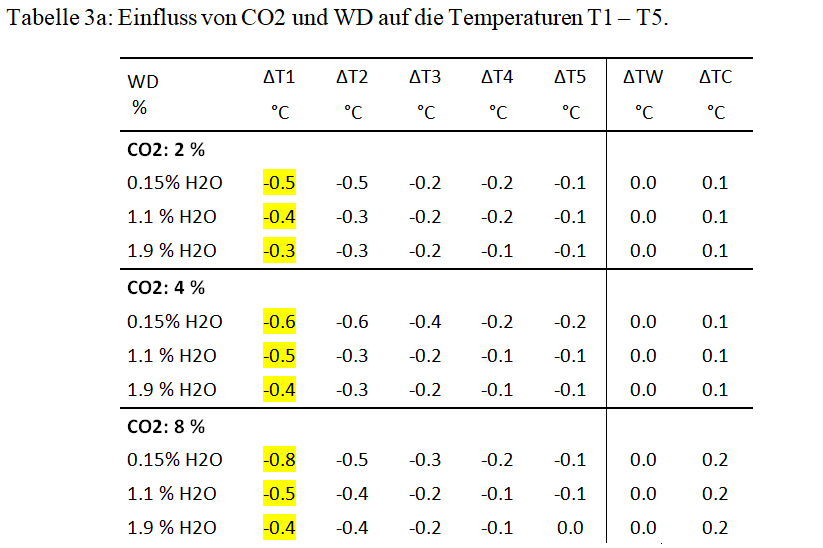

Die stärkste Abkühlung findet sich in der Position T1 und schwächt sich in Richtung Dom allmählich ab. Dieser Temperaturgradient stimmt mit dem Strahlungstransfer gemäß der Schwarzschild-Gleichung und dem Schichtenmodell überein (Schwarzschild 1906 [5], Harde 2013 [4]). Die nur 5 cm von der PE-Folie entfernte T1-Gasschicht kann ihre Infrarotstrahlung nahezu ungehindert an die PC-Platte abgeben und kühlt sich dabei am stärksten ab. Alle weiter entfernten Schichten müssen die Energie durch Absorption und Re-Emission transportieren, wodurch eine Dämpfung mit zunehmendem Abstand zur PE-Folie entsteht. Dieser Effekt ist besonders gut beim Lachgas und Freon zu sehen, da diese Gase alle 5-Messstellen T1 – T5 beeinflussen (Kap. 4.1 u. 4.4).

Die Intensität der IR-Strahlung, die bei der PC-Platte ankommt, wird durch die Temperatur- bzw. Spannungs-Anstiege der TD- bzw. VP-Sensoren ermittelt und in Leistungen W/m2 umgerechnet [3].

Dabei ist I0 die Hintergrundstrahlung des Versuchsaufbaus vor und IG die gesamte Strahlungsintensität nach Zugabe eines TH-Gases. Durch die Differenzmessung mit und ohne TH-Gase lässt sich so der Strahlungsanteil des Gases ΔIGas ermitteln.

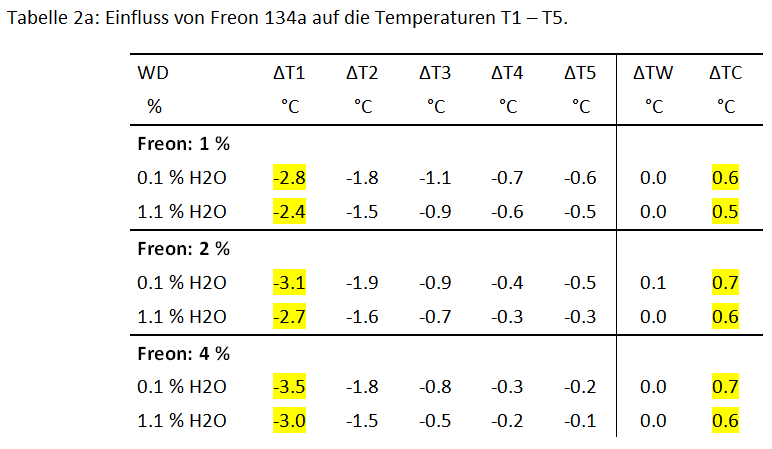

Zur Kontrolle werden auch die Veränderungen der Heiz- und Kühl-Temperaturen als ΔTW bzw. ΔTC angegeben. Diese Werte sollten annähend Null sein, um zu zeigen, dass die Emissionen und Zylinder-Temperaturen nicht durch äußere Faktoren verursacht werden. Für die TH-Gase CO₂ und Methan trifft das vollumfänglich zu. Bei den sehr wirksamen TH-Gasen Lachgas und insbesondere Freon 134a ist dagegen nur die Heizung ΔTW annähernd Null. Die Kühltemperatur ΔTC weist jedoch einen deutlichen Anstieg von bis zu 0,7 °C auf, der durch die starke Zunahme der Gasstrahlung verursacht wird.

4.1. Die Freon 134a-Strahlung

Tetrafluorethan (CFH2CF3), das auch bekannt ist als HFC-134a oder als Freon 134a, wurde über viele Jahre als chlorfreies (es ist kein FCKW), effizientes Kühlmittel eingesetzt. Es soll entsprechend einer EU-Verordnung bis zum Jahr 2030 schrittweise reduziert werden, da von einem hohen Treibhauspotenzial ausgegangen wird.

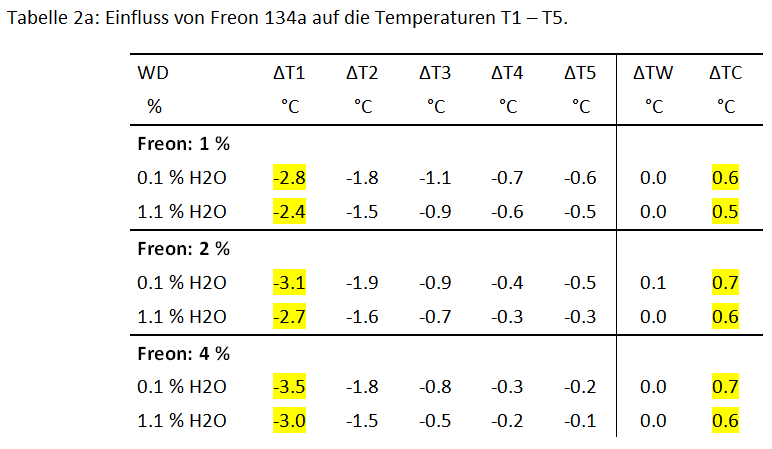

Aufgrund seiner starken Wirkung als Treibhausgas eignet sich Freon 134a hervorragend zur Demonstration der Gasstrahlung. So führt bereits eine Konzentration von nur 1 Vol.-% zu einer Steigerung der IR-Emission um beeindruckende 36 W/m2 und zu einem Temperaturrückgang der Zylinderluft von bis zu 2,8 °C (siehe Abb. 4 und Tab. 2).

Angesichts dieser eindeutigen Datenlage ist die These, dass Treibhausgase bei Normaldruck nur Absorber sind und keine Infrarotstrahlung emittieren bzw. keine Gegenstrahlung erzeugen, klar widerlegt.

Trotz seines starken Effektes ist die Wirksamkeit von Freon 134a auch von der WD-Konzentration abhängig. Bei einer WD-Konzentration von 1,1 Vol.-% beträgt die Strahlungsintensität nur noch etwa 88 % des Wertes im Vergleich zu getrockneter Luft (Tab. 2b).

Da Freon 134a nicht als „Line-by-Line“-Datensatz in der HITRAN-Datenbank gelistet ist, ist eine Überprüfung durch Strahlungstransfer-Rechnungen an dieser Stelle nicht möglich.

4.2. Die CO₂-Strahlung

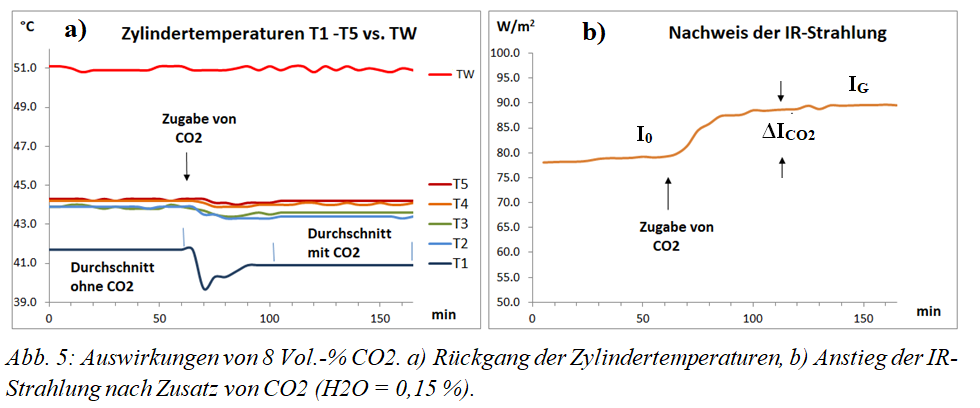

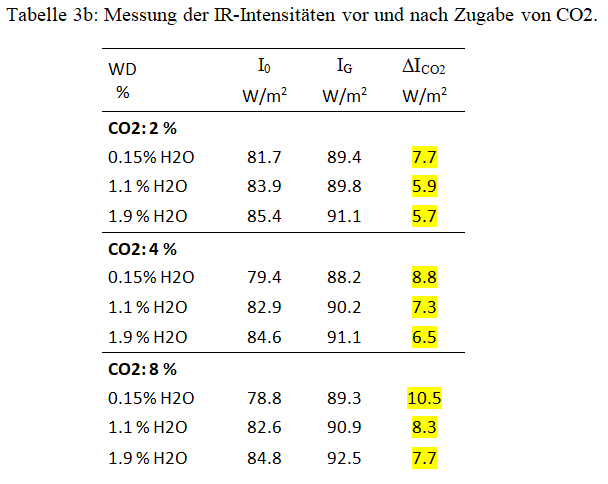

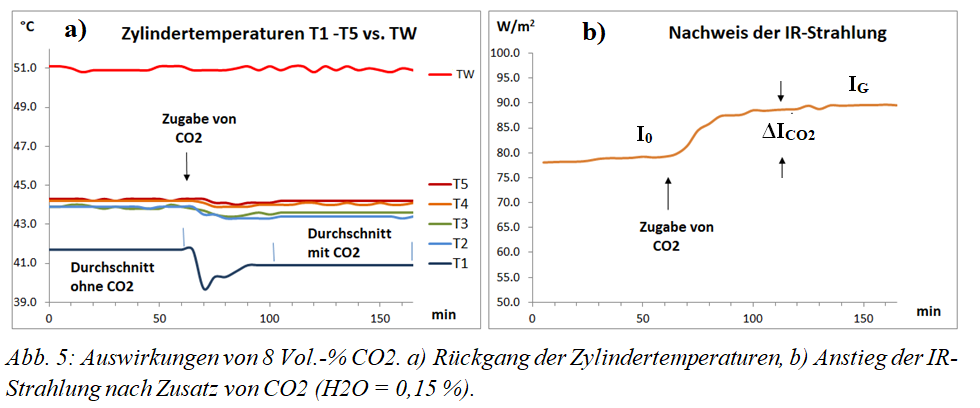

Die CO₂-Wirksamkeit ist viel schwächer als die von Freon. Deshalb werden hier, wie auch bei den folgenden TH-Gasen, höhere Konzentrationen von 2, 4 und 8 Vol.-% eingesetzt. Bei diesen Konzentrationen führt die Zugabe von CO₂ zu einer deutlichen Abkühlung der T1- und T2-Temperaturen bei gleichzeitigem Anstieg der IR-Strahlungsintensität ΔICO₂ (Abb. 5).

Bitte beachten: Aufgrund der deutlich geringeren Wirkung im Vergleich zu Freon 134a werden die Diagramme für CO₂, Methan und Lachgas jeweils bei 8 Vol.-% dargestellt.

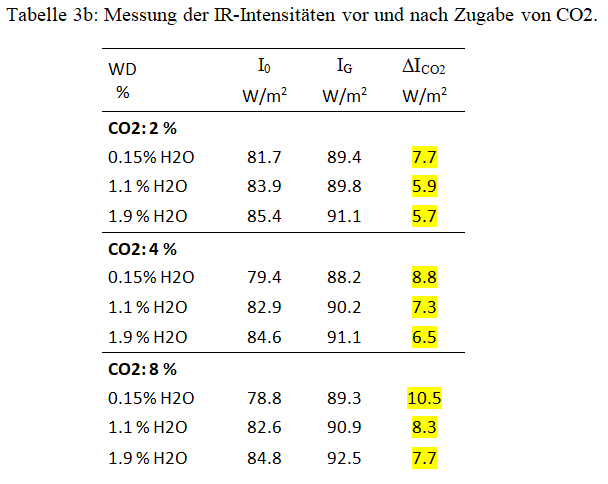

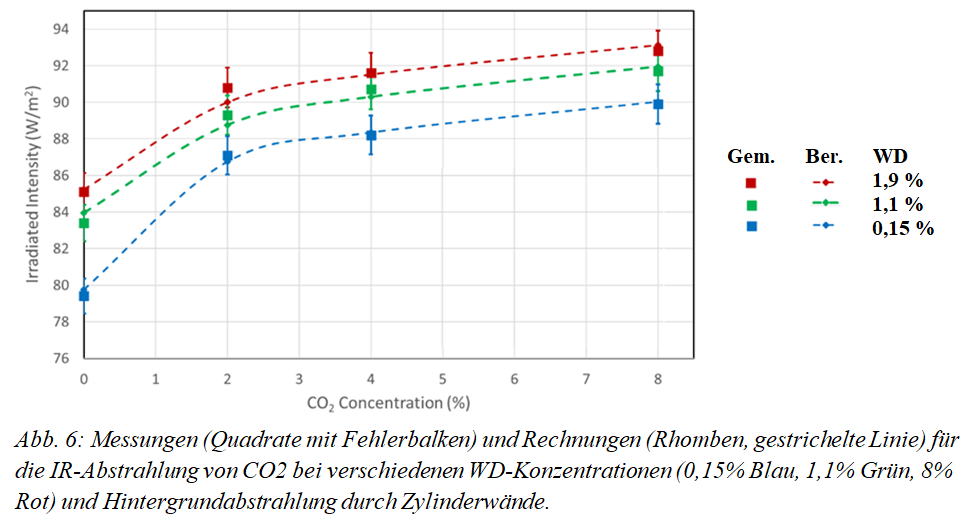

Im Falle von CO₂ wird der Einfluss von Wasserdampf bei drei Konzentrationen (0,15 %, 1,1 % und 1,9 Vol.-%) überprüft (Tab. 3a und 3b). Mit zunehmender WD-Konzentration zeigt sich, dass die Hintergrundstrahlung weiter zunimmt und dies zu einer Abschwächung des CO₂-Strahlungsanteils führt. Diese Abschwächung ist besonders bei niedrigeren Konzentrationen von WD und CO₂ erkennbar, wie die unterschiedlichen Steigungen nach Zugabe von CO₂ zeigen. So ergibt eine H2O-Konzentration von 0,15 % einen Anstieg um 7,7 W/m2, für 1,9 % WD dagegen nur 5,7 W/m2 (siehe Tabelle 3b, letzte Spalte). Dies sind nur 74 % der ursprünglichen Intensität. Die Abschwächung ist auf eine Anhebung des Hintergrunds und damit eine erhöhte Sättigung der CO₂ Flanken zurückzuführen.

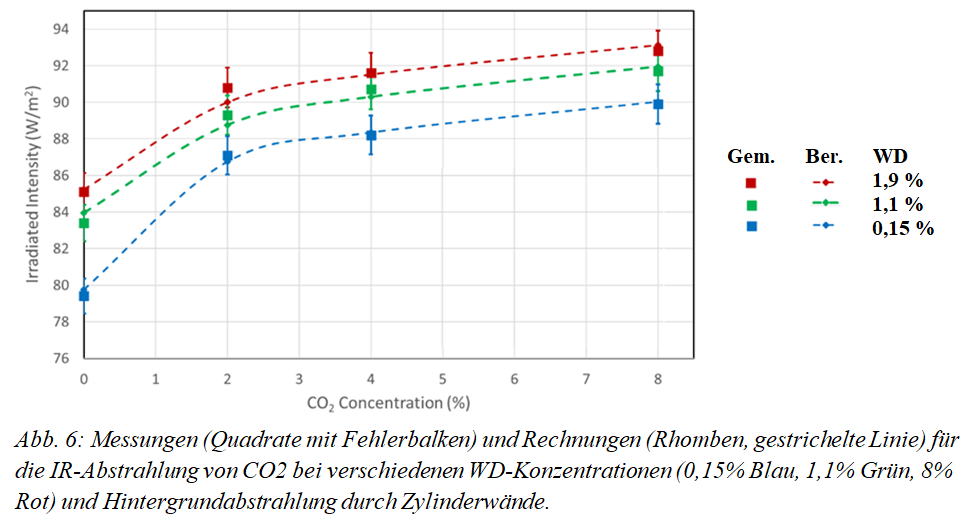

Zur Überprüfung werden die ermittelten Daten zur Gesamtintensität IG durch Strahlungstransfer-Rechnungen für CO₂ und H₂O gegenübergestellt (Abb. 6, Gem. = Gemessen, Ber. = Berechnet). Details zu diesen Rechnungen, die auch für Methan und Lachgas vorliegen, finden sich in [3].

Zur Überprüfung werden die ermittelten Daten zur Gesamtintensität IG durch Strahlungstransfer-Rechnungen für CO₂ und H₂O gegenübergestellt (Abb. 6, Gem. = Gemessen, Ber. = Berechnet). Details zu diesen Rechnungen, die auch für Methan und Lachgas vorliegen, finden sich in [3].

Über die langen Ausbreitungswege in der Atmosphäre und die 30 – 40-fach höhere WD-Konzentration im Vergleich zum CO₂ führt die schwache Überlappung der Spektren um 670 cm-1 (Teil 1, Abb. 2) dennoch zu einer deutlichen Begrenzung der CO₂-Klimasensitivität und auch einer reduzierten Wasserdampf-Rückkopplung (Harde 2014 [6], Harde 2017 [7]).

Auffällig ist der unterschiedliche Anstieg der CO₂-Strahlungsintensität bei Konzentrationen unter bzw. über 2 %, der von einem annähernd linearen zu einem logarithmischen Verlauf übergeht und die deutliche Sättigung der Absorptions- wie Emissionsprozesse auf der Hauptbande um 670 cm-1 widerspiegelt. Für Konzentrationen über 2 % wird die weitere Intensitätszunahme vornehmlich durch die ungesättigten Flanken und schwächeren Banden bestimmt.

Dieses Phänomen eines „Knicks“ im Anstieg der Strahlungsintensität ist bei allen Treibhausgasen zu beobachten. Dieser Wechsel in der Sensitivität ist der Grund dafür, dass das sogenannte „Treibhauspotenzial“, der Vergleich eines Treibhausgases sehr kleiner Konzentration mit CO₂, ein Apfel-Birnen-Vergleich ist (siehe Methan).

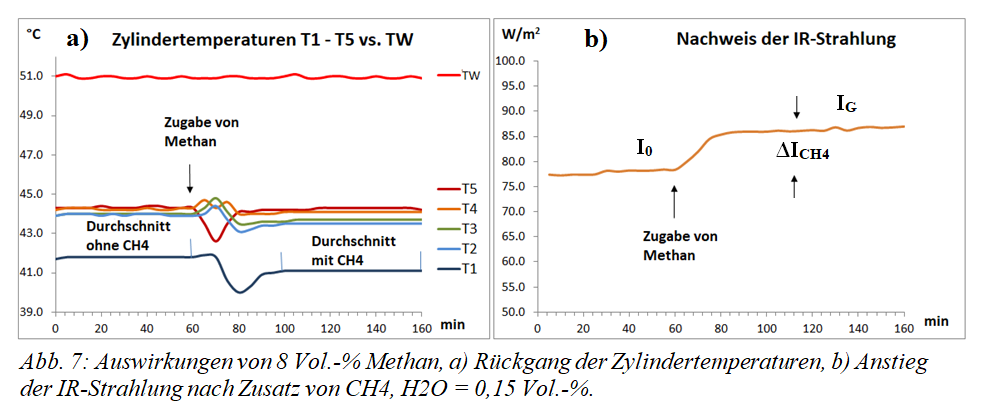

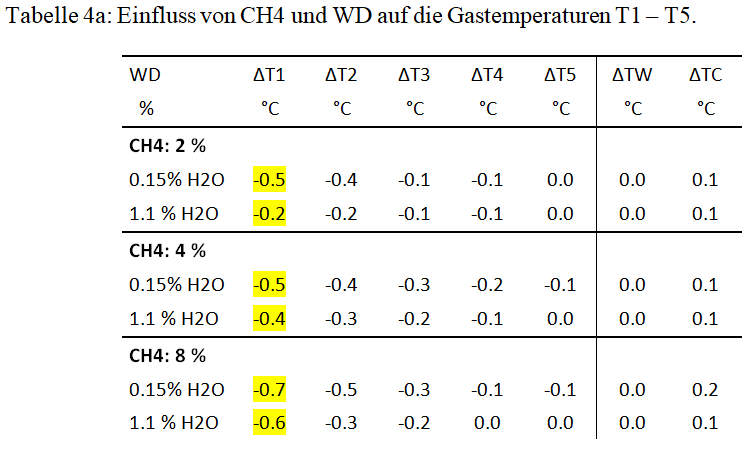

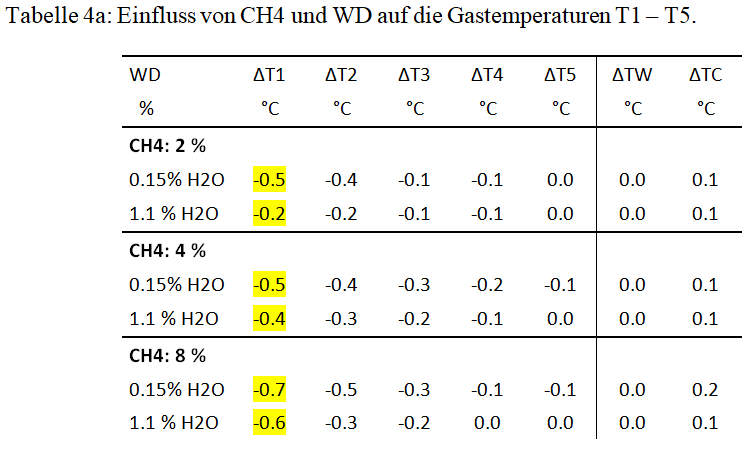

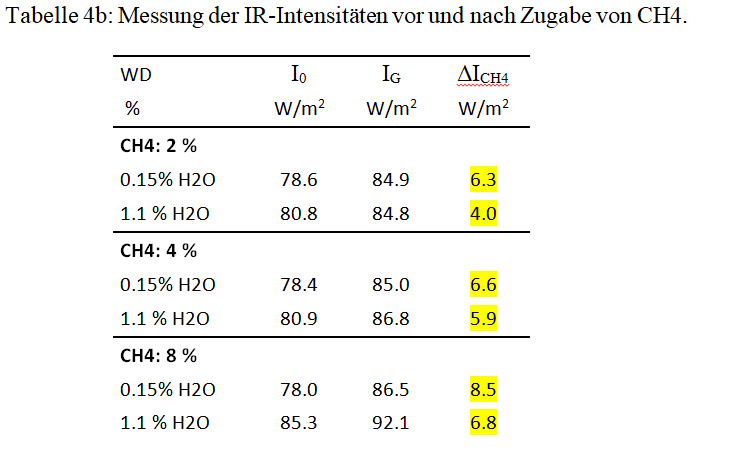

4.3. Die Methan-Strahlung

Methan gilt als besonders gefährliches Treibhausgas, da es je nach Zeitachse ein 25- bis 84-mal höheres Treibhauspotential haben soll als CO₂. Diese Einstufung ergibt sich paradoxerweise aus seiner geringen atmosphärischen Konzentration von ca. 2 ppm. In diesem Bereich ist die optische Dichte im Vergleich zu CO₂ noch sehr gering, sodass ein lineares Steigerungspotenzial vorliegt. CO₂ hingegen befindet sich mit seinen 420 ppm bereits im logarithmischen Bereich (siehe Kap. 4.2.). Die völlig unterschiedlichen spektralen Überlagerungen mit Wasserdampf sind ein weiterer Grund für den Vorwurf des „Apfel-Birnen-Vergleichs“ (siehe Teil 1, Abb. 2).

Treibhauspotential wird fälschlicherweise oft mit Wirksamkeit verwechselt. Tatsächlich ist Methan, auf der Basis gleicher Konzentrationen, ein schwächeres Treibhausgas als CO₂ (Tab. 4b vs. Tab 3b). Die theoretischen Berechnungen (Teil 1, Kap. 2) haben bereits gezeigt, dass die IR-Strahlung von Methan im Vergleich zu CO₂ geringer ist. Dies bestätigt sich nun auch in den Experimenten.

Methan wird in der Atmosphäre unter dem Einfluss von Ozon und UV-Licht zu CO₂ oxidiert und hat deshalb eine relativ kurze Verweilzeit von ca. 9 -12 Jahren.

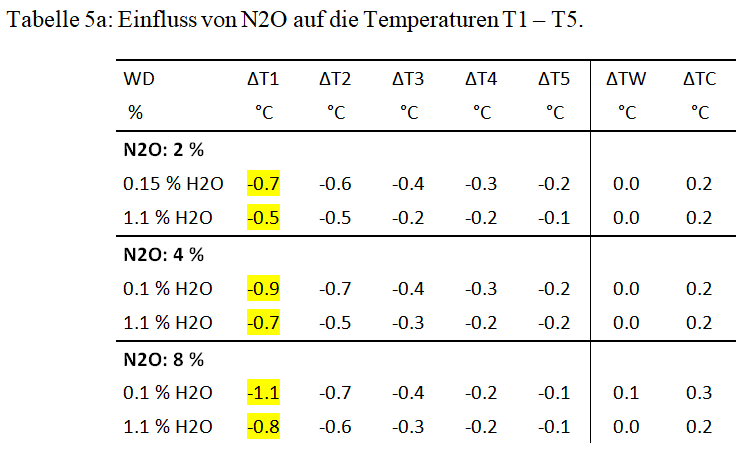

Wie schon beim CO₂ ist auch die Methan-Strahlung von der Wasserdampf-Konzentration abhängig. Die größte Methanwirkung wird bei einer H2O-Konzentration von 0,15 Vol.-% erreicht und beträgt bei 1,1 % Wasserdampf nur noch 78 % der ursprünglichen Wirkung (Tabelle 5b).

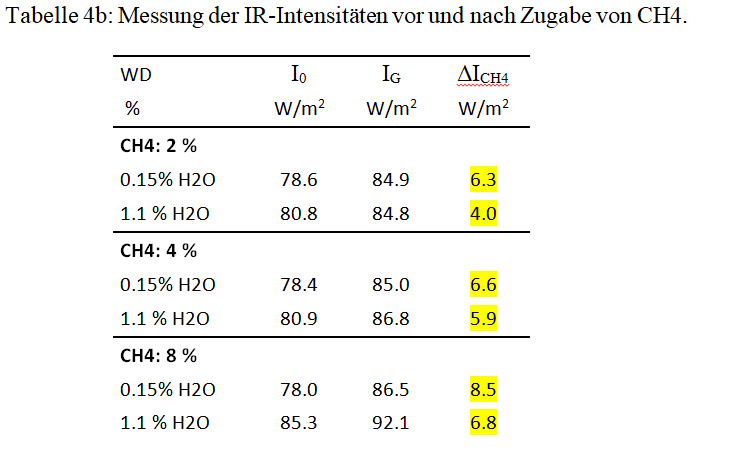

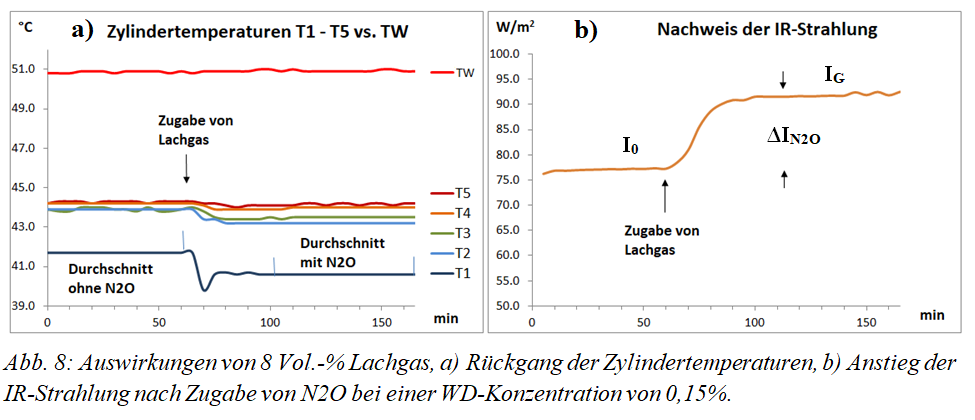

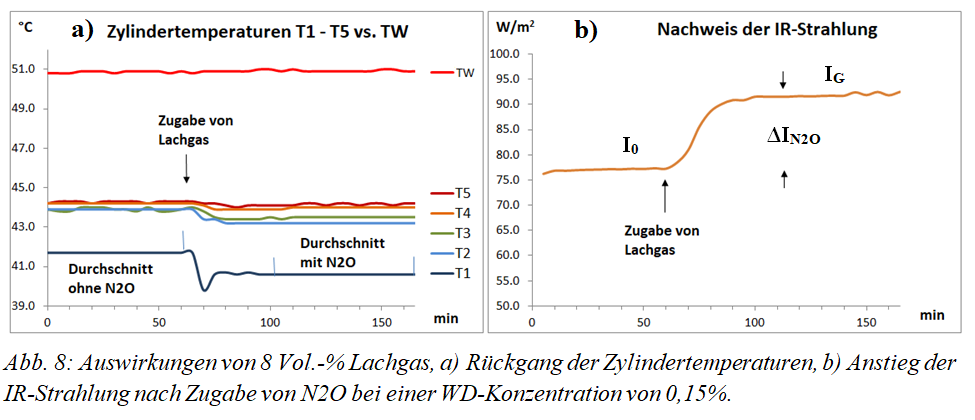

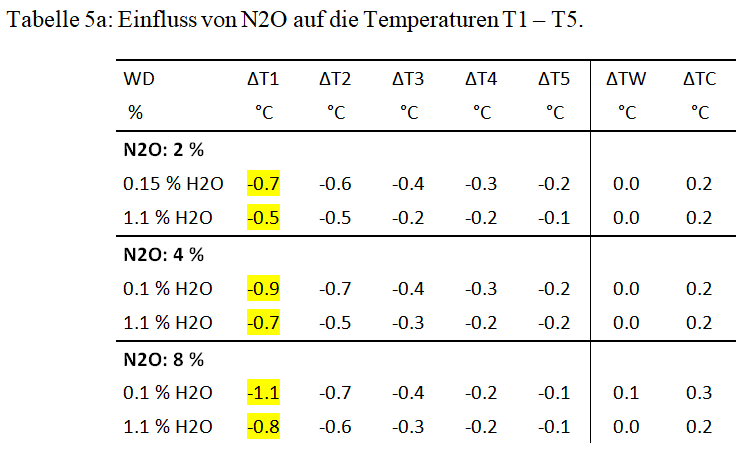

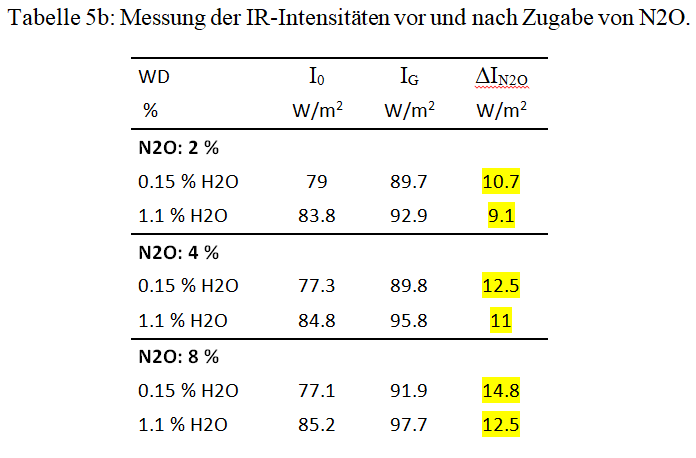

4.4. Die Lachgas-Strahlung

Distickstoffmonoxid (N2O, Lachgas) soll als drittwichtigstes langlebiges Treibhausgas erheblich zur globalen Erwärmung beitragen, was an seiner langen atmosphärischen Verweilzeit und seinem rund 300-mal höherem Treibhauspotential, bezogen auf CO₂, liegen soll. Im Strahlungs-Experiment ist die Wirkung von N2O erkennbar höher als die von CO₂, allerdings nur um den Faktor 1,5 bei gleicher Konzentration (Tab. 5b vs. Tab. 3b). Auch bei den theoretischen Rechnungen ist die IR-Strahlung von Lachgas nur unwesentlich höher als beim CO₂ (Teil 1, Kap. 2).

Mit 0,3 ppm ist die Konzentration von N2O in der Atmosphäre 1400-mal geringer als die von CO₂, was Fragen zu seiner Wirksamkeit aufwirft.

Wie schon bei CO₂ und CH4 ist auch die Lachgas-Strahlung von der Wasserdampf-Konzentration abhängig. Die größte Wirkung wird wieder bei einer H2O-Konzentration von 0,15 Vol.-% erreicht und reduziert sich auf 86 % der ursprünglichen Wirkung bei 1,1 % Wasserdampf (Tab. 5b).

5. Zusammenfassung

Die Untersuchung wurde durchgeführt, um einerseits die Emissionseigenschaften der Treibhausgase unter Bedingungen wie in der unteren Atmosphäre zu zeigen und andererseits die Existenz des negativen Treibhauseffekts im Modellmaßstab nachzuweisen.

Zu diesem Zweck wurde eine Apparatur entwickelt, die aus zwei Kammern besteht und senkrecht steht. Der obere Teil dieser Apparatur ist ein beheizbarer Gaszylinder, der untere Teil ein wärmeisolierter Zylinder mit einer gekühlten Platte, in der sich Detektoren für Wärmestrahlung befinden.

Bei Zugabe von Freon 134a, CO₂, Methan oder Lachgas zur oberen Kammer wird je nach Art und Konzentration eine Verringerung der Lufttemperaturen bei gleichzeitiger Zunahme der IR-Strahlung beobachtet. Das heißt, diese TH-Gase können durch inelastische Stöße mit anderen Luftmolekülen die kinetische Energie ihrer Umgebung aufnehmen und diese durch nachfolgende Emission in Wärmestrahlung umwandeln.

Eine Abkühlung der Luft bei gleichzeitiger Zunahme der Wärmestrahlung wird als „negativer Treibhauseffekt” bezeichnet, da es normalerweise genau umgekehrt ist. Solche Umkehrungen sind auch bei Inversionswetterlagen, bei der nächtlichen Abkühlung der bodennahen Luft oder bei den Luftströmungen zu den winterlichen Erdpolen Teil des Klimasystems der Erde.

Die These, dass ein Treibhauseffekt grundsätzlich nicht möglich sei, da Kollisionsprozesse angeblich zu einer strahlungslosen Deaktivierung führen und somit keine Rückstrahlung entstehen könne, wird durch diese Experimente widerlegt. Im Falle einer Thermalisierung müssten die Auswirkungen von TH-Gasen genau andersherum sein, denn dann müsste sich die Luft unter Abschwächung der IR-Emission erwärmen, was nicht beobachtet wurde.

Obwohl sich die Wasserdampfkonzentration aufgrund ihrer Kondensationsneigung nur begrenzt erhöhen lässt, konnte in Gegenwart von Wasserdampf eine deutliche Dämpfung des Effekts der oben genannten TH-Gase festgestellt werden.

Die oft fälschlicherweise angeführte These, die Gasstrahlung verletze den zweiten Hauptsatz der Thermodynamik, greift bei diesen Untersuchungen nicht, da hier nur der Wärmestrom von warm nach kalt betrachtet wird. Damit entfällt ein grundlegendes Argument der Skeptiker.

Eine Plausibilitätsüberprüfung mittels Strahlungstransfer-Rechnungen ergibt eine gute Übereinstimmung mit den gemessenen Daten, wenn unvermeidliche Verluste berücksichtigt werden.

Der Nachweis der Gasstrahlung ist alles andere als einfach, da die Hintergrundstrahlung der oberen Kammer die Strahlung der TH-Gase überdeckt, so dass nur ein Bruchteil ihrer Strahlung sichtbar wird. Um diese abgeschwächten Effekte nachweisen zu können, ist eine ausgefeilte Technik erforderlich. Neben verspiegelten Oberflächen ist ein senkrechter Versuchsaufbau, der Konvektion verhindert, Mindestanforderung.

Referenzen

-

H. Harde, M. Schnell, 2021: Verification of the Greenhouse Effect in the Laboratory, Science of Climate Change, Vol. 2.1, 1-33. https://doi.org/10.53234/scc202203/10

-

M. Schnell, H. Harde, 2025: The Negative Greenhouse Effect Part I: Experimental Studies with a Common Laboratory Set-Up, Science of Climate Change, Vol. 5.3., pp. 1-9, https://doi.org/10.53234/scc202510/02.

-

H. Harde, M. Schnell 2025: The Negative Greenhouse Effect Part II: Studies of Infrared Gas Emission with an Advanced Experimental Set-Up, Science of Climate Change, Vol. 5.3., pp. 10-34, https://doi.org/10.53234/scc202510/03.

-

H. Harde, 2013: Radiation and Heat Transfer in the Atmosphere: A Comprehensive Approach on a Molecular Basis, International Journal of Atmospheric Sciences (Open Access), vol. 2013, http://dx.doi.org/10.1155/2013/503727

-

K. Schwarzschild, 1906: Über das Gleichgewicht der Sonnenatmosphäre. In: Nachrichten von der Königlichen Gesellschaft der Wissenschaften zu Göttingen, Mathematisch-Physikalische Klasse, 1906, Heft 1, pp. 41–53 (13. Januar 1906).

-

H. Harde, Advanced Two-Layer Climate Model for the Assessment of Global Warming by CO₂, OPEN JOURNAL OF ATMOSPHERIC AND CLIMATE CHANGE, Volume 1, Number 3, November 2014, DOI: 10.15764/ACC.2014.03001,

-

H. Harde, 2017: Radiation Transfer Calculations and Assessment of Global Warming by CO₂, International Journal of Atmospheric Sciences, Volume 2017, Article ID 9251034, pp. 1-30, https://doi.org/10.1155/2017/9251034