Die neue französische Regierung unter Gabriel Attal macht ernst mit der Energie-Souveränität

Edgar L. Gärtner

Wie erwartet, hat die unbeliebte französische Premierministerin Elisabeth Borne am Abend des 8. Januar 2024 Staatspräsident Emmanuel Macron ihren Rücktritt angeboten und Macron hat diesen sofort angenommen. Nachfolger von Madame Borne wurde der erst 34 Jahre alte bisherige Erziehungsminister und Regierungssprecher Gabriel Attal. Dieser gilt als Klon Macrons, weil er wie dieser die Weihen als „Young Global Leader“ des World Economic Forums (WEF) in Davos empfangen hat. Er saß dort im Jahre 2020 zusammen mit der heutigen deutschen Außenministerien Annalena Baerbock, der zeitweiligen finnischen Ministerpräsidentin Sanna Marin und mit Alicia Garza, einer Mitbegründerin der rassistischen Black-Lives-Matter-Bewegung (BLM) in den USA in einer Lehrgangs-Klasse zusammen. Das heißt: Attal ist der direkte Repräsentant jener „Erleuchteten“, die uns ab 2030 den Fleischkonsum, Urlaubsreisen und den Privatbesitz von Pkws verbieten wollen.

Dennoch enthält die am 12. Januar von Attal vorgestellte neue Regierung einige Überraschungen, die von der grün-linken Politi-Szene als „Rechtsruck“ interpretiert werden. Für die Energie- und Klimapolitik ist nun nicht mehr das Umwelt- bzw. Energiewende-Ministerium zuständig, sondern das mächtige Wirtschafts- und Finanzministerium unter dem erfahrenen Super-Minister Bruno La Maire. Dieser gilt schon länger als überzeugter Anhänger der Kernenergie, musste aber aus wahltaktischen Gründen bislang hinter Grünen und Sozialisten zurückstehen. Bislang residierte die deutsche „Erneuerbaren“-Lobby in Gestalt des Office Franco-Allemand de la Transition Ecologique (OFATE) direkt in dem zuletzt von Agnès Pannier-Runacher geleiteten Energiewende-Ministerium. Der neuen deutlich verkleinerten Regierung gehört Pannier-Runancher nicht mehr an.

Staatspräsident Emmanuel Macron, der 2017 nicht zuletzt mithilfe massiver Unterstützung durch die deutsche Bundeskanzlerin Angela Merkel und deren Berliner Gefolgsleute an die Macht gekommen war, hatte in de letzten Jahren versucht, den Konflikt zwischen den „Erneuerbaren“ und der Kernenergie zu entschärfen, indem er dafür sorgte, dass beide Alternativen vom Staat gleichermaßen finanziell gefördert wurden, obwohl das sinnlos ist. Denn Windräder und Photovoltaikanlagen erweisen sich selbst nach dem herrschenden grünen Weltbild durchaus nicht als „klimafreundlicher“ als Kernkraftwerke.

Im Unterschied zur Berliner „Ampel“ sind den Angehörigen der Herrschaftskaste in Frankreich selbstmörderische Aufopferungs-Fantasien für das „Weltklima“ eher fremd. Viele von ihnen träumen noch immer von einer Rückkehr zu Frankreichs einstiger weltpolitischer Bedeutung. Sie sehen deshalb in der Schwächung der deutschen Wirtschaft durch die zügellose Verarmungs- und Gängelungspolitik der Berliner „Ampel“ die Chance, diesem Ziel näher zu kommen. Schon im Februar 2022 hat Emmanuel Macron in einer viel beachteten Rede in der ostfranzösischen Industriestadt Belfort den neuerlichen Ausbau der Kernenergie angekündigt. Damals kündigte er den Bau von sechs neuen Groß-Kernkraftwerken des Tys EPR sowie eine Option von acht weiteren an. Auch modular aufgebaute kleinen Kernkraftwerken (SMR) sollten eine Chance bekommen. Lange ließ Macron dieser Ankündigung keine Taten folgen. Noch immer galt das unter Macrons Amtsvorgänger François Hollande mit den Grünen und Linken vereinbarte Ziel, den Anteil der Kernenergie am nationalen französischen Strommix von über 70 schrittweise auf 50 Prozent zurückzufahren. Das ist nun vorbei. In dem bald zur parlamentarischen Beratung anstehenden Gesetzentwurf über die Energiesouveränität ist fürs erste von „erneuerbaren“ Energien keine Rede mehr, sondern nur noch von Technologieneutralität im Hinblick auf die Ansteuerung der Ziele des Pariser Klimaabkommens von 2015, zu dem sich die französische Regierung weiterhin uneingeschränkt bekennt.

Macron und seine neue Regierung haben den „Rechtsschwenk“, den ihr die Linksgrünen vorwerfen, sicher nicht ganz freiwillig vollzogen. Vielmehr mussten Macron und seine Berater davon Kenntnis nehmen, dass er mit seiner grünen und extrem EU-freundlichen Politik nicht nur in der Nationalversammlung, sondern erst recht bei der breiten Wählerschaft über keine Mehrheit verfügte. Die bisherige Premierministerin Elisabeth Borne hatte nach der für Macron und seine Partei „Renaissance“ ungünstig ausgegangenen Parlamentswahl vom Mai 2022 die undankbare Aufgabe übernommen, wichtige Reformvorhaben wie vor allem die Absenkung des Rentenalter6s mithilfe des von General de Gaulle in die Verfassung der V. Republik eingeführten Artikels 49.3 durchzupeitschen. Dieser erlaubt es der Regierung, im Falle eines parlamentarischen Patts, Gesetze ohne Zustimmung der Parlamentsmehrheit durch Notverordnungen zu erlassen. Elisabeth Borne benutzte den Art. 49.3 der Französischen Konstitution in ihrer kurzen Amtszeit von einem Jahr, sieben Monaten und einigen Tagen ganze 23 mal! Das führte dazu, dass sie am Ende kaum noch ernstgenommen wurde.

Macron entschloss sich deshalb, das ebenso umstrittene neue Einwanderungsgesetz mit deutlich strengeren Vorgaben nicht mehr mithilfe einer Notverordnung zu erlassen, sondern einen Kompromiss mit der rechten Parlamentsmehrheit zu suchen. Dabei gingen ihm bereits einige seiner linken Minister und Anhänger von der Fahne. So musste sich Macron, um sich an der Macht halten zu können, nun zu einem „Rechtsruck“ entschließen. Neben der Entmachtung des Energiewendeministeriums und der Rückkehr zur Kernenergie zeigt vor allen die Ernennung von Rachida Dati, der ehemaligen Justizmisterin des rechten Präsidenten Nicolas Sarkozy, zur neuen Kulturministerin, wohin der Hase läuft. Die Einwanderer-Tochter Dati, deren Eltern aus Marokko und Algerien stammen und die auf einer katholischen Privatschule erzogen wurde, ist dafür bekannt, dass sie kein Blatt vor den Mund nimmt. Sie wird folglich von der linken Kulturszene als Provokation empfunden. Das gilt wohl auch für Catherine Vautrin, die neue konservative Ministerin für Arbeit und Gesundheit, die den durch den Corona-Schwindel kompromittierten Regierungssprecher und ehemaligen Gesundheitsminister Olivier Veran ablöst.

Warum hat sich Macron für die Ernennung für die Ernennung eines vor allem international noch weitgehend unerfahrenen blutjungen jungen Mannes zum Premierminister entschieden? Der tiefere Grund dafür dürfte im kommenden Wahlkampf zu finden sein. Nicht wenige Beobachter der politischen Entwicklung in Frankreich gehen davon aus, dass Präsident Macron im Spätsommer nach den Wahlen zum Europa-Parlament und dem Ende der prestigeträchtigen Olympischen Spiele von Paris, die den französischen Staat Milliarden kosten werden, die Nationalversammlung auflösen und Neuwahlen ausrufen wird. Dann wird der Jungspund Attal dem mit 28 Jahren noch jüngeren politischen Naturtalent Jordan Bardella gegenüber stehen. Der Migrantensohn mit algerischen und italienischen Wurzeln wurde als Vorsitzender der Le-Pen-Partei Rassemblement National (RN) im vergangenen Jahr zum beliebtesten Politiker Frankreichs gekürt.

Im Unterschied zu Attal, der aus dem schicken Pariser Westen stammt, kommt Bardella aus der vorwiegend von Mietskasernen des Sozialwohnungsbaus dominierten Stadt Drancy im verrufenen Département Seine-Saint-Denis im Nordosten der französischen Hauptstadt. Der durchtrainierte Aikido-Kämpfer hat mit seinem seriösen Auftreten wesentlich dazu beigetragen, die Le-Pen-Partei vom Schwefelgeruch zu befreien und ist zum Hoffnungsträger für die Benachteiligten in den Banlieues geworden. Kein Zweifel: Attal wird es sehr schwer haben in diesem Wahlkampf. Deshalb bedauern es manche, dass der durchaus talentierte junge Mann schon in so jungen Jahren verheizt wird.

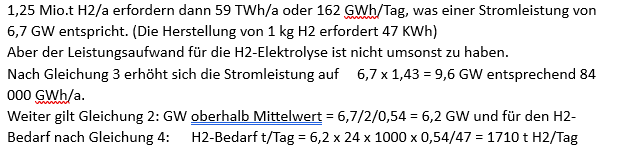

Der hier für den Gleichgewichtszustand errechnete H2-Verbrauch wird natürlich in einem durchströmten Schachtofen nicht erreicht werden können. Versuche mit der Reduktion mit reinem Wasserstoff im Schachtofen sind nicht bekannt.

Der hier für den Gleichgewichtszustand errechnete H2-Verbrauch wird natürlich in einem durchströmten Schachtofen nicht erreicht werden können. Versuche mit der Reduktion mit reinem Wasserstoff im Schachtofen sind nicht bekannt.