Die weltweiten CO2-Emissionen stagnieren, aber die CO2-Gehalte der Atmosphäre steigen unverändert weiter an

Nun stagnieren die weltweiten CO2-Emissionen, aber die CO2-Gehalte der Atmosphäre steigen unverändert weiter an – das führt die Aussagen des „Klimarates der Vereinten Nationen“ (IPCC) zur Wirkung von CO2 ad absurdum und damit auch die deutsche ideologische Energiepolitik

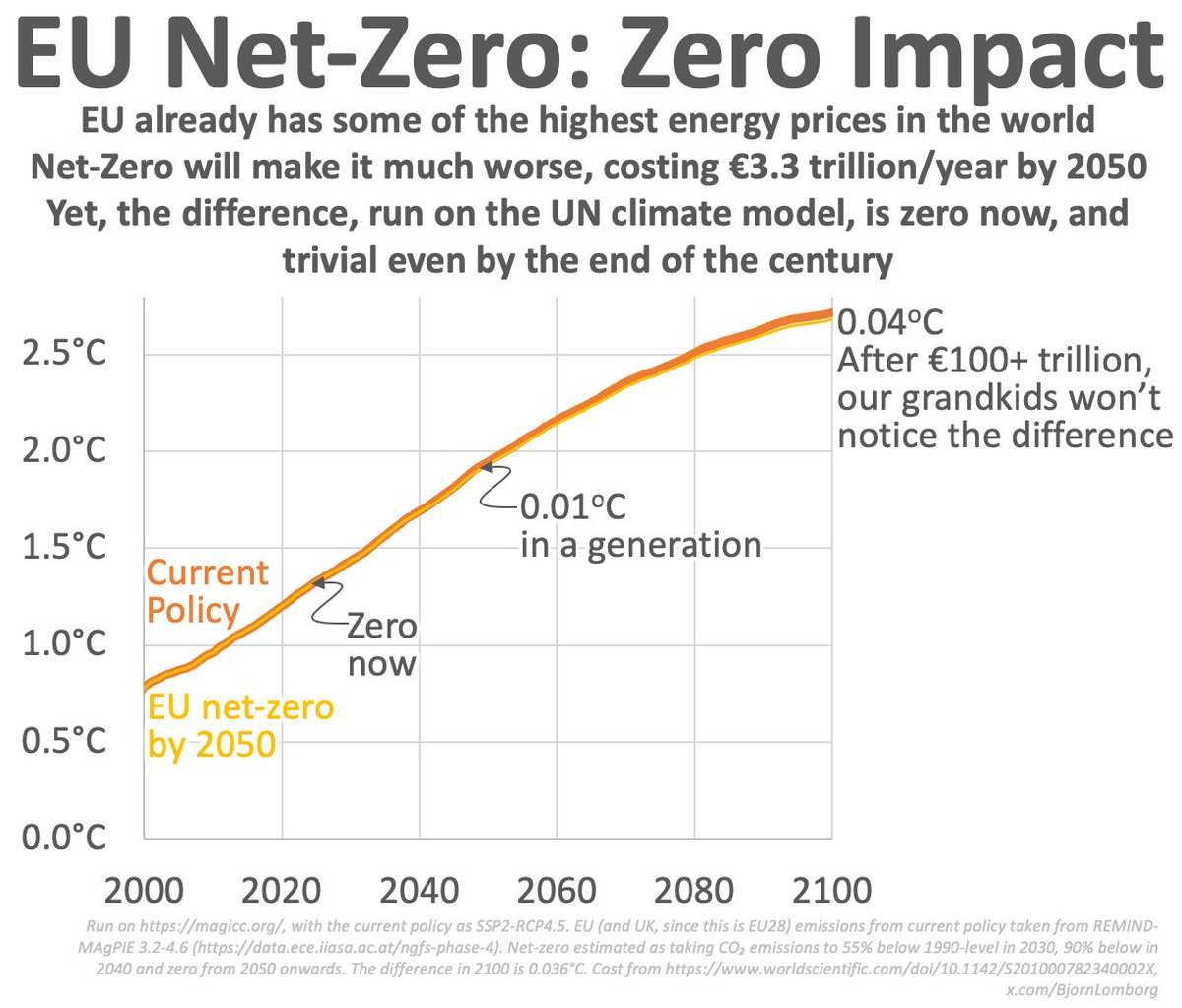

Durch die Dekarbonisierung Deutschlands wird der CO2-Gehalt der Atmosphäre um skurrile 0,000 28 ppm/a (0,000 000 028 %/a) abgebaut – die Verfolgung dieser Dekarbonisierung im „Kern durch die Bepreisung der Treibhausgase“ (Regierung) entbehrt bei diesen CO2-Spuren jeglicher Grundlage

Dr. Erhard Beppler

Fazit

Es gibt viele messbare Einflussgrößen auf die Temperatur der Erde wie z. B. der Abstand der Erde zur Sonne (Milankovic-Zyklus), die Sonnenaktivität, etc., nur der Einfluss des CO2-Gehaltes der Atmosphäre auf die Temperatur konnte nicht gemessen werden.

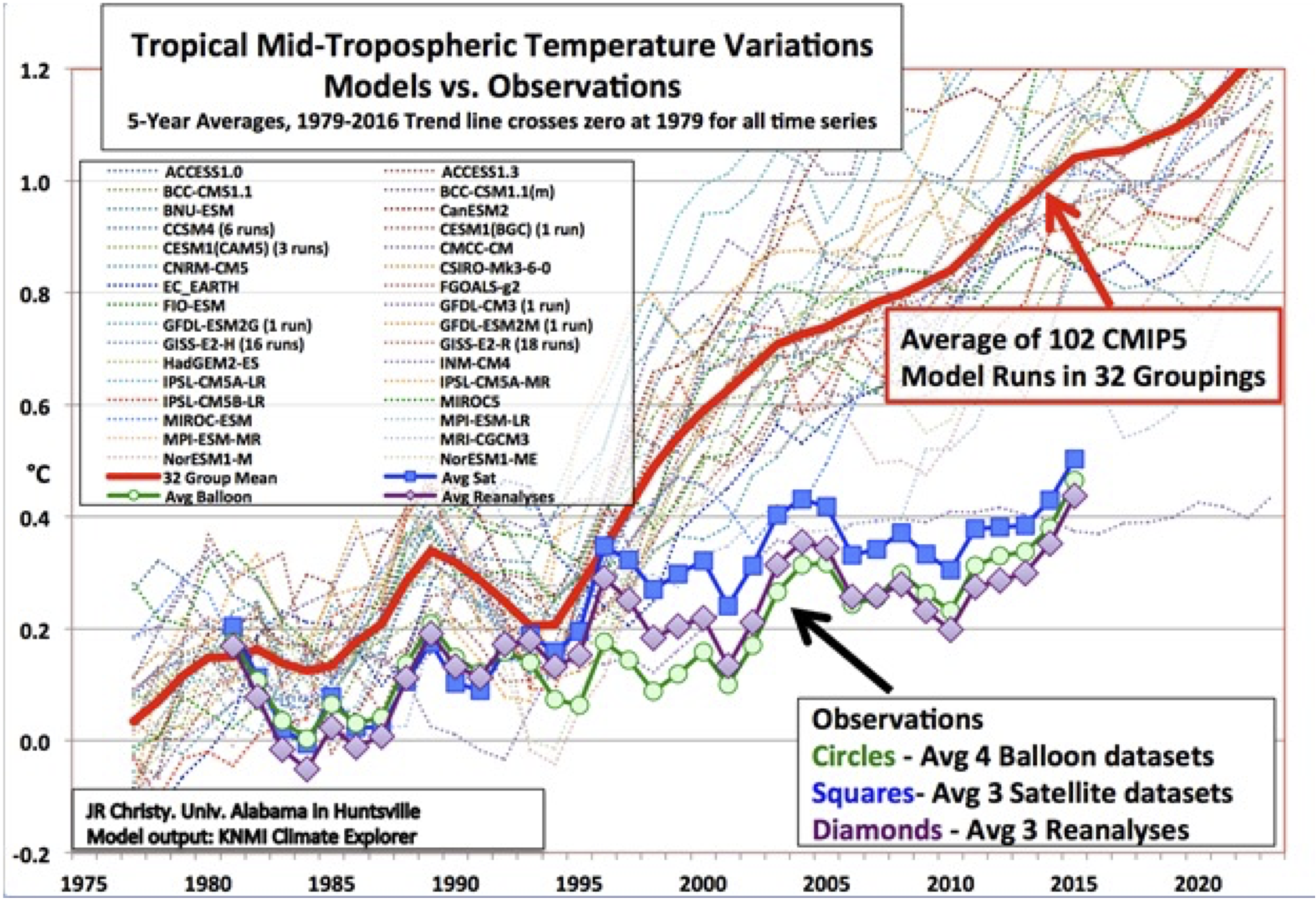

Nun werden fehlerhafte Computermodelle des IPCC herangezogen, um den Einfluss der weltweiten, von Menschen verursachten CO2-Emissionen auf die Temperatur zu beweisen.

Aber besagte Modelle weisen viele Fehler auf.

So wird stets vom Gesamt-CO2-Gehalt der Atmosphäre ausgegangen, obwohl der anthropogene CO2-Anteil nur bei 4% liegt.

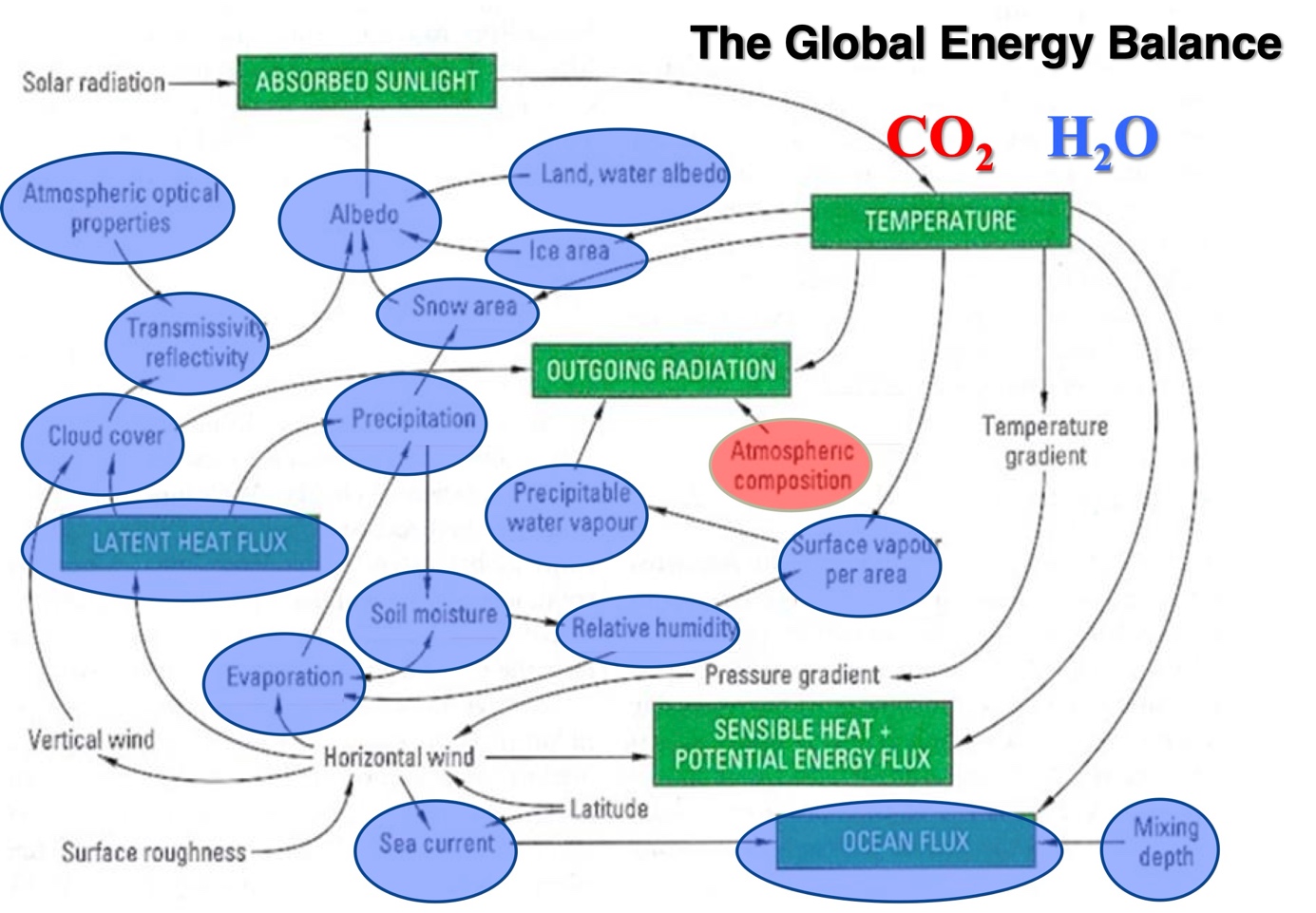

Selbst bei der atmosphärischen Rückstrahlung (Treibhauseffekt) bleibt in den Modellen unberücksichtigt, dass die Absorptionsbanden des CO2 (0,04%) im Wellenlängenbereich von 14-17 µm stark von Wasserdampf (bis 4%) überlagert werden.

Außerdem kann der Einfluss von Wasserdampf und Wolken in den Modellen nicht berücksichtigt werden.

Schließlich geht auch noch der Anstieg der weltweiten anthropogenen CO2-Emissionen bis 2024 gegen null. Nach der Vorstellung des IPCC zum ausschließlichen Einfluss des anthropogenen CO2-Anteiles der Atmosphäre auf den Anstieg der Temperatur müssten dann die Temperaturen abfallen – aber das Gegenteil ist der Fall: die Temperaturen steigen sogar vermehrt an.

Durch den Rückgang des Anstieges der weltweiten anthropogenen CO2-Emissionen von 2019-2024 auf nur noch 0,112 Giga Tonnen (Gt) CO2/a steigen die CO2-Gehalte der Atmosphäre nur noch um 0,112/7,75 = 0,014 ppm/a und nicht um 2 ppm/a nach Aussage des IPCC.

Wird nun berücksichtigt, dass Deutschland an den weltweiten CO2-Emissionen nur mit weniger als 2% beteiligt ist, errechnet sich ein skurriler deutscher Anteil am Anstieg der CO2-Gehalte der Atmosphäre von 0,014 x 0,02 = 0,000 28 ppm/a oder 0,000 000 028 %/a.

Damit wird der „Kern des Klimaschutzes, die Bepreisung der Treibhausgase“ (Regierung) obsolet.

Deutschland lebt dennoch völlig losgelöst von Fakten und will die Dekarbonisierung bis 2045 vollenden, obwohl die Stromkosten bereits die weltweit höchsten sind, die Industrien abwandern, die Insolvenzen Rekordzahlen aufweisen mit Folgen für die Steuereinnahmen und damit die sozialen Fähigkeiten unseres Sozialstaates (Reaktionen aus der Politik sind inzwischen vernehmbar).

1.Einleitung

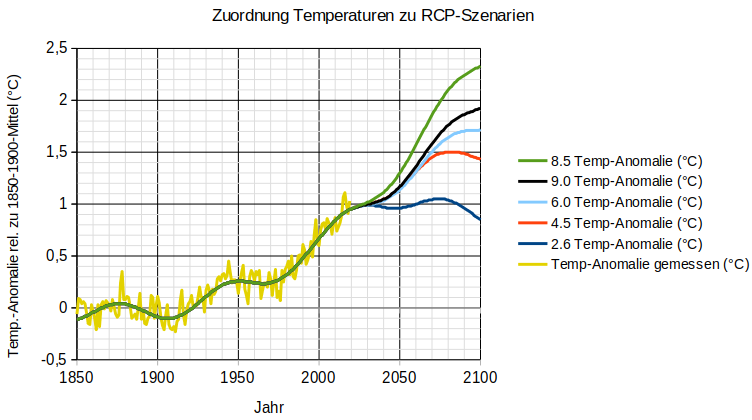

Die Klimapolitik der Welt wird seit den 1980er Jahren vom Klimarat der Vereinten Nationen“ (IPCC) bestimmt mit Aussagen zum ausschließlichen Temperaturanstieg der Atmosphäre durch die weltweiten anthropogenen CO2-Emissionen auf der Basis von Computermodellen und Hinweisen auf diverse Weltuntergangsszenarien (6. Sachzustandsbericht IPCC, März 2023).

Im Einzelnen lauten die Aussagen des IPCC wie folgt:

a) Von den jährlichen weltweiten anthropogenen CO2-Emissionen von z.Z. 10 Giga Tonnen Kohlenstoff/a (GtC/a) entsprechend 4 ppm gelangen 50% in die Atmosphäre , sichtbar an einem CO2-Anstieg der Atmosphäre von z.Z. 2 ppm/a und verbleiben dort über Jahrhunderte, und die andere Hälfte wird in gleichen Teilen (je 25%) von 10 GtC/a vom Ozean und der Biomasse aufgenommen

b) Durch den Eintrag der anthropogenen CO2-Emissionen in die Atmosphäre soll die CO2-Konzentration der Atmosphäre immer weiter ansteigen und damit über den Treibhauseffekt die Temperaturen auf der Erde bis zur Katastrophe anheben. (Anstieg CO2-Gehalte von 1850 bis heute etwa 120 ppm (0,0120%))

c) Daraus resultiert die Forderung nach einer vollständigen Dekarbonisierung (Net Zero), nur so könnte die Klimakatastrophe abgewendet werden

Gemäß Koalitionsvertrag von Union und SPD soll der Kern des Klimaschutzes aus der Bepreisung von Treibhausgasemissionen bestehen, d.h. am Ende sollen nur Wind und Sonne einschließlich Wasserstoff die Stromerzeugung sichern, koste es was es wolle.

2. Erdgeschichtliche Betrachtung der CO2-Gehalte der Atmosphäre sowie der Temperatur und Einflussgrößen auf die Temperatur

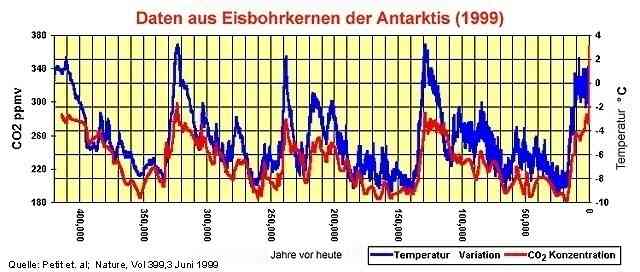

Durch die Veränderung der Umlaufbahn der Erde um die Sonne von kreisförmig zu elliptisch im Zeitraum von etwa 100 000 Jahren wurden die Temperaturen auf der Erde gewaltig verändert (Milankovic-Zyklus), wie Messungen an Eisbohrkernen gezeigt haben. (Bild 1)

Bild 1: Verlauf der CO2-Gehalte wie der Temperaturen nach Messungen an Eisbohrkernen

In den Eiszeiten sind CO2-Gehalte um 200 ppm, in den Warmzeiten um 280 ppm gemessen worden. Der Anstieg der CO2-Gehalte der Atmosphäre folgt zeitversetzt dem Temperaturanstieg – durch die mit steigender Temperatur abnehmende Löslichkeit von CO2 in Wasser.

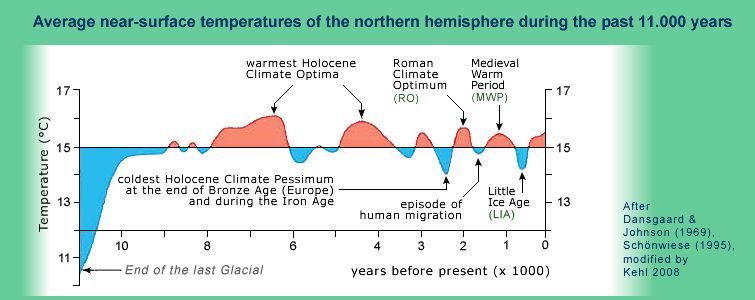

Der Temperaturverlauf nach der letzten Eiszeit ist Bild 2 zu entnehmen.

Bild 2: Warmphasen nach der letzten Eiszeit

In den wärmsten Phasen des Holozäns waren die Alpen eisfrei.

Ausgerechnet die jetzige Warmzeit wird vom IPCC als ein apokalyptisches Ereignis bezeichnet und das vom Menschen verursachte CO2 für den Temperaturanstieg verantwortlich gemacht, obwohl die Warmphasen vor der jetzigen ohne menschlich verursachtes CO2 praktisch alle wärmer waren.

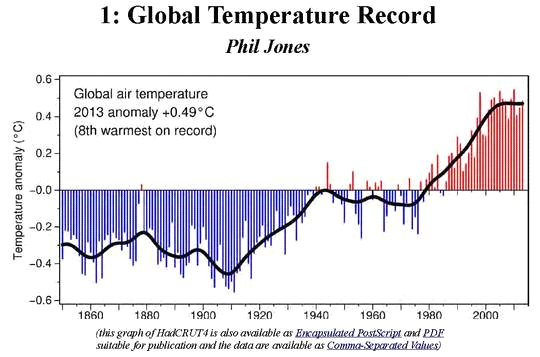

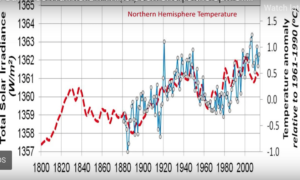

Neuere Messungen zeigen, dass in der jetzigen Warmphase nach 1940 bis etwa 1980 die Temperaturen nach einem Anstieg zunächst wieder abfallen, um dann bis heute erneut anzusteigen. (Bild 3)

Bild 3: Temperaturentwicklung nach 1850

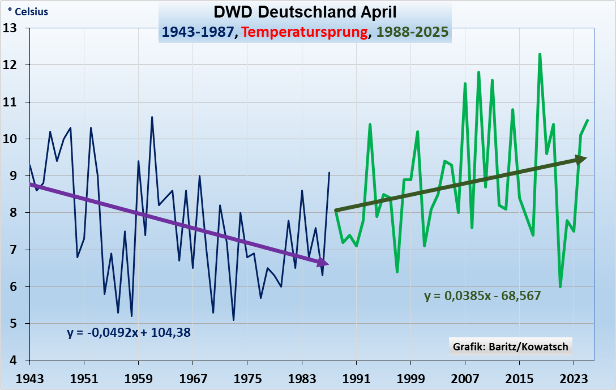

Dieser Abfall bis etwa 1980 und Wiederanstieg bis 2025 wird auch in neueren Messungen bestätigt. (Bild 4)

Bild 4: Temperaturentwicklung 1940 bis 2025

Dieser Verlauf ist im Wesentlichen auf wechselnde Aktivitäten der Sonne einschließlich der damit verknüpften kosmischen Strahlung zurückzuführen. (Bild 5) (1)

Hinzugefügt werden muss noch die zunehmende Sonnenscheindauer als Einflussgröße auf den jetzigen Temperaturanstieg, verursacht durch einen Rückgang der Aerosole als Verursacher für die Wolkenbildung.

Bild 5: Verlauf der Intensität der Sonneneinstrahlung

Hervorzuheben ist weiterhin, dass trotz steigender Temperaturen die Nachttemperaturen abfallen, vermutlich durch die Abnahme der nächtlichen Bewölkung. (2)

Es kann also festgestellt werden, dass es viele gemessene Einflussgrößen auf die Temperatur gibt, aber keine zum Einfluss des CO2-Gehaltes der Atmosphäre, geschweige denn den von anthropogenen CO2-Emissionen. (vgl. Kapitel 4)

Nicht unerwähnt darf auch der Einfluss des Vulkanismus auf die Entwicklung des CO2-Gehaltes bleiben, ebenso wie die CO2-Freisetzung der Meere bei steigenden Temperaturen, etc. (vgl. später)

Schließlich sind die Ozeanzyklen und ihr Einfluss auf die globalen Temperaturen zu nennen: El Nino Sothern Oszillation (ENSO), Pazifische Dekaden-Oszillation (PDO), Atlantische Multidekaden-Oszillation (AMO) (mit Temperaturänderungen bis zur Arktis) und die Indische-Ozan-Dipol (IOD), etc. (3)

3. Weitere kritische Betrachtungen zu der Aussagefähigkeit der Modelle des IPCC

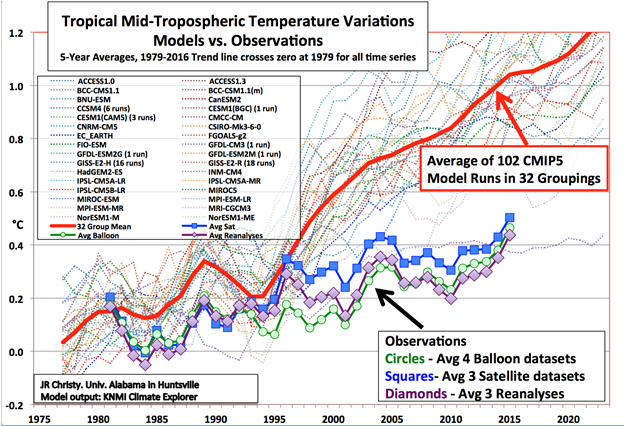

Nachdem es nun viele messbare Einflussgrößen auf die Temperatur gibt aber keinen durch den Einfluss der CO2-Konzentrationen, nun zu den Aussagefähigkeiten der IPCC-Modelle, dargestellt an einigen Beispielen.

Alle Wetter- und Klimaphänomene der Erde sollen mit Hilfe von Computermodellen gelöst werden – aber selbst einfachste Eingaben in die Modelle sind nicht nachvollziehbar. So wird ausgerechnet bei der Vorhersage der Temperatur auf der Basis von CO2-Vorgaben nicht differenziert nach anthropogenen CO2-Emissionen und natürlichen CO2-Quellen, sondern stets ausschließlich von ihrer Summe. (vgl. Kapitel 5)

Außerdem ist die Betrachtung der atmosphärischen Rückstrahlung („Treibhauseffekt“) des CO2 kritisch zu sehen. Die Absorptionsbanden des CO2 (0,04%) im Wellenlängenbereich von 14-17 µm werden stark von Wasserdampf (bis 4% H2O) überlagert. Schon alleine dadurch kann CO2 energetisch betrachtet in der Atmosphäre keine Rolle spielen.

Selbst der Einfluss des Wasserdampfes und der Wolken kann in den IPCC-Modellen nicht berücksichtigt werden.

Es verwundert nun nicht mehr, dass die mit Hilfe der IPCC-Modelle ausgewiesenen Temperaturerhöhungen bei steigenden CO2-Gehalten der Atmosphäre weder die Vergangenheit abbilden können, geschweige denn die Zukunft voraussagen. (Bild 6)

Bild 6: Aussagefähigkeit der Klimamodelle

4. Betrachtung des anthropogenen CO2-Anteiles in der Atmosphäre von 1870 bis 2020

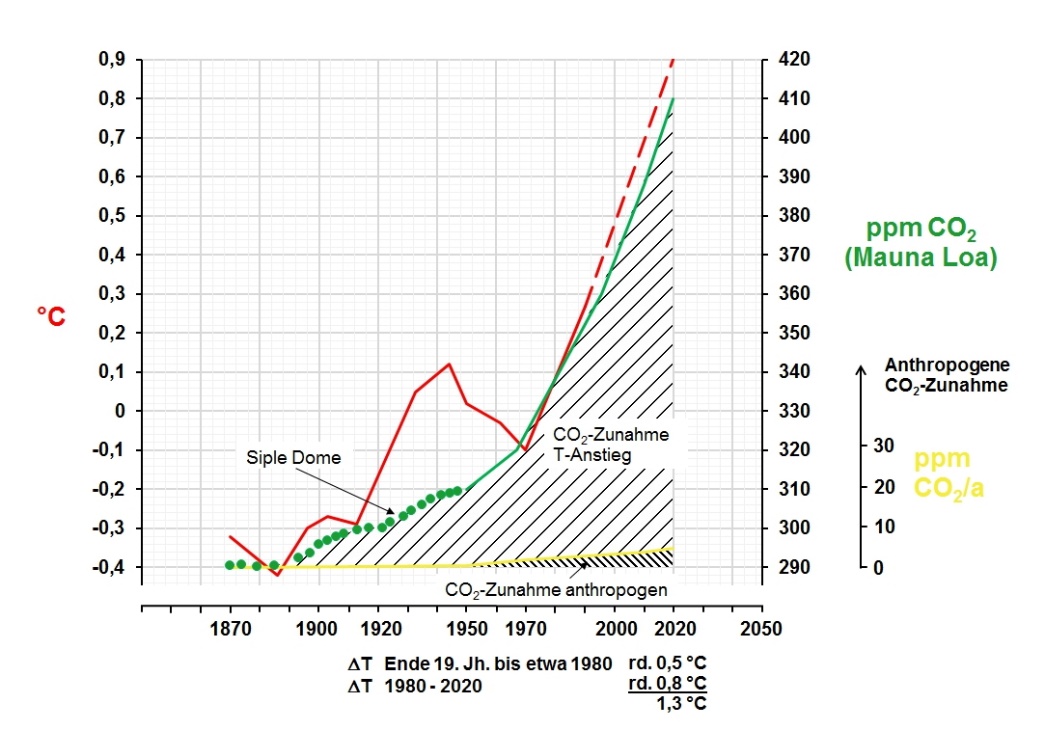

In früheren Arbeiten (4) war der CO2-Zuwachs der Atmosphäre aus dem weltweiten anthropogenen CO2-Eintrag in die Atmosphäre von 1870 bis 2020 mit den gemessenen CO2-Gehalten dargestellt worden (Bild 7), ausgehend von 870 Gt Kohlenstoff in der Atmosphäre (6. Zustandsbericht des IPCC, Fig.5.12).

Bild 7: Anstieg der gemessenen und über die anthropogenen CO2-Emissionen in die

Atmosphäre eingebrachten CO2-Gehalte

Bekanntlich steigen die CO2-Gehalte der Atmosphäre von 1870 bis 2020 um 120 ppm von 290 auf 410 ppm an.

Die in 2020 eingebrachten anthropogenen CO2-Emissionen in die Atmosphäre liegen bei 35 008 Mio. t CO2 (35 Gt CO2). (vgl. Bild 9) Daraus errechnen sich 4,7 ppm CO2 oder 0,000 47%.

Somit gilt: 410 – 290 – 4,7 = rd. 115 ppm, die auf natürliche CO2-Quellen zurückzuführen sind. (CO2-Löslichkeit Meere, Vulkane, etc.)

Damit liegt der CO2-Anstieg über natürliche Quellen bei 96%, über den anthropogenen Anteil bei 4%.

Aus Bild 7 wird weiter deutlich, dass vor 1950 der CO2-Anstieg der Atmosphäre ausschließlich über den CO2-Eintrag über natürliche Quellen erfolgte. Ein merklicher Anstieg über anthropogenen CO2-Emissionen erfolgt erst nach 1950 bis auf 4,7 ppm in 2020 – oder durchschnittlich 4,7 ppm/70 Jahre = 0,07 ppm/a und nicht 2 ppm/a nach Aussage des IPCC (siehe Einleitung, vgl. auch Kap.5).

Wenn das IPCC den Temperaturanstieg durch Abbau der anthropogenen CO2-Emissionen auf null setzen will, so kann sich diese Maßnahme nur in einer Verminderung der CO2-Gehalte der Atmosphäre in der Größenordnung von 4,7 ppm CO2 äußern, was wiederum bedeutet, dass eine messbare Temperaturabnahme über Wunschdenken nicht hinaus kommt.

5. Stagnation der weltweiten anthropogenen CO2-Emissionen bis 2024 durch die weltweiten Maßnahmen zu ihrer Absenkung sowie ihre Wirkung auf die CO2-Gehalte der Atmosphäre

Die Bemühungen der verschiedenen Länder zur Absenkung der CO2-Emissionen sind unterschiedlich.

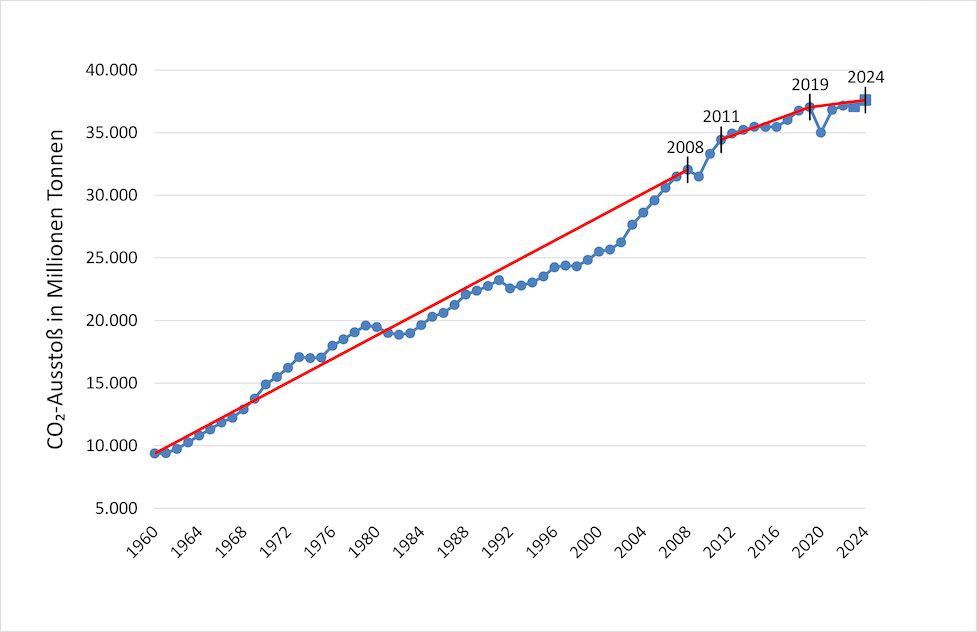

In Bild 8 sind die weltweiten anthropogenen CO2-Emissionen aller Länder zusammengefasst.

Die Werte bis 2022 basieren auf Angaben von „Statista“, die Werte für 2023 und 2024 wurden aus den Angaben von „International Energy Agency“ (IEA) und „wissenschaft.de“ entnommen und zu 37,1 Gt CO2 (2023) und 37,6 Gt CO2 (2024) gemittelt (in Bild 8 gekennzeichnet mit Vierecken).

Bild 8: Entwicklung der anthropogenen CO2-Emissionen von 1960 bis 2024

Die Entwicklung der weltweiten anthropogenen CO2-Emissionen zeigt von 1960 bis 2024 eine starke Abflachung.

Die Entwicklung der Abflachung lässt sich mathematisch wie folgt definieren:

1960- 2008: 478 Mio. t CO2/a; 2011- 2019: 325 Mio. t CO2/a; 2019- 2024: 112 Mio. t CO2/a.

Das Jahr 2009 wurde nicht in die Auswertung einbezogen, weil das Jahr als das Jahr des konjunkturellen Tiefganges bezeichnet wird, sichtbar an dem Einbruch der jährlichen CO2-Emissionen.

Auch das Corona-Jahr 2020 wurde nicht einbezogen, da bedingt durch Corona die Weltwirtschaft zurückgefahren werden musste.

Die weltweiten CO2-Emissionen lagen 2019 bei 37 040 Mio. t CO2/a, im Corona-Jahr 2020 bei 35 008 Mio.t CO2/a (Statista), entsprechend einer Absenkung von 5,5% – eine Abnahme der CO2-Gehalte der Atmosphäre konnte jedoch nicht gefunden werden.

Aus der Abflachung des Eintrages der anthropogenen CO2-Emissionen kann zunächst abgeleitet werden, dass das Bestreben der Weltgemeinschaft zur Absenkung des C02-Anstieges bisher deutliche Früchte trägt.

Wenn nun aber nach Bild 8 der Anstieg der weltweiten CO2-Emissionen bis 2024 gegen null geht, müsste dann nach der Vorstellung des IPCC der Anstieg des CO2-Gehaltes der Atmosphäre auch gegen null gehen (Bild 9) einschließlich einer Abnahme der Temperatur.

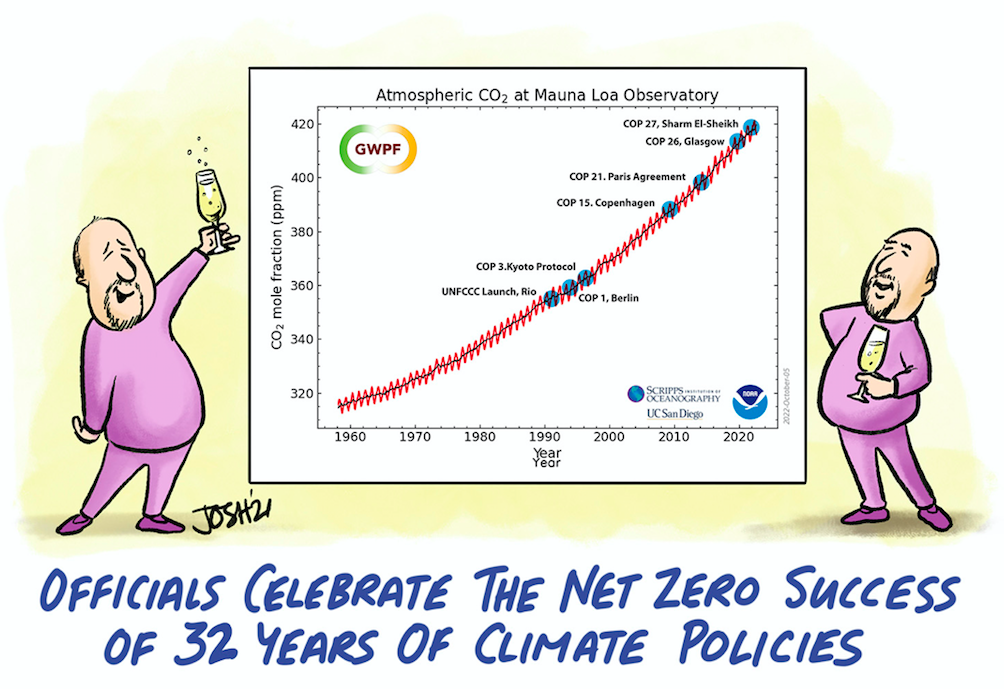

Bild 9: Entwicklung der CO2-Gehalte der Atmosphäre sowie die hoffnungslosen Versuche zu ihrer Absenkung

Bild 9 zeigt aber zunächst, dass die praktisch gegen null verlaufenden weltweiten, anthropogenen CO2-Emissionen auch nicht den geringsten Einfluss auf einen zu erwartenden Abfall der CO2-Gehalte der Atmosphäre ausüben (vgl. auch Corona-Jahr) – im Gegenteil: die CO2-Gehalte steigen nach 2000 sogar verstärkt an.

Außerdem wird der hoffnungslose Versuch einer Absenkung der CO2-Gehalte der Atmosphäre durch diverse Tagungen und dort beschlossene Maßnahmen sichtbar. Aber bei den niedrigen anthropogegen CO2-Emissionen von 4% kann eine Abnahme des CO2-Gehaltes der Atmosphäre auch nicht erwartet werden (vgl. Kapitel 4)

Nach den Vorstellungen des IPCC steigt der CO2-Gehalt der Atmosphäre über die jährlich eingebrachten CO2-Emissionen um 2 ppm an. (vgl. „Einleitung“)

Das entspräche einem CO2-Eintrag in die Atmosphäre von 2 ppm CO2/a oder 15,5 Gt CO2/a.

In den Jahren 2019 bis 2024 stiegen nach Bild 8 die anthropogenen CO2-Emissionen jedoch nur um 0,112 Gt CO2/a an oder 0,112 Gt CO2/7,75 = 0,014 ppm/a und nicht 2 ppm/a nach Aussage des IPCC:

Wird zudem berücksichtigt, dass Deutschland an den weltweiten CO2-Emissionen mit weniger als 2% beteiligt ist, so errechnet sich ein geradezu skurriler deutscher Anteil von 0,014 ppm/a x 0,02 = 0,000 28 ppm/a oder 0.000 000 028%/a– natürlich nicht messbar.

Bei diesem abbaubaren deutschen CO2-Anteil aus der Atmosphäre ist die Vorstellung der Regierung geradezu absurd, dass der „Kern des Klimaschutzes aus der Bepreisung von Treibhausgasen bestehen“ soll. Das Sondervermögen für Klimaschutz ist sinnvoller zu nutzten.

6. Welches sind die Quellen und Senken für die CO2-Gehaltes der Atmosphäre

In Kapitel 4 war aufgezeigt worden, dass der CO2-Anstieg der Atmosphäre in 2020 nur zu 4% (4,7 ppm) über anthropogene CO2-Emissionen erfolgt, 96% (115 ppm) über natürliche Quellen.

Neben den anthropogenen CO2-Quellen aus der Verbrennung von fossilen Brennstoffen, Abholzung, Landwirtschaft, Zementproduktion gehören zu den natürlichen Quellen die Ausgasung der Meere bei Erwärmung, Vulkanausbrüche, Atmung Lebewesen und die Zersetzung organischer Stoffe.

Zu den CO2-Senken werden im Wesentlichen Pflanzen und Wälder, humusreiche Böden, Gesteinsverwitterung und technologische Senken gezählt (vgl. später).

Ozean als CO2-Quelle

Ozeane enthalten 40mal so viel CO2 wie die Atmosphäre.

In der Vergangenheit wurden die Ozeane zu CO2-Senken erklärt, obwohl durch die Temperaturerhöhungen der Atmosphäre inzwischen auch die Meere erwärmt wurden und große CO2-Mengen freigeben. (CO2-Löslichkeit von CO2 in Wasser fällt mit steigender Temperatur)

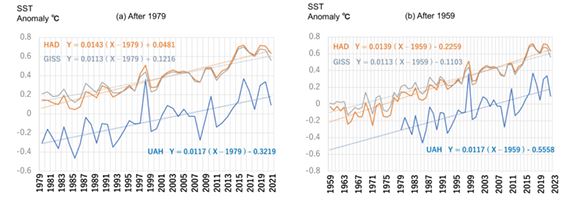

In einer Untersuchung des „Science of Climate Change“ (5) waren anhand von multiplen linearen Regressionsanalysen die Einflussgrößen auf den Anstieg der Meerestemperaturen SST (sea surface temperature) untersucht worden (vgl. auch (6)).

Sowohl auf der Basis der UAH-, HAD- wie GISS-Daten konnten enge Verknüpfungen der SST mit den CO2-Daten gefunden werden. (Bild 10)

Bild 10: Anstieg der Meerestemperaturen

In Bild 10 beinhalten die Jahreszahlen auf der X-Achse die jeweiligen CO2-Gehalte der Atmosphäre.

Der Anstieg der Meerestemperaturen von 1979 bis 2021 auf der Basis von Satellitenmessungen liegt bei etwa 0,5 °C (Bild 10 ((a) After 1979), was einem CO2-Anstieg in der Atmosphäre von 335 auf 415 ppm entspricht. (Bild 9)

Ebenfalls in Bild 10 ((b) After 1959) sind die Messergebnisse für den Zeitraum 1959 bis 2023 dargestellt mit einem Temperaturanstieg von etwa 0,8 °C und einem CO2-Anstieg nach Bild 9 von 315 auf 420 ppm.

Die CO2-Löslichkeit in Wasser nimmt mit steigender Temperatur deutlich ab: bei 15 °C liegt die Löslichkeit bei 1,97 g CO2/kg H20/bar, bei 20°C bei 1,67.

Wird von einem Temperaturanstieg der Meere im Temperaturbereich von 15-20°C ausgegangen,

so fällt die CO2-Löslichkeit von 1,97 (15°) auf 1,67 (20°) g CO2/kg H2O oder 0,048 g CO2/kg H2O je 0,8 °C ab.

Wird bei einer Wasseroberfläche der Meere mit 360 570 000 km2 eine Reaktionstiefe von 500 m und eine Temperaturerhöhung von 15 auf 15,8°C angesetzt, so könnte eine CO2-Menge bei einem Betrachtungszeitraum von 64 Jahren (1959-2023) 8 650 Gt CO2 aus dem Meer freigesetzt werden. (oder 4325 Gt CO2 bei 250 m)

Die Atmosphäre enthält etwa 3300 Gt CO2.

Neuere Untersuchungen zeigen im Übrigen im Vergleich zu Messungen an Eisbohrkernen deutlich schnellere Ansprechzeiten der CO2-Gehalte der Meere bei Temperaturerhöhungen im Bereich von wenigen Monaten. (7)

Hinzu kommt noch die nicht unerhebliche Verdunstung von Wasser an Land bei steigenden Temperaturen, was hier nicht berücksichtigt wird.

Vulkane als CO2-Quelle

Kürzlich wurde berichtet: 19 000 neue Unterwasser-Vulkane entdeckt. (8)

Eine Studie der Universität von Manchester zeigt, dass vulkanische CO2-Emissionen dreimal höher sein könnten als bisher angenommen. In einer 2.Studie der School of Ozeans and Earth Science and Technology (SOEST) geht es um 19 325 neu entdeckte unterseeische Vulkane. Damit erhöht sich die Gesamtzahl auf 43 000.

Bisher sind nur ¼ des Meeresbodens mit Sonar kartiert worden, d.h. die meisten dieser Unterwasserriesen sind noch unerforscht.

Die Strömungen um die untermeerischen Berge erzeugen „Wirbelschleppen“, die kohlenstoffreiches Tiefwasser an die Oberfläche ziehen.

Im Januar 2022 brach der Unterwasservulkan Hunga Tonga aus und erzeugte gewaltige Wasserdampf – Mengen – etwa 50 Mio. t bis in die Stratosphäre.

Dieser Anstieg der Feuchtigkeit in der Stratosphäre um etwa 10-30% hat zu einer Erwärmung der Erdoberfläche 2023-2024 erheblich beigetragen. (9)

Waldbrände als CO2-Quelle

Laut Phys.org wurden in 2021 durch Waldbrände 1,8 Mrd. t CO2 in die Atmosphäre freigesetzt.

CO2-Senken

Die Erde wird grüner, erhöhte CO2-Gehalte der Atmosphäre sind dafür verantwortlich. Chinesische Wissenschaftler stellten fest, dass 55% der globalen Landmasse eine „beschleunigte Wachstumsrate“ der Vegetation aufweisen bei gleichzeitiger Verringerung der Wüstenbildung. (10)

Technologische Maßnahmen als CO2-Senken

Die neue Regierung will das Gesetz zur Abscheidung und Speicherung von CO2 über das CCS-Verfahren durchbringen (Carbon Capture Storage).

CO2 soll aus der Luft entzogen werden (oder direkt bei der Erzeugung von Produkten – z.B. von Zement), um es unterirdisch zu lagern.

Nachbar- und Überseeländer haben CCS als wirksames Instrument zur angeblichen Klimaneutralität weiterentwickelt: Großbritannien, Norwegen, Liederlande, Schweden.

Weltweit gibt es z.Z. 47 CCS-Anlagen. Forscher schätzen die Kosten für Abscheidung, Transport und Speicherung von CO2 mittelfristig auf 150 bis 250 EURO/t CO2.

Die CO2-Löslichkeit im Meerwasser liegt etwa 40mal höher als die CO2-Gehalte in der Atmosphäre und beide stehen in einem thermodynamischen Gleichgewicht zueinander.

Außerdem bedeutet die Reduzierung der CO2-Gehalte der Atmosphäre über CCS nach dem „Prinzip vom kleinsten Zwang“ ein Entweichen von CO2 aus den Meeren in die Atmosphäre.

Das CCS -Verfahren kann daher nicht zu einem Abbau der CO2-Gehalte der Atmosphäre führen.

7. Schlussbetrachtung

Bei der Überflutung der Nachrichten in den Medien mit zunehmenden Extremwetterlagen, Waldbränden, schmelzenden Gletschern, Rekord- Temperaturen etc. sind die vermehrt aufkommenden Klimaängste in Deutschland nicht überraschend: 68% der Deutschen befürworten die Energiewende.

Hinzu kommen all die Profiteure dieser Energiewende: ein Windrad in Tübingen bringt der Stadtkasse 250 000 EURO ein (Aussage B. Palmer in einer Talk Show bei M. Lanz am 20.07.2025).

Selbst der „Internationale Gerichtshof“ in Den Haag formulierte kürzlich einen klaren juristischen Auftrag an die Staatengemeinschaft zum Klimaschutz. Kommen Staaten dieser Pflicht nicht nach, stelle das nicht nur einen Verstoß gegen das Völkerrecht dar, sondern könne unter Umständen sogar zu Schadenersatzansprüchen führen.

Deutschland folgt diesen Umfrageergebnissen, obwohl Deutschland nur 0,000 28 ppm/a (0,000 000 028%/a) CO2 durch seine Dekarbonisierung aus der Atmosphäre abbauen kann.

Der Nobelpreisträger (Physik) John F. Clauser bezeichnete den CO2-Klimawandel eine „schockjournalistische Pseudowissenschaft“.

Dennoch will Deutschland in 2045 den Strom ausschließlich über Wind, Sonne und Wasserstoff darstellen, obwohl die Stromkosten bereits die höchsten in der Welt sind, die Industrien abwandern, die Insolvenzen bereits heute Rekordzahlen aufweisen.

A. Thess (Universität Stuttgart) ermittelte für die deutsche Energiewende Gesamtkosten von 10 Billionen EURO.

Deutschland muss raus aus den ideologischen Träumereien, deren Stromversorgungsicherheit keineswegs gewährleistet ist. (Es sei an den Stromausfall in Spanien am 28.04.2025 erinnert)

Bei der hohen Sensibilität für gesicherten Strom in Deutschland sowie die erforderliche Absenkung der Kosten können nur Kohle-, Gas-, Kernkraftwerke helfen – eine Verabschiedung von der Skurrilität eines deutschen CO2-Abbaues der Atmosphäre durch die Energiewende von 0,000 28 ppm/a oder 0,000 000 028%/a ist zwingend geboten.

Die Vorstellung der Regierung, dass „der Kern des Klimaschutzes aus der Bepreisung von Treibhausgasen bestehen sollte“, entbehrt damit jeglicher Grundlagen.

8. Quellen

1.https://tinyurl.com/y5nhhfnd

2 Baritz, B., J. Kowatsch: „Frühlingsverlauf Deutschland: ein weiterer Verlauf gegen die These einer starken Treibhausgaserwärmung“; EIKE, 18.06. 2025

3. Fleischmann, B.: „Warum sich das Klima ändert (Kurzfassung)“; Version 30.09.2021

4. Beppler, E.: „Quantifizierung des marginalen anthropogenen CO2-Gehaltes in der Atmosphäre – ein seit Jahren überfälliger Schritt“; EIKE, 16.12.2020

5. https://scienceofclimatechange.org.

6. Eschenbach, W.: „Wassertemperatur-Blues“; EIKE, 10.06.2024

7. Macrae, A., J. D` Aloe: „Die wirkliche Klimakrise ist nicht die globale Erwärmung, sondern die globale Abkühlung und vermischt hat sie bereits begonnen“, EIKE,05.03.2020

8. Watts, A.: „Vulkane emittieren dreimal mehr CO2 als gedacht“, EIKE, 22.05.2025

9. Allen, C.: „Aktualisierung: Neues zum stratosphärischen Wasserdampf“, EIKE, 25.07 2024

10. Sterling Burnett, H.: „Dank des Klimawandels: die Erde wird grüner“, EIKE, 05.03.2020