Juni-Klimaerwärmung seit 1988 ja, aber nicht durch CO₂

Der hohe Wärmeinseleffekt der Wetterstation Weiden

Josef Kowatsch, Matthias Baritz

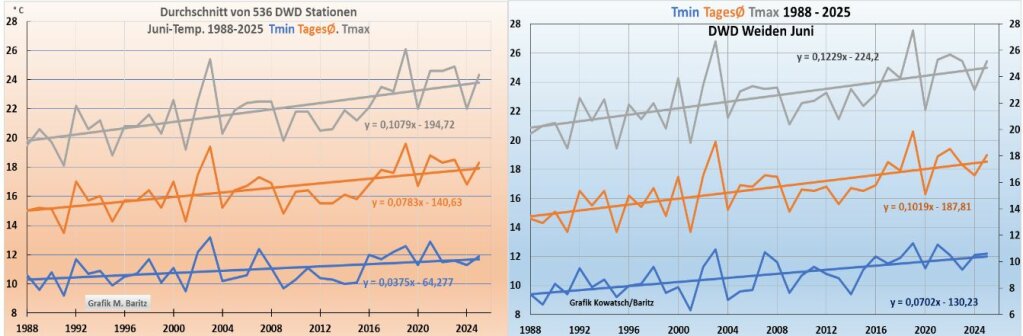

Der Juni ist der Monat, der sich seit der im Jahre 1988 beginnenden Erwärmung in Mitteleuropa am meisten erwärmt hat. Es gibt dafür natürliche Gründe, aber auch vom Menschen verursachte. Zu diesen Ursachen zählt der zunehmende Wärmeinseleffekt, der im Sommer und insbesondere beim Monat Juni besonders hoch ist.

Im Sommer und bereits ab Juni können deshalb vermeintlich ländliche Wetterstationen einen hohen zunehmenden Wärmeinseleffekt (WI) haben. Das wollen wir am Beispiel der DWD-Wetterstation Weiden/Oberpfalz zeigen. Beachte: Einen WI-Effekt haben alle Wetterstationen, unter WI-stark verstehen wir einen stark zunehmenden WI-Effekt. Siehe unser Beispiel aus dem letzten Artikel, Abb. 8. München Stadtmitte und Holzkirchen im Speckgürtel.

Wie erkennt man eine WI-starke DWD-Wetterstation?

Antwort: Eine WI-starke Station hat im Vergleich zum DWD-Schnitt seit 1988 vor allem im Sommer deutlich stärkere Temperatursteigungen, und zwar sowohl nachts, tagsüber als auch über den 24 Stundenschnitt

Wir müssen auch betonen, dass unsere Definition von WI-Effekt nicht gleichzusetzen ist mít dem reinen städtischen WI-Effekt, Abk. UHI

Die nächsten beiden Abbildungen wollen die Definition erklären.

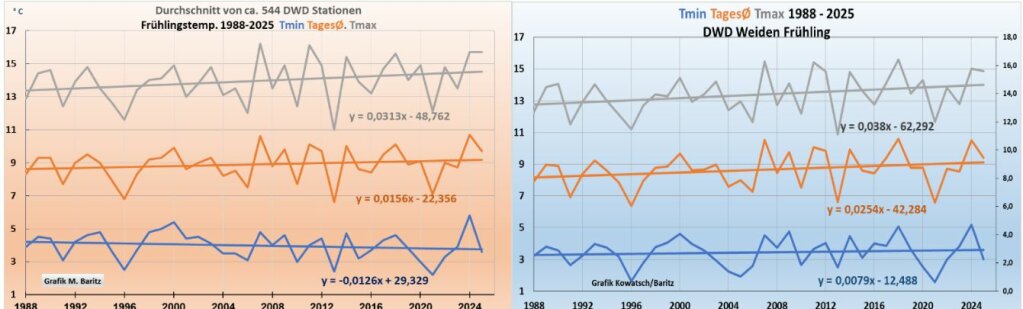

Abb. 1a/b: Oben in grau die Höchsttemperaturen tagsüber, ganz unten in der Farbe Blau die Tmin-Temperaturen, die im Sommer meist kurz vor Sonnenaufgang auftreten.

Ergebnis: alle drei Graphen, also Tmax, Tmin und der Gesamttag, steigen bei der DWD-Wetterstation Weiden viel stärker als beim Deutschlandmittel.

Verkürzt könnte man sagen, Tag und Nacht wurden bei einer Wärmeinselstation viel wärmer als der DWD-Schnitt.

Bedingungen für eine Station mit stark steigendem Wärmeinseleffekt:

- Im Betrachtungszeitraum hat sich ein Ort in die einstige Grünfläche hinein ausgedehnt. Also mehr wärmespeichender Beton, sowie eine Bodenversiegelung durch mehr bebaute Fläche und Asphalt für Straßen. Dabei muss sich nicht einmal die Einwohnerzahl erhöht haben, aber die bebaute und versiegelte Fläche nahm zu.

- Die Trockenlegung des ganzen Landes seit Jahrzehnten, und zwar im Feld, im Wald, in den Wiesen und Fluren. Ganz Deutschland wird dadurch schleichend trockener, insgesamt stellen wir eine zunehmende Versteppung Deutschlands in den Sommermonaten fest.

- Vermehrter Straßenbau in freier Landschaft, die grauschwarzen Asphaltbänder wirken wie ein Wärmeband quer durch die Landschaft, Temperaturen im Sommer bis 50°C.

- Umstellung der Messmethoden, die Wetterstation muss jetzt ganztägig in der Sonne stehen, das war bei der Erfassung in der Wetterhütte nicht immer der Fall. Alle DWD-Stationen sind inzwischen umgestellt.

- eine mögliche Änderung der Homogenisierungsart, also eine stärker erwärmende Datenbearbeitung der gemessenen Werte durch den DWD.

- Die Sonnenstundenzunahme und die Strahlungsintensitätszunahme, ein trockener Boden erwärmt sich besonders

- Der Niederschlagsverlauf, weniger Niederschlag heißt auch weniger Verdunstungskälte.

- Standortwechsel, mit der Umstellung auf die neuen Messmethoden erfolgte nahezu bei allen DWD-Stationen ein Standortwechsel, da der alte Wetterhüttenstandort die neuen Bedingungen meist nicht erfüllen konnte.

Übertragen wir diese Punkte auf Weiden.

Punkt 1 trifft weniger zu, da die Wetterstation eh außerhalb und zwar südlich des Ortes steht. Folgende Bilder sollen dies verdeutlichen.

Abb. 2a: Die Stadt Weiden liegt nordwestlich der Wetterstation. Diese befindet sich direkt neben der Bundesstraße 22, die sich just in Stationsnähe asphalterweiternd aufspaltet.

Zwei Spuren führen aus der Stadt raus nach Süden und drei Spuren an der Wetterstation vorbei in Richtung Weiden, dazu noch unmittelbar vor dem eingezäunten Wetterstations-Gelände ein breiter asphaltierter zweispuriger Grüner Plan Weg.

Abb. 2b: Zwei Spuren Bundesstraße Richtung Norden und zusätzlich die Abbiegespur nach Weiden. Direkt vor der Station der breite grüne Planweg. Der Hang ist leicht geneigt und entwässert nach links ins Tal. Man beobachte auch das schützende Gebäude direkt bei den Wetterstations-Elementen.

Diese insgesamt 7 Straßen-Wärmebänder erwärmen sich infolge der hoch stehenden Junisonne besonders stark und die sommerliche Versteppung des Bodens beginnt unmittelbar daneben. Zudem steht das Haus im Norden der Wetterstation und staut den warmen sommerlichen Südwind auf. Umgekehrt werden sommerliche Nordwetterlagen abgeschirmt, natürlich auch durch die Häuser des Stadtteils, der danach beginnt.

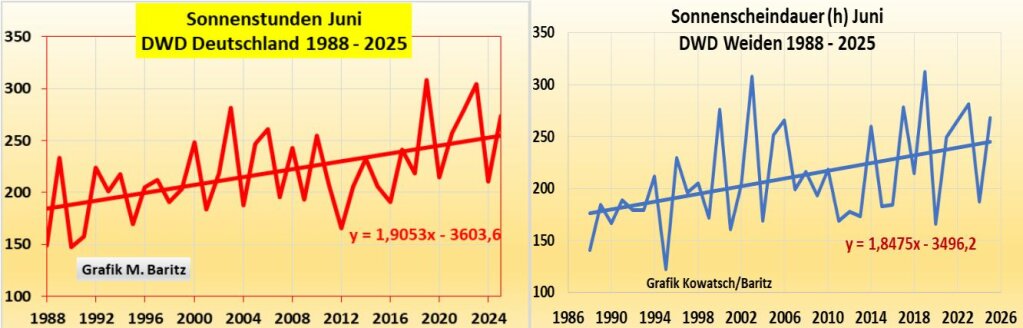

Die Sonnenstundenzunahme in Deutschland und in Weiden

Abb. 3a/b: Die beiden Steigungslinien sind etwa gleich, somit hat Weiden keinen Orts-Erwärmungsvorteil durch mehr Sonne im Betrachtungszeitraum.

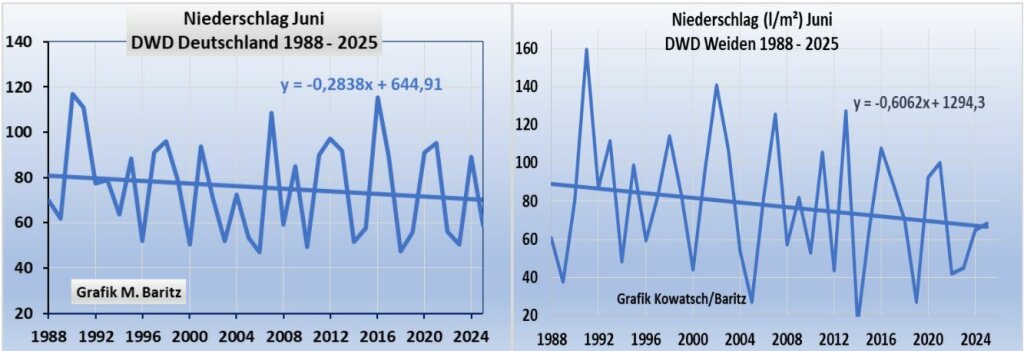

Der Niederschlag im Vergleich: Deutschland links

Abb.4a/b: Im Raum Weiden haben die Juniniederschläge im Vergleich zu Gesamtdeutschland deutlich nachgelassen, damit ging auch die Verdunstungskälte in den Sommermonaten stark zurück. Eine notwendige Voraussetzung für eine starke Erwärmung der Luft über dem Boden vor allem tagsüber. Das Digitalthermometer der Wetterstation reagiert prompt nach oben.

Unsere Vorhersage: Die Wetterstation Weiden auf 400 m Höhe ist geeignet für sommerliche DWD-Spitzentageswerte.

Punkt 4: Umstellung der Messmethoden.

Alle DWD-Stationen mussten auf die neuen Messmethoden umgestellt werden. Das führte wahrscheinlich insgesamt zu steigenden Temperaturen, ob dieser Punkt Weiden eine zusätzliche Erwärmung gegenüber dem Schnitt bringt, können wir nicht beurteilen.

Punkt 5: eine mögliche Änderung der Homogenisierungsart, also eine stärker erwärmende Datenbearbeitung der gemessenen Werte durch den DWD.

Ob das bei Weiden veranlasst wurde, können wir nicht beurteilen. Wir wissen aber, dass alle veröffentlichten Werte vom DWD nach einer eigenen Methode bearbeitet werden und nur diese werden veröffentlicht. Siehe die Mitteilung ganz links unten bei wetteronline.

Punkt 8: Die Station wurde im Jahre 2006 an den jetzigen Standort versetzt, um die neuen DWD-Normen zu erfüllen, insbesondere ganztägig in der Sonne.

Fazit: Alle Maßnahmen in der Summe führten seit 1988 zu einem stärker steigenden WI-Effekt des Standortes Weiden im Vergleich zum DWD-Schnitt, vor allem in den Sommermonaten. Im Winter sind die zusätzlich wärmenden Effekte viel weniger ausgeprägt, da sich die Straßenflächen weniger aufheizen und bei Temperaturen um 0°C eh kaum Wasser aus der Landschaft verdunstet und die Sonne weniger und auch weniger intensiv scheint. Insgesamt erwärmt sich der Winter in Weiden seit 1988 jedoch auch etwas stärker als der DWD-Schnitt.

Abb. 5a/b: insgesamt ähnlich, jedoch bei Weiden teilweise winters merkwürdige, nicht zu erwartende Temperaturverläufe. Hinweise auf Messunregelmäßigkeiten/Homogenisierungen?

Hinweise auf Messfragwürdigkeiten/Homogenisierungen bei Weiden? Den Eindruck kann man auch gewinnen, wenn man die Jahreszeit Frühling betrachtet

Abb. 6a/b. Frühlingsvergleich DWD-Deutschland und Weiden. Insbesondere die nächtlichen Tiefsttemperaturen sind positiv, beim DWD dagegen fallend. Der Frühling wird in Deutschland nachts kälter. In Weiden nicht. T-Min zeigt bei allen drei Grafikvergleichen eine höhere Steigung als beim DWD. Woher kommt die sich steigernde nächtliche Zusatzwärme, insbesondere auch beim Monat Juni?

Zusammenfassung:

Der neuzeitliche Klimawandel begann in Deutschland und Mitteleuropa im Jahre 1988. Je nachdem wo die DWD-Wetterstationen stehen, ergeben sich mehr oder weniger starke Temperatursteigerungen, die sich auch noch deutlich unterscheiden, wenn man die nächtlichen Tiefst- und die Tageshöchsttemperaturen mit vergleicht.

Bei allen deutschen Wetterstationen hat seit 1988 bis heute ein zunehmender Wärmeinseleffekt mitgewirkt, der die Temperaturen mit nach oben treibt. Ob eine Wetterstation einen großen zunehmenden WI-Effekt hat, zeigt sich vor allem in den Sommermonaten durch Vergleich mit dem DWD-Schnitt. Alle drei Temperaturgraphen liegen bei Weiden deutlich darüber.

Wir wollten zeigen, die im Jahre 1988 begonnene Erwärmung, die man Klimawandel nennt, hat natürliche Gründe und vom Menschen verursachte. Die Zunahme der Wärmeinseleffekte bei den Deutschen Wetterstationen ist anthropogen verursacht, aber natürliche Faktoren wie Sonne oder Niederschlag verstärken den WI-Effekt. Natürliche Ursachen der allgemeinen Erwärmung sind die Zunahme der Südwetterlagen ab dem Jahre 1988.

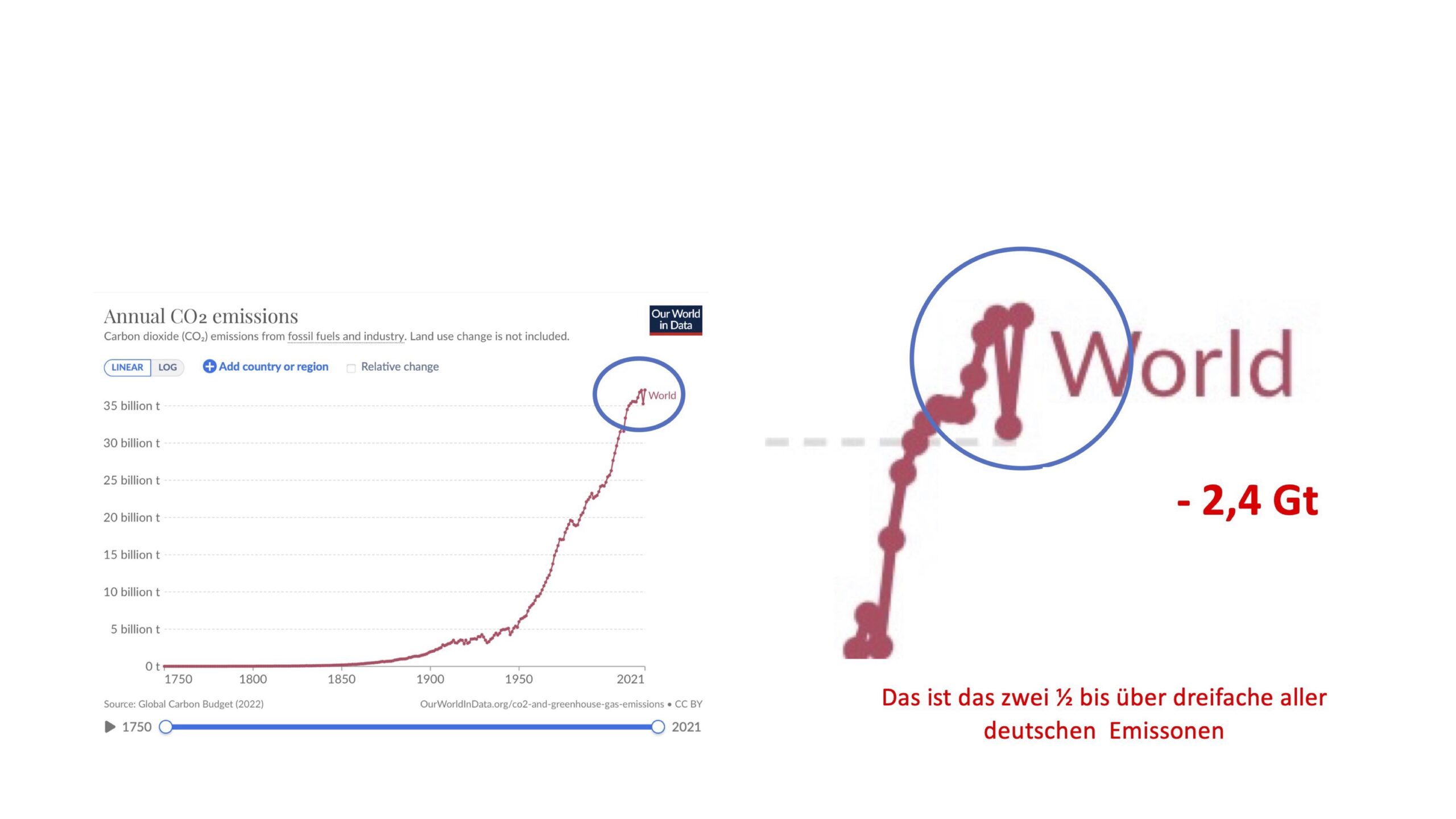

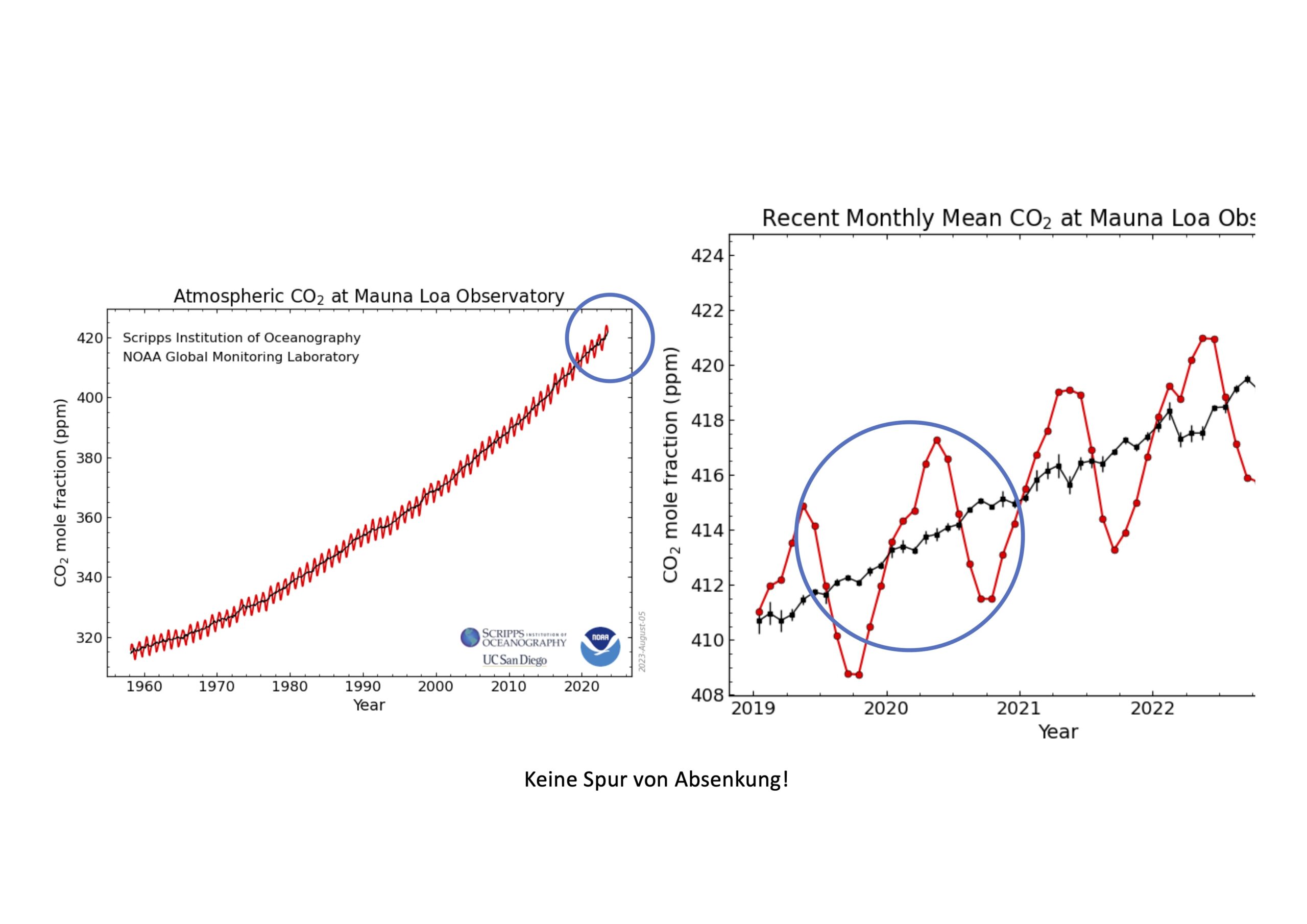

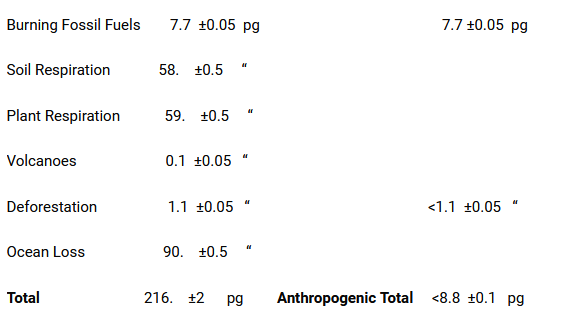

Was bleibt noch übrig für CO₂ als angeblicher Erwärmungstreiber seit 1988? Antwort: gar nichts, denn CO₂ kann vor 1988 nicht abkühlend wirken, und dann aufgeschreckt durch einen Zeitzünder ab 1988 (1988 = Gründung des Weltklimarates) bis heute plötzlich stark erwärmend. Und auch noch unterschiedlich stark zwischen Tag und Nacht!! Solche Gaseigenschaften gibt es nicht! Die nächste Grafik zeigt uns den plötzlichen Juni-Temperaturwechsel im Jahre 1987/88

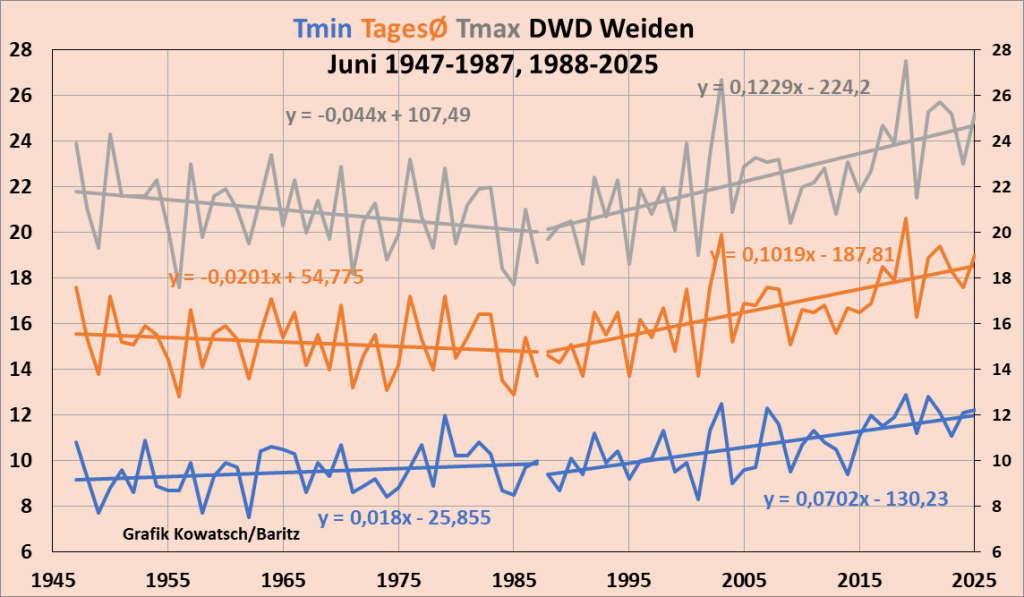

Abb. 7: Wie überall in Mittel- West- und Nordeuropa begann der Klimawandel im Jahre 1987 auf 1988. In Weiden haben sich vor allem die Tageshöchsttemperaturen sehr stark verändert. Auch das ist ein Hinweis auf einen stark wachsenden WI-Effekt bei der Station seit 1988.

Weiden bestätigt das, was wir seit einigen Jahren betonen, und zwar, der WI-Effekt nimmt am Stadtrand meist stärker zu als in der Stadtmitte oder in der Stadt ist die Zunahme des WI-Effektes weitgehend ausgereizt.

Wenn wir von einer WI-starken Station reden, dann meinen wir eine starke Zunahme des WI-Effektes

Wir alle sind aufgerufen, jeder auf seinem Weg und nach seinem Können die derzeitige Klima-Panikmache und die politisch inszenierte Verteufelung des lebensnotwendigen Kohlendioxids zu bekämpfen. Kohlendioxid ist nicht der Temperaturregelknopf fürs Klima, sondern diese Behauptung des geldsüchtigen Klimakartells ist ein Geschäftsmodell.

Kurz: Klimawandel und Erwärmung ja, aber erst seit 1988, CO₂ hat nichts damit zu tun.

Ein Umdenken bezüglich Kohlendioxid in der Bevölkerung und bei den Kirchen ist schnellstens erforderlich, um den völlig unsinnigen CO₂-Reduzierungsmaßnahmen der weltweit verlogenen linksgrünen Klimapolitik ein Ende zu bereiten. Dieses „Grün“ hat nichts mit einer notwendigen Naturschutz- und Umweltpolitik zu tun. Die Klimapolitik will unser Land, unsere Kultur-Landschaft und unseren Wohlstand zerstören.

Sauberes Wasser, saubere Luft, eine erholsame abwechslungsreiche Landschaft mit einer intakten Fauna und Flora mit ausreichend, und zwar mit mehr Kohlendioxid in der Atmosphäre als derzeit ist gut für den Erhalt der Schöpfung. Der optimale CO₂-Konzentationsbereich für das Leben auf der Erde muss endlich wissenschaftlich erforscht werden. Er dürfte gut doppelt so hoch sein wie derzeit.

Josef Kowatsch, Naturbeobachter, Naturschützer und unabhängiger, weil unbezahlter Klimaforscher, außerdem in Rente und von keinem Arbeitgeber abhängig.

Matthias Baritz, Naturwissenschaftler und Naturschützer