Von Matthias Baritz, Josef Kowatsch

Teil 1 hier

Teil 2: Unterschiedlicher Verlauf der Tages/Nachttemperaturen

- Die Schere zwischen Tag und Nachttemperaturen öffnet sich seit dem Klimawandel

- Der Klimawandel fand in Mittel- und Westeuropa erst im Jahre 1987/88 statt

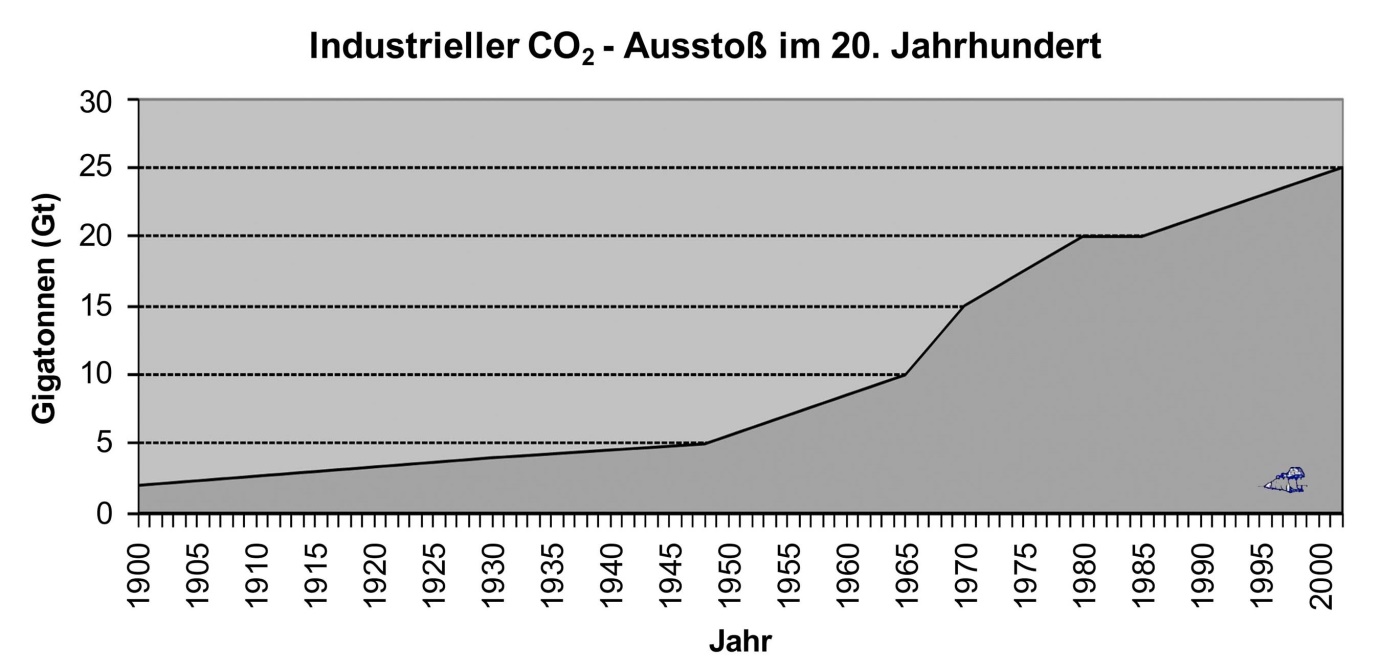

- Keine Korrelation zwischen Temperaturen und CO₂-Zunahme

Anmerkung: Der DWD- erfasst bei seinen Wetterstationen die Maximum- und die Minimum-Temperaturen mit einem Digitalthermometer, also die Tagesspitzen und die nächtlichen Tiefsttemperaturen, die in aller Regel kurz nach Sonnenaufgang gemessen werden. Bei warmen Apriltagen schaukelt sich die Temperatur aufgrund der schon hochstehenden Sonne und den südlichen Wetterlagen auf, so dass eine hohe Tmax auch zugleich einen warmen Apriltag tagsüber beschreibt. Umgekehrtes gilt für die Nacht. Deshalb reden wir verkürzt von Tages/Nachttemperaturen.

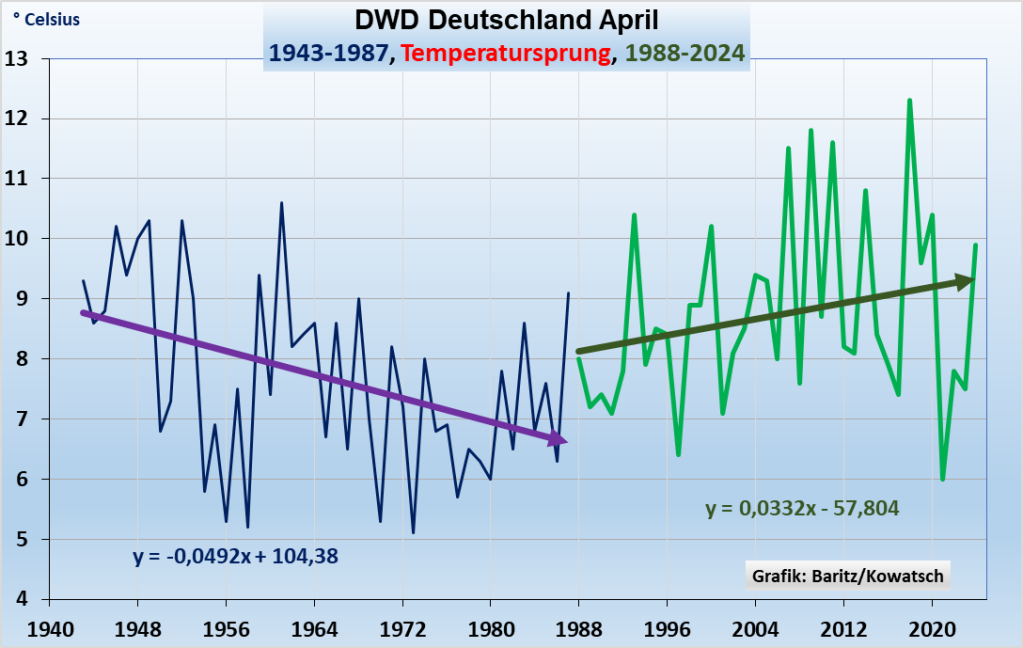

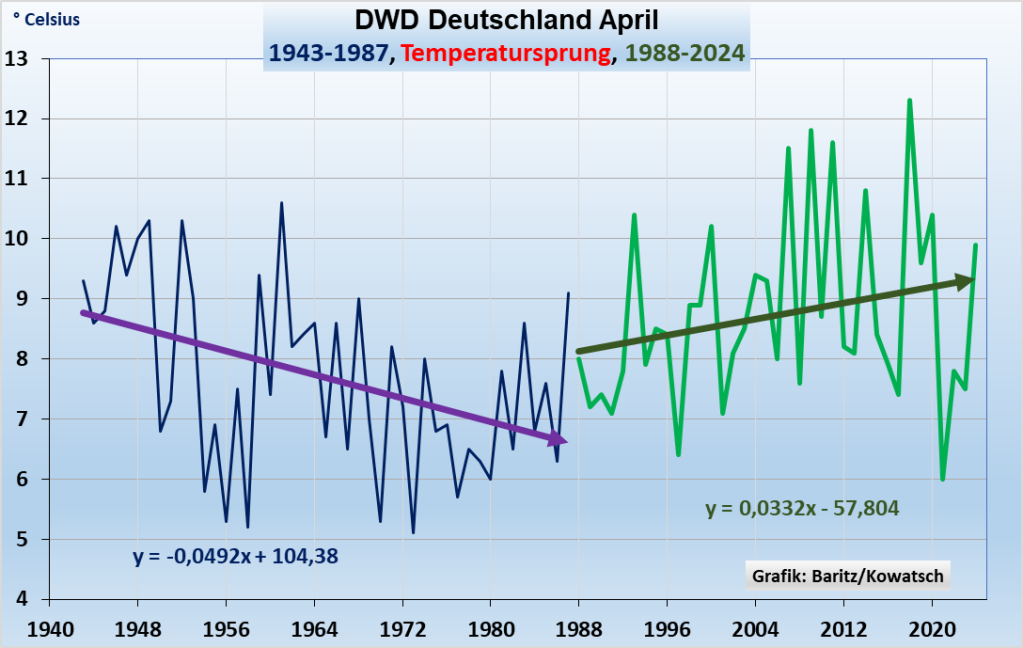

In Teil 1 hatten wir festgestellt, dass der April ab 1987/88 durch einen Temperatursprung wärmer wurde und zwar bei allen deutschen Wetterstationen, auch bei den WI-armen. Nochmals die Grafik der Apriltemperaturen dazu, ohne Aufschlüsselung in Tag/Nacht:

Abb.1: 30 Tagesmessungen ergeben den Schnitt für 1 Jahr. In früheren Jahrzehnten wurde diese Tagesmessung nach einer anderen Methode und analog in der englischen Wetterhütte ermittelt, die auch noch an einem anderen Platz stand, als die heutige Ermittlung nach DWD-Norm.

Nun könnten von der Treibhauserwärmung Überzeugte unter den Lesern behaupten, dieser natürliche Temperatursprung 1988 – siehe Grafik 1- wäre ein Einfluss von Treibhausgasen. Diese eventuelle Falsch-Überzeugung lässt sich leicht widerlegen, indem man den April-Temperaturverlauf seit 1988 auftrennt in Tag/Nachttemperaturen.

Wir gehen davon aus: Würde CO₂ der Haupttreiber der Temperaturen sein wie die Definition der Treibhauskirche von Klimawandel vorgibt, dann dürfte es zwischen einzelnen Wetterstationen kaum Unterschiede in den linearen Regressionslinien geben und zwar bei allen Wetterstationen der Welt.

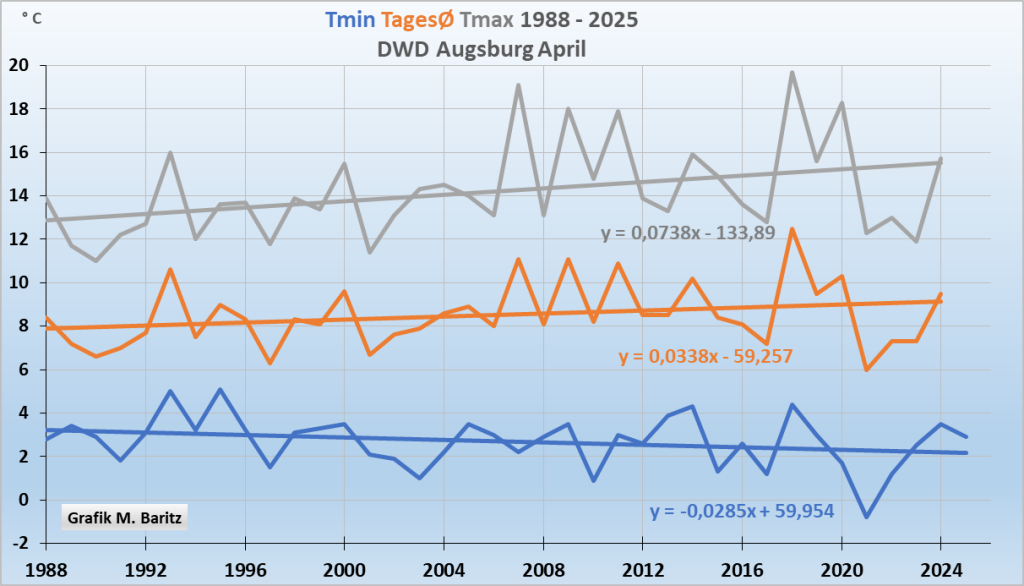

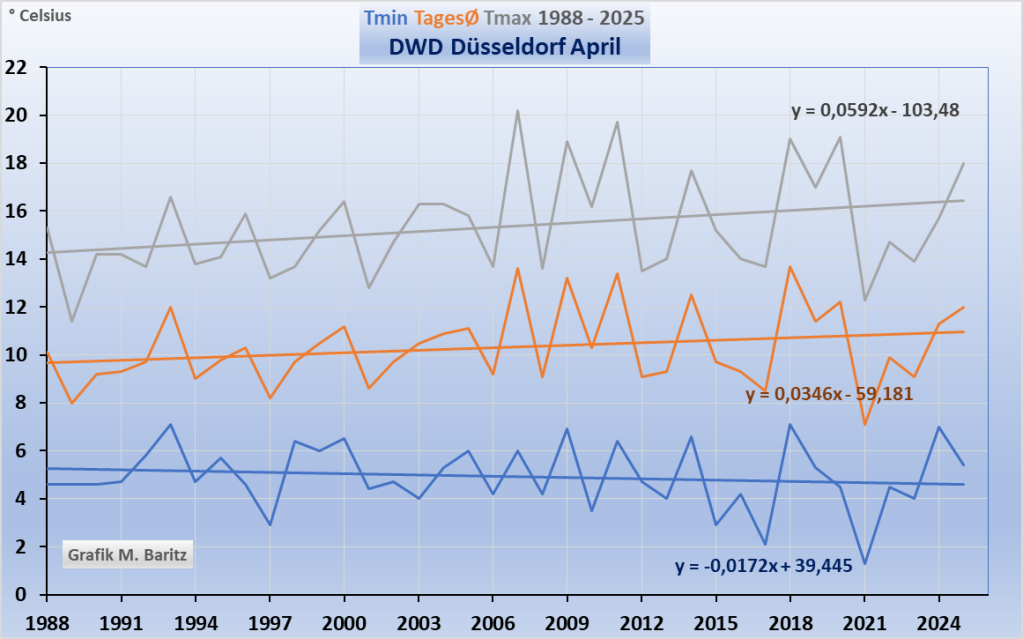

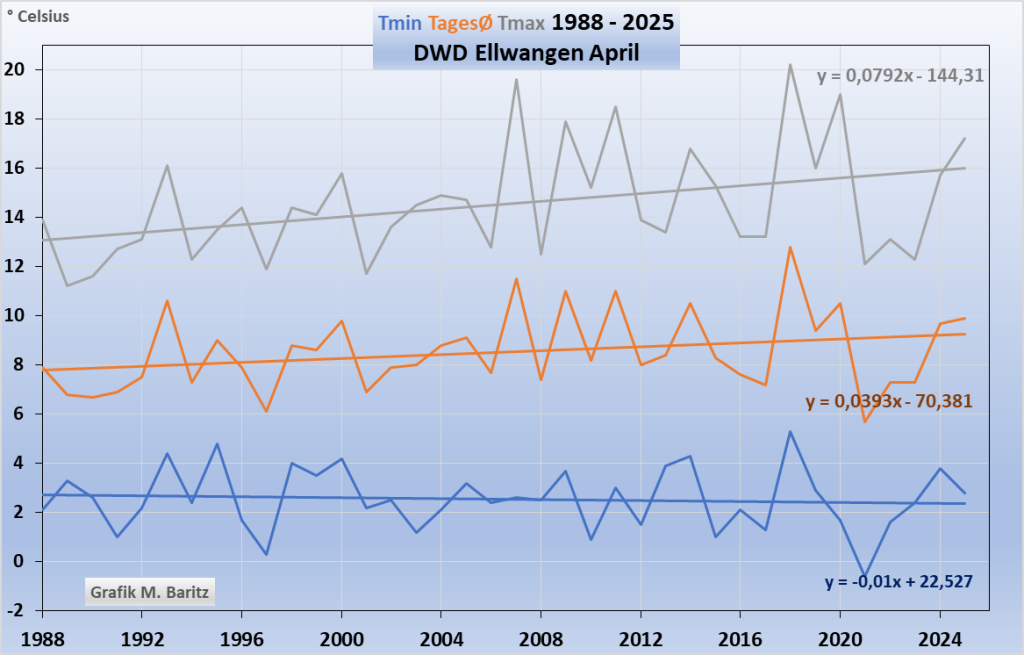

Hinweis zur Übersichtlichkeit der folgenden Grafiken: Der Leser möge in den nun folgenden Grafiken vor allem den Trendverlauf der blauen unteren Nachttiefsttemperaturen mit dem Trendverlauf der oberen grauen Grafik, den Tageshöchsttemperaturen vergleichen. Vielleicht sollte man noch betonen, dass die monatlichen Maxima und Minima Durchschnittswerte aller täglichen Tmax/Tmin sind.

Unterschiedliche Entwicklung der Tag/Nachtemperaturen beim April

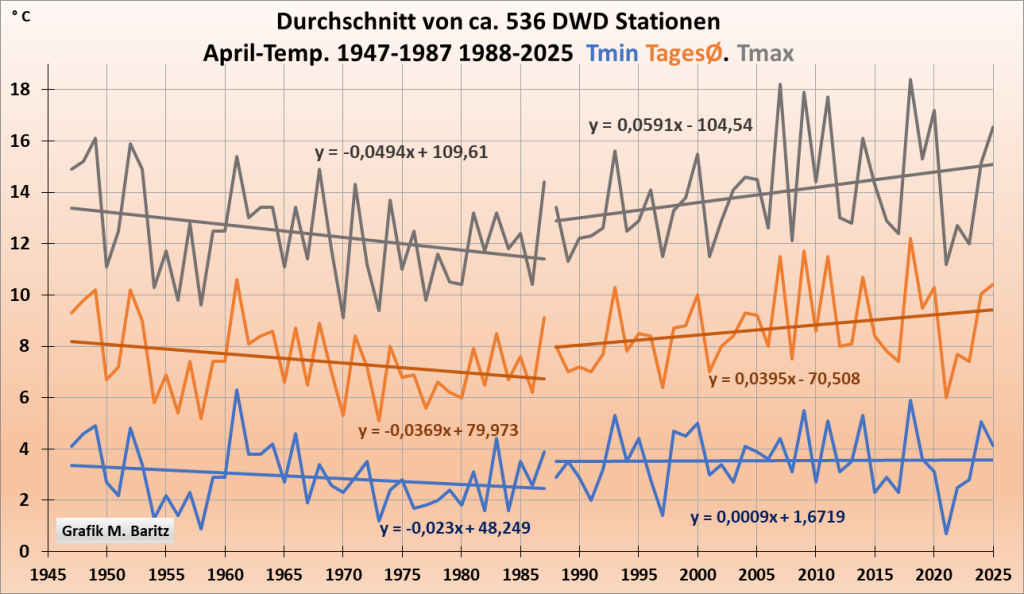

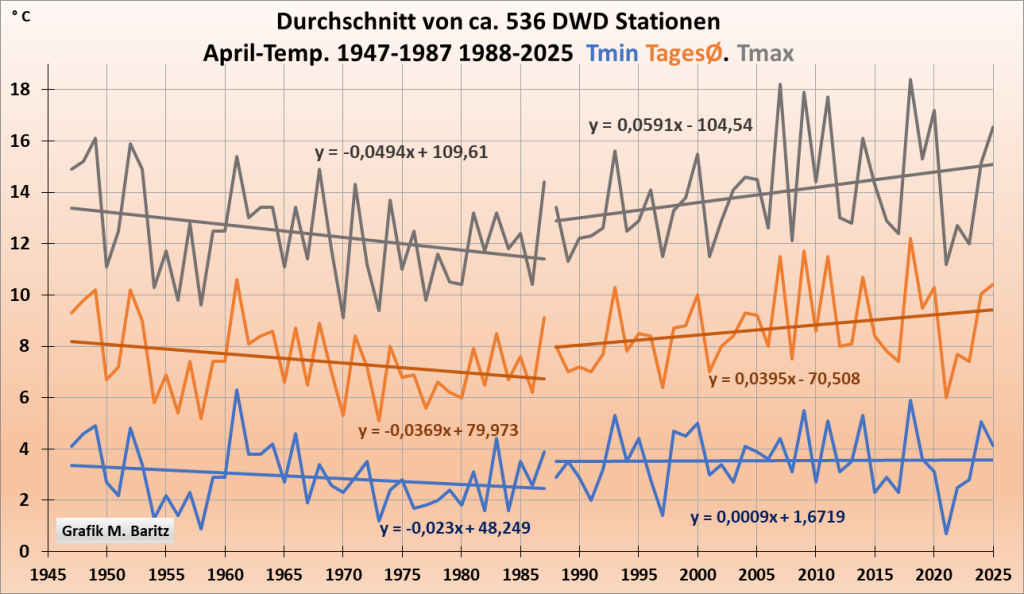

Der DWD bietet keinen Schnitt der Tag/Nachttemperaturen, erfasst als Tmax und Tmin seiner fast 2500 Wetterstationen an. Also auch kein Diagramm. Nur Einzelstationen. Herr Baritz hat sich die zeitaufwändige unendliche Mühe gemacht und fast 540 repräsentativ herausgegriffene DWD-Stationen zu einem Deutschland-Schnitt seit 1947 zusammengefasst. Ein zeitlich weiteres Zurückgehen war leider nicht möglich, da erst nach Kriegsende genügend Wetterstationen vorliegen, die auch heute noch alle drei Parameter messen.

Abb. 2: Aufgetragen sind 2 Zeiträume, 1947 bis 1987, dann der Temperatursprung und ab 1988 bis heute. Außerdem 3 Grafikverläufe: Die obere graue Grafik fasst die Tmax Temperaturen des Monats April, die mittlere braune Grafik die Tagesschnitte (24-Stunden) und die blaue Grafik die kältesten Nachttemperaturen, gemessen in Tmin. Quelle https://www.wetterzentrale.de/de/weatherdata_de.php

Ergebnis: Vollkommen anderer Verlauf vor und nach dem Temperatursprung

Tmax: bis 1987 stark fallend, Temperatursprung, seitdem stark steigend

Schnitt: bis 1987 deutlich fallend, Temperatursprung, danach deutlich steigend.

Tmin: ab 1947, 40 Jahre leicht fallend, Temperatursprung, danach ausgeglichen

Wichtige Erkenntnis, nach dem Temperatursprung 1987/88 wurden beim Monat April nur die Tage tagsüber wärmer.

Wo ist der CO₂-Treibhauseffekt in der Grafik 2 erkennbar? Antwort: Nirgendwo

- An dem unterschiedlichen Verlauf der Temperatur-Maxima und -Minima hat der Deutsche Wetterdienst selbst den CO₂-Treibhauseffekt als Haupttreiber der Temperaturen widerlegt.

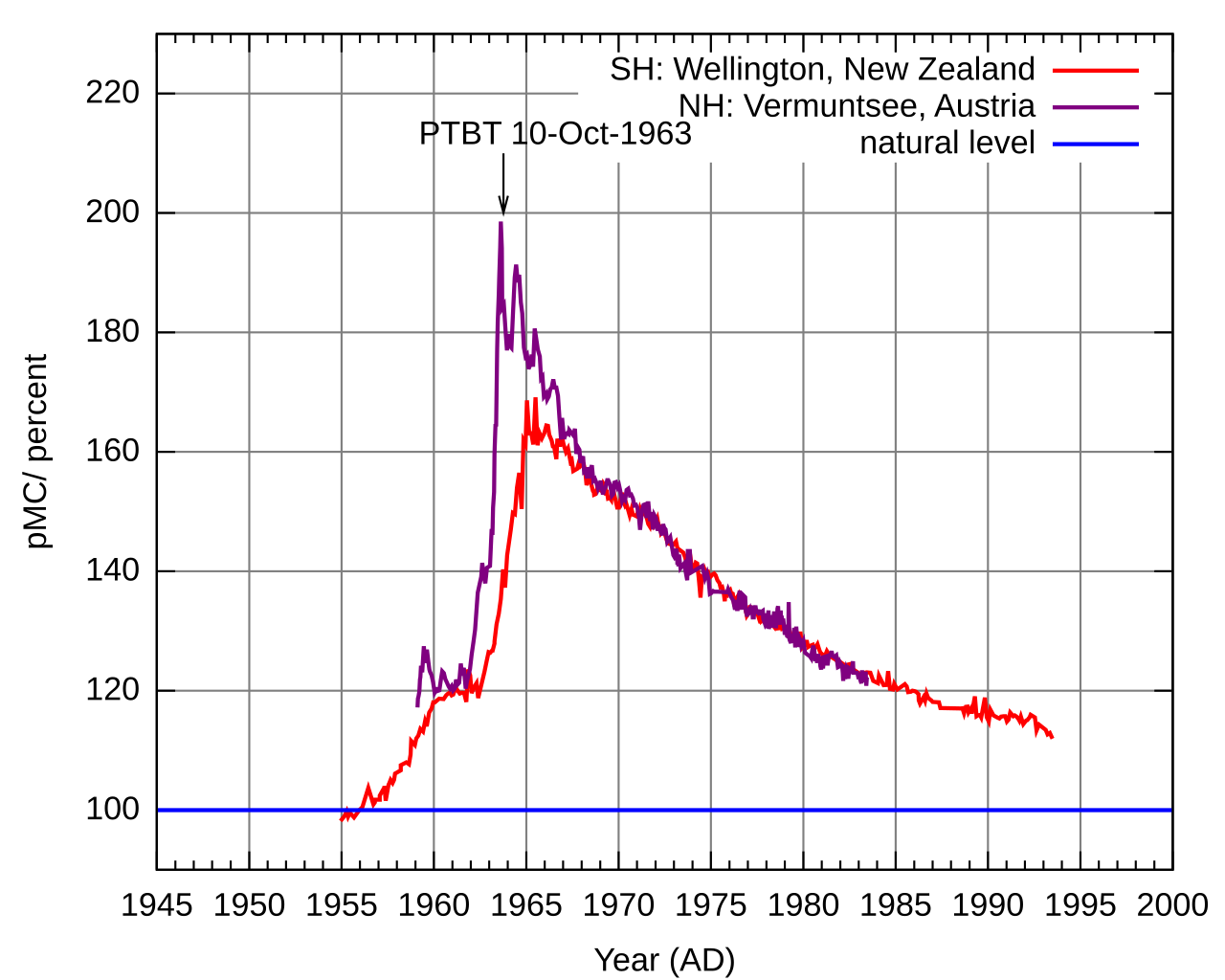

- Die CO₂-Konzentration ist tagsüber und nachts gleich. Die Grafik 2 zeigt, dass die Aprilerwärmung seit 1988 aber nur tagsüber stattfand. (ähnlich wie bei allen Monaten im Sommerhalbjahr)

Dabei sollte doch laut Theorie der Treibhauskirche der Treibhauseffekt nachts stärker wirken als tagsüber, hier hat der RTL Klima-„Experte“ Christian Häckl diese Theorie ausführlich und verständlich beschrieben.

Auch der deutsche Physiknobelpreisträger von 2021, Klaus Hasselmann hat behauptet: Der Treibhauseffekt soll nachts stärker wirken als tagsüber, was ihm und seinem Team angeblich durch Satellitenmessungen bestätigt wurde. So seine Behauptungen. Und damit habe er die CO₂-Fußabdrücke in der Atmosphäre gefunden und als erster bestätigt. So wird der Mann im neuen Buch von Axel Bojanowski in einem ganzen Kapitel ab Seite 142 als Entdecker des nächtlichen CO₂-Signals gelobt: „Was Sie schon immer übers Klima wissen wollten“.

Es gibt nur einen Nachteil: die Vorhersagen einer stärkeren nächtlichen Erwärmung als angeblicher Beweis einer CO₂-Treibhauswirkung sind grottenfalsch, weil die Realität der DWD-Temperaturen das Gegenteil zeigt. Es ist aber auch zu dumm, wenn der DWD zwar die Tmin/Tmax erhebt, aber selbst nirgendwo eine Grafik anbietet und überzeugte Treibhausexperten dann ohne Beweis irgendwas behaupten dürfen und dafür auch noch den Nobelpreis erhalten! Oder – so unsere Vermutung – bietet der DWD etwa nur deshalb keine eigenen Grafiken mit Nacht- und Tagestemperaturen an, um die Treibhauskirche nicht ad absurdum zu führen? Um einen deutschen Nobelpreisträger nicht bloß zu stellen für seine falsche Theorie!!!

Mit der Grafik 2 weiter oben haben wir zusammen mit dem Deutschen Wetterdienst den Beweis erbracht, dass die Temperaturen am Tage stark steigen und nachts gar nicht.

Mehrere tatsächliche Gründe dieser Erwärmung tagsüber haben wir im Teil 1 genannt und gezeigt, es waren hauptsächlich die Sonnenstunden, die mit den Apriltemperaturen stark korrelieren.

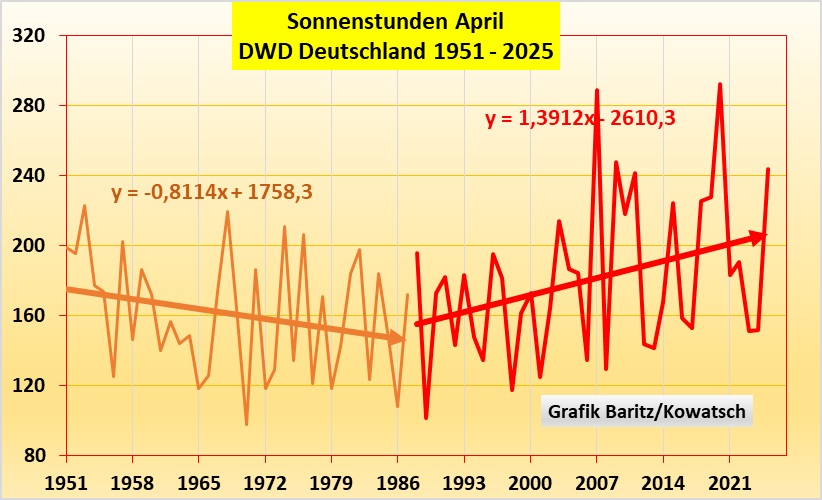

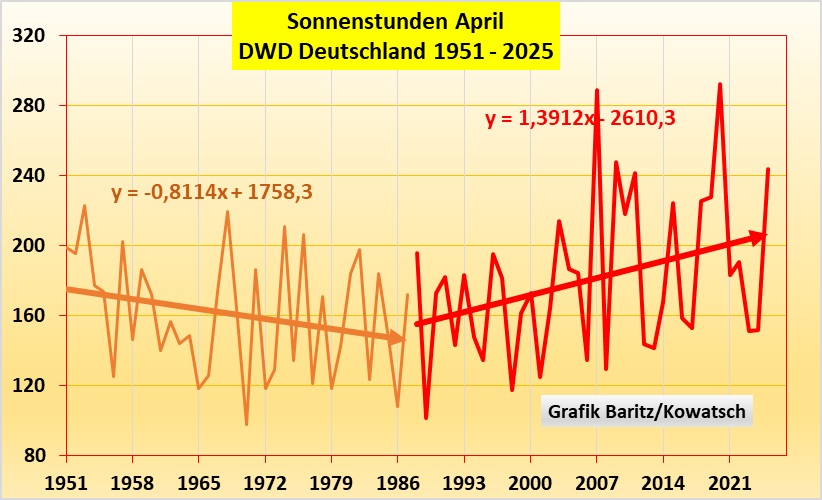

Abb. 3: Beachte, zunächst die Abnahme der Sonnenstunden bis 1987, dann die Zunahme. Die Sonnenstundenzunahme hat wesentlich zu einem Anstieg der Apriltemperaturen seit 1988 beigetragen.

Mit den Sonnenstunden hat zugleich auch die Intensität der Sonnenstrahlung zugenommen, nähere Erläuterungen hier: Martin Wild’s Übersichtsartikel „Global dimming and brightening“, A review, J. Geophys. Res., 114, D00D16, doi:10.1029/2008JD011470.1.

Es sei darauf hingewiesen, durch unsere Grafikbeweise kann eine winzige CO₂-Wirkung (erwärmend oder abkühlend) jedoch nicht ausgeschlossen werden. Doch wir können zeigen: Keinesfalls ist CO₂ der entscheidende Temperaturregelknopf wie die linksgrüne Treibhauskirche uns vorlügt. Keinesfalls ist CO₂ ein Temperaturregelknopf und schon gar kein Klimakiller.

Ein möglicher weiterer Grund für die Aprilerwärmung neben den in Teil 1 sonst noch genannten soll hier aufgrund von Hinweisen in Kommentaren mit erwähnt werden: das Geo-Engineering. Der Schweizer Dipl. Physiker Dr. rer. nat. Philipp Zeller beschäftigt sich schon über 30 Jahre mit den Methoden des Geo-Engineerings. In diesem Vortrag (45-Minuten) stellt er einige vor, die alle Anwendung finden.

Wer sich doppelt so lange damit beschäftigen möchte, derselbe Physiker, Vortrag nur wissenschaftlicher aufgebaut.

Halten wir für den weiteren Verlauf fest: Die DWD-Temperaturdatenreihen und damit der Deutsche Wetterdienst selbst widerlegen die starke Wirkung eines CO₂-Treibhauseffektes: CO₂ wirkt allerhöchstens in homöopathischen Dosen versteckt mit.

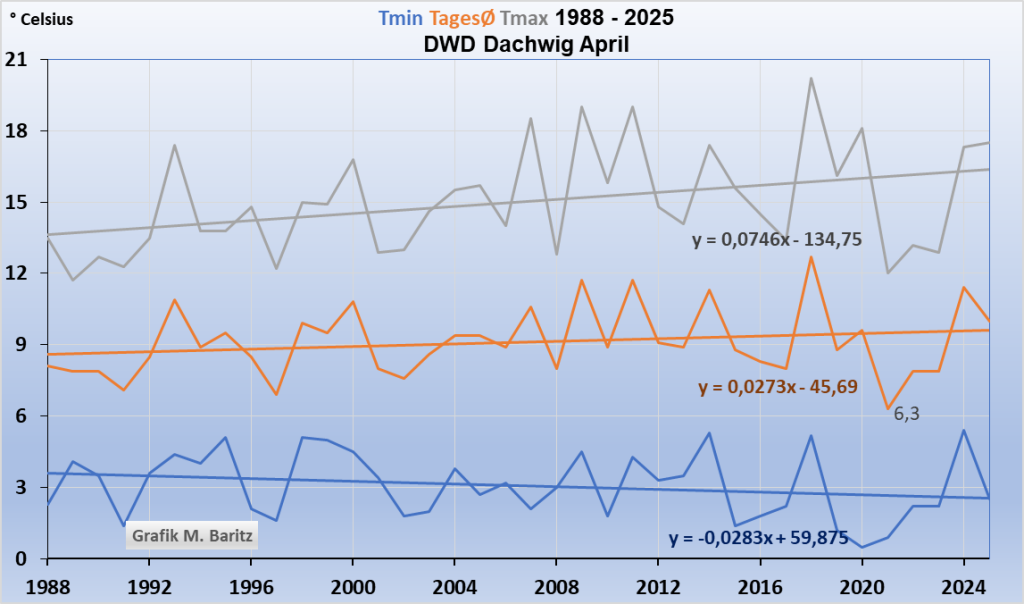

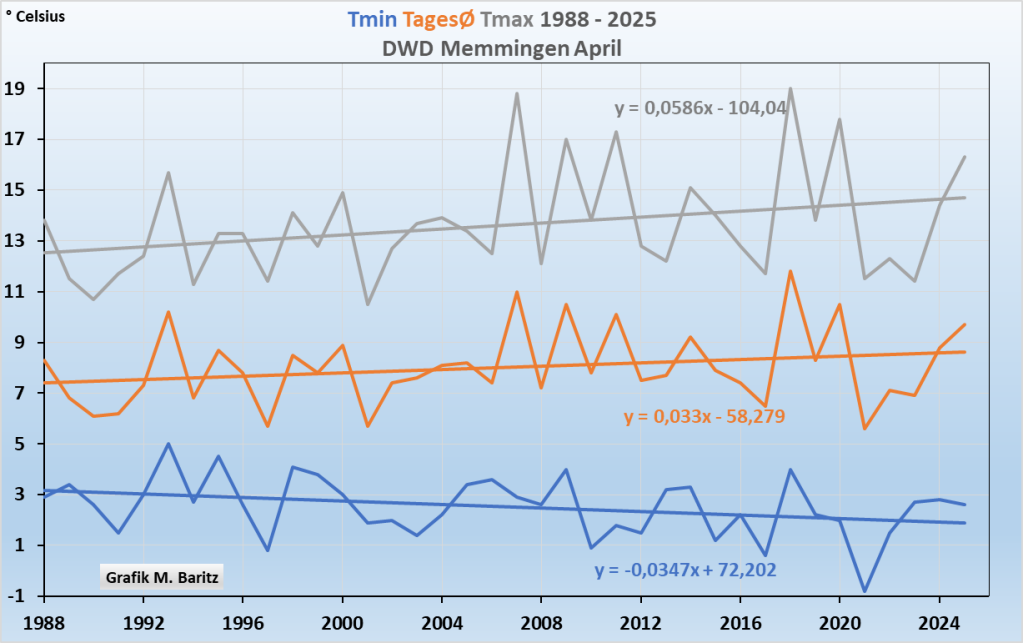

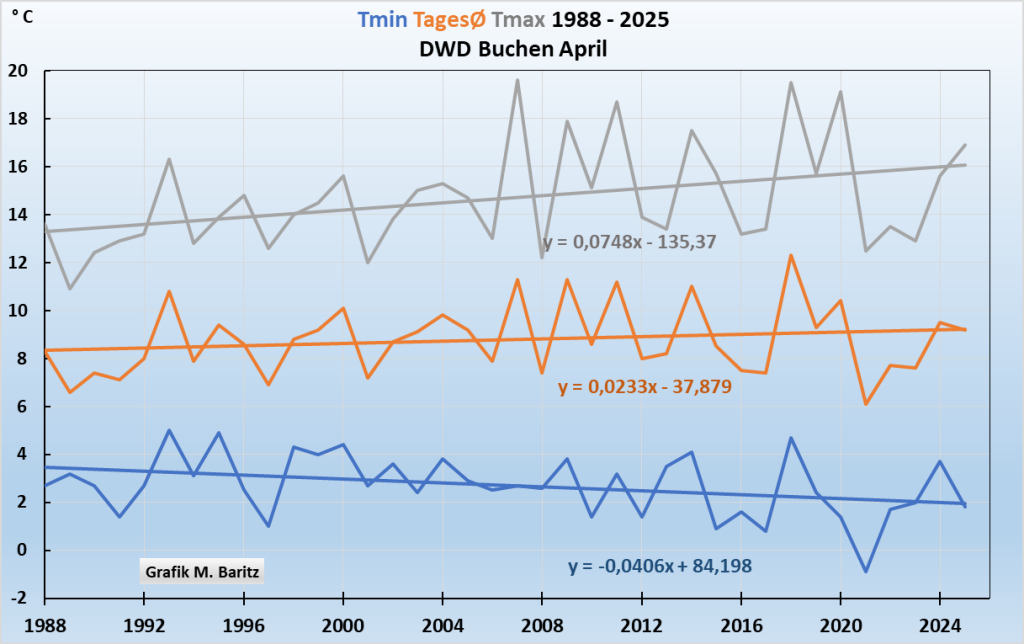

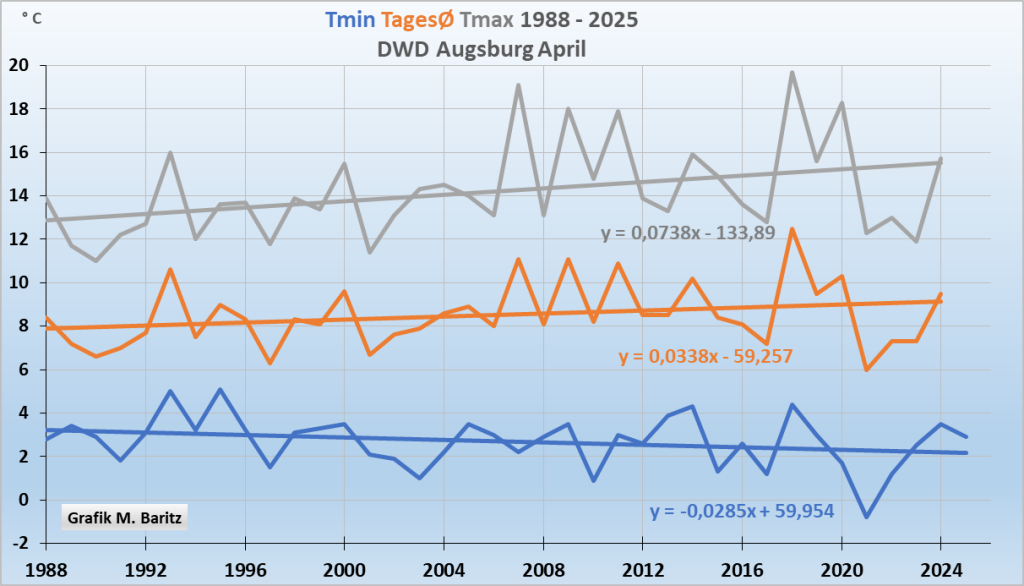

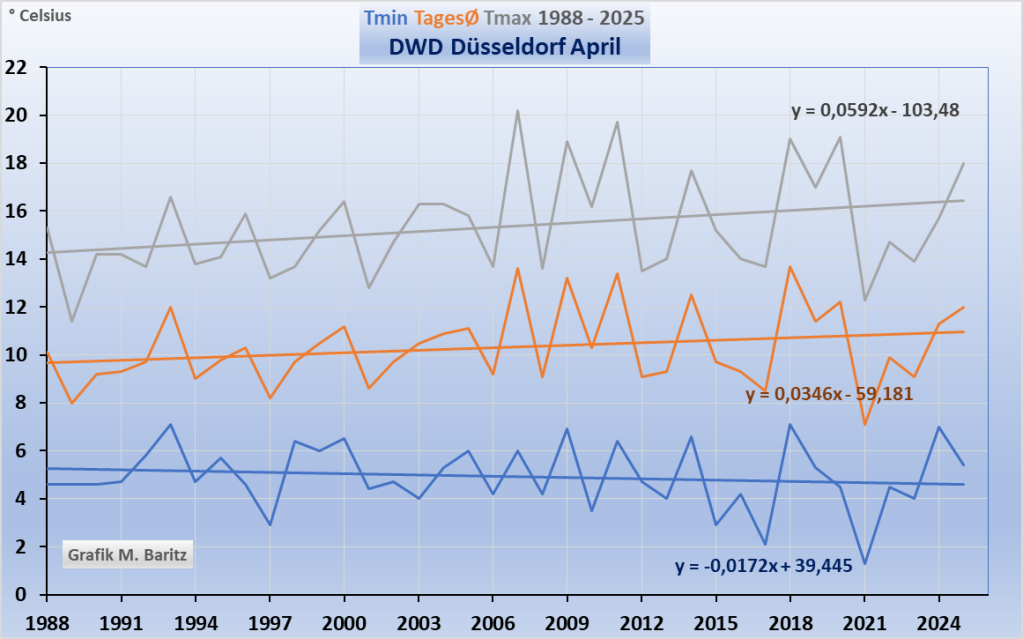

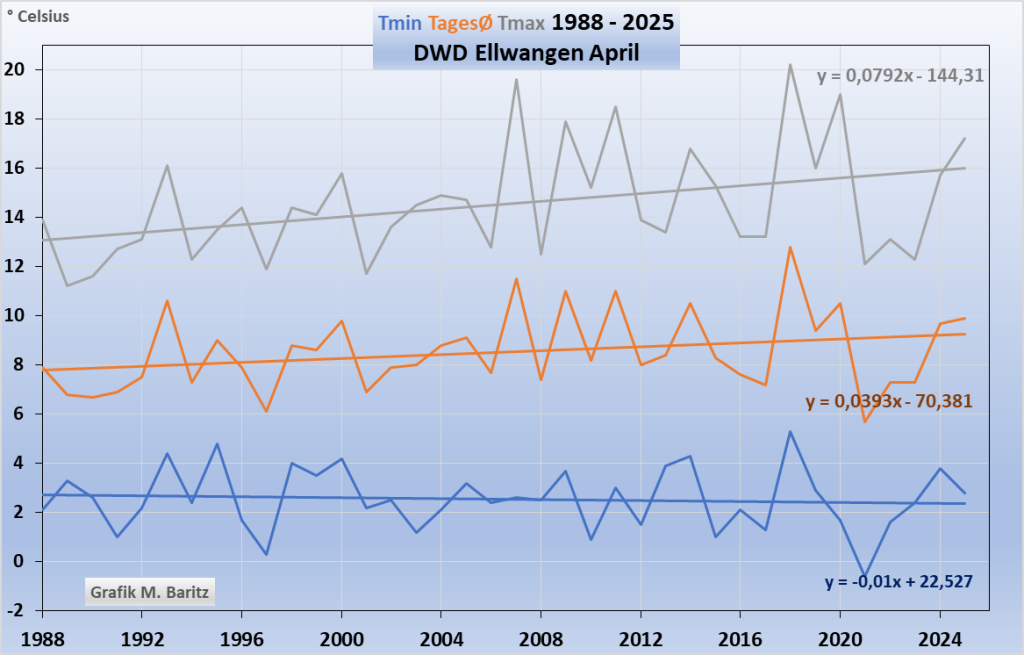

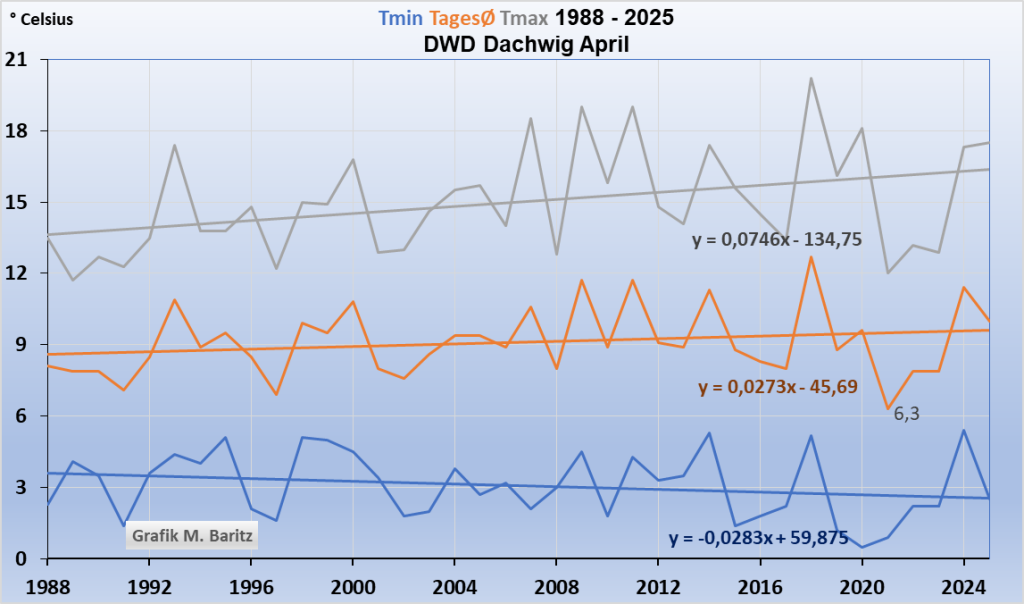

Hier noch einige DWD-Einzelstationen. Wie oben erwähnt dürfte es bei einer alleinigen CO₂-Wirkung zumindest in Mitteleuropa keine Unterschiede geben. Bitte auf die Scherenöffnung und die Differenzen von Tmax zu Tmin achten.

Zunächst drei Wetterstationen in Stadtnähe

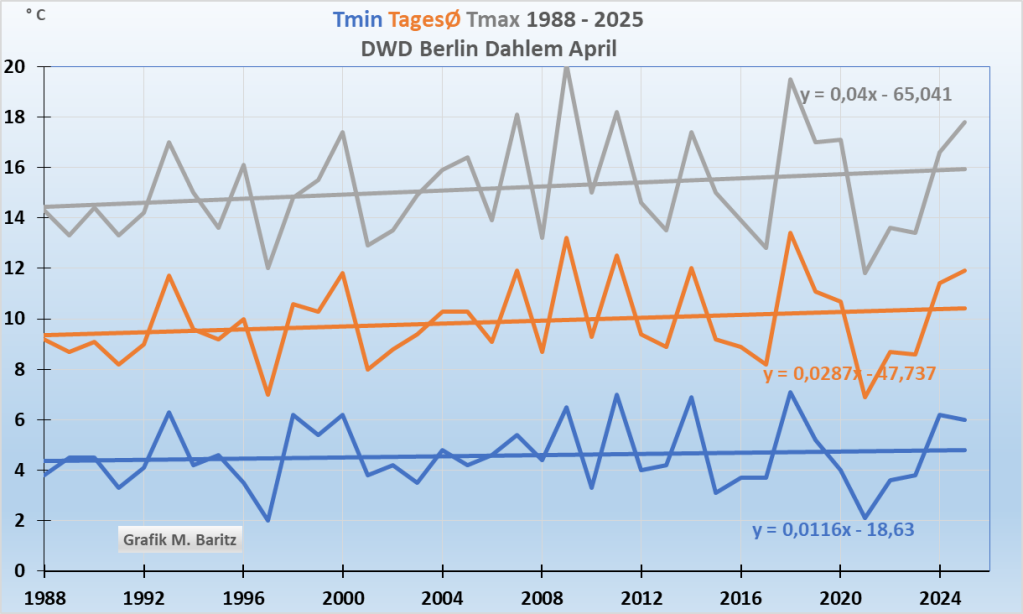

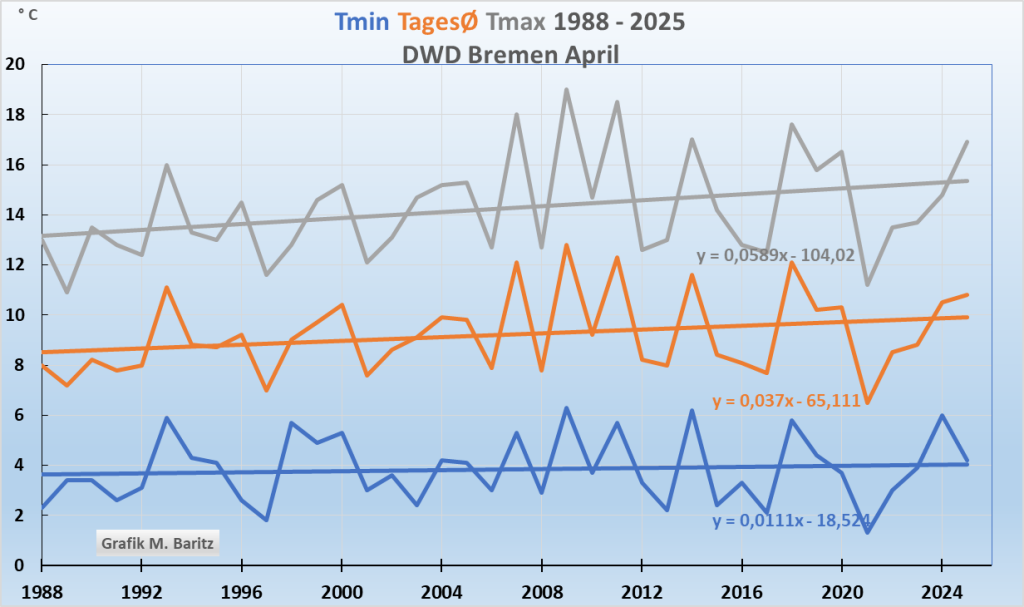

Grafiken 4a bis 4c: Stadtnähe: Im April beobachten wir große Scherenöffnungen zwischen Tag/Nacht, nachts wurde der April bei Wetterstationen in Stadtnähe kälter, siehe Trendlinien mit negativer Steigungsformel.

Schon nach 3 DWD-Wetterstationen zeigt sich deutlich:

Ergebnis 1: Die Aprilnächte wurden kälter seit 1988, die Tage hingegen deutlich wärmer. Die mittlere braune Grafik ist eher die Resultierende aus Tag/Nachtverlauf.

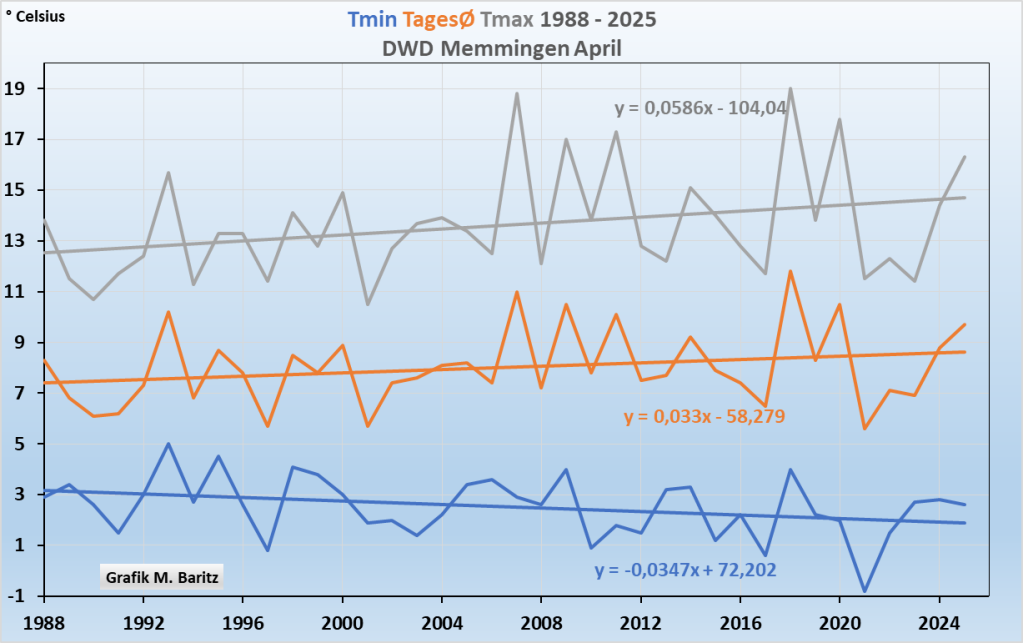

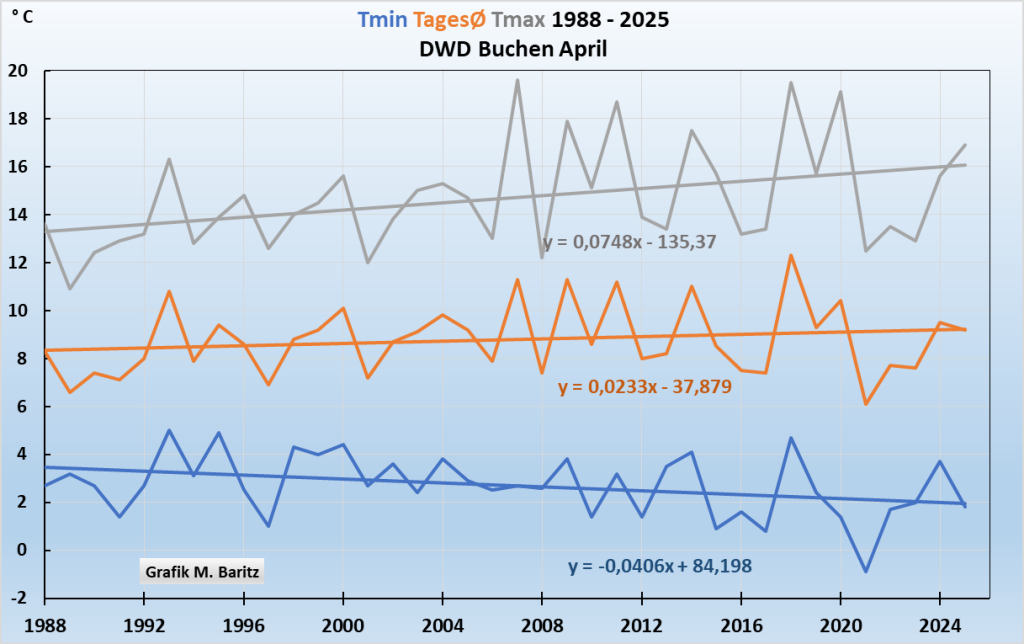

Weiter geht es mit drei eher ländlichen Stationen: Grafiken 4d – 4f:

Schon jetzt sieht man, dass die Aprilnächte im ländlichen Bereich nachts deutlich kälter wurden. Ein klarer Beweis gegen die Treibhaustheorie, wonach CO₂ der Haupterwärmungstreiber wäre und nachts auch noch stärker wirken würde als tagsüber.

Ergebnis 2: Die Schere zwischen Tageshöchst- und den nächtlichen Tiefst-Temperaturen öffnet sich immer weiter. Der April wird vor allem auf dem Lande nachts eindeutig kälter seit 1988. Und das freie Land ist die Hauptfläche Deutschlands

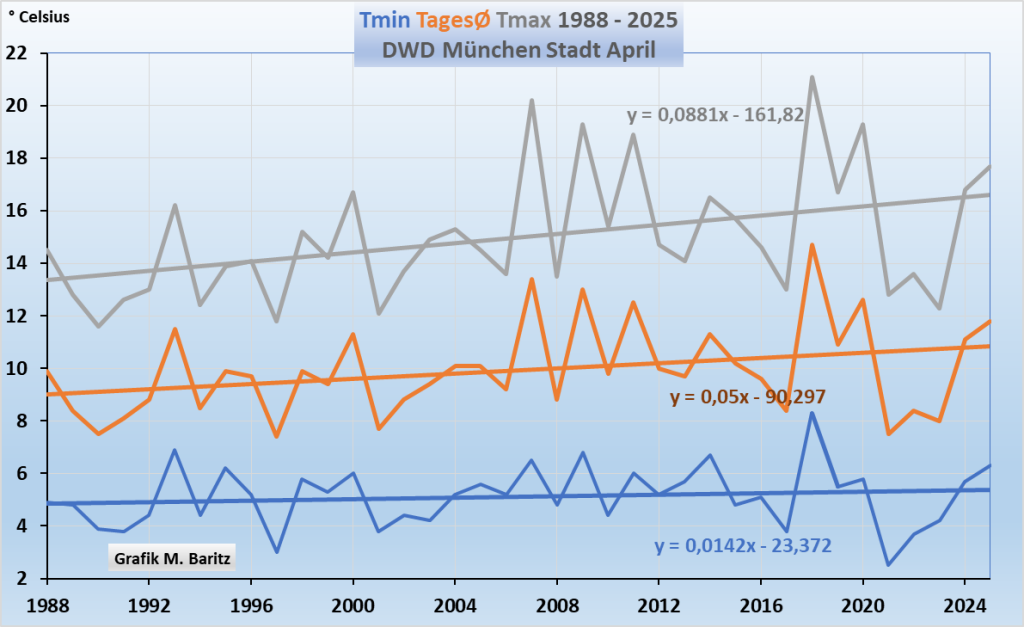

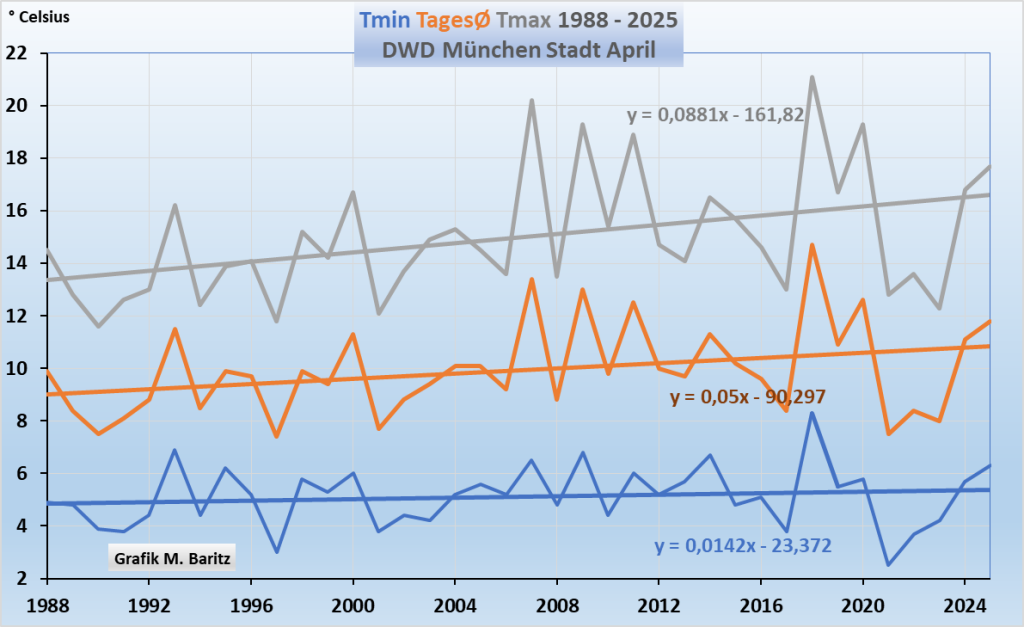

Und hier noch ausgesprochen städtische Stationen, mitten in der Wärmeinsel München:

Auch in einer ausgesprochenen städtischen Wärmeinsel gibt es deutliche Unterschiede im Apriltemperaturverlauf zwischen Tag und Nacht. Allerdings ist die nächtliche Tmin-Trendlinie nicht fallend, sondern eher ausgeglichen bis leicht steigend. Wir erklären es damit, dass die kalten Aprilnächte einfach aus der Stadt hinaus geheizt werden.

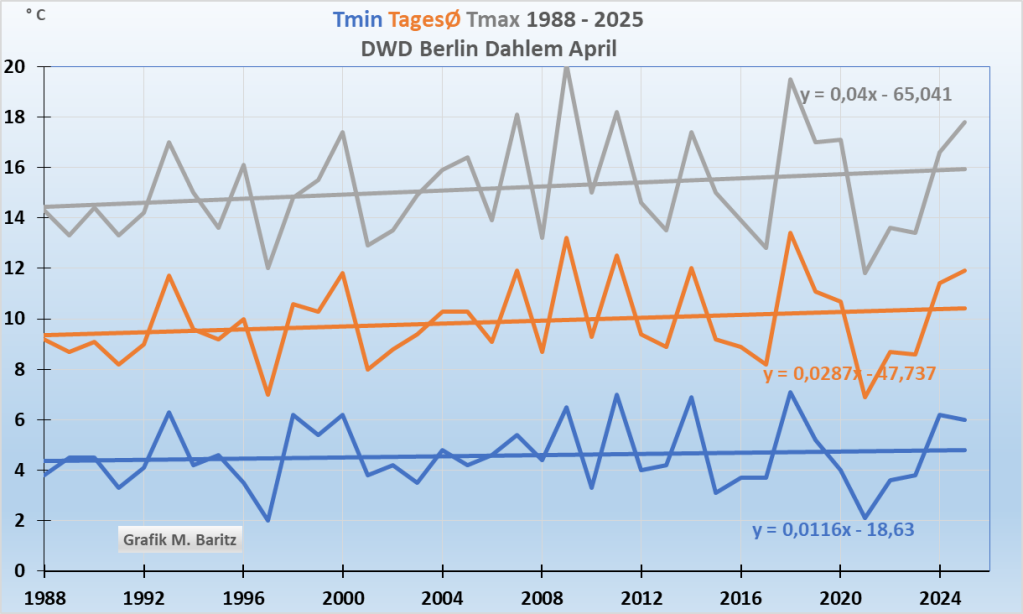

Ähnliches gilt auch für die Wetterstationen in Berlin, hier als Beispiel Dahlem:

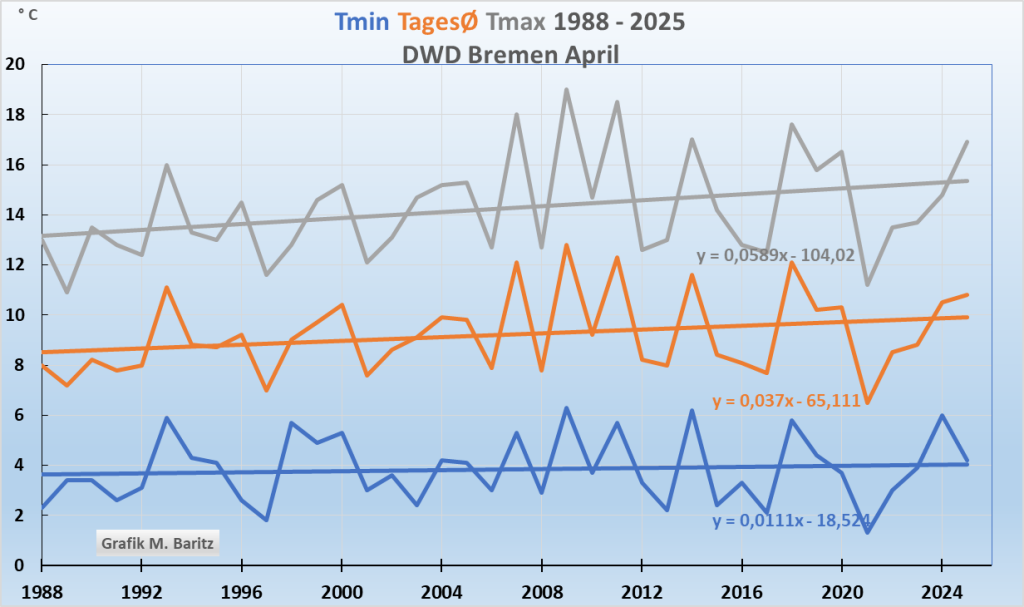

Bremen: hier wirkt zusätzlich die Nordseenähe mit:

Abb. 4g bis i: Auch in Großstädten erwärmen sich die Tage tagsüber viel stärker, die Nächte bleiben ausgeglichen bis leicht zunehmend. Die kalten Aprilnächte werden hinaus geheizt, in Bremen zusätzlich durch die Nordsee. Die Scherenöffnung zwischen Tmax/Tmin ist nicht ganz so stark.

Ergebnis 3: alle Grafiken zeigen, die Aprilerwärmung seit 1988 fand im Gebietsmittel Deutschlands nur tagsüber statt. Selbst bei städtischen Wärmeinselwetterstationen wurden die Aprilnächte durch die Wirkungen des städtischen Wärmeinseleffektes leicht wärmer. Keinesfalls wirkt ein Treibhauseffekt nachts stärker wie die Theorie nobelpreisausgezeichnet behauptet.

Der völlig unterschiedliche Verlauf der Tmax und Tmin Temperaturen sind der eindeutige Beweis, dass die CO₂-Konzentrationsänderungen überhaupt keinen oder fast keinen Einfluss auf irgendwelche Temperaturen haben.

Für Zweifler: Bei Sonnenuntergang kann eine CO₂-Erwärmungswirkung nicht aussetzen, um dann anderntags bei Sonnenaufgang tagsüber wieder zu wirken. Derartige Gaseigenschaften gibt es nicht.

Und nicht vergessen: der Treibhauseffekt soll laut Treibhaustheorie nachts stärker wirken als tagsüber.

Man muss richtigerweise folgern: Die physikalische CO₂-Erwärmungstheorie mit den behaupteten hohen Klimasensitivitätswerten zwischen 2 und 5 Grad ist eindeutig falsch. Und CO₂ ist schon gar kein Temperaturregelknopf, denn diese linksgrüne politische Meinungsmache, die vor allem in Deutschland gilt, würde bedeuten, dass ausschließlich Kohlendioxid die Temperaturen rauf und runter regelt.

Richtig ist vielmehr diese Aussage: CO₂ hat auf den Temperaturverlauf der Atmosphäre keine erkennbare Wirkung. Auch wenn CO₂ im Infrarotbereich absorbiert, und emittiert – was physikalisch richtig ist – dann sollten sich Physiker endlich überlegen, weshalb diese Tatsache in der Gesamtatmosphäre keine Rolle spielt, warum es zu keinen „Thermalisierungen“ kommt und keine CO₂-basierten Erwärmungen gemessen und bestätigt werden können.

Letztlich hat der Großversuch bei der Sprengung der Ostseepipeline gezeigt, dass selbst das 50 mal stärkere Treibhausgas Methan zu keinerlei messbaren Erwärmungen über der Ostsee geführt hat. Die behauptete Thermalisierung der Luft durch Treibhausgase findet nicht oder nur in homöopathischen, nicht messbaren Dosen statt.

Außerdem: Es gibt auch keinerlei technische Anwendung des behaupteten CO₂-Erwärmungeseffektes oder sonstiger positiver Treibhauseffekte anderer Gase, die wir Menschen uns zunutze machen könnten.

Zusammenfassung:

1a) Die DWD-Aprilmitteltemperatur 2025 aller Stationen von 10,5°C ist zu hoch im Vergleich zu früher. Die heutigen Wetterstationen stehen im Vergleich zu früher eher in Wärmeinseln. Außerdem hat sich in den letzten zwei Jahrzehnten die Messerfassung geändert. Die Wetterhütte ist abgeschafft und die neuen Digital-Einheiten müssen laut neuer DWD-Norm frei in der Sonne stehen.

1b) Somit richtet sich der Trendlinienverlauf tagsüber hauptsächlich nach der Zunahme der Aprilsonnenstunden, die überall in Deutschland zunehmend sind.

2) Die Grafiken des Artikels zeigen allesamt: CO₂ hat keinen erkennbaren Einfluss auf das Temperaturverhalten.

3) Die Erwärmung seit dem Temperatursprung 1987/88 fand aber nur am Tage statt. Die Nächte wurden entgegen der Treibhaustheorie nicht wärmer. Auch dieser Umstand ist ein deutlicher Beweis, dass CO₂ nichts mit den Temperaturen der Atmosphäre zu tun hat. Es gibt allerhöchstens Zufalls-Koinzidenzen zwischendurch für kurze Zeitabschnitte.

4) Der Monat April nimmt bereits vorweg, was die Sommermonate bis in den Herbst hinein noch deutlicher zeigen werden: Die Klimaerwärmung Deutschlands fand erst ab 1988 und nur tagsüber statt.

5) Alle teuren Maßnahmen zur CO₂-Reduzierung sind ein Geschäftsmodell und ändern am Temperaturverlauf überhaupt nichts. Sie müssen sofort eingestellt werden, weil diese unser Land ruinieren.

6) Es wird Zeit, dass endlich Natur- und Umweltschutz in den Mittelpunkt einer allumfassenden Politik gestellt werden. Der Erhalt einer sauberen Luft, sauberes Wasser und intakte Naturlandschaften mit genügend Bodenfeuchte sollten das gemeinsame Ziel sein und nicht die planmäßige Angstmacherei, die Klimahysterie mit einem angeblichen und nur erfundenen Treibhausgas.

7) Das Leben auf der Erde ist auf dem Element Kohlenstoff aufgebaut. Kohlendioxid ist das Transportmittel für den Kohlenstoff. Die Erde braucht höhere CO₂-Konzentrationen in der Atmosphäre und nicht weniger. Der CO₂-Optimumsbereich für die Schöpfung Erde sollte endlich wissenschaftlich erforscht werden

8) Wer CO₂ verdammt als Klimakiller oder Klimagift, versündigt sich an der Schöpfung. Das gilt insbesondere für die beiden christlichen Kirchen.

9) Wir alle sind aufgerufen, diesem unheilvollen Geschäftsmodell Klimahysterie durch Kohlendioxid ein Ende zu bereiten. Jeder so wie er kann und wie er es für richtig hält. Eine Klimakatastrophe ist weit und breit nicht in Sicht. Die in den Medien ständig verkündeten Panikmeldungen sind entweder Übertreibungen oder Folgen einer bisher verfehlten Natur- und Umweltpolitik

Josef Kowatsch, Naturbeobachter, aktiver Natur- und Umweltschützer

Matthias Baritz, Naturwissenschaftler und Naturschützer

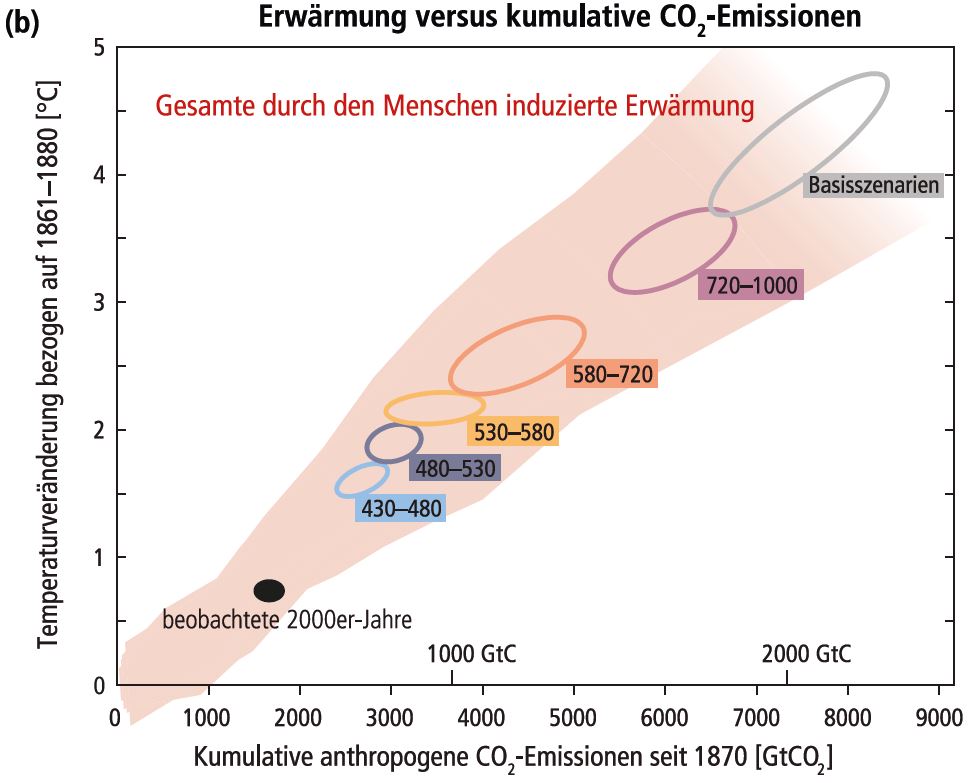

Abbildung 1: „Erwärmung versus kumulative CO2-Emissionen – Quelle:

Abbildung 1: „Erwärmung versus kumulative CO2-Emissionen – Quelle: