Pat Frank

„LiG Metrology, Correlated Error, and the Integrity of the Global Surface Air Temperature Record“ (LiG-Metrologie, korrelierte Fehler und die Integrität der globalen Aufzeichnungen der Lufttemperatur) hat die Begutachtung durch Fachkollegen bestanden und wurde nun in der MDPI-Zeitschrift Sensors (pdf) veröffentlicht.

Die Arbeit ergänzt Anthonys revolutionäres Projekt der Oberflächenstationen, da sich die forensische Analyse auf ideal platzierte und gewartete meteorologische Sensoren konzentriert.

Die Erfahrung bei Sensors war wunderbar normal. Die Einreichung erfolgte ganz sachlich. Der Manuskriptredakteur hat die Einreichung nicht abgelehnt. Die Gutachter äußerten konstruktive Kritik. Es gab keine Verteidigung einer bevorzugten Erzählung. Es gab keine abwertende Sprache.

MDPI hat auch einen bewundernswerten Ansatz für Kontroversen. Die Redakteure „ignorieren die Blogosphäre“. Der Wettbewerb der Ideen findet in der Zeitschrift statt, unter den Augen der Öffentlichkeit, und kritische Kommentare müssen die Peer-Review bestehen. Drei mal Hurra! für MDPI.

LiG Metrology… (im Folgenden LiG Met.) bringt instrumentelle Verfahren für die Aufzeichnung der globalen Lufttemperatur zurück. Eine seit 40 Jahren überfällige forensische Untersuchung des Flüssigkeits-Glas-Thermometers (LiG).

Der Aufsatz ist ein bisschen lang und kompliziert. Aber die ihm innewohnende Botschaft ist einfach:

1. Die Leute, welche die globale Aufzeichnung der Lufttemperatur erstellen, verstehen nichts von Thermometern.

2. Die Geschwindigkeit oder das Ausmaß der Klimaerwärmung seit 1900 ist nicht bekannt.

Die globale Temperatur rückte mit dem Science-Artikel von Starr und Oort aus dem Jahr 1973 mit dem Titel Five-Year Climatic Trend for the Northern Hemisphere ins Blickfeld. 1983 lag der Charney-Report mit dem Titel [übersetzt] Kohlendioxid und Klima vier Jahre zurück, Stephen Schneider hatte sich bereits zum Thema CO₂ und Klimagefahr geäußert, Jim Hanson veröffentlichte seine Klimamodelle, Eiskern-CO₂ wurde bewertet, und der Trend der Lufttemperatur rückte in den Mittelpunkt des Interesses.

Die Lufttemperatur war zum zentralen Thema geworden. Was war ihre Botschaft?

Um das herauszufinden, hätte die Zuverlässigkeit der Temperatur-Aufzeichnungen in den Vordergrund gerückt werden müssen. Aber das geschah nicht. Die Messungen wurden für bare Münze genommen.

Fehler und Unsicherheiten wurden als außerhalb des Instruments liegend betrachtet; eine Ansicht, die sich bis heute hält.

LiG Met. holt das Versäumnis mit 40 Jahren Verspätung nach und beginnt mit den Nachweisgrenzen meteorologischer LiG-Thermometer. Die Abhandlung ist lang und deckt viel Terrain ab. Diese kurze Zusammenfassung beginnt mit einem absolut entscheidenden Konzept in der Messwissenschaft und -technik, nämlich:

I. Instrumentelle Nachweisgrenzen: Die Nachweisgrenze gibt das Ausmaß der physikalischen Veränderung (z. B. eine Temperaturänderung ΔT) an, auf die ein bestimmtes Instrument (z. B. ein Thermometer) zuverlässig reagieren kann.

Jede Anzeige, die unterhalb der Nachweisgrenze liegt, hat keine offensichtliche physikalische Bedeutung, da das Instrument nicht zuverlässig auf diese Größenordnung der Störung anspricht. (Das Thema ist kompliziert; siehe hier und hier.)

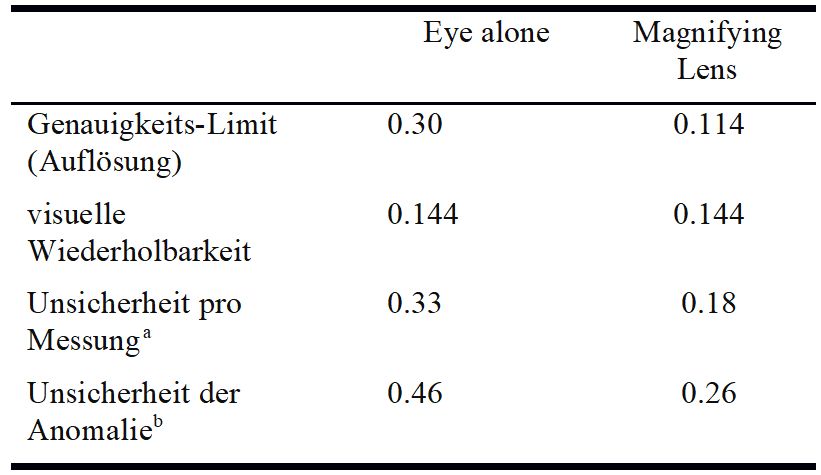

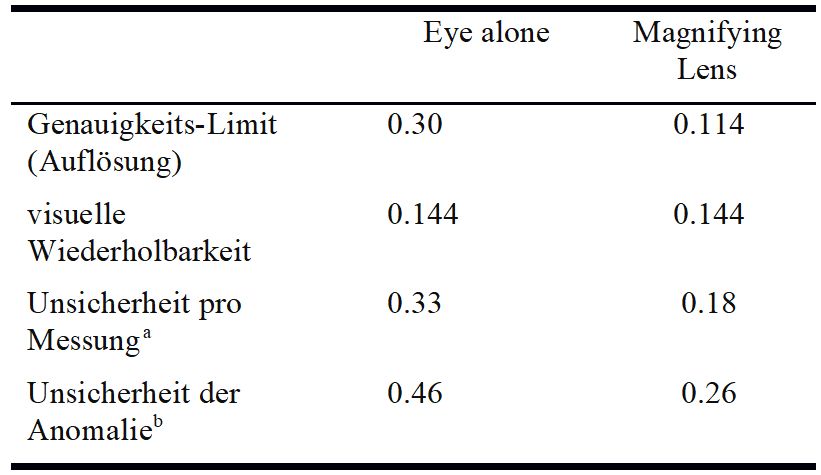

Die folgende Tabelle enthält die untere Auflösungsgrenze – die Nachweisgrenzen – von Quecksilber-LiG-Thermometern mit 1°C/Teilung, wie sie vom National Institute of Standards and Technology (NIST) ermittelt wurden.

NIST 1C/Teilung Quecksilber-LiG-Thermometer Kalibrierungsauflösungsgrenzen (2σ, ±C)

Tabelle: a. Wurzel-Summe-Quadrat der Auflösung und visuelle Wiederholbarkeit. b. Die Unsicherheit einer Anomalie ist das Wurzel-Summe-Quadrat der Unsicherheiten in den unterschiedenen Größen.

Dies sind die idealen unteren Grenzen der Unsicherheit, die man bei Messungen eines sorgfältigen Forschers mit einem qualitativ hochwertigen LiG-Thermometer mit 1°C/Division erwarten sollte. Die Messunsicherheit kann nicht geringer sein als die untere Grenze der instrumentellen Reaktion.

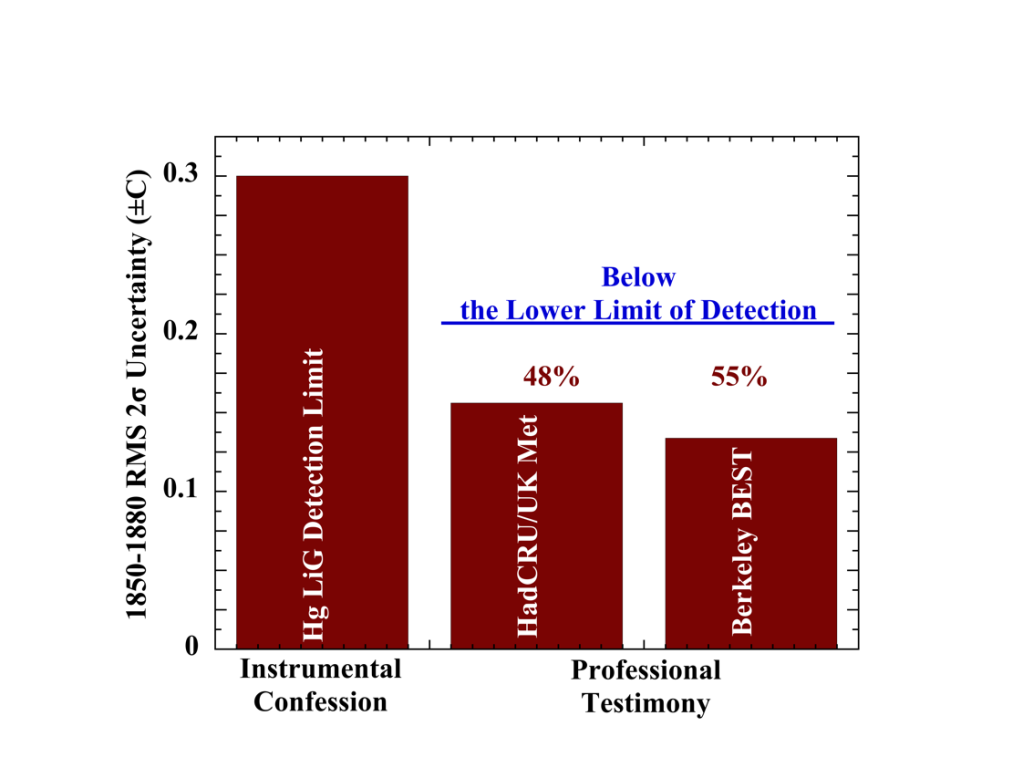

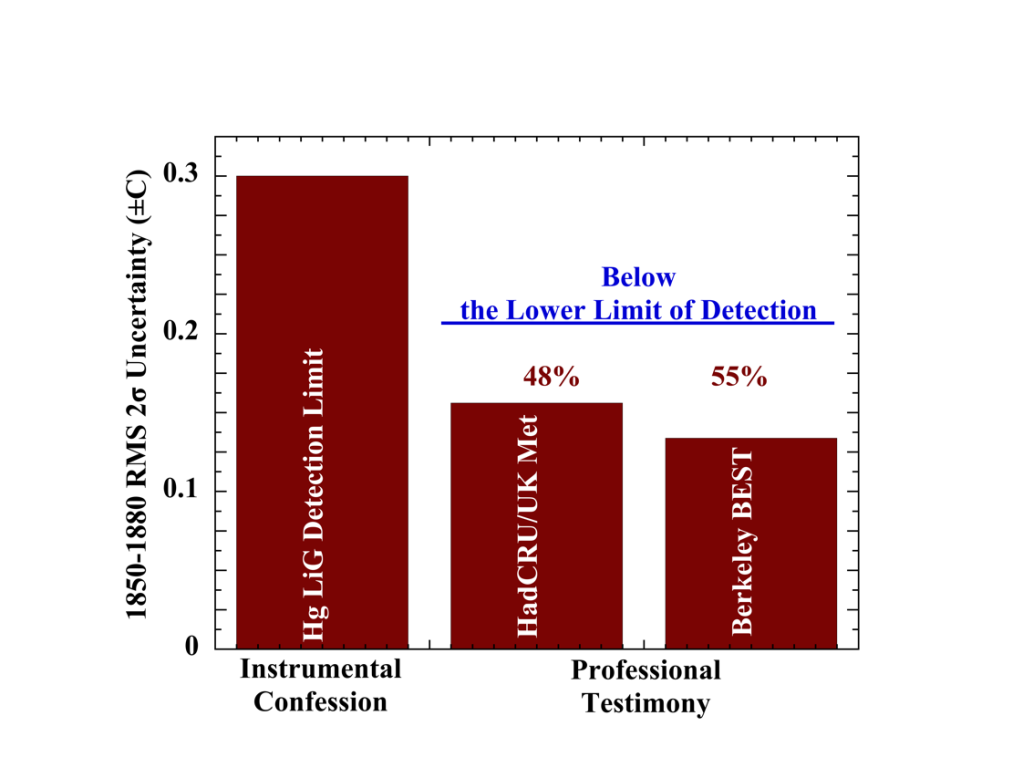

Die NASA/GISS-Aufzeichnung der Lufttemperatur-Anomalien beginnt im Jahr 1880. Die größten Unsicherheiten in den modernen Aufzeichnungen der globalen Lufttemperatur-Anomalien finden sich jedoch in den Jahrzehnten 1850-1879, die von HadCRU/UKMet und Berkeley BEST veröffentlicht wurden. Die 2σ root-mean-square (RMS) Unsicherheit ihrer globalen Anomalien über 1850-1880 ist: HadCRU/UKMet = ±0.16 C und Berkeley BEST = ±0.13 C. Grafisch dargestellt:

Abbildung 1: Die LiG-Nachweisgrenze und der Mittelwert der Unsicherheit in den globalen Lufttemperatur-Anomalien von 1850-1880, veröffentlicht von der Hadley Climate Research Unit der University of East Anglia in Zusammenarbeit mit dem UK Meteorological Office (HadCRU/UKMet) und dem Berkeley Earth Surface Temperature Project (Berkeley BEST).

Das bedeutet, dass die veröffentlichten Unsicherheiten etwa die Hälfte der unteren instrumentellen Nachweisgrenze betragen – eine physikalische Unmöglichkeit.

Die Unmöglichkeit nimmt mit der Verringerung der späteren Unsicherheiten zu (Abbildung 6, unten). Diese Merkwürdigkeit zeigt das Problem, das sich durch den gesamten Bereich zieht: die Vernachlässigung der Grundlagen.

Zusammenfassend (vollständige Details und grafische Demonstrationen in LiG Met.):

Nichtlinearität: Sowohl Quecksilber als auch insbesondere Ethanol (Spiritus) dehnen sich nichtlinear mit der Temperatur aus. Der daraus resultierende Fehler ist bei Quecksilber-LiG-Thermometern gering, bei der Alkoholvariante jedoch erheblich. In der Standard-Oberflächenstation vor 1980 lieferte ein Alkoholthermometer Tmin, was 2σ = ±0.37 C an Unsicherheit in jeden täglichen Tmean der Landoberfläche bringt. Der Temperaturfehler aufgrund der Nichtlinearität der Reaktion ist in den historischen Aufzeichnungen unkorrigiert.

Joule-Drift: Bei der Alterung von Thermometern, die vor 1885 hergestellt wurden, kommt es zu einer erheblichen Kontraktion des Thermometerkolbens, die bei Thermometern aus Bleiglas am schnellsten eintritt. Durch die Joule-Drift wird ein falscher Erwärmungstrend von 0,3-0,7 °C/Jahrhundert in eine Temperaturaufzeichnung eingefügt. Abbildung 4 in LiG Met. zeigt das Pb-Röntgenfluoreszenzspektrum eines meteorologischen Spiritusthermometers aus dem Jahr 1900, das vom US Weather Bureau gekauft worden war. Unmöglich zu korrigierende Fehler aufgrund der Joule’schen Drift machen die gesamte Aufzeichnung der Lufttemperatur vor 1900 unzuverlässig.

Die Bedeutung der Auflösung: Alle diese Fehlerquellen und Unsicherheiten – Nachweisgrenzen, Nichtlinearität und Joule-Drift – sind dem LiG-Thermometer inhärent und hätten von Anfang an bewertet werden müssen. Und zwar bevor man ernsthaft versucht hat, eine Aufzeichnung der historischen globalen Temperatur zu erstellen. Das ist jedoch nicht geschehen. Sie wurden rundheraus vernachlässigt. Am schockierendsten ist vielleicht die professionelle Vernachlässigung der instrumentellen Nachweisgrenze.

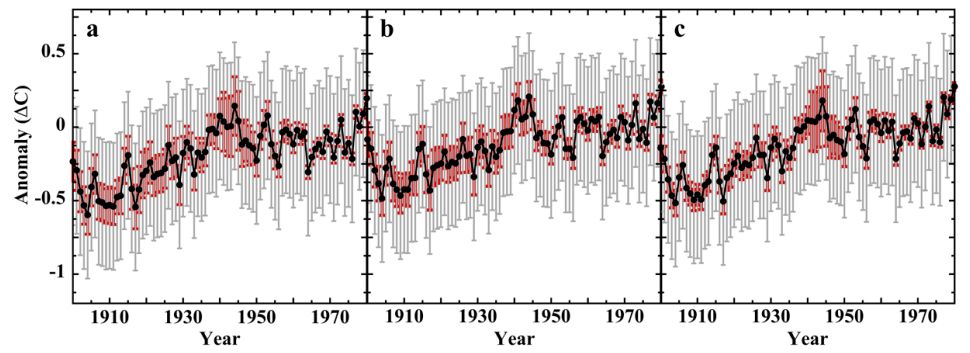

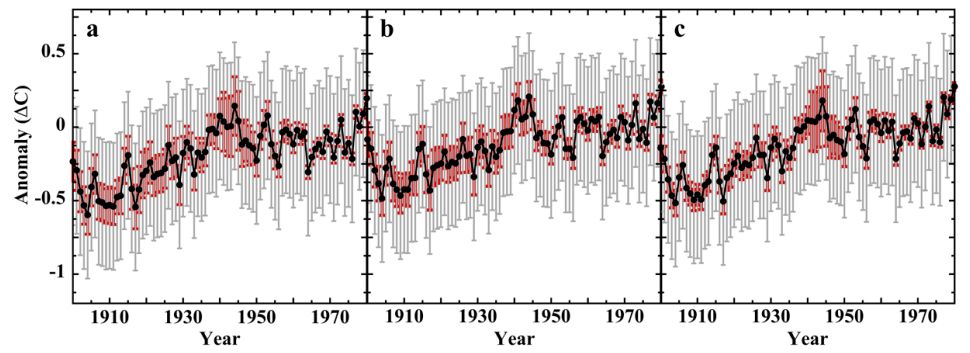

Abbildung 2: (Punkte), globale Lufttemperaturanomalien 1900 – 1980 für: Tafel a, HadCRUT5.0.1.0 (veröffentlicht bis 2022); Tafel b, GISSTEMP v4 (veröffentlicht bis 2018), und; Tafel c, Berkeley Earth (veröffentlicht bis 2022). Rote Whisker: die veröffentlichten 2σ Unsicherheiten. Graue Whisker: die einheitliche 2σ = ±0.432 C Unsicherheit, die die untere Laborgrenze der instrumentellen Auflösung für eine globale durchschnittliche jährliche Anomalienreihe vor 1981 darstellt.

Abbildung 2 zeigt die Auswirkungen der Nachweisgrenze allein auf die Aufzeichnung der globalen Lufttemperaturanomalien von 1900-1980.

Die Mittelwerte der Landtemperaturen enthalten den unkorrigierten Fehler aufgrund der Nichtlinearität von Flüssigkeitsthermometern. Die Meerestemperaturen (SST) wurden nur mit Quecksilber-LiG-Thermometern gemessen (kein Spiritus-LiG-Fehler). Die Auflösungs-Ünsicherheit für die Aufzeichnung der globalen Lufttemperatur vor 1981 wurde wie folgt berechnet:

2σT = 1.96 x sqrt[0.7 x (SST resolution)² + 0.3 x (LST resolution)²]

= 1.96 x sqrt[0.7 x (0.136)² + 0.3 x (0.195)²] = ±0.306 C, wobei LS die Landoberfläche ist.

Die Veränderung der globalen Lufttemperatur wird jedoch als Anomalienreihe im Verhältnis zu einem 30-jährigen Normalwert angegeben. Die Differenzierung von zwei Werten erfordert die Addition ihrer Unsicherheiten in Quadratur. Die Auflösung einer LiG-basierten 30-Jahres-Normaltemperatur ist ebenfalls 2σ = ±0.306°C. Die Auflösungsunsicherheit in einer LiG-basierten globalen Temperaturanomalienreihe ergibt sich dann aus:

2σ = 1.96 x sqrt[(0.156)² + (0.156)²] = ±0.432°C

In Abbildung 2 reicht der Mittelwert der veröffentlichten Anomalie-Unsicherheiten von 3,9x kleiner als die LiG-Auflösungsgrenze im Jahr 1900 bis 5x kleiner im Jahr 1950 und fast 12x kleiner im Jahr 1980.

II. Systematische Fehler gehen in die globale Unsicherheit ein. Ist der Fehler bei der Temperaturmessung zufällig?

Ein Großteil der Studie testet die Annahme eines zufälligen Messfehlers; eine Annahme, die in Studien zur globalen Erwärmung absolut universell ist.

LiG Met. Abschnitt 3.4.3.2 zeigt, dass die Differenzierung zweier normalverteilter Datensätze eine andere Normalverteilung ergibt. Dies ist eine wichtige Erkenntnis. Wenn der Messfehler zufällig ist, dann sollte die Differenzierung von zwei Sätzen gleichzeitiger Messungen einen normalverteilten Fehlerdifferenzsatz ergeben.

II.1 Der systematische Messfehler der Lufttemperatur an Landoberflächen ist korreliert: Es stellt sich heraus, dass der systematische Kalibrierungsfehler der Temperatursensoren nahe beieinander liegender Sensoren paarweise korreliert ist.

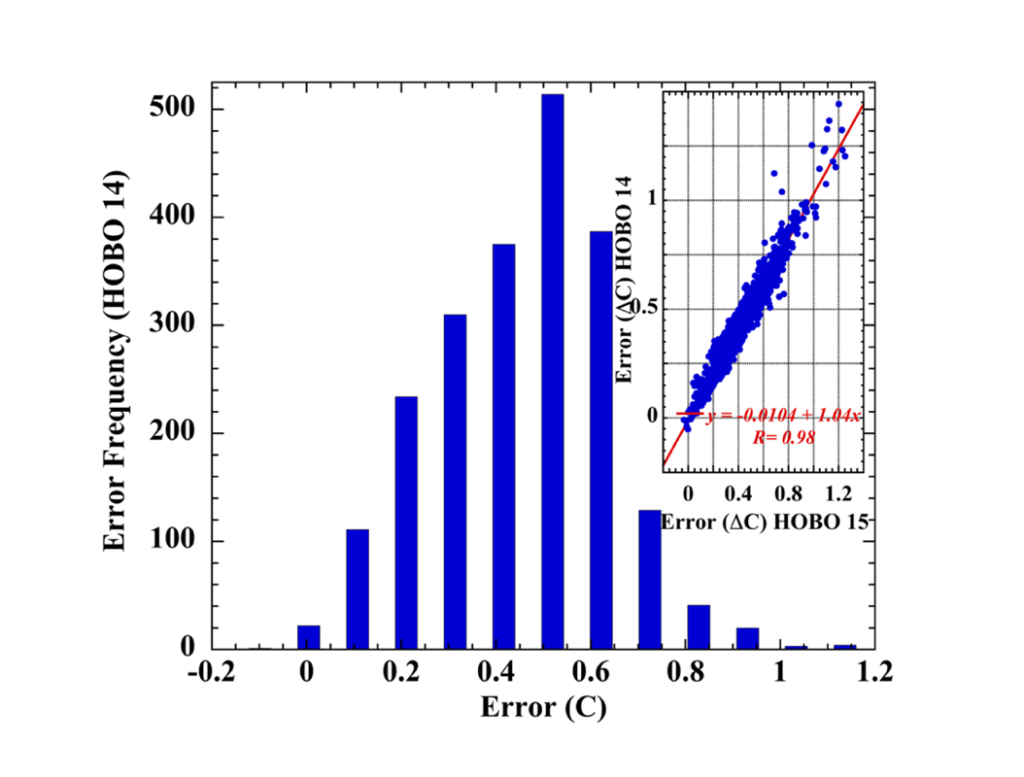

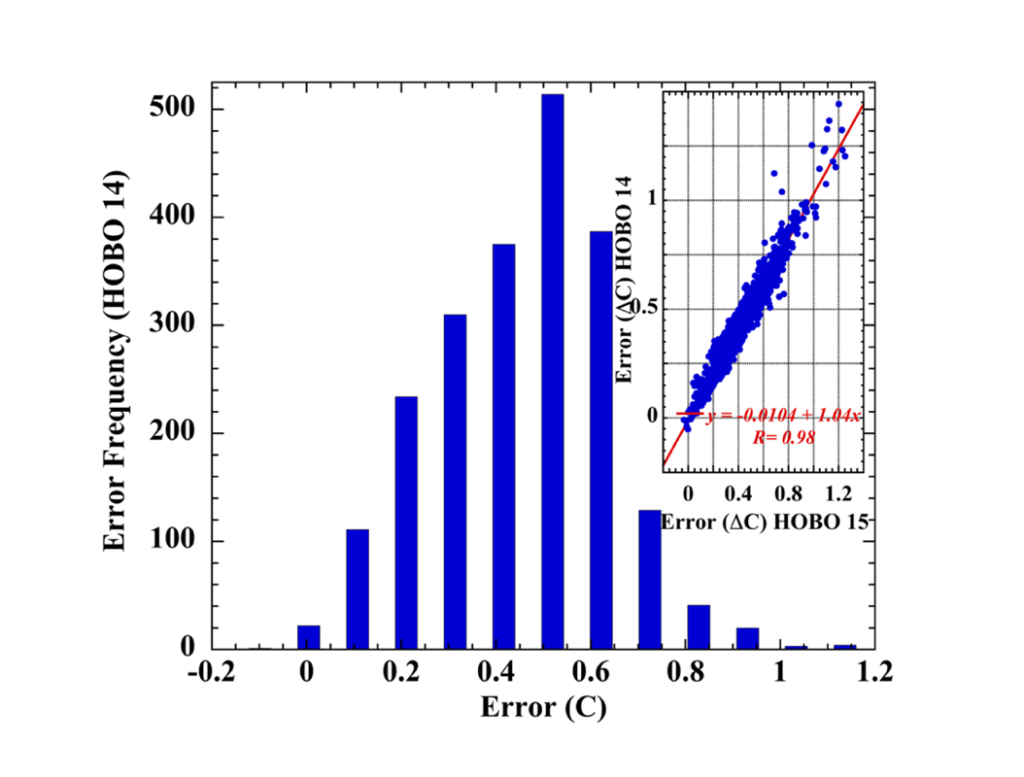

Matthias Mauder und seine Kollegen veröffentlichten eine Studie über die Fehler, die innerhalb von 25 natürlich belüfteten HOBO-Sensoren (Kiemenschild, Thermistorsensor) im Vergleich zu einem angesaugten Met-One-Präzisions-Thermistoren-Standard entstehen. Abbildung 3 zeigt eine paarweise Korrelation der 25 in dieser Versuchsreihe mit einer Korrelation r = 0,98.

Abbildung 3: Histogramm des Fehlers in HOBO Nummer 14 (von 25). Der StatsKingdom online Shapiro-Wilk Normalitätstest (2160 Fehlerdatenpunkte) ergab: 0,979, p < 0,001, statistisch nicht normal. Inset: Korrelationsdiagramm des Messfehlers – HOBO #14 gegenüber HOBO #15; Korrelation r = 0,98.

Es wurden hohe paarweise Korrelationen zwischen allen 25 HOBO-Sensor-Messfehler-Datensätzen gefunden. Der Shapiro-Wilk-Test, der die größte statistische Aussagekraft hat, um die Normalität einer Datenverteilung zu bestätigen oder zu verwerfen zeigte, dass jeder einzelne Messfehlersatz nicht normal war.

LiG Met. und die begleitenden Informationen enthalten mehrere Beispiele für unabhängige Feldkalibrierungsexperimente, die paarweise korrelierte systematische Sensormessfehler ergaben. Die statistischen Shapiro-Wilk-Tests der Kalibrierungsfehler-Datensätze wiesen ausnahmslos auf Nicht-Normalität hin.

Die Korrelation zwischen den Sensoren bei den systematischen Messfehlern der Feldkalibrierung an der Landoberfläche und die nicht normalen Verteilungen der Differenzfehlerdatensätze widerlegen zusammen die allgemeine Annahme eines streng zufälligen Fehlers. Es gibt keine Evidenzbasis, die eine abnehmende Unsicherheit als 1/N zulässt.

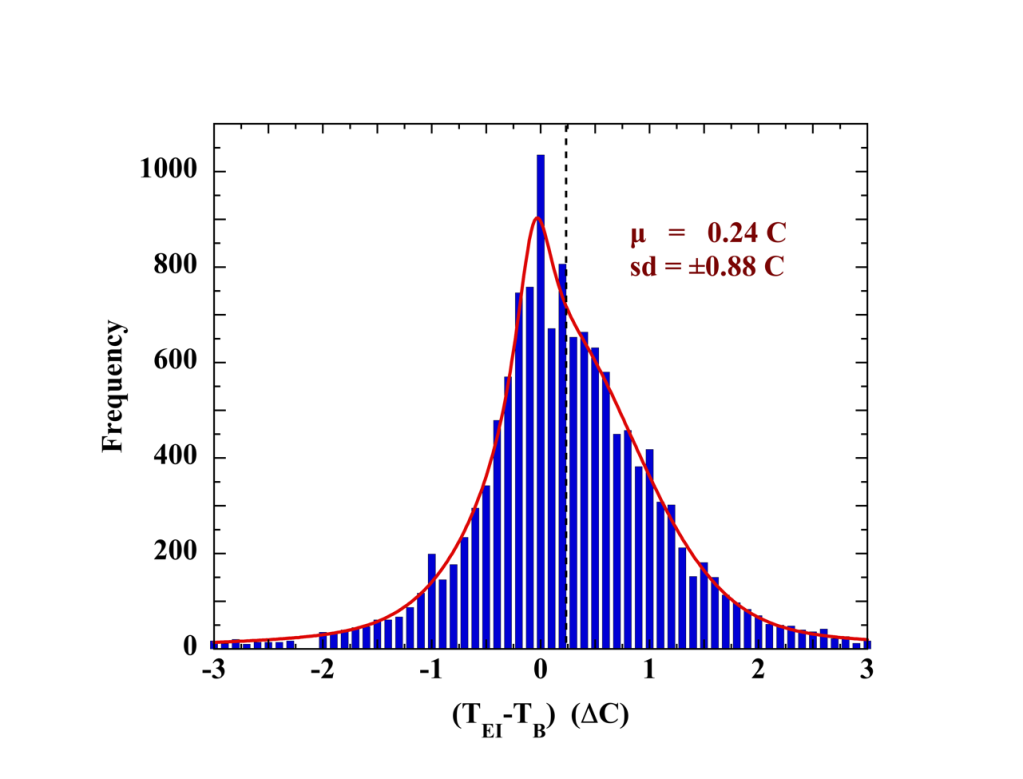

II.2.1 Der Messfehler der Meerestemperatur ist nicht zufällig: Die Differenzierung gleichzeitiger Eimer-Eimer- und Eimer-Motor-Messungen ergibt wiederum die Messfehlerdifferenz Δε2,1. Wenn der Messfehler zufällig ist, sollte ein großer SST-Differenzdatensatz Δε2,1, eine Normalverteilung aufweisen.

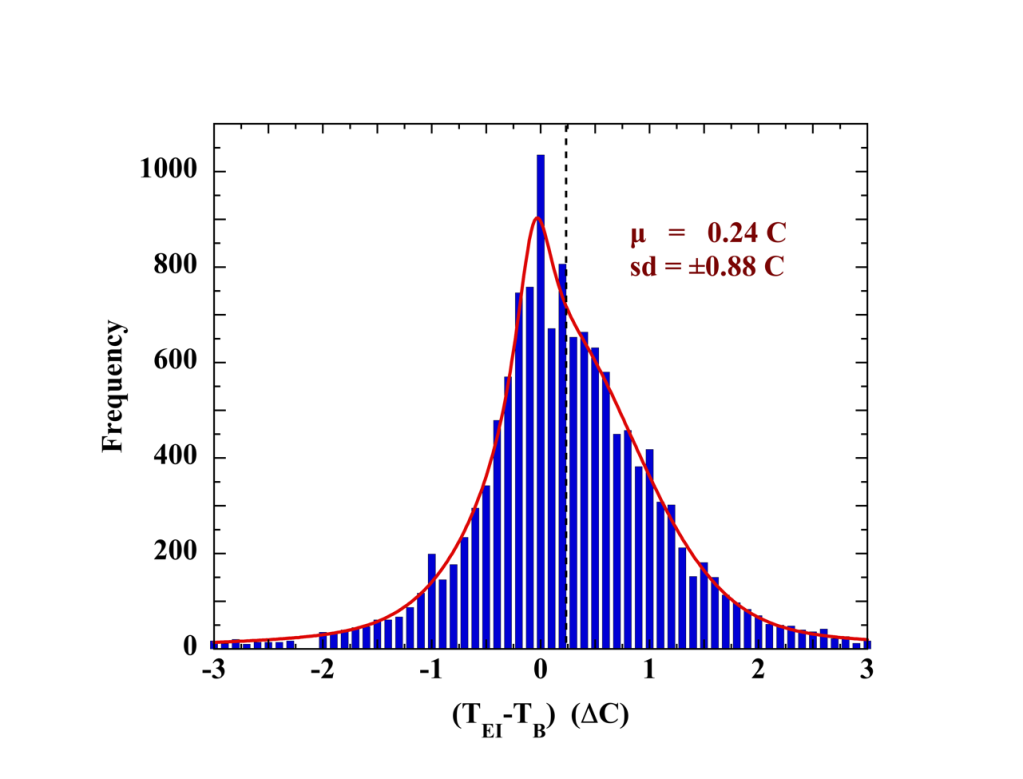

Abbildung 4 zeigt das Ergebnis eines Projekts der Weltorganisation für Meteorologie, das 1972 veröffentlicht wurde und in dem die Differenzen von 13511 gleichzeitig gemessenen SST-Werten von Schiffen aller Art in niedrigen und hohen N,S-Breiten und unter einer Vielzahl von Wind- und Wetterbedingungen erfasst wurden. Die erforderliche Normalverteilung ist nirgends zu finden.

Abbildung 4: Histogramm der Differenzen von 13511 gleichzeitigen SST-Messungen von Motor und Eimer während eines groß angelegten Experiments, das unter der Schirmherrschaft der Weltorganisation für Meteorologie durchgeführt wurde. Die rote Linie ist eine Anpassung mit zwei Lorentzianern und einem Gauß. Die gestrichelte Linie markiert den Mittelwert der Messung.

LiG Met. präsentiert mehrere unabhängige großräumige Eimer/Motoreinlass-Differenzdatensätze von gleichzeitig gemessenen SSTs. Die Verteilungen waren ausnahmslos nicht normal, was zeigt, dass die SST-Messfehler nicht zufällig sind.

II.2.2 Der Mittelwert des SST-Messfehlers ist unbekannt: Das von Geostatistik übernommene Semivariogramm-Verfahren wurde verwendet, um den Mittelwert des SST-Fehlers an Bord abzuleiten (±εmean). Auch hier wird davon ausgegangen, dass der SST-Messfehler streng zufällig ist, jedoch mit einer mittleren Abweichung.

Zieht man εmean ab, so erhält man eine Normalverteilung mit einem Mittelwert von Null und einer Unsicherheit, die mit 1/ N abnimmt.

N abnimmt.

Allerdings zeigt LiG Met. Abschnitt 3.4.2, dass die Semivariogramm-Analyse nicht ±Δεmean, sondern ±0.5Δεmean ergibt, die Hälfte des Mittelwerts der Fehlerdifferenz. Die Subtraktion führt nicht zu einem Mittelwert von Null.

Schlussfolgerung zum SST: II.2.1 zeigt, dass der Messfehler nicht streng zufällig ist. II.2.2 zeigt, dass der Mittelwert des Fehlers nicht bekannt ist. Es gibt keinen Grund mehr, die SST-Unsicherheit als 1/ N abzuschwächen.

N abzuschwächen.

II.2.3 Die SST ist unbekannt: 1964 (LiG Met. Abschnitt 3.4.4) führte Robert Stevenson ein ausgedehntes SST-Kalibrierungsexperiment an Bord des ozeanographischen Forschungsschiffs VELERO IV durch. Dabei wurden gleichzeitig hochpräzise SST-Messungen von der VELERO IV und von einer kleinen Barkasse aus vorgenommen, die vom Schiff aus gestartet wurde.

Stevenson stellte fest, dass das Schiff die umgebenden Gewässer so stark störte, dass die vom Schiff aus gemessenen SST-Werte nicht repräsentativ für die tatsächliche Wassertemperatur (oder Lufttemperatur) waren. Unabhängig davon, wie genau die Temperaturmessung mit dem Eimer, dem Triebwerkseinlass oder der am Rumpf befestigten Sonde war, konnte die wahre SST nicht ermittelt werden.

Die einzige Ausnahme war eine SST, die mit einer am Bug montierten Sonde gemessen wurde, aber nur, wenn das Schiff gegen den Wind fuhr „oder mit einer Geschwindigkeit größer als die Windgeschwindigkeit“.

Stevenson schlussfolgerte: „Man kann dann den Wert der an Bord eines Schiffes oder eines anderen großen Bauwerks auf See gemessenen Temperaturen in Frage stellen. Da die Messungen mit der Windgeschwindigkeit und der Ausrichtung des Schiffes in Bezug auf die Windrichtung variieren, kann kein Faktor zur Korrektur der Daten angewendet werden. Es ist daher wahrscheinlich, dass die Temperaturen nur für grobe Analysen von Klimafaktoren nutzbar sind, außer vielleicht für solche, die mit einer sorgfältig ausgerichteten Sonde gemessen wurden.“

Stevensons Experiment ist vielleicht die wichtigste Untersuchung, die jemals zur Wahrhaftigkeit der von Schiffen gemessenen SST durchgeführt wurde. Das Experiment fand jedoch kaum Beachtung. Es wurde nie wiederholt oder erweitert, und die Frage der Zuverlässigkeit der SST, die das VELERO IV-Experiment aufdeckte, wurde im Allgemeinen übergangen. Die Zeitschrift weist seit 1964 nur 5 Zitate auf.

Dennoch wurden die SST-Werte von Schiffen zur Kalibrierung der Satelliten-SST-Werte wahrscheinlich bis 2006 verwendet. Das bedeutet, dass frühere Satelliten-SSTs nicht unabhängig von der großen Unsicherheit der Schiffs-SSTs sind.

III. Unsicherheit im Trend der globalen Lufttemperaturanomalie: Wir wissen jetzt, dass die Annahme eines rein zufälligen Messfehlers bei LST oder SST nicht gerechtfertigt ist. Man kann nicht davon ausgehen, dass die Unsicherheit mit 1/ N abnimmt.

N abnimmt.

III.1 Für die Landtemperatur wurde die Unsicherheit berechnet aus:

● LiG-Auflösung (Nachweisgrenzen, visuelle Wiederholbarkeit und Nichtlinearität).

● systematischer Fehler von unbelüfteten CRS-Bildschirmen (vor 1981).

● Interpolation von CRS zu MMTS (1981-1989).

● Unbelüftete Sensoren des Min-Max-Temperatursystems (MMTS) (1990-2004).

● Fehler der Sensoren des Klimaforschungsnetzes (CRN) bei der Selbsterhitzung (2005-2010).

Im Zeitraum 1900-1980 wurde die Auflösungsunsicherheit in Quadratur mit der Unsicherheit aus systematischen Feldmessfehlern kombiniert, was zu einer RMS-Gesamtunsicherheit 2 = ±0,57 C in der LST führte.

= ±0,57 C in der LST führte.

III.2Für die Meerestemperatur wurde die Unsicherheit aus der Hg-LiG-Auflösung in Kombination mit dem Mittelwert der systematischen Unsicherheit von Eimer-, Motoreinlass- und Bathythermographen-Messungen, skaliert mit ihrem jährlichen Anteil seit 1900, berechnet.

Die SST-Unsicherheit schwankte aufgrund der jährlichen Veränderung der Anteile von Eimer-, Motoreinlass- und Bathythermographenmessungen. Die Fehler bei der Kühlwasser-Aufnahme dominierten.

Im Zeitraum 1900-2010 betrug die Unsicherheit der SST RMS 2 = ±1.38°C.

= ±1.38°C.

III.3 Global: Jährliche Unsicherheiten in der Landoberfläche und der Meeresoberfläche wurden wieder kombiniert als:

2 T = 1.96 x sqrt[0.7 x (SST uncertainty)² + 0.3 x (LST uncertainty)²]

T = 1.96 x sqrt[0.7 x (SST uncertainty)² + 0.3 x (LST uncertainty)²]

Für den Zeitraum 1900-2010 wurde eine RMS-Unsicherheit der globalen Lufttemperatur von 2 = ±1,22°C ermittelt.

= ±1,22°C ermittelt.

Die Unsicherheit in einer Anomalie-Reihe ist die Unsicherheit im jährlichen (oder monatlichen) Mittelwert der Lufttemperatur, kombiniert in Quadratur mit der Unsicherheit in der ausgewählten 30-jährigen Normalperiode.

Die RMS-Unsicherheit 2 in der NASA/GISS-Normalreihe 1951-1980 beträgt ±1,48°C und in der HadCRU/UEA- und Berkeley BEST-Normalreihe 1961-1990 beträgt sie ±1,49°C.

in der NASA/GISS-Normalreihe 1951-1980 beträgt ±1,48°C und in der HadCRU/UEA- und Berkeley BEST-Normalreihe 1961-1990 beträgt sie ±1,49°C.

Die mittlere globale Lufttemperaturanomalie 1900-2010 beträgt 0,94°C. Bei Verwendung der NASA/GISS-Normale beträgt die Gesamtunsicherheit der Anomalie 1900-2010:

2 = 1.96 x sqrt[(0.755)² + (0.622)²] = ±1.92°C

= 1.96 x sqrt[(0.755)² + (0.622)²] = ±1.92°C

Die gesamte Veränderung der Lufttemperatur zwischen 1900-2010 beträgt dann 0,94×1,92°C.

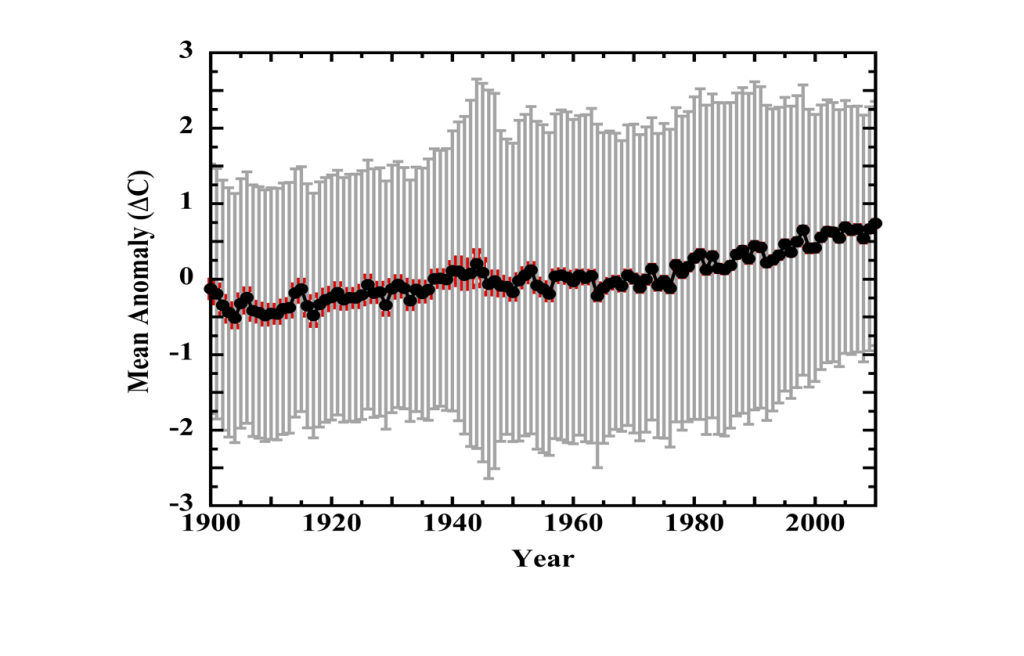

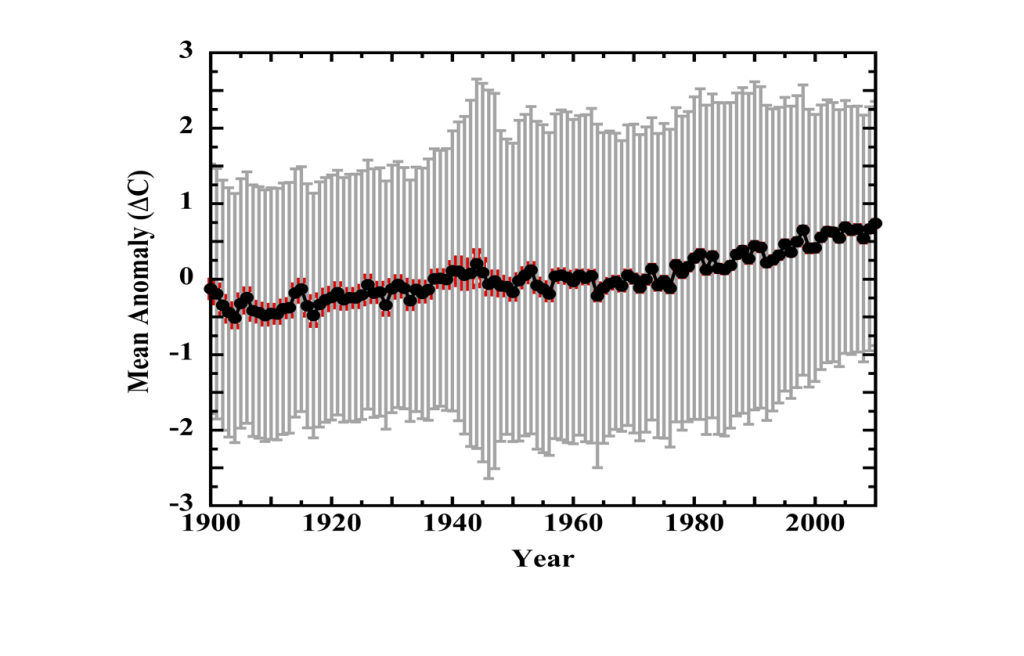

Abbildung 5 zeigt das Ergebnis, angewandt auf die jährlichen Anomalienreihen. Die roten Whisker sind der 2 quadratische jährliche kombinierte RMS der drei wichtigsten veröffentlichten Unsicherheiten (HadCRU/UEA, NASA/GISS und Berkeley Earth). Die grauen Whisker umfassen die kombinierten systematischen Messunsicherheiten von LST und SST. Die LiG-Auflösung ist nur bis 1980 enthalten.

quadratische jährliche kombinierte RMS der drei wichtigsten veröffentlichten Unsicherheiten (HadCRU/UEA, NASA/GISS und Berkeley Earth). Die grauen Whisker umfassen die kombinierten systematischen Messunsicherheiten von LST und SST. Die LiG-Auflösung ist nur bis 1980 enthalten.

Die verlängerte Vegetationsperiode, die Begrünung des hohen Nordens und die polwärts gerichtete Verschiebung der nördlichen Baumgrenze sind Anzeichen für eine Klimaerwärmung. Die Geschwindigkeit oder das Ausmaß der Erwärmung seit 1850 ist jedoch nicht bekannt.

Abbildung 5: (Punkte), Mittelwert der drei Reihen von Lufttemperaturanomalien, die vom britischen Met Office Hadley Centre/Climatic Research Unit, dem Goddard Institute for Space Studies oder Berkeley Earth veröffentlicht wurden. Jede Anomalie-Reihe wurde vor der Mittelwertbildung an eine einheitliche Normale von 1951-1980 angepasst. (Rote Whisker) = der 2 RMS der veröffentlichten Unsicherheiten der drei Anomalieaufzeichnungen. (Graue Whisker) = die 2Unsicherheit, berechnet als die untere Grenze der LiG-Auflösung (bis 1980) und der mittlere systematische Fehler, kombiniert in Quadratur. In den Anomalie-Reihen wurde die jährliche Unsicherheit der Lufttemperatur in Quadratur mit der Unsicherheit der Normalwerte von 1951-1980 kombiniert. Die erhöhte Unsicherheit nach 1945 ist auf die umfassende Einbeziehung von SST-Messungen mit Schiffsmotorenthermometern zurückzuführen (2 = ±2°C). Die Reihe der Lufttemperatur-Anomalien ist durch die aufgedeckten Unsicherheitsgrenzen vollständig verdeckt.

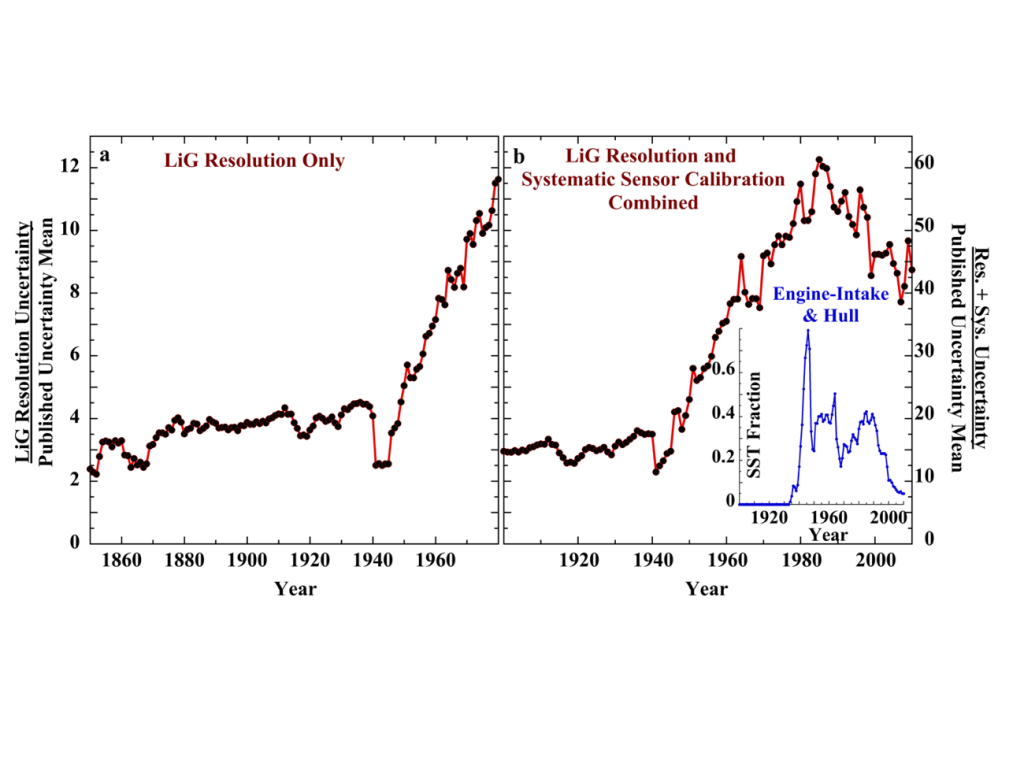

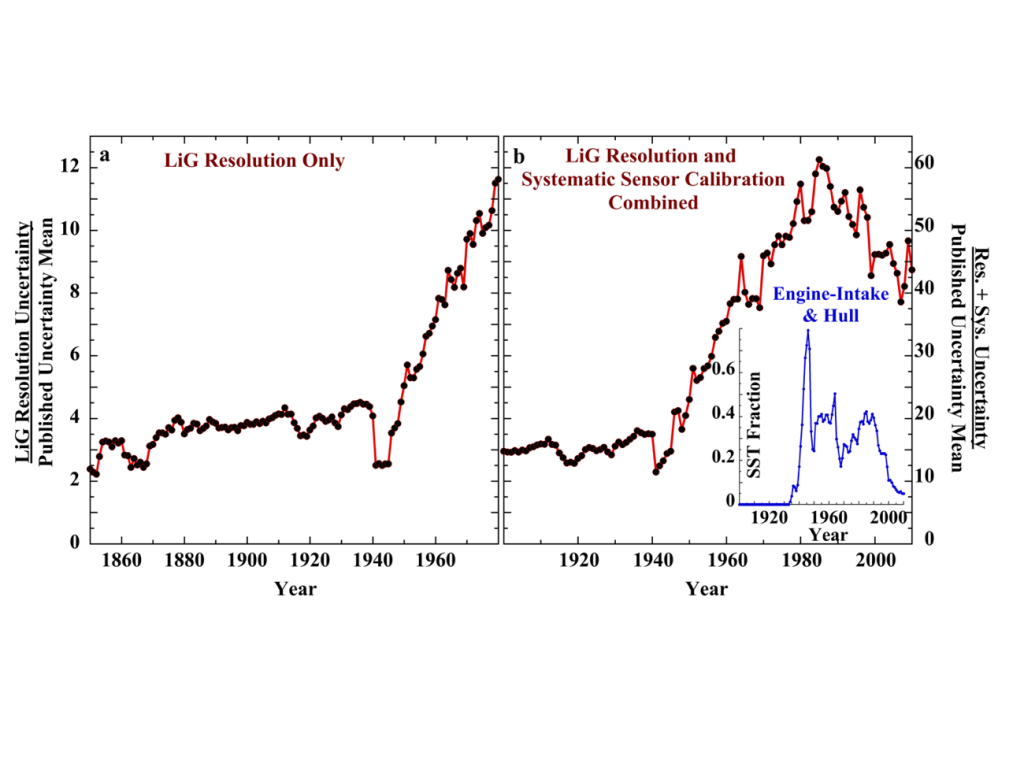

IV. Die 60-fache Täuschung: Abbildung 6 zeigt das Verhältnis zwischen den aufgedeckten und den veröffentlichten Unsicherheiten und veranschaulicht das Ausmaß der falschen Präzision in der offiziellen Aufzeichnung der globalen Lufttemperatur-Anomalien.

Tafel a ist (LiG ideale Laborauflösung) ÷ Veröffentlicht. Tafel b ist die Gesamtmenge (Auflösung plus systematische Unsicherheit) ÷ Veröffentlicht.

Feld a deckt den Zeitraum 1850-1980 ab, in dem die Aufzeichnung allein von LiG-Thermometern dominiert wird. Die untere Nachweisgrenze von LiG ist eine harte physikalische Grenze.

Dennoch ist die veröffentlichte Unsicherheit sofort (1850) etwa die Hälfte der unteren Nachweisgrenze. Während die veröffentlichten Unsicherheiten im Laufe des 20. Jahrhunderts immer kleiner werden, werden sie immer unphysikalischer und enden 1980 bei fast 12x kleiner als die untere physikalische Nachweisgrenze von LiG.

Feld b deckt den modernen Zeitraum von 1900 bis 2010 ab. Die Joule-Drift ist größtenteils nicht vorhanden, und die Aufzeichnungen gehen über in MMTS-Thermistoren (1981) und CRN-angesaugte PRTs (nach 2004). Der Vergleich für diesen Zeitraum enthält Beiträge sowohl der instrumentellen Auflösung als auch des systematischen Fehlers.

Das Unsicherheitsverhältnis erreicht 1990 seinen Höhepunkt, wobei die veröffentlichte Version etwa 60x kleiner ist als die Kombination aus instrumenteller Auflösung und Feldmessfehler. Bis 2010 sinkt das Verhältnis auf etwa 40, da die Messungen im Kühlwasser-Einlauf der Schiffsmotoren nach 1990 einen immer geringeren Beitrag leisten (Kent, et al., (2010)).

Abbildung 6: Feld a. (Punkte), das Verhältnis der jährlichen LiG-Auflösungsunsicherheiten geteilt durch den RMS-Mittelwert der veröffentlichten Unsicherheiten (2, 1850-1980). Feld b. (Punkte), das Verhältnis der jährlichen Gesamtmessunsicherheiten geteilt durch den RMS-Mittelwert der veröffentlichten Unsicherheiten (2, 1900-2010). Inset: der Anteil der SST, der von Thermometern im Ansaugtrakt des Motors und von am Rumpf montierten Sonden stammt (eine Minderheit). Der Rückgang der E-I-Temperaturen in der historischen Aufzeichnung nach 1990 erklärt das abnehmende Unsicherheitsverhältnis.

V. Das Urteil über die instrumentellen Methoden: Bestandsaufnahme der Fehler und Unsicherheiten in den veröffentlichten Lufttemperaturdaten:

NASA/GISS: unvollständige räumliche Abdeckung, städtische Wärmeinseln, Stationsverlegungen.

Hadley Centre/UEA Climate Research Unit: Zufällige Messfehler, Instrumenten- oder Stationsverschiebungen, Änderungen des Instrumententyps oder der Ablesezeit, spärliche Stationsdaten, städtische Wärmeinseln, Verzerrungen aufgrund von Änderungen der Sensorexposition (Bildschirmtyp), Verzerrungen aufgrund von Änderungen des verfahrens der SST-Messungen.

Berkeley Earth: nicht-klimabezogenes Rauschen, unvollständige räumliche Abdeckung und begrenzte Wirksamkeit ihres statistischen Modells.

Niemand erwähnt irgendetwas in Bezug auf instrumentelle Analysemethoden in einem Bereich, der vollständig von Instrumenten und Messungen beherrscht wird.

Stattdessen stößt man auf eine Analyse, die weder die Genauigkeitsgrenzen der Instrumente noch die Folgen ihrer technischen Entwicklung oder ihres Betriebsverhaltens berücksichtigt. Und das in einem Bereich, in dem die Kenntnis solcher Dinge eine Voraussetzung ist.

Diejenigen, die den Lufttemperaturrekord erstellen, haben keine Ahnung von Thermometern. Das ist vielleicht die größte Ironie.

Keine Bewertung von LiG-Thermometern als Messinstrumente, obwohl sie in den historischen Temperaturaufzeichnungen überwiegen. Nichts über die sehr relevante Geschichte ihrer technischen Entwicklung, ihrer Zuverlässigkeit oder ihrer Auflösungs- oder Nachweisgrenzen.

Nichts über die bekannten systematischen Feldmessfehler, die sowohl die LiG-Thermometer als auch ihre Nachfolger betreffen.

Man könnte diese Lücken von mathematisch versierten wissenschaftlichen Dilettanten erwarten, die in flachen numerischen Oberflächengewässern kreuzen, während sie sich der instrumentellen Tiefen darunter nicht bewusst sind; sie werden niemals die Grundlagen der Studie in den Griff bekommen. Aber nicht von Fachleuten.

Wir wussten bereits, dass die Klimamodelle keine Vorstellung von einer glühenden Zukunft unterstützen können. Siehe auch hier und hier. Wir wissen auch, dass die Klimamodellierer die physikalische Fehleranalyse nicht verstehen. Zuverlässigkeit der Vorhersagen: eine reine Bagatelle der modernen Modellierung?

Jetzt wissen wir, dass die Lufttemperaturaufzeichnungen keine Aussage über eine noch nie dagewesene Erwärmung zulassen. In der Tat gibt es so gut wie keine Hinweise auf eine Erwärmung.

Und wir wissen jetzt auch, dass die Ersteller der Lufttemperaturaufzeichnungen keine Ahnung von Thermometern haben, so unglaublich das auch erscheinen mag. Instrumentelle Methoden: eine bloße Bagatelle der modernen Temperaturmessung?

Die Auswirkungen unserer CO₂-Emissionen auf das Klima sind, wenn überhaupt, unsichtbar. Die Geschwindigkeit oder das Ausmaß der Veränderung der Lufttemperatur im 20. Jahrhundert ist nicht bekannt.

Mit dieser Studie bleibt vom IPCC-Paradigma nichts mehr übrig. Nichts. Es ist inhaltsleer. Das war schon immer so, aber diese Wahrheit wurde unter den gemeinsamen Bemühungen von administrativer Umarmung, Parteischreiern, Rufmördern, Medienpropagandisten und professioneller Abwesenheit verborgen.

All jene Psychologen und Soziologen, die ihre fundierten Erkenntnisse über die Wahnvorstellungen, psychologischen Barrieren und unangemessenen Persönlichkeiten, die sie mit ihrer Vorstellung von Klima-/Wissenschaftsleugnern plagen, veröffentlicht haben, sind mit Eiern im Gesicht oder in ihren akademischen Bärten zurückgeblieben. In ihrer professionellen Schärfe haben sie sowohl die Reihenfolge als auch die Wahrnehmungen von Wahn und Wirklichkeit auf den Kopf gestellt.

Wir stehen wieder einmal vor der ungeheuren Aufgabe, eine Wissenschaft zu betrachten, die zu einem parteiischen Narrativ verkommen ist, das einer ethischen Praxis feindlich gegenübersteht.

Und die Berufsverbände, die mit der Verkörperung der physikalischen Wissenschaft, der Wahrung von Ethik und Methode beauftragt sind – die Nationalen Akademien, die American Physical Society, das American Institute of Physics, die American Chemical Society – beteiligen sich an diesem Betrug. Ihre Nachlässigkeit ist mehr als beschämend.

——————————–

Übersetzt von Christian Freuer für das EIKE

Hinweis: Dieser Beitrag ist per ED-Mail eingegangen, so dass kein expliziter Link angegeben werden kann. Wer die Übersetzung überprüfen will, kann das mit dem beigefügten DOCX-Original tun.

The Verdict of Instrumental Methods