Die Blackout-Koalition! Sicherheit der Stromversorgung bleibt auf der Strecke

Die Energiewende soll noch einmal beschleunigt werden, so die aktuelle Meldungslage zur großen Koalition [SPI1, SPI2]. Statt der bisher angestrebten 35 % sollen bis zum Jahr 2025 sogar 40-45 % Strom aus sogenannten Erneuerbaren Energien erzeugt werden. Der Schwerpunkt dürfte dabei auf der Windenergie liegen, insbesondere an den „guten“ küstennahen Standorten in Norddeutschland, und die Kapazität der Offshore-Windenergie soll von derzeit wenigen 100 MW auf 6500 MW vervielfacht werden. Dies dürfte vor allem zu Lasten der konventionellen Kraftwerke gehen, denen man – soweit sie fossil befeuert werden – zusätzlich auch noch die CO2-Zertifikate verteuern will [CO2]. Als Antwort auf den überbordenden Preisanstieg bei den EE-Energien will man lediglich die Förderung in einigen Bereichen nach unten anpassen oder gar deckeln. Falls dies so umgesetzt wird, könnte sich der Anteil der Windenergie an der deutschen Stromerzeugung, der im Jahre 2012 noch bei 7,3 % lag, bis zum Jahr 2025 mehr als verdreifachen und auf über 22 % anwachsen. Für Solarenergie kann von einem Anwachsen von 4,6 auf bis zu 7 % ausgegangen werden, während das Wachstum bei Wasser, Biomasse und Müll gedrosselt werden dürfte. Für Deutschlands Energieversorgung bedeutet diese Entwicklung eine Katastrophe. Grund ist, dass im Netz im Prinzip kaum Strom gespeichert werden kann. Produktion und Verbrauch müssen deshalb stets im Gleichgewicht gehalten werden. Erzeuger wie Wind und Sonne, die nicht stabil einspeisen, stören dieses Gleichgewicht. Zur Stabilisierung müssen die Netzbetreiber dabei vor allem auf die konventionellen Kraftwerke zurückgreifen. Und genau die dürften zu den Leidtragenden der Koalitionsvereinbarungen gehören.

Wind und Sonne bieten weder Versorgungssicherheit…

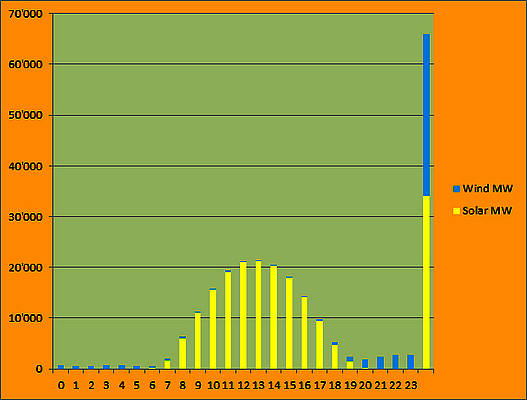

Ursache der Probleme ist die Unzuverlässigkeit der Energielieferungen aus Sonne und Wind. Die moderne Industrienation Deutschland benötigt an Werktagen im Winter bis zu 80000 MW an elektrischer Leistung. Da Wind und Sonne selbst zusammen manchmal nur wenige 100 MW liefern können (Bild 1), muss die Differenz – also nahezu die gesamte erforderliche Leistung von bis zu 80000 MW – durch konventionelle Kraftwerke abgesichert werden.

Bild 1. Am 22.8.2013 lag die gesamte EE-Stromproduktion aus Wind und Sonne in der Zeit von 05:00 und 07:00 Uhr bei weniger als 600 MW. Ganz rechts die installierten Gesamtkapazitäten (Datenquelle: EEX)

Um dies zu gewährleisten, wird in Deutschland eine sogenannte gesicherte Kraftwerksleistung bereitgehalten, die zurzeit bei 85000 MW liegt [ENLE]. Diese kann faktisch nur von konventionellen Kraftwerken inklusive Kernkraftwerken erbracht werden. Zwar wird im Prinzip auch Windrädern ein gewisser Beitrag von 6 % ihrer Nennleistung zugesprochen, doch zeigt Bild 1 deutlich, dass dies eher eine ideologisch motivierte Wunschvorstellung ist: Bei einer installierten Windkapazität von knapp 32000 MW hätten mehr als 1900 MW zur Verfügung stehen müssen, tatsächlich waren es zeitweise weniger als 600 MW. Versorgungssicherheit sieht anders aus.

…noch Vorhersagbarkeit

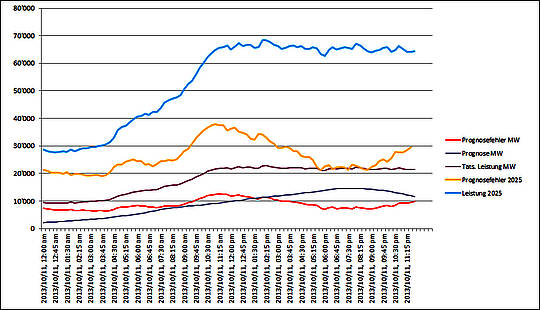

Von den Befürwortern der EE-Energien wird oft behauptet, dank moderner Methoden zur Wettervorhersage sei das Aufkommen an Wind- und Solarenergie inzwischen so gut vorhersagbar, dass man den Fahrplan der konventionellen Kraftwerke problemlos an das zu erwartende Leistungsprofil anpassen könne. Leider ist dies jedoch nichts anderes als eine ideologisch motivierte Lüge, die an den harten Fakten der Realität zerbricht. Trotz modernster Computersysteme liegen die Prognosen manchmal schon im 24-h-Bereich grausam daneben, wie Bild 2 anschaulich zeigt.

Bild 2. Verlauf von Windenergieprognose, tatsächlicher Stromerzeugung und des resultierenden Prognosefehlers am 11.10.2013, ergänzt um die entsprechenden Werte bei gleichem Wettergeschehen unter Annahme einer verdreifachten Windenergiekapazität im Jahre 2025 (Datenquelle: EEX)

Der Blick auf Bild 2 zeigt, wie das Windenergieaufkommen im Verlauf des Vormittags mehr und mehr von der Prognose abweicht. Um die Mittagszeit herum lag die Differenz zwischen Vorhersage und Ist-Werten bei bis zu 12500 MW, das entspricht der Leistung von 12 Großkraftwerken der 1000-MW-Klasse. Zu diesem Zeitpunkt erreichte die Windenergieleistung 22000 bis 23000 MW. Besonders interessant wird die Darstellung, wenn man sie um eine Projektion für das Jahr 2025 mit einer verdreifachten Windenergiekapazität bei Annahme einer gleichen Wetterlage ergänzt. Man kommt dann auf einen Prognosefehler von knapp 38.000 MW bei einer maximalen Windenergieleistung von 68000 MW. Da die EE-Erzeugung Vorrang vor allen anderen Stromanbietern hat, müssten dann faktisch alle konventionellen Kraftwerke vom Netz genommen werden.

Ähnlich groß sind solche Abweichungen auch im Bereich der Solarenergie. So kam es im Zeitraum zwischen dem 4. und dem 6. April zu einem Prognosefehler von mehr als 8800 MW. Beim Netzbetreiber 50 Hz war die Lage dadurch zeitweilig äußerst kritisch [ZFK].

….noch Stabilität

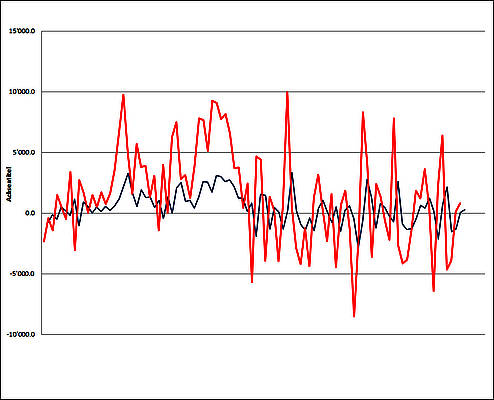

Ein weiteres Problem insbesondere der Windenergie sind die teilweise extremen, kurzfristig im Viertelstunden-Rhythmus auftretenden Schwankungen der Einspeisung. Ungeachtet gegenteiliger Behauptungen der Windkraftlobby ändert daran auch die großräumig verteilte Aufstellung der Windräder kaum etwas. Bild 3. zeigt die kurzfristigen Sprünge der Windenergieleistung am 11. Oktober 2013. Solche Schwankungen „rütteln“ ganz erheblich an der Netzstabilität und zwingen die Netzbetreiber, von den konventionellen Kraftwerken teure Regelenergie abzurufen, um das Gleichgewicht aufrechtzuerhalten. Bei den verärgerten Mitarbeitern der entsprechenden Schaltwarten setzen sich für den Strom aus Wind und Sonne daher inzwischen Ausdrücke wie „Zappelstrom“ oder „Neue Instabile Energie“ (NIE) immer mehr durch. Die Folgen sind fatal.

Bild 3. Kurzfristige Schwankungen des Aufkommens an Windenergie im Viertelstundenabstand um bis zu + 3000/ -2500 MW/h am 11.10.2013 (blau). Bei der entsprechenden Projektion für das Jahr 2025 (rot) zeigen sich Gradienten von bis zu + 10000/ -6500 MW/h (Datenquelle: EEX)

Konventionelle Kraftwerke als Lückenbüßer missbraucht

Je höher der Anteil der sogenannten EE-Stromerzeugung im Netz ist, desto unzuverlässiger und schwankender ist das Stromaufkommen im Netz. Da dieser Strom aufgrund des Erneuerbare-Energien-Gesetzes jedoch Vorrang hat, müssen die konventionellen Kraftwerke ihre Leistung immer häufiger stark reduzieren oder gar ganz vom Netz gehen, ohne jedoch abschalten zu können, weil sie dennoch dringend gebraucht werden: Zum einen müssen sie einspringen, wenn Sonne und Wind gerade mal wieder keine Lust zur Arbeit haben, zum anderen müssen sie ständig dafür sorgen, dass die Schwankungen der EE-Erzeuger ausgeglichen werden. Statt kontinuierlich arbeiten zu können, wofür sie eigentlich ausgelegt sind, müssen sie zunehmend in einem Stop-and-Go-Modus agieren, der für sie sowohl technisch als auch wirtschaftlich desaströs ist. So muss beispielsweise auch im sogenannten „Hot Standby“, bei dem ein Kohlekraftwerk seinen Kessel auf Betriebsdruck und -temperatur hält, in erheblichem Maße Kohle verbrannt werden. Zusammen mit der Tatsache, dass auch die Belegschaft weiterhin präsent sein muss, bedingt dies erhebliche Kosten, ohne dass auch nur ein Cent verdient werden kann. Unter dem erzwungenen Stillstand leidet auch die Fähigkeit der Kraftwerke zu schneller Reaktion auf plötzlich auftretende Bedarfsspitzen, denn sie können bei stillstehenden Generatoren keine Rotationsenergie zur Netzstabilisierung bereitstellen.

Bild 4. Großkraftwerke wie das 2575-MW-Braunkohlekraftwerk Boxberg kann man nicht einfach an- und abschalten wie ein Auto (Foto: Kohlekraftwerke.de)

Reaktionsfähigkeit von Großkraftwerken

Konventionelle Kraftwerke kann man nicht einfach wie einen Automotor betreiben, den man mal eben mit dem Zündschlüssel anwirft, um sofort losfahren zu können. Große, dampfbetriebene Kraftwerke (Bild 4) sind riesige Anlagen mit gewaltigen Massen. Sie müssen zunächst auf Temperatur gebracht werden, bevor sie Leistung liefern können, denn allein im Kessel müssen mehrere 1000 Tonnen Wasser in superheißen Dampf verwandelt werden. Bei den wirklich großen Grundlastkraftwerken mit Leistungen im Bereich ab 1000 MW kann es bis zu einer Woche dauern, bevor sie nach längerem Kaltstillstand wieder ans Netz gehen können [WIDA]. Die typischen Hochlaufzeiten von Kohlekraftwerken – diese werden häufig für den reaktionsschnellen Mittellastbetrieb eingesetzt – liegen zwischen 6-7 Stunden bei einem Kaltstart und immerhin noch 2 Stunden bei einem sogenannten Heißstart, worunter ein Stillstand von weniger als 8 h zu verstehen ist [WIKO]. Zwingt man solche Kraftwerke also zum Stop-and-Go-Betrieb, so nimmt man ihnen gleichzeitig die Fähigkeit, im Notfall rasch Energie liefern zu können. Das hat nachteilige Auswirkung auf die Versorgungssicherheit.

Stabilität in Gefahr

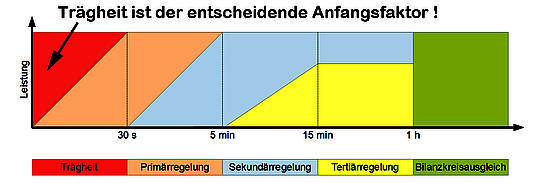

Das entscheidende Problem für die Aufrechterhaltung der Netzstabilität ist, dass sich einerseits aufgrund des Anwachsens von Zappelstrom-Erzeugung der Bedarf an Regelenergie erheblich erhöht, während gleichzeitig aufgrund der zunehmenden Stillsetzung konventioneller Kraftwerke deren Verfügbarkeit zurückgeht. Um bei einem größeren Ausfall wie z.B. einer Kraftwerksstörung sofort gegensteuern zu können, benötigen die Netzbetreiber zuverlässige Kraftwerke, von denen sie kurzfristig gestaffelt die benötigte Regelenergie abrufen können, Bild 5.

Bild 5. Schema des zeitlichen Einsatzes der unterschiedlichen Regelleistungsarten (Grafik: DF5GO/ Wikimedia Commons)

Hierfür eignen sich nur konventionelle Kraftwerke oder Wasserspeicherkraftwerke. Am wichtigsten sind hierbei die augenblicklich wirksame Trägheitsreserve – hierfür sorgt der Schwungradeffekt der riesigen Turbinen und Generatoren – sowie die Primärregelleistung, die innerhalb von Sekunden zur Verfügung gestellt werden muss. Für beides braucht man Großkraftwerke. Damit die einzelnen liefernden Kraftwerke dabei nicht selbst überlastet werden, wird hierfür pro Einheit nur 2,5 % der Anlagenleistung herangezogen. Für Deutschland wird aktuell eine jederzeit verfügbare Primärregeleistung von 700 MW für erforderlich gehalten. Somit kann eine ständige Präsenz von 28000 MW primärregelfähiger Leistung von konventionellen Kraftwerken als Untergrenze der Netzstabilität angesetzt werden. An Wochenenden liegt die Netzlast jedoch manchmal nur bei 30000 bis 40000 MW. Bereits jetzt kommen dann manchmal 20000 MW an Windleistung und ebensoviel Solarleistung dazu, so dass es nahezu unmöglich wird, die erforderliche Präsenz an konventionellen Kraftwerken zu gewährleisten. Wenn in zwölf Jahren 40 % statt wie derzeit 22 % EE ins Netz eingespeist werden sollen, ist die Stabilität der Netze nicht mehr zu gewährleisten.

Hinzu kommt eine Tatsache, über die sich kaum jemand Gedanken zu machen scheint. Jedes „Zappeln“ von Zufallsstrom im Netz muss durch entsprechende Zufuhr von Regelenergie der zweiten und dritten Ebene kompensiert werden. Dazu muss jedoch entsprechende Kraftwerksleistung von konventionellen Kraftwerken abrufbar bereitstehen. Zurzeit werden in Deutschland insgesamt 7000 Megawatt positiver Regelleistung und 5500 Megawatt negativer Regelleistung vorgehalten [WIKI]. Die Kosten dafür betragen etwa 40 Prozent des gesamten Übertragungsnetzentgeltes. Sie werden im Netzentgelt versteckt, obwohl sie eigentlich durch die “Erneuerbaren” verursacht werden. Bereits im Jahr 2006 wurde geschätzt, dass es hierbei um etwa 300 bis 600 Mio. Euro ging [CARE]. Inzwischen dürfte die Milliardengrenze längst überschritten sein.

Das eigentliche Problem ist jedoch, dass für den Ausgleich der „Zappelei“ künftig immer noch mehr an Regelleistung bereitgehalten werden muss, während der Marktanteil der konventionellen Kraftwerke gleichzeitig zurückgedrängt werden soll. Von den Verantwortlichen scheint sich kaum jemand darüber Gedanken zu machen, woher denn bei dieser gegenläufigen Entwicklung die künftig benötigte Regelenergie kommen soll. Mit Gaskraftwerken allein ist das nicht zu stemmen, nicht nur aufgrund der Kosten, sondern auch weil im Stillstand befindliche Gasturbinen weder Trägheitsreserve vorhalten noch schnell genug hochgefahren können, um in nennenswertem Umfang Primärregelenergie bereitstellen zu können. Sie sind zwar Schnellstarter, aber es dauert dennoch eher Minuten als Sekunden, bis sie wirklich hohe Leistungen abgeben können.

Konventionelle Kraftwerke verschwinden vom Markt

Nach der Aufstellung der deutschen Strombörse umfasst der konventionelle Kraftwerksbestand derzeit Anlagen mit einer Gesamt-Erzeugungskapazität von knapp 110000 MW. Für eine Projektion bis zum Jahre 2020 (bzw. 2022) muss man hiervon noch rund 8000 MW Pumpspeicherkapazität abziehen, da Pumpspeicher ja selbst keine Energie erzeugen, sondern sie lediglich zwischenspeichern. Außerdem muss man bedenken, dass bis 2022 rund 12000 MW an Kernkraftkapazität zur Stilllegung anstehen. Ab 2022 verbleiben also rund 90000 MW, doch will man diesen ein um 18 % kleineres Marktsegment zugestehen als bisher. Zudem werden sie mehr und mehr zu unwirtschaftlichem Teillastbetrieb gezwungen. Schon heute ist die Situation für viele Betreiber kritisch, wie die aktuellen Pläne von RWE und E.ON zur Stilllegung von Kraftwerken und Freistellung von Mitarbeitern belegen. Auch immer mehr Stadtwerke haben mit ihren Kraftwerken Schwierigkeiten. In den nächsten Jahren ist damit zu rechnen, dass zahlreiche weitere der zurzeit noch existierenden Kraftwerke stillgelegt werden. Planungen für neue Kraftwerke sind mittlerweile nahezu zum Erliegen gekommen. Bei Bauzeiten von bis zu 15 Jahren ist dies eine bedenkliche Situation.

Bild 6. Die Politik wird weiterhin daran festhalten, im Namen des angeblichen Umwelt- und Klimaschutzes unsere Natur zu schädigen

Welche Entwicklung ist zu erwarten?

Nachdem noch vor kurzem Stellungnahmen des NRW-Wirtschaftsministers Garrelt Duin sowie von NRW-Chefin H. Kraft Hoffnungen geweckt hatten, dass bei den Koalitionsverhandlungen die Bedenken der Industrie zumindest ansatzweise Berücksichtigung finden könnten, zeigt der derzeit kommunizierte Verhandlungsstand, dass man seitens der Politik weiterhin unbeirrt in die falsche Richtung marschieren wird, Bild 6. Im Prinzip hat man sich völlig verfahren. Es gibt keinerlei strategische Planung, stattdessen scheint man nur noch zu versuchen, sich im Widerstreit zwischen den Interessengruppen mit den für Politiker üblichen „Formelkompromissen“ weiter durchzumogeln. Zurzeit wird zwar noch behauptet, man wolle das Tempo des EE-Ausbaus weiter steigern, dabei jedoch gleichzeitig an der Kostenschraube drehen und allzu üppige Vergütungszahlungen zurückschneiden. Gleichzeitig hält man die konventionellen Kohlekraftwerke wegen ihres CO2-Ausstosses weiterhin auf der Abschussliste und will sie durch Verknappung von CO2-Zertifikaten bestrafen. Vermutlich erhofft man sich dadurch eine Besserung der Wettbewerbssituation der notleidenden Gaskraftwerke. Diese will man offensichtlich als flexible Schnellstarter verfügbar halten, damit sie als Ausputzer für die Eskapaden der EE-Erzeuger einspringen können. Augenscheinlich war bei den Verhandlungen niemand dabei, der auch nur ein klein wenig Ahnung davon hatte, warum wir auf unsere Großkraftwerke und ihre entscheidende Fähigkeit, das Netz in den ersten entscheidenden Sekunden(bruchteilen) einer Störung zu stabilisieren, umso weniger verzichten können, je mehr Zappelstrom ohne Sinn und Verstand in die Netze gedrückt wird.

Bild 7. Egal wie solide ein (Energieversorgungs)-Gebäude auch gebaut sein mag – man kann es viel schneller kaputtmachen als wieder aufbauen

Nicht bedacht wird zudem, dass bis 2022 mit den zur Stilllegung verurteilten Kernkraftwerken weitere 12000 MW Großkraftwerksleistung vom Netz gehen werden, deren Funktion durch Gaskraftwerke nicht zu ersetzen ist. Unsere Energiepolitik steuert daher so oder so unbeirrt auf einen massiven Crash zu (Bild 7), langdauernde Blackouts eingeschlossen. Denk ich an Deutschland in der Nacht…

Fred F. Mueller

Quellen

[CARE] http://www.care-energy-online.de/index.php/stromgas/strom/oekostrom.html?showall=&start=19

[ENLE] http://www.energie-lexikon.info/jahreshoechstlast.html

[SPI1] http://www.spiegel.de/politik/deutschland/energiewende-koalition-will-windrad-schwemme-bremsen-a-932599.html

[SPI2] http://www.spiegel.de/wirtschaft/soziales/arbeitsgruppe-union-und-spd-wollen-energiewende-billiger-machen-a-932733.html

[CO2] http://www.spiegel.de/wissenschaft/natur/emissionshandel-eu-staaten-wollen-co2-ausstoss-teurer-machen-a-932575.html

[WIDA] http://de.wikipedia.org/wiki/Dampfturbine

[WIKI] http://de.wikipedia.org/wiki/Regelleistung_(Stromnetz)

[WIKO] http://de.wikipedia.org/wiki/Kohlekraftwerk

[ZFK] http://www.zfk.de/strom/artikel/prognosefehler-von-8800-mw.html