Sind 100 % NIE (Neue Instabile Energien) zur Stromversorgung eines Industrielandes sinnvoll machbar?

Wir stehen bei der Energiewende vor folgenden Problemen:

1. Grundsätzliches

2. Absolut notwendig Sicherheitsreserve von ca. 28.000MW durch konventionelle Kraftwerke

3. Abhängigkeit des Stromes aus Wind und PV vom Freiheitsgrad 10^30 des Wetters. (1)

4. Phasenschieber in Polen und Tschechien – kein Strom mehr in Richtung Süddeutschland.

1. Grundsätzliches

Der Wunschtraum von 100 % NIE (Neue Instabile Energien) wird uns nun seit mehr als 10 Jahren jeden Tag von den Politikern und den Medien, vertreten durch die sogenannten Experten von der grünen Heilsfront, in den tollsten Versionen eingehämmert. Über diese ideologischen Umspülungen des „BETREUTEN DENKENS“, soll der Umbau der Gesellschaft zur "GROSSEN TRANSFORMATION" erreicht werden.

Ob in der Süddeutschen Zeitung, in der Hannoverschen Allgemeinen Zeitung oder in unserem gleichgeschalteten Kreisblättchen der Schaumburger Zeitung, überall werden von uns Bürgern Opfer abverlangt: Es gehe ja um die Vermeidung einer Klimakatastrophe, sonst steht der Weltuntergang bevor.

Mit dieser medial erzeugten Angst wird an unser gutes Gewissen appeliert, auf die sogenannten erneuerbaren Energien (EE) wie Wasser, Geothermie, Wind, Sonne und Biomassen in vollem Umfang umzusteigen. Kosten dürfen hierbei keine Rolle spielen. Hauptsache der Planet wird gerettet und einige wenige Schmarotzer unseres korrupten politischen und wissenschaftlichen Systems machen mehr als nur Kasse.

Natürlich bezahlen wir freudestrahlend auch noch die EEG-Steuern und, wenn gewünscht, auch die mehr als wichtigen CO2-„Verschmutzungsrechte“ oder „-Zertifikate“.

Wenn in einer Zeit, wie zB. vom 19.Okt. bis 07.Dez..2013 von allen 92 Windenergieanlagen (WEA) -Offshore nur noch 10 Strom produzieren, sind wir natürlich gern bereit, für die ausgefallenen Erträge der armen WEA-Besitzer unser weiteres Scherflein auch dort noch zu entrichten. Auch wenn wir über die Weihnachtstage 2012 mehr als 100 Mill.€ von allen Haushalten für PV- und Windstrom an unsere Nachbarn in den Niederlanden verschenkt haben, sind wir nun weihnachtlich glücklich gestimmt und zahlen immer weiter, immer mehr !!!

Die direkten Kosten für unsere deutsche Volkswirtschaft liegen entsprechend dem EEG-Gesetz von 2000 bei ca. 123 Mrd. € bis Ende 2013. Das wird natürlich durch die Medien nicht verbreitet, aber es sind die Kosten, die wir alle privat und in den Betrieben zusätzlich für Waren und Dienstleistungen noch darüber hinaus zu bezahlen haben. Hier sind nach vorsichtigen Schätzungen Summen von ca. 450 – 500Mrd.€ im Gespräch.

Dann hören wir wieder vom Club of Rome, wie damals 1972, dass die Reserven von Öl und Gas und auch der anderen Ressourcen nun bis 2052 endgültig verbraucht seien. Leider haben die „Wissenschaftlern“ des Club of Rome die Kreativität des Menschen in ihrer Analyse außen vor gelassen. Auch haben diese selbst ernannten Vordenker noch nie was von physischer Ökonomie gehört. Durch technische Weiterentwicklungen zB. im Bereich der neuen Bohrtechniken konnten neue, sehr große Lagerstätten fossiler Energieträger bereits heute erschlossen werden.

Lt. eines Berichtes der internationalen Energieagentur vom Juni 2013 haben die zur Zeit produzierenden Ölquellen eine Reichweite von ca. 53 Jahre plus ca. 120 Jahre aus den seit 2009 gefundenen neuen Vorräten. Erdgas und Methanhydrat reichen einige 1.000 Jahre (Japan fördert bereits als erstes Land seit Jan. 2013 Methanhydrat = Reserven vor der Küste ca. für > 400Jahre ), Braunkohle hat eine Reichweite von ca. 3.000 Jahren, Steinkohle ca. 2000 Jahre etc..

Kernkraftwerke (KKWs) der 4. Generation bringen dank Thoriumnutzung eine Reichweite von > 1.000Jahren ( deren Vorteil: Sie sind –intrinsic- eigensicher , d.h. kein GAU mehr möglich, der radioaktive Abfall ist sehr gering !

Und ab Ende 2014 oder Anfang 2015 beginnt vermutlich in Deutschland das Fusionszeitalter – mit dem Fusionsreaktor Wendelstein 7X. Ich hoffe, wir können die NI-Energie-Anlagen NEUEN INSTABILEN ENERGIEN dann nach 2035-40 endlich verschrotten ( viele Schwermetalle und Chemie dürfen wir dann beseitigen. ) Wasserstoff-Energiereserven nun ca. 40Mill. Jahre = Abfall sehr sehr sehr gering.

2. Absolute Sicherheitsreserve von ca. 28.000MW durch die Strom-Dinosaurier

In der deutschen Stromerzeugung wird eine absolute nicht unterschreitbare Sicherheitsreserve von ca. 28.000MW benötigt, die für einen möglichen schlagartigen Ausfall immer innerhalb einer SEKUNDE bereitgestellt werden muss, da sonst die Netz-Frequenz zusammenbricht. Dieses wird über die riesigen Schwungmassen aller Großgeneratoren gewährleistet, die technisch dafür sorgen, dass innerhalb der ersten Sekunde die Sicherheitsventile aller über das automatische IT-Netzwerk gesteuerten Großkraftwerke sich öffnen, um dann die Kraftwerke über die zweite Frequenz-Verteidigungsstufe mit mehr komprimiertem Dampf zu versorgen!

Die NIE sind dazu nicht in der Lage , denn sie halten weder nennenswerte Rotationsenergie vor, noch lassen sich Sonne und Wind gezielt und schlagartig herauf- oder herunter regeln. Vor diesem Hintergrund sind Behauptungen, eine 60-80-100 prozentige Stromversorgung aus erneuerbaren Energien sei ohne konventionelle Kraftwerke machbar, barer Unsinn!!!

Diese unmstößlichen Fakten wurden mir am 23.11.2013 von Hern Peter Franke, Vizepräsident der BUNDESNETZAGENTUR, eindeutig, klar und persönlich bestätigt, sowie auch von Herrn Prof. Dr.-Ing. Alt ( für Netze und Kraftwerke ) FH-Aachen und durch Herrn Dipl.-Ing. F. Müller Schweiz, technischer Energie-Redakteur!

3. Abhängigkeit des Stromes aus Wind und PV vom 10 32 Freiheitsgrade des Wetters.

Zum besseren allgemeineren Verständnis hier einen Überblick über die verwendeten technischen Begriffe in Bezug auf Stromherstellung, Lieferung und Verbrauch:

Nicht, dass es uns so geht wie manchen Politikern, die über die Energiewende Kompetenz vortäuschend und schwadronierend, die Begriffe kW und kWh nicht unterscheiden können.

1.Elektrische Leistung wird in W(Watt) bzw. kW (Kilowatt) oder Megawatt (MW)

angegeben,

Hat ein Kohlekraftwerk eine Leistung von 980 MW, so sind das 980.000kW. Produziert

diese Anlage 1Stunde lang Strom, so ergibt das 980.000 kWh Energie bzw. Arbeit..

2. Diese Kilowattstunden (kWh) sind die elektrische Energie oder die geleistete Arbeit, die

wir alle jeden Monat in Cent/kWh beziehen und bezahlen müssen.

3. PV Strom = Bezeichnung für Strom aus Photovoltaik-Anlagen.

4. Wind Onshore ( Windenergieanlagen an Land ) und Offshore ( Windenergieanlagen auf

See ).

5. Laststrom: Strom, den wir zB. in Deutschland pro Stunde beziehen („verbrauchen“).

6. Strom-Jahresbemessungszeitraum 8.760 Std./a = max. Arbeitszeit pro Jahr für ein konv. Kraftwerk. Im Normalfall, ohne Revisionszeit ca. 7.800 bis 8.000Std/a.

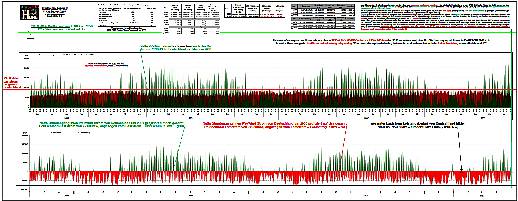

Abb. 1. Hier wird die gerechnete Leistungsabgabe der NIE in 33 Monaten um das Jahr 2050 gezeigt. Sie wurde berechnet unter Verwendung der realen Daten von 33 Monaten zwischen 2009 und 2013. Großformatig herunter ladbar als Datei im Anhang

Das Bundesumweltamt, bei dem sich EIKE seit ca. zwei Jahren bemüht bisher ohne Erfolg, einen klaren eindeutigen technischen und physikalischen Beweis zu erhalten, dass wir – verursacht durch das CO2- schon jetzt in einer die Vorboten einer künftigen angeblichen Klimakatastrophe erleben, behauptete im Jahre 2010, dass unsere gesamte Volkswirtschaft bis " 2040-50 zu 100% ausschließlich mit sogenannten erneuerbaren „Energien " versorgt werden kann. Als notwendige Stromerzeugungsleistung wurde für eine 100% Versorgung überwiegend aus die PV- und Wind- installierte Leistungen von 380.000 MW angegeben. Diese Leistungen sind, bezogen auf das Jahr 2012 im Jahre 2040-50 ca. 6x grösser als heute!

Diesem Hinweis sind wir nun nachgegangen. Im Prinzip ist die Aussage, wie in der Technik immer, leicht zu beweisen oder zu widerlegen. Dazu müssen wir di Daten einige Jahre, ( zur Zeit ca. 4 1/2 Jahre ) NI-Energien im Stundentakt erfassen. Die offiziellen Stellen haben es leider und vielleicht bewusst versäumt, dese Stundendaten den interessierten Bürgern zur Verfügung zu stellen. Also haben wir für jeden Tag über 24 Stunden die Strommengen für PV- und Windstrom ermittelt. Das sind heute mehr als 300.000 Datenreihen für nun ca. 5 Jahre.

Nach diesem Erfassungszeitraum wurde aus den 41/2 Jahren für 33 Monaten die PV- und Windmengen für jede einzelne Stunde zusammengerechnet. Danach konnten wir für jede Stunde der 33 Monate die verhältnismäßige Mehrstrommenge für PV und Wind bezogen auf die 380.000MW mit dem Sicherheitsfaktor von 0,9 bestimmen ( Faktor ca. 6 x 0,9 ). Somit haben wir nun für jede Stunde des Jahres ( 8.760Std./a ) die hochgerechnete Strommenge aus PV und Wind für die Jahre 2050 – 51 – 52 also bei dieser unserer Betrachtung von ca. 33 Monaten vorliegen.

Für die gesamten Berechnungen und für die Erstellung der Grafiken wurde eine optimierte Datenbank erstellt. Nun konnten wir auf die für Deutschland festgestellten 8.760 Strom-Laststunden die PV und Wind-Stunden projizieren. Man kann sehr klar erkennen, es gibt keine einheitlichen flächenmäßigen Überdeckungen. Aus diesem Grunde sind wir auf den Gedanken gekommen von den Strom-Laststunden die Strom PV-und Wind-Stunden abzuziehen und eine neue +/- Grafik dafür zu erzeugen.Nun erkennt man sehr einfach und schnell, es gibt einen Strom PV- und Wind-Überschuß und eine über das ganz Jahr verteilte Strom-Unterdeckung. Die Stundenunterdeckung liegt bei ca. 6.500 Std./a. Sie kann zB. bei nur -5% liegen oder aber auch bei -100% Unterdeckung.

Ein sehr großes Problem ist im Bereich des Strom-Überschusses zu erkennen. Hier erreichen die Stunden-Spitzenwerten die gigantische Größe von ca. 160.000 MWh.

Lt. Aussage von Netzwerkern in den Ringvorlesungen der UNI-Hannover vom Sommer 2013, sind diese Strommengen auch nicht mit den noch zu bauenden neuen Stromleitungen zu transportieren.

Daraus folgt zwangsweise, dass eine Energieversorgung durch die "sogenannten erneuerbaren Energien" von mehr als max. 40-50% technisch und physikalisch nicht möglich ist, wenn man den Strom-Supergau von 6-14 Tage keinen Strom für Deutschland vermeiden möchte.

( lt. Herrn Unger, Präsident des Bundesamts für Katastrophenhilfe )!

Eine Energiewende von 2030 – 50 ohne Kohle , Gas, Atom mit erneuerbaren Energien von 60 – 80 – oder 100 % ist nicht möglich!

Sehen Sie unten die Grafik: Szenario Umweltbundesamt mit 380.000MW.

Hierbei sollten wir bedenken, dass sich in ca. 26 bis 36 Jahren der technische und physikalische Fortschritt erheblich weiter entwickeln wird. Strom-Speicher aber in diesen riesigen Dimensionen sind auch dann nur schwer vorstellbar. Die Industrie wird über die 4. industrielle Revolution den IT und Automationsgrad in diesem Zeitraum gewaltig ausweiten. Sie rechnen mit einem Mehrbedarf in der Stromleistung von ca. 20.000MW im Jahr lt. Hannovermesse von 2011-13.

4. Phasenschieber in Polen und Tschechien – kein Strom mehr in Richtung Süddeutschland

Die Firmen Tennet und auch 50hertz haben für das Jahr 2012 zusammen mehr als ca. 1250 Frequenzgefährdungen gemeldet, füher lagen diese Werte bei ca.3-5 Fällen in Deutschland pro Jahr. Eine Verschärfung des Problems liegt bezogen auf die neuen Phasenschieber auf der Hand, zumal die beteiligten Staaten bis heute keine Klärung anstreben. Die Phasenschieber sollen Anfang 2014 einsatzbereit sein, was dann?

Ein großes Dankeschön geht an Herrn Rolf Schuster, der in einem nicht zu beschreibenden Zeitaufwand diese Strom-PV- und Windmengen erfasst hat und die dafür notwendig Datenbank mit Grafik entwickelte. Auch einen herzlichen Dank an Herrn Dr. Theo Eichten und Herrn Limburg.

Hartmuth Huene EIKE

Hinweis. Das Bild ist eine sehr fein aufgelöste pdf Datei. Sie finden sie im Anhang. Der Autor empfiehlt diese so groß wie möglich auszudrucken.

Weiter Ausführungen dazu:

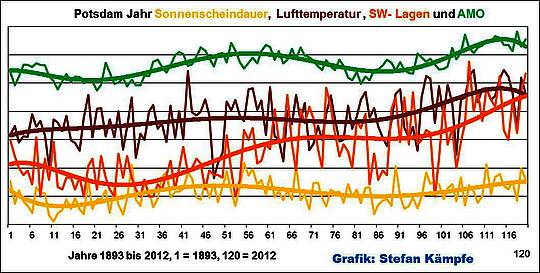

1. Vortrag von Herrn Prof. Dr. Werner Kirstein, 3. Internationale Energie- und Klimakonferenz 2010: Klimawandel zwischen Modellen, Statistik und Ersatzreligion ( DVD3 – 1.07.58 )

2. Auf grundlegende Beschreibungen zu diesen Ausführung möchte ich auf die Arbeit von Herrn DIpl-Physiker Karl Linnenfelser verweisen: http://www.eike-klima-energie.eu/climategate-anzeige/lastganglinien-als-erfolgskontrolle-der-energiewende-mit-windenergie-und-fotovoltaik-anlagen/

3. Auch weitere Arbeiten zu diesen Themenfeld wurden von Herrn Prof. Dr.-Ing. Alt FH-Aachen schon seit Jahren mehrfach veröffentlich: http://www.alt.fh-aachen.de/downloads//Allgemeines/Merkel%20EEG%20Frequenz-Leistungsregelung.pdf

4. Das gleiche gilt für Herrn Dipl.-Ing. Fred. F. Mueller-Schweiz zum Thema Strom-Sicherheitsreserven: http://www.eike-klima-energie.eu/climategate-anzeige/stromnetze-am-limit-das-risiko-waechst-mit-jedem-windrad-nehmen-die-probleme-zu/

5. Informationen von Herrn Dipl-Ing. Limburg zur Sicherheitsreserve und den sogenannten erneuerbaren Energien unter: http://www.eike-klima-energie.eu/news-cache/kombikraftwerke-fuer-100-erneuerbare-teil-1-ein-projekt-von-tagtraeumern-oder-huetchenspielern/

Weiter Szenarien wurden gerechnet zB. Bundesland Niedersachsen – Laststrom zum PV-Wind von gesamt Deutschland – 461.000MW Bruttoleistung Frauenhofer-ISE-Studie usw.