Das Rätsel der Eiszeiten, Teil I und II

Was ist SOD, wer ist verantwortlich und was ist seine Philosophie

Science of doom (SOD) (hier) ist ein Klima-Wissenschaftsblog von bester Qualität. Es ist etwas mühsam herauszubekommen, wer ihn betreibt. Schließlich wird man bei Wikipedia fündig. Es sind die beiden Professoren Peter Ward (Paläontologe, Univ. Washington, USA, hier) sowie Donald Brownlee (Atronom an der Univ. Washington, USA, hier). Wer Englisch mag, sollte SOD im Original lesen, denn in der deutschen Übersetzung geht einiges von der angelsächsischen Ironie verloren. Außerdem sind wir der Meinung, dass insbesondere die SOD-Kommentare oft fast ebenso wertvoll sind wie der SOD-Text selber. Hier tummeln sich meist Fachleute. Verbissene Auseinandersetzungen wie in manch anderen Klima-Blogs (wir nennen besser keine Namen), die sich durch mangelnde Fachkenntnissen und der sich daraus ergebenden Unbelehrbarkeit der Streithähne auszeichnen, sucht man in SOD glücklicherweise vergebens. Wir möchten fernen betonen:

Die von uns verfasste deutsche Version ergänzt in vielen Einzelheiten das Original und ist nicht immer die wörtliche Übersetzung. Insbesondere haben wir – wenn es uns zur Verdeutlichung als notwendig errschien – eigene Textteile, Kommentare und fachliche Ergänzungen hinzugefügt.

Das Rätsel der Eiszeiten, Teil 1 – Einführung

Für viele Teilnehmer an der Klimadebatte ist es ein Schock, wenn sie zum ersten Mal erkennen, wie oft und wie stark sich das Klima in der Vergangenheit geändert hat. Selbst Prinz Charles war vermeintlich irritiert, als er fragte:

Nun, wenn es ein Mythos ist und die globale wissenschaftliche Gemeinschaft in eine Art Verschwörung involviert ist, wie kommt es dann, dass auf der ganzen Welt der Meeresspiegel über sechs Inches [über 15 cm] höher liegt als vor 100 Jahren?

Dieser Kommentar von Prinz Charles ist komisch, aber nicht überraschend, da die meisten Menschen keine Ahnung von der Klimavergangenheit haben (Meine tief empfundene Entschuldigung an Prinz Charles, falls er von den Englischen Medien falsch zitiert worden sein sollte)

Man schaue sich nur die folgende "unbequeme" Temperaturgraphik an, wenn man sehen will, wie sich die Temperaturen im Laufe der letzten 150.000 Jahre und weiter noch während der letzten Millionen Jahre verändert haben:

Quelle: “Holmes’ Principles of Physical Geology” 4th Ed. 1993

Die letzte Million Jahre sind unglaublich. Der Meeresspiegel – soweit wir das mit einiger Sicherheit sagen können – hat sich um mindestens 120 m nach oben und unten bewegt, vielleicht sogar noch um mehr. Es gibt nun zwei Sichtweisen, die diese massiven Änderungen zu erklären meinen. Besonders interessant ist dabei, wie die gleichen Daten auf derart unterschiedliche Weisen interpretiert werden können. Entweder nämlich so:

Die gewaltigen Änderungen des Klimas der Vergangenheit, die wir aus Meeresspiegel- und Temperatur-Rekonstruktionen erkennen können, zeigen, dass sich das Klima immer ändert. Sie zeigen, dass die Temperaturzunahme des 20. Jahrhunderts nichts Ungewöhnliches sind. Und sie zeigen, dass das Klima viel zu unvorhersagbar ist, um genau modelliert werden zu können.

Oder ganz anders so:

Die gewaltigen Änderungen des Klimas der Vergangenheit zeigen die sensitive Natur unseres Klimas. Kleine Änderungen der Solarstrahlung und kleinere Änderungen der Verteilung der Sonnenenergie über die Jahreszeiten (durch kleinere Änderungen im Erdorbit) haben zu Klimaänderungen geführt, die heute katastrophal wären. Klimamodelle können diese Änderungen der Vergangenheit erklären. Und wenn wir den Strahlungsantrieb des anthropogenen CO2 mit diesen kleinen Änderungen vergleichen, erkennen wir, was für eine unglaubliche Gefahr wir für unseren Planeten erschaffen haben.

Ein Datensatz also, aber zwei völlig verschiedene Sichtweisen. Wir werden versuchen, diese "Geister der Klimavergangenheit" im Nachfolgenden besser zu verstehen.

Das Rätsel der Eiszeiten, Teil II – Lorenz

Vor sehr langer Zeit habe ich den Beitrag Ghosts of Climates Past geschrieben. Ich habe viele Paper zu den Eiszeiten und den Zwischeneiszeiten gelesen, bin aber nie an den Punkt gelangt, von dem ab ich irgendetwas Zusammenhängendes schreiben konnte. Dieser Beitrag ist mein Versuch, wieder in die Gänge zu kommen – nachdem ich lange Zeit zu beschäftigt gewesen war, irgendwelche Artikel zu schreiben.

In seinem Paper aus dem Jahr 1968 mit dem Titel Climatic Determinism – präsentiert auf einem Symposium unter dem Motto Causes of Climatic Change – schreibt der berühmte Edward Lorenz:

Die oft akzeptierte Hypothese, dass die physikalischen Gesetze, die das Verhalten der Atmosphäre bestimm, das Klima eindeutig festlegen, wird kritisch geprüft. Es ist zu betonen, dass es physikalische Systeme gibt, deren Statistiken über unbegrenzte Zeitintervalle eindeutig durch herrschende Gesetze und Umweltbedingungen gesteuert werden (transitive Systeme); und es andere Systeme gibt, bei denen das nicht der Fall ist (intransitive Systeme).

Es gibt auch bestimmte transitive Systeme (fast intransitive Systeme), deren Statistiken sich über sehr lange, aber begrenzte Zeitintervalle merklich von einem Intervall zum nächsten unterscheiden. Es wird hier die Möglichkeit in Erwägung gezogen, dass langzeitliche klimatische Änderungen eher aus der Fast-Intransitivität der Atmosphäre resultieren, als dass sie von äußeren Umweltänderungen verursacht werden.

Diese Sprache könnte vielen Lesern etwas dunkel vorkommen. Aber Lorenz verdeutlicht in seinem Paper weiter:

……Während dieses Symposiums kann erwartet werden, dass viele alternative und manchmal Widerspruch auslösende Erklärungen angeboten werden. Einige davon werden Änderungen des Klimas den Änderungen der Eigenschaften der Ozeane zuordnen. Andere können sich auf Variationen vulkanischer Aktivität beziehen. Wieder andere werden Fluktuationen der Sonnenstrahlung berücksichtigen.

Die von mir gewählten Erklärungen haben als Hauptgrund für die Änderungen des Verhaltens der Atmosphäre die Änderungen der Umgebung dieser Atmosphäre. Jene, die solche Erklärungen propagieren, könnten mit sehr guten Gründen annehmen: falls Umwelteinflüsse vor langer Zeit die Gleichen gewesen wären wie heute, müsste auch das historische Klima das Gleiche gewesen sein; daher die Notwendigkeit des Bezugs auf Umweltänderungen als eine Erklärung. Kurz gesagt, sie könnten zu der nicht unvernünftigen Schlussfolgerung kommen, dass die Umgebung der Atmosphäre zusammen mit der internen Physik der Atmosphäre das Klima auf mehr oder weniger eindeutige Weise bestimmt.

Genau diese Hypothese, nämlich dass einzig die die Atmosphäre steuernden physikalischen Gesetze für das Klima verantwortlich sind, möchte ich kritisch überprüfen.

[Link zum Original dieses Ausschnitts: http://scienceofdoom.files.wordpress.com/2013/10/lorenz-1968-1.png]

Lorenz fasst hier also transitive Systeme ins Auge – das heißt, die Anfangsbedingungen bestimmen nicht den zukünftigen Klimazustand. Stattdessen tun dies die Physik und die „äußeren Einflüsse“ oder Antriebe (wie die auf dem Planeten einfallende Solarstrahlung). Lorenz schreibt weiter:

Vor allem, wenn die ein physikalisches System steuernden Gleichungen linear sind, kann ein einheitlicher Satz langfristiger Statistiken oft in analytischer Form ausgedrückt werden. Allerdings sind die die Atmosphäre steuernden Gleichungen in höchstem Maße nicht linear. Die den Hauptteil der Schwierigkeiten ausmachenden Nichtlinearität ist Advektion – der Transport von bestimmten Eigenschaften der Atmosphäre von einem Gebiet zu einem anderen Gebiet durch die Bewegung der Atmosphäre selbst. Da die Bewegung der Atmosphäre von einer Stelle zu einer anderen ebenfalls eine der Eigenschaften der Atmosphäre ist, die von abhängigen Variablen repräsentiert wird, werden jene Terme in den Gleichungen, die die Advektion repräsentieren, quadratisch sein, was das gesamte System nichtlinear macht.

Im Falle nichtlinearer Gleichungen ist die Einheitlichkeit langzeitlicher Statistiken nicht sicher. Die mathematische Modellbildung als System von gekoppelten Gleichungen, ausgedrückt in deterministischer Form, zusammen mit einem spezifizierten Satz von Anfangsbedingungen, bestimmen die zeitabhängige Lösung. Diese erstreckt sich unendlich in die Zukunft und legt daher einen Satz langzeitlicher Statistiken fest. Bleibt die Frage, ob derartige Statistiken unabhängig von der Wahl der Anfangsbedingungen sind. Wir definieren ein transitives System von Gleichungen als eines, bei dem dies der Fall ist. Gibt es jedoch zwei oder noch mehr Sätze langzeitlicher Statistiken, von denen jede eine Wahrscheinlichkeit größer als Null für die Abhängigkeit von den gewählten Anfangsbedingungen aufweist, nennen wir das System intransitiv.

Bisher sind dies nur Definitionen. Die mathematische Theorie sagt uns aber, dass sowohl transitive als auch intransitive Systeme existieren. Mehr noch, bislang wurde kein einfacher Weg gefunden, zu entscheiden, ob ein willkürliches vorgelegtes Gleichungssystem transitiv oder intransitiv ist.

[Link: http://scienceofdoom.files.wordpress.com/2013/10/lorenz-1968-21.png]

Hier führt Lorenz das verbreitet bekannte Konzept eines „chaotischen Systems“ ein, in dem unterschiedliche Anfangsbedingungen zu unterschiedlichen langzeitlichen Ergebnissen führen. (Man beachte, dass es chaotische Systeme geben kann, in welchen unterschiedliche Anfangsbedingungen unterschiedliche Zeitreihen mit den gleichen statistischen Eigenschaften über einen Zeitraum erzeugen – daher ist "intransitiv" die restriktivere Bezeichnung (siehe die Originalarbeit für mehr Einzelheiten).

3. Beispiele eines intransitiven Systems

Da ein intransitives physikalisches System, in dem die physikalischen Gesetze nicht einheitlich das Klima steuern, ein ungewöhnliches Konzept ist, seien ein paar Beispiele genannt. Eines wird durch Laborexperimente zur Simulation bestimmter atmosphärischer Vorgänge geliefert (siehe Fultz et al. 1959 und Hide 1958). Der Versuchsaufbau besteht im Wesentlichen aus einem rotierenden Bassin mit Wasser, das einer unterschiedlichen Erwärmung ausgesetzt wird. Die Bewegung des Wassers wird durch ein Kontrastmittel sichtbar gemacht. Unter geeigneten Bedingungen ensteht ein sich um die Rotationsachse bewegendes Wellenmuster.

Unter bestimmten festgelegten Bedingungen wird eine Anordnung von vier Wellen unbegrenzt lange bestehen bleiben, wenn es sich erst einmal gebildet hat; aber eine Anordnung von fünf Wellen bleibt ebenfalls unbegrenzt lange bestehen. Das ist ein wirklich intransitives System. Externes Manipulieren wie umrühren des Wassers mit einem Bleistift kann das System von vier Wellen in eines mit fünf Wellen umwandeln und umgekehrt. Unter geringfügig veränderten festgelegten äußeren Bedingungen wie z. B. einer etwas höheren Rotationsgeschwindigkeit, wird sich nur das System mit fünf Wellen ausbilden. In diesem Falle ist das System transitiv. Transitivität ist eine qualitative Eigenschaft des Experiments, aber sie hängt definitiv ab von den quantitativen Eigenschaften der Eingangsgrößen.

Ein anderes Beispiel wird durch einfache numerische Modelle zur Simulation allgemeiner Eigenschaften der Atmosphäre geliefert (siehe z. B. Lorenz 1963). Sowohl transitive als auch intransitive Systeme sind leicht zu konstruieren. Der Unterschied zwischen ihnen kann einfach der numerische Wert eines einzelnen vorbestimmten Parameters sein.

Wie ist das nun in der realen Atmosphäre? Ist sie transitiv? Wir wissen es nicht. Die Atmosphäre ist weder ein Laborexperiment noch ein Zahlensatz in einem Computer, und wir können sie nicht abschalten und dann erneut in Bewegung setzen, um zu sehen, ob sich ein neues Klima bildet. Auch die derzeit bekannte mathematische Theorie gibt uns darauf keine Antwort.…

Wie war das doch gleich wieder mit der realen Atmosphäre? Es war nicht meine ursprüngliche Absicht, einen Pflock "Fast-Intransitivität" als Hauptgrund für eine Klimaänderung einzuschlagen. Allerdings ist die Fast-Intransitivität ein zu wichtiges Phänomen, um als Ganzes missachtet zu werden. Was dieses Symposium angeht, habe ich den deutlichen Eindruck, dass auch niemand anders einen solchen Pflock einschlagen wird. Lassen Sie mich also sagen, dass ich Fast-Intransitivität als prinzipiellen Grund für Klimaänderungen für möglich halte, aber nicht in der Lagen bin zu sagen, sie sei der wahrscheinlichste Grund. Vielleicht kann man einmal mehr sagen, wenn wir die Gelegenheit erhalten, die Lösungen von viel größeren numerischen Modellen auf viel längere Zeitintervalle auszudehen und dabei zu sehen, ob Fast-Intransitivität im Zeitmaßstab von Jahrhunderten und nicht nur von Jahren auftritt.

5. Schlussfolgerungen

Trotz unseres mageren Wissens über die Fast-Intransitivität können wir ein paar Schlussfolgerungen ziehen. Zum Einen kann die bloße Existenz langzeitlicher Klimaänderungen nicht aus sich selbst heraus als Beweis für Umweltveränderungen herangezogen werden; es gibt jetzt alternative Erklärungen. Und schließlich, was ist mit der nicht unwahrscheinlichen Möglichkeit, dass die Atmosphäre fast-intransitiv ist, falls die Umwelteinflüsse konstant sind, während gleichzeitig äußere Umweltveränderungen stattfinden? Die Auswirkungen dieser Änderungen werden dann schwieriger zu entdecken und kausale Beziehungen schwieriger zu etablieren sein. Zum Beispiel: eine Umweltveränderung, die einen Temperaturanstieg um 2°C zur Folge hat, könnte genau zu der Zeit erfolgen, wenn die Temperatur als Folge der Fast-Intransitivität um 2°C fällt. Die Umweltveränderung bleibt dann unbemerkt, weil niemand einen Grund erkennt, nach ihr zu suchen.

Zusammengefasst kann das Klima deterministisch sein oder auch nicht. Möglicherweise werden wir das niemals sicher sagen können. Wenn aber die mathematische Theorie weiter entwickelt wird, könnten wir hinsichtlich unserer Ansichten allmählich sicherer werden.

Nun, das ist ein interessanter Ansatz des bedeutenden Lorenz‘. Ein späteres Paper, nämlich von Kagan, Maslova & Sept (1994) kommentierte Lorenz‘ Studie aus dem Jahr 1968 und erzielte mit einem ziemlich einfachen Modell interessante Ergebnisse:

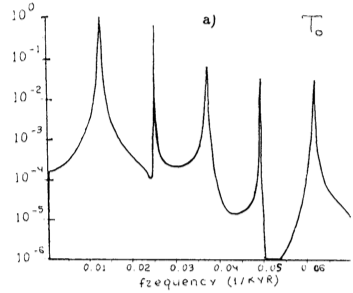

Bild: Spektrale Intensität von Klimaperiodizitäten gegen Frequenz in [1/tausend Jahre], die Periodenlänge ergibt sich aus dem Kehrwert der Frequenz.

Im paper von Kagen und Maslova findet sich weiter folgender Kommentar:

Man beachte folgende bemerkenswertesten Eigenschaften: erstens, die starken Maxima bei den Perioden 80 x 10³, 41 x 10³, 21 x 10³ und 18 x 10³ Jahren nahe der Exzentrizitäts-Periode (~100 x 10³ Jahre), der "precessional"-Periode (~41 x 10³ Jahre) sowie der Präzessions-Perioden (~23 x 10³ und ~19 x 10³ Jahre). zweitens, eine Abnahme der Amplituden der Ozeantemperatur-Oszillationen mit Perioden von 21 x 10³ und 18 x 10³ Jahren mit zunehmender Tiefe (oder Breite); und drittens die führende Rolle der Änderungen des Partialdrucks des atmosphärischen CO2 während Änderungen der kontinentalen Eismassen (cf. Abbildungen 2a und 2b).

Diese Eigenschaften der Lösung sind ähnlich den aus geochemischen Studien gewonnenen Daten (Broecker und Danton 1989; Imbrie 1992; Ruddiman und McIntyre 1984), jedoch in keiner Weise verbunden mit Variationen der astronomischen Parameter. Im Einzelnen sind 80 x 10³ Jahre eine Periode diskontinuierlicher Auto-Oszillationen. 41 x 10³ und 21 x 10³ Jahre sind Perioden ihrer Schwingungen, und 18 x 10³ Jahre ist eine Periode, die definiert wird durch die Differenz zwischen der Lebenszeit einer normalen (gegenwärtigen) und anormalen (umgekehrten) Zirkulation (Abbildung 2c). Mit anderen Worten, in unserem Fall ist der Grund für die oben genannten Eigenschaften die interne Variabilität des Klimasystems als Folge von diskontinuierlichen Auto-Oszillationen der ozeanischen thermohalinen Zirkulation.

Das heißt, ein paar zusammen arbeitende gekoppelte Systeme können ausgeprägte Veränderungen des Erdklimas auslösen in Zeiträumen wie 80.000 Jahren. Falls irgendjemand denken könnte, dass es lediglich obskure ausländische Journale sind, die über Lorenz‘ Arbeit schreiben, so hat der viel veröffentlichte Klimaskeptiker(?) James Hansen dazu Folgendes zu sagen {– Redaktionelle Anmerkung: Das Fragezeichen wurde von uns hinzugefügt, denn wir kennen J. Hansen nur als AGW-Aktivisten, seine Eigenschaft als "Klimaskeptiker" ist uns neu –}:

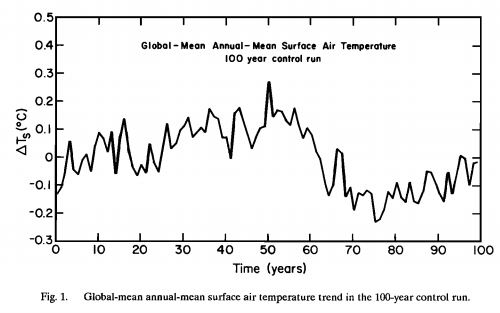

Die Variation der globalen mittleren jährlichen Lufttemperatur während des 100-jährigen Kontrolllaufes zeigt die weiter unten stehende Abbildung. Die globale mittlere Temperatur am Ende des Laufes ist sehr ähnlich derjenigen zu Beginn, aber es gibt eine substantielle Variabilität ohne äußeren Antrieb in allen Zeiträumen, die untersucht werden können, das heißt bis zu Zeiträumen von Jahrzehnten. Man beachte, dass eine Änderung (ohne äußeren Antrieb) der globalen Temperatur von etwa 0,4°C (0,3°C, wenn die Kurve mit einem 5-jährigen gleitenden Mittel geglättet wird) in einem 20-Jahres-Zeitraum aufgetreten ist (Jahre 50 bis 70). Die Standardabweichung über das 100-jährige Mittel beträgt 0,11°C. Diese Variabilität (ohne äußeren Antrieb) der globalen Temperatur im Modell ist nur wenig kleiner als die beobachtete Variabilität der globalen Temperatur während des vorigen Jahrhunderts wie in Abschnitt 5 diskutiert. Die Schlussfolgerung, dass eine (ohne äußeren Antrieb und unvorhersagbare) Klimavariabilität für einen Großteil der Klimaänderung ursächlich sein kann, ist von vielen Forschern betont worden; zum Beispiel Lorenz (1968), Hasselmann (1976) und Robock (1978).

Und hier nun der Kontrolllauf aus der Studie von J. Hansen:

Abbildung (J. Hansen): Trend der globalen jährlichen Mitteltemperatur während des 100-jährigen Kontrollaufes.

{– Redaktionelle Anmerkung: Inzwischen weiß man, dass solche Fluktuationen, wie in der Abbildung von J. Hansen gezeigt, durch "Persistenz" oder Autokorrelation jeder realen Temperaturreihe auftreten. Die hier geltende Theorie (Hurst-Exponent) ist rein empirisch, also modellfrei, physikalische Ursachen der Persistenz von Temperaturreihen sind nicht bekannt (hier) –}.

In späteren Artikeln werden wir einige Theorien der Milankovitch-Zyklen beleuchten. Verwirrenderweise laufen viele unterschiedliche Theorien, die zumeist auch noch jeweils inkonsistent miteinander sind, alle unter der gleichen Bezeichnung "Milankovitch".