|

Mit dem Ausbau erneuerbarer Energien will die Bundesregierung die Energieversorgung in Deutschland auf eine neue Grundlage stellen. Strom soll klimafreundlich, preiswert und versorgungssicher produziert werden. Diese "Energiewende" schaffe Millionen neuer Jobs in der Ökoindustrie und reduziere unsere Abhängigkeit von Öl- und Gasimporten aus den Krisenregionen der Welt.

Was klingt, wie das energiepolitische "Utopia", ist der ernstgemeinte Anspruch deutscher Energiepolitik. Parteien übertreffen sich in einem Wettbewerb der schönen Worte und guten Absichten. Mit der Realität haben diese aber wenig zu tun. Alle wichtigen Ziele wurden verfehlt. Die deutschen Kohlendioxidemissionen steigen trotz gigantischer Subventionen für Erneuerbare Energie, die Kosten laufen aus dem Ruder, und die Versorgungssicherheit des Stromnetzes ist zunehmend gefährdet. Der flächendeckende Zubau von Solar- und Windkraftanlagen führt zu massiven Konflikten mit dem Natur- und Landschaftsschutz. Immer mehr Bürger wenden sich von der "Energiewende" ab.

Es ist eine grundlegende Kurskorrektur notwendig. Wir brauchen eine Energiepolitik mit wirtschaftlichem Verstand, eine Energiepolitik, die die Gesetze der Physik versteht und Innovationen fördert statt bremst. Energieerzeugung muss sich an den Bedürfnissen der Verbraucher, nicht an politischen Ideologien ausrichten. Statt grüner Steinzeitökonomie müssen endlich wieder marktwirtschaftliche Prinzipien und ordnungspolitische Grundsätze Platz greifen, wenn Deutschland energiepolitisch nicht völlig gegen die Wand gefahren werden soll….

….Das seither mehrfach angepasste EEG garantiert auf zwanzig Jahre Vergütungen für die Erzeugung von Ökostrom und verpflichtet die Versorger zum Anschluss der Anlagen sowie zur Abnahme und Einspeisung von Grünstrom. Mit diesem beispiellosen "Rund-Um-Sorglos-Paket" werden Investoren (fast) alle Risiken und Aufgaben eines Unternehmers per Gesetz zu Lasten der Verbraucher abgenommen. Vermarktung, Preisgestaltung, Produktivität, Innovationen – damit müssen sich die als Pioniere gefeierten Ökoinvestoren nicht beschäftigen. Auch wie die speziellen Herausforderungen von Energieversorgungssystemen, konkret die Sicherstellung der Netzstabilität und Versorgungssicherheit, gemeistert werden sollen, ist nicht deren Problem.

Diese Planwirtschaft hat maßgeblich dazu beigetragen die gesamte Energiewirtschaft, nicht nur in Deutschland, in eine tiefe Krise zu führen. Wenn Markt und Wettbewerb ausgeschaltet werden, entstehen keine Innovationen, gibt es keine Anreize, etwas zu verbessern und die Produktivität zu erhöhen. Wer sich am Markt behaupten muss, steht dagegen ständig unter Druck, besser und oder günstiger zu werden und ist viel stärker auf den Verbraucher und seine Bedürfnisse orientiert.

Für Betreiber von Windkraft- und Solaranlagen spielt das alles dagegen keine Rolle. Sie können wie auf einer Insel agieren, losgelöst von allem, was herum passiert. Die Ökostromproduktion ist blind und taub gegenüber allen Impulsen und Signalen des Marktes. Risiken tragen nur die Verbraucher und die nicht subventionierten Wettbewerber im Bereich der konventionellen Stromerzeugung. Doch wenn Markt und Wettbewerb ausgeschaltet werden folgt, Stagnation. Wie aus dem Lehrbuch zeigt das EEG, wie staatswirtschaftlich orientierte Politik die Entwicklung einer preisgünstigen, klimafreundlichen und technisch tragfähigen Energieerzeugung verhindert.

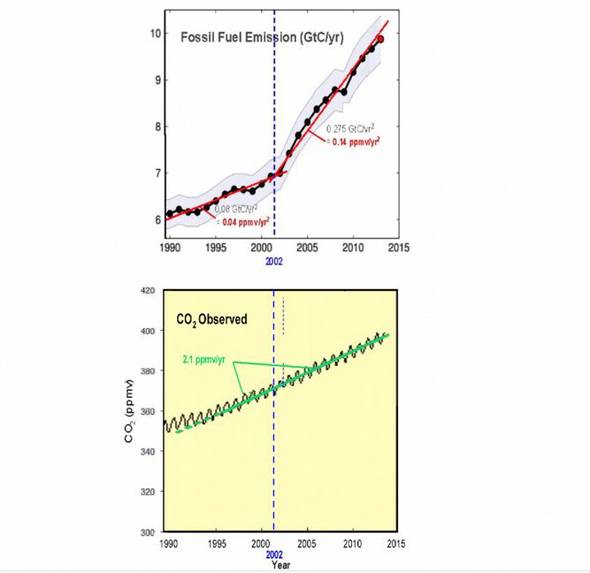

So haben die deutschen Verbraucher bisher rund 150 Milliarden Euro an Subventionen für Erneuerbare Energien aufbringen müssen. In den letzten Jahren jeweils deutlich mehr als 20 Milliarden Euro. Die deutsche Klimabilanz ist deshalb aber nicht besser geworden. Im Gegenteil: Laut Bundesumweltamt steigen die CO-2 Emissionen Jahr für Jahr. Die Expertenkommission der Bundesregierung schreibt in ihrem aktuellen Bericht, dass das EEG kein Beitrag zu einem effektiven Klimaschutz darstellt und damit das eigentliche Hauptziel verfehlt. Zu einer ähnlichen Bewertung kommt der dritte Teilbericht zum Fünften Sachstandsbericht des IPCC, besser bekannt als "Weltklimarat" der Vereinten Nationen.

….Dieses intelligente und technologieoffene Instrument der europäischen Ebene (Anmerkung der EIKE Redaktion: gemeint ist der ebenso kostentreibende wie unnütze Emissionshandel) wird jedoch in Deutschland durch das dumpfe und starre EEG weitgehend ausgeschaltet. Hierzulande definiert nämlich das Gesetz auf zwanzig Jahre im Voraus, welche Technologien zu welchen Kosten zum Einsatz kommen sollen. So fließt mit über 10 Milliarden Euro jährlich der größte Teil der EEG-Umlage in die Photovoltaik und damit ausgerechnet in die Technologie, die die schlechteste CO-2-Vermeidungsbilanz aufweist. Im Vergleich zu anderen Maßnahmen, zum Beispiel die Modernisierung von Braunkohlekraftwerken in Polen, kostet die Vermeidung einer Tonne CO-2 durch Subventionierung von Solarstrom das Vierzigfache…..

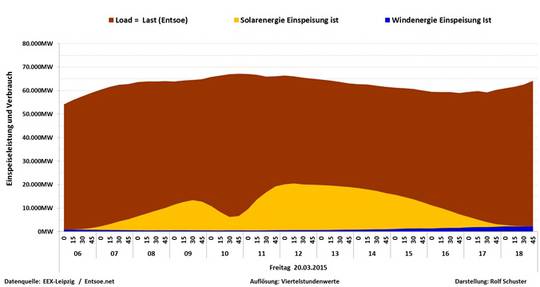

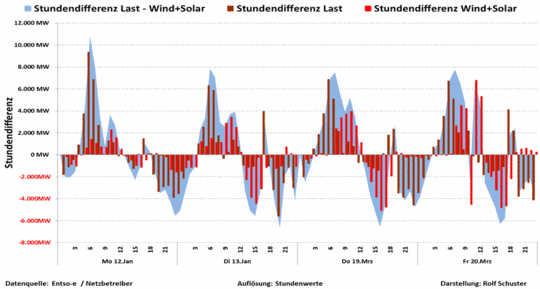

….Auch den komplexen technischen Anforderungen an die Energieversorgung eines modernen Industriestaates wird das planwirtschaftliche EEG nicht einmal im Ansatz gerecht. Es ist gegenüber der Notwendigkeit blind, dass elektrischer Strom aufgrund seiner physikalischen Eigenschaften ein besonderes Gut ist. Für die Versorgungssicherheit eines Stromnetzes ist es irrelevant, ob auf Jahressicht 30 oder 40 Prozent des Verbrauches aus erneuerbaren Energiequellen stammt. Entscheidend ist alleine, ob entsprechend des Lastganges, also der Verlaufskurve des Stromverbrauches, in jedem Augenblick die notwendige Menge an Energie verfügbar ist. Wird zu viel oder zu wenig Strom eingespeist, droht der Netzkollaps.

Die mit Gas oder Kohle betriebenen konventionellen Kraftwerke können nach dem Bedarf der Verbraucher, also des Lastganges, gesteuert werden. Das gleiche gilt für Kernkraftwerke. Die Verbrauchskurven sind regelhaft, d.h. die Versorger wissen genau, dass die Spitzen werktags zur Mittagszeit erreicht werden und die geringste Leistung sonntags in der Nacht zur Verfügung stehen muss. Im Winter steigt die Kurve gegenüber den Sommermonaten, da beispielsweise mehr Strom für Beleuchtung notwendig ist. Kohle- und Kernkraftwerke arbeiten im Bereich der Grundlast, d.h. rund um die Uhr, Tag für Tag, Jahr für Jahr. Gaskraftwerke werden in der Regel zugeschaltet, um den stundenweisen Mehrbedarf an Leistung zu befriedigen.

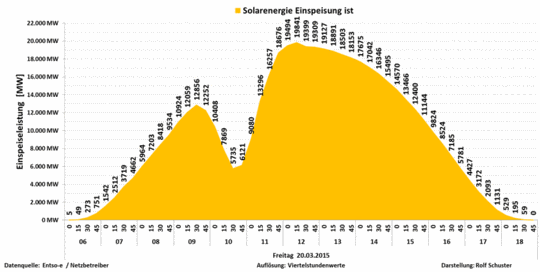

Mit dem Ausbau erneuerbarer Energien kommt es zu einem Paradigmenwechsel. Die grundlegenden Vorzeichen der Stromversorgung ändern sich. Wind- und Sonnenstrom werden nämlich nicht so erzeugt, wie es der Energiebedarf der Verbraucher verlangt, sondern wie es das Wetter möglich macht. Logischerweise hängt die Leistung der Solarkraftwerke vom Stand der Sonne ab. Wenn die Sonne untergeht, geht auch die elektrische Leistung dieser Kraftwerke auf Null.

Die in Deutschland installierte Solarstromleistung betrug im Februar 2015 insgesamt 38,3 Gigawatt. Das entspricht theoretisch der Leistungsfähigkeit von 38 Atomkraftwerken. In den Wintermonaten lässt sich die Sonne bekanntlich aber kaum in unseren Breitengraden sehen, und so standen durchschnittlich nur 2 GW Leistung tatsächlich zur Verfügung, was einer mageren Auslastung von etwas mehr als 5 Prozent entspricht. An den wenigen sonnigen Tagen, beispielsweise am 20. Februar, standen zur Mittagszeit fast 18 GW zur Verfügung. An den bewölkten Tagen schwankte die Leistung dagegen zwischen Null und 6 GW.

Eine verlässliche Stromversorgung ist auf dieser Basis schlicht unmöglich. Selbst wenn die installierte Solarkraftleistung verzehnfacht würde, wäre eine Stromversorgung aufgrund der Schwankungen nicht möglich. Wenn keine Sonne scheint, kann auch kein Strom erzeugt werden, egal wie viele Solarmodule auf den Dächern und Feldern stehen. An sonnigen Tagen würde die Produktion dagegen durch die Decke schießen und viel zu viel Strom erzeugt, der den Ökoinvestoren bezahlt werden müsste, aber ohne Speichertechnologien völlig unbrauchbar ist. Im Gegenteil: Die Ableitung und Verwertung dieses "Strommülls" führt noch zu erheblichen Zusatzkosten.

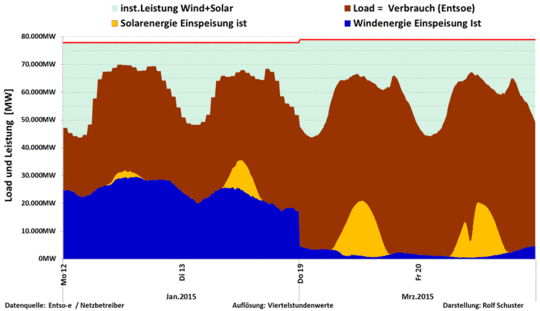

Genau die gleichen technischen Probleme macht auch die Windkraft. Von den 27.000 deutschen Windrädern mit einer installierten Leistung von 40 GW stehen regelmäßig etwa 26.900 Windkraftanlagen still, und zwar nicht nur in den windschwachen Sommermonaten, sondern auch im Januar oder Februar. Schauen wir auf die Zahlen. Im Februar lag die Leistungsspitze der Windkraft bei 24,9 GW, was einer Auslastung von 62,5 Prozent entspricht. Das Minimum wurde bei 0,26 GW (0,7 Prozent Auslastung) erreicht. Mit jeder neuen Windkraftanlage wird diese Leistungsschere größer und das Problem der Netzstabilität verschärft. Obwohl in ganz Deutschland Windkraftanlagen verteilt sind, kommt es zu keiner Glättung der eingespeisten Leistungen. Die Wetterdaten belegen vielmehr eine enge Korrelation der windstarken deutschen Regionen. Da, wo viel Wind weht, weht er meistens gleichzeitig, und wenn Flaute herrscht, dann im ganzen Land.

Im Verhältnis zur Sonnenstromerzeugung hat die Windenergieerzeugung eine noch größere Schwankungsbreite, worunter die Versorgungssicherheit leidet. Auch wenn nicht genau absehbar ist, wie groß die Solarstromleistung von Tag zu Tag ist, fällt Solarstrom regelmäßig in den Mittagsstunden an, weil der Lauf der Sonne einem Naturgesetz folgt. Da die Verbrauchsspitzen auch zur Mittagszeit auftreten, ist Solarstrom in der gegenwärtigen Größenordnung zwar sehr teuer, aber technisch verwertbar.

Der Wind weht dagegen nach keinen festen Regeln und so fällt die gesamte deutsche Windstromerzeugung manchmal tagelang am Stück aus, weil Hochdruckwetterlagen vorherrschen. Und wenn der Wind dann einmal stark weht, dann eben auch in den Nachtstunden, in denen der Stromverbrauch am geringsten ist. Windkraft ist also nicht nur sehr unzuverlässig, ist erzeugt Strom eben auch dann, wenn er am wenigsten benötigt wird. Von allen erneuerbaren Energiequellen ist Windkraft deshalb am schlechtesten geeignet und stellt das Stromnetz vor die größten Herausforderungen.

Für den Rhythmus eines modernen Industriestaates hat der beschriebene Paradigmenwechsel – weg vom Vorrang des Bedarfes, hin zum Vorrang der Verfügbarkeit – dramatische Auswirkungen. Synchronisierung und Standardisierung von Handeln sind grundlegende Voraussetzungen moderner, arbeitsteiliger Gesellschaften. Das Arbeitsleben beginnt morgens und endet abends und nicht dann, wenn Strom gerade da ist oder nicht.

Alles, was jetzt unter so schönen Schlagwörtern wie "Lastgangmanagement" oder "smart grids" als Lösungsvorschlag präsentiert wird, ist nichts anderes als der Versuch, die beschriebenen grundlegenden technischen Probleme erneuerbarer Energien zu übertünchen. Das berühmte Beispiel von der Waschmaschine, die in Zukunft nachts laufen soll, wenn gerade Windstrom im Netz ist, hat mit den realen Problemen nichts zu tun.

Die großen Stromverbraucher, die Deutsche Bahn, die Betriebe der chemischen Industrie, die Unternehmen in der Metallverarbeitung oder die Rechenzentren, sind auf eine sichere, kontinuierlich verfügbare und im internationalen Vergleich bezahlbare Stromversorgung angewiesen. Deutsche Werke und Standorte sind Teil eng vernetzter, länderübergreifender Wertschöpfungsketten. Schon die Idee, dass eine Exportnation wie Deutschland seine Energieversorgung und damit auch die Produktionsprozesse nach dem Lauf der Sonne oder der momentanen Windgeschwindigkeit ausrichten könne, ist lächerlich.

Ohne konventionelle Kraftwerke ist eine sichere und bezahlbare Stromversorgung auf absehbare Zeit nicht möglich. Das Geschäftsmodell der Ökoinvestoren basiert immer auf der Inanspruchnahme und Betriebsbereitschaft von Kohle-, Gas- und Kernkraftwerken. Für die Betreiber dieser systemrelevanten Kraftwerke wird es dagegen immer schwerer, die Kosten am Markt zu refinanzieren. Die großen deutschen Energieunternehmen und die kommunalen Stadtwerke machen deshalb gegenwärtig massiv Verluste. Ihr Geschäftsmodell wird durch den Ausbau der erneuerbaren Energien zerstört.

Je mehr subventionierter Ökostrom an der Strombörse zu billigsten Preisen auf den Markt gebracht wird, umso geringer ist der mögliche Erlös der Betreiber konventioneller Kraftwerke. Von Jahr zu Jahr sinken die durchschnittlichen Strompreise an der Börse. Besonders die klimafreundlichen Gaskraftwerke haben unter dieser Entwicklung zu leiden, weil sie die relativ höchsten Erzeugungspreise aufweisen.

Die Bundesnetzagentur verbietet jedoch unter Verweis auf die Rechtslage das Abschalten konventioneller Kraftwerke, weil die Versorgungssicherheit sonst gefährdet sei. Während Ökoinvestoren üppige Subventionen kassieren, werden andere Unternehmen also kalt enteignet…..

…..Die Frage der Energieerzeugungskosten und der Gesamtkosten des Systems ist ein ganz entscheidender Faktor in der Bewertung der Energiepolitik. Auch in diesem Punkt weist das EEG eine verheerende Bilanz auf. Der frühere Bundesumweltminister Jürgen Trittin hatte den Deutschen versprochen, dass die Förderung erneuerbarer Energien im Monat so viel koste wie eine Kugel Eis.

In Wahrheit wurden bisher schon rund 150 Milliarden Euro an EEG-Umlage von den Verbrauchern kassiert, in den letzten Jahren jeweils über 20 Milliarden Euro. Da die Ökosubventionen auf 20 Jahre gewährt werden, kommen zu den bereits gezahlten Summen noch die zukünftigen Zahlungsverpflichtungen. Experten rechnen aktuell mit Gesamtkosten von 500 Milliarden Euro. Zum Vergleich: Für die Zukunftsthemen Bildung und Forschung gibt der Bund gerade 13,7 Milliarden Euro aus.

Den größten Teil der Ökosubventionen bringen die gewerblichen Verbraucher auf. Dadurch sinkt deren Wettbewerbsfähigkeit mit negativen Auswirkungen auf Wertschöpfung und Arbeitsplätze. Deutschland hat nach Dänemark, dem Windkraftland Nummer Eins, die höchsten Strompreise Europas. Industriebetriebe müssen laut Bundesverband der Energiewirtschaft mehr als 10 Cent je Kilowattstunde für Steuern, Abgaben und Umlagen aufbringen. In Frankreich und den Niederlanden sind es nur 3,7 Cent, in Polen und Großbritannien sogar nur 2,6 Cent. International agierende Unternehmen werden deshalb genau rechnen, ob sie weiter in Deutschland investieren oder ihre Kapazitäten im Ausland, etwa im Billigstromland USA oder in Asien, (noch schneller) hochfahren.

Eine Umfrage der landeseigenen Hessen-Agentur (2013) bei allen hessischen Unternehmen mit mehr als 250 Beschäftigten kommt zu einem klaren Ergebnis: Mehr als zwei Drittel der Befragten rechnen mit negativen oder sehr negativen Auswirkungen und die Hälfte der Unternehmen erwartet eine sinkende Wettbewerbsfähigkeit.

Aus dem grünen Jobwunder, das vielfach besprochen wurde, ist dagegen nichts geworden. Die mit Milliardensubventionen aufgebaute Solarindustrie ist jäh auf den Boden der Tatsachen aufgeschlagen. Der Beschäftigungsbericht "Erneuerbare Energien" (2013) des Bundeswirtschaftsministeriums weist beispielsweise bei Solarunternehmen im Vergleich zum Vorjahr ein Minus von 56 Prozent beim Umsatz und ein Minus von 44 Prozent bei den Jobs aus.

Statt sonniger Aussichten stehen Rekordverluste und Insolvenzen auf der Tagesordnung. Statt neuer Jobs gibt es Massenentlassungen. Und das alles, obwohl der Weltmarkt für Solarmodule weiter wächst. Die deutsche Solarwirtschaft ist ein Paradebeispiel dafür, dass sich mit Subventionen langfristig kein wirtschaftlicher Erfolg erkaufen lässt. Verwöhnt von Anfangserfolgen und der starken heimischen Nachfrage haben deutsche Hersteller den Anschluss an die Weltspitze, die heute ausnahmslos aus Asien kommt, verloren.

Wer die deutsche Energiepolitik und das EEG nüchtern betrachtet, muss zu der Erkenntnis kommen, dass diese Politik gescheitert und die zentralen Ziele verfehlt wurden. Das EEG sollte deshalb schnellstmöglich abgeschafft werden. Außer der Ökolobby braucht niemand dieses Gesetz. Wir müssen die Energiepolitik wieder vom Kopf auf die Füße stellen und die grüne Steinzeitökonomie beenden……

..Entscheidend darf nicht sein, ob die Art und Weise der Stromerzeugung der politischen Führung unseres Landes gefällt, sondern ob sie im Sinne des Klimaschutzes und der Verbraucher wirklich funktioniert, und zwar so, dass Deutschland auch im internationalen Wettbewerb und angesichts sinkender Weltmarktpreise für Energie und Rohstoffe bestehen kann. Deshalb müssen wir mehr Markt erlauben und den Wettbewerb zwischen den Anbietern und Technologien fördern, da nur so Innovationen entstehen können.

|