Eine schöne Theorie, aber wieviel Wahrheit steckt dahinter? Gibt es Messdaten, die dieses Modell untermauern? Zuallererst muss man sich die Komplexität der Fragestellung vor Augen führen: Wir möchten herausfinden, ob es in den Weltozeanen Wasserschichten gibt, die sich erwärmt haben. Die Temperatur der Wasseroberfläche lässt sich anhand der modernen Satelliten relativ leicht ermitteln. Bei den bis zu 11 km tiefen Ozeanen wird es allerdings schwieriger. Satelliten helfen hier nicht weiter, denn sie erhalten aus der Tiefe der Ozeane keine Informationen. Die oberen Wasserschichten verdecken die darunterliegenden. Um die Temperaturdaten in allen drei Dimensionen, Fläche und Tiefe sowie die zeitliche Veränderung der Werte zu erfassen, müssen Wiederholungsmessungen in der Wassersäule vor Ort durchgeführt werden, was sich bei 362 Millionen Quadratkilometern Meeresoberfläche als logistisches Problem darstellt.

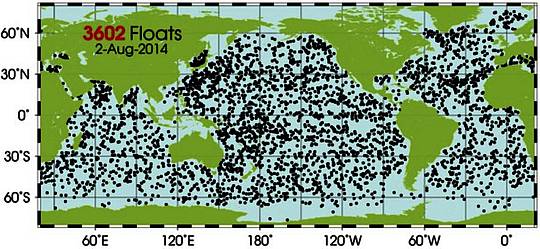

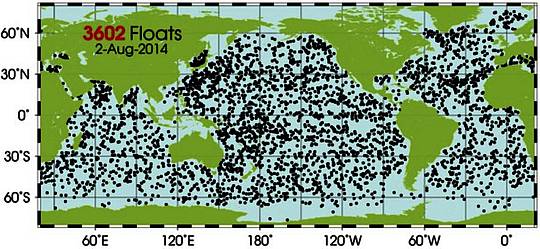

Aufgrund der enormen Bedeutung solcher Daten hat sich die Wissenschaft in den letzten Jahren jedoch etwas einfallen Lassen. Seit 2007 gibt es zur Bestimmung der Temperatur der Tiefsee das sogenannte Argo-Programm, das aus mehr als 3600 automatischen Tauchbojen besteht, die in den Weltozeanen treiben und regelmäßig die Wassersäule von 2000m Tiefe bis zur Wasseroberfläche durchtauchen und dabei Temperatur und Salzgehalt messen. Wikipedia hat die Einzelheiten:

Diese Messroboter sind relativ klein und wiegen zwischen 20 und 30 kg. Alle profilierenden Treibbojen, die zum Argo-Programm gehören, unterliegen einer gemeinsamen Datenpolitik und die Daten werden in Echtzeit ohne Einschränkung für die Allgemeinheit verfügbar gemacht. In der Mehrzahl der Fälle treiben die Floats in Tiefen von 1000 m (der sogenannten Parktiefe) und tauchen alle zehn Tage dann zunächst auf 2000 m ab, um von dieser Tiefe aus an die Oberfläche aufzusteigen. Während des Aufstiegs zur Meeresoberfläche messen die Floats Temperatur, Leitfähigkeit und Druck in der Wassersäule. Mit der Hilfe der gemessenen Parameter können dann auch noch der Salzgehalt und die Dichte des Meerwassers berechnet werden. Dichte ist eine wichtige Größe in der Ozeanographie, da horizontale Dichteunterschiede die großskaligen Strömungen im Ozean antreiben. Das mittlere Strömungsfeld in der Parktiefe lässt sich aus der zurückgelegten Distanz und der Richtung aufeinanderfolgender Floatpositionen bestimmen. Dabei werden die Positionen aber nicht in der Parktiefe gemessen, sondern erst an der Oberfläche durch die Positionierungssysteme der GPS- oder ARGOS-Satelliten. Die Übertragung der gemessenen Daten erfolgt ebenfalls per Satellit an internationale Datenzentren wo alle Daten gesammelt, in Echtzeit qualitätsgeprüft und dann zur Nutzung bereitgestellt werden.

Abbildung 1: Lagekarte der Argo-Bojen am 2. August 2014. Abbildung: Argo-Webseite.

Der folgende Cartoon von Malou Zuidema & Esmee van Wijk beschreibt den Argo-Messablauf sehr eindrücklich:

Während das Argo-Programm einen Riesenschritt nach vorne bedeutet, fehlen immer noch systematische Messungen aus Wassertiefen unterhalb von 2000 m. Die Datenlücke ist enorm, wenn man bedenkt, dass die durchschnittliche Tiefe der Ozeane bei knapp 3700 m liegt. Auch fehlen natürlich verlässliche, weltumspannende Daten aus der Vor-Argo-Ära, also vor 2007. Der gut abgedeckte Argo-Messzeitraum beträgt lediglich 7 Jahre, was gegenüber dem klimatischen Mindestintervall von 30 Jahren äußerst gering ist.

Bevor wir nun in die vorliegenden Messdaten gehen, müssen wir noch einen Begriff einführen, der bei der Beschreibung und Zusammenfassung der ozeanischen Temperaturverhältnisse und Veränderungen eine wichtige Rolle spielt, der sogenannte „Wärmeinhalt der Ozeane“, auf englisch „Ocean Heat Content“ (OHC). Wikipedia erläutert:

Als Wärmeinhalt der Ozeane […] wird die im Meer oder auch Teilen desselben (z. B. Ozeanen) gespeicherte thermische Energie (die Wärmemenge) bezeichnet. Wasser hat eine höhere Wärmekapazität als die Luft, daher ist der Wärmeinhalt der Ozeane höher als in der Atmosphäre. Die Atmosphäre enthält nur etwa 2% der gesamten Wärmekapazität der Erde.

Und dies ist einer der Hauptgründe, weshalb wir uns mit allen Wasserschichten der Ozeane beschäftigen sollten und nicht nur mit der Wasseroberfläche: In der Gesamtheit des Ozeanwassers kann tausend Mal mehr Wärme gespeichert werden, als in der Atmosphäre. Selbst kleine Veränderungen in den Ozeanen haben daher eine Bedeutung.

Veränderungen des ozeanischen Wärmeinhalts in den letzten 50 Jahren

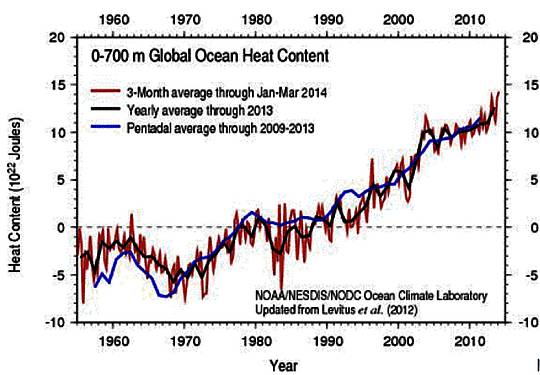

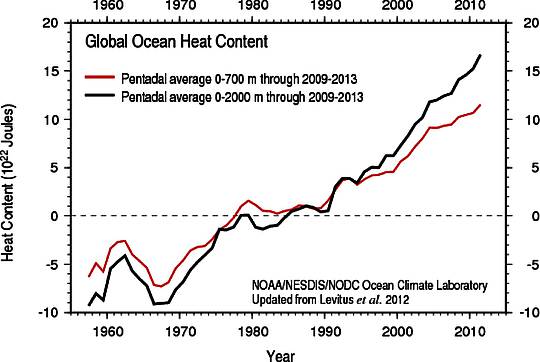

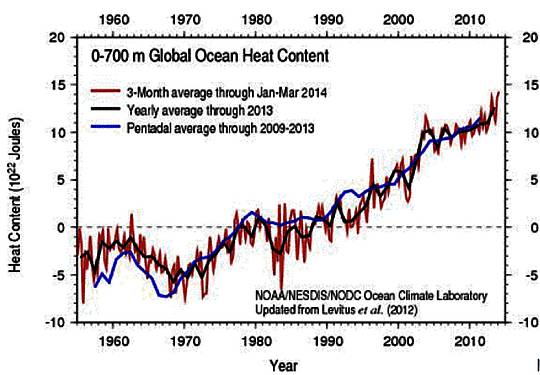

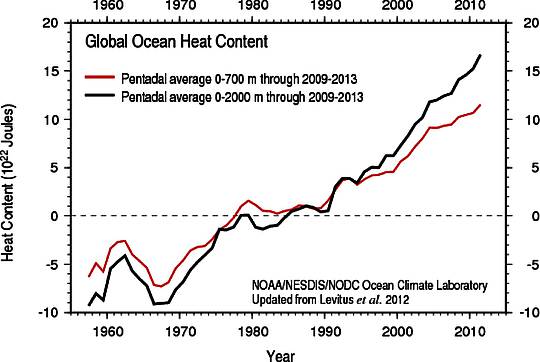

Die Entwicklung des ozeanischen Wärmeinhalts (OHC) wird üblicherweise für bestimmte Wassertiefenbereiche dargestellt. Die Nordamerikanische Ozeanographische Behörde NOAA zeigt in der folgenden Abbildung die OHC für die letzten 60 Jahre für das Tiefenintervall 0-700m, also einen zusammenfassenden Wert für den globalen Wasserkörper von der Wasseroberfläche bis in eine Tiefe von 700 m:

Abbildung 2: Entwicklung des ozeanischen Wärmeinhalts für die letzten 60 Jahre (Tiefenintervall 0-700m). Quelle: NOAA.

Der OHC stieg in den letzten Jahrzehnten spürbar an, was wenig verwundert, da die globale Erderwärmung in der gleichen Zeit um ein halbes Grad fortgeschritten ist. Die Datengrundlage in der Vor-Argo-Zeit ist selbstverständlich recht dünn. Nehmen wir trotzdem einmal an, dass der Trend so stimmt. Vielleicht haben Sie schon bemerkt, dass an der Y-Achse keine Temperaturen aufgetragen sind, sondern die Energie in Joules. Diese Energie lässt sich jedoch in Temperaturen zurückübersetzen (mit Dank an Lucia / The Blackboard):

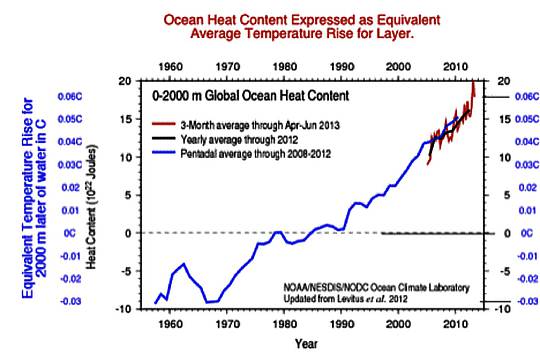

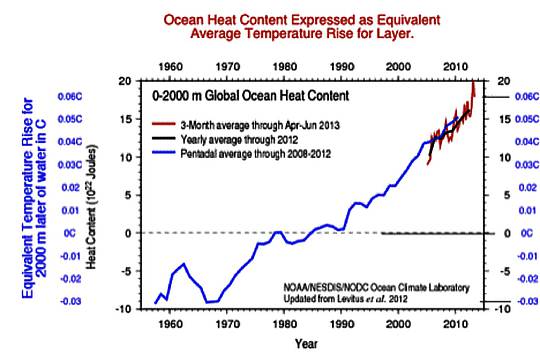

Abbildung 3: OHC-Veränderung der letzten 60 Jahre, ausgedrückt in Grad Celsius. Quelle: Lucia / The Blackboard.

Haben Sie es bemerkt? Die OHC-Veränderung der letzten 60 Jahre umfasst eine Änderung um weniger als 0,1°C. Ein äußerst geringer Betrag, selbst wenn man die enorme Wärmekapazität des Ozeans gegenüber der Atmosphäre berücksichtigt (siehe auch Bob Tisdales Kurven auf WUWT).

Schauen wir jetzt in die tieferen Wasserschichten, 0-2000m:

Abbildung 4: OHC der letzten 60 Jahre, 0-2000m. Quelle: NOAA.

Im Prinzip ähneln sich die Entwicklungen der Wassertiefenintervalle 0-700m und 0-2000m. Die Schichten 0-2000m nehmen einen Tick mehr Wärme auf, vermutlich vor allem weil die Wassersäule viel größer ist als im Fall 0-700m.

Bei den Kurven handelt es sich um globale Mittelwerte. Interessanterweise unterscheiden sich die Entwicklungen der einzelnen Ozeane zum Teil deutlich (siehe Darstellungen von Bob Tisdale auf WUWT). So kühlte sich der nördliche Nordatlantik im Tiefenbereich 0-700m zwischen 1955-1997 stetig ab. Eine Forschergruppe um Sirpa Häkkinen vom NASA Goddard Space Flight Center konnte zudem in einer 2013 im Journal of Geophysical Research publizierten Studie zeigen, dass der Wärmeinhalt des nördlichen Nordatlantiks stark durch Ozeanzyklen geprägt ist. Die OHC-Entwicklung verläuft weitgehend parallel zur Atlantischen Multidekadenoszillation (AMO), die durch einen quasizyklischen 60-Jahresverlauf gekennzeichnet ist.

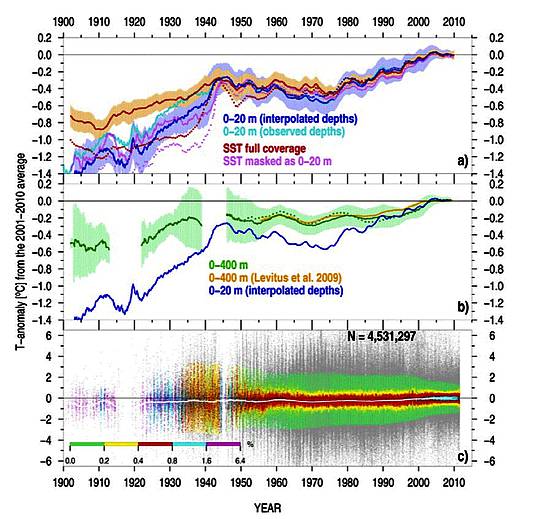

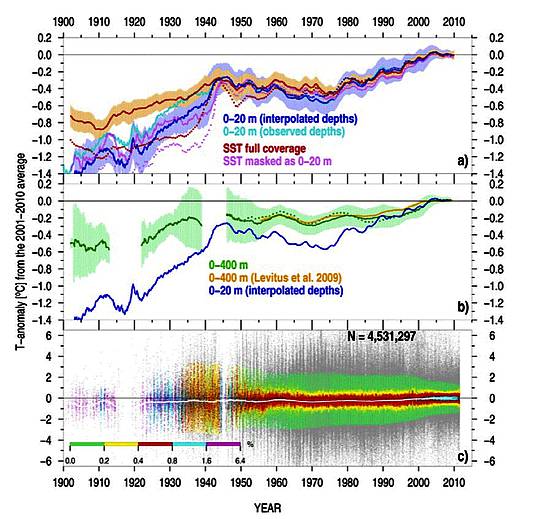

Die zyklische 60-Jahres-Komponente im globalen OHC-Verlauf wird umso deutlicher, wenn man längere Datenreihen betrachtet. Ein Team um Viktor Gouretski von der Universität Hamburg durchforstete die globalen ozeanographischen Datenbanken und fand darin Temperaturdaten aus Wassertiefen bis in 400m, die bis 1900 zurückreichten. Die Arbeit erschien 2012 in den Geophysical Research Letters. Die OHC-Kurve 0-400m (grüne Kurve in Teilabbildung b unten) verläuft dabei weitgehend parallel mit der bekannten globalen Temperaturentwicklung: Es sind zwei Erwärmungsphasen zwischen 1900-1945 sowie 1970-2003 zu erkennen, unterbrochen von einer Erwärmungspause. Die Daten der Studie stammen laut Autoren aus:

1) bottle casts, 2) Conductivity-Temperature-Depth (CTD) profilers, 3) Mechanical BathyThermographs (MBT), 4) eXpendable BathyThermographs (XBT), 5) Argo profiling floats, and 6) pinniped mounted sensors (sensors attached to marine mammals).

Abbildung 5: Entwicklung des globalen ozeanischen Wärmeinhalts für die letzten 110 Jahre nach Gouretski et al. 2012. Grüne Kurve in Teilabbildung b zeigt OHC für das Tiefenintervall 0-400m.

Im Jahr 2012 veröffentlichte ein Team um Dean Roemmich von der Scripps Institution of Oceanography im Fachmagazin Nature Climate Change sogar eine Studie zur Erwärmung der Ozeane während der letzten 135 Jahre, wobei sie unter anderem Daten der bekanntenChallenger-Expedition 1872–1876 nutzten. In einer dazugehörigen Pressemitteilung erläutert Roemmich, dass die Erwärmung der Ozeane ein Prozess ist, der nicht erst im Zeitalter der industriell gesteigerten CO2-Emissionen einsetzte, sondern vor mehr als 100 Jahre einsetzte:

“The significance of the study is not only that we see a temperature difference that indicates warming on a global scale, but that the magnitude of the temperature change since the 1870s is twice that observed over the past 50 years,” said Roemmich, co-chairman of the International Argo Steering Team. “This implies that the time scale for the warming of the ocean is not just the last 50 years but at least the last 100 years.”

Veränderungen des ozeanischen Wärmeinhalts in den letzten 10 Jahren

Wie wir gesehen haben, ist der OHC im Zuge der Wiedererwärmung des 20. Jahrhunderts im Anschluss an die Kleine Eiszeit langfristig angewachsen. 60-Jahres-Ozeanzyklen und andere Prozesse haben den Erwärmungsverlauf moduliert und geformt. Nun haben einige IPCC-nahe Forscher gemutmaßt, dass die fehlende Erwärmung an der Erdoberfläche während der letzten 16 Jahre durch ein Versenken der Wärme in den Weltozeanen verschuldet sei. Wir wollen daher im Folgenden vor allem die letzten ein, zwei Jahrzehnte näher unter die Lupe nehmen. Glücklicherweise können uns hierbei – zumindest für die obere Hälfte der Wassersäule – die neuen Argo-Daten helfen.

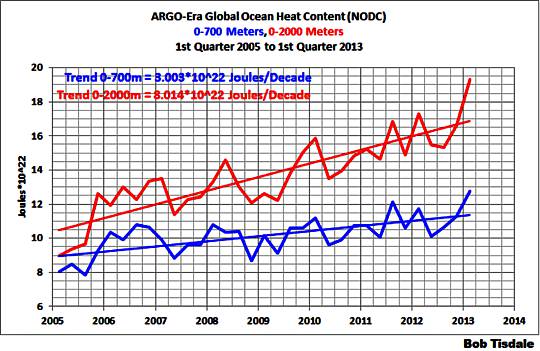

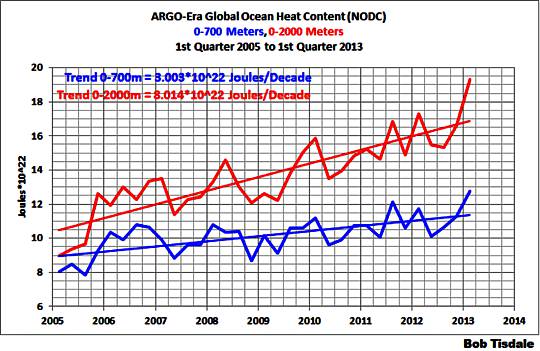

Laut Argo-Daten des US-amerikanischen National Oceanographic Data Center (NODC) der NOAA ist der OHC für die beiden Tiefenbereiche 0-700m und 0-2000m in den letzten 10 Jahren angestiegen (Abbildung 6). Eine Beschleunigung der Erwärmung gegenüber dem davorliegenden Jahrzehnt ist jedoch nicht zu erkennen (Abbildungen 2-4).

Abbildung 6: Entwicklung des OHC für die beiden Tiefenbereiche 0-700m und 0-2000m in den letzten 10 Jahren. Daten: NODC, Graphik: Bob Tisdale.

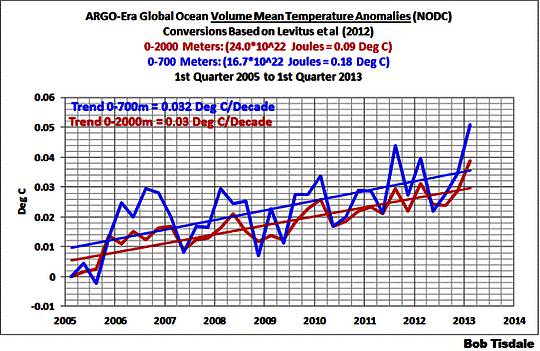

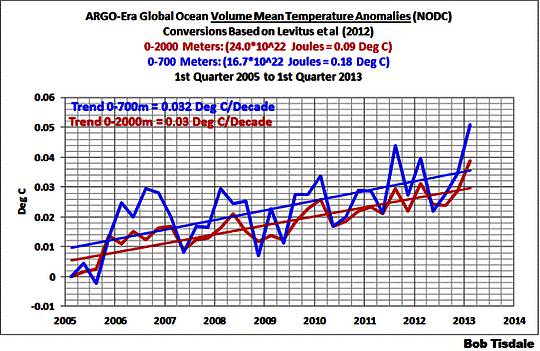

Die an der Meeres- und Landoberfläche beobachtete Erwärmungspause gilt also offenbar nicht für die obersten 2 km der Wassersäule. Hier setzt sich die Erwärmung gemäß NODC-Datensatz fort. Man sieht die IPCC-Anhänger bereits lustig um ein Freudenfeuer tanzend: „Yippie, die Erwärmung geht weiter! Hatten wir Euch doch immer gesagt. Müsst Ihr halt nur an der richtigen Stelle suchen!“. Erwärmung im Ozean ja, aber um wieviel? An dieser Stelle bricht die Party plötzlich ab: Der aktuelle Ewärmungstrend der oberen Ozeanhälfte beträgt nur klägliche 0,03°C pro Jahrzehnt (Abbildung 7). In 30 Jahren kommt hier nur ein Zehntelgrad zusammen, in 300 Jahren ein volles Grad – falls die Erwärmung so weiter ginge wie bisher. Eine Hitzekatastrophe sieht anders aus.

Abbildung 7: Globale Temperaturentwicklung der Meere für die beiden Tiefenbereiche 0-700m und 0-2000m in den letzten 10 Jahren. Daten: NODC, Graphik: Bob Tisdale.

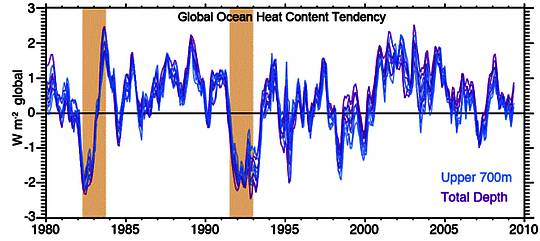

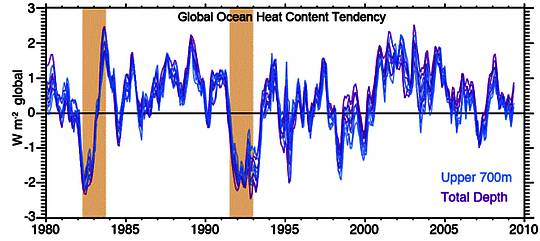

Der IPCC-nahe US-Wissenschaftler Kevin Trenberth – bekannt für seinen “it’s a travesty!”-Email-Schluchzer zur Erwärmungspause – musst in einer im Mai 2014 im Journal of Climate erschienenen Arbeit sogar einräumen, dass sich die Erwärmung der Ozeane zwischen 2001-2010 verlangsamt hat, die Rate der OHC-Zunahme also abgenommen hat (Abbildung 8).

Abbildung 8: Entwicklung der Rate der OHC-Änderung 1980-2010. Aus Trenberth et al. 2014.

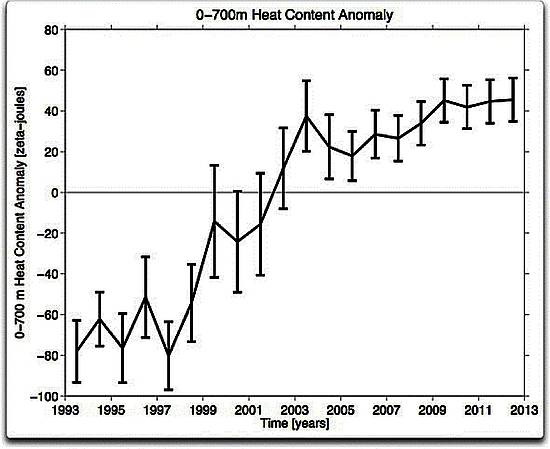

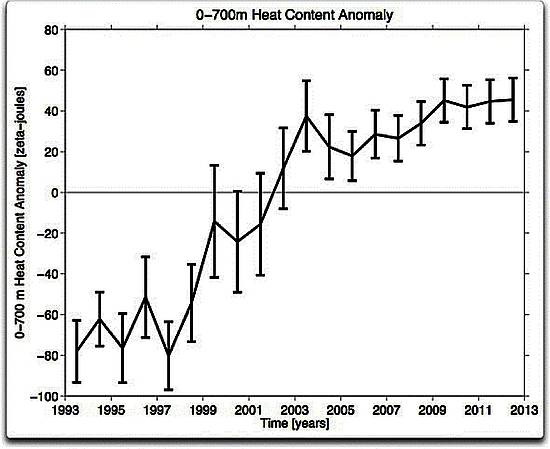

Offenbar gibt es jedoch unter den Wissenschaftlern Meinungsunterschiede, wie die heterogenen Messdaten aufzubereiten sind. Forscher desPacific Marine Environment Laboratory (PMEL) der NOAA vermuten, dass Daten aus den XBT-Messungen (expendable bathythermograph)nicht korrekt verarbeitet worden sind. In einer verbesserten Analyse kommen die PMEL-Wissenschaftler auf eine OHC-Entwicklung für das Tiefenstockwerk 0-700m, die seit 2003 kaum noch einen Anstieg der Kurve enthält (Abbildung 9). Somit wäre die Erwärmung der Ozeane bis in eine Tiefe von 700 also doch quasi zum Stillstand gekommen.

Abbildung 9: Entwicklung der OHC für das Tiefenintervall 0-700m während der letzten 20 Jahre. Daten und Graphik: NOAA Pacific Marine Environment Laboratory (PMEL)

Abbildung 9: Entwicklung der OHC für das Tiefenintervall 0-700m während der letzten 20 Jahre. Daten und Graphik: NOAA Pacific Marine Environment Laboratory (PMEL)

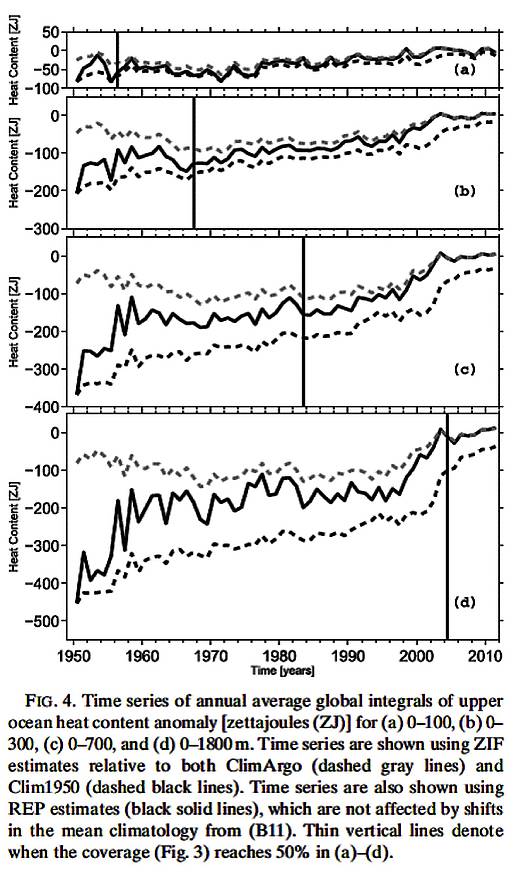

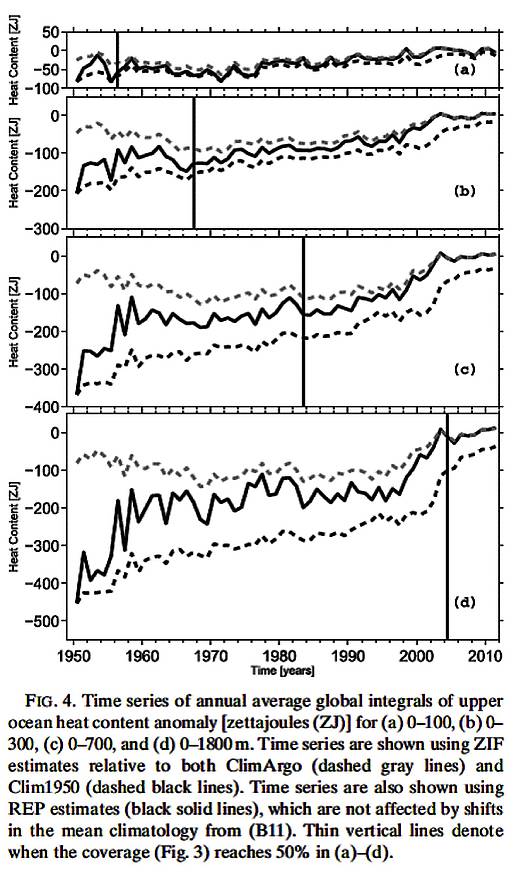

Im März 2014 erschien im Journal of Climate ein Paper der beiden PMEL-Forscher John Lyman und Gregory Johnson, in dem sie zudem auf Probleme mit dem gewählten klimatologischen Referenzzeitraum hinwiesen. Wählt man den Zeitraum, auf den sich die Anomalien beziehen zu früh, gehen viele interpolierte Werte mit ein und verändern die Trends. Die räumliche Abdeckung und die Unsicherheiten durch “Infill” wachsen mit zunehmendem Zeitabstand zur Gegenwart. In der Arbeit werden die OHC- Anomalien 1950-2011 neu bestimmt, indem ein Referenzzeitraum 2005-2010 gewählt wird, mit den genauesten monatlichen Daten die verfügbar sind: Argo. Das Ergebnis lässt aufhorchen (Abbildung 10): Der OHC hatte ca. 2003 einen Peak und stagniert seitdem. Kein Nachweis von “missing heat” in Tiefen bis 1800m.

Abbildung 10: OHC-Entwicklung für (a) 0-100m, (b) 0-300m, (c) 0-700m, (d) 0-1800m. Aus Lyman & Johnson 2014.

Auch das UK Met Office hat einen OHC-Datensatz (UKMO EN3) entwickelt, der seit 2003 nahezu keine Erwärmung mehr in den 0-700m und 0-2000m Kurven zeigt (siehe Abbildungen 4 und 5 in Bob Tisdales Beitrag auf WUWT).

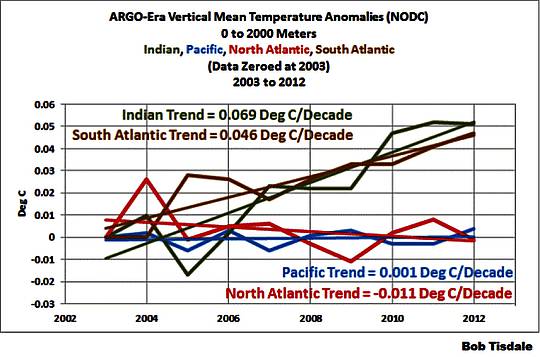

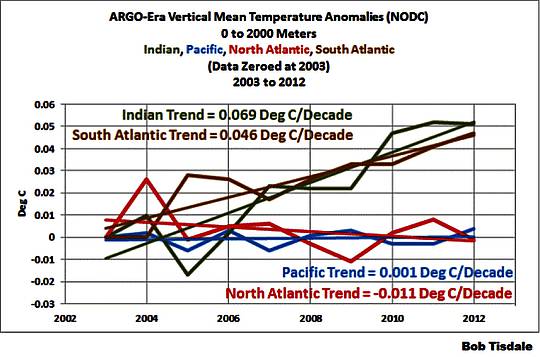

Wiederum unterscheiden sich die Entwicklungen der einzelnen Ozeane sehr voneinander. Während sich der Indische Ozean und Südatlantik überdurchschnittlich stark erwärmen, hat sich der Wärmeinhalt im Nordatlantik und Pazifik in den letzten 10 Jahren kaum geändert (Tiefenintervall 0-2000m) (Abbildung 11). Auch der Südliche Ozean um die Antarktis scheint derzeit eher Wärme zu verlieren als anzuhäufen, wie Schulz et al. 2012 dokumentierten.

Erneut sei der Warnhinweis genannt, dass hier auf jeden Fall Ozeanzyklen zu berücksichtigen sind, die über Zeiträume wirken, die die Argo-Messära um ein Vielfaches übersteigen. Eine simplistische Fortschreibung der festgestellten Argo-Trends in die kommenden 20-30 Jahre macht daher wenig Sinn.

Abbildung 11: OHC-Trends aus der Argo-Ära, aufgeschlüsselt auf die wichtigsten Ozeane. Daten: NODC, Graphik: Bob Tisdale

Am Rande kurz erwähnt sei, dass die OHC-Werte von Jahr zu Jahr größere Schwankungen zeigen. Daher werden in der Praxis oft laufende Mittelwerte über mehrere Jahre dargestellt, um dieses „Rauschen“ zu unterdrücken. Die jährlichen Schwankungen rühren von Änderungen im Pazifik her, wo sich El Nino- und La Nina-Phasen bemerkbar machen und den globalen OHC-Haushalt beeinflussen. Wikipedia weiß hierzu:

Modell-Studien ergaben, dass während La-Niña-Jahren durch wechselnde Winde vermehrt wärmere Wassermassen über Meeresströmungen in tiefere Meeresschichten transportiert werden. Dies führt zu mehr Wärmeaufnahme der Tiefsee und weniger Wärmeaufnahme der Atmosphäre und der Oberflächen Temperatur des Meeres. Jahre mit Zunahme der Temperatur in tieferen Gewässern werden mit einer negativen Phase der interdekadischen Pazifischen-Oszillation (IPO) in Verbindung gebracht. Während den El-Niño-Jahren der ENSO-Zirkulation befördern Meeresströmungen wesentlich weniger Wassermassen in die Tiefsee, dadurch steigen die Temperaturen des Wassers an der Meeresoberfläche und der atmosphärischen Grundschicht über der Meeresoberfläche stärker an.

Die unbekannte Tiefe: Verbirgt sich hier vielleicht die vermisste Erwärmung?

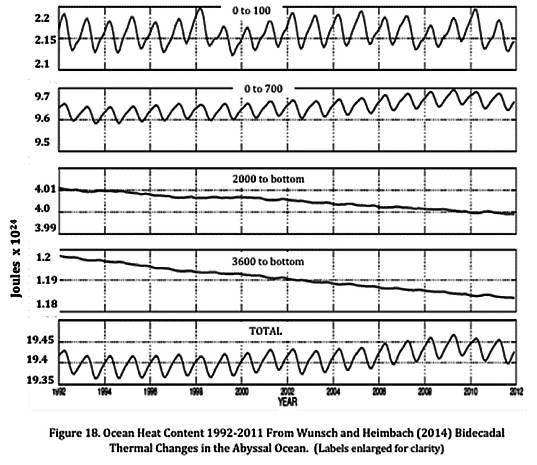

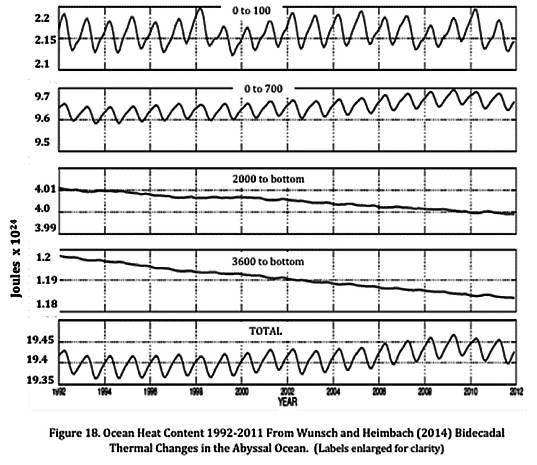

Es wird immer klarer, dass die an der Erdoberfläche ausgebliebene Erwärmung nicht in die obere Hälfte des Ozeans umgeleitet wurde. Die mittlerweile bis 2000 m Tiefe zur Verfügung stehenden Messdaten deuten vielmehr darauf hin, dass sich auch hier die Erwärmung abgeschwächt hat, möglicherweise sogar seit neun Jahren zum Stillstand gekommen ist. Bleibt also der Tiefseebereich darunter. Verbirgt sich hier vielleicht die vermisste Erwärmung? Die Datenlage ist dürftig, da die Argo-Bojen in diesen Bereich nicht vordringen. Trotzdem gibt es auch hierzu Untersuchungen und Indizien zur OHC-Entwicklung. So veröffentlichte Carl Wunsch von der Harvard University zusammen mit Patrick Heimbach vom Massachusetts Institute of Technology (MIT) dieses Jahr (2014) im Journal of Physical Oceanography ein Paper, das sich mit dem Abyssal, also den untersten Stockwerken der Ozeane beschäftigt. Das Fazit fällt deutlich aus: Die Wassermassen unterhalb von 2000m haben sich in den letzten 20 Jahren abgekühlt (Abbildung 12). Keine Spur von der ominösen Wärme, die einige IPCC-nahe Forscher hier vermutet hatten. In der Zusammenfassung schreiben die Autoren:

A dynamically consistent state estimate is used for the period 1992-2011 to describe the changes in oceanic temperatures and heat content, with an emphasis on determining the noise background in the abyssal (below 2000 m) depths. Interpretation requires close attention to the long memory of the deep ocean, and implying that meteorological forcing of decades to thousands of years ago should still be producing trend-like changes in abyssal heat content. Much of the deep ocean volume remained unobserved. At the present time, warming is seen in the deep western Atlantic and Southern Ocean, roughly consistent with those regions of the ocean expected to display the earliest responses to surface disturbances. Parts of the deeper ocean, below 3600 m, show cooling. Most of the variation in the abyssal Pacific Ocean is comparativelyfeatureless, consistent with the slow, diffusive, approach to a steady state expected there.

Abbildung 12: OHC-Entwicklung der letzten 20 Jahre. Das Tiefenwasser unterhalb 2000m hat sich in diesem Zeitraum offenbar stetig abgekühlt. Abbildung aus Wunsch & Heimbach 2014.

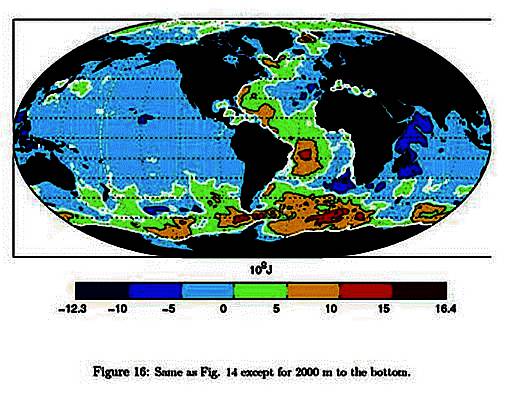

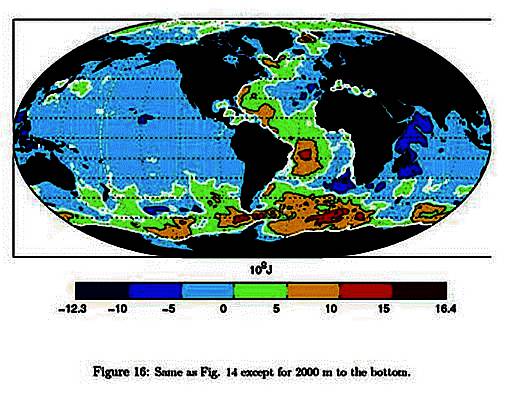

Abbildung 13: OHC-Änderung 1993-2011 für Wasserschichten unterhalb 2000m. Mit Ausnahme des westlichen Atlantiks und des Südlichen (zirkumantarktischen) Ozeans ist nur Abkühlung zu verzeichnen. Abbildung aus Wunsch & Heimbach 2014.

Wunsch und Heimbach deuten im Diskussionsteil des Papers an, dass die Datenlage wohl eher gegen das Modell von in der Tiefsee zwischengelagerter Wärme spricht:

…the uncertainties remain too large to rationalize e.g., the apparent “pause” in warming

Ähnlich sieht es Judith Curry, die im Januar 2014 in ihrem Blog schrieb:

All in all, I don’t see a very convincing case for deep ocean sequestration of heat.

Bereits 2012 hatten Mauritzen et al. in einer in Nature Geoscience veröffentlichten Studie von einer Abkühlung des Tiefenwassers im nördlichen Nordatlantik für den Zeitraum 1953-2007 berichtet. Auch Roemmich et al. 2012 scheinen auf globalem Maßstab Hinweise hierauf gefunden haben. Der Vergleich mit den Challenger-Daten von vor 135 Jahren deutet auf eine Abkühlung unterhalb von 1500m hin (Fig. 3hier).

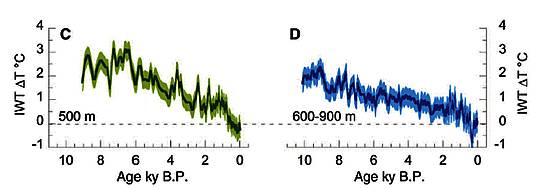

Veränderungen des ozeanischen Wärmeinhalts im Kontext der letzten 10.000 Jahre

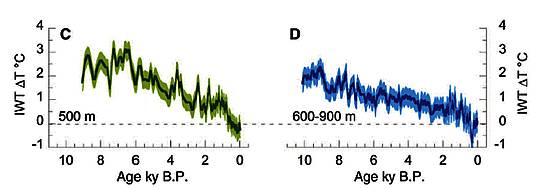

Abschließend lohnt noch ein Blick auf den langfristigen Kontext der Entwicklung der Ozeantemperaturen. Im November 2013 veröffentlichte ein Team um Yair Rosenthal von der Rutgers University im Fachjournal Science eine Rekonstruktion der OHC-Entwicklung im Pazifik während der vergangenen 10.000 Jahre. Anhand von temperatursensitiven Foraminiferen aus Bohrkernen rekonstruierten sie die Temperaturgeschichte einer Wasserschicht aus „mittlerer Tiefe“ bei ca. 500-1000m, des sogenannten ‚North Pacific Intermediate Water‘. Das Ergebnis ist spektakulär: Interessanterweise waren die untersuchten Wassermassen während eines Großteils der letzten zehn Jahrtausende deutlich wärmer als heute (Abbildung 14). So lagen die Temperaturen im Nordpazifik 9000-6000 Jahre vor heute zur Zeit des mittelholozänen Optimums ganze 2°C über dem heutigen Wert. Und während der Mittelalterlichen Wärmeperiode vor 1000 Jahren war es noch immer knapp ein Grad wärmer als heute, wie die Autoren in der Kurzfassung zu ihrem Paper schreiben:

Observed increases in ocean heat content (OHC) and temperature are robust indicators of global warming during the past several decades. We used high-resolution proxy records from sediment cores to extend these observations in the Pacific 10,000 years beyond the instrumental record. We show that water masses linked to North Pacific and Antarctic intermediate waters were warmer by 2.1 ± 0.4°C and 1.5 ± 0.4°C, respectively, during the middle Holocene Thermal Maximum than over the past century. Both water masses were ~0.9°C warmer during the Medieval Warm period than during the Little Ice Age and ~0.65° warmer than in recent decades.

Abbildung 14: Temperaturentwicklung des nordpazifischen Intermediate Water (IWT) für die Wassertiefen 500m (links) und 600-900m (rechts). Die Nulllinie entspricht dabei dem Durchschnitt der ausgehenden Kleinen Eiszeit 1850-1880. Quelle: Rosenthal et al. 2013.

Ein herber Dämpfer für die Theorie der drohenden Hitzekatastrophe: Selten zuvor war es in den vergangenen 10.000 Jahren kühler als heute! Die Autoren bekamen es offenbar mit der Angst zu tun und erstellten zusammen mit der Pressestelle des Lamont-Doherty Earth Observatory schleunigst eine Pressemitteilung, die kaum noch etwas mit dem Paper zu tun hatte. Als Schwerpunkt des Pressetextes wurde kurioserweise die drohende Klimakatastrophe gewählt. Man wollte es sich offenbar mit der IPCC-Clique und den damit verbundenen üppigen Forschungsgeldquellen nicht verscherzen. Während das Hauptresultat der Studie – also die langfristige Abkühlung des Pazifiks – in der Mitte des Textes gut versteckt wurde, hebt die Meldung vor allem auf etwas ganz Anderes ab: Angeblich würde die Studie zeigen, dass sich Teile des Pazifiks in den letzten Jahrzehnten 15 mal schneller erwärmt hätten als jemals zuvor in den letzten 10.000 Jahren. Auszug aus derPressemitteilung vom 28. Oktober 2013:

Parts of Pacific Warming 15 Times Faster Than in Past 10,000 Years

[…] over the last 60 years, water column temperatures, averaged from the surface to 2,200 feet, increased 0.18 degrees C […]. That might seem small in the scheme of things, but it’s a rate of warming 15 times faster than at any period in the last 10,000 years, said [co-author Braddock Linsley, a climate scientist at Columbia University’s Lamont-Doherty Earth Observatory]. […] The study’s long-term perspective suggests that the recent pause in global warming may just reflect random variations in heat going between atmosphere and ocean, with little long-term importance, says Drew Shindell, a climate scientist with joint appointments at Columbia’s Earth Institute and the NASA Goddard Institute for Space Studies, and a lead author on the latest IPCC report.

Herrlich zu sehen, wie die Studie in der Pressemitteilung in ihr komplettes Gegenteil verkehrt wird. Die klimaalarmistische Presse fing den ihr zugespielten Ball nur zu gerne auf. Bei Spiegel Online war der gemäßigte Axel Bojanowski wohl gerade im Urlaub, so dass der IPCC-Freund Markus Becker freie Bahn hatte. In einer von ihm verfassten Meldung vom 1. November 2013 schaffte er es doch tatsächlich, die langfristige Abkühlung des Pazifiks bis zur Heutezeit mit keiner Silbe zu erwähnen (Auszug):

Klimawandel: Ozeane haben Wärmespeicherung stark beschleunigt

[…] Ein Team um Yair Rosenthal von der Rutgers University im US-Bundesstaat New Jersey hat die Temperaturen der Meere nun für die vergangenen 10.000 Jahre rekonstruiert. Das Ergebnis: Die Wärmeaufnahme ist zuletzt dramatisch gestiegen. Wie die Forscher im Fachblatt “Science” schreiben, haben sich die mittleren Tiefenschichten der Meere in den vergangenen 60 Jahren 15-mal schneller erwärmt als bei jeder natürlichen Schwankung der vergangenen 10.000 Jahre. […] Die Ergebnisse halten die Forscher für durchaus besorgniserregend, denn sie deuten darauf hin, dass die Ozeane die Wirkung der menschlichen Treibhausgas-Emissionen noch stärker gedämpft haben könnten als bisher angenommen. “Möglicherweise haben wir die Effizienz der Meere als Lagerstätte für Wärme und Energie unterschätzt”, sagt Rosenthal. “Das könnte uns mehr Zeit verschaffen. Aber wie viel, weiß ich nicht.”

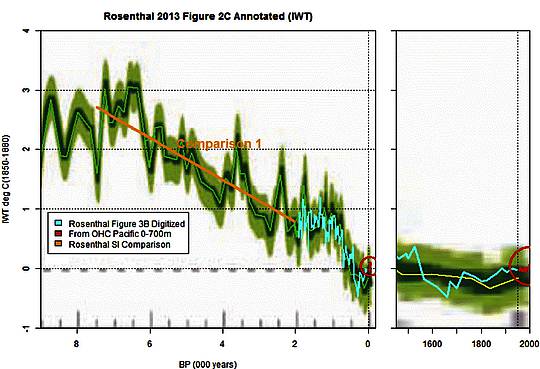

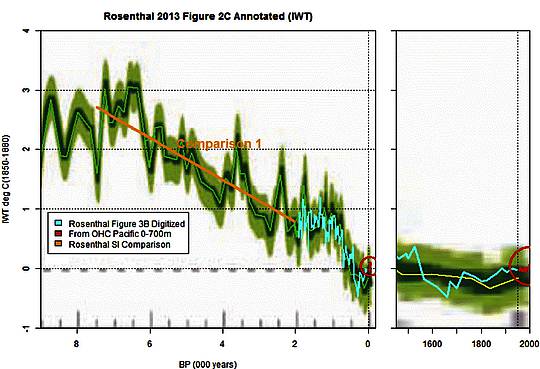

Ähnliche Berichte erschienen in US-amerikanischen Zeitungen, zum Beispiel der New York Times. Die renommierte Klimaforscherin Judith Curry erkannte sofort, dass da etwas nicht stimmen konnte. In einem Beitrag am 1. November 2013 erläuterte sie, dass die Erwärmungsrate der letzten Jahrzehnte überhaupt nicht mit den historischen Daten der Studie vergleichbar ist. Offensichtlich werden hier Äpfel mit Birnen verglichen, denn die Auflösung der Temperaturkurve in der Rosenthal-Arbeit reicht bei weitem nicht an jene der modernen Messungen heran. Schnelle Erwärmungs- oder Abkühlereignisse würden in der historischen Kurve überhaupt nicht sichtbar sein. Judith Curry schreibt:

…we have the very high rate of increase at the end of the time series, but it seems that the temporal resolution is pretty low, century resolution at best. So if the signal from AGW is say since 1970, this seems well below the resolution of the analysis, so I am not sure how significant this rapid rate of increase in context of AGW attribution. […] The key issue for AGW detection is to get paleo proxy resolution at decadal time scales. If the temporal resolution of the paleo time series is a century or lower, but sees an ‘uptick’ at the end of the time series, to me this doesn’t say anything about AGW detection, which at best is detectable since about 1975.

Aber es kommt noch besser. Steve McIntyre hat sich auf Climate Audit die Mühe gemacht und die von Rosenthal und Kollegen in der Arbeit abgebildeten Temperaturkurven auf Erwärmungsraten hin zu untersuchen. Es stellte sich dabei heraus, dass es in den letzten 10.000 Jahren offenbar eine Vielzahl von Phasen gegeben hat, in der Erwärmungsraten erreicht wurden, die jener der letzten Jahrzehnte ähnelten bzw. sogar übertrafen (Abbildung 15). Die Behauptung „die mittleren Tiefenschichten der Meere [haben sich] in den vergangenen 60 Jahren 15-mal schneller erwärmt als bei jeder natürlichen Schwankung der vergangenen 10.000 Jahre“ ist schlichtweg falsch. Eigentlich müsste Spiegel Online schnellstmöglch eine Korrekturmeldung nachschieben. Man hat den Lesern einen Bären aufgebunden, vermutlich um die klimaalarmistische Bewegung zu befördern.

Abbildung 15: Temperaturentwicklung des North Pacific Intermediate Water (grüne Kurve, Fig. 2c aus Rosenthal et al. 2013). Steve McIntyre hat die Entwicklung der letzten 2000 Jahre (hellblau, Fig. 3b aus Rosenthal et al. 2013) sowie moderne OHC-Messungen (rot) ergänzt. Quelle:Climate Audit.

Damit schließen wir diese kleine Einführung in die phantastische Welt des ozeanischen Wärmeinhalts. Vielleicht ermöglicht die Zusammenschau es dem ein oder anderen, nun effektiver in die öffentliche Diskussion einzusteigen und Fiktion von Wahrheit besser zu unterscheiden. Für den Fall, dass Sie einmal selber mit den OHC-Daten des National Oceanographic Data Center (NODC) der NOAA experimentieren wollen, finden Sie sie gut aufbereitet online auf der  KNMI-Webseite (Rubrik „Heat Content“).

KNMI-Webseite (Rubrik „Heat Content“).

Der Beitrag erschien zuerst bei "die kalte Sonne" hier

Abbildung 9: Entwicklung der OHC für das Tiefenintervall 0-700m während der letzten 20 Jahre. Daten und Graphik: NOAA Pacific Marine Environment Laboratory (

Abbildung 9: Entwicklung der OHC für das Tiefenintervall 0-700m während der letzten 20 Jahre. Daten und Graphik: NOAA Pacific Marine Environment Laboratory (

KNMI-Webseite

KNMI-Webseite