Macht endlich Schluss mit der Theorie des atmosphärischen Treibhauseffekts!

Richtigstellung nach der Konfusion durch die tendenziöse und irrige Interpretation des atmosphärischen Gleichgewichts unter dem Einfluss der Schwerkraft

Der Treibhauseffekt gilt inzwischen als „wissenschaftliche Tatsache“, weil ihm Millionen von Menschen und insbesondere die selbsternannten Klimaspezialisten des IPCC, viele politisierte NGOs und besonders in Europa viele Umwelt- und Energieminister anhängen.

Die Hypothese der Klimaerwärmung stützt sich auf zwei Dogmen: den Treibhauseffekt und die Beteiligung des CO2 daran. Ich finde es überraschend und beunruhigend, dass diese „wissenschaftliche Tatsache“ sich mit keinem der allgemein anerkannten Grundprinzipien der Physik wie der Thermodynamik oder dem Gravitationsgleichgewicht der Atmosphäre erklären lässt. Ich möchte mich mit dem zuletzt genannten Prinzip beschäftigen, denn eine irrige Interpretation des Gravitationsgleichgewichts der Atmosphäre hat zur Formulierung der Theorie vom Treibhaus Atmosphäre und der schädlichen Rolle des CO2.

Ich möchte also nicht das thermische und radiative Gleichgewicht der von der Sonne beschienenen Erde behandeln, die durch die Gleichungen von Planck und Stefan-Boltzmann über schwarze Körper erklärt werden, sondern nur die Verwirrung, die durch eine tendenziöse Interpretation des atmosphärischen Gleichgewichts unter dem Einfluss des Gravitationsfeldes der Erde entstanden ist.

Nur wer den Einfluss der Schwerkraft leugnet und die Beobachtungen von Newton und Galilei zurückweist, kann die folgenden Fakten übersehen: Die Atmosphäre wiegt im Durchschnitt auf Meereshöhe etwa zehn Tonnen je Quadratmeter. Mit minimalen Abweichungen von diesem Mittelwert beschäftigen sich die Meteorologen, denn es handelt sich dabei um Hoch- und Tiefdruckgebiete und die mit Luftdruckunterschieden verbundenen Wetterphänomene. Es geht dabei um Schwankungen in der Größenordnung von höchstens 3 Prozent. Das mag vernachlässigbar erscheinen. Da aber riesige Luftmassen im Spiel sind, fällt das doch ins Gewicht. Die Dichte und die Temperatur der Luft nehmen bekanntlich nach oben hin ab. Jeder Bergwanderer spürt das am eigenen Leib. Die Kompression der Atmosphäre durch die Schwerkraft ist also verantwortlich für die Verteilung der Temperaturen in der ganzen Troposphäre, die am Äquator bis in 17 Kilometer Höhe reicht. Oberhalb von dieser Grenze sorgt die Ionisierung der immer spärlicher werdenden Gasmoleküle durch den Sonnenwind und die kosmische Strahlung dafür, dass die bekannten physikalischen Gesetze über das Verhalten idealer Gase nicht mehr gelten.

Die einfache Beziehung zwischen der Höhe, der Dichte und der Temperatur der Luft wird in der Physik durch den adiabatischen Gradienten ausgedrückt. Dieser drückt aus, dass die trockene Luft sich auf 1.000 Meter Höhe um 9,8 und die feuchte Luft aufgrund der großen thermischen Trägheit des Wasserdampfes lediglich um 6,5 Grad Celsius abkühlt.

Ich erinnere daran, dass die Erde sich thermodynamisch wie ein schwarzer Körper mit einer Temperatur von minus 18 Grad Celsius verhält. Diese Temperatur finden wir auf einer mittleren Höhe von 5.000 Metern. Wenn wir den adiabatischen Gradienten anwenden, finden wir auf Meereshöhe eine Durchschnittstemperatur von 14,5 Grad Celsius. Das wird durch Beobachtungen bestätigt. Wenn wir uns den Polen nähern, nimmt die Durchschnittstemperatur selbstverständlich wegen der geringeren mittleren Sonneneinstrahlung ab. Aber der adiabatische Gradient gilt auch dort. In den Wüsten liegt die Temperatur wegen der geringen Luftfeuchtigkeit am Tag über, bei Nacht aber unter dem Mittelwert.

Die Verfechter der Treibhaustheorie verweisen nun auf die Beobachtung unseres Nachbarplaneten Venus. Aus mehreren Gründen ist aber der Vergleich von Erde und Venus irreführend.

Die Umlaufbahn der Venus liegt näher zur Sonne. Venus erhält also mehr Strahlungsenergie als die Erde. Da sie aber gleichzeitig wegen ihrer dichten Wolkendecke eine größere Albedo hat, also mehr Sonnenstrahlen reflektiert als die Erde, spielt ihre größere Nähe zur Sonne keine so große Rolle. Was aber ins Gewicht fällt, ist die sehr viel größere Dichte ihrer Atmosphäre, die größtenteils aus dem schweren Gas CO2 besteht. Diese ist ungefähr 92mal so hoch wie die der Erde. Der atmosphärische Druck beträgt dort 920 Tonnen je Quadratmeter (wie auf der Erde in 1.000 Meter Meerestiefe). Aber der adiabatische Gradient gilt auch auf der Venus. Die Temperatur nimmt auch dort um etwa 9 Grad Celsius je 1.000 Höhenmeter ab.

Da die Dichte der Venus-Atmosphäre jedoch am Boden etwa 95 Kilo je Kubikmeter beträgt, ergibt sich bei der Anwendung des gleichen Gesetzes der adiabatischen Kompression eine Temperatur von 465 Grad. Temperaturen um Null Grad finden sich auf der Venus erst in 50 Kilometer Höhe. Schließlich darf man nicht vergessen, dass ein Tag auf der Venus so lange dauert wie 243 Tage auf der Erde. Starke Konvektionsströme und Stürme sorgen aber für einen guten Temperaturausgleich zwischen Tag- und Nachseite des Planeten. Deshalb ist es nicht gerechtfertigt, von einem Treibhauseffekt auf der Venus zu sprechen. Der Planet befindet sich vielmehr in einem Strahlungsgleichgewicht mit dem Weltraum. Nur sind dessen Parameter andere als die der Erde. Gäbe es auf der Venus einen durch CO2 verursachten Treibhauseffekt, hätte der Planet längst schmelzen und verdampfen müssen. Stattdessen gibt es darauf der Berge und Ebenen und sogar Vulkane wie auf der Erde – und vielleicht sogar Seen aus überkritischem CO2.

Von daher lässt sich begreifen, warum der vor allem vom NASA-Forscher James Hansen für die Erklärung des Treibhauseffektes bemühte Vergleich zwischen Erde und Venus hinkt. Die Atmosphäre der Venus besteht zu 95 Prozent aus CO2, der Rest aus Stickstoff und Spuren von Schwefeldioxid. Zu Unrecht haben James Hansen oder Al Gore Kritikern entgegnet: „Schauen Sie doch, was auf der Venus los ist!“ Denn nicht wegen des CO2 herrscht auf der Venusoberfläche eine Temperatur von 465 Grad. Diese ergibt sich allein aus der Anwendung fundamentaler Gesetze der Thermodynamik und der Physik idealer Gase. Die Treibhaustheorie widerspricht hingegen den fundamentalen Prinzipien der Physik.

Ich frage mich daher, warum es niemand wagt, den Vertretern der Treibhaustheorie die Stirn zu bieten. Stattdessen folgen die Regierungen blind den vom IPCC und von grünen NGOs vorgerechneten Extrapolationen. Sie schämen sich nicht, offen malthusianistisch zu argumentieren und drohen damit, etliche Länder in die ökonomische und soziale Katastrophe zu führen.

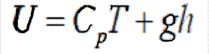

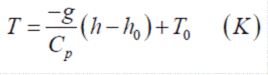

Für Neugierige bringe ich hier die Gleichung des adiabatischen Gleichgewichts. Der thermodynamische Zustand einer Luftsäule lässt sich vereinfacht folgendermaßen umschreiben:

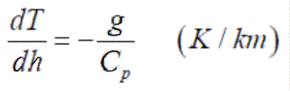

Dabei ist U die Gesamtenergie, Cp die thermische Kapazität der Atmosphäre (1004 joules/kg/Grad K für trockene Luft, 1012 für feuchte Luft mit durchschnittlich 0,25 % Wasserdampf), T die Temperatur des Abschnitts der Luftsäule (in Grad Kelvin), g die Erdbeschleunigung und h die Höhe in km. Leitet man diese Gleichung ab, erhält man:

(ausgedrückt in K/km). Hier taucht der Term g/Cp, genannt « Adiabatischer Gradient », auf. Dieser beschreibt das Gleichgewicht zwischen dem Druck und der Temperatur der Atmosphäre. Wir können diese Differentialgleichung folgendermaßen umformen:

![]()

Da g und Cp positive physikalische Größen sind, sieht man sofort, dass die Verteilung der Temperaturen im Schwerefeld der Erde, wie auch im Schwerefeld beliebiger Planten mit einer Gashülle, mit der Höhe abnimmt.

Die letztgenannte Gleichung kann aufgelöst werden, indem man für h0 die Meereshöhe und für T0 die entsprechende Temperatur einsetzt:

Man findet dann leicht die Bodentemperatur (h0 = 0), indem man in die Gleichung die Höhe von 5 Kilometern für die Isotherme von -18 °C einsetzt, die dem Strahlungsgleichgewicht des Systems Erde-Atmosphäre (nach den Gesetzen von Stefan-Boltzmann) entspricht:

t = – 6,5 (h – 5) – 18 = 32,5 – 18 = 14,5 Grad Celsius. Der Faktor 6,5 entspricht der thermischen Kapazität der mit Wasserdampf beladenen Luft. Der mittlere Wasserdampfgehalt der Atmosphäre liegt ungefähr bei 0,25 Prozent.

Gäbe es in unserer Atmosphäre einen Treibhauseffekt, dann müsste an erster Stelle der Wasserdampf dafür verantwortlich sein. Es gibt in der Atmosphäre 600mal mehr Wasserdampf als Kohlenstoffdioxid. Diesen Faktor 600 muss man noch einmal mit 5 multiplizieren, denn die thermische Kapazität des Wassers liegt bei 4.180 joule/kg/°K gegenüber nur 840 joule/kg/°K für CO2. Wasserdampf besäße also ein 3.000mal so starkes „Treibhauspotenzial“ wie CO2. Wäre unsere Atmosphäre tatsächlich ein Treibhaus, wären die Ozeane längst verdampft. (Übersetzung: Edgar L. Gärtner)

*) Original erschienen im französischen Magazin Contrepoints am 5. November 2014

Über den Autor

Jacques Henry ist Biologe. Er arbeitete lange Jahre als Forscher beim CNRS (Centre National de Recherche ScientifiqueI, dem franz. Partner der Max-Planck-Gesellschaft, Henry hat danach als Berater für die Nuklearsparte von Electricité de France (EdF) gearbeitet und befindet sich jetzt im Ruhestand.