„Versauern“ die Ozeane? Die pHälschung!

Anmerkung: Der aktuelle Anlass für diesen Artikel ist eine Veröffentlichung auf einem US-Blog, die auf WUWT auszugsweise wiedergegeben, und dann von EIKE als Übersetzung publiziert wurde. Im Zentrum stehen Betrügereien mit pH-Werten von Meerwasser. Was zunächst mit dem englischen Wortspiel „pHraud“ bezeichnet wurde, lässt sich gut ins deutsche Wortspiel „pHälschung“ übertragen. Hier gehen wir auf die physikalischen, chemischen und biologischen Fakten ein, schauen uns diese pHälschung nochmal genauer an, und suchen (vergeblich) nach Belegen für die Gefahren von CO2 im Meerwasser. Dabei fällt die Wechselwirkung zwischen pH, Temperatur und CO2 auf.

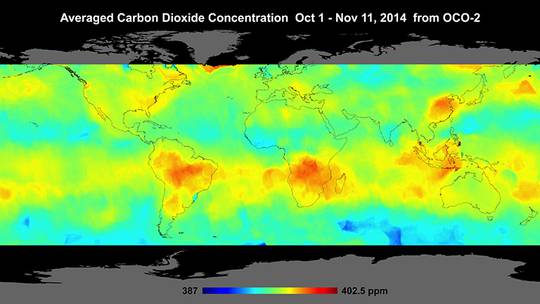

Kohlendioxid (CO2) ist in der globalen Atmosphäre einigermaßen gleichmäßig verteilt (s. auch Abbildung) und bleibt es, ganz anders als Wasserdampf, der sich gelegentlich zu einer Wolke wandelt, oder gar als Regen wieder auf die Erde zurück kommt.

An Land nutzen die Pflanzen das CO2 als Gas direkt aus der Luft und stellen per Photosynthese daraus die Kohlenhydrate Zucker, Stärke und Zellulose her. Es ist essentiell für alles Leben auf Erden. Das Pflanzenwachstum, und damit die weltweite landwirtschaftliche Produktion von Nahrungsmitteln, würde sogar von einem Mehrfachen der heutigen CO2 Konzentrationen profitieren. Allerdings sei das CO2 in der Atmosphäre für die per Computermodell vorhergesagte „katastrophale Erwärmung“ der Erde verantwortlich (was jedoch in realen Messdaten nicht sichtbar wird).

Im Wasser wird es komplizierter. Zunächst einmal wird das CO2 im Wasser physikalisch gelöst, so wie man Salz oder Zucker in Wasser auflösen kann und wie auch andere Gase gelöst werden. Bekanntermaßen ist auch Sauerstoff (O2) im Wasser physikalisch gelöst und die Fische können über ihre Kiemen diesen Sauerstoff „einatmen“. Auch Wasserpflanzen, wozu auch Mikroalgen gehören, können mit dem gelösten CO2 Photosynthese betreiben.

Anders als bei O2 reagiert jedoch eine kleine Menge (~1%) des zunächst physikalisch gelösten CO2 mit dem Wasser chemisch unter Bildung von „Kohlensäure“, wodurch das Wasser saurer wird.

In noch einem weiteren chemischen Schritt geschieht die Karbonatbildung; überwiegend in der Form von Calciumcarbonat (CaCO3, Kalkstein). Dies kann als chemischer Prozess ablaufen, der nichts mehr als die Gegenwart von Calcium-Ionen und Kohlensäure benötigt, wobei das gebildete, schwer lösliche Calciumcarbonat ausfällt und auf den Meeresboden absinkt. Oder es kann ein biologischer Prozess sein, bei dem Korallen, Muscheln und andere Organismen ihre harten Schalen bilden, und nach ihrem Absterben Teil der Kalksteinschicht werden. Über lange Zeiträume und nachfolgende geologische Verwerfungen führt dies zur Bildung von Kalksteingebirgen.

Allerdings ist dieser Schritt, chemisch wie auch biologisch, nur bis zu einem bestimmten Säuregrad möglich; ist das Meerwasser wesentlich saurer könnte er sogar rückwärts laufen, und eine Auflösung des Kalks zur Folge haben. Entsprechend fatal wären die Konsequenzen für die davon abhängigen Organismen.

Den Säuregrad misst man als pH-Wert, was relativ einfach zu machen ist.

Was eigentlich ist pH-Wert? Und was ist Säure?

Wasser ist bekanntlich H2O und ein energetisch stabiles Molekül, das man nur unter Energiezufuhr (z.B. Elektrolyse mit elektrischem Strom) zerlegen kann. Aber etwa jedes 100 Millionste Wassermolekül dissoziiert (zerfällt) auf natürliche Weise in die elektrisch positiv bzw. negativ geladenen Ionen H+ und OH- [1]). Diese Ionen haben dann beide eine Konzentration von 10-7 mol pro liter Wasser. Der pH-Wert [2]) ist somit 7 ( = der negative Wert des Exponenten der H+ Ionen Konzentration). An diesem Punkt ist Wasser neutral. Gibt es mehr H+ Ionen, dann ist die Flüssigkeit eine Säure, der pH-Wert ist kleiner als 7. Im anderen Fall von weniger H+ Ionen Konzentration ist die Flüssigkeit eine Lauge, der pH-Wert ist größer als 7.

Sprachlich ist zu beachten, dass eine Säure „sauer“ ist, aber eine Lauge „alkalisch“ [3]).

Beispiele für pH-Werte

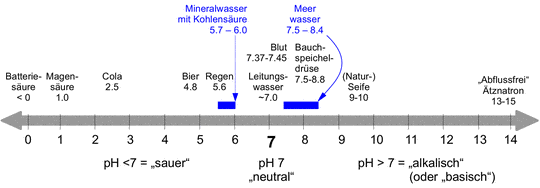

Um ein Gefühl für pH-Werte aus unserem täglichen Leben zu bekommen, sind in Abbildung ein paar pH-Werte gezeigt. Leitungswasser ist meist (aber nicht unbedingt) nahe dem Neutralpunkt. Auf der sauren Seite folgen Regen, Bier, Cola, Magensäure und Batteriesäure. Letztere kann auch negative pH-Werte haben. Auf der alkalischen Seite folgen Blut, Bauchspeicheldrüsensekret, Naturseife, und ganz extrem Ätznatron oder darauf basierende „Abflussreiniger“, die Fette und Proteine (Haare bestehen aus Proteinen) auflösen können.

Auch wenn unser Körper von Verdauungstrakt bis Hautoberfläche einen Bereich von pH=1 bis pH=10 verträgt – das ist immerhin ein 1 Milliarden-facher Unterschied bezogen auf die H+ Ionen Konzentration – toleriert unser Blut dagegen nur äußerst enge Grenzen von pH=7.37-7.45 [4]), also im leicht alkalischen Bereich. Werte außerhalb dieses sehr schmalen Bereiches sind bereits krankhaft!

|

Abbildung SEQ Abbildung * ARABIC1: pH-Wert Skala |

Zellkulturen, die gerne als Wundertechnologie zum Ersatz von Tierversuchen zur Prüfung von Medikamenten gepriesen werden, oder die zur biotechnologischen Herstellung von Medikamenten wie Immunglobulinen eingesetzt werden, wollen in ihrer Nährlösung einen pH-Wert innerhalb des immer noch engen Bereiches von 7.0-7.4 haben, also neutral bis ebenfalls leicht alkalisch. Andere Mikroorganismen können bei anderen pH-Werten existieren – Backhefe z.B. um pH=5 (also sauer). Für optimales Wachstum werden eher enge pH Bereiche benötigt, wenngleich tendenziell die Organismen um so toleranter sind, je primitiver sie sind.

Es ist daher zunächst einmal durchaus denkbar, dass die heutzutage im Wasser lebenden Tiere sich evolutionär so an ihre Umgebung angepasst haben, dass sie nunmehr sehr empfindlich auf pH Veränderungen reagieren!

Wie beeinflusst CO2 den pH-Wert von Wasser?

Ist (Mineral-)Wasser mit CO2 versetzt (umgangssprachlich: „mit Kohlensäure“), ist es erwartungsgemäß saurer als Leitungswasser. Überraschenderweise ist aber Meerwasser alkalisch, obwohl es doch angeblich durch das CO2 der Atmosphäre versauert.

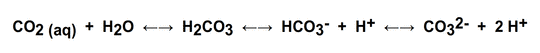

Der Grund liegt in dem chemischen Verhalten von CO2 im Wasser. Die folgende chemische Gleichung zeigt das Gleichgewicht von im Wasser gelöstem CO2 (links) zur Kohlensäure (H2CO3), die sofort in das Hydrogencarbonat- und Wasserstoff-Ion dissoziiert, und schließlich zum Carbonat-Ion und weiteren Wasserstoff-Ionen. Die Verteilung der Komponenten auf die einzelnen Stufen zwischen links und rechts hängt sehr stark von pH-Wert, Temperatur und den Konzentrationen der einzelnen Komponenten ab.

Damit besteht ein Puffersystem.  Im Zusammenwirken mit weiteren, zum Teil ebenfalls puffernden, Bestandteilen des Meerwassers (eine Vielzahl verschiedener Salze in deutlich höherer Konzentration als im Leitungswasser, sowie diverse organische Komponenten) kann die Pufferwirkung verstärkt, und der pH Wert verschoben werden.

Im Zusammenwirken mit weiteren, zum Teil ebenfalls puffernden, Bestandteilen des Meerwassers (eine Vielzahl verschiedener Salze in deutlich höherer Konzentration als im Leitungswasser, sowie diverse organische Komponenten) kann die Pufferwirkung verstärkt, und der pH Wert verschoben werden.

Im Fall von Meerwasser ist der pH in den leicht alkalischen Bereich verschoben. Die Pufferung bedeutet weiter, dass die den pH verschiebenden Substanzen – wie CO2 – nicht zur vollen Wirkung gelangen können. Nehmen wir an, dass eine bestimmte Menge CO2 den pH von Leitungswasser um 1 Einheit saurer macht, dann könnte die gleiche Menge CO2 den pH von Meerwasser, dank dessen Pufferung, möglicherweise nur um Werte verschieben, die wesentlich geringer oder gar unmessbar klein sind. Diese Pufferwirkung ist auch der Grund, weswegen der pH Wert im Blut überhaupt in seinem sehr engen Bereich gehalten werden kann.

Da Meerwasser aber sehr komplex ist, weltweit in seiner Zusammensetzung variieren kann, und das ganze System dann auch noch von Temperatur und Druck (durch die Meerestiefe) abhängig ist, ist es höchst schwierig, die Auswirkungen einer CO2 Erhöhung theoretisch vorherzusagen.

Klimaforscher haben es dennoch getan, und wie wir sehen werden, scheitern sie auch mit diesen Ozean pH Modellen so eklatant, wie sie es mit der Vorhersage der Globalen Erwärmung tun.

Was sagen die „Klimaforscher“ zur „Versauerung“ der Ozeane?

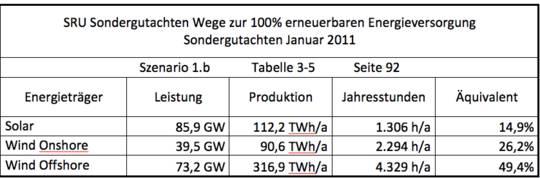

Der Amerikaner Richard A. Feely und seine Mitarbeiter haben sich insbesondere mit Arbeiten zur angeblichen Ozeanversauerung hervorgetan. In der Publikation „CO2 und unser Ozean Vermächtnis“ (2006), die von der amerikanischen Ozean und Atmosphären Behörde (NOAA, National Oceanic and Atmospheric Administration)

|

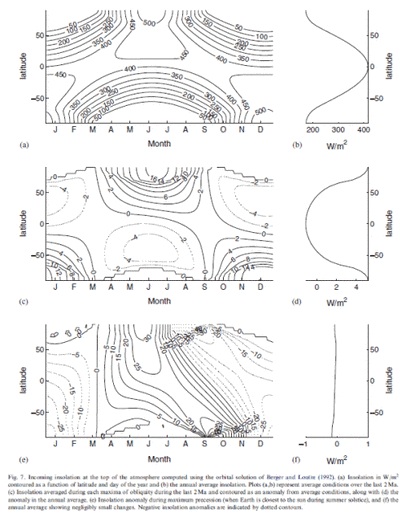

Abbildung SEQ Abbildung * ARABIC2: Historischer und vorhergesagter Trend von pH und gelöstem CO2 des Meerwassers |

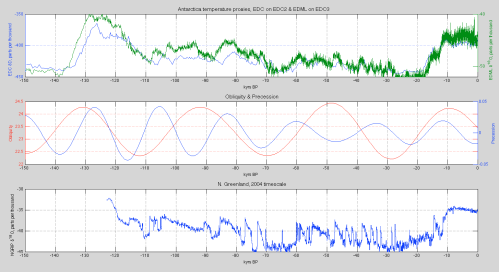

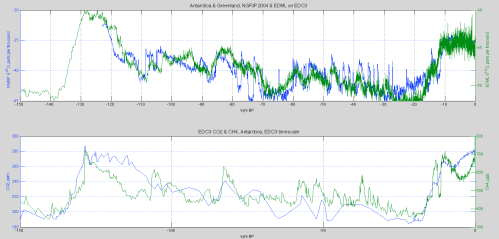

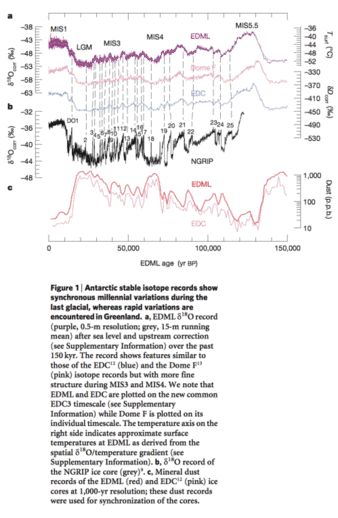

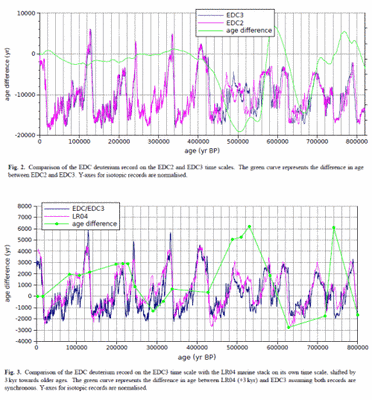

Demnach ist der pH seit dem Beginn der industriellen Revolution um 1850 bis heute gleichmäßig von 8.16 auf 8.05 gesunken, und wird bis 2100 auf pH=7.85 sinken. Weiter führen sie aus, wie verheerend sich dies auf die Meereslebewesen auswirken wird, und wie verheerend dies dann für die Menschen sein wird.

Diese verheerenden Wirkungen kämen daher, dass Meeresorganismen bei zu niedrigem pH keine Schalen und/oder Skelette aus Calciumcarbonat mehr bilden könnten, und dann nicht mehr als Nahrung für höhere Organismen zur Verfügung stünden. So könnten substantielle Änderungen in der Biodiversität der Ozeane resultieren, die letztlich den Fischfang bedrohen und damit die menschliche Nahrungsversorgung und die gesamte damit zusammenhängende Wirtschaft, und ebenso den milliardenschweren Tourismus, und alle an diesen Industrien hängenden Arbeitsplätze. Weiter werden verschwindende Korallenriffe die Küsten stärker den Stürmen aussetzen, mit wiederum gravierenden Folgeschäden. Bereits in der Mitte dieses Jahrhunderts wird es beginnen.

Gegenwärtig, so die Autoren, verändere sich die Meeres Chemie „100mal schneller als in den vergangenen 650 000 Jahren“ und „Computer Modelle (!) zeigen, dass der Ozean mit seiner Versauerung fortfahren wird und zwar in einem Ausmaß und in Geschwindigkeiten, wie sie seit mehreren 10 Millionen Jahren nicht stattfanden“.

Man beachte, dass selbst in der Vorhersage für das Jahr 2100 ein pH von 7.85 oder gar 7.65 [5]) nicht sauer ist, sondern immer noch alkalisch! Das Wort Meeres-Versauerung (engl.: Ocean Acidification) suggeriert ätzende Säuregrade von Essig oder gar Batteriesäure – dem ist beileibe nicht so.

Aber es bleibt immerhin denkbar, dass Meeresorganismen bereits mit diesen leichten Veränderungen der pH Werte Probleme bekommen, selbst wenn diese noch nicht einmal im sauren, sondern noch immer im alkalischen Bereich liegen.

|

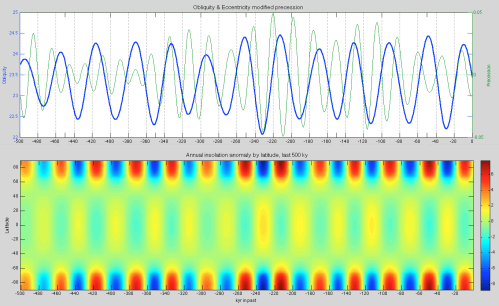

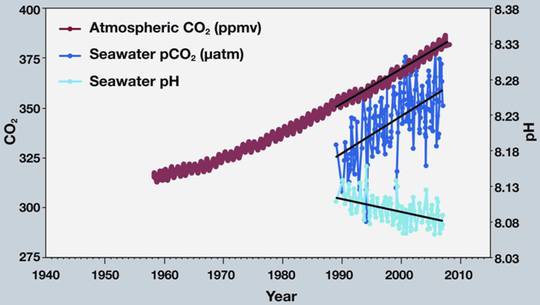

Abbildung SEQ Abbildung * ARABIC3: CO2 in Atmosphäre und Meerwasser und pH des Meerwassers |

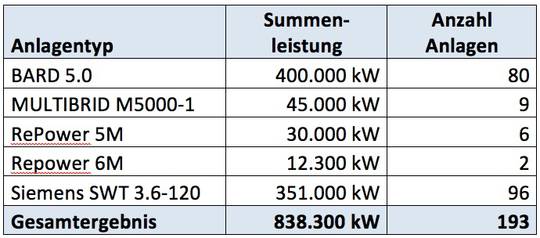

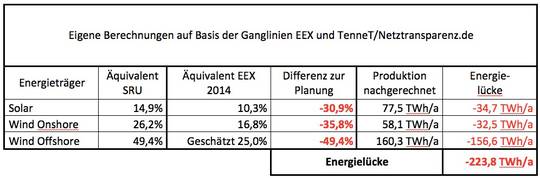

Die Messdaten, die Feely’s Klimamodell-Kurven bestätigen sollen, finden sich ebenfalls auf den NOAA Servern, und sind in Abbildung gezeigt. Die wellige, braune Kurve stellt die bekannten atmosphärischen CO2 Werte dar, wie sie von der Messstation auf dem Vulkan Mauna Loa auf Hawaii gemessen werden. Die dunkelblaue Kurve zeigt den Partialdruck des Meerwasser CO2, also der im Meerwasser gelösten Menge an CO2. Die hellblaue Kurve zeigt den daraus angeblich resultierenden pH im Meerwasser. Der hätte danach von pH=8.112 im Jahre 1989 auf pH=8.081 in 2007, also um 0.03 pH Einheiten abgenommen (Werte von mir aus der Grafik abgelesen. Die durch die Skala suggerierte Messung von hundertstel pH Einheiten im Meer ist gewiss als „sehr sportlich“ zu bezeichnen; nicht einmal im Labor ist das einfach!)

Es fällt auf, dass die NOAA Daten erst 1989 beginnen. Moderne pH Messungen werden mit Glaselektroden durchgeführt, und da diese bereits seit etwa 100 Jahren bekannt sind, ist das Fehlen früherer Messungen besonders merkwürdig. Das fiel auch dem Amerikaner Mike Wallace auf, der Feely und Kollegen um die fehlenden Daten bat. Die dann folgende Odyssee von ignorieren, bedrohen, verweigern und belügen können Sie in dem bereits eingangs erwähnten Artikel nachlesen.

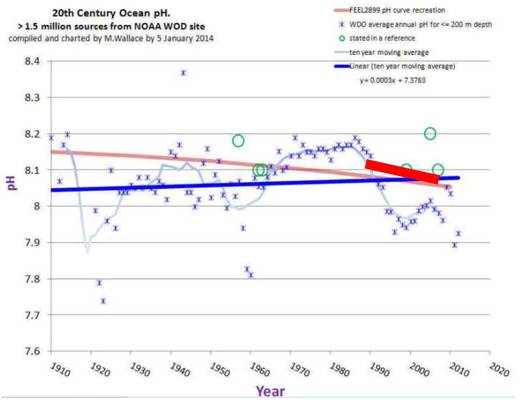

Auch hier beim Meeres-pH wurde die Herausgabe der Daten verweigert, am Ende gar mit der Behauptung, dass sie nicht existierten. Letztlich tauchten sie aber – wohl eher unbeabsichtigt – durch die Freigabe einer Datenbank durch NOAA auf. Aus diesen mehr als 1.5 Mio (!) Messdaten entwickelte Wallace die in Abbildung gezeigte Kurve.

|

Abbildung SEQ Abbildung * ARABIC4: Meeres pH seit 2010 basierend auf NOAA Daten |

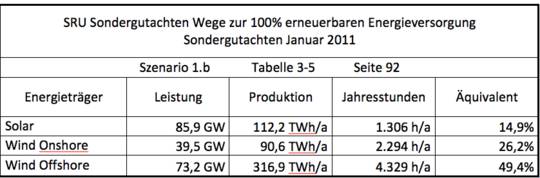

Die Sternchen stellen die jährlichem pH Mittelwerte der letzten 100 Jahre für Meerestiefen bis 200m dar. Die dünne, hellblaue Kurve ist der gleitende Mittelwert über 10 Jahre. Die dicke, dunkelblaue Kurve gibt den 100 Jahre Trend. Die blass-rote Kurve ist die rote pH Kurve aus der Feely Grafik in Abbildung. Die kurze, dicke, rote Kurve ist von mir eingezeichnet, und stellt die Regressionsgerade der hellblauen pH Daten aus Abbildung dar.

Daraus können folgende Schlussfolgerungen gezogen werden:

- Die pH Veränderungen, die nach Feely die größten seit 650 000 Jahren seien, sind kleiner als die in gerade einmal den letzten 100 Jahren mehrfach beobachteten.

- Die Schnelligkeit der Veränderungen der Feely Daten ist nicht etwa 100mal schneller als seit 650 000 Jahren beobachtet, sondern beträchtlich langsamer als Veränderungen mit ca. 10 Jahren Zeitkonstante in den letzten 100 Jahren.

- Über den 100 Jahre Zeitraum nimmt der pH nicht etwa ab, sondern im Mittel nimmt er zu. Mithin also keine „Versauerung“, sondern das Gegenteil!

- Da der CO2 Gehalt der Atmosphäre erst seit 1950 kräftig gestiegen ist, müsste die Kurve vor und nach diesem Zeitpunkt ein anderes Verhalten zeigen. Das tut sie aber nicht. Der pH Wert ist heute so niedrig, wie um 1920 oder auch 1960, und dazwischen jeweils deutlich höher.

- Die pH Veränderungen, die NOAA auf ihrer Webseite zeigt ( Abbildung) sind lächerlich klein und bedeutungslos angesichts der Schwankungen, die tatsächlich über 100 Jahre gemessen wurden.

- Die Computermodelle liegen wieder einmal kräftig daneben.

Der Vorgang erinnert in nahezu jedem Detail ungemein an die Climategate Ereignisse, wie die Behauptung, dass die Erde für Jahrtausende konstante Temperaturen – jetzt eben pH Werte – hatte, und diese erst in der Neuzeit verrückt spielen, und die Verweigerung der Preisgabe von Daten, die Rosinen Pickerei in den Daten, die Geheimhaltung von ausgewählten Teilen der Daten, die nicht passten, die Behauptung der Nicht-Existenz der Daten, die Verleihung von gut dotierten „Wissenschaftspreisen“ – dort der Nobelpreis, hier der Ketchup-Preis [6]) – , das Ignorieren von Freedom-of-Information-Act Anfragen, der Vehemenz, mit der die Herausgabe von Daten verweigert wurde, die Bedrohungen der danach fragenden Wissenschaftler, die Nutzung von Computermodellen, die die Vorhersagen selbstverständlich mit „einem hohen Maß von Zuverlässigkeit“ vorhergesagt haben, und mehr.

Feely et al. und/oder NOAA haben sehr klar durch die Selektion der Daten für den kurzen Zeitraum von nur knapp 20 Jahren, dabei nicht einmal zu erwähnen, dass längerfristige Daten vorliegen, in Verbindung mit der nahezu maßlosen quantitativen Übertreibung angeblicher Folgeeffekte, was Ihnen durch Kenntnis der weggelassenen Daten klar sein musste, eine mehrfache wissenschaftliche Fälschung begangen, eben eine pHälschung!

Der Climategate Skandal wird nun also ergänzt mit dem Acidificationgate Skandal. Interessant könnte es noch werden, da Feely auch als Zeuge vor dem US-Kongress ausgesagt, und dabei die gleichen Falschaussagen gemacht hat. Belogen zu werden hat der Kongress nicht gerne, obwohl politische Korrektheit auch dort für viel Weißwascherei sorgt. Nun aber werden die Republikaner demnächst die Majorität stellen und sind zum „Klimawandel“ wesentlich skeptischer eingestellt, als die Demokraten. Schaun mer mal.

Wie reagieren denn nun die Meerestiere auf pH Änderungen?

Vor lauter Klimaaktivismus sind Feely et al. doch wenig substantiell geblieben, wenn es darum geht, diese angeblich verheerenden Auswirkungen mit Daten zu belegen. Es wäre aber doch schön, könnte man feststellen, ob überhaupt und wenn ja, wie, Meerestiere auf pH Veränderungen reagieren und wo die Grenzen liegen.

Angesichts der bereits beobachteten pH Schwankungen, die so groß oder größer sind, als die aus Klimamodellen erwarteten und dem bisherigen Überleben der Meeresfauna und -flora kann man zunächst wohl nur sagen, dass trotz pH Schwankungen der letzten 100 Jahre innerhalb des ganzen, als verheerend behaupteten Bereichs, verheerende Auswirkungen nicht beobachtet wurden. Prüfen wir aber ein paar weitere Daten.

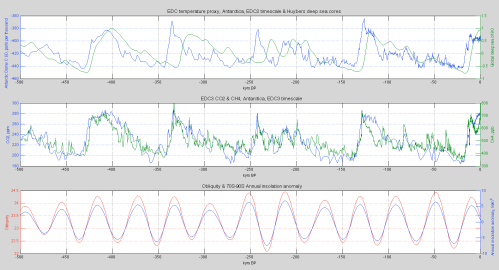

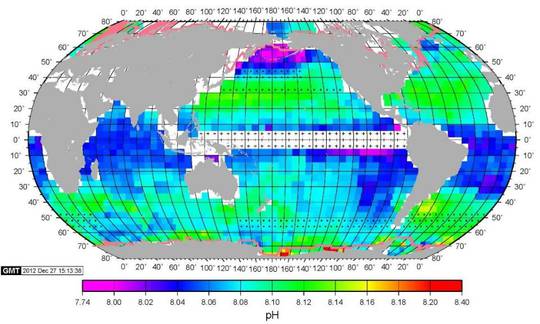

Dazu schauen wir uns eine Karte der Meeres pH Werte ( Abbildung) an, gemessen im Februar 2005. Gemäß Farbskala wird der Bereich von 7.74 bis 8.40 abgedeckt, also wiederum der gesamten „verheerenden“ Bereich. Folglich gilt nicht nur, dass der pH zeitlich über Jahre in diesem Bereich schwankt, auch zu jedem Zeitpunkt scheint es Unterschiede der gleichen Größe je nach Meeresregion zu geben.

|

Abbildung SEQ Abbildung * ARABIC5: Karte der Meeres pH Werte (Februar 2005) |

Quelle: Columbia’s Lamont-Doherty Earth Observatory

Dabei sind regionale Unterschiede auffällig: In Äquatornähe sieht man ein pH Band von etwa 8.03-8.05. Nördlich und südlich Bänder um 8.08-8.14, homogener im Norden als im Süden. Ganz im Norden dann die niedrigsten Werte bis herunter zu 7.74, und ganz im Süden die höchsten bis 8.40. Aus dem Text kann man entnehmen, dass dies typisch für Winter auf der Nord-Halbkugel ist, und die in dieser Messung extremen pH Werte im Norden bzw. Süden sich durch die jeweiligen Temperaturen einstellen. Mithin schwanken die pH Werte um so mehr, je näher man den Polen kommt.

Macht es angesichts dieser globalen Unterschiede überhaupt Sinn, einen mittleren globalen pH-Wert zu bestimmen?

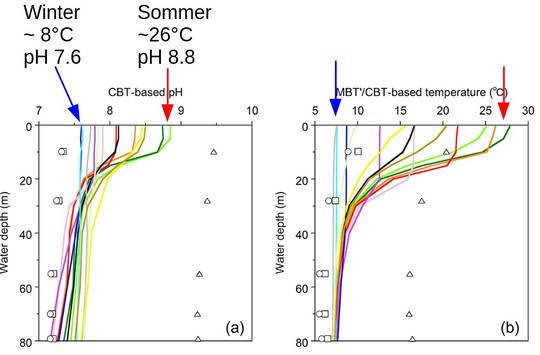

Dass die pH Werte in der Wärme höher sind als in der Kälte finden auch Ajioka et al. [7]) bei Messungen an einem Süßwasser See. Ein Auszug der Daten ist in Abbildung gezeigt. Im Winter wird an der Oberfläche bei ~8°C ein pH von 7.6 erreicht, im Sommer bei ~26°C ein pH von 8.8. Mit zunehmender Wassertiefe zeigen Temperaturen und pH geringer werdende Schwankungen, und nehmen in etwa die Winterverhältnisse an.

|

Abbildung SEQ Abbildung * ARABIC6: Sommer, Winter pH und T Messungen an einem See |

Das heißt dann aber auch, dass die Wasserorganismen, im Meer oder im Süßwasser, aber am Ort ihres Aufenthalts, im jahreszeitlichen Wechsel pH Schwankungen von sogar mehr als dem „verheerenden“ Bereich erfahren.

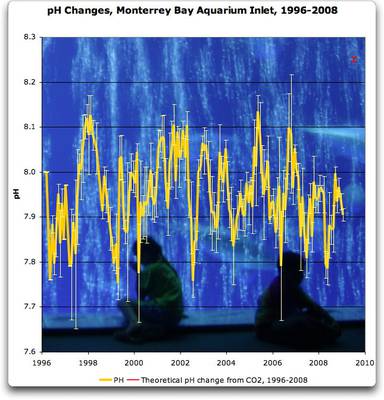

Das Monterey Bay Meerwasser Aquarium (Kalifornien, USA) misst seit Jahren den pH Wert des aus dem Meer in das Aquarium eingeleiteten Wassers (Quelle von Daten, Abbildung). Den Verlauf zeigt Abbildung. Auch hier müssen die Organismen im Meer und im Aquarium mit pH Schwankungen von 7.75 bis 8.15 leben, wiederum so groß wie der „verheerende“ Bereich!

Offenkundig zeigen die Beobachtungen, dass die Organismen pH Schwankungen im „verheerenden“ im Bereich gut verkraften, ob diese sich nun über Jahre hinweg ändern, über die Jahreszeiten, oder durch lokale, regionale, oder globale Besonderheiten bedingt sind.

Labortests

|

Abbildung SEQ Abbildung * ARABIC7: pH Werte Monterey Bay Aquarium 1996-2008 |

Um die Reaktion von Korallen auf erhöhte CO2 Werte zu messen, sind verschiedene Labor Studien gemacht worden. Es wurden z.B. Coccolithophore untersucht, die für ein drittel der marinen Kalksteinproduktion verantwortlich seien, und man fand, dass Kalkbildung und Produktivität bei höherer CO2 Konzentration signifikant höher war. In einer weiteren Studie fand man, dass die Koralle Lophelia pertusa sich in einigen Monaten an saurere Bedingungen anpassten und dann ebenfalls erhöhte Kalkbildung zeigte. Beide Male also das Gegenteil der Katastrophen-Behauptungen. Eine weitere Studie zeigte gemischte Ergebnisse, war allerdings so kurzfristig angelegt, dass möglicherweise noch keine Adaption der Meeres Organismen stattgefunden hatte. Es gibt noch viele weitere Studien [8]). Welche davon negative Effekte zeigte, trotz Berücksichtigung von Adaption, ist nicht einfach zu klären.

Historisch

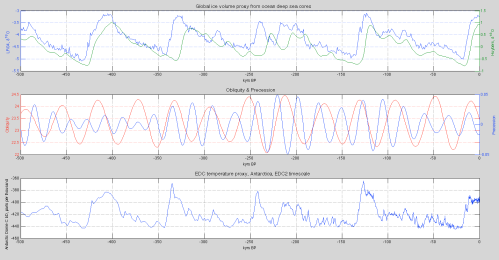

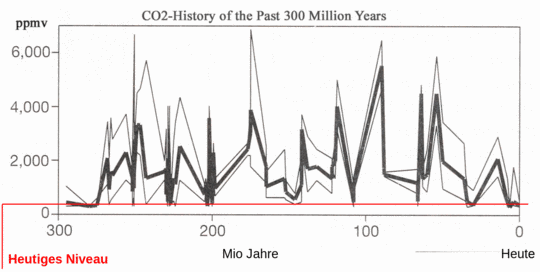

In den letzten 300 Mio Jahren betrug die CO2 Konzentrationen in der Atmosphäre bis zum 15fachen der heutigen Werte (s. Abbildung). Wenn erhöhtes CO2 durch Versauerung der Ozeane den kalkbildenden Organismen das Leben unmöglich gemacht hat, warum gibt es dann heute noch Kalksteingebirge und Fossilien mit Kalkschalen ?

|

Abbildung SEQ Abbildung * ARABIC8: CO2 in den letzten 300 Mio Jahren (kaltesonne.de) |

Riffe sind Klimasünder

Und noch ein weiterer Effekt macht Vorhersagen komplizierter: In einem Riff findet Photosynthese durch die Algen statt, wodurch CO2 verbraucht wird. Gleichzeitig findet aber auch die Kalkbildung statt, wodurch CO2 erzeugt wird!

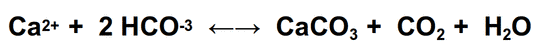

Die Calcifizierungs Gleichung zeigt es:

Da Calcium  carbonat (CaCO3, Kalkstein) in Wasser schwer löslich ist, fällt es aus. Dabei wird CO2 freigesetzt! Tatsächlich sind vitale Riffe insgesamt Quellen von CO2 [9]), tragen also zum CO2 Anstieg in der Atmosphäre bei!

carbonat (CaCO3, Kalkstein) in Wasser schwer löslich ist, fällt es aus. Dabei wird CO2 freigesetzt! Tatsächlich sind vitale Riffe insgesamt Quellen von CO2 [9]), tragen also zum CO2 Anstieg in der Atmosphäre bei!

Ein gut wachsendes Riff ist ein Klimasünder. Was tun wir dagegen?

Temperaturen

Wie beobachtet sind niedrige pH Werte mit niedrigen Temperaturen und hohe pH Werte mit hohen Temperaturen assoziiert sind und wenn eine „Globale Erwärmung“ auch die Meere erwärmt, müsste man doch folglich eine pH Erhöhung erwarten, also eine Alkalisierung und eben nicht eine Versauerung! Das passt zu der Tatsache, dass sich CO2 in kaltem Wasser besser löst als in warmen – öffnen Sie spaßeshalber mal eine gut vorgewärmte Flasche Mineralwasser!

Nur ist es nicht einfach zu sagen, was der Netto Effekt ist zwischen einer CO2 Erhöhung in der Atmosphäre, die den pH-Wert des Meerwassers tendenziell absenkt, und einer CO2-Ausgasung des Meeres, weil durch Erwärmung die Löslichkeit von CO2 sinkt. Und wie das Puffersystem auf das gleichzeitige Verändern von CO2 und Temperatur regiert.

Im Originalartikel wird darauf hingewiesen, dass Wallace in einem noch kommenden Artikel eine Korrelation der pH Werte mit der PDO (Pazifisch Dekadischen Oszillation) zeigen wird (kann ich aus den Daten bisher nicht erkennen [10])). Das gäbe einen starken Hinweis darauf, dass die pH Werte tatsächlich primär temperaturabhängig schwanken.

Für diese Vermutung sprechen auch die ersten Daten der amerikanischen OCO2 Satelliten Mission zur Messung der globalen CO2 Verteilung, gezeigt in Abbildung. Die mittlere CO2 Konzentration schwankt nur um ±2%, ist also tatsächlich global ziemlich konstant. Auffällig sind niedrige Konzentrationen über Europa, insbesondere UK und Irland, und hohe in der Südhalbkugel, einschließlich der Meere. Könnte es sein, dass die Emissionen von Industrie, Verkehr und Privathaushalten unbedeutend ist im Vergleich zu natürlichen Schwankungen? Und das die CO2 Ausgasungen auf den Meeren der Südhalbkugel – dort ist Frühling zur Zeit dieses Messungen – auf Erwärmung zurückzuführen sind?

Überhaupt könnte der CO2-Anstieg der letzten 160 Jahre durch Entgasung aus dem Ozean dank stärkerer Sonnenaktivität erklärt werden, wobei CO2 nicht die Ursache sondern die Folge einer Temperaturerhöhung ist (weiteres hier, hier, hier, und hier).

|

Abbildung SEQ Abbildung * ARABIC9: Globale CO2 Konzentration per Satellit (Okt/Nov 2014) |

Konklusion

- Feely et al. haben durch das selektive Verwenden von Daten – was ihnen offenkundig bekannt war – eine pHälschung begangen, und darauf aufbauend wilde Behauptungen über die Folgen eines CO2 Anstiegs für die Meeresbiologie angestellt

- Tatsächlich zeigen die Daten, dass Schwankungen um angeblich verheerenden Bereich normal, und in den letzten 100 Jahren mehrfach vorgekommen sind.

- Außerdem treten diese Schwankungen in Gewässern im jahreszeitlichen Rhythmus auf, wodurch sich auch zumindest ein Teil der globalen Schwankungen erklären lässt.

- Zumindest einige der potentiell betroffenen Organismen können sich adaptieren, und haben dann sogar Vorteile von einer solchen angeblich verheerenden Entwicklung.

- Es gibt begründete Zweifel, dass die steigenden CO2 Emissionen durch Aktivitäten des Menschen bedingt sind. Auch zunehmende biologische Aktivität im Meer (und an Land) trägt zu den CO2 Emissionen bei.

- Womöglich ist der ganze CO2 Anstieg nur eine Folge einer natürlichen Erwärmung, und nicht etwa seine Ursache.

[1] genauer: H3O+ statt H+. Auch müssten in der Folge Aktivitäten statt Konzentrationen genommen werden – aber diese Feinheiten übergehen wir hier. Für schwache Säuren und Laugen ist letzteres ohnehin bedeutungslos.

[2] Das kleine „p“ in pH ist historisch bedingt, aber das H bezieht sich auf Wasserstoff. Entsprechend gibt es auch pOH für die OH–Ionen. Am Neutralpunkt ist pOH = pH = 7.

[3] alternativ kann für Lauge auch das Wort „Base“ genommen werden, und statt alkalisch findet auch „basisch“ Verwendung. Das Wort Lauge kommt daher, dass eine klassische Seifenlauge einen alkalischen pH-Wert hat. Auch nimmt man Natronlauge, also Ätznatron (=NaOH) gelöst in Wasser, zum „Ablaugen“ von alten Möbelstücken. Das Wort „alkalisch“ rührt daher, dass Natrium (Na) zur Gruppe der Alkalimetalle (Li, Na, K, Rb, Cs) gehört, die alle mit Wasser starke Laugen bilden.

[4] Pschyrembel Wörterbuch Pflege (2003), S. 517

[5] im Text wird, anders als in der Grafik gezeigt, sogar ein Absinken auf pH=7.65 genannt

[6] Feely erhielt in 2010 einen $100,000 Preis von der Heinz Family Foundation („Heinz-Ketchup“) der von Teresa Heinz, Ehefrau des US-Außenministers John Kerry), gegründet wurde, für seine „maßgebenden Arbeiten zur Meeresversauerung“.

[7] Water pH and temperature in Lake Biwa from MBT /CBT indices during the last 280 000 years, T. Ajioka et al., Clim. Past, 10, 1843–1855, 2014

[8] Auf der Webseite http://www.co2science.org/data/acidification/background.php wird eine Datenbank mit Artikeln zur Wirkung einer Meeresversauerung geführt. Nach den Betreibern der Webseite spräche etwa die eine Hälfte der Artikel für eine Schädigung, die andere Hälfte dagegen. Gewissheit sieht anders aus.

[9] Reef Water CO2 System and Carbon Production of Coral Reefs: Topographic Control of System-Level Performance, Atsushi SUZUKI and Hodaka K AWAHATA, Global Environmental Change in the Ocean and on Land, Eds., M. Shiyomi et al., pp. 229–248. (Download)

[10] Da aber der gegenwärtige Datensatz global ist, und PDO und das atlantische Gegenstück AMO (Atlantische Multidekadische Oszillation) um etwa 20 Jahre phasenverschoben sind, muss man wohl zumindest erst die pH Daten nach den Ozeanen aufschlüsseln. (Daten zu AMO, PDO, Korrelation mit Temperatur)