Eine sofortige Rückkehr zum Statu quo ante durch Entfall des Einspeisevorrangs für Wind- und Solarstrom in einem freien Strommarkt ohne Sondersteuern hätte gravierende wirtschaftliche und politische Verwerfungen zur Folge. Mit an Sicherheit grenzender Wahrscheinlichkeit werden die handelnden Politiker den Status quo der Energiewende 2015 ausbessern, einfrieren und die Probleme in bewährter Manier aussitzen. Am Ende wird es nur Verlierer geben, das vermutet der Autor.

1. Die Einstimmung

Im Jahr 1960 waren 73 Millionen Deutsche mit 2,4% Teil einer Weltbevölkerung von 3 Milliarden Menschen. Im Jahr 2010 war ihre Zahl auf 81 Millionen angestiegen und ihr Anteil an nun 7 Milliarden Menschen auf der Welt hatte sich auf 1,2 % halbiert.

Der jährliche Stromverbrauch der Deutschen stieg Im gleichen Zeitraum von knapp 300 TWh1 auf über 600 TWh an. Der Strombedarf pendelt seit einigen Jahren um diese 600 TWh.

Energieintensive Industrie meidet das Land inzwischen und über die zukünftige Entwicklung der Größe der Bevölkerung wird gestritten. Gegenläufig zum Sinken der Geburtenrate existiert jedoch unverändert ein erhebliches Interesse an Einwanderung.

Seit dem Ende des zweiten Weltkrieges besorgte zunächst deutsche Steinkohle die Stromversorgung des Landes. Eine viertel Million Arbeitskräfte förderten in Deutschland „unter Tage“ Steinkohle.

Braunkohle aus dem „Tagebau“ kam nach der Entwicklung eines für ihre Nutzung erforderlichen speziellen Dampfkessels hinzu, Ihre erheblich geringeren Gewinnungskosten zusammen mit einem Verfall der Preise sowohl für Erdöl als auch für importierte Steinkohle machten deutsche Steinkohle in den 60 er Jahren des vorigen Jahrhunderts hoffnungslos unwirtschaftlich.

Der Strombedarf stieg zu dieser Zeit in den Industrieländern und auch in Deutschland jährlich um etwa 7%. Seine geographische Lage stellte insbesondere an die Versorgung Süddeutschlands mit Strom besondere Anforderungen.

Politiker und Energieversorger erarbeiteten einvernehmlich eine Lösung des Problems:

Die Steinkohleförderung soll grundsätzlich sozialverträglich und hinreichend langsam ersetzt werden. Die Mehrkosten bis zum endgültigen Ausstieg aus ihrer Nutzung, der leider auch in 2014 nicht vollständig abgeschlossen wurde, trägt der Steuerzahler. Die seinerzeit nicht einmal annähernd erahnten Gesamtkosten haben sich inzwischen über regelmäßige Neuverschuldung auf etwa 1 Billion Euro in den Staatsschulden Deutschlands akkumuliert. Ein nachhaltig niedriger Ölpreis schien unwahrscheinlich und schied daher als Alternative aus. Neben der Importkohle kam Kernenergie ins Blickfeld. Mit dem Einsatz von Kernenergie konnte auf den kostspieligen Energietransport nach Süddeutschland über Stromleitungen verzichtet werden.

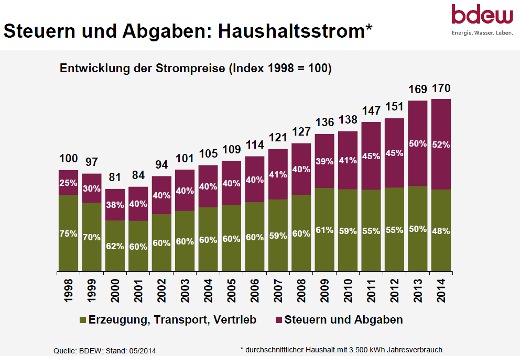

Dieses Konzept wurde erfolgreich umgesetzt. Eine sichere, zuverlässige und durch umfassende Abgasreinigung umweltfreundliche Stromversorgung lieferte noch im Jahr 2000 Haushaltstrom zum Preis von 12 Cent/kWh für Tagstrom und etwa 8 Cent/kWh für Nachtstrom an Haushalte und andere Kleinverbraucher. Die Strompreise für industrielle Großverbraucher lagen deutlich darunter.

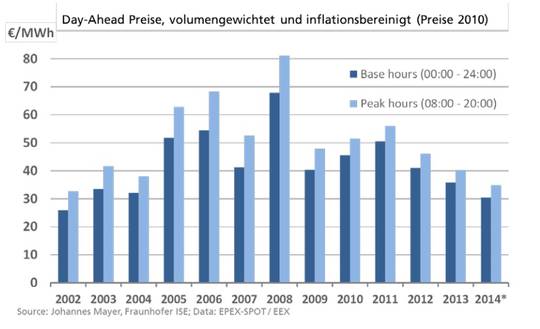

Erst nach 2000 wurde das lebenswichtige Kohlenstoffdioxid mit der Energiewende in der Stromversorgung Deutschlands signifikant wirksam. Noch im Lande ansässige stromintensive Industrie muss inzwischen durch Subvention gestützt werden. Der Preis für den Haushaltsstrom ist auf 28 Cent/kWh angestiegen. Die für eine zuverlässige Stromersorgung erforderlichen Kapazitätsreserven zuverlässiger Kraftwerke sind geschrumpft, verdrängter Strom führt in die Verlustzone.

2. Die Energiewende soll „den“ anthropogenen Klimawandel stoppen

Im Jahr 1988 gründen dazu das „United Nations Environment Program“ und die „World Meteorological Organization“ das „Intergovernmental Panel on Climate Change“, das IPCC [1]. oder auch Weltklimarat genannt:

„Es drohe ein gefährliche Erwärmung, ein Klimawandel [2], wenn die Nutzung fossiler Brennstoffe nicht unverzüglich drastisch reduziert, wenn nicht gar völlig eingestellt würde.“

Einer Hinterfragung zur Sache selbst vorangestellt wird folgend zunächst geprüft, ob ein solche drastische Forderung überhaupt global umsetzbar sein könnte und welchen Beitrag die Stromversorgung Deutschlands dazu leisten kann:

Im Jahr 1970 wurden mit Hilfe fossiler Bennstoffe global 5.500 TWh elektrischen Stroms erzeugt. Diese Strommenge ist bis zum Jahr 2011 auf 14.000 TWh angestiegen. Das ist ein Anteil von 64% am Gesamtverbrauch von etwa 22.000 TWh. Die Differenz zum Gesamtverbrauch glichen Wasserkraft mit 14%, Kernenergie mit 9 %, Windkraft und Solarenergie zusammen mit 9 % ergänzt durch einen Beitrag der Biomasse von gut 4% aus. .

Sowohl die Industrialisierung als auch das Wachstum der Weltbevölkerung schreiten fort. Für eine Abschwächung im Trend der ständig weiter ansteigenden Nutzung fossiler Brennstoffe zur Stromerzeugung ist weder eine realistische Möglichkeit noch ein Indiz zu erkennen. Auf einer Vielzahl internationaler Konferenzen, einberufen zur Umsetzung der Empfehlung des IPCC , wird folgerichtig de facto lediglich leeres Stroh gedroschen.

Im Jahr 1970 wurden in Deutschland 300 TWh Strom erzeugt. Fossile Brennstoffe waren daran mit etwa 270 TWh beteiligt. Ab 2000 ansteigend verdrängen im Jahr 2014 fluktuierender Wind- und Solarstrom 72,5 TWh, etwa 12% einer jährlich um 600 TWh schwankenden Gesamtmenge. Das reduziert den Beitrag der mit fossilem Brennstoff betriebenen Kraftwerke um 18%.

Wind und Sonne fallen für Zeiträume bis zu zwei Wochen nahezu komplett aus. Zusätzliche Stromspeicher, die solche Zeiträume überbrücken könnten, sind technisch, wirtschaftlich und ökologisch eine Utopie [3]. Zum Erhalt der Stromersorgung kann daher auf keines der anderen Kraftwerke im Netz verzichtet werden. Selbst eine weitere marginale Steigerung des Beitrages von Wind und Sonne zur Stromerzeugung muss daher eine Illusion bleiben.

Im Zeitraum vom Jahr 2000 bis zum Jahr 2011 hat Kernenergie in Deutschland jährlich mit mindestens 180 TWh, d. h. mit 30%, zur Stromerzeugung beigetragen. Der nach 2011 verbliebene Beitrag von etwa 20% muss in den kommenden Jahren als Folge der gesetzlich fixierten Abschaltung der Kernkraftwerke ersetzt werden. Das können Windkraft, Solarenergie aus den genannten Gründen nicht leisten. Nur eine verstärkte Nutzung fossiler Brennstoffe in zusätzlichen neuen Kraftwerken und Stromtrassen könnte daher die fehlenden Kernkraftwerke ersetzen. Zum Schwerpunkt dieser Aufgabe wird erneut die Stromversorgung Süddeutschlands.

Die Umsetzung der Energiewende bis zur Abschaltung des letzten Kernkraftwerkes würde aus den genannten Gründen im Vergleich zum Jahr 2010 einen Anstieg des Beitrages fossiler Brennstoffe zur Stromerzeugung um etwa 100 TWh, das sind mehr als 15% des gesamten Strombedarfes, erzwingen.

Fazit:

Die deutsche Energiewende kann die CO2 Freisetzung nicht reduzieren, sondern bewirkt ihre Zunahme. Auch ein erhoffter Ersatz fossiler Brennstoffe durch Strom in anderen Teilen der Energieversorgung ändert daran nichts. Darüber hinaus muss entweder der Strompreis weiter signifikant über 28 Cent/kWh hinaus ansteigen, oder Insolvenzen der Betreiber von Kraftwerken, die fossile Brennstoffe zur Stromerzeugung nutzen, beenden eine zuverlässige Stromerversorgung in Deutschland.

3. Ist der Klimawandel Angstobjekt [4] oder Realität [5]?

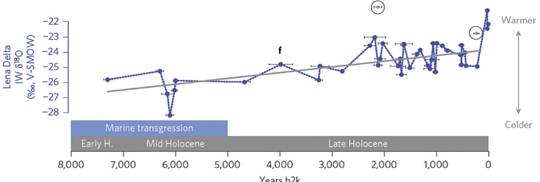

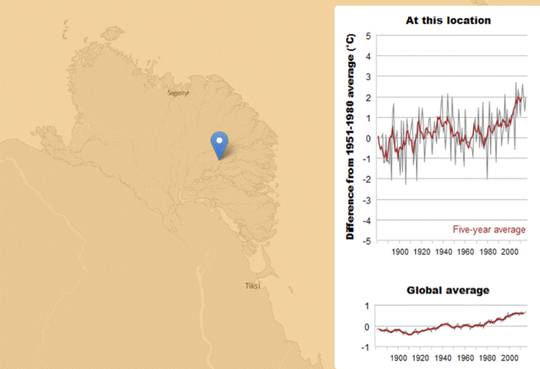

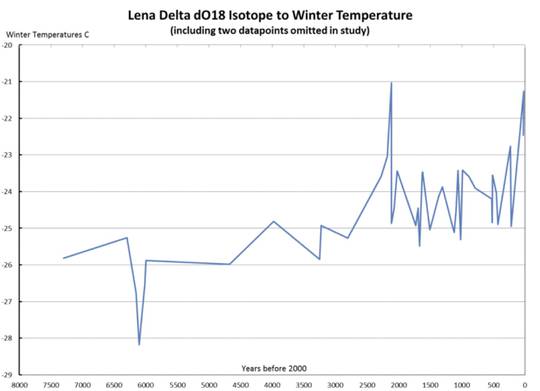

Für den Fall, dass ein „anthropogener Treibhauseffekt“ tatsächlich existieren sollte, reduziert sich das Problem Klimawandel auf die Frage ob und in wieweit seine Wirkung als Komponente der stets erforderlichen Anpassung an die natürlichen Klimaänderungen berücksichtigt werden könnte. Die behauptete Existenz eines solchen Effektes wird allein gestützt durch grundsätzlich fragwürdige Modellrechnungen [6]. Natürliche Klimaänderungen können allerdings nicht vorhergesagt, sondern lediglich in der Geschichte der Klimate dokumentiert werden:

Assimilation der Flora hat den CO2 Gehalt der Luft von ursprünglich mindestens 25% auf gegenwärtig 0,04% reduziert, das inzwischen fehlende CO2 in Sauerstoff, Kohle, Erdöl und Erdgas gewandelt und dazu noch Eisenerzvorkommen entstehen lassen

Während des Zeitraums von 12.000 Jahren nach dem Ende der letzten Eiszeit stiegen die Meeresspiegel jährlich im Mittel um 10 mm an. Dieser Anstieg hat sich seit einigen tausend Jahren auf gegenwärtig 1 – 2 mm/Jahr verringert.

Im Verlauf der letzten 150 Jahre ist eine mittlere Temperatur über der Erdkruste um etwa 0,7 ℃ angestiegen, seit 18 Jahren ändert sich dieser Zahlenwert nicht mehr.

Man muss sehr stark im Glauben sein, um sich von den Modellrechnungen, die das IPCC als angeblichen Beweis eines anthropogenen Einflusses auf den natürlichen Klimawandel anbietet, ängstigen zu lassen.

4. Aufstieg und Fall der Kernenergie in Deutschland

Das „Atom for Peace“ Programm der USA und der wachsende Strombedarf lösten in Deutschland um 1960 einem fast „revolutionären“ Einstieg in die wirtschaftliche Nutzung der Kernenergie aus. Forschung und Lieferindustrie erreichten 20 Jahre später einen globalen Spitzenplatz. Bis zum Jahr 2011 hatten 17 große Kernkraftwerke fast ein Drittel einer Stromversorgung übernommen, die insgesamt sicher, zuverlässig, umweltfreundlich und preiswert funktionierte.

Parallel dazu eskalierte (eifrig geschürt) menschliche Angst vor allem Neuen auch gegen Kernenergie. Widerstand organisierte sich, politisches und kommerzielles Interesse half dabei nach Kräften. Ein erwarteter Zuwachs des Strombedarfes von jährlich bis zu 7% setzte sich nicht fort, so dass – bedingt durch eine Vorlaufzeit von etwa 10 Jahren zwischen der Entscheidung zum Bau eines Kraftwerkes bis zu seiner Inbetriebnahme – zwangsläufig eine Überkapazität entstehen musste.

So wurde es möglich und politisch opportun, den Aufstieg der Kernenergie zu beenden und den Ausstieg einzuleiten. Die Forschung wurde eingestellt. Restlaufzeiten der Kernkraftwerke wurden gesetzlich festgeschrieben. Das alles geschah, obwohl deutsche Kernkraftwerke – nach wie vor – als die sichersten der Welt gelten. Die Lieferindustrie hatte keine Wahl, eine Aufgabe des Geschäftszweiges Kernenergie war unter diesen Umständen unvermeidbar. – Die Wartung deutscher Kernkraftwerke blieb durch potente ausländische Industrie gesichert.

Als die Laufzeiten der Kernkraftwerke verlängert wurden, schien es, als sei die globale Vernunft im Begriff, nach Deutschland zurückzukehren. Doch eine Naturkatastrophe in Fukushima, Japan, im März 2011 zerstörte auch solchen Hoffnungsschimmer:

Obwohl die zuständige Reaktorsicherheitskommission im japanischen Reaktorunfall keine Relevanz für Deutschland erkennen konnte, wurden in einer Panikreaktion 8 der 17 Kernkraftwerke abgeschaltet. Japan setzt dagegen die Nutzung der Kernenergie fort. Dieser Alleingang Deutschlands war damals und ist auch heute rational nicht zu begründen. Helfen mussten daher Fachfremde, die „endlich herausfanden“, dass Kernenergie in Deutschland nicht mit der Ethik vereinbar sei, Zitat:

„Der Ausstieg ist nötig und wird empfohlen, um Risiken, die von der Kernkraft in Deutschland ausgehen, in Zukunft auszuschließen. Es ist möglich, weil es risikoärmere Alternativen gibt. Der Ausstieg soll so gestaltet werden, dass die Wettbewerbsfähigkeit der Industrie und des Wirtschaftsstandortes nicht gefährdet wird. Durch Wissenschaft und Forschung, technologische Entwicklungen sowie die unternehmerische Initiative zur Entwicklung neuer Geschäftsmodelle einer nachhaltigen Wirtschaft verfügt Deutschland über Alternativen: Stromerzeugung aus Wind, Sonne, Wasser, Geothermie, Biomasse, die effizientere Nutzung gesteigerte Produktivität von Energie sowie klimagerecht eingesetzte fossile Energieträger. Auch veränderte Lebensstile der Menschen helfen Energie einzusparen, wenn diese die Natur respektieren und als Grundlage der Schöpfung erhalten.“

Dazu nur folgende Anmerkung: Wenn künftig Ethiker exklusiv und unbelastet von jeder Fachkunde die Bewertung der Risiken des Lebens vornehmen und über ihre Akzeptanz entscheiden sollen, läuft gegenwärtig fast nichts richtig in Deutschland.

Zur Erinnerung: Der Reaktorunfall in Fukushima als Folge einer Naturkatastrophe hat zum Glück nicht einmal die Gesundheit eines einzigen Menschen in Gefahr gebracht!

6. Die Suche nach den Schuldigen

Die Suche nach den Schuldigen, das Aufspüren der Täter und selbst ihre Bestrafung können entstandenen und fortschreitenden Schaden niemals beseitigen. An der Energiewende haben sehr viele gewerkelt:

Das IPCC, die Leichtgläubigen, die Scharlatane, die Opportunisten in Politik, Wirtschaft und in vielen Bereichen des gesellschaftlichen Lebens. Ohne Wertung der jeweiligen Beteiligung folgend einige Beispiele:

Wer keinen Markt für Gas-, Kohle-, oder Kernkraftwerke hat, liefert gern Windmühlen als Ersatz, hinter denen Andere ein versprochenes, durch Verbraucher (zwangs-) subventioniertes Geschäft wittern.

Ein Elektriker, der zu wenige Neubauten findet, installiert mit Fleiß Solarzellen auf Dächern, unter denen Menschen leben, die eine zuverlässig fließende Nebeneinnahme erwarten.

Grüne Politiker erkennen die Möglichkeit, Wählerstimmen zu sammeln, SPD Politiker können das nicht überhand nehmen lassen und steigen ein, CDU/CSU Nachläufer nutzen eine günstige Gelegenheit um auch einen Platz auf der Lokomotive des „Wählerzuges“ zu besetzen.

Die öffentlich rechtlichen Sendeanstalten folgen ihrem (Rundfunk) Rat, der doch völlig neutral von allen Parteien besetzt wird und „verkünden zuverlässig Energiewende“:

Die Presse ist eine kommerzielle Veranstaltung, die sowohl von hilfreicher Information, als auch von Werbung lebt. Warum also Streit suchen?

Diese unvollständige Liste ergänzt eine gläubige Mehrheit der „Klimawandel Gläubigen“, die inzwischen sogar die Kindertagestätten erreicht hat.

Es melden sich seit vielen Jahren auch einige Menschen zu Wort, die vorgeben Fachleute zu sein. Sie nörgeln, nörgeln und nörgeln noch einmal, – Das kann und darf doch Niemanden davon abhalten, die „Kuh Energiewende“ aufs Eis zu treiben. Das Eis ist inzwischen leider so dünn geworden, dass die Kuh – für alle sichtbar -einbrechen und ertrinken könnte.

7. Die „Energiewende“ ist trotz gegenteiliger Fakten und Argumente inzwischen stabil:

Es ist die normative Macht des Faktischen die zuverlässig schnelle und signifikante Änderungen des Status quo ausschließt.

Der Ratio konstatiert:

Für den Fall, dass der feste Glaube an den Klimawandel erschüttert werden könnte, würde eine sofortige Rückkehr zum „Status quo ante“ die sichere, zuverlässige, umweltfreundliche und preisgünstige Stromversorgung wieder herstellen.

Dann müssten jedoch (im Wesentlichen):

– deutsche Politiker zugeben, dass sie (vorsätzlich oder fahrlässig) teils Scharlatanen auf den Leim gegangen sind, teils den Rat von Fachleuten missachtet haben, teils nur ihre Wiederwahl betrieben haben.

Das Vertrauen in die parlamentarische Demokratie wäre (zu Unrecht) erschüttert, das Vertrauen in die handelnden Personen (zu Recht) ebenfalls. Ihre Wiederwahl würde zur Illusion. – Beimischung direkter Demokratie bekäme endlich auch in Deutschland eine Chance.

– alle Subventionen und Sonderrechte für Stromlieferung ersatzlos entfallen.

Wind- und Solarstrom sind dann an einer Strombörse weitgehend unverkäuflich, die Investition daher im Handel wertlos, die Eigennutzung wird sogar spezifisch teurer, wenn eine Netzanbindung nötig wird.

– alle Kraftwerke (auch die abgeschalteten 8 Kernkraftwerke) wieder eine uneingeschränkte Betriebserlaubnis erhalten, solange sie ihre Eignung für den Betrieb (wie auch in der Vergangenheit stets erforderlich) nachweisen.

Die Betreiber der zur Versorgung unverzichtbaren Kraftwerke würden die Verlustzone verlassen. Die Investition in Kraftwerke würde wieder kalkulierbar und die Stromerzeugung selbst wieder optimierbar. Der Preis für Haushaltsstrom würde sich etwa halbieren.

Es ist in der Geschichte allerdings weitgehend unbekannt, dass auf Macht freiwillig verzichtet wird. Vielleicht war Gorbatschow unter dem Druck der Fakten eine solche Ausnahmeerscheinung. Im vorliegenden Fall bilden die Politiker aller zu beachtenden deutschen Parteien eine Phalanx, deren Verhalten z. B. mit dem einer Elefantenherde verglichen werden kann. „Man ist gemeinsam so stark, dass die Möglichkeit einer freiwilligen Richtungsänderung ausgeschlossen werden muss.“

Literatur

[1]. Die Aktivitäten des IPCC:

http://www.ipcc.ch/activities/activities.shtml

[2] IPCC Fifth Assessment report

http://www.ipcc.ch/report/ar5/

[3] Kernenergie, Windkraft und Pumpspeicher

https://de.scribd.com/doc/129978934/Kernenergie-Windkraft-und-Pumpspeicher-docx

[4] Angst auf Objektsuche wählt Klimawandel und Energiewende

http://de.scribd.com/doc/190496647/Angst-auf-Objektsuche-wahlt-Klimawandel-und-Energiewende

[5] Klimaänderung, ein Buch mit sieben Siegeln

https://de.scribd.com/doc/251222131/Klimaa-nderung-ein-Buch-mit-sieben-Siegeln

[6] Fakten, die Klimapolitik beachten sollte.

https://de.scribd.com/doc/245220065/Fakten-Die-Klimapolitik-beachten-sollte?post_id=100005110448729_335951823251830#_=_

1 1 Terawattstunde [TWh] = 1 000.000.000 Kilowattstunden [kWh]