PIK Vizechef Edenhofer: Die Besitzer von Kohle, Öl und Gasvorkommen müssen enteignet werden.

Die altehrwürdige Berliner URANIA will den Berlinern Zugang zur Wissenschaft verschaffen. Ihnen wissenschaftliche Bildung vermitteln. Das tut sie mit einigem Erfolg seit 1888. Viele illustre Menschen durften bei Ihr vortragen, u.a. so herausragende Wissenschaftler wie Albert Einstein oder Christiane Nüsslein-Volhard. Aber auch angesehene Schriftsteller wie Thomas Mann, Heinrich Böll oder Max Frisch. Doch auch Staatsmänner oder solche, die vom Mainstream dafür gehalten werden sprachen dort, wie Michail Sergejewitsch Gorbatschow und Helmut Kohl, ja auch das ewige SPD Irrlicht und Beinahe-Bundespräsidentin Gesine Schwan durften schon mal dort reden.

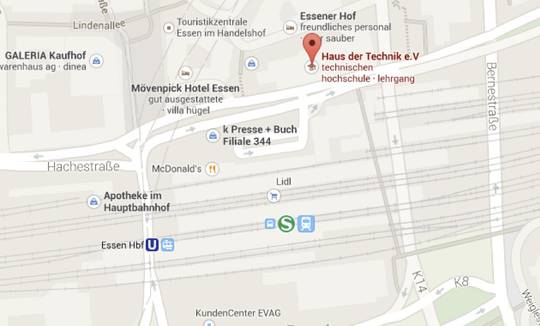

Daher sei es der passende Ort, so dachte es sich wohl der dort Verantwortliche Herr Dr. Ulrich Bleyer , dass mal wieder jemand Bedeutendes vom „Weltklimarat“, vulgo IPCC, vorträgt. Geht es doch bei denen um nichts anderes als um die Weltrettung. So wurde Prof. Dr. Ottmar Edenhofer,

Stellvertretender Direktor und Chefökonom am Potsdam Institut für Klimafolgenforschung (PIK), einem Institut der Leibniz-Gemeinschaft und Vorsitzender der Arbeitsgruppe III des Weltklimarats IPCC eingeladen seine Sicht der Dinge, nämlich zur „Erforschung von Lösungswegen für den Klimawandel“ vorzutragen. Und das tat der dann auch. Eingeladen wurde mit dem schlichten Text

Der 5. Sachstandsbericht des Weltklimarats IPCC zeigt, dass menschliche Aktivitäten für den Anstieg der globalen Mitteltemperatur verantwortlich sind: die Verbrennung von Kohle, Öl und Gas und Entwaldung. Weitere Erwärmung birgt das Risiko irreversibler Folgen. Der Klimawandel kann jedoch nicht mehr vollständig vermieden werden. Daher sind Anpassung und Klimaschutz komplementäre Strategien zum Umgang mit und zur Verringerung dieser Risiken; vor allem die substantielle Reduzierung der Treibhausgas-Emissionen in den kommenden Jahrzehnten können die Risiken des gefährlichen Klimawandels verringern. Das Zwei-Grad-Ziel ist noch erreichbar, wenn es zu einer Entkopplung von Emissionen und Wirtschafts- und Bevölkerungswachstum kommt. Diese Entkopplung erfordert aber international koordinierte Klimapolitik.

Er enthält in Kurzform das Credo des Herrn Edenhofer und seiner Kollegen und es störte keinen, weder die Einladenden noch viele Gäste, welches Aufgebot von Binsenweisheiten bzw. Banalitäten, zum Teil sogar stupende Leerformeln schon die Einladung enthält. Da ist die Rede von … Der Klimawandel kann jedoch nicht mehr vollständig vermieden werden… und das religiöse aber völlig unbewiesene Mantra wird wiederholt… vor allem die substantielle Reduzierung der Treibhausgas-Emissionen in den kommenden Jahrzehnten können die Risiken des gefährlichen Klimawandels verringern.

Abb. 1 Täuschen und Tarnen bei der Darstellung der Realität in der Summary for Policymakers 2013

Ja ist denn wirklich niemandem aus dem Hause URANIA aufgefallen, dass es eine schier endlose Klimageschichte auf diesem Planeten gibt, mit vielen Klimata, die sich vor allem durch ständigen immerwährenden Wandel auszeichnen? Was also soll dieses nichtssagende Gerede, dass „der Klimawandel“ nicht „mehr vollständig“ aufzuhalten sei? Wann war er das jemals? Oder die nicht minder gebetsmühlenartige vorgetragene Schein-Weisheit .. dass die substantielle Reduzierung der Treibhausgas-Emissionen in den kommenden Jahrzehnten die Risiken des gefährlichen Klimawandels verringern (können). Auch dafür wurde bisher nirgendwo in den tausenden von Seiten aller 5 Sachstandsberichte irgendein Beweis, irgendeine Beobachtung vorgelegt. Und so blieb es auch während des Vortrages.

Abb 2 & 3: es gibt auch lt IPCC Bericht keinerlei Anzeichen für erhöhte Extremwetteraktivitäten, noch für Schäden, die zu Klimaflüchtlingen führen würden

Die Einführung gab der Hausherr Programmdirektor und Geschäftsführer Dr. habil Ulrich Bleyer. Er wies daraufhin, dass der Vortragende Edenhofer nicht nur ein vorzüglicher Ökonom sei, der nun die Wissenschaftslandschaft über das Potsdam Institut für Klimafolgenforschung (PIK) mit über 300 Mitarbeitern bereichere, sondern auch Vorsitzender (Chair) der Arbeitsgruppe III des IPCC sei, und dort entscheidend an der Verbesserung der Transparenz dieser Organisation mitgewirkt habe, wozu ihm u.a. auch seine über siebenjährige Zugehörigkeit zu den Jesuiten gedient hätte. Dem Orden, der von seinen Mitgliedern unbedingten „Kadavergehorsam“ gegenüber der Kirche (Papst) fordert und dessen Gründer Ignacio von Loyola verlangte

„Wir müssen, um in allem das Rechte zu treffen, immer festhalten: ich glaube, dass das Weiße, das ich sehe, schwarz ist, wenn die Hierarchische Kirche es so definiert."[1]

Und damit sei er vorzüglich gerüstet auch die schwierigen Lösungen zu suchen und zu finden, die der allgegenwärtige gefährliche Klimawandel mit sich bringe. Solcherart eingeführt begann Herr Otmar Edenhofer seinen Vortrag. Eloquent, sachkundig und keinen Zweifel am Gesagten zulassend.

Gleich zu Beginn wies der darauf hin, dass er davon ausgehe, dass das CO2 die Globaltemperatur gefährlich aufheize, das sei schließlich im Bericht der Arbeitsgruppe I so festgehalten worden (… Der 5. Sachstandsbericht des Weltklimarats IPCC zeigt, dass menschliche Aktivitäten für den Anstieg der globalen Mitteltemperatur verantwortlich sind: die Verbrennung von Kohle, Öl und Gas und Entwaldung.), leider seien weder er noch seine Kollegen in der Lage mitzuteilen ob und wann und wo diese gefährliche Erwärmung, leider auch nicht bis zu welcher Höhe sie eintreten würde, aber dass es irgendwie, irgendwann, irgendwo dazu käme sei höchst wahrscheinlich. Deswegen sei es so notwendig schon jetzt und weltweit die notwendigen Gegen-Maßnahmen zu treffen, von denen er einige aufzeigen wolle. Diese seien zwar die private Meinung des O. Edenhofer aber würden trotzdem mit vielen Verantwortlichen in dieser Welt genauso diskutiert.

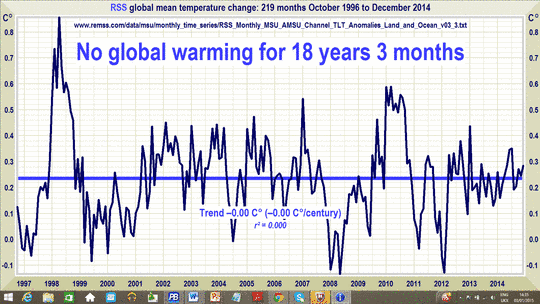

Abb. 4 Aktueller Stand der Entwicklung der globalen Mitteltemperatur nach Satellitenbeobachtungen ausgewertet durch RSS. Kein Anstieg seit 18 Jahren und 3 Monaten. Zur Erinnerung, das IPCC wurde 1988 also bereits 12 Jahre nach Beginn der Minierwärmung im vorigen Jhh gegründet. Diese war 1996 wieder vorbei

Dann widmete er sich unter Verwendung jeder Menge Folien dem 2 ° Ziel, großzügig meinend, dass es nicht wichtig sei, ob es 1,8 oder 2,2 ° würden, denn dass sei für die Gesellschaft schließlich gerade noch so auszuhalten. Aber mehr nicht! Doch leider, leider würden Kohle, Öl und Gas immer billiger und würden deshalb immer mehr zur Energieerzeugung eingesetzt. Dank der Entwicklung neuer Technologien hätte sich auch das Märchen vom Peaköl irgendwohin (Anm. des Autors: auf den Müllplatz der Geschichte) verflüchtigt, so dass der CO2 Anstieg in der Atmosphäre sich sogar beschleunigt hätte. Schlimme 2,2 % pro Dekade seien das jetzt. Das sei nun wirklich besorgniserregend, denn damit würde das uns verbleibende CO2 Budget, dass wir noch gerade so in die Atmosphäre eintragen dürften, um das 2 ° Ziel nicht zu gefährden, umso früher erschöpft. Insgesamt bezifferte er dieses Budget auf rd. 1000 Gt CO2 [2] , Davon sei aber schon ein erheblicher Teil verbraucht und nur durch gewaltige Anstrengungen sei die notwendige Decarbonisierung zu erreichen, indem wir lieber früher als später die Verwendung fossiler Energieträger völlig einstellten. Das heißt aber, den weitaus größten Teil dieser Ressourcen im Boden zu belassen.

Andernfalls würde die Temperatur um bis zu 4 ° C oder mehr steigen, mit schrecklichen Folgen. Das aber sagten dem IPCC und ihm seine Modelle. Wenn sich auch nicht sagen ließe wo, wann und um wie viel diese eintreten.

Abb 5: Vergleich IPCC Prognosen/Projektionen oder wie sie noch heißen gegenüber der Realität. Alle falssch!

Und wir alle wüssten doch welche verheerenden Folgen die Extremwetter bereits hätten, und die daraus ausgelösten Schäden seien nun mal unausweichliche Folgen des Klimawandels. Leider fand sich im ganzen über einstündigem Vortrag mit rd 40 Folien nicht eine einzige, die darstellte, wie viele und wie starke „Extremwetter“ sich vor dem ganzen Klimawandel so ereignet haben, noch wie viele und wie starke es seit der Entdeckung des Klimawandels durch das IPCC und seine Gründer und Unterstützer ereignete. Nicht eine! Das – so hieß die Botschaft- weiß man eben. (Details dazu siehe pdf Anlage)

Dann widmete er sich den „Lösungswegen“ aus diesem Weltdilemma und wiederholte dazu sein Mantra, das er zuvor auch schon der NZZ am 14.11-2010 in die Feder diktierte:

„Zunächst mal haben wir Industrieländer die Atmosphäre der Weltgemeinschaft quasi enteignet. Aber man muss klar sagen: Wir verteilen durch die Klimapolitik de facto das Weltvermögen um. Dass die Besitzer von Kohle und Öl davon nicht begeistert sind, liegt auf der Hand. Man muss sich von der Illusion freimachen, dass internationale Klimapolitik Umweltpolitik ist. Das hat mit Umweltpolitik, mit Problemen wie Waldsterben oder Ozonloch, fast nichts mehr zu tun.“

Und für Edenhofer ist demnach die Enteignung der Besitzer der fossilen Ressourcen der Schlüssel zur erfolgreichen Decarboniserierung. Und hier brach dann wieder der alte Marxist durch, der Edenhofer schon seit früher Jugend ist. Denn diese Ressourcen gehörten ja nicht den „Besitzern“ – so Edenhofer- sondern allen Menschen. Deswegen sei deren Enteignung der Besitzer höchst moralisch und damit auch richtig. Und noch eine gute Botschaft hätte er: Die gesamten Aufwendungen für die Decarbonisierung würden das Wachstum des globalen Bruttosozialproduktes GDP nur um 0,06 % dämpfen.

Aber beim Wie täte man sich schwer. Und deswegen führe der Weg dahin über (Anmerkung des Verfassers: die Gier der) jeweiligen Finanzminister. Diese müssten überzeugt werden, so wie in der EU ja schon erfolgreich geschehen, das Verbrennen von fossilen Brennstoffen mittels des Zertifikatehandels kräftig zu besteuern. Mit dem so eingezogenen Geld könnten sie unglaublich und unendlich Gutes tun, die „Erneuerbaren“ wundervoll subventionieren und ähnlich Edles mehr. Er und seine Kollegen arbeiteten intensiv daran, dass dies in Paris auch so beschlossen würde.

Doch spätestens an dieser Stelle kam Unglaube im sonst andächtig folgendem Publikum auf, wohl auch eingedenk der nackten Tatsache, dass in den meisten Ländern der OPEC, aber auch in Russland, China und andernorts der Staat bereits heute der Besitzer all dieser Schätze ist, und die Verbraucherländer durch ihre Finanzminister den Verbrauch fossiler Brennstoffe hoch besteuerten. Allerdings häufig ohne dass diese Gelder der örtlichen Infrastruktur und den Menschen zur Verfügung gestellt worden. Die Frage drängt sich auf: Wie will man die enteignen? Schickt man ganze schwer armierte Klimaretter-Divisionen nach Saudi-Arabien oder Russland oder Venezuela. Oder wie sollte man sich das vorstellen?

So blieb nicht nur bei denen ein schaler Geschmack über ob der dürftigen, wenn auch Hochglanz- Un„wissenschaftlichkeit“ diese Vortrages, die sich die ganze Zeit darüber wunderten, dass Edenhofer mit keiner Silbe auf die nunmehr seit 18 Jahren veränderte Klimarealität einging, in der die globale Mitteltemperatur nicht mehr ansteigt, nicht erwähnte, dass weder die Zahl der Stürme, noch Überschwemmungen noch Dürren und andere Unbill zugenommen haben, der Meeressspiegel so wenig wie eh und je ansteigt und weder Arktis noch Antarktis noch Grönland an übermäßiger Eisschmelze leiden, sondern immer wieder darauf beharrte, dass seine Modelle genau solch schreckliches Ungemach zeigten, und seine Wirtschaftsmodelle diese Lösungswege wiesen, sondern auch bei denjenigen, und das war wohl die übergroße Mehrheit im Saal, die ihm bis dahin gebannt gefolgt waren.

Auch bei diesen ergab sich Unglauben, wie man denn wohl die OPEC Potentaten zwingen könne, ihr Öl oder Gas in der Erde zu lassen, auch wenn man sie mit großen Summen – aus Emissionshandelsgeldern- zu überzeugen versuchte. „Traumtänzer“ war einer der Ausdrücke, der gelegentlich aus dem Publikum zu hören war.

Bezeichnend für den Zustand der Wissenschaft hierzulande, dass solche Leute wie der Vortragende, sich anmaßen den Schlüssel für unsere Zukunft in der Hand zu halten und das mit Steuergeldern finanzierte Institutionen wie die URANIA und die Leibnitz Institute ihnen Wirkmöglichkeiten und internationale Plattformen an vorderster Front ermöglichen, um ihre wirren Ideologien vorzutragen.

Aufgrund der Überlänge des Vortrages wurden kaum Fragen und schon gar keine Statements zugelassen. Das Einladungsversprechen „Vortrag mit anschließender Diskussion“ wurde einmal mehr nicht eingehalten.

1. [1] Quelle Wikipedia Ignatius von Loyola: Die Exerzitien. 13. Auflage. Johannes Verlag Einsiedeln, Freiburg 2005, ISBN 3-89411-028-7, Randziffer 365.

[2] An dieser Stelle ist es angebracht meiner Verwunderung über das fast göttliche Wirken der Modellierer Ausdruck zu geben, die es irgendwie schaffen, immer ganz runde Zahlen, sozusagen als Quintessenz ihrer Berechnungen, zu erfinden. Zwei Grad Ziel, 1000 Gigatonnen CO2 und viele andere – immer schön rund. Ist da evtl. göttlicher Wille am Werk, dass die Natur auf unsere politische Kampagnenfähigkeit Rücksicht nimmt?