Wie Umweltorganisationen die Umwelt zerstören

„Aber – und das habe ich Tom und seiner Frau Kate Taylor sowie einigen anderen gegenüber erwähnt – die Politik dazu ist schwierig [tough]“, fügte Obama hinzu, jedenfalls einem Schriftstück des Weißen Hauses zufolge. „Nur weil man ein Jahrzehnt lang keinen Anstieg beobachtet hat … wenn dein Haus immer noch mit 25000, 35000 Dollar in der Kreide steht, wirst du dir vielleicht Sorgen um die Temperatur des Planeten machen, aber das wird vermutlich nicht an oberster Stelle deiner Sorgen stehen. Und wenn die Leute glauben, dass das – nun – kurzsichtig ist, dann passiert das eben, wenn man versucht zurechtzukommen“.

Ich liebe Obamas Beschreibung ökonomischer Schwierigkeiten, wenn er sie mit den Worten charakterisiert „…wenn dein Haus in der Kreide steht…“ – in meiner Umgebung ist das etwas, das wohlwollend als ein „Problem der Ersten Welt“ bekannt ist. Aber das beschreibt sehr gut die enge Beziehung zwischen dem ökonomisch Wünschenswerten und fehlendem Umweltbewusstsein, selbst unter Menschen mit viel Geld.

In diesem Beitrag werde ich die Verbindung zwischen dem CO2-Alarmismus und Umweltzerstörung behandeln und wie die Arbeit der großen Nicht-Regierungs-Umweltorganisationen (NGOs) wie Greenpeace und der WWF aktiv die Umwelt schädigen.

Beginnen möchte ich mit den beiden wichtigsten Tatsachen in der Diskussion um die globale Umwelt. Erstens, die Hälfte aller Menschen auf diesem Planeten lebt von weniger als 2 Dollar pro Tag. Darum habe ich die Verschuldung des Grundeigentums ein „Problem der Ersten Welt“ bezeichnet. Menschen, die von 2 Dollar pro Tag leben, haben keine Schulden auf Privathäusern – die meisten davon haben kein Haus oder viel mehr als ein paar Lumpen Kleidung.

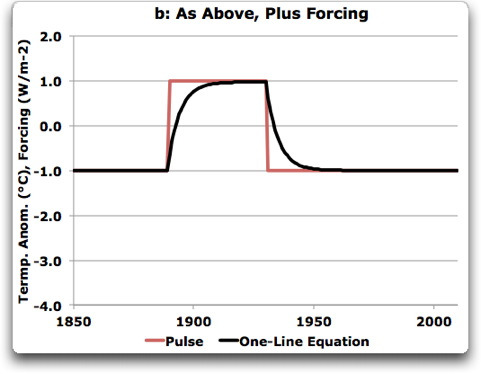

Abbildung 1 [oben rechts]: Grenze zwischen Haiti und der Dominikanischen Republik. Raten Sie mal, in welchem Land die Öko-Kriminellen zu hause sind, die es sich leisten können, fossile Treibstoffe zu verbrauchen, und in welchem Land die Naturliebhaber wohnen, die von natürlicher, erneuerbarer organischer Biomasse zur Energieerzeugung abhängig sind…

Zweitens: nur entwickelte Länder haben jemals ihre Umwelt in Ordnung gebracht. Nur wenn die Bewohner eines Landes angemessen ernährt und gekleidet und geschützt vor den Unbilden des Wetters sind, können sie es sich leisten, sich über die Umwelt Gedanken zu machen. Und weit davon entfernt, die Umwelt in Ordnung zu bringen, wie es sich wohlhabende Länder leisten können, wirken die Menschen in armen Ländern sehr zerstörerisch auf die Umwelt. Menschen in armen Ländern werden jeden Baum verbrennen, wenn das notwendig ist, und das würden Sie auch, wenn Ihre Kinder schreien. Sie werden jeden Affen essen und am Ende auch die Schimpansen verspeisen, und das würden Sie auch, wenn Ihre Familie am Verhungern wäre. Sie werden die Notwendigkeit beklagen, sie mögen es genauso wenig wie Sie oder ich … aber sie werden es tun. Im Bild oben rechts sieht man die Grenze zwischen Haiti und der Dominikanischen Republik:

Angesichts der Tatsache, dass Armut die größte Bedrohung der globalen Umwelt ist, lautet die unvermeidliche Schlussfolgerung, dass der einzige Weg, der globalen Umwelt eine Chance zu geben, darin besteht, dass sich arme Länder wirtschaftlich entwickeln können.

Und genau deswegen ist die Anti-Entwicklungs-Haltung und Pro-teure-Energie-Politik der großen Umwelt-NGOs eine der großen Umwelttragödien unserer Zeit.

Die Kausalkette sieht so aus:

1. Die Klimaalarmisten haben mit starker Unterstützung großer Umwelt-NGOs wie Greenpeace und WWF dem CO2 den Krieg erklärt.

2. Die von ihnen gewählte Methode zur Bekämpfung des CO2 war es, den Verbrauch fossiler Treibstoffe unattraktiv zu machen, indem Energie immer teurer gemacht wurde, und zwar mittels einer Kombination von Steuererhöhungen, Gesetzgebungen, internationalem Druck und teuren Subventionen, um dieses Ziel zu erreichen. Der gerade von Obama verkündete Krieg gegen die Kohle ist nur eines von hunderten anderer Beispiele der wohlhabenden NGOs und der reichen Regierungen, die daran arbeiten, Energie immer weiter zu verteuern.

3. Da Energie gleich Entwicklung ist, hält teure Energie die armen Länder in Armut. Wenn die Weltbank Anleihen für Kohlekraftwerke in Indien ablehnt, leiden die Armen … aber die Umwelt leidet noch mehr. Solange sie es sich nicht leisten können, Kohle und Gas zu verbrauchen, werden sie das Land vom Holz befreien … ich verweise zurück auf die Abbildung oben, wie gut das der Natur tut.

4. Teure Energie verzögert die ökonomische Entwicklung eines Landes, und wie Präsident Obama gesagt hat: Menschen, die sich um ihr Auskommen sorgen, achten nicht auf ihre Umwelt.

Dies führt am Ende zu einer bizarren Lage – die Aktionen der großen Umwelt-NGOs stellen die fortgesetzte Umweltzerstörung in den Entwicklungsländern sicher.

Ich habe die Lektion über den Zusammenhang zwischen Armut und Umweltzerstörung teilweise durch traurige Erfahrungen gelernt. Ich habe meine Unterhaltung mit dem mittellosen Verkäufer von Feuerholz in Costa Rica und seine Art, in Nationalen Wäldern sein Feuerholz zu holen, in meinem Beitrag über den Papageifisch diskutiert. Hier folgt die Story einer längeren und traurigeren Wechselwirkung zwischen Armut und der Umwelt.

Heute lebe ich umgeben von Wäldern, genau wie auch als Kind. Ich habe daraus Kraft gezogen. Mein Stiefvater war Holzfäller, ebenso wie dessen Vater, und ich habe in den Wäldern mitgeholfen [I’ve worked in the woods setting choker]. Ich habe gutes Holz fällen, schlechtes Holzfällen und glatt kriminelles Holzfällen gesehen, und ich war immer leidenschaftlich, wenn es um den Schutz der Wälder ging und um ethische Praktiken des Holz Fällens. Hier sieht man eine Ansicht des Redwood-Waldes aus meinem Fenster, und es regnet immer noch…

Ende der achtziger Jahre war ich ein paar Jahre lang Direktor eines Programms zur Entwicklung der Umwelt auf den Solomon Inseln, so etwas Ähnliches wie „Save the Children“, aber in einem allgemeineren Rahmen. Unter den Projekten unter meiner Leitung war das „Walkabout Sawmill“-Programm. Das war ein voller Erfolg. Anstatt Geld zur Begrenzung von Katastrophenschäden nach einem Zyklon zu verteilen, haben wir ein paar tragbare Sägemühlen von nebenan, also in Papua-Neuguinea gekauft. Wir haben einige Teams geschult, die Sägemühlen zu betreiben, die wir anschließend auf die Dörfer geschickt haben, um die Bäume zu zerlegen, die im Zyklon umgeweht worden waren. Die Dorfbewohner bekamen Holz, unsere Teams lernten den Gebrauch der Sägemühlen. Als das Projekt zu Ende gegangen war, haben wir die Sägemühlen auf Kredit an die Teams verkauft, so dass sie damit in ihren eigenen Heimatländern arbeiten konnten.

Warum war ich froh, ihnen beim Fällen im Wald helfen zu können? Weil ich wusste, dass es der einzigen anderen Option bei Weitem vorzuziehen war, die darin bestand, asiatische Holzfäller-Unternehmen ins Land zu lassen und riesige Landgebiete komplett abzuholzen. Wegen ihrer Armut haben die Bewohner der Solomon-Inseln ihr Erbe verkauft, ihre unglaublich wertvollen tropischen Harthölzer, für ein paar lumpige Pennys.

Und wie hat ihre Armut dazu geführt, dass sie ihren Wald verloren haben? Ich kann diese Frage beantworten.

Wenn ein Land arm ist, kann man alles kaufen.

Viele Jahre lang habe ich Ende der achtziger Jahre auf einem Korallenatoll in der Nähe einer großen Vulkaninsel gewohnt, die die höchst euphemistische Bezeichnung „Vella Lavella“ trug. Das Atoll befand sich in der Westprovinz der Solomon-Inseln. Zu jener Zeit wuchsen auf den Solomonen ausgedehnte tropische Wälder voller wertvoller tropischer Harthölzer. Holzfäller-Unternehmen kamen aus Übersee, zahlten den Bewohnern ein paar Pennys für ihre Stämme, bezahlten die Zollinspektoren und verschifften Ladung für Ladung des Schatzes und des Erbes der Inseln, ihre tropischen Bäume. Also machte es mich glücklich, dass es mir möglich war, den Menschen dort eine Alternative anbieten zu können, nämlich ihre eigenen Wälder zu bewirtschaften und zu erhalten.

Zu jener Zeit unternahm ein malaysisches Unternehmen Schritte, um die Rechte für das Abholzen der Insel Vella Lavella zu bekommen. Einige Leute sagten nein, aber es gab auch Befürworter. Es gibt eine Art lokalen Inselrat, mit etwa fünf „großen Männern“, lokale Führer, die alle Entscheidungen treffen. Die Leute waren leidenschaftlich, wenn es um das Fällen ging, wie man sich vorstellen kann. Der Inselrat trat zusammen, und das Unternehmen hielt seine Präsentation ab. Die großen Männer haben, das sei zu ihrer Ehrenrettung vermerkt, den Antrag abgelehnt.

Also zückte das Unternehmen seine Brieftaschen und kaufte sie gleich vor Ort. Nachdem die Leute gegangen waren, erklärten sie den Rat für immer noch in der Sitzung befindlich, und jetzt stimmten sie der Gewährung der Rechte für das Unternehmen zu. Das einzige Problem dabei war, dass das Ergebnis des ersten Treffens bereits offiziell verkündet worden war.

Natürlich geschah das auf den Solomonen, und die Männer vor Ort waren gänzlich unerfahren in der Kunst des Verbrechens. Sie griffen einfach zu ein wenig Deckweiß und weißten die Passage „keine Fällung“ aus. Dann überschrieben sie mit dieser überarbeiteten Version die ursprüngliche Version.

Als ich das gehört habe, war ich sowohl amüsiert als auch sehr zornig. Also sind einige von uns beim Public Solicitor [so etwas wie ein öffentlicher Anwalt] vorstellig geworden, damit dieser den Fall übernehme. Er war darüber zunächst enthusiastisch – bevor er erkrankte. Am Ende steckte er sich mit der Krankheit an, die viele weiße Kerle in den Tropen befällt; sie kommt in einer Flasche und macht, dass man sich elend fühlt, aber das geschah, bevor er krank geworden ist. Also hat er den Fall auf brillante Art gelöst und dafür gesorgt, dass die Entscheidung nichtig war. Wir haben alle gejubelt und das Gefühl gehabt, dass wir gewonnen hatten.

Als die Entscheidung des Gerichts verkündet worden ist, hat das Holzfäller-Unternehmen das Offensichtliche getan – dieses Mal betrogen sie nach allen Regeln der Kunst. Sie bezahlten die Inselräte, aber diesmal taten sie das vor dem nächsten Treffen. Damit bestand keine Notwendigkeit, die offizielle Verlautbarung zu ändern … ich war schwer geschockt, genau wie meine Freunde vor Ort.

Also gab dieser billige Handel der Inselräte – ich habe gehört, es waren großartige zehn Dollar pro Mann – dem Unternehmen das Recht, mit den Bewohnern von Vella Lavella einen Vertrag auszuhandeln, falls sie den unterschreiben wollten. Eines Nachmittags ließ sich ein junger Bewohner von Vella Lavella auf die Insel übersetzen, auf der ich wohnte, und fragte mich um Hilfe. Ich kaufte drei Biere, und wir unterhielten uns über das Holzfäller-Unternehmen. Er sagte, dass seine Leute agitiert haben, um die Menschen davon zu überzeugen, das Unternehmen außen vor zu lassen und sich selbst um ihre Wälder zu kümmern. Aber das Gefühl der Leute stand gegen sie. Sie wollten das leichte Geld, sich einfach zurücklehnen und das Unternehmen die Arbeit machen lassen.

Also haben sie mich gefragt, ob ich mir den Vertrag mal ansehen und ihnen erklären könnte, was das Unternehmen da von ihnen zu unterschreiben verlangte. Ich sagte, natürlich, und sie übergaben mir eine Kopie des verfluchten Dokuments.

Ich sage Ihnen, ich habe schon so manch einen durchtriebenen und listigen Weg gesehen zu betrügen und jemanden mit einem Füller und einem Blatt Papier zu ködern, aber dieses hier war wie reiner Schwefel. Weiß war darin schwarz, und schwarz war weiß. Skandalöse Dinge waren vorgeschlagen und den Bewohnern als Vorteile weisgemacht worden.

Und die Regeln selbst zum Fällen in dem Vertrag waren bodenlos. Ein 100 Meter breiter Streifen unversehrter Wälder um die Flüsse und Wasserwege wird als Minimum angesehen, um die Gewässer vor der Sedimentation zu bewahren. Das Unternehmen schlug einen 10 Meter breiten Streifen vor und behauptete, dies sei Ausdruck ihrer Sorge um die Umwelt. Auch gab es keinerlei Begrenzung der Menge, die sie fällen durften. Normalerweise schützt man auf steilen Hängen die Bäume, weil Erosion und Erdrutsche so schädlich sind … hier gab es überhaupt keinen Schutz.

Dann gab es da Strafen für Fällungen außerhalb des festgelegten Gebietes … zehn US-Dollar pro Baum. Zu jener Zeit waren die Harthölzer der Solomonen nach der Verarbeitung und Trocknung etwa 1400 US-Dollar pro Festmeter wert, und einige Bäume maßen drei oder mehr Festmeter. Dies bedeutete: wenn die Holzfäller eines wertvollen Baumes ansichtig wurden, der sich nicht auf dem zugelassenen Gebiet befand, konnten sie ihn fällen, den Bewohnern 10 Dollar dafür zahlen und ihn für fünftausend Dollar verkaufen…

Aber das ist längst noch nicht alles. Es gab da nämlich noch das kleine Problem des Preises. Von ihm sagte das Unternehmen, dass es der beste Teil des Vertrages sei. Anderswo auf den Solomonen erhielten die Menschen lediglich drei Dollar pro Festmeter, aber dieses Unternehmen bot aus reiner Menschenliebe nicht weniger als 10 Dollar pro Festmeter an…

Dann waren da noch die Transportwege. Ein gewaltiger Vorteil einer ordentlich durchgeführten Fällaktion ist es, wenn die Menschen am Ende Straßen bekommen, die die Küstendörfer mit dem Landesinneren verbinden.

Das kann aber auch ein großer Fluch sein, denn wenn die Straßen nicht ordentlich entworfen und gebaut sind, werden sie durch die tropischen Regengüsse weggespült. Zurück bleiben offene Schneisen, die Jahre brauchen, um sich wieder zu erholen.

Nun, in diesem Dokument wurde auf all das hingewiesen. Es ging darin um die mannigfaltige Qualität von Straßen, von den Waldwegen im Inneren bis zu den befestigten Straßen entlang der Küste. Es gab seitenlange Spezifikationen der Straßen und liebliche Schwarzweiß-Bilder von asphaltierten Autobahnen zu den tropischen Stränden – mit nur einem kleinen Problem.

Das Dokument beschrieb die Straßen und die Örtlichkeiten ihres Baus und wie gut diese doch wären … aber nirgends in dem gesamten Dokument fand sich tatsächlich das Versprechen, auch nur einen einzigen Meter Straße zu bauen, befestigt oder nicht. Es war alles nur Schall und Rauch; sie haben nichts versprochen.

Also arbeitete ich mich durch das gesamte Dokument und markierte die relevanten Punkte. Dann traf ich mich wieder mit den jungen Leuten, und wir durchforsteten das Ganze gemeinsam, Klausel für Klausel. Ich habe etwa zwei Drittel der Klauseln umgeschrieben; ich habe mit meinem Freund, dem Public Solicitor zusammen gearbeitet, und wir haben ein Dokument erstellt, das wirklich für die Bewohner ein guter Handel sein würde. Die Holzfäller würden immer noch auf ihre Kosten kommen, aber wie Geschäftsleute und nicht wie Straßenräuber.

Es war eine lange Sitzung, die Männer hatten sehr viele Fragen, und wir besprachen jede Klausel einzeln, damit auch jeder verstand, warum ich diese Änderungen vorgenommen hatte und was die Änderungen für sie bedeuten würden. Nach vorhergehenden Diskussionen mit einigen der Männer haben wir auch einen Abschnitt eingefügt, dem zufolge ein Trust eingesetzt werden sollte, der den Großteil des Geldes verwalten sollte, damit nicht alles für Bier und Freizeit ausgegeben und in sechs Monaten verschwunden sein würde. Sie waren sehr einverstanden damit, hatten sie doch früher schon das Geld davon rinnen sehen.

Dann waren sie bereit, sich mit den Repräsentanten des Unternehmens zu treffen. Sie fragten mich, ob ich mit ihnen zu dem Treffen gehen würde. Ich sagte, dass das nicht gehen würde … ein anderer, mir bekannter Ausgebürgerter war mit den Holzfällern einige Monate zuvor aneinandergeraten, und innerhalb einer Woche wurde seine Arbeitserlaubnis einkassiert, und er musste das Land verlassen. Ich konnte nicht riskieren, meine Arbeitserlaubnis zu verlieren, also sagte ich, dass sie das gut auch alleine könnten, schließlich hatten sie verstanden, worum es ging.

Sie fragten, ob sie in einem der Gästehäuser tagen könnten, die ich auf der Insel angemietet habe. Ich sagte, natürlich, kein Problem. Sie konnten das Treffen dort abhalten und die Nacht verbringen und am nächsten Tag nach Vella zurückfahren.

Dann kam die große Nacht des Treffens. Alle kamen, Holzfäller und Inselbewohner. Ich spielte den Gastgeber und ließ sie mit der Diskussion über das Schicksal des Waldes allein.

Und am nächsten Morgen? Alle kamen sie heraus, die Gesichter vor Scham verzogen. Ich sah es mit einem Blick, und mein Herz sank. Ich fragte einen der Alten, einen der Großen, was geschehen war. „Oh, die Männer des Holzfäller-Unternehmens waren sehr nett! Können Sie sich vorstellen, sie schenkten uns eine ganze Kiste voller Black Label Whiskey. Sie erklärten den Vertrag, und es klang wunderbar, also haben wir ihn unterschrieben…“ Oh Mann, mein Blut geriet mächtig in Wallung, und ich lief große Gefahr auszurasten … aber ich kannte den alten Mann, er war kein schlechter Mann, aber ein schwacher. Also biss ich mir auf die Zunge und schüttelte mit dem Kopf und sagte, dass seine Söhne vielleicht noch einen Vorteil davon hätten, aber dass seine Enkel sich fragen würden, warum sie ihr Geburtsrecht für ein paar lumpige Pennys verkauft haben … dann wandte ich mich an die jungen Leute. Sie sagten, dass sie es nicht verhindern konnten. Als die großen Männer einmal betrunken waren, wurden sie streitlustig, hörten auf niemanden mehr und hätten alles unterschrieben.

Zuerst war ich wütend über das Holzfäller-Unternehmen, dass es so schändlich und hinterhältig war, die Bewohner dazu zu bringen, betrunken zu unterschreiben.

Dann dachte ich: “Moment …”. Diese Männer waren keine Indianer, die noch nie in ihrem Leben Feuerwasser probiert hatten. Sie waren alle auch früher schon mal betrunken, möglicherweise sogar in der gleichen Woche. Sie wussten ganz genau, was das für ihre Urteilsfähigkeit bedeutete. Also war ich dann über sie verärgert.

Dann aber dachte ich, nein, sie waren lediglich schwach und eingeschüchtert durch fehlende Bildung und Erfahrung und Geld. Das Unternehmen hatte gebildete, gepflegte und freundliche Leute geschickt, teuer gekleidet und geschmückt mit Gold, großen Ringen und Ketten. Die Großen Männer waren alle gleich gekleidet – kurze Hosen und T-Shirts, bündelweise importiert aus Australien. Mir wurde klar: anstatt mit ihrer vorhersehbaren Unfähigkeit in Konflikt zu geraten, mit den Holzfällern zu verhandeln, haben sie den einfachen Weg gewählt und sich betrunken.

Dann ärgerte ich mich über die jungen Leute, weil sie nicht mehr Widerstand gezeigt hatten … das dauerte lange genug, um sich klarzumachen, dass man unter den unverbrüchlichen Stammesgewohnheiten von ihnen erwartete und sie zwang, ihren Alten zu gehorchen, genauso wie sie es von ihren Jungen verlangen würden, wenn sie wirklich alt geworden sind … sagen wir mal fünfzig Jahre … das Leben ist kurz hier.

Es dauerte eine Weile, aber dann kam ich letztendlich doch zu der Schlussfolgerung, dass diese Menschen immer Gefahr laufen würden, Opfer dieser Art von habgierigen und amoralischen Männergruppen zu werden, die schon immer unter uns waren – solange sie nicht angemessen ernährt und gekleidet sind oder über bequemen Wohnraum verfügten…

Und am Ende des Tages war mir klar geworden, dass ich ein Narr gewesen war. Oh, ich würde diesen Kampf immer wieder kämpfen, aber ich würde immer wieder verlieren. Es ist das, was passiert, wenn das große Geld auf ein armes Land trifft – die Umwelt wird zerstört, egal ob es um Holzfällen, angeln oder Bergbau geht. Solange ein Land nicht wohlhabend genug ist, seine Bewohner zu ernähren und sich selbst zu schützen, werden dessen Ressourcen immer meistbietend zu verkaufen sein … dabei meine ich mit den Meistbietenden diejenigen mit der geringsten Moral.

Nun habe ich diese ganze Geschichte aus einem bestimmten Grund erzählt, nämlich um zu erhärten, welchen Schaden Armut an der Umwelt anrichtet. Wenn man einen Inselrat für zehn Dollar pro Mann kaufen kann und buchstäblich Millionen Dollar auf dem Spiel stehen, wird dieser Rat sich kaufen lassen, egal wie sehr ich dagegen ankämpfen würde. Das Bruttosozialprodukt auf den Solomonen beträgt pro Jahr etwa 600 Dollar; das Land wird als „LDC“ gelistet, also als Least Developed Country … und in einem Land, in dem zwanzigtausend Dollar das Gehalt von fast zwanzig Jahren ist, kann man viele Menschen für zehn Große kaufen…

Das ist einer der Hauptgründe, warum ich viel Zeit damit verbracht habe, in Übersee zu arbeiten in dem Versuch, die globale Armut abzumildern. Zuerst mache ich das für die Menschen, gleich danach aber für die Umwelt.

Und darum fühle ich mich so persönlich betrogen durch den gegenwärtigen geistlosen Anschub zu teurer Energie, ein Anschub durch genau jene Organisationen, die ich früher auch mal unterstützt habe, weil sie damals vermeintlich für die Umwelt eingetreten waren, nicht dagegen. Die Erhöhung der Energiepreise ist die regressivste Besteuerung, die ich kenne. Je ärmer man ist, umso härter wird man durch steigende Energiepreise betroffen, und je mehr die Armen leiden, umso mehr trägt die Umwelt den Schaden davon.

Hier also habe ich angesetzt zu erklären, warum Menschen, die CO2 bekämpfen, die Umwelt schädigen. Ich möchte die Glieder der Kette noch einmal wiederholen:

1. Teilweise angeführt von den NGOs haben viele Menschen und Regierungen dem CO2 den Krieg erklärt.

2. Ihre bevorzugte Methode der Kriegführung ist die Erhöhung der Energiepreise, und zwar durch Subventionen, Steuern, Verbote, Gesetze zur Nutzung von Erneuerbaren, die Ablehnung von Pipeline-Projekten und so weiter.

3. Der Anstieg der Energiepreise verarmt die Ärmsten noch weiter und verhindert die Entwicklung armer Länder.

4. Wie Obama gesagt hat, selbst wohlhabende Menschen mit ökonomischen Sorgen tendieren dazu, die Umwelt zu ignorieren … also ist das Herumtrampeln auf den Entwicklungsmöglichkeiten armer Länder durch das Anheben der Energiepreise eine Garantie für Jahre lange Umweltzerstörung.

Ich sage, dass die Geschichte nicht freundlich auf diese Menschen und Organisationen schauen wird, die gegenwärtig die Armen weiter verarmen und die Umwelt schädigen in einem aussichtslosen und nutzlosen Kampf gegen CO2, selbst wenn die Täter wohlhabend sind und es ihnen an Melanin mangelt, und wenn sie angeblich nur mit besten Absichten handeln…

Meine Grüße an alle von Ihnen – und führen Sie den guten Kampf fort!

Willis Eschenbach

AKTUALISIERUNG: Für all jene, die ein wenig mehr Informationen über die Verbindungen zwischen Armut und Umwelt haben möchten, die zum Foto in der Abbildung oben rechts geführt haben: Im Jahr 1960 hatten Haiti und die Dominikanische Republik (DR) etwa ein gleich hohes Bruttoinlandsprodukt (GDP). Die klimatischen und physikalischen Bedingungen waren ebenfalls gleich, teilten sich beide Länder doch die gleiche Insel.

Bis zum Jahr 2012 jedoch ist das GDP in der DR auf etwa 9600 Dollar pro Jahr gestiegen, während es in Haiti auf etwa 1200 Dollar gesunken ist, also niedriger lag als im Jahr 1960. Und als Folge dessen, dass die Haitianer fast überhaupt kein Geld haben und nur ein Achtel des GDP der DR, haben sowohl die Menschen als auch die Umwelt in Haiti schwer gelitten.

Nur so zum Vergleich: In Norwegen beträgt das Bruttosozialprodukt etwa 60000 Dollar und in den USA etwa 49000 Dollar. Am anderen Ende der Skala stehen die Solomon-Inseln, von der UN klassifiziert als eines der „Least Developed Countries“. Dort beträgt das Bruttosozialprodukt etwa das Doppelte wie in Haiti (und ein Viertel desjenigen in der DR), also etwa 2500 Dollar.

Willis Eschenbach

2. AKTUALISIERUNG von Anthony Watts: Ich wollte eine unabhängige Bestätigung des Photos in der Abbildung oben rechts einholen, weil auf dem Photo vielleicht nur ein kleiner, nicht repräsentativer Ausschnitt abgebildet sein könnte. Also habe ich das mittels Google Earth mal untersucht. Zwar sieht es nicht an der gesamten Grenze zwischen Haiti und der Dominikanischen Republik so aus wie in der Abbildung oben, doch gibt es weite Gebiete im nördlichen Teil, die dieses Phänomen zeigen, zum Beispiel:

Anthony Watts

Link: http://wattsupwiththat.com/2013/06/25/how-environmental-organizations-are-destroying-the-environment/

Übersetzt von Chris Frey EIKE