Vom Unsinn der Klimasensivität CS im IPCC Bericht AR5

Dr. Kiehl’s Paradoxon

Im Jahre 2007 wies Jeffrey Kiehl in einem im GRL veröffentlichten Papier mit dem Titel “Twentieth century climate Modell response and Climate Sensitivity” auf ein sonderbares Paradoxon hin. Alle von den verschiedenen Forschergruppen betriebenen Klimamodellle konnten die historischen Temperaturen an der Erdoberfläche ganz vernünftig nachbilden. Aus dieser Übereinstimmung wurde von Leuten wie z. B. im IPCC viel Aufhebens gemacht. Nach deren Ansicht ist das der Beleg, dass die Modellle stimmen, dass sie die natürlich gegebene Wirklichkeit abbilden.

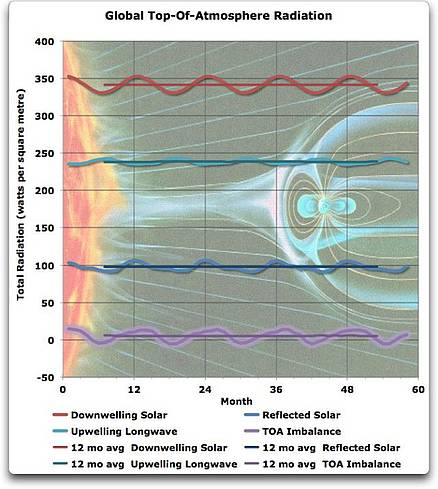

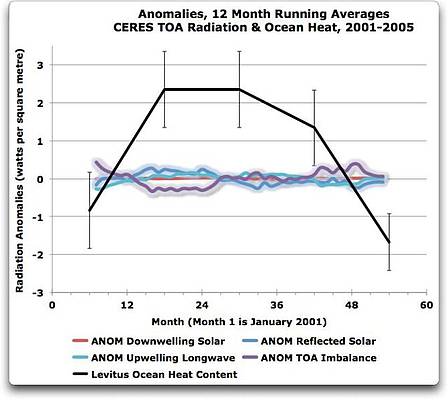

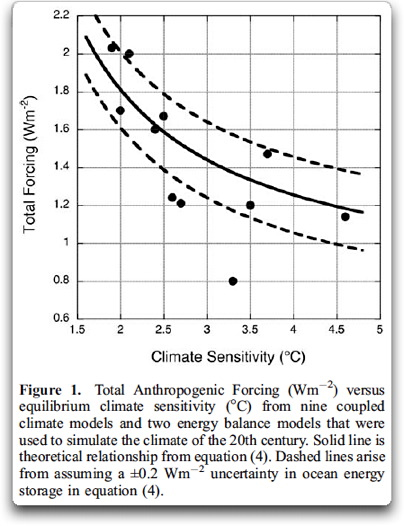

Fig. 1. Kiehls Ergebnis beim Vergleich der Klimasensitivität (ECS) mit allen Antrieben.

Das Paradoxon besteht darin, dass alle Modellle eine stark unterschiedliche Klimasensitivität zeigen, aber dass sie alle in etwa zum gleichen Ergebnis kommen … was stimmt da nicht? Und so schrieb Kiehl in seinem Papier:

[4] Ein sonderbarer Aspekt dieses Ergebnisses ist, dass es allgemein bekannt ist [Houghton et al., 2001], dass die gleichen Modellle, die bei der Simulation der Anomalien bei den Temperaturen an der Erdoberfläche übereinstimmen, signifikant bei der vorhergesagten Klimasensitivität voneinander abweichen. Die angegebene Spannweite bei der Klimasensitivität aus einer großen Anzahl von Modellen reicht normalerweise bei einer Verdoppelung des CO2 von 1.5 bis 4.5C, wobei die meisten der für die Klimawandel-Studien benutzten globalen Klimamodelle wenigstens um den Faktor Zwei beim Gleichgewicht der Klimsensitivität voneinander abweichen.

[5] Die Frage ist: wenn die KlimaModellle sich um einen Faktor von 2 bis 3 in der Klimasensitivität unterscheiden, wieso können sie alle die globalen Temperatur-Aufzeichnungen in einem vernünftigen Genauigkeitsgrad nachbilden?

Kann es so etwas geben? Die Modellle haben stark unterschiedliche Sensitivitäten … aber sie können alle die historischenTemperaturgänge wiedergeben? Wie ist das möglich?

Die Antwort schieben wir zunächst auf, zuerst hier die Antwort von Kiehl (Hervorhebung vom Verfasser):

Man hat herausgefunden, dass der anthropogene Gesamtantrieb bei sehr vielen Klimamodellen sich um den Faktor Zwei unterscheidet und dass der Gesamtantrieb umgekehrt zur Klimasensitivität korreliert ist.

Irgendwie macht das Sinn, weil, wenn der Gesamtantrieb größer ist, man ihn stärker vermindern (geringere Sensitivität) muss, um beim Temperaturgang zu einer Darstellung zu gelangen, die zur historischen Aufzeichnung passt. Kiehl hat aber trotzdem nicht recht.

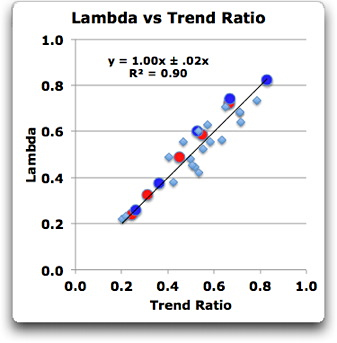

Meine eigene Forschung im Beitrag Climate Sensitivity Deconstructed vom Juni dieses Jahre hat gezeigt, dass der entscheidende Faktor nicht der Gesamtantrieb ist, wie Kiehl vermutete. Ich habe herausgefunden, dass die Klimasensitivität der Modellle sehr genau durch ein einfaches Trendverhältnis emuliert wird – Trend des Antriebs geteilt durch den Trend des Modell-Outputs.

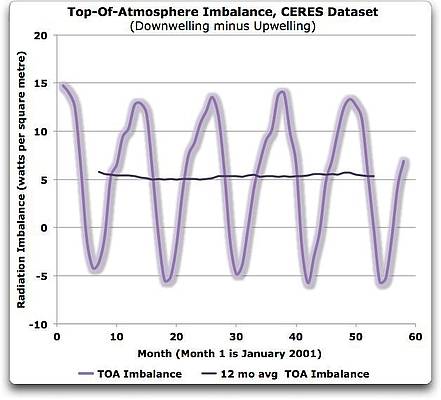

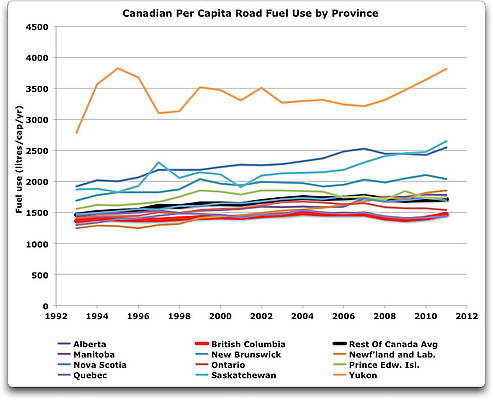

Fig. 2. Lambda verglichen mit dem Trend-Verhältnis. Rot zeigt die transiente Klimasensitivität (TCR) von vier Modellen plus einen 19-Modelle-Durchschnitt. Dunkelblau zeigt das Gleichgewicht der Klimasensitivität (ECS) der gleichen Modelle. Hellblau ist das Ergebnis aus den Antriebs-Datensätzen, wie sie sich aus tatsächlichen historischen Temperatur-Datensätzen ergeben.

Man sieht, dass Kiehls Fehler bei der Erkennung der Ursache der Veränderungen naheliegend ist. Erstens sind die Outputs der Modelle alle ziemlich ähnlich dem historischen Temperaturverlauf. Deswegen konnte Kiehl den Modell-Output vernachlässigen, was die Frage vereinfacht, aber die Ungenauigkeit vergrößert. Zweitens ist der Gesamtantrieb eine Anomalie, die bei Null anfängt am Beginn der historischen Rekonstruktion. Im Ergebnis ist der Gesamtantrieb irgendwie proportional zum Trend des Antriebs. Und das vergrößert auch noch die Ungenauigkeit. Aber bevor ich das Paradoxon löse und zugleich als Erster, der darüber schreibt, möchte ich Dr. Kiehl meine hohe Anerkennung zollen.

Ich hätte eigentlich nicht davon überrascht sein sollen, dass die Sensitivität wie von den Modellen errechnet, nichts anderes als das Trend-Verhältnis ist. Schließlich ist die kanonische Gleichung des herrschenden Klima-Paradigmas, dass der Antrieb direkt mittels der Klimasensitivität (lambda) auf die Temperatur bezogen ist. So ausgedrückt:

Temperaturänderung (∆T) = Klimasensitivität (lambda) mal Veränderung im Antrieb (∆F), oder kürzer,

∆T = lambda ∆F

Das impliziert natürlich

lambda = ∆T / ∆F

Und der Ausdruck auf der rechten Seite ist nichts anderes als das Verhältnis der Trends.

Wir sehen also, dass, wenn wir uns für einen speziellen Antriebs-Datensatz für das Modell entschieden und dazu einen historischen Datensatz festgelegt haben, der Output passen wird, und damit haben wir die Klimasensitivität hineingepackt. Jetzt brauchen wir nicht einmal mehr das Modell, um sie zu berechnen. Es ist das Trend-Verhältnis – der Trend des historischen Temperatur-Datensatzes geteilt durch den Trend des Antriebs-Datensatzes. Das ergibt sich zwangsläufig aus der Definition.

Damit haben wir die vollständige Erklärung, warum nach jahrelang und immer wieder verbesserten Computer-Modelllen diese Modellle in immer besserer Genauigkeit und Komplexität die Vergangenheit rückwärts gerichtet voraussagen können … aber bei der Klimasensitivität immer noch nicht übereinstimmen.

Der Grund liegt darin, dass die Klimasensitivität überhaupt nichts mit den Modelllen zu tun hat, aber alles mit den Trends bei den Inputs für die Modellle (Antriebe) und den Outputs (Nach-Berechnungen historischer Temperaturverläufe).

Um es zusammenzufassen, wie Dr. Kiehl vermutete, sind die Variationen in der Klimasensitivität, so wie sie die Modelle ausgeben, nur auf die Unterschiede in den Trend-Differenzen zwischen den von den unterschiedlichen Modellen benutzten Antriebe und den Trends der Outputs zurückzuführen.

Angesichts dessen habe ich laut lachen müssen, als ich den jüngsten UNO-IPCC- Mischmasch von Wissenschaft, Glauben und Pseudo-Wissenschaft durchstudierte, der auch Fünfter Zustandsbericht heißt (AR5). Man halte sich vor Augen, dass das Folgende, wie der Name sagt, von einem Ausschuss von Regierungen kommt, nicht von Wissenschaftlern:

Die Spannweite der Modelle reicht beim Gleichgewicht der Klimasensitivität von 2.1°C bis 4.7°C, und das ist sehr ähnlich wie schon beim AR4. Es besteht sehr hohes Vertrauen, dass der zur Spreizung des Gleichgewichts der Klimasensitivität beitragende Primärfaktor das Feedback der Wolken ist. Das gilt sowohl für das moderne Klima wie für das Maximum der vergangenen Eiszeit.

Ich musste lachen, obschon mir zum Weinen war. … Die IPCC-ler verstehen wirklich überhaupt nicht, was sie machen. Wie können sie “sehr hohes Vertrauen” (95%) haben, dass die Ursache der “Wolken-Feedback” ist, wenn sie an anderer Stelle zugeben, dass sie die Wirkung der Wolken überhaupt nicht verstehen? So schreiben sie über die Beobachtungen von Wolken und deren Wirkungen und viel weniger darüber, was sie in den Modellen damit machen:

• Beträchtliche Ungewissheit und daher niedriges Vertrauen betrifft die Beobachtungen der Wolkenveränderlichkeit im globalen Ausmaß und den Trends. {2.5.7}

• Es besteht geringes Vertrauen, dass ein globaler Trend bei Trockenperioden oder Niederschlagsarmut beobachtet wurde, weil es keine direkte Beobachtungen gibt und methodische Unsicherheiten bei der Auswahl und geographische Inkonsistenzen bei den Trends. {2.6.2}

• Es besteht geringes Vertrauen, dass berichtete Langzeit-Veränderungen (über Jahrhunderte) bei den Eigenschaften der Tropischen Zyklonen robust sind, wenn man die jüngeren Veränderungen der Beobachtungsmöglichkeiten in Betracht zieht. {2.6.3}

Ich muss schon sagen, ich für meinen Teil habe “sehr geringes” Vertrauen in die Beurteilungen der Grade des Vertrauens durch das IPCC in allen Dokumenten …

Wie dem auch sei, liebe IPCC-ler, die Spannweite der Modell-Sensitivität kann nicht auf die zugegebenermaßen schwächlich modellierten Wirkungen der Wolken zurückgeführt werden. Sie hat auch rein garnichts damit zu tun, wie die Modelle im Inneren ablaufen. Die Klimasensitivität ist eine Funktion der Auswahl der Antriebe und dem gewünschten Output (dem historischen Temperaturgang), und sonst nichts.

Unter Berücksichtigung des Mangels an Verständnis auf seiten der Regierungen kann das noch ein langer Kampf bergauf werden. … Aber ich weiß ja nichts Besseres zu tun.

w.

Nachsatz vom Verfasser: Ich halte die ganze Vorstellung von einer “Klimasensitivität” für bedeutungslos im Kontext von natürlichen thermoregulierten Systemen, wie das Klima eins ist. In derartigen Systemen wird eine Zunahme in einem Teilbereich von einer Abnahme in einem anderen Teilbereich oder über einen längeren Zeitraum konterkariert. Hierzu verweise ich auf meine Beiträge It’s Not About Feedback und Emergent Climate Phenomena als Diskussionsbeiträge.

Übersetzung: Helmut Jäger, EIKE