Mathematisch wird das zu

∆T = lambda ∆F

wobei T die globale Mitteltemperatur ist, F ist der Gesamtantrieb an der Obergrenze der Atmosphäre TOA und lambda wird „Klimasensitivität“ genannt.

Mit andere Worten, die Idee ist, dass die Änderung der Temperatur eine lineare Funktion der Änderung des Antriebs an der TOA ist. Ich selbst bezweifle das stark, denn ich glaube nicht, dass die Welt so einfach gestrickt ist. Aber die Hypothese der Linearität macht die Berechnungen so einfach, dass die Leute es einfach nicht fertigbringen, sich davon zu lösen.

Nun wissen die Leute natürlich, dass das nicht wirklich linear ist, aber wenn ich darauf hinweise, kommt oftmals die Behauptung, dass es im interessierenden Bereich nahe genug an Linearität ist, dass wir Linearität annehmen können mit einem kleinen Fehler.

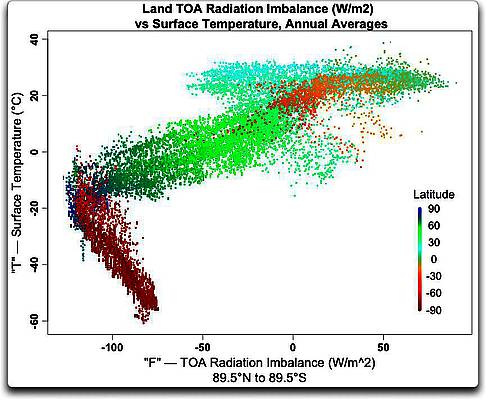

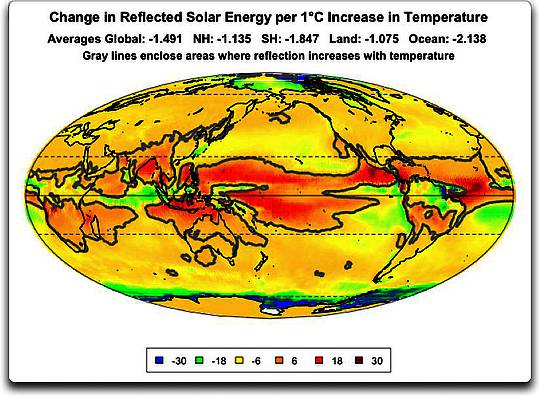

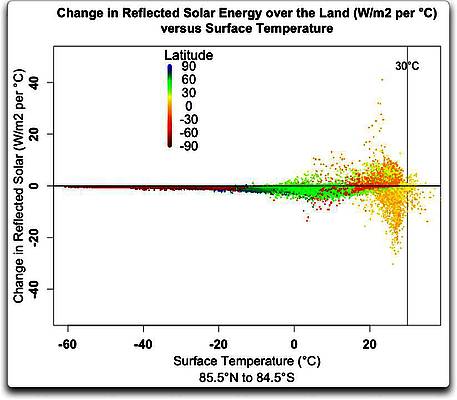

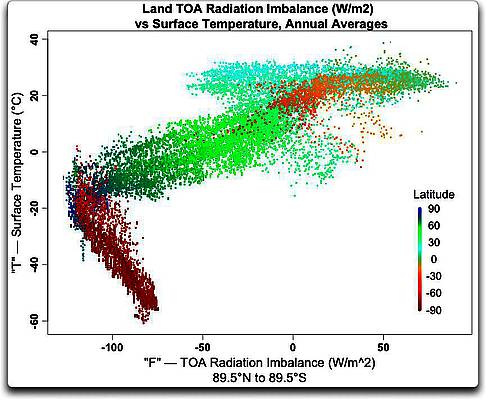

Um zu sehen, ob die Beziehungen wirklich linear sind, dachte ich mir, die CERES-Satellitendaten zu nutzen, um die Temperatur T und den Antrieb an der TOA F zu vergleichen. Diese Graphik zeigt Abbildung 1:

Abbildung 1: Festland allein, Antrieb F (Strahlungs-Ungleichgewicht an der TOA) und Temperatur T auf einem Gitternetz 1° mal 1°. Man beachte, dass zwischen 50°S und 65°S kaum Festland vorhanden ist. Der Gesamtantrieb an der TOA wird berechnet als einfallende Sonnenstrahlung minus langwellige Ausstrahlung.

Wie man sehen kann, gibt es überall eine Beziehung zwischen Antrieb an der TOA und der Temperatur, also alles andere als linear. Bei den niedrigsten Temperaturen sind sie umgekehrt korreliert. In der Mitte gibt es einen klaren Trend … aber dann, bei den höchsten Temperaturen, entkoppeln sie sich voneinander, und es gibt praktisch keine Korrelation mehr.

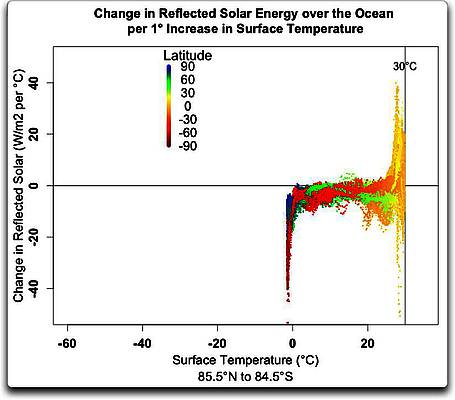

Über den Ozeanen ist die Lage irgendwie einfacher, obwohl wir auch dort große Variationen finden:

Abbildung 2: Ozean allein, Gesamtantrieb F gegen Temperatur T in einem Gitternetz 1° mal 1°. Die Farben indizieren die Breite.

Während die Änderungen nicht so extrem sind wie auf dem Festland, ist die Beziehung auch hier alles andere als linear. Im Besonderen beachte man, wie sich die Daten am oberen Ende der Karte mit zunehmendem Antrieb immer mehr nach rechts neigen. Das ist ein klarer Hinweis, dass die Klimasensitivität bei steigender Temperatur abnimmt. Man braucht mehr und immer mehr Energie, um die Temperatur ein weiteres Grad steigen zu lassen, und daher verläuft die Kurve oben rechts praktisch flach.

Am wärmsten Ende gibt es eine ziemlich starke Grenze der Oberflächentemperatur des Ozeans, die gerade etwas über 30°C liegt. (im Vorübergehen: Ich bemerke, dass es auch eine ziemlich starke Grenze der Oberflächentemperatur über dem Festland gibt, und zwar etwa auf dem gleichen Niveau um 30°C. Komischerweise wird diese Landtemperatur erreicht bei jährlichen mittleren Ungleichgewichten der Strahlung an der TOA, die von -50 W/m² bis +50 W/m² reicht).

Was ich oben gezeigt habe, sind die jährlichen Mittelwerte. Zusätzlich zu diesen sind wir jedoch auch an lambda interessiert, also an der Klimasensitivität, die diese Abbildungen nicht zeigen. Dem IPCC zufolge liegt die Gleichgewichts-Klimasensitivität irgendwo im Bereich 1,5°C bis 4,5°C bei jeder Verdoppelung des CO2-Gehaltes. Nun gibt es aber viele Arten der Sensitivität, darunter monatliche, dekadische und Gleichgewichts-Klimasensitivitäten.

Monatliche Sensitivität

Die monatliche Klimasensitivität tritt ein, wenn das Antriebs-Ungleichgewicht an der TOA in einer gegebenen Gitterzelle von 1° mal 1° von – sagen wir – plus 50 W/m² (Energie hinzugefügt) in einem Monat auf minus 50 W/m² im nächsten Monat sinkt (Energieverlust) Natürlich führt dies zu einem korrespondierenden Unterschied der Temperatur dieser beiden Monate. Die monatliche Klimasensitivität sagt, wie stark sich die Temperatur ändert bei einer gegebenen Änderung des Antriebs an der TOA.

Aber das Festland und die Ozeane können sich nicht augenblicklich ändern. Es gibt eine Verzögerung bei diesem Prozess. Daher ist die monatliche Klimasensitivität die kleinste der drei, weil die Temperatur keine Zeit hatte, sich zu ändern. Abbildung 3 zeigt die monatlichen Klimasensitivitäten, basierend auf den monatlichen CERES-Daten.

Abbildung 3: Die monatliche Klimasensitivität

Wie man erwarten kann, ändern sich die Ozeantemperaturen bei einer gegebenen Änderung des Antriebs weniger stark als die Landtemperaturen. Das liegt an der größeren Wärmemenge [thermal mass] der Ozeane über alle Zeiträume zusammen mit der größeren spezifischen Wärme von Wasser im Vergleich zu Erde und der größeren Verdunstung über den Ozeanen.

Dekadische Sensitivität

Die dekadische Sensitivität, auch Transient Climate response TCR genannt [?], ist die Änderung, die wir im Zeitraum von Jahrzehnten erkennen. Da die Temperaturänderung umso geringer ist, je länger die Verzögerung ist, können wir die Größe der Verzögerung benutzen, um die TCR aus der monatlichen Klimareaktion zu berechnen. Die Verzögerung über Land mittelt sich zu 0,85 Monaten und über den Ozeanen zu länger als 2,0 Monaten. Für das Festland gilt, dass die TCR im Mittel 1,6 mal so groß ist wie die monatliche Klimasensitivität. Die ozeanische Anpassung der TCR ist natürlich größer, weil die Verzögerung länger ist. Die ozeanische TCR ist im Mittel 2,8 mal größer als die monatliche Ozean-Klimasensitivität.

[Im Anhang führt Eschenbach diese Berechnung durch. Interessierte halten sich bitte an das Original, weil ich diesen Anhang nicht mit übersetzt habe. A. d. Übers.]

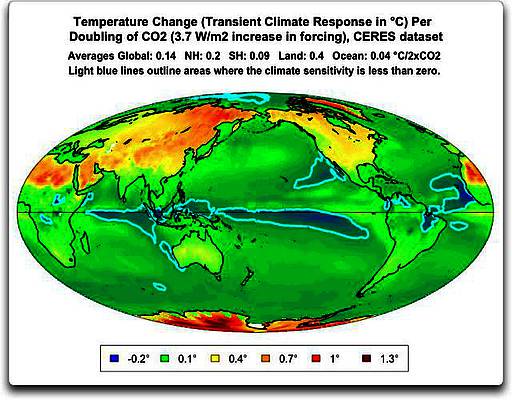

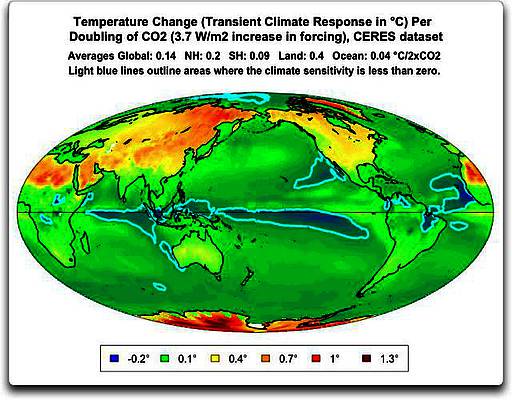

Abbildung 4 zeigt, was passiert, wenn wir die Informationen aus der Verzögerung zusammen mit der monatlichen Klimasensitivität betrachten. Sie zeigt für jedes Gitterquadrat die dekadische Klimasensitivität oder die TCR. Ausgedrückt wird das Ganze in Grad C bei einer Verdoppelung des CO2-Gehaltes (was das Gleiche ist wie Grad pro Zunahme des Antriebs um 3,7 W/m²). Die in Abbildung 4 gezeigte TCR enthält auch die Anpassungen für die Verzögerung auf einer Basis von Gitterzelle für Gitterzelle.

Abbildung 4: Transient Climate Response TCR. Sie wird berechnet aus der monatlichen Klimasensitivität für jedes Gitterquadrat und multipliziert mit dem für dieses Gitterquadrat berechneten Verzögerungsfaktor.

Es gibt einige interessante Dinge in der Abbildung 3. Eine davon ist: wenn man einmal die Verzögerung in Betracht zieht, verschwindet Einiges des Unterschieds der Klimasensitivität zwischen Festland und Ozean, und einiges davon ist verändert. Vor allem zeigt sich dies in der Südhemisphäre; man vergleiche Südafrika oder Australien in den Abbildungen 3 und 4.

Außerdem, wie man auch hier wieder sieht, regiert das Wasser. Entfernen wir den Effekt der Verzögerung, treten die trockeneren Gebiete klar hervor, und das sind auch die Stellen mit der größten Sensitivität auf Änderungen des Strahlungsantriebs an der TOA. Das ist verständlich, weil kaum Wasser für die Verdunstung zur Verfügung steht. Daher sorgt die meiste Energie für die Erwärmung des Systems. Nassere tropische Gebiete andererseits reagieren viel ähnlicher dem Ozean mit weniger Sensitivität hinsichtlich einer gegebenen Änderung des TCR-Antriebs.

Gleichgewichts-Sensitivität

Die Gleichgewichts-Sensitivität ECS, die langfristigste Art der Sensitivität, ist das, was theoretisch passieren würde, wenn einmal die verschiedenen Wärmereservoire ihre Gleichgewichts-Temperatur erreicht haben. Der Studie von Otto mit aktuellen Beobachtungen zufolge lag die ECR [ECS? Schreibfehler des Autors?] gleichbleibend bei etwa 130% der TCR. Andererseits zeigt die Studie von Forster, dass die untersuchten 19 Klimamodelle eine ECR [ECS?], die von 110% bis 240% der TCR reichte mit einem Mittelwert bei 180%.

Damit kann man jetzt die globale mittlere Sensitivität berechnen. Falls wir die Modell-Prozentwerte zur Schätzung der ECS aus der TCR verwenden, ergibt dies ein ECS von 0.14 * 1.1 bis 0.14 *2.4. Dies impliziert eine Gleichgewichts-Klimasensitivität im Bereich 0,2 bis 0,3°C pro CO2-Verdoppelung, mit einem wahrscheinlichsten Wert (der Modelle) von 0,25°C pro Verdoppelung. Falls wir die 130%-Schätzung der Studie von Otto verwenden, bekommen wir ein sehr ähnliches Ergebnis, nämlich 0, 14 * 1.3 = 0.2 °C pro Verdoppelung.

Das ist klein genug, um im Rauschen unseres besonders rauschstarken Klimasystem verloren zu gehen.

Eine abschließende Bemerkung zu Linearität. Man erinnere sich, wir begannen mit der Behauptung, dass die Änderung der Temperatur gleich ist der Änderung des Antriebs multipliziert mit einer Konstante, die man „Klimasensitivität“ nennt. Mathematisch wird das zu

∆T = lambda ∆F

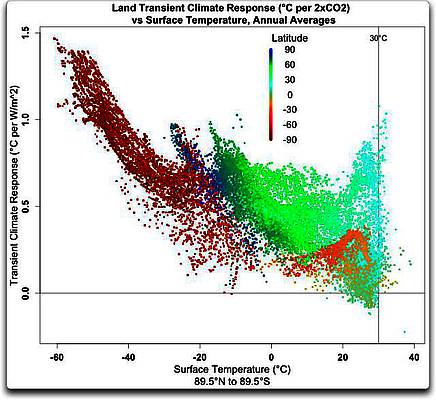

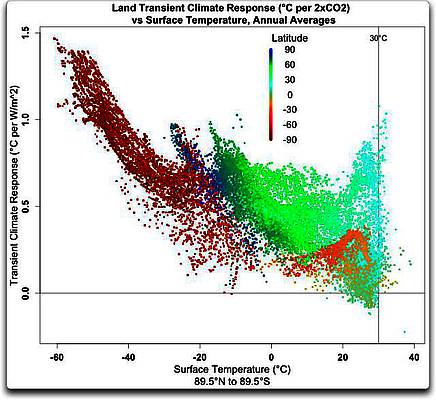

Ich habe lange gedacht, dass dies eine total ungeeignete Repräsentation ist, teils weil ich sage, dass lambda selbst, die Klimasensitivität, keine Konstante ist. Stattdessen ist es eine Funktion von T. Allerdings können wir wie gewöhnlich nicht von Linearität ausgehen … wir können keine Linearität in irgendeiner Form annehmen. Abbildung 5 zeigt die TCR (die dekadische Klimasensitivität) im Vergleich zur Temperatur.

Abbildung 5: Transient Climate Response im Vergleich zur mittleren jährlichen Temperatur, nur Festland. Man beachte, dass TCR nur selten unter Null sinkt. Die größte Reaktion gibt es in der Antarktis (dunkelrot).

Hier sehen wir die Entkoppelung der Temperatur und der TCR bei den höchsten Temperaturwerten. Man beachte auch, wie wenige Gitterquadrate wärmer als 30°C sind. Wie man sehen kann, während es eindeutig bei steigender Temperatur einen Abfall der TCR (Sensitivität) gibt, ist die Beziehung alles andere als linear. Und schaut man auf die Ozean-Daten, wird es noch eigenartiger. Abbildung 6 zeigt die gleiche Relation wie Abbildung 5. Man beachte die unterschiedliche Skalierung sowohl in X- als auch in Y-Richtung.

Abbildung 6: Wie in Abbildung 5, jedoch nur für den Ozean. Man beachte, dass sich die Skalierung von Abbildung 5 unterscheidet.

Ich liebe dieses Klimasystem – endlos komplex. Die Ozeane zeigen eine gänzlich andere Verteilung als das Festland. Erstens, die TCR der globalen Ozeane beträgt fast durchweg weniger als ein Zehntelgrad Celsius pro CO2-Verdoppelung (globales Mittel = 0.08°C/2xCO2). Und im Gegensatz zu meinen Erwartungen gibt es unter etwa 20°C kaum Anzeichen irgendeines Rückgangs der TCR mit der Temperatur, wie wir in Abbildung 5 für das Festland gesehen haben. Und über 25°C gibt es einen klaren und raschen Abfall in einer Reihe von Gebieten (einschließlich des pazifischen „Warm-Pools“), die negative Klimareaktionen zeigen.

Im Vorübergehen bemerke ich auch, dass die im offenen Ozean beobachtete 30°C-Grenze an einem Punkt eintritt, an dem die TCR = 0 ist …

Was schließe ich aus all dem? Nun, so genau weiß ich gar nicht, was das alles bedeutet. Einige Dinge sind aber eindeutig. Meine erste Schlussfolgerung lautet, dass der Gedanke, die Temperatur sei eine lineare Funktion des Antriebs, nicht durch die Beobachtungen gestützt wird. Die Relation ist weit entfernt davon, linear zu sein und kann nicht einfach approximiert werden.

Weiter. Die Schätzungen der ECS aus dieser auf Beobachtungen basierenden Studie zeigen eine Bandbreite von 0,2°C bis 0,5°C pro CO2-Verdoppelung. Das liegt weit unter der Schätzung des IPCC … was aber soll man andererseits von der Arbeit von Regierungen erwarten?

Und schließlich, die Entkoppelung der Variablen am warmen Ende des Spektrums der Gitterquadrate ist ein klares Zeichen dafür, dass ein aktives Temperatur-Regulierungssystem aktiv ist.

Unter dem Strich: Das Klima ist nicht linear und war es niemals… und die Unterwerfung unter das fatale Lockmittel einer vermuteten Linearität hat das Gebiet der Klimawissenschaft um Jahrzehnte zurückgeworfen.

Link: http://wattsupwiththat.com/2013/12/18/the-fatal-lure-of-assumed-linearity/

Übersetzt von Chris Frey EIKE