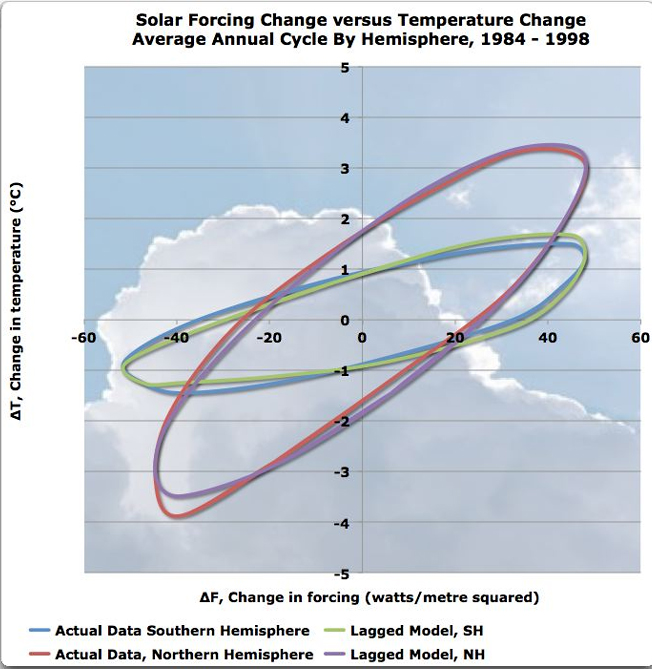

BEST, Vulkane und Klimasensitivität

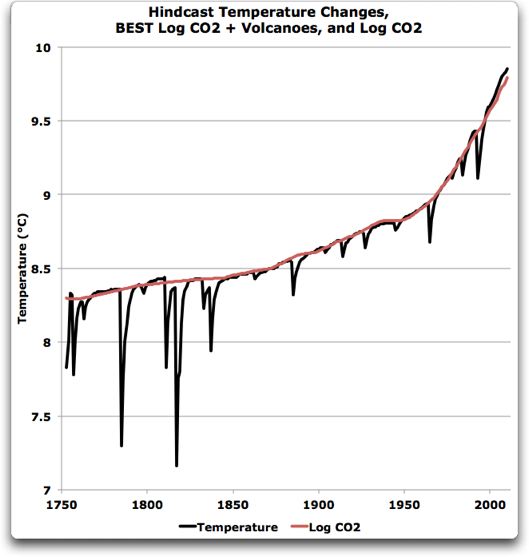

Bild rechts [Abbildung 1]: Vergleich der in der Vergangenheit eingetretenen Temperaturänderungen nach BEST infolge CO2 plus Vulkane (dicke schwarze Linie) mit den BEST-Temperaturdaten (dünne schwarze Linien). Quelle

Ich habe Steven Mosher gefragt, woher die BEST-Leute ihre Daten haben zur erwarteten Temperaturänderung durch vulkanische Antriebe wie mit der dicken schwarzen Linie dargestellt … keine Antwort. Also schob ich die Frage erst einmal beiseite und beschloss, die Daten einfach selbst zu benutzen. Also … habe ich das gemacht, was ich normalerweise immer tue. Ich habe ihre Abbildung digitalisiert, da die zugrunde liegenden Daten nicht verfügbar waren. Sie haben mir erlaubt, ihre Daten zu analysieren, was eine sehr merkwürdige Sache enthüllte.

Ihre Erklärung der schwarzen Linie in Abbildung 1 oben (ihre Abbildung 5) lautet so:

„Eine lineare Kombination von vulkanischen Sulfaten und Änderungen beim CO2 wurden angepasst an die Temperaturgeschichte auf dem Festland, um Abbildung 5 zu erzeugen. Wie wir gleich beschreiben werden, hat die Addition eines Proxies zur Sonnenaktivität die Anpassung nicht signifikant verbessert. Die großen negativen Abweichungen hängen zusammen mit vulkanischen Sulfatemissionen, wobei sich die vier größten Eruptionen alle vor 1850 ereignet haben; folglich hat sich unsere Einbeziehung der Daten vor 1850 als nützlich erwiesen für die Beobachtung dieser Ereignisse. Um die Anpassung durchzuführen, haben wir die Sulfataufzeichnungen adjustiert, indem wir ein exponentielles Abklingen mit einer Halbwertszeit von zwei Jahren nach der Emission angebracht haben. Die Wahl von zwei Jahren wurde motiviert, um die Anpassung zu maximieren, und sie ist deutlich länger als die 4 bis 8-monatige Halbwertszeit, die für die Gesamtmenge der Sulfate in der Atmosphäre beobachtet worden ist (was aber plausibel ist bzgl. der Reflektivität, die vom Gebiet und nicht vom Volumen abhängt).“

OK, das macht mich nervös … sie haben eine Anpassung durch eine lineare Regression an die Temperaturaufzeichnung der verzögerten exponentiellen Abschwächung angebracht, mit einer separat angepassten Zeitkonstante, von einer Schätzung vulkanischer Sulfatemissionen basierend auf Eisbohrkernen … OK, ich akzeptiere das, jedoch mit einer Einschränkung. Sie verwenden die Emissionen von hier, aber obwohl ich mich der Abbildung oben gut nähern kann, kann ich sie doch nicht genau nachbilden.

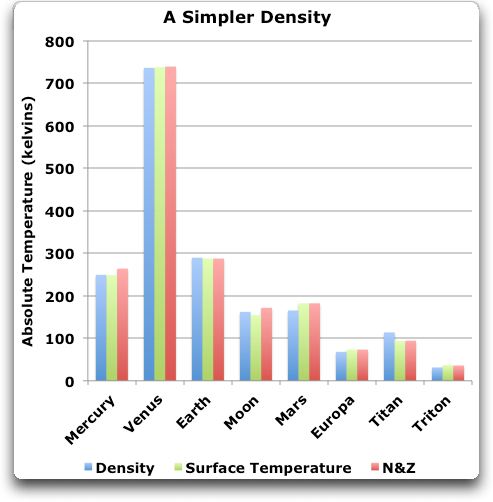

Ich wollte die vulkanischen Daten herausfiltern. Folgendermaßen wollte ich vorgehen: Zuerst würde ich die dicke schwarze Linie der Abbildung 1 oben rechts digitalisieren. Dann würde ich sie zusammenpassen mit dem Logarithmus der CO-Zunahme [CO2-Zunahme?] seit 1750. Habe ich erst einmal die CO2-Zunahme subtrahiert, müsste der verbleibende Rest die Temperaturänderungen aus vulkanischen Eruptionen allein zeigen.

Abbildung 2 zeigt den ersten Teil der Berechnung, die digitalisierte schwarze Linie aus Abbildung 1 (CO2 + Vulkane) mit dem Logarithmus CO2 überlagert in rot.

Abbildung 2: Die schwarze Linie ist die digitalisierte dicke schwarze Linie aus Abbildung 1. Die rote Linie ist dreimal der Logarithmus (zur Basis 2) der CO2-Änderung plus einer Verschiebung. Die CO2-Daten stammen von 1750 bis 1950 aus Eisbohrkernen in Law Dome, danach vom Mauna Loa.

Ich habe die CO2-Kurve händisch und nach Augenmaß an die Daten angepasst, indem ich die Neigung und den Achsenabschnitt der Regression adjustiert habe, weil Standard-Regressionsmethoden es nicht zur Spitze der schwarzen Linie anpassen. Verschiedene Dinge deuteten darauf hin, dass ich mich auf dem richtigen Weg befand. Erstens ist da die gute Anpassung des Logarithmus‘ der CO2-Daten an die BEST-Daten. Zweitens hat sich herausgestellt, dass sich die beste Anpassung ergibt, wenn man die Standard-Klimasensitivität von 3°C pro Verdoppelung des CO2-Gehaltes verwendet. Ermutigt fuhr ich fort.

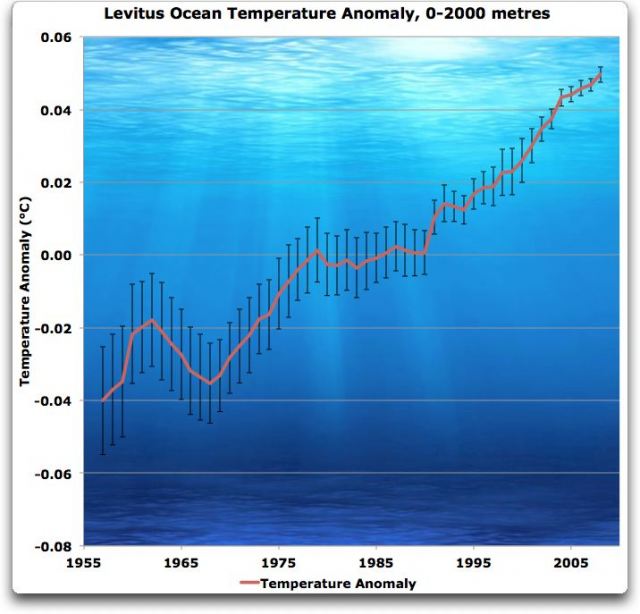

Zieht man die vulkanischen Daten von den CO2-Daten ab, erhält man die durch Vulkane erwartete Temperaturänderung, dargestellt in Abbildung 3:

Abbildung 3: Temperaturänderungen durch Vulkane (Abkühlung nach Eruptionen), wie sie von BEST dargestellt werden (schwarze Linie) und als Anpassung an die verzögerten Emissionen, wie sie oben in ihrer zitierten Erläuterung erklärt haben (rote Linie).

Wie ich oben erwähnt habe, kann ich mich den von ihnen dargestellten Temperaturänderungen (schwarze Linie) gut nähern unter Verwendung einer verzögerten Version ihrer Sulfat-Daten, wie sie es beschrieben haben (rote Linie), aber die Übereinstimmung ist nicht genau. Da die schwarze Linie dem entspricht, was sie in Abbildung 1 oben zeigen und die Unterschiede vernachlässigbar sind, arbeite ich weiter mit der dicken schwarzen Linie.

Hier wollen wir einen Moment innehalten und uns überlegen, was sie gemacht haben und was sie nicht gemacht haben. Was sie gemacht haben: Sie haben Änderungen des atmosphärischen CO2-Antriebs in Watt pro Quadratmeter (W/m²) in eine Temperaturänderung (in Grad Celsius) konvertiert. Diese Konversion haben sie unter Verwendung der Standard-Klimasensitivität von 3°C Erwärmung für jede Verdoppelung des CO2 durchgeführt (eine Verdoppelung ergibt zusätzlich 3,7 W/m²).

Auch haben sie stratosphärische Einträge von vulkanischen Sulfaten (in Teragramm) auf eine Temperaturänderung (in Grad Celsius) konvertiert. Dies haben sie durch rohe Kraft getan unter Verwendung eines verzögerten Modells der Ergebnisse der stratosphärischen Sulfateinträge, welches eine Anpassung der Temperatur ist.

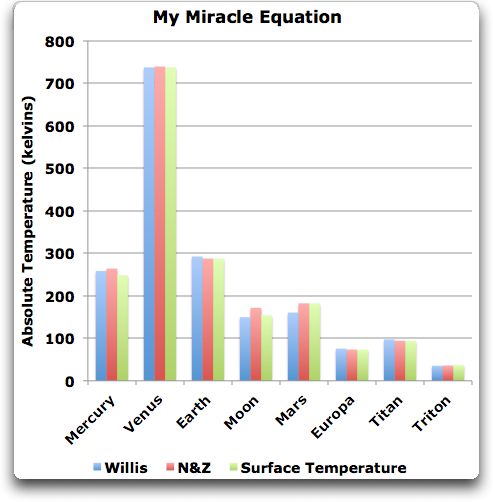

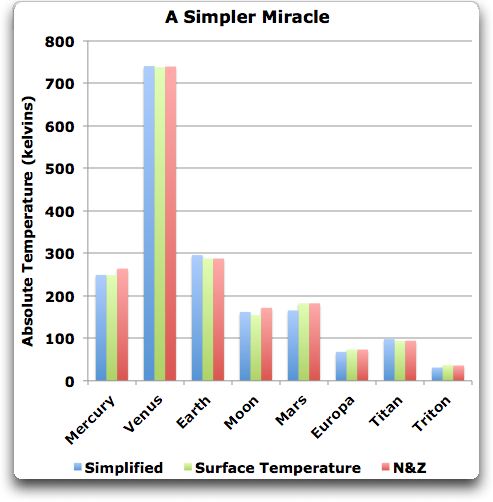

Aber was sie nicht getan haben, so weit ich das herausfinden konnte, war die Berechnung des Antriebs durch die vulkanischen Eruptionen (in W/m²). Sie haben lediglich die Sulfat-Daten direkt an die Temperaturdaten angepasst und den Zwischenschritt ausgelassen. Ohne Kenntnis des Antriebs durch die Eruptionen konnte ich nicht abschätzen, welche Klimasensitivität sie verwendet haben, um die Reaktion der Temperatur auf vulkanische Eruptionen zu berechnen.

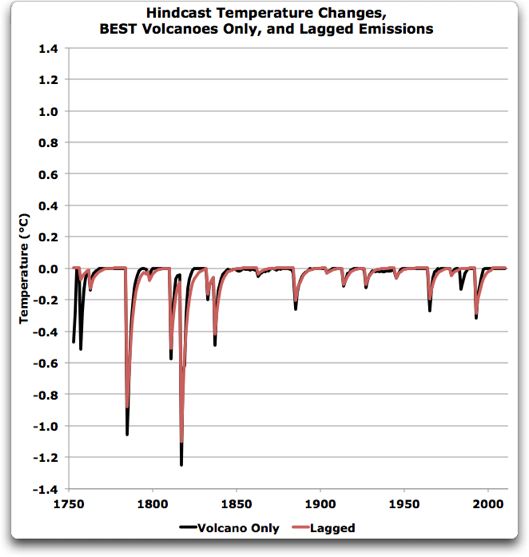

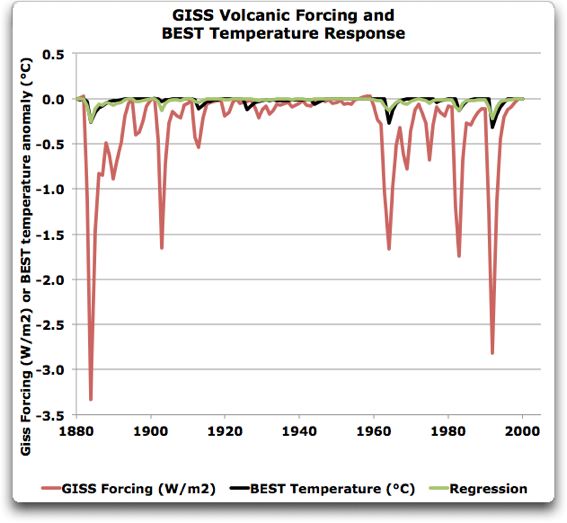

Allerdings führen viele Wege nach Rom. Die Leute bei NASA GISS verfügen über eine Schätzung des vulkanischen Antriebs (in W/m²; die Spalte unter der Bezeichnung „StratAer“ für stratosphärische Aerosole von Vulkanen). Also verwendete ich die vulkanischen Antriebe nach GISS, um die Klimasensitivität von BEST zu untersuchen. Sie decken nur den Zeitraum von 1880 bis 2000 ab, aber ich konnte sie trotzdem benutzen, um die Klimasensitivität zu schätzen, die BEST für den vulkanischen Antrieb verwendet hat. Und da fand ich den komischen Teil. Abbildung 4 zeigt den vulkanischen Antrieb in W/m² von NASA GISS, zusammen mit der BEST-Darstellung der Reaktion der Temperatur durch diesen Antrieb.

Abbildung 4: Die schwarze Linie zeigt die Temperaturanomalie der Vergangenheit (Abkühlung) nach den Eruptionen. Die rote Linie zeigt die Änderung des Antriebs in Watt pro Quadratmeter (W/m²) durch die Eruptionen. Die grüne Linie zeigt die beste Anpassung theoretischer Abkühlung, die aus dem GISS-Antrieb folgt. Beachte die unterschiedlichen Zeitperioden im Vergleich mit den vorigen Abbildungen.

Wie man erkennt, zeigt die Regression (grüne Linie) des GISS-Antriebs eine vernünftige Approximation zur BEST-Temperaturanomalie. Also befinden wir uns immer noch auf dem richtigen Weg. Der merkwürdige Teil sind die relativen Größenordnungen. Die Temperaturänderung liegt gerade unter einem Zehntel der Änderung des Antriebs (0,08°C pro W/m²).

Dies ergibt sich zu einer Klimasensitivität von etwa 0,3°C pro Verdoppelung des CO2 (0,08°C/W/m² mal 3,7 W/m²/Verdoppelung = 0,3°C/Verdoppelung) … was nur einem Zehntel der kanonischen Zahl von drei Grad pro Verdoppelung des CO2 entspricht.

Also zeigen sie in ihrer Graphik die dicke schwarze Linie als Kombination einer Klimasensitivität von 3°C pro Verdoppelung des CO2-Anteils mit einer Klimasensitivität von nur 0,3°C pro Verdoppelung des vulkanischen Anteils…

Das ist nun in der Tat ein merkwürdiges Ergebnis. Es gibt viele mögliche Wege, dieses Ergebnis einer Klimasensitivität von 0,3°C pro Verdoppelung zu erklären. Hier folgen die Möglichkeiten:

1. Die Leute bei NASA GISS haben den Antrieb durch Vulkane um einen Faktor zehn überschätzt, eine ganze Größenordnung. Möglich, aber sehr zweifelhaft. Die Reduktion des Sonnenlichts bei klarem Himmel nach vulkanischen Eruptionen wurde in zahlreichen Studien untersucht. Wir haben eine ziemlich gute Vorstellung von dem Energieverlust bei der Einstrahlung. Vielleicht irren wir uns um einen Faktor zwei, aber nicht um einen Faktor zehn.

2. Die BEST-Temperaturdaten unterschätzen die Temperaturvariationen nach vulkanischen Eruptionen um eine ganze Größenordnung. Sogar noch zweifelhafter. Die BEST-Temperaturdaten sind nicht perfekt, sind aber das Beste, was wir haben.

3. Die BEST-Daten und die NASA-Daten sind beide falsch, aber passenderweise sind sie beide in der gleichen Richtung falsch, so dass sich die Fehler gegenseitig aufheben und eine Sensitivität von drei Grad pro Verdoppelung zeigen. Die Wahrscheinlichkeit dafür, dass dies zufällig ist, ist gering, zumal auch die o. g. Gründe noch gelten.

4. Sowohl die NASA- als auch die BEST-Daten sind in etwa korrekt, und die Klimasensitivität beträgt nur etwa ein Zehntel dessen, was behauptet wird.

Ich persönlich halte Nummer 4 für die Hausnummer, kleine Klimasensitivität. Ich sage, dass das Klima durch eine Vielfalt homöostatischer Mechanismen gepuffert wird, die dazu tendieren, die Auswirkungen von Änderungen des Antriebs auf die Temperatur zu minimieren, wie ich ausführlich in verschiedenen früheren Beiträgen gezeigt habe.

Wie immer sind aber alternative Hypothesen willkommen.

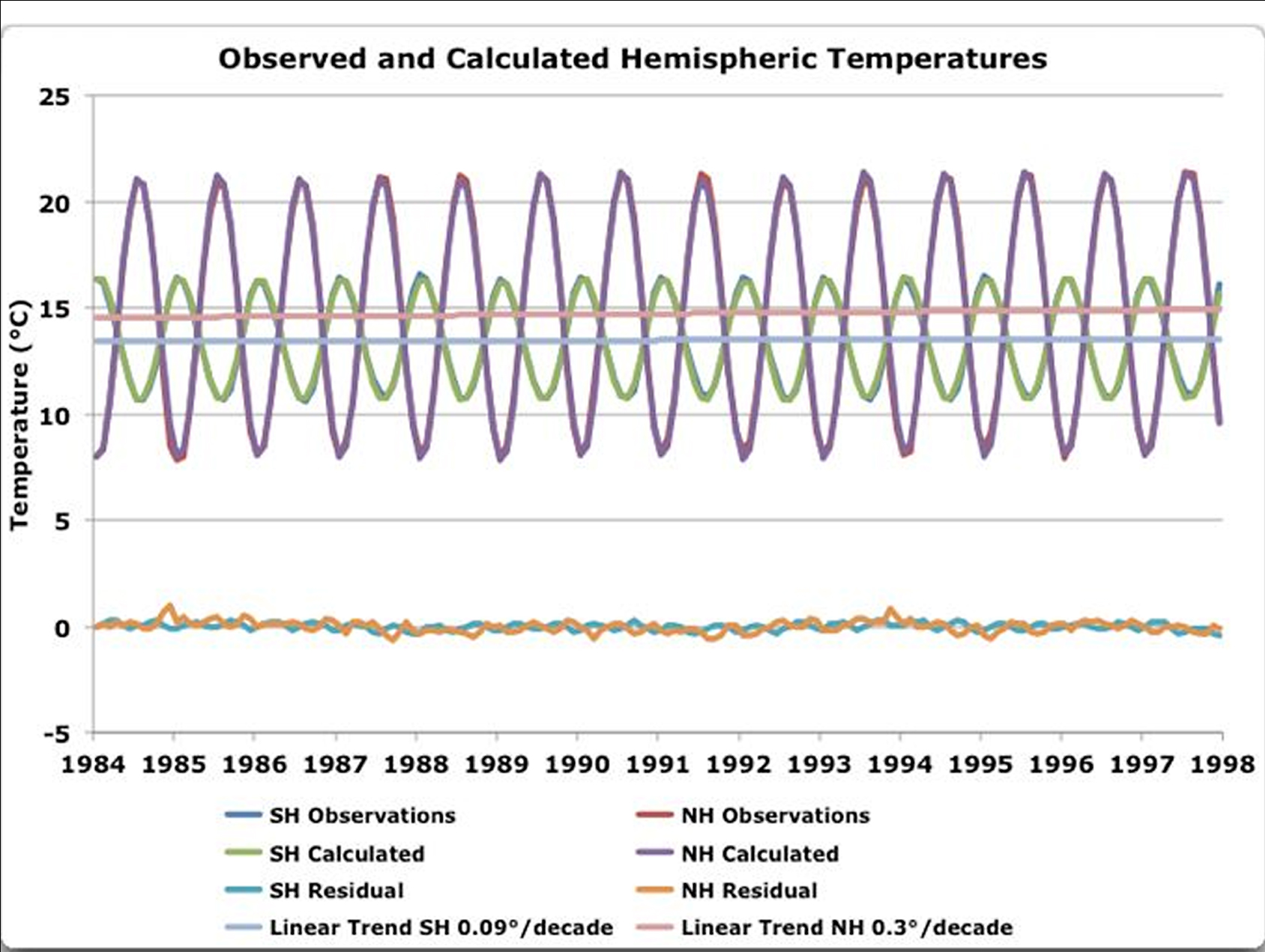

DATEN: Ich habe das in einer Excel-Tabelle gerechnet, und zwar hier. Das ist nicht nutzerfreundlich, aber ich glaube auch nicht, dass es aktiv nutzerfeindlich ist … die BEST-Temperaturdaten in dieser Tabelle stammen von hier. Man beachte, dass komischerweise die BEST-Leute nicht alles des jährlichen Zyklus‘ aus ihren Temperaturdaten eliminiert haben, es verbleibt ein ganzes Grad jährlicher Schwingung … man stelle sich das mal vor!

(Aktualisierung) Richard Telford hat in Kommentaren darauf hingewiesen, dass das, was ich berechnet habe, die momentane Sensitivität ist, und da hat er recht.

Wie ich allerdings im Beitrag „Time Lags in the Climate System“ [etwa: Zeitliche Verzögerungen im Klimasystem] gezeigt habe, hängt die momentane Sensitivität in einem zyklisch getriebenen System, das Wärme durch exponentielle Verstärkung und Abschwächung gewinnt und verliert, mit einer längerzeitlichen Sensitivität zusammen, und zwar durch die Beziehung

![]()

Dabei ist t1 die Verzögerung, t die Länge des Zyklus‘ und s2/s1 die Größe der Reduktion der Amplitude. Da wir in diesem Falle ausschließlich mit BEST-Temperaturdaten nur vom Festland arbeiten, wo die Verzögerung kurz ist (im Mittel weniger als einen Monat), bedeutet das, dass die kurzfristige Sensitivität etwa 64% der längerzeitlichen Sensitivität ausmacht. Dies ergibt eine längerzeitliche Sensitivität von etwa 0,46°C pro Verdoppelung. Auch das liegt noch weit, weit unter der üblichen Schätzung von 3°C pro Verdoppelung.

Willis Eschenbach

Link: http://wattsupwiththat.com/2012/08/13/best-volcanoes-and-climate-sensitivity/

Übersetzt von Chris Frey EIKE