Ohne Energie keine Zivilisation Deutschland: Mit Vollgas in die Steinzeit

Bild rechts: Fortschritt 2050: Ultramoderne, rostfreie, garantiert carbonfrei hergestellte Messerklinge Marke „Flintstone“

Bei früheren Kreuzzügen ging es vorgeblich darum, das heilige Land von „den Heiden“ zu befreien. Heutzutage sind wir moderner. Die „Heiden“ werden mit Gummibärchen und Selfies willkommen geheißen, als Beelzebub haben wir stattdessen das CO2 ausgemacht, von dem die Welt und ihr Klima befreit werden müssen. Letzteres wurde im Dezember 2015 auf der denkwürdigen „Welt-Klimakonferenz“ COP21 in Paris beschlossen. Die Bundesregierung will dabei den Vorreiter geben und hat deshalb am 9. März 2016 der Unterzeichnung dieses „Klimaschutzabkommens“ zugestimmt. Die Unterzeichnungszeremonie soll am 22. April 2016, dem „Tag der Erde“, in New York stattfinden. Umweltministerin Barbara Hendricks betont, dass Deutschland damit zu den Erstunterzeichnern gehören werde. Schon am 19. März 2016 präsentierte sie der Nation einen Katalog von 89 Maßnahmenvorschlägen für den deutschen „Klimaschutzplan 2050“ und kündigte den weiteren „klimafreundlichen Umbau von Wirtschaft und Gesellschaft“ mit dem Ziel der „Treibhausgasneutralität“ an. Worin unterscheidet sich dies von gesellschaftspolitischen Ansätzen früherer Jahrtausende?

Ohne Energie keine Zivilisation

In der Geschichte der Menschheit haben nur wenige Herrscher bewusst auf eine Verelendung des eigenen Volkes hingearbeitet. Es gab natürlich jede Menge unfähiger Fürsten und Könige, doch hat kaum jemand von diesen ernsthaft versucht, einmal erreichte zivilisatorische Errungenschaften für seine eigenen Leute rückgängig zu machen. Im Gegenteil: Sieht man sich die Geschichte von Hochzivilisationen an, so sind Fortschritte für die Masse der Bevölkerung untrennbar mit der Verfügbarkeit von zusätzlicher Nahrung und Energie verbunden. Das Große an Karl dem Großen war nicht das Massaker an den Sachsen, sondern die Einführung der Dreifelderwirtschaft. Das dadurch verbesserte Nahrungsangebot kam letztlich allen zugute, und das war das entscheidende. Den herrschenden Klassen ging es nämlich auch schon vor Jahrtausenden gut, wie das Sterbealter ägyptischer Pharaonenmumien oder die Grabinschriften römischer Patrizier unschwer beweisen. Die weit überwiegende Masse der Bevölkerung jedoch fristete selbst noch im 16. Jahrhundert ein kärgliches Dasein, das von Mühsal, Entbehrungen, Siechtum und frühem Tod geprägt war. Eltern mussten oft vier von fünf Kindern begraben, die durchschnittliche Lebenserwartung lag bis 1700 auch in Deutschland bei 30 Jahren, teilweise sogar noch darunter. Als einzige Energiequellen standen Reit- und Zugtiere sowie in geringem Umfang Wind- und Wassermühlen zur Verfügung.

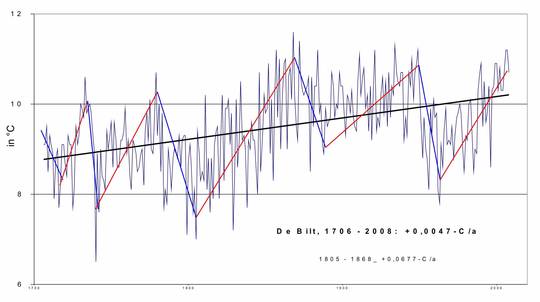

Den Anstoß zu einer modernen Zivilisation, welche auch der Bevölkerung in ihrer Breite merklich zugute kam, gaben erst die Kohlegewinnung und die damit verknüpfte Einführung der Dampfmaschine ab etwa 1720. Damit erschloss sich die Menschheit den Zugriff auf thermische, mechanische und schließlich auch elektrische Energie in einem Ausmaß, das sich vorher niemand hatte vorstellen können. Dokumentieren lässt sich dies an zwei entscheidenden Kenngrößen: Der Zunahme des Ausstoßes an CO2 durch Verbrennung von fossilen Rohstoffen einerseits und der Zunahme der Lebenserwartung der breiten Bevölkerung andererseits, Bild 1. Nur die reichliche Verfügbarkeit von Energie ermöglichte die Entwicklung unserer modernen technischen Zivilisation mit den Errungenschaften für die gesamte Bevölkerung, die wir heute kennen und als selbstverständlich empfinden.

Bild 1. Erst die Verfügbarkeit von reichlicher und bezahlbarer Energie ermöglichte die Entwicklung der modernen technischen Zivilisation, wie wir sie heute kennen. Vereinfachte linearisierte Darstellung. Daten: [CDIA, LEBE, BPB] (Grafik: eigene Berechnungen)

Weltweit gelten diese Gesetzmäßigkeiten übrigens auch heute noch. Nach wie vor verfügen Millionen von Menschen nicht über die Energieressourcen, die ihnen unseren Lebensstandard ermöglichen würden. Das zeigt sich beispielsweise, wenn man die Lebenserwartung in verschiedenen Ländern mit dem jeweiligen Pro-Kopf-Ausstoß an CO2 in einem Diagramm aufträgt, Bild 2.

Bild 2. Zusammenhang zwischen Verfügbarkeit von Energie, ausgedrückt durch den nationalen Pro-Kopf-Ausstoß an CO2, und der durchschnittlichen Lebenserwartung. Daten: [CDIA, LEBE] (Grafik: eigene Berechnungen)

Zivilisatorisches Niveau, ausgedrückt durch die mittlere Lebenserwartung, und die Verfügbarkeit von (fossiler) Energie sind daher nach wie vor eng verknüpft. Bei den CO2-Ausreißern nach oben handelt es sich meist um Länder mit überreichlichen Ressourcen an Öl und Gas sowie vergleichsweise geringer Bevölkerungszahl wie Katar, Brunei, Oman oder Trinidad und Tobago. In anderen Fällen dürfte es sich um kleine Inselnationen mit weit überdurchschnittlichem Flugverkehrsaufkommen durch Tourismus handeln. Deutschland liegt ebenso wie die meisten seiner Nachbarländer im Bereich zwischen 7-11 t CO2/Kopf und Jahr.

Energieverweigerung bedeutet Massenmord

Allen politischen Akteure, die heute publikumswirksam den weitgehenden oder vollständigen Verzicht auf die Verbrennung fossiler Rohstoffe predigen, müsste eigentlich klar sein, dass es nicht darum gehen darf, der Menschheit die Verfügbarkeit von Energie zu verwehren. Das liefe auf Massenmord in einem Ausmaß hinaus, wie es in der ganzen Menschheitsgeschichte bisher nicht dagewesen ist. Betroffen wären nicht nur die Länder der 3. Welt, sondern auch die Industrienationen, denn deren Infrastruktur und auch die gesundheitliche Robustheit der Bevölkerung sind viel empfindlicher als in Ländern der 3.Welt. Mit dem Technologieniveau des 16. Jahrhunderts könnte Deutschland nicht einmal die Hälfte seiner heutigen Bevölkerung ernähren. Wir hätten „Bio“ für die Reichen und Hungertod für die Massen. Ganz wie früher.

Diejenigen, die uns den Verzicht auf fossile Ressourcen predigen, müssen daher die Frage beantworten, welche Alternativen sie der Menschheit als Ersatz anbieten wollen. Die vielfach angepriesenen „erneuerbaren“ Energien wie Solar- und Windenergie sind hierzu untauglich [ELHI, IVAN, TASM], nicht zuletzt auch deshalb, weil es derzeit keine technisch wie wirtschaftlich vertretbaren Lösungen für die erforderliche Energiespeicherung gibt. Alle derzeit propagierten Konzepte stecken in den Kinderschuhen. Keine einzige hat sich bisher als ausreichend praxistauglich erwiesen, im Gegenteil: Diverse hochgelobte Inselprojekte wie El Hierro, Tasmanien oder die eine oder andere Nordseeinsel haben sich bisher stets als teure Flops erwiesen.

Als einzige andere Alternative bliebe dann noch die Kernenergie. Diese wird jedoch im Augenblick von den meisten selbst ernannten „progressiven Kräften“ mit aller Leidenschaft bekämpft. „Alternativloser“ Verzicht, wie er teilweise propagiert wird, hätte gerade bei den Ärmsten der Armen katastrophale Auswirkungen. Letztlich ist es egal, ob jemand umweltpolitisch oder kirchlich ausgerichtet ist oder schlicht und undifferenziert gegen „Sozialkapitalismus“ wettert: Er sollte sich hier und jetzt klarmachen, dass er der Weltbevölkerung von aktuell rund 7,4 Mrd. Menschen Wege anbieten muss, an günstige Energie zu gelangen, sonst gibt es mehr Opfer ideologischer Verblendung als jemals zuvor in der Geschichte.

Die Utopie einer deutschen „Treibhausgasneutralität“

Bis vor einigen Monaten verfolgte die Bundesregierung noch vorrangig das Ziel, die deutschen CO2-Emissionen bis zum Jahr 2020 auf 625 Mio. Tonnen/Jahr zu senken. Dieses wurde insbesondere im Rahmen von EU-Vereinbarungen propagiert. Ein Blick auf die tatsächliche Entwicklung zeigt jedoch, dass der Rückgang bereits weit oberhalb dieser Zielmarke zum Stillstand gekommen ist, Bild 3.

|

Bild 3. Der Rückgang der deutschen CO2-Emissionen ist faktisch zum Stillstand gekommen. Das für 2020 angestrebte Ziel dürfte um rund 190 Mio. t/a verfehlt werden. Daten: [STAT], eigene Berechnungen.

Betrachtet man die Trendlinie, so dürfte das Ziel sogar um rund 190 Mio. t CO2/a verfehlt werden. Das entspricht glatten 30 %. Hierbei muss man noch ins Kalkül ziehen, dass wir in 2014 und 2015 zwei vergleichsweise milde Jahre in Folge hatten, was eine entsprechende Verringerung der heizungsbedingten CO2-Emissionen zur Folge hatte [AGEV]. Während man in ökopolitischen Kreisen lautstark über die „Verhagelung“ der CO2-Bilanz aufgrund des „zu kalten“ Jahres 2015 klagte, zeigt der Blick auf das langjährige Mittel 1981-2010, dass nicht nur das extrem milde Jahr 2014 mit 2453 sogenannten Gradtagen (was das ist? hier), sondern auch das angeblich zu kalte Jahr 2015 mit 2852 Gradtagen immer noch unterhalb des Durchschnitts von 2.993 Gradtagen lagen. Zudem war das Jahr 2015 außergewöhnlich sonnen- und windreich, was zu einem massiven Anstieg vor allem beim Windstrom (+ 50 % !) wie auch bei der Fotovoltaik (+ 7%) führte. All dies zusammen hatte entsprechende Auswirkungen auf die CO2-Emissionen. Realistisch betrachtet waren 2014 und 2015 also Ausnahmejahre mit außergewöhnlich niedrigen CO2-Emissionen.

Bei nüchterner Betrachtung der Zahlen zur Entwicklung der deutschen CO2-Emissionen kommt man zu dem Schluss, dass schon die bisherige Politik der Bundesregierung bezüglich der Verringerung der deutschen CO2-Emissionen gescheitert ist. Mit den üblichen Mitteln politischer und wirtschaftlicher Lenkung und Anreizbildung steckt man hier offensichtlich in der Sackgasse. Normalerweise müsste die Politik in einer solchen Situation einen Rückzieher machen. Im heute „alternativlos“gewordenen Deutschland ist die Reaktion jedoch eine andere.

Die Vision einer deutschen „Treibhausgasneutralität“

Doch beflügelt vom erfolgreichen Verlauf des großen Klimarettungs-Jamborees in Paris hat sich die Bundesregierung in Person der Ministerin Hendricks stattdessen jetzt noch viel ambitioniertere Ziele gesteckt. Zwar sind konkrete Zahlenwerke noch nicht veröffentlicht, doch sollen schon bis Mitte 2016 gesetzliche Vorgaben erarbeitet werden, welche den CO2-Ausstoss Deutschlands bis zum Jahre 2050 um rund 85 % drücken sollen. Wichtige Eckpunkte des „Klimaschutzplans 2050“ sind bereits bekannt [EIKE] und lassen Schlimmes befürchten.

So soll im Autoland Deutschland, wo etwa jeder siebte Industriearbeitsplatz direkt oder indirekt am Automobil hängt, der Verkauf von Verbrennungsmotoren für den Einsatz bei Transport und Verkehr schon ab 2030 verboten werden. Da die Modellpolitik der Hersteller über lange Zeiträume geplant werden muss, bedeutet dies mehr oder weniger das Aus für wesentliche Teile der Branche innerhalb der nächsten paar Jahre. Hausbesitzer sollen durch „Straf-Grundsteuern“ und eine Umstellungspflicht auf „EE-Heizungen“ zu unrentablen Investitionen in angebliche „Energiesparmaßnahmen“ gezwungen werden. Zusätzlich flankiert werden soll dies durch Brennstoffsteuern auf Öl- und Gasheizungen. Innerorts soll das Verkehrstempo grundsätzlich auf 30 km/h begrenzt werden, für Autobahnen sollen 120 km/h gelten. Die Stromproduktion soll verringert werden. Ein besonderes „Schmankerl“ ist hierbei die beabsichtigte Beendigung des Kohleeinsatzes in Kraftwerken bereits ab 2035. Da die Kernenergie sogar noch früher, nämlich bis 2022 auslaufen soll, wäre Deutschland bezüglich seiner Stromversorgung dann weitgehend auf Windmühlen, Solarpaneele, Biomasse und etwas Wasserkraft beschränkt. Zur Stabilisierung der Netze stünde lediglich noch ein wenig Erdgas zur Verfügung Die Blaupause hierfür liefert unter anderem ein jetzt bereits verabschiedetes Gesetz für das Land Berlin [EWBE, EWB2], siehe Bild 4.

Bild 4. Die vom Land Berlin im Rahmen seiner Klimaschutzgesetzgebung festgelegten Maßnahmen sehen bis 2050 eine Reduzierung der CO2- Emissionen um 85 % vor (Grafik: [KLNB])

Utopische Vorstellungen beim Strom

Unterzieht man die bis jetzt bekannten Eckdaten der Politik beispielsweise bezüglich der Stromerzeugung einem Plausibilitätstest, so stellt man schnell fest, dass es sich hier um politische Vorgaben handelt, die in der Realität gar nicht umsetzbar wären. Das beginnt bereits mit der aktuell von verschiedenen Quellen erwarteten Verringerung der Stromproduktion von rund 10 % seit 1990 bis zum Jahr 2050, Bild 5.

Bild 5. Laut aktuellen Daten von AGEB und Prognosen von Statista wird eine Rückgang der Stromproduktion von 1990 bis 2050 um ca. 10 % erwartet (Daten: [AGE2, STA2]

Als Begründung für die allgemein erwarteten Reduzierungen bei der Stromerzeugung werden u.a. Effizienzsteigerungen und der Einsatz „smarter“ Energieverteilungstechnologien angeführt. „Smarte“ Netze sollen dafür sorgen, dass Strom vorrangig dann genutzt wird, wenn er aufgrund geeigneter Wetterlagen reichlicher vorhanden und damit billiger ist. Das ist so weltfremd, dass man sich fragen muss, welchen Leuten man denn da das Steuerrad für das Land übergeben hat. Bei einigermaßen realistischer Betrachtung gibt es nämlich weder im privaten noch im gewerblichen Bereich viele Möglichkeit, zeitlich „flexibel“ auf ein erratisch schwankendes Stromangebot zu reagieren. Im Privatbereich ist es der Lebensrhythmus der Bewohner, der festlegt, wann gebadet, gekocht oder der Fernseher eingeschaltet wird, und es ist schlechterdings kaum vorstellbar, dass ein Bundesligaspiel oder ein Boxwettkampf um eine Stunde verzögert würden, weil dann billigerer Windstrom zur Verfügung stünde. Auch im gewerblichen Bereich mit seinen synchronisierten Abläufen ist die Vorstellung, tausende Mitarbeiter Däumchen drehen zu lassen, weil bei den Windmühlen gerade Flaute herrscht, so aberwitzig, dass man darüber gar nicht zu diskutieren braucht. Dass dennoch selbst große Unternehmen der Energiebranche in teuren Werbekampagnen suggerieren, in Zukunft werde sich der Verbrauch anders als bisher nach dem Angebot richten, sollte eigentlich strafrechtliche Konsequenzen nach sich ziehen.

Hinweg mit den fossilen Energien?

Der Gesamtenergieverbrauch Deutschlands im Jahre 2015 erreichte 13.306 Petajoule (PJ) [AGEB], was in etwa 3.700 TWh entspricht. Hiervon stammten lediglich 1670 PJ bzw. ca. 460 TWh (12,5 %) aus „erneuerbarer“ Energieerzeugung, der Rest von 3.240 TWh aus fossilen Energien bzw. aus Kernkraftwerken. Geht man davon aus, dass die Bundesregierung vorhat, den CO2-Ausstoss aus der Verbrennung fossiler Rohstoffe um 85 % zu reduzieren, so dürften im Jahre 2050 nur noch rund 158 Mio. Tonnen CO2 emittiert werden, siehe Bild 3. Bei der Verbrennung von Erdgas entstehen rund 219 g CO2/kWh [VDS]. Rechnet man diese Werte entsprechend um, so dürften 2050 noch maximal 2.600 PJ Energie aus Erdgas gewonnen werden. Erdgas wäre die einzige noch sinnvoll nutzbare Quelle, denn Kohle und Erdöl kämen wegen ihrer deutlich schlechteren CO2-Bilanz nicht infrage, Bild 6. Verglichen mit dem heutigen Gesamt-Energiebedarf der Nation müssten also zusätzliche 9.040 PJ bzw. 2.510 TWh allein durch Strom aus „sauberer EE-Erzeugung“ zur Verfügung gestellt werden, um auch nur den aktuellen Stand der Energieversorgung aufrechtzuerhalten. Hierfür kämen ausschließlich zwei Technologien infrage: Wind und Fotovoltaik. Alle anderen „EE“-Technologien sind faktisch bereits ausgereizt und können keine wesentlich höheren Beiträge als bisher liefern. Zusammen haben Wind und FV 2015 insgesamt 124,5 TWh Strom geliefert. Um auch noch den Rest zu erzeugen, müsste ihre Kapazität demnach um den Faktor 20 gesteigert werden. Da uns die „Energiewende“ bisher bereits mehr als eine halbe Billion € gekostet hat, kämen demnach Kosten von mehr als 10 Billionen € auf uns zu, nur um unseren heutigen Status im Bereich der Energieversorgung zu erhalten. Und das noch ohne Berücksichtigung der zusätzlich erforderlichen Investitionen in Infrastruktur.

Bild 6. Im Vergleich zu anderen fossilen Rohstoffen weist Erdgas die geringsten CO2-Emissionen auf (Grafik: [VDS])

Der „vergessene“ Strombedarf

Noch grotesker werden die Vorstellungen der Politik, wenn man sich ansieht, welcher zusätzliche Strombedarf allein schon durch die Umstellung einiger wichtiger Bereiche wie Verkehr und Heizung in Zukunft entstehen würde. Während die Politik und die „grünlinken“ Lobbyverbände und Thinktanks von einer Verringerung der Stromproduktion fabulieren, sähe die Realität ganz anders aus. Allein die Umstellung des PKW-Verkehrs auf E-Mobile würde einen zusätzlichen Strombedarf von mindestens 135 TWh bedingen, das sind gut 20 % der derzeitigen Jahresproduktion von 647 TWh [AGE2]. Hinzu kommt der gewerbliche Verkehr, denn man müsste ja auch LKW, Busse und evtl. Schiffe auf E-Antriebe umstellen. Hierfür müssten jährlich weitere 64 TWh Strom bereitgestellt werden. Vom Flugverkehr wollen wir in diesem Zusammenhang gar nicht erst reden.

Der eigentliche 400-Pfund-Gorilla des künftigen Stromverbrauchs lauert aber in den Bereichen Heizung, Warmwasser und industrieller Prozesswärme. Will man diese CO2-frei gestalten, so muss man von Gas oder Öl auf Elektrizität umstellen. Insgesamt benötigte Deutschland im Jahre 2015 866 Terawattstunden (TWh) an Erdgas [AGEB]. Hiervon wurden 384 TWh in Haushalten und Kleingewerben eingesetzt, 360 TWh in der Industrie und 110 TWh in Kraftwerken und Heizanlagen [AGEB]. Durch Strom ersetzbar sind etwa 66 % des Anteils der Haushalte. (Der Einsatz von Wärmepumpen ist nur im Bereich von Niedertemperaturanwendungen wie Heizung und Warmwasser sinnvoll). Der Energiebedarf einer Wärmepumpenheizung liegt bei rund 1/3 dessen, den die bisherige Heizung benötigte [FAWA]. Der zusätzliche Bedarf an elektrischer Energie für die Wärmepumpen kann in etwa auf jährlich rund 200 TWh geschätzt werden (Erdgas und Erdöl zusammen). Bei den industriellen Anwendungen lassen sich wegen des meist deutlich höheren Temperaturniveaus grob geschätzt nicht mehr als 20 % einsparen, so dass hier wiederum ein zusätzlicher jährlicher Strombedarf von 290 TWh erforderlich wäre. Noch außen vorgelassen wurden bei dieser Betrachtung das leichte Heizöl in der Industrie sowie der Einsatz von Kohle bzw. Koks in der Stahlerzeugung.

Zählt man diesen zusätzlichen Strombedarf einmal zusammen, so landet man bei insgesamt 690 TWh/ a. Zusammen mit den bereits jetzt erzeugten 647 TWh/a müsste unser Kraftwerkspark daher 2050 insgesamt 1.340 TWh bereitstellen, das sind über200 % mehr als heute. Die Differenz zu den „offiziös“ verbreiteten Planzahlen ist auf gut Deutsch erschreckend.

Großangriff auf die Hausbesitzer

Hinzu kommt die Frage, welche Kosten denn zusätzlich noch auf unsere Bevölkerung zukämen, beispielsweise durch die Umstellung der Heizsysteme. Wie Bild 7 zeigt, haben unsere Häuslebauer in den letzten Jahren in erster Linie auf Erdgas- und daneben auf Erdölheizungen gesetzt.

Bild 7. Bei den Heizungen dominieren mit deutlichem Abstand Erdgas und Erdöl (Grafik: [AGEV])

Der Einsatz von Fernwärme dürfte wegen des gesetzlichen Drucks zur Reduzierung von CO2-Emissionen in den nächsten Jahren drastisch zurückgehen. Fernwärme- und Heizkraftwerke funktionieren nur mit Verbrennungsprozessen, und die Ressourcen an Pellets und Biomasse sind bereits heute nahezu ausgereizt. Man mag sich gar nicht vorstellen, was es bedeutet, wenn der Staat darangeht, die Besitzer von rund 29 Mio. bestens funktionierender und teils sogar hochmoderner Heizungsanlagen (19 Mio. Erdgas-, 10 Mio. Ölheizungen, Zahlen nach [AGEV]) zu zwingen, für schätzungsweise kumulierte 700-750 Mrd. € auf elektrisch betriebene Wärmepumpensysteme umzustellen [HEIZ, HEI2]. Hinzu kommen noch weitere staatlich verordnete „energetische Sanierungsmaßnahmen“. Wenn dann auch noch die Zinsen anziehen, dürfte so mancher Häuslebauer aufgeben müssen. Industriebetriebe dürften in Scharen abwandern. Auf Deutschland werden wohl noch sehr „interessante Zeiten“ zukommen.

Fred F. Mueller

Quellen

[AGEB] Energieverbrauch in Deutschland im Jahr 2015. ageb_jahresbericht2015_20160317_final

[AGE2] http://www.ag-energiebilanzen.de/index.php?article_id=29&fileName=20160128_brd_stromerzeugung1990-2015.pdf

[AGEV] Energieverbrauch in Deutschland. Daten für das 1.- 4. Quartal 2015. Arbeitsgemeinschaft Energiebilanzen e.V.

[BPB] http://www.bpb.de/politik/grundfragen/deutsche-verhaeltnisse-eine-sozialkunde/138003/historischer-rueckblick?p=all

[BURN] http://www.welt.de/politik/deutschland/article122939590/Die-Frau-die-bei-der-CDU-Burning-Barbara-heisst.html

[CDIA] http://cdiac.ornl.gov/trends/emis/meth_reg.html

[EWBE] Senatsverwaltung für Stadtentwicklung und Umwelt. Entwurf eines Gesetzes zur Umsetzung der Energiewende und zur Förderung des Klimaschutzes in Berlin (Berliner Energiewendegesetz – EWG Bln)

[EWB2] http://www.berliner-e-agentur.de/news/land-berlin-beschliesst-energiewendegesetz

[HEIZ] http://www.heizsparer.de/heizung/heizungssysteme/heizungsvergleich/heizungsvergleich-einfamilienhaus

[HEI2] http://www.co2-emissionen-vergleichen.de/Heizungsvergleich/CO2-Vergleich-Heizung.html

[KLNB] http://www.stadtentwicklung.berlin.de/umwelt/klimaschutz/studie_klimaneutrales_berlin/

[EIKE] http://www.eike-klima-energie.eu/news-cache/klimaschutzplan-2050-morgenthauplan-20/

[ELHI] http://www.eike-klima-energie.eu/energie-anzeige/100-ee-millionengrab-el-hierro-windenergie-unreif-fuer-die-insel/

[IVAN] http://www.eike-klima-energie.eu/news-cache/ivanpah-das-groesste-us-solarprojekt-koennte-gezwungen-werden-abzuschalten/

[LEBE] http://www.lebenserwartung.info/index-Dateien/ledeu.htm

[STAT] http://de.statista.com/statistik/daten/studie/2275/umfrage/hoehe-der-co2-emissionen-in-deutschland-seit-1990/

[STA2] http://de.statista.com/statistik/daten/studie/182020/umfrage/prognose-zur-bruttostromerzeugung-in-deutschland-bis-2050/

[TASM] http://www.eike-klima-energie.eu/news-cache/inseln-sind-mit-dem-versuch-gescheitert-sich-zu-100-mit-gruener-energie-zu-versorgen-und-kehrten-zurueck-zu-diesel/

[VDS] http://www.erdgas.ch/erdgas/umwelt/emissionswerte/