Im Jahre 1988 riefen die Vereinten Nationen, eine politische Institution, die globale Erwärmungsberichte schreibende Unternehmung Intergovernmental Panel on Climate Change (IPCC) ins Leben. Das IPCC wurde gegründet mit der Aufgabe, politische Agenden zu stützen. Und im Jahre 1995 korrumpierte die Politik die Klimawissenschaft, als Politiker die Sprache des Zweiten IPCC-Zustandsberichtes änderten dergestalt, dass sie die von den Wissenschaftlern beschriebenen Unsicherheiten herausgestrichen haben. Bis auf den heutigen Tag kann die klimawissenschaftliche Gemeinschaft nicht wirklich unterscheiden zwischen der natürlichen und der anthropogenen globalen Erwärmung. Warum? Die in herangezogenen Studien verwendeten Klimamodelle können immer noch nicht Zustände der natürlichen Variabilität simulieren, die im multidekadischen Zeitmaßstab globale Erwärmung verursachen können.

Einführung

Der Skeptizismus von Donald Trump hinsichtlich einer vom Menschen verursachten globalen Erwärmung/Klimawandels war ein Konzentrationspunkt der Mainstream-Medien während der Wahlen in den USA. Das ist er immer noch in den Köpfen vieler Umweltaktivisten und ihren Verbündeten in den Medien. Eine Unmenge von Artikeln und Diskussionen wurde geschrieben bzw. gesendet, was die politische Natur der Klimawissenschaft für jedermann erneut sichtbar werden ließ.

Aber vor wie langer Zeit wurde die Klimawissenschaft politisiert?

Ich wurde an die Antwort auf diese Frage erinnert bei der Lektüre des jüngsten Blogbeitrags von Dr. Roy Spencer Global Warming: Policy Hoax versus Dodgy Science. Er beginnt diesen Beitrag so:

Anfang der neunziger Jahre besuchte ich den Wissenschaftsberater des Weißen Hauses Sir Prof. Dr. Robert Watson, der sich hochtrabend beweihräucherte, wie man doch erfolgreich den Gebrauch von Freon reguliert habe, um das Problem des Ozon-Abbaus zu lösen. Jetzt sei es das nächste Ziel, auch Kohlendioxid zu regulieren, von dem man zu jener Zeit glaubte, dass es die einzige Ursache für globale Erwärmung sei.

Ich war ein wenig begeistert ob dieses Verfahrens, den Karren vor das Pferd zu spannen. Es kam mir wirklich so vor, dass das politische Ziel in Stein gemeißelt werden sollte, und dass das neu gegründete IPCC jetzt die ziemlich dubiose Aufgabe hatte, die Wissenschaft zur Unterstützung dieser Politik zu erzeugen.

Die dubiose Aufgabe, die Wissenschaft zur Unterstützung von Politik zu erzeugen

Um Dr. Spencers Statement bzgl. des Karrens vor dem Pferd zu bekräftigen, werde ich einen Auszug aus der Einführung zu meinem über 700 Seiten starken Nachschlagewerk (ein Gratis-E-Buch) mit dem Titel On Global Warming and the Illusion of Control – Part 1 wiederholen. Dieser Auszug enthält Zitate der UN und des IPCC zusammen mit den Links zu den zitierten Websites. Unter der Überschrift [übersetzt] „Es ist ein Irrtum zu glauben, dass das IPCC eine wissenschaftliche Institution ist“ schrieb ich:

Das IPCC ist eine politische Einrichtung und nicht eine wissenschaftliche. Das IPCC leitet seine Eingangs-Paragraphen seiner History-Website mit den Worten ein (Hervorhebung von mir [Tisdale]):

Das IPCC wurde im Jahre 1988 ins Leben gerufen. Es wurde gebildet durch die Weltwetterorganisation WMO und durch das United Nations Environment Program (UNEP) aufgebaut, um auf der Grundlage aller verfügbaren wissenschaftlichen Informationen Zustandsberichte über alle Aspekte des Klimawandels und deren Auswirkungen zu erstellen mit Blick auf zu entwickelnde realistische Strategien, dem zu begegnen. Die ursprüngliche Aufgabe des IPCC, wie sie in der Resolution 43/53 des UN-Generalsekretariats vom 6. Dezember 1988 umrissen worden ist, war die Vorbereitung einer umfassenden Übersicht und Empfehlungen zu geben hinsichtlich des Status‘ des Wissens um die Wissenschaft vom Klimawandel; die sozialen und wirtschaftlichen Auswirkungen des Klimawandels sowie mögliche Strategien, dem zu begegnen, und Konzepte für die Inklusion in mögliche zukünftige internationale Konventionen bzgl. Klima.

Folglich ist das IPCC gegründet worden, damit es Berichte schreibt. Zugegeben, es sind sehr detaillierte Berichte; so sehr, dass kaum jemand diese Berichte zur Gänze liest. Von den wenigen Menschen, die das doch tun, lesen die meisten nur die ,Summary for Policymakers‘. Aber ist man sich der Tatsache bewusst, dass Politiker in wochenlangen Diskussionen jedem einzelnen Wort in dieser Summary zustimmen müssen? Die Wissenschaftler schreiben eine Vorlage für die Politiker, aber die Politiker debattieren über die Formulierung jedes einzelnen Satzes und ob dieser überhaupt in der Summary auftauchen sollte. Und jene wochenlangen politischen Debatten über die Summary for Policymakers finden unter Ausschluss der Öffentlichkeit statt.

Ebenso geht aus obigem Zitat hervor, dass der Inhalt der IPCC-Berichte dazu gedacht war, ein internationales Klimawandel-Abkommen zu unterstützen. Jener Vertrag aus dem Jahr 1992 ist bekannt unter der Bezeichnung United Nations Framework Convention on Climate Change (UNFCCC). Eine Ausgabe des UNFCCC gibt es hier. Unter der Überschrift von Artikel 2 – Objective – definiert das UNFCCC sein Ziel als die Begrenzung der Emission von Treibhausgasen (Hervorhebung von mir):

Die ultimative Objektive dieser Convention und jedweder damit in Beziehung stehender rechtlicher Instrumente, die zu übernehmen der Conference of Parties empfohlen wird, ist es, in Übereinstimmung mit den relevanten Vorschriften der Convention die Stabilisierung von Treibhausgas-Konzentrationen in der Atmosphäre zu erreichen auf einem Niveau, welches eine gefährliche anthropogene Interferenz mit dem Klimasystem verhindern soll.

Weil es die Objektive des UNFCCC-Vertrages ist, die Emissionen anthropogener Treibhausgase zu limitieren, und weil es das Ziel des IPCC ist, Berichte zu erstellen, die den Vertrag stützen, kann man mit einiger Sicherheit sagen, dass es die einzige Rolle des IPCC ist, wissenschaftliche Berichte zu erstellen, die die vermeintliche Notwendigkeit zur Begrenzung von Treibhausgas-Emissionen stützen. Hmmm. Könnte diese Vorgabe wissenschaftliche Untersuchungen und das Verständnis begrenzen?

Weiter unten im Einführungsabschnitt der History-Website des IPCC heißt es (Hervorhebungen von mir):

Heute ist es die Aufgabe des IPCC, definiert in den Principles Governing IPCC Work „… auf einer umfassenden, objektiven, offenen und transparenten Grundlage die wissenschaftlichen, technischen und sozio-ökonomischen Informationen abzuschätzen, die relevant sind hinsichtlich des Verständnisses der wissenschaftlichen Grundlage des Risikos eines VOM MENSCHEN INDUZIERTEN Klimawandels, dessen potentielle Auswirkungen und Optionen zur Anpassung und Abschwächung.

Die Tatsache, dass das IPCC all seinen Bemühungen auf das „Verständnis der wissenschaftlichen Basis der Risiken des vom Menschen verursachten Klimawandels“ konzentriert hat, ist sehr bedeutsam. Das IPCC hat niemals ernsthaft versucht zu bestimmen, ob nicht natürliche Faktoren für den größten Teil der Erwärmung verantwortlich sind, zu der es auf der Erde im vorigen Jahrhundert gekommen war. Jahrzehnte lang hat man dort Scheuklappen aufgesetzt, welche ihre Übersicht zu allem und jedem blockiert haben – außer zu den hypothetischen Auswirkungen von Kohlendioxid. Die Rolle des IPCC war es immer gewesen, Berichte zu erstellen, die die Reduktion von Treibhausgasen stützen, die bei der Verbrennung fossiler Treibstoffe entstehen. Die Folge hiervon ist, dass alle Forschungsgelder ausschließlich in diesen Bereich fließen. Die Entscheidung, nur die vom Menschen verursachte globale Erwärmung zu untersuchen, ist eine politische Entscheidung, keine wissenschaftliche Entscheidung. Und es ist eine furchtbare Entscheidung.

Als Folge dieser politischen Entscheidung gibt es kaum wissenschaftliche Forschungen, die versuchen, realistisch zu ermitteln, wie viel der Erwärmung natürlichen Faktoren zugeordnet werden kann. Wir wissen, dass diese Tatsache besteht, weil die jetzige Generation von Klimamodellen – bisher die komplexesten jemals – immer noch nicht natürlich auftretende Ozean-Atmosphäre-Prozesse simulieren können, die eine Erwärmung der Erdoberfläche (und der Tiefen der Ozeane) über multidekadische Zeiträume bzw. deren Beendigung mit sich bringen können. Skeptiker haben dieses wiederholte Scheitern oftmals in Blogbeiträgen beschrieben, und ich selbst habe sogar ein Buch über dieses Scheitern geschrieben mit dem passenden Titel Climate Models Fail.

…

(Ende Auszug)

Sogar noch dubioser: Verbiegen der Wissenschaft zur Unterstützung der Politik

Weiß man eigentlich, dass Politiker den Text des 2. IPCC-Zustandsberichtes überarbeitet haben, wobei sie den Entwurf der Wissenschaftler drastisch veränderten? Hier folgt noch einmal ein Auszug aus meinem frei verfügbaren E-Book On Global Warming and the Illusion of Control – Part 1. Der Auszug steht im Kapitel mit der Überschrift [übersetzt] Die Evolution der Bewegung der katastrophalen anthropogenen globalen Erwärmung:

Während es frühe wissenschaftliche Studien gab, die auf einen möglichen Temperaturanstieg in Verbindung mit den Emissionen von anthropogenen Treibhausgasen hinwiesen, wollen wir diese Diskussion beginnen mit der Bildung des Berichte schreibenden Flügels der UN mit der Bezeichnung Intergovernmental Panel on Climate Change (IPCC). Wie oben erwähnt war es die primäre Aufgabe des IPCC, Berichte zu erzeugen, die die Agenden der Politiker stützen. Die Begrenzung der globalen Erwärmung war wahrscheinlich einer dieser Schwerpunkte, aber höchstwahrscheinlich gab es auch noch viele andere.

Die Politiker fanden Wissenschaftler, die jene Berichte schrieben – und damit begann die gegenseitige sehr vorteilhafte Beziehung zwischen Klimawissenschaftlern und Politikern. Die Politiker wollten für ihre Agenden wissenschaftliche Stützung, und die Wissenschaftler waren nur zu gerne dazu bereit, weil den Politiker die Verteilung Gelder für Klimaforschung oblag.

Der erste IPCC-Bericht 1991 war wenig aufschlussreich dahingehend, dass die Wissenschaftler nicht zwischen anthropogener und natürlicher Erwärmung unterscheiden konnten…

Anmerkung für diesen Beitrag: Die Summary for Policymakers im 1. IPCC-Zustandsbericht steht hier. Dort heißt es:

Die Größenordnung dieser Erwärmung ist im Großen und Ganzen konsistent mit den Prophezeiungen der Klimamodelle, aber sie weist auch die gleiche Größenordnung auf wie die natürliche Klimavariabilität. Folglich kann die beobachtete Erwärmung großenteils dieser natürlichen Variabilität geschuldet sein. Alternativ kann es aber auch sein, dass diese Variabilität und andere menschliche Faktoren eine noch größere, anthropogen induzierte Treibhaus-Erwärmung ausgelöst haben. Die eindeutige Bestimmung des verstärkten Treibhauseffektes aus Beobachtungen ist noch mindestens ein Jahrzehnt lang unwahrscheinlich.

Im Jahre 1991 sah sich die wissenschaftliche Gemeinschaft also noch bis mindestens zum Jahr 2001 außerstande, zwischen natürlicher und anthropogener globaler Erwärmung zu unterscheiden.

(Ende Auszug)

Und doch haben Politiker trotz dieses unbestimmten Ergebnisses nur ein Jahr später (1992) einen Vertrag erarbeitet mit der Bezeichnung United Nations Framework Convention on Climate Change mit der Absicht, den Anstieg der globalen Temperaturen auf 2°C über den vorindustriellen Werten zu begrenzen – ein Limit, das zuerst Mitte der siebziger Jahre von einem Ökonom ins Spiel gebracht worden war, nicht von einem Klimawissenschaftler.

In dem Artikel Two degrees: The history of climate change’s ‘speed limit’ bei TheCarbonBrief schreiben die Autoren Mat Hope & Rosamund Pearce:

Für Manchen vielleicht überraschend kam die Idee, dass die Temperatur dazu herangezogen werden könnte, die Reaktion der Gesellschaft auf den Klimawandel zu dirigieren, von einem Ökonom.

…

In den siebziger Jahren sprach der Yale-Professor William Nordhaus erstmals die Gefahr an, die sich aus dem Überschreiten einer Grenze von zwei Grad ergeben, und zwar in einem Paar von inzwischen berühmten Studien, in denen gezeigt wurde, dass eine Erwärmung um über 2 Grad das Klima über einen Punkt hinaus bringen würden, mit dem die Menschen noch fertig werden konnten:

„Den meisten Quellen zufolge liegt die Bandbreite der Variation zwischen unterschiedlichen Klimaregimes in der Größenordnung von ±5°C, und zum gegenwärtigen Zeitpunkt befindet sich das globale Klima am oberen Ende dieser Bandbreite. Falls die globalen Temperaturen um mehr als 2 bis 3 Grad Celsius über der jetzigen mittleren Temperatur liegen, würde dies ein Klima schaffen, das außerhalb der Bandbreite von Beobachtungen liegt, die während der letzten vielen tausend Jahre gemacht worden sind“.

Anfang der neunziger Jahre fuhren die Politiker fort, mit Geld an Wissenschaftlern um sich zu werfen in der Hoffnung, dass der nächste Bericht mehr Unterstützung für ihre Agenden liefern würde. Sehr zur Überraschung der Politiker gab es jedoch auch im Original-Entwurf der Wissenschaftler aus dem Jahr 1995 der Summary zum 2. Zustandsbericht keinen Aufschluss.

Man stelle sich das mal vor. Im Jahre 1992 haben die UN viele Länder auf der ganzen Welt davon überzeugt, in einen Vertrag zur Begrenzung der Emissionen von Treibhausgasen einzutreten, obwohl das IPCC ein Jahr zuvor nicht den Fingerabdruck der Menschheit in der globalen Erwärmung auffinden konnte. Dann hat die wissenschaftliche Berichte schreibende Einrichtung der Politiker, das IPCC, im Jahre 1995 immer noch nicht unterscheiden können zwischen anthropogener und natürlicher Erwärmung – und genau diese Tatsache haben die Klimawissenschaftler im Entwurf ihres 2. IPCC-Berichtes geschrieben. Die Politiker saßen zwischen Pest und Cholera. Sie hatten seit drei Jahren einen Vertrag in der Hinterhand, aber ihre Berichte schreibenden Wissenschaftler konnten keine Beweise zu dessen Stützung finden.

Nachdem dann die meisten Wissenschaftler das Treffen verlassen hatten, änderten die Politiker und ein einzelner Wissenschaftler die Sprache des 2. Zustandsberichtes auf eine sehr subtile, aber bedeutende Art und Weise. Voila! Die Politiker und der eine Wissenschaftler initiierten das, was heute Konsens genannt wird. (Eine sehr detaillierte Analyse dazu von Bernie Lewin über die IPCC-Konferenz 1995 in Madrid steht hier).

…

(Ende Auszug)

Die Analyse von Bernie Lewin gliedert sich in drei Teile, jeweils mit sehr passenden Überschriften:

Madrid 1995: Was this the Tipping Point in the Corruption of Climate Science? (archived here.)

Madrid 1995 and The Quest for the Mirror in the Sky (archived here.)

Madrid 1995: The Last Day of Climate Science (archived here.)

In Teil 1 seiner Reihe schreibt Lewin über den Entwurf des 2. Zustandsberichtes (Hervorhebung von mir):

Oh weh, im Frühherbst des Jahres 1995 standen die Zeichen auf schlecht. Obwohl in einem durchgesickerten Entwurf im September zu lesen war, dass es unwahrscheinlich sei, dass die Erwärmung ausschließlich natürlichen Gründen geschuldet ist, wurde dies kaum bestritten, und es war nicht eigentlich die Verkündigung einer unmittelbar bevorstehenden Katastrophe. Außerdem verblieben immer noch außerordentlich große Schwächen, besonders in Kapitel 8, für jede positive Schlussfolgerung. Der Entwurf wurde allen Teilnehmern der Madrid-Konferenz zugeleitet und war auch der einzige Verfügbare, der schließlich auf dem Treffen ,akzeptiert‘ worden war. In der Introduction wurde auch festgestellt, dass die gegenwärtigen Studien auf einen menschlichen Einfluss hindeuten. Dies war bis dahin die stärkste Aussage, aber die Hauptfassung des Dokuments und die Zusammenfassung mit den Schlussfolgerungen war da nicht so vertrauensselig. Einige der verwegensten Rückzieher waren Folgende:

Aus Studien von Änderungen der globalen mittleren Variablen (8.4.1): Während keine dieser Studien das Thema Zuordnung speziell in Betracht gezogen hatte, ziehen sie oft einige Schlussfolgerungen bzgl. Zuordnung, für die es kaum eine Rechtfertigung gibt.

Aus dem Treibhaus-Signal in Studien der modellierten und beobachteten räumlichen und zeitlichen Verteilung von Änderungen (8.4.2.1): Keine der oben zitierten Studien hat klare Beweise dafür gezeigt, dass wir die beobachteten Änderungen der spezifischen Ursache Zunahme der Treibhausgase zuordnen können.

Aus Studien zum ,Fingerabdruck‘ der globalen Erwärmung: Während einige dieser Studien die Erkennung eines signifikanten Klimawandels behaupteten, hat keine davon die gesamte (oder Teile des beobachteten Klimawandels) anthropogenen Gründen zugeordnet. Auch hat keine einzige Studie die Größenordnung eines Treibhausgas- oder Aerosol-Effektes in den gemessenen Daten quantifiziert – ein Umstand, der für Politiker von primärer Relevanz ist.

Aus dem Gesamtniveau der Unsicherheiten: jedwede Behauptungen über positive Erkennung und Zuordnung eines signifikanten Klimawandels wird wahrscheinlich kontrovers bleiben, solange die Unsicherheiten bei der totalen natürlichen Variabilität im Klimasystem nicht reduziert werden.

Zur Frage: Wann wird der anthropogene Effekt auf das Klima identifiziert? (8.6): Es ist keine Überraschung, dass die beste Antwort auf diese Frage lautet ,wir wissen es nicht‘.

Die Politiker mochten die Aussagen über die Unsicherheiten nicht, die in jenen Statements zum Ausdruck kamen, folglich haben sie diese gelöscht. Wussten Sie, dass die Politik der Klimawissenschaft diktiert, welche Ergebnisse sie zu erbringen habe?

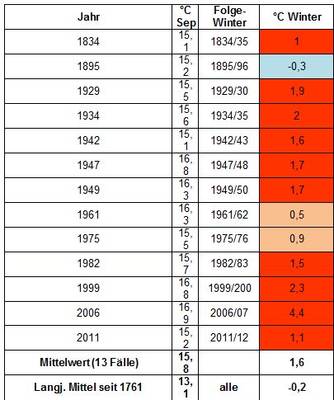

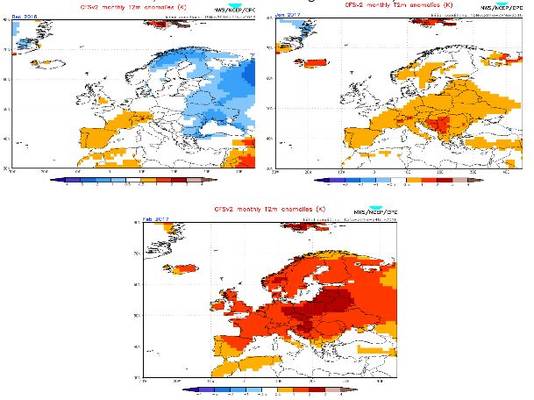

Wichtige Anmerkung: Man vergesse nicht, dass der Pinatubo im Jahre 1991 ausgebrochen war, wodurch die Temperaturen global vorübergehend gesunken sind. Während die Temperatur bis 1995 wieder auf ein Niveau etwas über dem von 1991 gestiegen war, erzeugten die in die Stratosphäre geschleuderten Aerosole des Pinatubo einen merklichen Rückgang der Erwärmungsrate seit dem Beginn der Erwärmung Mitte der siebziger Jahre. Siehe Abbildung 1. Das heißt, die globale Erwärmungsrate von 195 bis 1995 ist merklich geringer als die von 1975 bis 1991, wie man auch erwarten würde.

Abbildung 1

Nun könnte man glauben, dass mit der massiven Auswirkung des Pinatubo auf die globalen Temperaturen die fortgesetzte Unsicherheit unter den Klimawissenschaftlern auch 1995 noch garantiert war.

Die Klimawissenschaft unter Führerschaft des IPCC kann immer noch nicht realistisch differenzieren zwischen natürlicher und anthropogen induzierter globaler Erwärmung!

Noch einmal möchte ich auf mein E-Book zurückgreifen On Global Warming and the Illusion of Control – Part 1. Das Kapitel 1.12 trägt den Titel [übersetzt] „Wie Wissenschaftler den größten Teil der globalen Erwärmung seit Mitte der siebziger Jahre anthropogenen Ursachen zuordneten“:

Eine der Objektiven der klimawissenschaftlichen Gemeinschaft unter Führung des IPCC war es, den größten Anteil der globalen Erwärmung seit Mitte der siebziger Jahre anthropogenen Gründen zuzuordnen. Mit anderen Worten, falls Mutter Natur für die Erwärmung verantwortlich war, würde das politische Ziel, die Verbrennung fossiler Treibstoffe zu begrenzen, keinerlei Grundlage haben, und weil es die Absicht des IPCC ist, politische Agenden zu stützen, hatte die klimawissenschaftliche Gemeinschaft in der Lage zu sein, auf die Menschheit als den Schuldigen zu zeigen. Die Klimamodellierer erreichten dieses Ziel mittels ein paar sehr einfacher Tricks.

Das erste, was die Klimamodellierer gemacht haben war, die natürlichen Ozean-Atmosphäre-Prozesse vollständig zu ignorieren, die eine globale Erwärmung verstärken oder unterdrücken. Die vom IPCC verwendeten Klimamodelle können bis auf den heutigen Tag immer noch nicht diese Prozesse angemessen simulieren, und diese Tatsache wird später in diesem Buch noch detailliert demonstriert. Die Beiträge von Mutter Natur zu ignorieren war der einfachste und bequemste Weg, um zu zeigen, dass die Menschen für die Erwärmung verantwortlich waren. Die Modellierer haben sich auch entschieden, diese Tatsache der Öffentlichkeit vorzuenthalten, als sie ihre modellbasierten Zuordnungs-Studien unter Verwendung der nächsten Taktik präsentierten.

Diese Taktik ist ein sehr einfacher und leicht zu verstehender Weg, das Meiste der Erwärmung fälschlich der Menschheit in die Schuhe zu schieben. Die Modellierer hatten ihre Klimamodell-Läufe, die einen virtuellen globalen Temperaturanstieg zeigten als Reaktion auf alle Klimaantriebe, die als Input für die Modelle dienten. Dann führten sie zusätzliche Modellierungs-Experimente durch. Anstatt alle Klimaantriebe heranzuziehen, die sie normalerweise für die Simulation des Klimas der Vergangenheit eingehen lassen, verwendeten sie in den zusätzlichen Klimamodell-Läufen ausschließlich die Antriebe durch Solarstrahlung und vulkanische Aerosole. Die betrügerische Logik dahinter: Falls die nur mit den natürlichen Antrieben Solarstrahlung und vulkanischen Aerosolen die Erwärmung, zu der es zum Ende des 20. Jahrhunderts gekommen war, nicht simulieren können, dann muss die Erwärmung seit den siebziger Jahren auf anthropogene Treibhausgase zurückgehen.

Als Beispiel ist Abbildung 1.12-1 eine Zeitreihe von 1880 bis 2010. Die durchgezogene braune Linie zeigt den Gesamt- Strahlungsantrieb von allen Antrieben, die in die Klimamodelle eingingen und die vom GISS aufbereitet worden waren. Sie stammen von der Forcings in GISS Climate Model-Website, vor allem aus der Tabelle hier. Ebenfalls in Abbildung 1.12-1 eingezeichnet ist der Antrieb allein durch Solarstrahlung und stratosphärische Aerosole (welche das Sonnenlicht blockieren), gezeigt als gestrichelte dunkelgrüne Kurve. Diese werden als natürlich auftretende Antriebe betrachtet. Wie man sieht, zeigt die Gruppe mit allen Antrieben eine langzeitliche Zunahme, die bei den kombinierten Antrieben durch Sonne und Aerosole nicht erkennbar ist.

# # #

Dann ließen die Klimawissenschaftler die zusätzlichen Modellsimulationen nur mit den natürlichen Antrieben laufen. Danach verglichen sie die Modellsimulationen mittels natürlicher und anthropogener Antriebe mit denen mittels natürlicher Antriebe allein. Als Beispiel eines dieser Vergleiche dient Abbildung 1.12-2. Die Modelle mit allen Antrieben zeigen deutliche Erwärmung zum Ende des 20. Jahrhunderts, die Modelle mit den natürlichen Antrieben allein zeigen dies nicht.

Ähnliche Graphiken wie die in Abbildung 1.12-2 gezeigte finden sich in den IPCC-Zustandsberichten Nr. 4 und 5. Ein Beispiel ist FAQ 10.1, Abbildung 1 im Kapitel Chapter 10, Detection and Attribution of Climate Change: from Global to Regional des IPCC’s 5th Assessment Report (AR5). Siehe meine Abbildung 1.12-3. Man beachte, dass die Überschrift ihres FAQ 10.1 lautet [übersetzt] „Das Klima ändert sich immer. Wie können wir die Gründe der beobachteten Änderungen bestimmen?“

(Ende des Auszugs)

Über ihr FAQ 10.1, Abbildung 1, schreibt das IPCC:

FAQ 10.1, Abbildung 1 illustriert einen Teil der Abschätzung eines Fingerabdrucks auf die Änderung der globalen Temperatur während der zweiten Hälfte des 20. Jahrhunderts. Die beobachtete Änderung während dieser Zeit, dargestellt durch die schwarze Zeitreihe in den linken Graphiken, ist größer als erwartet, wenn man nur die interne Variabilität betrachtet. Simulationen mit nur natürlichen Antrieben (gelbe und blaue Linien in der oberen linken Graphik) reproduzieren die Erwärmung zum Ende des 20. Jahrhunderts nicht, wobei die räumliche Verteilung der Änderung (oben rechts) vollkommen unterschiedlich ist von der beobachteten Verteilung der Änderung (Mitte rechts). Simulationen mit sowohl natürlichen als auch anthropogenen Antrieben zeigen eine viel bessere Repräsentation der zeitlichen Änderungsrate (links unten) und der räumlichen Verteilung (rechts unten) der beobachteten Temperaturänderung.

Beide Graphiken links zeigen, dass Computermodelle die natürlich getriebene Abkühlung ein oder zwei Jahre nach großen Vulkanausbrüchen reproduzieren, wie es 1982 und 1991 der Fall war. Simulationen mit natürlichen Antrieben allein zeigen die kurzfristigen Temperaturänderungen nach Eruptionen auch, aber nur die natürlichen + anthropogenen Antriebe simulierten den längerzeitlichen Erwärmungstrend.

Die Bildinschrift ihrer FAQ 10.1-Abbildung liest sich so:

(Links) Zeitreihe der globalen und jährlich gemittelten Temperaturänderung von 1860 bis 2010. Die Graphik oben links zeigt Ergebnisse aus zwei (sic) Ensembles von Klimamodellen mit nur natürlichen Antrieben, gezeigt als dünne blaue und gelbe Linien; Ensemble-Änderungen der Mitteltemperatur sind dick blau und rot. Drei verschiedene beobachtete Schätzungen sind als schwarze Linien dargestellt. Die Graphik links unten zeigt Simulationen der gleichen Modelle, aber diesmal mit sowohl natürlichen als auch anthropogenen Antrieben durch Treibhausgase und Aerosole. (Rechts) Räumliche Verteilung lokaler Temperaturtrends von 1951 bis 2010. Die obere Graphik zeigt die Verteilung von Trends mittels eines großen Ensembles von Coupled Model Intercomparison Project Phase 5 (CMIP5)-Simulationen mit nur natürlichen Antrieben. Die untere Graphik zeigt Trends eines korrespondierenden Ensembles mit natürlichen + menschlichen Antrieben. Die mittlere Graphik zeigt die Verteilung beobachteter Trends von HadCRUT4 während dieses Zeitraumes. [HadCRUT4 = Hadley Centre/Climatic Research Unit gridded surface temperature data set 4]

Für ein weiteres Beispiel dieser fehlgeleiteten, kindischen Logik schaue man auf Figure 9.5 im 4. Zustandsbericht. Die Bildunterschrift zu dieser Illustration im AR4 Chapter 9 lautet (Hervorhebungen von mir):

9.4.1.2Simulationen des 20.Jahrhunderts

Inzwischen gibt es eine größere Zahl von Klimasimulationen von AOGCMs (Atmosphere-Ocean General Circulation Models) für den Zeitraum der globalen instrumentellen Aufzeichnungen, als sie für den 3. Zustandsbericht zur Verfügung standen, einschließlich einer größeren Vielfalt von Antrieben in einer größeren Vielfalt von Kombinationen. Diese Simulationen stammen von Modellen mit unterschiedlichen Klimasensitivitäten, Raten der Wärmeaufnahme durch Ozeane sowie Größenordnung und Art der Antriebe. Abbildung 9.5 zeigt, dass Simulationen einschließlich anthropogener Antriebe, darunter zunehmende Treibhausgas-Konzentrationen und die Auswirkungen von Aerosolen, die außerdem natürliche externe Antriebe berücksichtigen, eine konsistente Erklärung bieten der gemessenen Temperaturaufzeichnung. Simulationen mit nur natürlichen Antrieben simulieren die während der letzten drei Jahrzehnte beobachtete Erwärmung nicht.

Wie zuvor schon erwähnt, ist die Logik hinter dieser Art von Zuordnung sehr einfach, kindisch einfach. Falls Modelle mit anthropogenen und natürlichen Antrieben die Erwärmung simulieren können und die Modelle mit natürlichen Antrieben allein nicht, dann müssen die anthropogenen Antriebe für die globale Erwärmung verantwortlich sein.

Aber diese Logik ist falsch – entsetzlich falsch. Es gibt natürlich auftretende Ozean-Atmosphäre-Prozesse, die die globalen Temperaturen steigen oder sinken lassen können, ohne durch menschliche Treibhausgase getrieben zu werden. Die Klimamodelle simulieren diese Prozesse nicht, das heißt sie werden in Zuordnungs-Studien wie dieser nicht berücksichtigt.

Man kann das noch auf andere Weise betrachten. Eines der größten Mängel der Klimamodelle ist deren Unfähigkeit, natürlich auftretende Ozean-Atmosphäre-Prozesse zu simulieren … wie jene in Verbindung mit El Nino und La Nina-Ereignissen, wie jene in Verbindung mit der Atlantic Multidecadal Oscillation. Wie jedermann, der ein falsches Produkt vermarkten will, stellte das listige IPCC diese Mängel als Vorteile dar, indem sie in den Zuordnungs-Studien ignoriert werden.

Jawoll, das ist eine ziemlich erbärmliche Art und Weise, die jüngste Runde der globalen Erwärmung anthropogenen Treibhausgasen zuzuordnen.

Schlussbemerkungen

Hat also der gewählte Präsident Donald Trump recht, skeptisch zu sein hinsichtlich der politisierten Wissenschaft hinter der hypothetischen, anthropogen induzierten globalen Erwärmung/Klimawandel? Natürlich hat er recht!

Die Klimawissenschaft ist im Jahre 1988 politisiert worden, als die UN-Politiker das IPCC ins Leben riefen und ihm die Richtung vorgaben. Die Klimawissenschaft wurde von der Politik im Jahre 1995 korrumpiert, also vor über 2 Jahrzehnten, als die Politiker den Wortlaut des 2. IPCC-Zustandsberichtes änderten. Und natürlich können Klimawissenschaftler bis auf den heutigen Tag immer noch nicht anthropogene Gründe realistisch der globalen Erwärmung zuordnen, wie sie seit den siebziger Jahren beobachtet wird, weil die Klimamodelle nicht sich aus natürlichen Antrieben speisende gekoppelte Ozean-Atmosphäre-Prozesse simulieren können, die im multidekadischen Zeitmaßstab Erwärmung verursachen können. Die Tatsache, dass die Modelle keinerlei Erwärmung simulieren können, es sei denn sie werden durch numerische Repräsentationen anthropogener Treibhausgase dazu gezwungen, ist ein Mangel des Modells und kein Mittel, die globale Erwärmung glaubwürdig den Emissionen von Kohlendioxid zuzuordnen. Mit dieser Klimawissenschaft befindet sich der Karren immer noch vor dem Pferd.

Link: https://wattsupwiththat.com/2016/11/29/the-politicization-of-climate-science-is-not-a-recent-phenomenon/

Übersetzt von Chris Frey EIKE

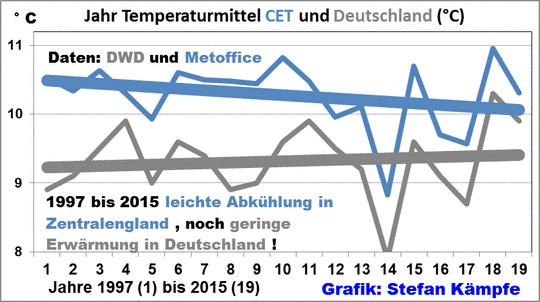

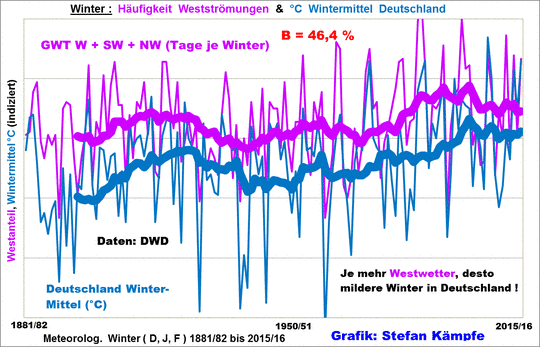

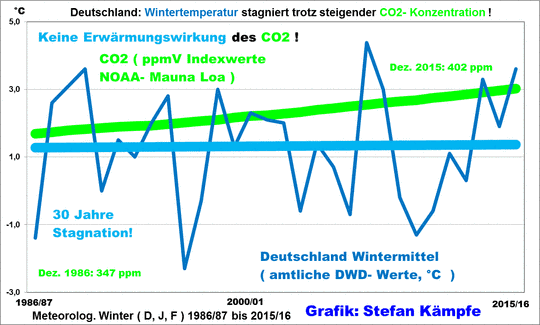

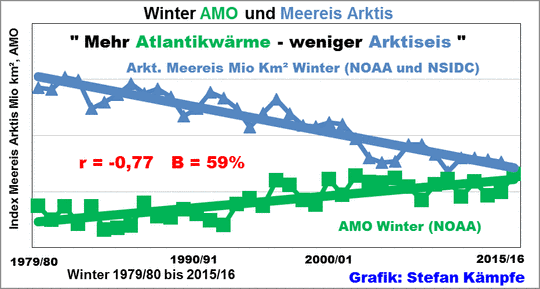

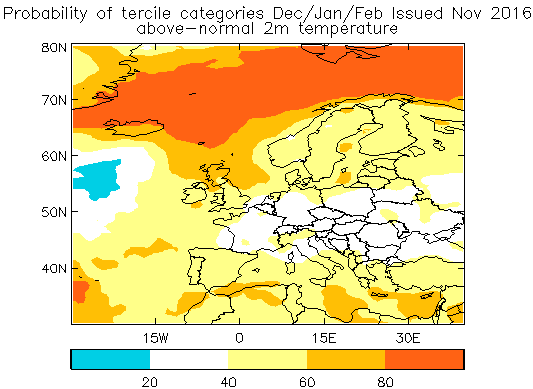

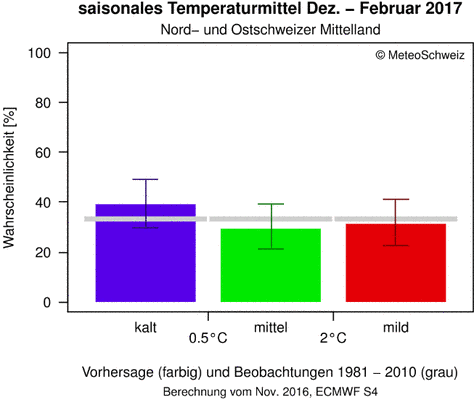

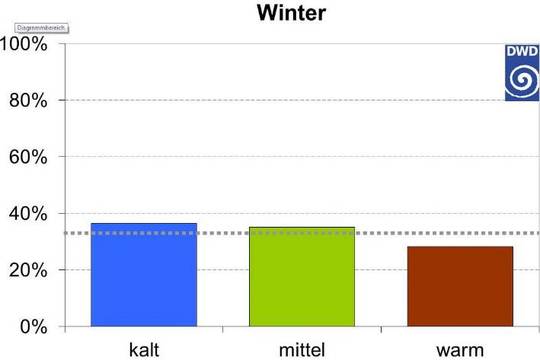

Grafik:

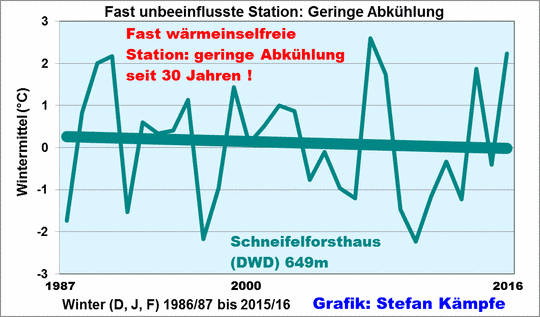

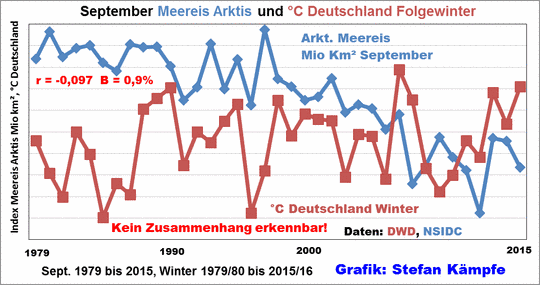

Grafik: