1. Wie lange Forschen Sie bereits an diesem Thema?

Das Thema Klimawandel und dessen Ursachen und Folgen beschäftigen mich schon seit vielen Jahren. Allerdings hat sich seit etwa 2007 mein Blickwinkel deutlich verändert. Sie erinnern sich vielleicht, damals wurde der 4. Sachstandsbericht des Weltklimarates (IPCC) publiziert und die Medien waren voll mit allen möglich Weltuntergangsszenarien.

Ich war zu dem Zeitpunkt noch einigermaßen überzeugt, dass an den Geschichten vom drohenden Weltuntergang durch die Freisetzung von CO2 etwas dran sein müsste. Ich war auch viele Jahre Lang Wähler der Grünen Partei in Deutschland.

Der Medienrummel im Jahr 2007 brachte mich dazu, mich daran zu erinnern dass ich als Chemiker, der sich einige Jahre mit der Forschung im Bereich CO2-Spektroskopie beschäftigt hatte, einmal einen genaueren Blick auf die Wissenschaft zur Erderwärmung werfen sollte.

Nun betreibe ich selbst keine Forschungsarbeit auf diesem Gebiet und würde meine Tätigkeit eher als Journalistisch bezeichnen. Allerdings liegt mein Interesse darin, Forschungsergebnisse auf ihre Konsistenz hin zu überprüfen. Ich habe schließlich eine wissenschaftliche Ausbildung genossen und einige Jahre selbst aktiv in der Forschung gearbeitet. Der kritische Blick den man dabei auf Forschungsergebnisse entwickelt bleibt einem fürs Leben.

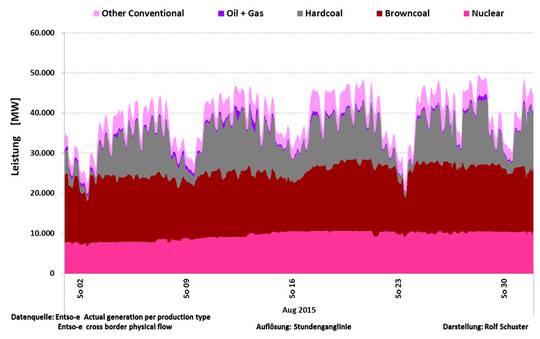

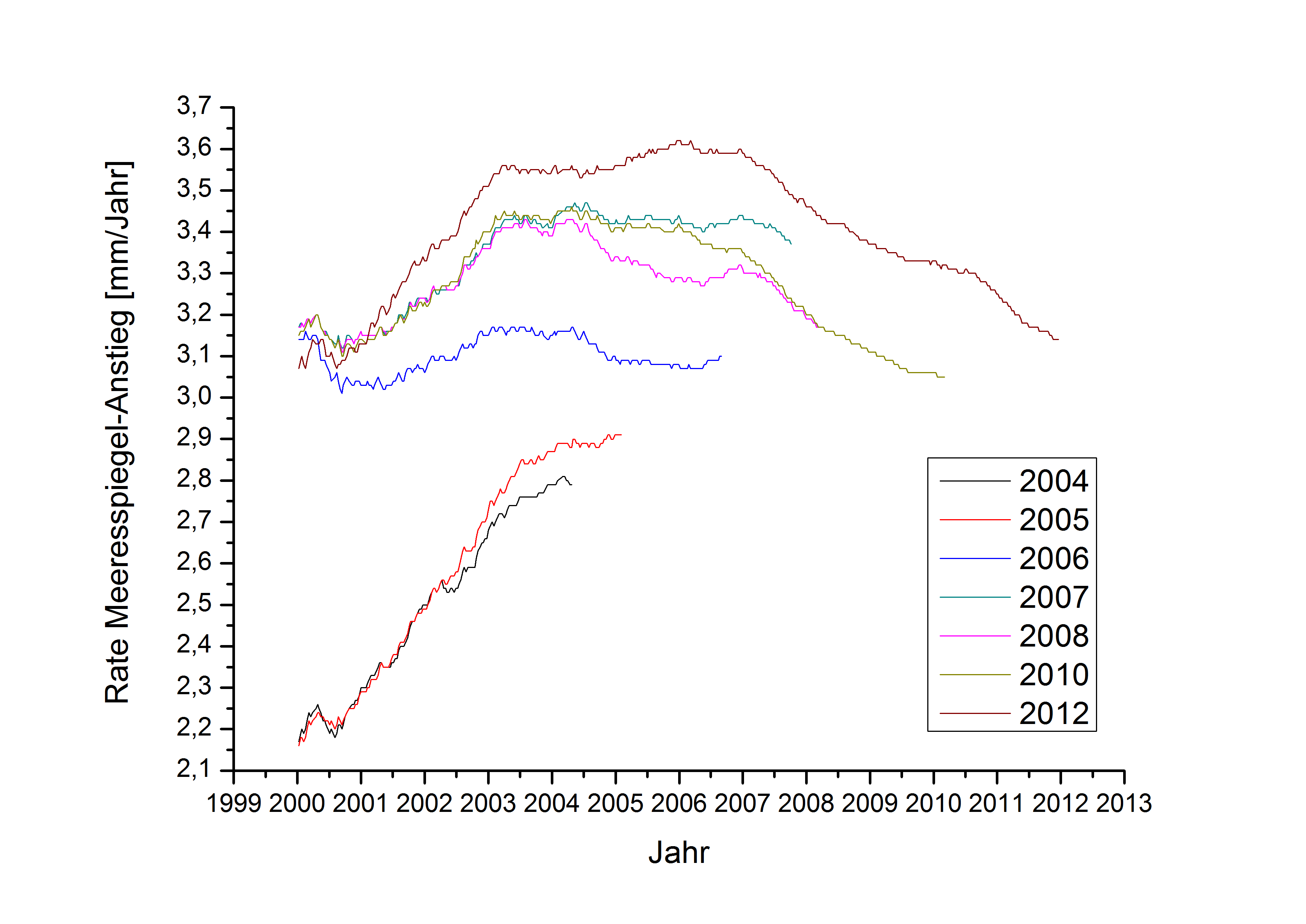

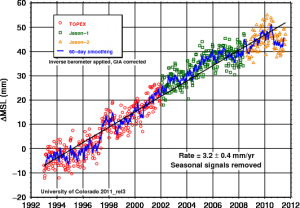

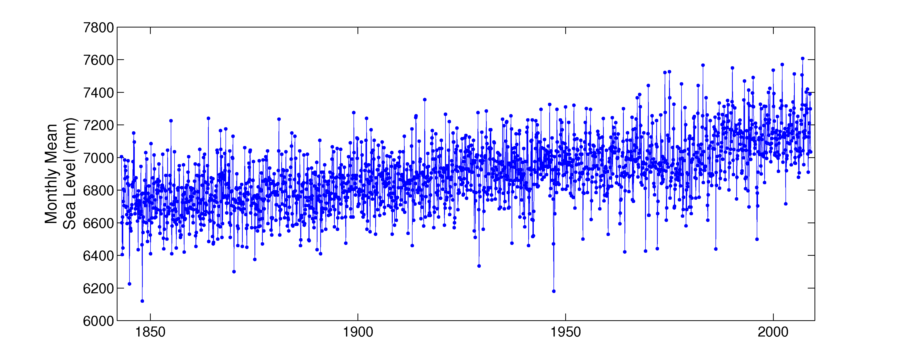

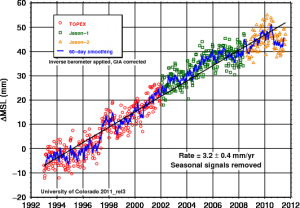

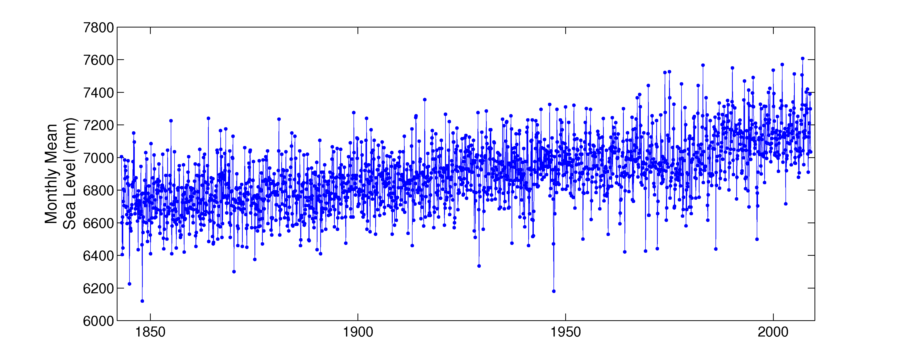

Der globale Meeresspiegelanstieg nach Satellitenmessungen

Um es kurz auf dem Punkt zu bringen: Die Wissenschaft hinter den Aussagen eines uns bevorstehenden dramatischen Klimawandels hat sich als deutlich weniger eindeutig erwiesen, als es die Pressemeldungen und auch die Aussagen vieler Klimawissenschaftler vermuten ließen. Wenn man genauer hinschaut stellt sich heraus, dass die ganzen Untergangs-Szenarien nicht auf Daten aus der realen Welt beruhen, sondern lediglich in Computermodellen stattfinden.

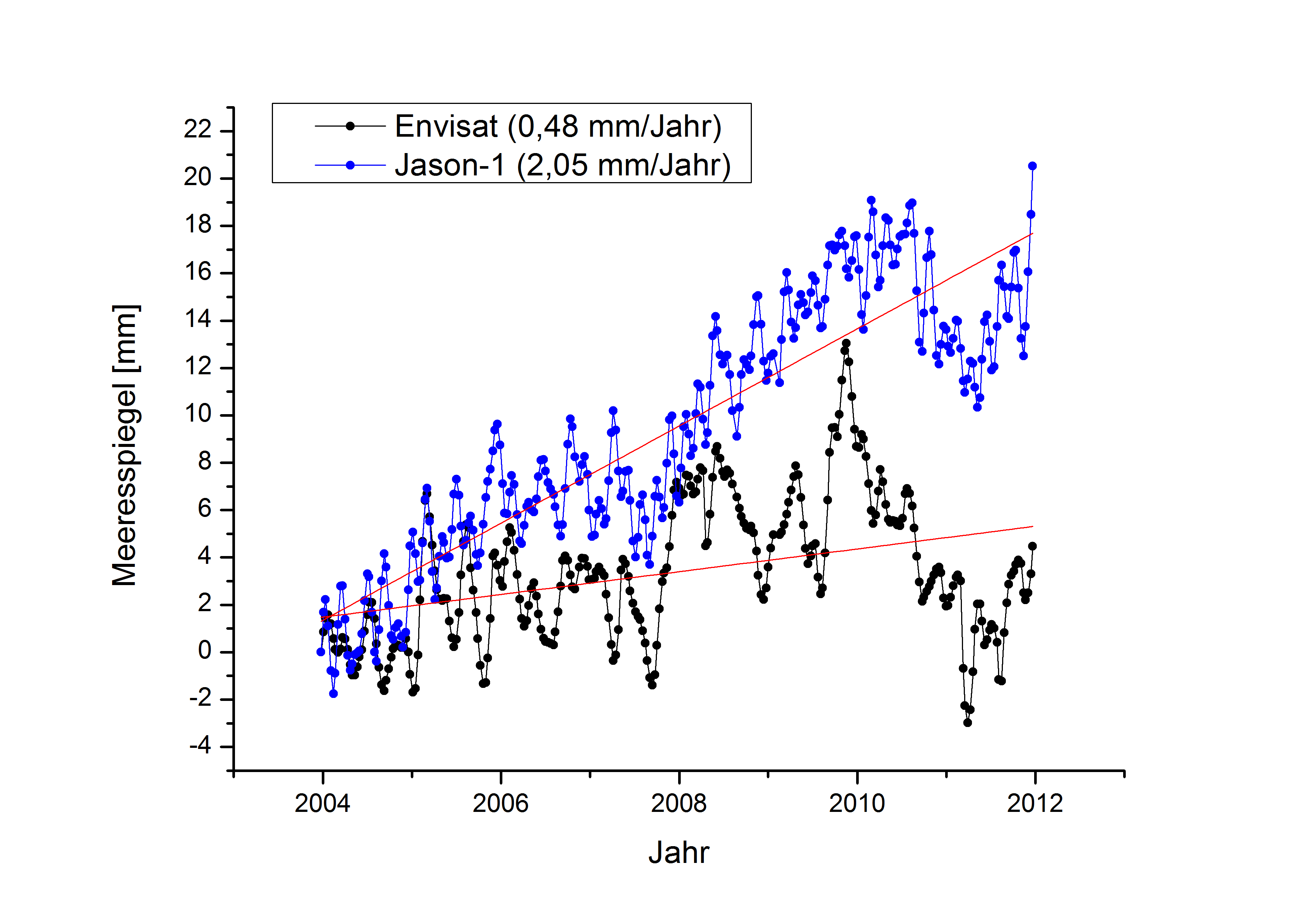

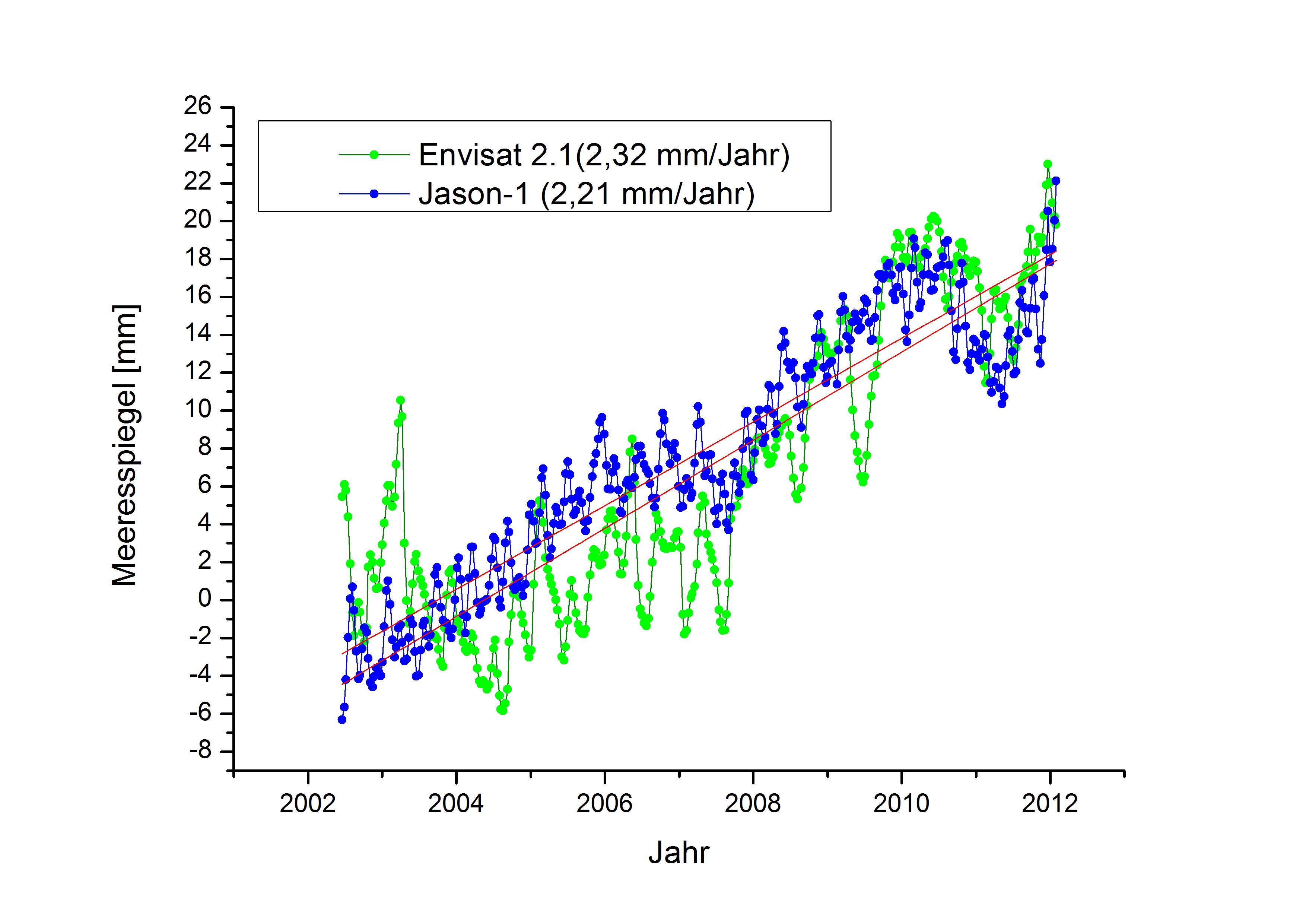

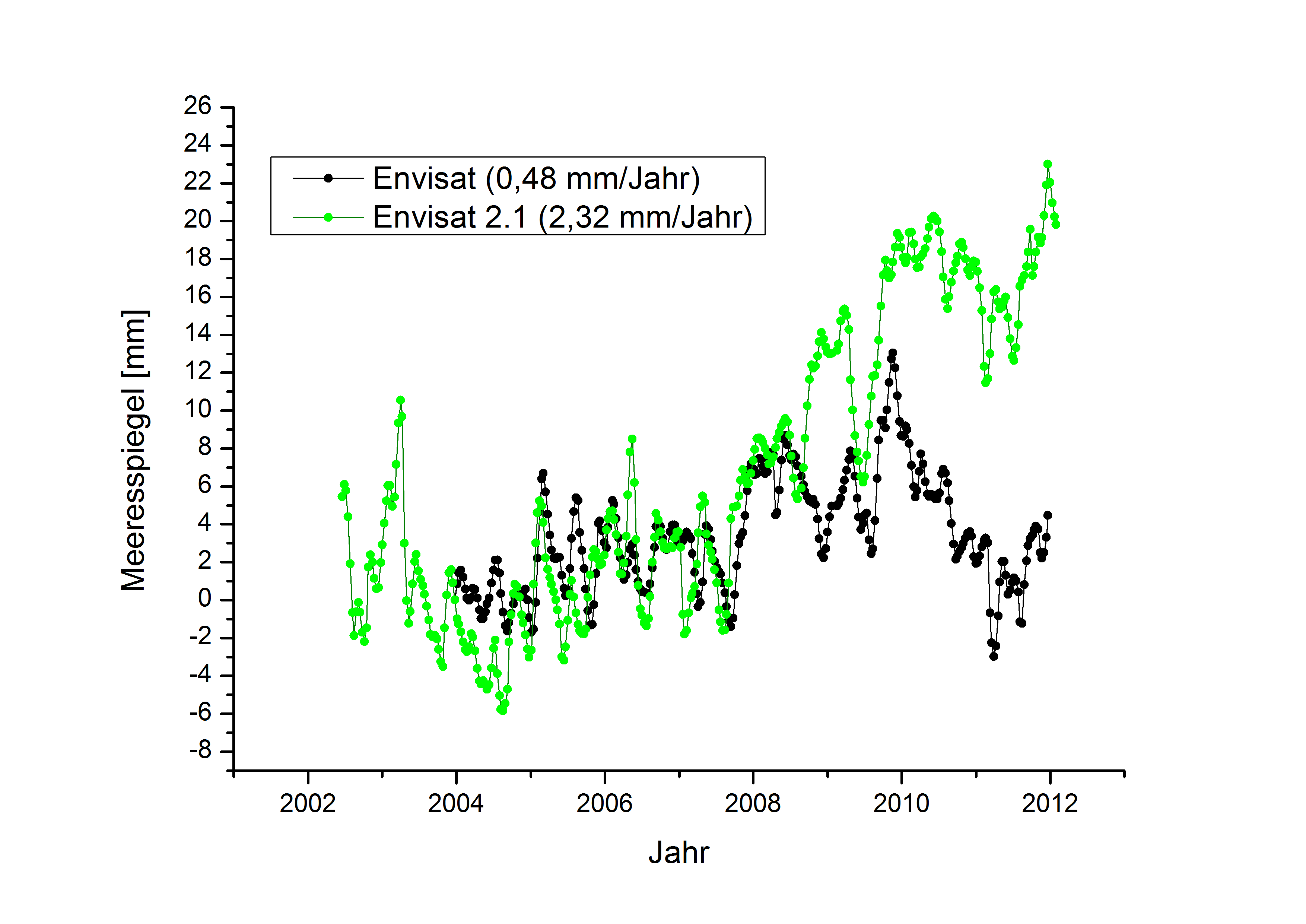

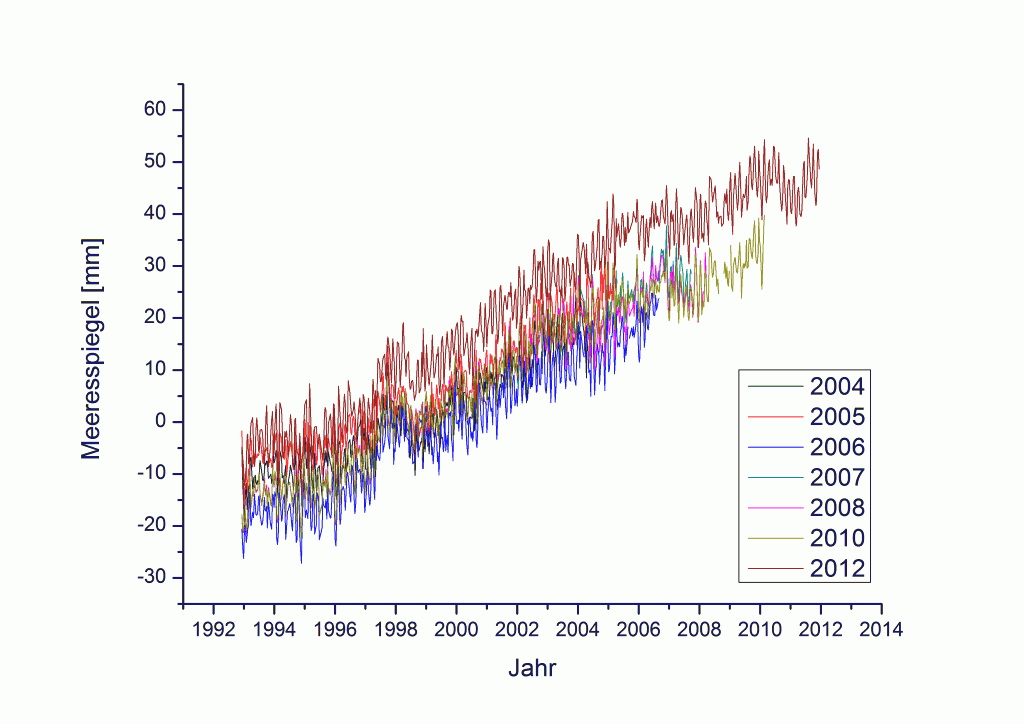

Dies wird gerade bei dem Punkt am deutlichsten, welcher gerne als das Schreckgespenst bei den Folgen der globalen Erwärmung in den Mittelpunkt gerückt wird – dem globalen Meeresspiegelanstieg. Wenn man nämlich etwas genauer in die Daten der weltweit verfügbaren Meeresspiegel-Pegelmessungen (hier als Plugin für Google Earth) schaut, oder die Ergebnisse von Satellitenmessungen ansieht, dann erkennt man den oft propagierten beschleunigten Anstieg der Meeresspiegel gerade nicht. Ganz im Gegenteil, seit 2005 nimmt die Geschwindigkeit, mit der der Meeresspiegel steigt sogar ab.

2. Was ist Ihre Motivation und Ihr Ziel dahinter?

Es war die Neugier, etwas mehr über die wirkliche Datenlage zu erfahren. Ich wollte nicht darauf angewiesen sein, meine Informationen nur aus zweiter oder dritter Hand zu beziehen. Ich wollte mir meine eigene Meinung bilden. Die österreichische Schriftstellerin Marie von Ebner Eschenbach hat das einmal ganz treffend auf auf den Punkt gebracht: „Wer nichts weiß, muss alles glauben.“ Oder wie es der deutsche Physiker und Kabarettist Vince Ebert formuliert: „Denken Sie selbst, sonst tun es andere für Sie.“

3. Wie sind Sie zu diesem Forschungsbereich gekommen?

Wie gesagt, ich bin selbst kein Forscher in dem Sinne, dass ich selber Daten aufnehme und auswerte. Ich habe einige Jahre in der Forschung gearbeitet und bin daher ganz gut in der Lage Forschungsergebnisse auszuwerten und zu beurteilen. Und das mache ich bei allen Themen die mich interessieren.

4. Wohin werden Ihre Resultate weitergeleitet?

Ich publiziere meine Arbeiten an verschiedenen Stellen. Das ist zum einen der von mir gegründete und in Zusammenarbeit mit anderen Autoren, darunter einigen Wissenschaftlern und Ingenieuren, betriebene Science Skeptical Blog. Außerdem publiziere ich regelmäßig Texte in bei Readers Edition, einer Plattform für Bürgerjournalismus, und im Debattenmagazin NOVO Argumente, dass als gedruckte Zeitschrift erscheint und dessen Inhalte teilweise auch im Internet verfügbar sind.

Ich mag es besonders, dass man sich dort einer öffentlichen Diskussion stellen muss. Das verlangt, dass man sich intensiv mit der Materie auseinandersetzt und nur Behauptungen aufstellt, die auch einer Überprüfung durch andere Experten standhält.

5. Mit welchen Methoden und Mitteln arbeiten Sie? Alleine oder in einem Team?

Ich arbeite zumeist mit Hilfe von Daten die frei im Internet verfügbar sind (hier eine kleine Sammlung). Dabei überprüfe ich statistische Auswertungen in Forschungsarbeiten oder setzte mich kritisch mit wissenschaftlichen Publikationen oder auch mit Pressemitteilungen von Forschungsinstituten, aber auch mit Artikeln die in den Medien wie etwa dem Spiegel oder Rundfunkberichten auseinander. Ich stehe dabei oft in Kontakt mit anderen Autoren, Ingenieuren und Wissenschaftlern. Das stellt sicher, dass man keine einseitige Sicht der Dinge bekommt und erhöht somit die Qualität der eigenen Arbeit. Ich nehme auch an wissenschaftlichen Konferenzen teil, sowohl von Forschern die von einem starken Einfluss des Menschen auf das Klima überzeugt sind, als auch an solchen von Wissenschaftlern, die eine andere Meinung vertreten.

6. Wie sicher sind die Resultate?

Ich halte mich bei meinen Arbeiten ausschließlich an Messergebnisse aus der realen Welt. Also Daten zur Temperaturentwicklung, zur Wolkenbedeckung oder zum Anstieg des Meeresspiegels. Viele Klimaforscher verlassen sich heute bei Ihren Projektionen in denen sie das Klima und damit auch den Meeresspiegelanstieg für die Zukunft vorhersagen möchten auf komplexe Computermodelle. Ich halte dieses Vorgehen für problematisch, weil man weder die Einflussgrößen hierfür bislang hinreichend verstanden hat, noch weiß, wie sich bestimmte Parameter in der Zukunft verändern werden. Der Weltklimarat (IPCC) hat das in seinem 3. Sachstandsbericht (TAR, 2001, Kapitel 14, Seite 771) auch noch sehr offen zugegeben (allerdings eher im „Kleingedruckten“. Unsere Politiker bekamen diese Aussage in der „Summary for Policy Makers“ nicht zu Gesicht.):

„The climate system is a coupled non-linear chaotic system, and therefore the long-term prediction of future climate states is not possible.“

„Das Klima-System ist ein gekoppeltes, nichtlineares chaotisches System; dadurch ist eine langfristige Voraussage des Klimas in der Zukunft nicht möglich.“

Im vierten Sachstandsbericht (AR4) fehlt dieser Hinweis. Obwohl sich an dieser grundlegenden Tatsache nichts geändert hat.

Grundsätzlich muss man anmerken, dass wissenschaftliche Ergebnisse immer nur eine Momentaufnahme darstellen können. Als Wissenschaftler muss man bereit sein, sich bei neuen Ergebnissen auch von liebgewonnenen Erkenntnissen zu verabschieden. Man muss bereit sein bei veränderter Faktenlage auch seine Meinung zu ändern. Man muss sein Leben lang skeptisch bleiben. Eine Geisteshaltung, die jeder denkende Mensch sein Leben lang bewahren sollte.

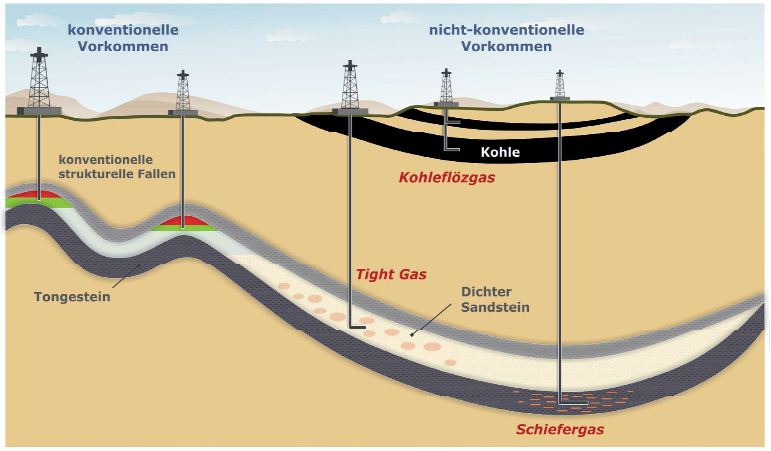

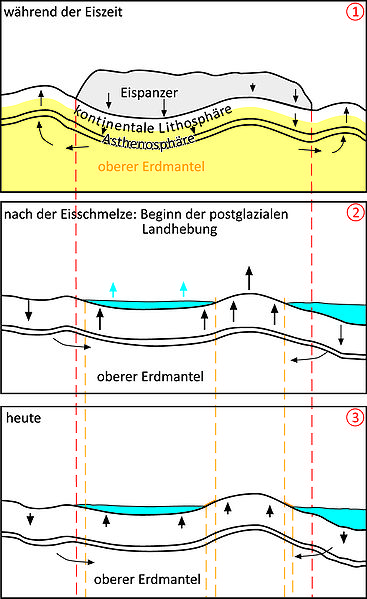

7. Was verursacht eine Meeresspiegelansteigung? (eventuell andere Gründe als Eis, welches schmilzt)

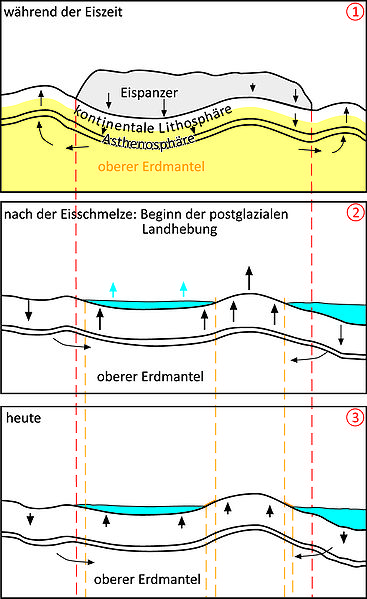

Ursachen und Ablauf der postglazialen Landhebung

Für einen Meeresspiegelanstieg gibt es verschieden Ursachen. Ein Hauptgrund dabei ist in der Tat die wechselnde Eisbedeckung der Kontinente. So lag der globale Meeresspiegel am Ende der letzten Eiszeit, bis vor ungefähr 10.000 Jahren, 120 Meter unter dem heutigen Niveau. Als dann die großen Eispanzer über Europa, Asien und Nordamerika geschmolzen sind, führte das zu einem Anstieg der Meeresspiegel. Die Auswirkungen davon erleben wir noch heute. Das führt unter anderem zu der etwas paradox anmutenden Situation, dass wir an manchen Stellen der Erde auch fallende Meeresspiegel beobachten, wie etwa in Skandinavien oder dem Norden von Großbritannien. Ursache dafür ist, dass die Gletscher der Eiszeit allein durch ihr Gewicht die Erdplatten in den Erdmantel gedrückt haben und diese auch heute noch „auftauchen“ und in eine gewisse „Schaukelbewegung“ geraten sind. Während der Norden der britischen Hauptinsel sich hebt (fallende Meeresspiegel) senkt sich der Südteil (steigende Meeresspiegel). Man nennt diesen Vorgang auchpostglaziale Landhebung.

Ein weiterer Grund, warum Meeresspiegel steigen können, ist die thermische Ausdehnung des Wassers (Bei Erwärmung nimmt das Volumen zu). Seit dem Ende der kleinen Eiszeit (etwa 1500-1850) erleben wir daher einen Meeresspiegelanstieg von 20-30 cm in 100 Jahren. Die Schwankungen der Meeresspiegel in den letzten Jahrhunderten (Abbildung 3 hier), ist nach Ansicht vieler Wissenschaftler zum großen Teil auf diesen Effekt zurückzuführen.

In den letzten Jahren wird der Fokus gerne auf den Rückgang der Eisbedeckung in der Arktis gelegt. Das imarktischen Meer treibende Packeis geht in der Tat seit dem Beginn der präzisen Messung mit Satelliten im Jahr 1978 zurück. Diese Eisschmelze leistet allerdings praktisch keinen Beitrag zur Entwicklung der Meeresspiegel. Dabei sollte man auch anmerken, dass die Eisbedeckung in der Antarktis sich im gleichen Zeitraum vergrößert hat, so dass die globale Eisbedeckung in diesem Zeitraum in etwa konstant geblieben ist. Aber wie gesagt, auf den Meeresspiegel hat dieses Eis so gut wie keine Auswirkung.

Auch die seit dem Ende der kleinen Eiszeit schmelzenden Gletscher in den Alpen oder im Himalaja haben auf der Entwicklung der Meeresspiegel nur einen sehr geringen Einfluss.

8. Wie schnell kann der Meeresspiegel ansteigen? Und wie viele Meter in welcher Zeit?

In der Erdgeschichte ist der Meeresspiegel immer in Bewegung – aufwärts und abwärts. Auf dem Höhepunkt der letzten

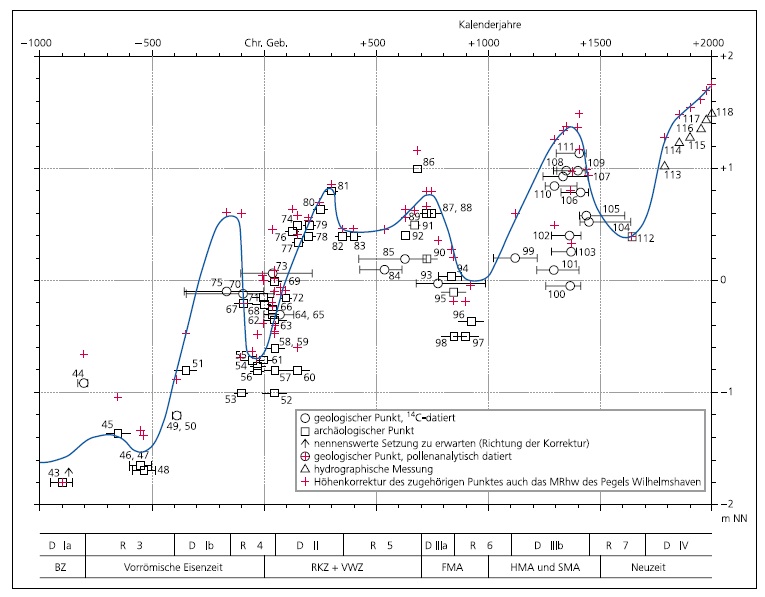

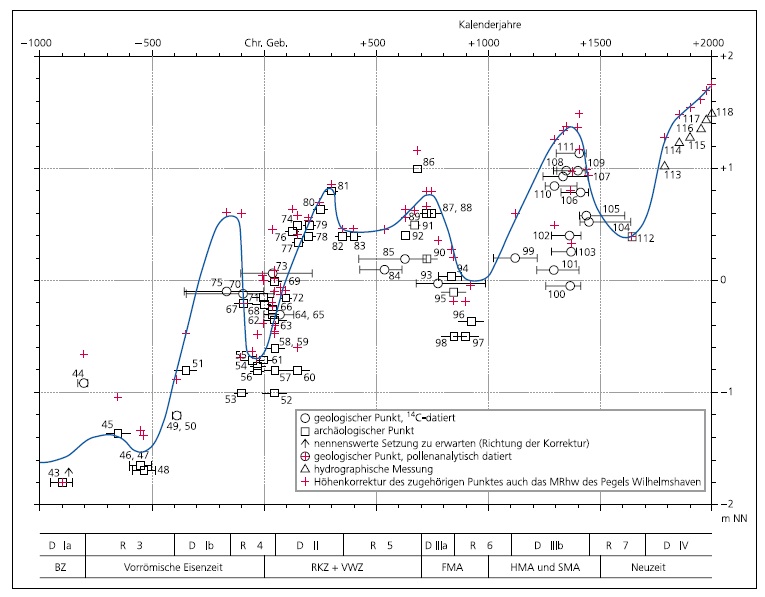

Regressionen und Transgressionen an der südlichen Nordseeküste

Eiszeit (vor ca. 20.000 Jahren) lag der Meeresspiegel um ca. 140 Meter unter dem heutigen Niveau. Seither und bis heute ist er im Wesentlichen angestiegen, allerdings insbesondere in den letzten 3000 Jahren immer wieder unterbrochen von kurzzeitigem Zurückweichen. Der Anstieg in der Zeit zwischen 7000 und 5000 vor Christus lag der Anstieg etwa bei 12,5 Meter in 1000 Jahren. 12.000-10.000 Jahre vor unserer Zeit vermutlich sogar bei 15 Metern in 1000 Jahren.

Diese Entwicklung ist z.B. für die deutsche Nordseeküste anhand von Sedimenten (Torfmoore) und archäologischen Daten wissenschaftlich detailliert untersucht worden (Abbildung 2 und 3 hier). Seit 1600 bis heute ist die Nordsee um 135 cm gestiegen. Das sind im Mittel 34 cm/Jh. Somit liegt der Anstieg des Cuxhavener Pegels von 1900 bis 2000 mit 25 cm eher im unteren Randbereich der naturgegebenen Schwankungen (Abbildung 4 hier).

9. Welches sind die historischen Hintergründe? (Seit wann beschäftigt man sich damit?)

Das Thema Fluten und steigende Wasserspiegel zieht sich durch die gesamte Menschheitsgeschichte. So ist in der Bibel und auch schon im wesentlich älteren babylonischen Gilgamesch Epos wird von Sintfluten berichtet, welche dort die Gottheiten den Menschen als Strafe schicken. Inwieweit diese Geschichten mit wirklichen historischen Flutereignissen in Zusammenhang stehen ist unter Historikern umstritten.

Der Pegel der Station Cuxhaven wird seit 1843 gemessen

Die am längsten messende Station der PSML-Stations liegt im französischen Brest. Dort wird der Meeresspiegel seit 1807 mit wenigen Unterbrechungen gemessen. Die älteste Messstation in Deutschland liegt in Cuxhaven und liefert seit 1847 ununterbrochen Messwerte.

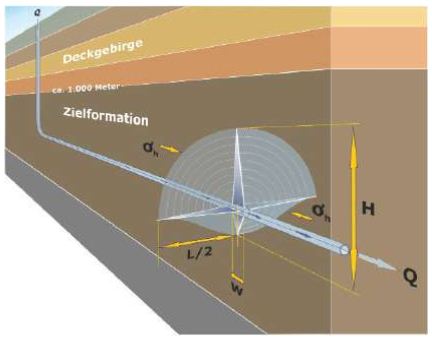

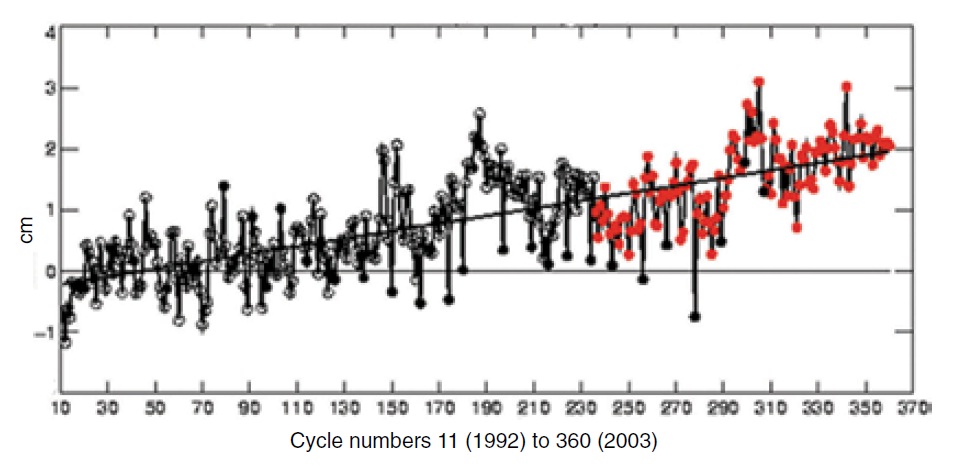

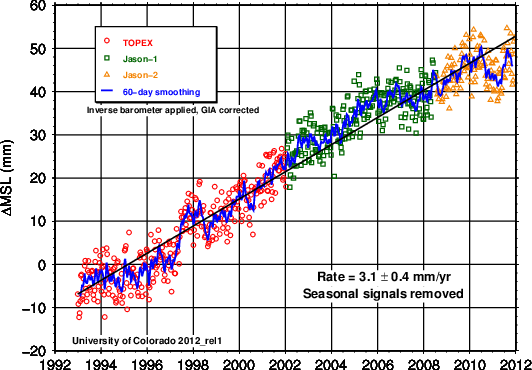

Eine neue Ära der Messung des globalen Meeresspiegels begann 1992, als mit dem Topex Satelliten erstmals der Meeresspiegel aus dem Weltraum gemessen werden konnte. Seit 2002 werden die Messungen von Jason-1 und Jason-2 unternommen.

Seit 2004 werden solche Daten auch vom Europäischen Envisat Programm gemessen. Die Messdaten kann manhier herunterladen, eine Grafik findet sich hier.

10. Sind eventuell schon Städte wegen des Anstiegs des Meeresspiegels untergegangen, oder Beschädigt worden?

Soweit ich weiß gibt es keine Belege dafür, dass in historischer Zeit Städte wegen steigender Meeresspiegel verschwunden sind. In der Zeit der stärksten Anstiege (bis ca. 5.000 Jahre vor der heutigen Zeit) gab es auch kaum größere Siedlungen.

In historischem Zeitraum sind durch Sturmfluten immer wieder ganze Landstriche verwüstet worden. So vielen etwa der ersten Marcellusflut am 16. Januar 1219 in Norddeutschland und den Niederlanden etwa 36.000 Menschen zum Opfer. Die sogenannte Grote Mandränke im Januar 1362 hat bis zu 100.000 Opfer an der deutschen und niederländischen Küste gefordert. Solche Ereignisse sind heutzutage aufgrund von Deichbau und anderen Küstenschutz Maßnahmen zum Glück nicht mehr zu erwarten.

11. Welche Gefahren stellt der Anstieg des Meeresspiegels dar?

Ein Anstieg der Meeresspiegel der Größenordnung die wir heute beobachten (10-30 cm in 100 Jahren) stellt keine Gefahr dar. Beim Deichbau etwa in Deutschland wird diese Entwicklung seit langem berücksichtigt. Auch die vom Weltklimarat im letzten Bericht (AR4) prognostizierten Werte von 18-59 cm in 100 Jahren sind absolut beherrschbar.

Und auch die vielfach beschworenen Gefahren für Korallen-Inseln wie etwa Tuvalu oder die Malediven sind bei näherer Betrachtung so nicht vorhanden. Wie Forschungen in jüngster Zeit gezeigt haben, wachsen Koralleninseln bei steigenden Meeresspiegeln einfach mit. Nur so haben sie schließlich den Anstieg in den letzten Jahrtausenden überstehen können.

12. Was passiert mit den naheliegenden Städten bzw. Gebäuden? (Evtl. Verschiebung des Fundaments, Abtrennung der Stadt, Untergang, …)

Bei dem aus heutiger Sicht zu erwartenden Anstieg und der Möglichkeit sich durch Deichbaumaßnahmen anzupassen – nichts.

13. Was passiert, wenn sich das Gegenteil beweist, also einen sinkenden Meeresspiegel?

Auch hier gilt: Eine dramatische Veränderung ist in näherer und auch in mittelfristiger Zukunft nicht in Sicht. Daher wäre hier jede Aussage unbegründete Spekulation.

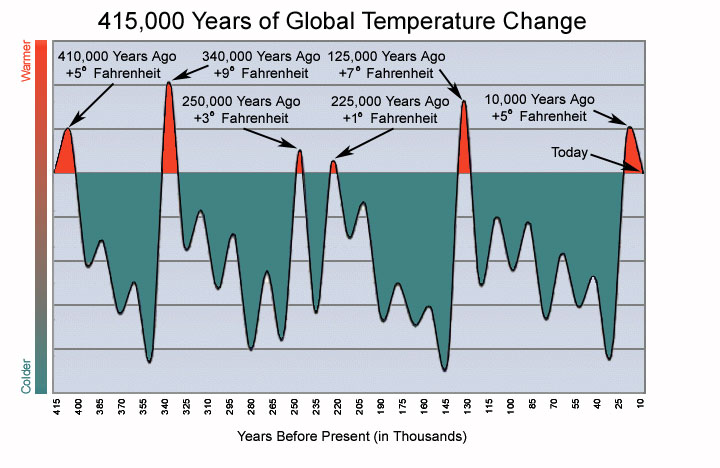

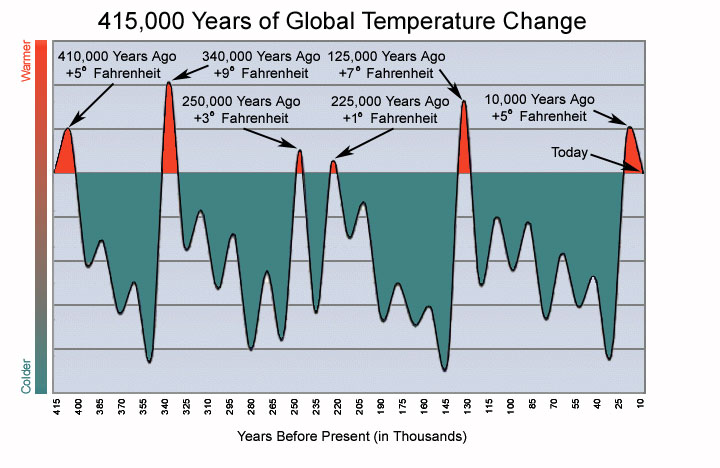

Temperaturschwankungen der letzten 415.000 Jahre

Langfristig könnte der Fall etwas anders liegen. DieMessdaten aus Eisbohrkernen in der Antarktis zeigen uns, dass wir uns seit etwa 10.000 Jahren in einem Interglazial (=Zwischeneiszeit) also einer relativ warmen Periode innerhalb einer Eiszeit befinden, die seit etwa 2,7 Millionen Jahren andauert. Was man vor allem aus den Eisbohrkernen ablesen kann ist, dass die Zwischeneiszeit bisher immer wieder in Eiszeiten umgeschlagen sind. Manche Interglaziale dauerten kaum länger als 10.000 Jahre. Es liegt also nahe, dass wir in Zukunft wieder einen Zustand des Klimas bekommen, bei dem große Teile der nördlichen Hemisphäre von riesigen Eisschilden bedeckt sind. Das würde dann wieder mit fallenden Meeresspiegeln verbunden sein. Allerdings wäre bei solch dramatischen Klimaveränderungen ein fallender Meeresspiegel nur eines von vielen Problemen.

14. Denken Sie dass die Menschheit überhaupt noch im Stande ist, gegen die Erderwärmung anzukämpfen?

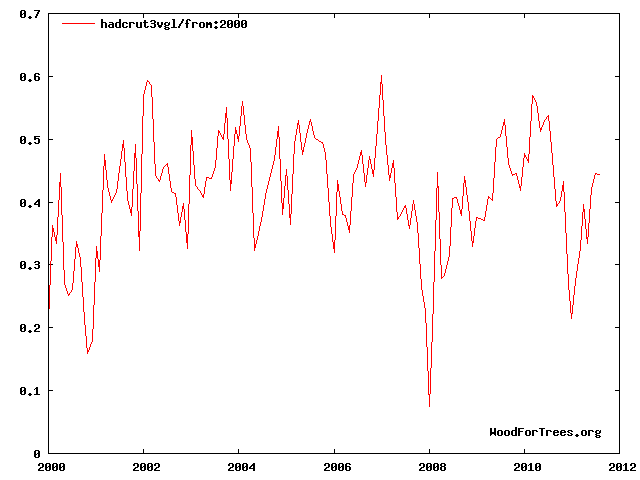

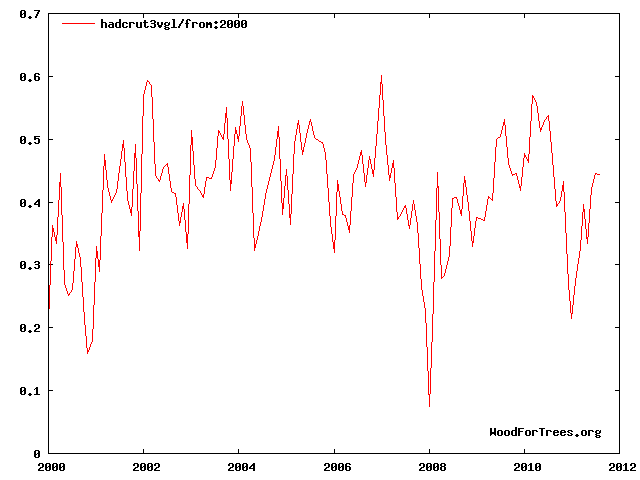

Die Entwicklung der Globaltemperatur seit 2000 (Quelle: HadCRUT)

Wie oben beschrieben, halte ich die Aussagen mancher Klimaforscher, dass das Klima hauptsächlich durch Schwankungen im CO2-Gehalt in der Atmosphäre bestimmt würde, für wissenschaftlich nicht haltbar. Auch die Tatsache, dass es seit mehr als 10 Jahren nicht mehr wärmer wird nicht gerade für einen sehr großen CO2-Einfuss auf das Klima.

Und auch wenn man an einen großen Einfluss durch CO2 auf das Klima glaubt, sind die bisher getroffenen Maßnahmen (wie etwa das Kyoto-Protokoll) nicht in der Lage die befürchtete Erwärmung maßgeblich zu beeinflussen. Der Dänische Statistikprofessor Björn Lomborg, ein früheres Mitglied bei Greenpeace, hat in seinem Buch „The sceptical Environmentolist“ (auf DeutschApokalypse No!) dargelegt, dass selbst eine vollständige Umsetzung des Kyoto-Protokolls die vom IPCC prognostizierte globale Erwärmung lediglich um 6 Jahre nach hinten verschieben würde (Hier ein Vortrag von Lomborg mit deutschen Untertiteln).

Stattdessen plädiert Lomborg dafür, die gigantischen Summen die bislang zur Vermeidung eines Klimawandels eingesetzt werden (es geht dabei um hunderte Milliarden Euro), für Anpassungsmaßnahmen zu verwenden und vor allem in die Bekämpfung der wirklich akuten heutigen Probleme der Menschheit zu investieren. Um die drängendsten Probleme zu ermitteln hat er eigens den Kopenhagen Konsensus ins Leben gerufen, bei dem versucht wird auf der Basis von ökonomischen Kosten-Nutzen-Analysen Prioritäten zu setzen für die wichtigsten Herausforderungen der Menschheit. Oben auf der Liste landeten dabei die Versorgung von Kindern mit Mikronärstoffen, Impfungen für Kinder, Verbesserung des Schulunterrichts für Mädchen, Unterstützung von Frauen bei Familienplanung und Mutterschaft, oder Malaria-Prävention und Behandlung.

15. Was denken Sie, sind sich die Bewohner solcher Städte der Gefahr bewusst?

Wie dargelegt bin ich der Überzeugung, dass auf absehbare Zeit der Anstieg des Meeres keine Gefahr darstellt. Das sehen die meisten Menschen auf der Welt ähnlich. In Staaten wir Großbritannien oder den USA ist die Zahl derer, die einen menschgemachten Klimawandel für bedrohlich halten, seit Jahren rückläufig.

Und in vielen Städten auf der Welt haben die Menschen tagtäglich mit realen und wesentlich existenzielleren Problemen zu kämpfen. Die Sorge um eine mögliche Veränderung des Klimas in 100 Jahren ist global gesehen beschränkt auf reiche und satte Menschen in westlichen Ländern.

16. Denken Sie das Interesse der Bevölkerung eines gefährdeten Landes/Stadt sind sich der Tatsache bewusster und interessierter als der Bevölkerung eines unbetroffenen Landes/Stadt?

Diese Frage ist in der Form eigentlich nicht zu beantworten. Schließlich gibt es bislang kein Land auf der Welt, dass belegbar unter den Folgen eines menschengemachten Klimawandels zu leiden hätte. Natürlich haben wir es auch heute mit Naturkatastrophen zu tun, denen immer wieder tausende Menschen zum Opfer fallen.

Das war in der Vergangenheit so und wird auch in Zukunft so sein. Auch ist bei diesen Naturkatastrophen, wie etwa Wirbelstürmen oder Überschwemmungen, kein Trend erkennbar, der auf eine Zunahme durch menschliches Handeln schließen ließe. Die Zahl und Energie der Wirbelstürme (Hurrikans, Taifune) etwa ist momentan auf einem der niedrigsten Stände der letzten Jahre.

Lediglich die Berichterstattung in den Medien hat sich deutlich gewandelt. Heute neigen die Nachrichtenschaffenden gerne dazu, jeden starken Sturm, jeden warmen Sommer und teilweise auch strenge Winter auf eine menschengemachte globale Erwärmung zurückzuführen. Das hat aber mit Wissenschaft nichts zu tun. Das ist Propaganda.

17. Wenn Sie der Präsident einer solchen Stadt wären, welche Massnahmen würden Sie ergreifen um Ihre Stadt zu schützen?

(Die hier zuvor gezeigte Karte "Landgewinnung in den Niederlanden" wurde aus urheberrechtlichen Gründen entfernt; Die Redaktion 12.2.16)

Für einen Präsidenten eines Küsten- oder Inselstaates sollte der Küstenschutz seit je her eine sehr hohe Priorität genießen. Und außerdem kann man durch Landgewinnungsmaßnahmen sogar noch Flächen dazu gewinnen. Die Niederländer machen seit Jahrhunderten sehr erfolgreich vor, wie das geht. Und so sind es auch niederländische Deichbau-Ingenieure, die Bangladesch heute dabei helfen, durch passende Dämme die Fläche des Landes zu vergrößern.

Natürlich könnte man auch den Weg gehen, den etwa der Präsident der Malediven, Mohamed Anni Nasheed, eingeschlagen hat. Dieser nutzt den Rummel um die angeblich dramatisch steigenden Meeresspiegel, um daraus politisches Kapital zu schlagen. Etwa indem er Ausgleichszahlungen von den Industrieländern fordert, oder die florierende Tourismusindustrie in seinem Land mit Sonderabgaben belegen will – vorgeblich um damit irgendwann eine neue Heimat in Indien oder Australien für seine vom Untergang bedrohten Landsleute zu erwerben.

18. Mit welchen Maßnahmen schützen Sie die Umwelt?

Um die Umwelt wirklich sinnvoll zu schützen bedarf es aus meiner Sicht etwas mehr, als was ein einzelner zu bewegen imstande ist. Einfache Maßnahmen, wie etwa keinen Müll in die Landschaft zu werfen oder Gefahrstoffe der richtigen Verwertung zuzuführen. Dass ich nicht unnötig mit dem Auto durch die Gegen fahre, nicht das Licht brennen lasse wenn ich es nicht brauche oder nicht unnötig heize, dazu entscheide ich mich ganz freiwillig, allein schon aus Kostengründen.

Heutzutage werden Umweltschutz und Klimaschutz gerne gleichgestellt. Wobei bei näherem Hinsehen Klimaschutz dem Umweltschutz häufig direkt widerspricht. Windräder sollen gut für das Klima sein und werden mittlerweile auch in Naturschutzgebieten aufgestellt. In Deutschland werden riesige Flächen in Mais-Monokulturen umgewandelt, damit man daraus Biogas gewinnen kann. Die (zwangs-)Beimischung von Biosprit in unseren Kraftstoffen führt dazu, dass Urwälder in Palmölplantagen umgewandelt werden und gleichzeitig die Nahrung für die Ärmsten Menschen knapp und teuer wird. Energiesparlampen belasten bei der Herstellung und der Entsorgung Mensch und Umwelt mit giftigen Quecksilberdämpfen. Diese Liste ließe sich beliebig fortsetzen.

Windkraftanlagen in Nissenshörn in Schleswig-Holstein

Diesen Umstand, dass die Umweltschutzbewegung sich über den Klimaschutz immer weiter von den eigenen Idealen wegbewegt, hat der deutsche Publizist und Autor Michael Miersch sehr treffend auf den Punkt gebracht:

„Das grüne Trauerspiel erinnert an die Geschichte einer anderen Weltanschauung. Kaum war der Sozialismus an der Macht, passierte das exakte Gegenteil dessen, was seine Propheten einst gepredigt hatten: Die Arbeiter wurden immer ärmer, und sie hatten weniger demokratische Rechte. Was den Sozialisten die Arbeiterklasse, ist den Grünen die Umwelt.“

19. Was müsste passieren, damit sich die Bevölkerung der Folgen bewusst wird?

Der Folgen wessen? Der Folgen eines Klimawandels, der bislang nur in den Großrechnern stattfindet und in 100 Jahren in die Katastrophe führen soll, weswegen wir heute immense Summen für wenig wirksamen und teilweise äußerst umweltschädliche Maßnahmen stecken?

Mittel, die uns an anderer Stelle fehlen, damit wir die heute drängenden Probleme, wie den Hunger auf der Welt, eine unzureichende Versorgung mit sauberem Wasser oder eine katastrophale medizinische Versorgung in den Entwicklungsländern lösen können.

Oder fragen Sie was passieren müsste, damit sich die Bevölkerung der Folgen einer sogenannten Umweltschutzpolitik bewusst wird, die über das Vehikel Klimaschutz den Schutz der Umwelt schon lange aus dem Fokus verloren hat? Hier würde ich mir wünschen, dass die Medien, welche sich schließlich als vierte Macht im Staate ansehen, ihrer Verantwortung gerecht würden und politische Entscheidungen vor allem im Bereich „Klimaschutz“ mehr zu hinterfragen. Eine Aufgabe, der die Medien, vor allem im deutschsprachigen Raum, bislang noch sehr unzureichend nachkommen.

Rudolf Kipp zuerst erschienen bei Science Sceptical

ÄHNLICHE BEITRÄGE (AUTOMATISCH GENERIERT):

* Hockeystick zum Meeresspiegelanstieg entzweit Forschergemeinde

* Wird es in Grönland wärmer? Nein – kälter

* Meeresspiegelanstieg stetig nachlassend – PIK-Propaganda im Abseits