Ein weiterer falscher Alarm bzgl. Anstieg des Meeresspiegels und Antarktischer Eisschmelze

Berichte in den Medien

Dazu ein Beispiel vom Weather Channel:

„Ein antarktischer Gletscher von der Größe von drei Vierteln der Fläche von Texas schmilzt unverändert, und falls er vollständig verschwindet, wird der Meeresspiegel auf der ganzen Welt dramatisch steigen, wie aus einer neuen Studie hervorgeht. Der Totten-Gletscher in der östlichen Antarktis schmilzt rasch und droht zu einem weiteren Sorgenkind zu werden angesichts der steigenden globalen Temperaturen. Die Studie wurde in dem Journal Nature veröffentlicht. Er ist bereits nahe an einen „Kipp-Punkt“, und – der Studie zufolge – falls er ganz kollabiert, könnte der globale Meeresspiegel um fast 10 Fuß steigen [ca. 3 m]… „Ich prophezeie, dass vor Ende dieses Jahrhunderts die großen Städte unseres Planeten in Küstennähe zwei bis drei Meter hohe Deiche um sich herum haben werden“. Das sagte der Autor der Studie Martin Siegert der French Press Agency (Hervorhebung vom Autor).

Aus Science Daily stammt dieser Auszug aus einer Presseerklärung des Imperial College London:

Gegenwärtige Raten des Klimawandels könnten einen großen Gletscher der Antarktis instabil werden lassen, was ultimativ einen Anstieg des Meeresspiegels über 2 Meter nach sich ziehen würde. Bei der Erforschung der Historie der Rückzüge und Vorstöße des Totten-Gletschers haben die Forscher entdeckt, dass falls sich der Klimawandel ohne Abschwächung fortsetzt, der Gletscher eine kritische Grenze während des nächsten Jahrhunderts überschreiten und eine irreversible Periode eines rapiden Rückzugs erleiden könnte. Dies würde ihn sich während der folgenden Jahrhunderte bis zu 300 Kilometer landeinwärts zurückziehen lassen, wobei riesige Wassermengen frei werden würden, die um 2,9 Meter zum globalen Anstieg des Meeresspiegels beitragen könnten. (Hervorhebung vom Autor).

Und schließlich noch die reißerische Schlagzeile von Chris Mooneys Beitrag in der Washington Post vom 18. Mai: ,Fundamental instabil‘: Wissenschaftler bestätigen ihre Befürchtungen hinsichtlich des größten Gletschers der Antarktis.

Aus der Studie

Den größten Teil der Studie macht eine komplexe Analyse der detaillierten gravimetrischen und magnetischen Daten aus, die aus Messungen eines tief fliegenden Flugzeuges gewonnen wurden, das wichtige Komponenten der Geologie unter dem Totten-Gletscher kartographiert hatte.

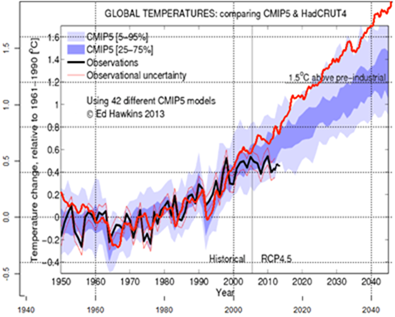

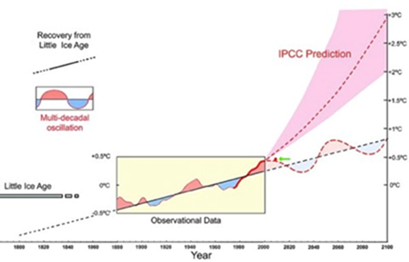

Es ist hilfreich, den Zusammenhang zu verstehen hinsichtlich eines alarmierenden Meeresspiegel-Anstiegs (SLR). Siehe dazu meinen früheren Beitrag hier. Der SLR beschleunigt sich nicht, weshalb die Warmisten nach zukünftigen Eisschild-,Kipp-Punkten‘ suchen mussten, die einen abrupten SLR auslösen könnten, was dringende Maßnahmen zur Abschwächung der CO2-Emissionen erforderlich machen würde. Grönland stand ursprünglich im Mittelpunkt, aber Grönland kooperiert nicht aufgrund seiner schüsselförmigen Geologie.

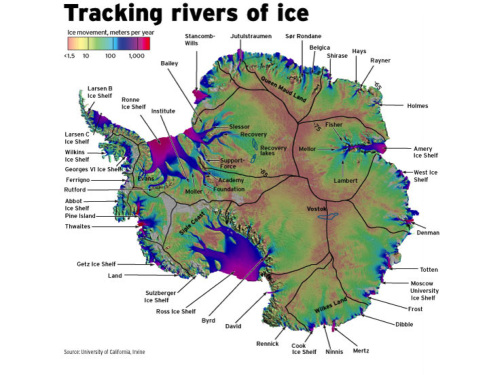

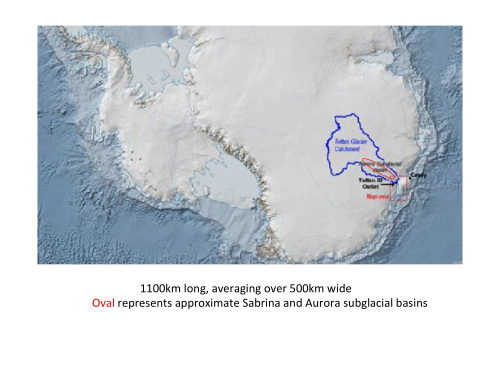

Der Westantarktische Eisschild (WAIS) war der nächste Konzentrationspunkt. Das Ronne-Eisschelf erwies sich als fest und stabil, wie in dem oben verlinkten Beitrag zu den Tipping Points beschrieben. ANDRILL zeigte, dass das Ross-Schelfeis ebenso stabil ist, hat sich doch dessen Aufsetzlinie [grounding line] seit vier Jahrtausenden nicht verändert. Die Aufmerksamkeit wandte sich dann der Amundsen-Bucht zu, wo im Jahre 2014 viel Aufhebens gemacht wurde um den fließenden Pine Island-Gletscher (PIG) – bis sich herausstellte, dass der PIG auf einem aktiven Vulkan saß, was nichts mit der globalen Erwärmung zu tun hatte. (Eingelagert in den PIG sind Schichten vulkanischer Asche). Auch der WAIS hat nicht kooperiert. Also verlagerte sich die Aufmerksamkeit jetzt zum Ostantarktischen Eisschild (EAIS), bei dem der Totten-Gletscher das größte Einzugsgebiet hat, welches etwa die Hälfte des von der NASA definierten geologischen Sektors einnimmt (siehe folgernde Karte.Darin auch eingezeichnet ist der Eisschild der Moscow University und der Frost-Gletscher).

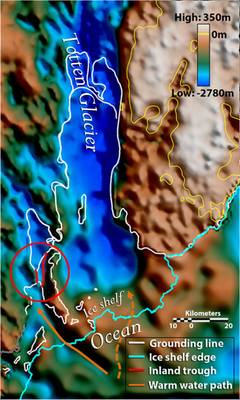

Wo der Totten den Südlichen Ozean erreicht, liegt er zumeist in flachen Gewässern auf Grund, die weniger als 500 m tief sind. Dies beeinträchtigt nicht dessen Stabilität (genauso wie beim Ross-Eisschelf), liegt doch die Wassertemperatur der oberen rund 500 m der Antarktischen Küstengewässer um den Gefrierpunkt. Aber wärmeres Meerwasser unterhalb von etwa 500 m schmilzt die Basis des Totten-Gletschers über einem tiefen untermeerischen Tal (hier), das etwa 5 km breit und etwa 800 m tief ist. Es wurde im Jahre 2015 entdeckt (hier). Dieses Abschmelzen verursachte ein langsames Zurückweichen der Aufsetzlinie hinter dem Tal. Der jährliche Rückzug der Aufsetzlinie beträgt gegenwärtig etwa 100 Meter pro Jahr. (Jedoch sind es Aitken in der Washington Post zufolge an manchen Stellen 175 m pro Jahr). Dazu muss man wissen, dass Aitken ein Mit- aber nicht der Leitautor der Studie 2015 war, in der es um das Tal gegangen war.

Dieser Schmelzprozess in der Tiefsee könnte sich im Verlauf von etwa 1500 Jahren etwa 150 km landeinwärts zurückziehen durch das unter dem Gletscher liegende Sabrina-Becken (in der folgenden Abbildung aus der Studie 2015 dunkelblau markiert), bevor er eine Felsenbarriere unter dem Eis erreicht, die lotrecht zum Gletscher nur etwa 200 Meter unter der Meeresoberfläche liegt. Dies würde das Abschmelzen zum Stoppen bringen (befindet sich doch das das Schmelzen verursachende Wasser in Tiefen unter 500 m). Aitken et al. 2016 schätzen, dass dies den Meeresspiegel um 0,9 Meter oder ~6 cm pro Jahrhundert steigen lassen könnte. Keinerlei Grund für Alarm.

Wovon Aitken et al. 2016 berichten, ist ein anderer Fjord-artiger ,Einschnitt‘ in diesem blockierenden Rücken, welcher (im Falle einer unveränderten Schichten-Abfolge der Wassertemperatur) es möglich machen würde, dass sich das Schmelzen an der Basis durch das innere Aurora-Becken unter dem Eis hinter dem Rücken fortsetzt. Dieser Prozess würde sich weitere 350 km lang fortsetzen oder etwa um 40% in das Totten-Becken hinein. Aitken et al haben auch Eis durchdringendes Radar eingesetzt zur Untersuchung des Meeresgrundes sowohl im Sabrina- als auch im Aurora-Becken, um zu bestätigen, dass der Totten-Gletscher tatsächlich durch beide Becken hindurch schon vor 3 Millionen Jahren im Pliozän (vor dem Einsetzen der gegenwärtigen Eiszeiten) geschmolzen war, wobei der CO2-Gehalt etwa 400 ppm betragen hatte. Dies wurde in den PR-Alarm hinein geworfen – es geschah zuvor bei 400 ppm!!! Mit den gegenwärtigen Schmelzraten würde dies etwa 3 Jahrtausende in Anspruch nehmen, was den Meeresspiegel um 2,9 Meter steigen lassen könnte – eine keineswegs alarmierende Rate von 10 cm pro Jahrhundert. Auch das ist möglicherweise noch viel zu hoch gegriffen, müsste doch das gesamte wärmere Wasser aus dem Aurora-Becken ungestört durch den gerade entdeckten Einschnitt im Rücken strömen.

Dies ist KEIN fundamental instabiler Kollaps, der 2 bis 3 m SLR bis zum Ende dieses Jahrhunderts implizieren würde, was die Autoren in ihren Presseerklärungen auch klar bekannt gegeben hatten.

Wie bekommt man einen SLR von 3 Fuß [ca. 0,9 m] durch das Schmelzen im Sabrina-Becken bis zu dem Rücken? Man nehme einfach an, dass das gesamte Eis in dem zurückhaltenden Becken verschwindet, auch das oberhalb des Meeresspiegels, das nicht durch warmes Meerwasser schmilzt. Bis zum Rücken ist das Rückhalte-Becken etwa 200 bis 250 km breit, der Gletscher etwa 100 km breit, dessen Zunge und der vorstehende Eisschild etwa 145 km breit. Diese Annahme ist dubios, aber nicht unplausibel. Es würde einen Eisfluss implizieren von ähnlicher Größenordnung wie bei den Gletschern im nordöstlichen Grönland heutzutage (ein weiterer Favorit der Übertreibung durch Alarmisten) außer dort, wo es heute keine solchen fließenden Gletscher gibt und wo die Temperatur im antarktischen Sommer niemals über den Gefrierpunkt steigt (in den meisten Gebieten von Grönland ist dies sommers kurzzeitig der Fall).

Wie bekommt man 2,9 Meter SLR aus dem roten Oval? Einfach! Just use the same entire catchment assumption to that deeper recessional melting point. [Verzeihung! Eine sinnvolle Übersetzung dieses Satzes habe ich nicht hinbekommen! Mag jemand einen Vorschlag machen? Anm. d. Übers.]

Wie bekommt man ~4 Meter (Washington Post)? Man nehme einfach an, dass falls das Aurora-Becken hinter den Rücken abschmilzt via Eindringens wärmeren Meerwassers durch den Einschnitt, dann wird das gesamte Rückhalte-Becken all sein Eis verlieren because it lost its Totten ‘plug’ (up catchment ice is about 2.5 km thick). [Gleiches Problem! Anm. d. Übers.]

Dies ist die gleiche Hypothese, die Rignot bei seinem PIG-Alarm aufgestellt hat hinsichtlich des Verlustes des gesamten Eises in der Amundsen-Bucht, obwohl sogar seine eigene Studie zeigte, dass dies unmöglich ist.

Dies ist die gleiche Hypothese, die Greenbaum et al. 2015 in der oben genannten Studie aufgestellt haben (bei der Aitken Mitautor war), aufgrund derer Aitken et al. 2016 aufbauen (hier; Abschnitt 8)

Schlussfolgerungen

Die alarmistischen Schätzungen dieser neuen Nature-Studie, vor allem wie sie in den Medien repräsentiert werden, sind ganz schwer falsch, sowohl hinsichtlich der Größenordnung als auch der Rate des Meeresspiegel-Anstiegs, der mit dem Schmelzen des Totten-Gletschers einher gehen könnte.

In den Presseerklärungen und den Interviews der Autoren gibt es völlig ungerechtfertigte Übertreibungen. Es wurden Hypothesen zugrunde gelegt, die niemals erwähnt worden sind außer als Referenz auf zuvor zurück gewiesene Studien durch Rignot. Ein gewebtes Netz des Betruges!

Link: https://judithcurry.com/2016/05/22/another-antarctic-sea-level-rise-false-alarm/

Übersetzt von Chris Frey EIKE