Die Wissenschaftler sagten, dass CO2-Emissionen die Erde aufheizen, mit schrecklichen, sogar katastrophalen Folgen: Eiskappen schmelzen, der Meeresspiegel steigt, Küsten verschwinden, massive und sehr häufige Hurrikane, Hitzewellen mit tödlichen tropischen, sich in bislang gemäßigte Temperaturzonen ausbreitenden Krankheiten, Missernten infolge Hitze und Wüstenausbreitung, Pandemien gegen die menschliche Gesundheit, Verschwinden des Schnees auf der Sierra Nevada in Kalifornien, Trinkwasserknappheit – die Liste ist lang und länger.

Die Lösung, sagten die Wissenschaftler, bestehe darin, keine fossilen Treibstoffe mehr zu verbrennen, d. h. Erdgas, Kohle und Öl. Stattdessen sollen wir Strom sparen und lernen, mit weniger Strom auszukommen, Elektroautos fahren, Benzin aus Mais-Ethanol sowie Diesel aus recycelten tierischen Fetten und Ölsamen herstellen, all unseren Müll in Verbrennungskraftwerken recyceln, Wind- und Solarparks zur Stromerzeugung errichten, Methan sammeln aus Jauchegruben und Müllhalden, um dieses Methan dann in Kraftwerken zur Stromerzeugung zu verbrennen. Aber bis solche Technologien zum Tragen kommen, müssen wir das CO2 aus Kraftwerken und Hochöfen einfangen und es irgendwo für immer vergraben. Dieser Vorgang wurde „Abscheidung (Sequestration)“ genannt.

Mein Interesse wurde zumindest angestachelt. Die Erde soll unbewohnbar werden? Millionen Klimaflüchtlinge würden anderswo Platz zum Leben suchen? Kriege würden um Nahrung und Frischwasser geführt werden? Küstenlinien sollen überschwemmt und für immer verschwunden sein? Und das alles soll wegen unseres Verbrauchs fossiler Treibstoffe passieren? Meine Industrie? Die Öl- und Gasindustrie?

Ich wusste, dass chemische Ingenieure involviert sein würden, und zwar mittendrin. Chemische Ingenieure sind diejenigen, die Substitute für Öl und Diesel zur Verfügung stellen können und die wissen, wie man aus Mais oder Zellulose Ethanol herstellt. Sie sind auch diejenigen die wissen, wie man Kraftwerke plant, baut und betreibt, die das CO2 einfangen, und sie finden Wege, das gefährliche CO2 entweder zu binden oder es permanent im Untergrund zu speichern als Teil der Sequestration.

Also begann ich mal zu eruieren, was die chemischen Ingenieure tun können, um das Problem zu lösen und nach Wegen zu suchen, von meinem eigenen Hintergrund als chemischer Ingenieur zu profitieren und eine Expertise als Anwalt zu erstellen. Sicher würde es doch einige Gelegenheiten für einen Mann mit meinen Erfahrungen in all dem geben. Ich musste meine Pflicht tun und die wissenschaftlichen Behauptungen verifizieren. Zunächst, auf welche Art und Weise verursacht das CO2 diese ganze Erwärmung? Ich habe Jahrzehnte lang mit CO2 gearbeitet, in vielen Formen und an vielen Orten. CO2 ist ein Verbrennungsprodukt (zusammen mit Wasserdampf) aus der Verbrennung von Erdgas, anderen leichten Hydrokarbonaten, Benzin, Diesel, Heizöl, Erdölkoks, Holz, Kohle, sogar Torf und getrocknetem Tierdung. Ich wusste mehr als die meisten, dachte ich. Ich habe flüssige CO2-Tanks entworfen, installiert und betrieben, ebenso wie Ausrüstungen, um flüssiges CO2 zu vergasen, es zu pressen und das gepresste Gas wieder zu verflüssigen. Ich hatte auch Verarbeitungsanlagen entworfen und betrieben, um das CO2 aus Abgasen von Brennöfen herauszuholen; und ich habe andere Anlagen entworfen und betrieben, die aus CO2 feste Partikel machen. Ich dachte mir, dass es eine Menge Möglichkeiten für mich geben müsste.

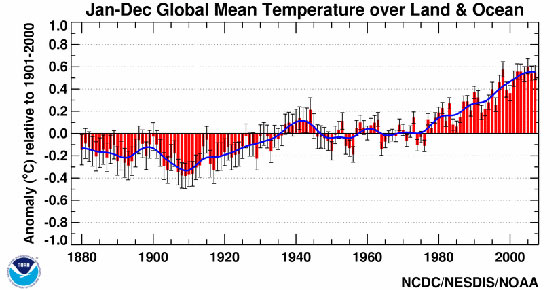

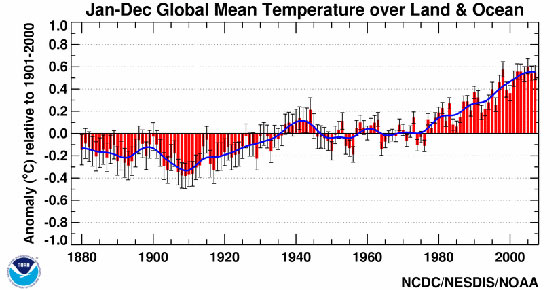

Herauszufinden, wie viel CO2 entfernt werden muss, schien mir ein guter Startpunkt zu sein. Ich begann mit der Lektüre von Blog Posts auf einer Website, die sich RealClimate.org nennt und wo behauptet wurde, dass „echte Klimawissenschaft von echten Klimawissenschaftlern“ geschrieben wird. Das hörte sich gut an, die Informationen direkt von den Experten zu bekommen. Ich habe dort einige Karten und Graphen gesehen, und ich verstehe Karten und Graphen. Chemische Ingenieure kennen alles darüber. Einer dieser Graphen zeigte die globale Mitteltemperatur der Erde von etwa 1880 bis 2005. Da zeigte sich ein dramatischer und bemerkenswerter Aufwärtstrend seit 1975 bis heute. Dieser Trend würde, wenn er sich fortsetzte, mit Sicherheit die Welt heißer machen, und vielleicht würden die Eiskappen tatsächlich alle schmelzen.

Da ich ein guter Ingenieur bin und ausgebildet, alle Seiten einer Angelegenheit zu betrachten, schaute ich mir den Rest der Graphik an. Sie kam mir etwas komisch aussehend vor. Da gab es einen ziemlich flachen Verlauf von etwa 1940 bis 1975, oder sogar einen leichten Abwärtstrend in diesen 35 Jahren. Hmmm… ich frage mich, was war der Grund dafür? Hat sich der CO2-Gehalt in diesem Zeitraum vielleicht verringert? Ich machte mir einen Vermerk, dies später genauer zu untersuchen.

Dann sprang mir die Zeit vor 1940 ins Auge. Von etwa 1900 bis 1940 zeigte der Graph einen bemerkenswert ähnlichen Aufwärtstrend, fast genau wie von 1975 bis 2005. Hmmm schon wieder… wie war es zu diesem Erwärmungstrend gekommen? Hat das CO2 in jenen Tagen zugenommen? Und falls ja, warum hörte das um 1940 auf? Die Welt befand sich Ende der dreißiger bis Mitte der vierziger Jahre im Krieg… haben wir während dieser Zeit keine Kohle, Erdgas oder Öl verbraucht? Irgendwas schien da nicht zu stimmen, konnte ich mich doch entfernt daran erinnern, wie ich aus meinem Studium der Ölindustrie gelernt hatte, dass die Ölproduktion während des 2. Weltkriegs dramatisch zugenommen hatte, wegen all der militärischen Maschinen, die Benzin und Diesel benötigten, und der Schiffe, die Heizöl benötigt hatten. Ich wusste, dass die Atomkraft bis lange nach dem Krieg keine Rolle gespielt hatte, so dass all diese Schiffe mit Schweröl betrieben wurden, welches wir Bunker-C-Öl nennen. Auch produzierten Fabriken rund um die Welt mit voller Kapazität Munition, Stahl, Aluminium, Kriegsmaschinen, Panzer, Jeeps, Schiffe und all die anderen Kriegsgerätschaften. Damals gab es nicht viel Einsparung, dachte ich. Eine Menge CO2 wurde auch emittiert. Niemand scherte sich um Effizienz oder sparsamen Verbrauch, nicht einmal um Verschmutzung; der einzige Gedanke war gewesen, so schnell und so viel wie möglich noch mehr zu produzieren. Schließlich herrschte Krieg!

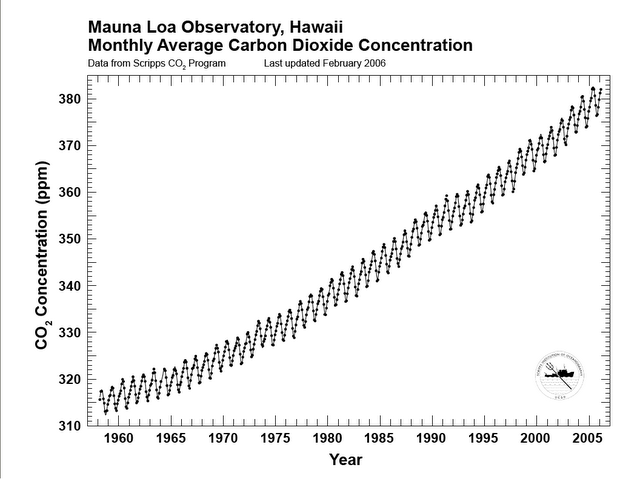

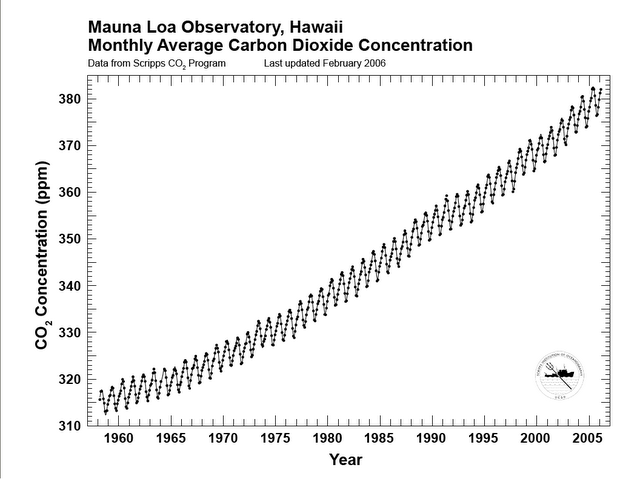

Dann besah ich mir den CO2-Anteil in der Atmosphäre, wobei ich eine große Prozentzahl vermutete, vielleicht 3 oder 4 oder sogar 5 Prozent. Die Graphen, die ich fand, sahen auf den ersten Blick falsch aus. Der CO2-Gehalt lag nicht einmal annähernd bei 5 Prozent. Nicht einmal 1 Prozent. Er lag so niedrig, dass er in Parts per Million gemessen wurde! Etwa 365 ppm habe ich gefunden, und eine Zunahme um etwa 2 ppm pro Jahr. Die Messungen reichten zurück bis zum Jahr 1959, und was mich noch mehr erstaunte – diese 365 ppm wurden auf knochentrockener Basis gemessen. Dies bedeutet, dass das als Beispiel dienende Luftpaket gedörrt oder sehr sorgfältig getrocknet worden ist, um allen Wasserdampf zu entfernen bevor der CO2-Gehalt quantifiziert wurde. Das ist tatsächlich ein gutes Verfahren, weil es alle Variationen infolge Änderung der Luftfeuchtigkeit eliminiert. Aber in der Praxis, falls die Atmosphäre sehr viel Wasserdampf enthält, wird die aktuelle CO2-Konzentration um Einiges geringer sein. Ich habe das mal ausgearbeitet, und gefunden, dass eine tropische Luftmasse mit einer Temperatur von 80°F [ca. 27°C] und einer Relativen Luftfeuchtigkeit von 90 Prozent etwa 0,2 Pfund Wasser pro Pfund trockener Luft enthält. Grob geschätzt besteht die Luft, die wir einatmen, zu 17 Prozent aus Wasserdampf. Damit würde sich die CO2-Konzentration ebenfalls um 17 Prozent reduzieren, so dass aus den 365 ppm tatsächlich 310 ppm werden. Wow! Kann ein CO2-Gehalt von 310 ppm all diese Probleme hervorrufen? Ich musste herausfinden, wie das gehen sollte!

Ich brauchte nicht lange im Internet zu suchen, bis ich Behauptungen von Wissenschaftlern gefunden hatte, dass das CO2 die Wärme von der Erdoberfläche absorbiert und etwa die Hälfte davon wieder zur Erde zurückstrahlt. Der Effekt wurde der „Treibhaus“-Effekt genannt, und CO2 wurde als „Treibhausgas“ bezeichnet. Hmmm… so funktionierten Treibhäuser nicht, wie ich wusste, weil wir selbst auch Treibhäuser entworfen und gebaut hatten. Die Sonnenwärme dringt durch das Glas, wird von den dunkelgrünen Pflanzen absorbiert und wärmt die Luft innerhalb des Treibhauses. Winde können die Warmluft wegen der Glasdecke und –wände nicht davon blasen. In der Sprache der Ingenieure ausgedrückt, es gibt dabei keinen konvektiven Wärmeaustausch. Nun, dieses „Treibhausgas“ könnte ein Kunstausdruck sein, und ich bin sicherlich vielen solcher Kunstbegriffe im Ingenieurswesen und in Gesetzen begegnet. Eindeutig waren weitere Untersuchungen erforderlich.

So stieß ich schließlich auf das Kyoto-Protokoll, das eine Menge über Treibhausgase zu sagen hatte. Wie sich heraus stellte, gab es sechs davon, nicht nur CO2. Die sechs waren natürlich das CO2, dann aber auch Methan, Stickstoffoxid, Schwefelhexafluorid, Hydrofluorkarbonate und Fluorkohlenwasserstoffe.

Aber wie genau geht das vor sich, dass das CO2 und die anderen Wärme absorbieren und sie zur Erde zurück strahlen? Und wie erzeugte das eine Erwärmung? Einiges passte da nicht zusammen, wie zum Beispiel der zunehmende CO2-Gehalt seit 1959 und die Abkühlung von 1940 bis 1975. Mehr dazu später.

Weitere Untersuchungen führten mich zum Blog von Anthony Watts, Watts Up With That. Das schien eine Stelle zu sein, an der Artikel gepostet wurden, die die Orthodoxie der anthropogenen, auf CO2 basierenden globalen Erwärmung in Frage stellen. Also las ich darin und las über Al Gore und seinen Film „Eine Unbequeme Wahrheit“, von Dr. James Hansen von der NASA, der eine Welttemperaturkarte erzeugt hatte, und viele andere Gestalten. Da gab es etwas, das „das Team“ genannt wurde, und ich wusste nicht, wer zu diesem Team gehörte und welches Spiel es spielte. Aus dem Zusammenhang jedoch ergab sich, dass es keine gute Sache war, Mitglied des Teams zu sein, da es irgendwie geringschätzig behandelt wurde.

Aber zurück zum CO2 und dem Aufheizen der Erde. Ich las über das CO2 und wie es Wärme absorbierte. Einige kleine Bruchstücke wanderten tief in mein Gedächtnis. Davon hatte ich schon mal gehört, vor sehr langer Zeit. Ich kramte mein altes Handbuch über chemisches Ingenieurwesen hervor, bekannt als Perry’s Handbook. Dieses Buch steckt voller felsenfester Wissenschaft, die immer zutrifft, sowie Fakten zum Ingenieurswesen. Wenn es in Perrys Buch stand, war es eine Tatsache. Darauf konnte man sich verlassen. Chemische Ingenieure rund um die Welt richteten sich nach den Dingen, die dort standen, jeden Tag. Also schlug ich dort nach. Und wurde fündig. Und zwar unter den Stichworten Wärmetransport, Transfer von Strahlungsenergie, Design von Hochöfen. In Hochöfen werden normalerweise einige Sorten fossiler Treibstoffe verbrannt, vielleicht Kohle oder Öl oder Erdgas oder eine Mischung leichter Hydrokarbonate, falls der Hochofen eine Ölraffinerie ist. Öfen für die Heizung von Haushalten verbrennen ein Öl ähnlich Diesel, und davon gibt es Millionen auf der ganzen Welt. Es gibt eine ähnlich große Zahl großer Industrieöfen in Kraftwerken, Fabriken Stahlwerken, Raffinerien und Chemiewerken. Der Bau von Öfen ist eine sehr ausgereifte Kunst, die nicht nur Jahrzehnte, sondern bereits Jahrhunderte lang ausgeübt worden ist. Selbst Lokomotiven verbrannten Holz oder Kohle, und auch das für Jahrhunderte. Und sicher muss beim Ofenbau auch der Faktor CO2 in den Verbrennungsabgasen berücksichtigt werden. Wasserdampf spielt ebenfalls eine Rolle, und seine Auswirkungen sind sogar noch größer als die vom CO2.

Etwas ist hier in gewisser Weise in Ordnung. Wenn ein fossiler Treibstoff verbrannt wird, findet eine chemische Reaktion statt, bei der eine Menge Wärme freigesetzt wird. Ein fossiler Treibstoff ist ein Hydrokarbon, was bedeutet, dass die meisten Moleküle entweder Wasserstoff oder Kohlenstoff sind. Also Hydrokarbon. Chemiker sind nicht sehr innovativ, wenn es um Namen geht, manchmal zumindest. Luft wird hinzugefügt und Wärme, und der Sauerstoff in der Luft reagiert chemisch mit dem Kohlenstoff und mit dem Wasserstoff. Ein Kohlenstoffatom kombiniert mit zwei Sauerstoffatomen in der Luft bilden CO2, Kohlendioxid – ein Kohlenstoff- und zwei Sauerstoffatome. Und wieder keine besonders kreative Namensgebung. Genauso reagieren zwei Wasserstoffatome mit einem Sauerstoffatom und bilden H2O, Dihydrogenmonoxid, bekannter unter der Bezeichnung Wasser. Das Wasser befindet sich im gasförmigen Zustand, ist also Wasserdampf. Dies ist beim Ofenbau wichtig, weil das, was aus dem Abgasschacht entweicht, zumeist Stickstoff aus der Luft ist, die in den Ofen einströmt, sehr wenig Sauerstoff, weil dieser zum größten Teil chemisch reagiert hat, und der Rest ist Wasserdampf und CO2. Wie viel CO2, und wie viel Wasserdampf? Ist das CO2 sehr gering konzentriert, wie in der Atmosphäre? Es sieht so aus, als sei die Antwort nein, denn CO2 hat jetzt eine Größenordnung von 19 Prozent und Wasserdampf von 29 Prozent. Dies unterscheidet sich erheblich von dem Gehalt in der Atmosphäre. Anders ausgedrückt, ist 19 Prozent das Gleiche wie 190000 ppm. Also ist die CO2-Konzengtration in einem Ofen viel, viel größer. Was ist noch unterschiedlich? Einmal ist die Temperatur sehr unterschiedlich. CO2 in einem Ofen ist glühend heiß, mit einer Temperatur um 1800°F [ca. 982°C]. In der Atmosphäre reicht die Spanne von 90°F bis -40°F [ca. +32°C bis -40°C]. Ich fragte mich, ob das etwas ausmacht, und wenn ja, wie viel? Die grundlegende Antwort war ja, CO2 und Wasserdampf absorbieren jeweils Strahlungswärme und geben sie wieder ab. Also schien es eine gewisse Basis für die Behauptung der Wissenschaftler zu geben, dass CO2 Wärme absorbiert. Aber immer noch stellte ich Fragen.

Ich stöberte noch weiter in der wissenschaftlichen Literatur und fand heraus, dass das CO2 nur einen kleinen Teil der Strahlungswärme absorbiert, die von der Erdoberfläche abgestrahlt wird. Ein sehr, sehr kleiner Teil. Nicht nur das, der Effekt beim Hinzufügen von weiterem CO2 in die Atmosphäre hat eine verringernde Auswirkung darauf, wie viel Strahlungsenergie absorbiert wird. Im Grunde ist die Strahlungsabsorption die gleiche, ob CO2 nun dabei ist oder nicht. Der Effekt wird noch weiter abgeschwächt, weil auch Wasserdampf Strahlungsenergie absorbiert, und zwar in der gleichen Wellenlänge wie das CO2. Wasserdampf absorbiert zwar auch in anderen Wellenlängen, aber es gibt eine Überlappung mit dem CO2.

Also lehnte ich mich zurück, wog das alles gegeneinander ab und überdachte alles sehr intensiv. Ich wusste, dass sich die Erde rasch und nachhaltig in klaren Wüstennächten abkühlte, selbst in der Hitze des Sommers. Dies liegt an der sehr trockenen Luft, die fast keinen Wasserdampf enthält. Dieser Effekt ist ziemlich faszinierend, und man kann tatsächlich manchmal sehen, wie sich in kleinen Senken Eis bildet, selbst wenn die Temperatur der umgebenden Luft über dem Gefrierpunkt liegt. Dies ist ein bevorzugtes Ereignis für Scouts, die in der Wüste zelten. Man nimmt eine kleine Pfanne, gießt ein wenig frisches Wasser hinein und stellt die Pfanne auf isolierendes Material wie Styroporschaum. Man wickelt auch ein trockenes Handtuch darum, um die Luft daran zu hindern, die Pfanne zu wärmen. Gerade vor Sonnenaufgang sahen wir nach und fanden eine Eisschicht auf dem Wasser. Genug Wärme war durch Strahlung in den schwarzen Himmel darüber entwichen, ungehindert durch CO2 oder Wasserdampf, wodurch sich das Wasser abkühlte bis zur Eisbildung. Das eisige Wasser war großartig geeignet, es in Feldflaschen zu füllen.

Niemand kann so etwas in den Nächten in einem feuchten Klima machen, wie es in Houston, Texas herrscht, wo ich aufgewachsen war und auch ein wenig gezeltet habe. Der Wasserdampf in der Luft verhindert dies selbst in klaren Nächten.

Also wälzte ich das gesamte Problem der Wärmeabsorption von CO2 im Kopf herum. Zunächst wurde in Perrys Handbuch ein sehr wichtiger Parameter erwähnt, die „mittlere Strahlungslänge“ [mean beam length MBL]. Dieser bezieht sich auf die Entfernung der heißen Gase CO2 und Wasserdampf zu den Behältern im Ofen, die das zu erwärmende Wasser enthalten. Je größer die Entfernung, umso weniger wirkt die Strahlungsenergie. Dies ist durch die alltägliche Erfahrung ziemlich offensichtlich und ist auch bei Lagerfeuern und einer Kerze so. Näher an der Quelle ist es wärmer, weiter entfernt davon kälter. Dies ist Allgemeinwissen, außer bei sehr kleinen Kindern. Dies ist auch von den Planeten im Sonnensystem bekannt, mit dem sonnennächsten, sehr heißen Planeten Merkur und den anderen, die immer kälter sind, je weiter sie von der Sonne entfernt sind. Die Temperatur an der Sonnenoberfläche ist immer die gleiche. Klarer Fall, die Entfernung hat etwas zu tun mit der absorbierten Menge Strahlungsenergie. Ich fragte mich, wie viel Wärme das CO2 in einer Höhe von ca. 3000 m, 6000 m, 9000 m oder noch höher absorbieren kann. Auch frage ich mich angesichts des Umstands, dass die Atmosphäre mit zunehmender Höhe immer dünner wird, wie viele CO2-Moleküle in jeder Höhe vorhanden sind, um jedwede durchlaufende Energie zu absorbieren.

Es war ziemlich offensichtlich, dass selbst unsere Urvorfahren etwas von diesen grundlegenden Dingen gewusst haben, da man sich immer wieder auf „die kalten Sterne“ in der Literatur bezog. Heute wissen wir, dass Sterne in Wirklichkeit Sonnen sind, einige davon viel größer und heißer als unsere Sonne. Wir können die Wärme der Sterne wegen der riesigen Entfernungen nicht fühlen, Milliarden von Meilen, wenn nicht Billionen. Weit weg heißt sehr kalt. Nah dran heißt sehr warm.

Noch war ich nicht zu einer Schlussfolgerung gekommen, einer festen Meinung bzgl. der Behauptung, dass das CO2 zu einer Erwärmung der Erde führt, aber es sah für mich ziemlich wacklig aus. Dann dachte ich an mein Hintergrundwissen als Ingenieur bei der Prozesskontrolle und dachte weiter an Lagerfeuer. Das Gesetz der Lagerfeuer ist einfach und wurde oben schon kurz erwähnt: Wenn es zu heiß wird, entferne man sich. Wenn es zu kalt ist, gehe näher ran. Näher dran ist immer wärmer, denn ein Lagerfeuer hat immer die gleiche Wärmeabstrahlung.

Und doch, ich habe die Graphik gesehen, die einen langsamen Anstieg des CO2-Gehaltes zeigte, eine schöne, glatte Kurve. Gleichzeitig erreichte die Mitteltemperatur der gesamten Erde ein Maximum um 1940 und ging dann 35 Jahre lang zurück. Dann kehrte sich der Trend um, und es wurde wieder wärmer. Falls das CO2 erst eine 35 Jahre lange Abkühlung und danach eine 35 Jahre lange Erwärmung verursacht haben soll, verletzt dies die Grundlagen der Prozesskontrolle. Ein bekannter chemischer Ingenieur mit einem PhD, Dr. Pierre Latour, schrieb hierzu etwas in einer bekannten Zeitschrift, Hydrocarbon Processing. Damals hatte ich meinen eigenen Blog und schrieb dazu einen Aufsatz, in dem ich die Ergebnisse von Dr. Latour diskutierte (hier). Wenn das CO2 erst die Abkühlung und dann die Erwärmung zulässt, wäre das genauso, wenn man sich näher an das Lagerfeuer begibt, um sich bei manchen Gelegenheiten abzukühlen, und sich davon zu entfernen, um sich bei anderen Gelegenheiten abzukühlen. Da wusste ich ganz genau, dass das CO2 nicht das tun konnte, was die Wissenschaftler behauptet hatten. Nicht bei diesen geringen Konzentrationen in der Atmosphäre und nicht bei diesen niedrigen Temperaturen. Aber ich wollte noch mehr wissen, also las und fragte ich weiter.

Etwa um diese Zeit, November 2009, brach der Climategate-Skandal aus, als Tausende e-mails und Computerdateien in das Internet gelangt waren. Die Dateien waren unglaublich empörend und verheerend für das Anliegen der Warmisten, weil hier unsaubere Aktionen mancher Wissenschaftler im Herzen der Klimadebatte enthüllt worden waren. Um den Schaden zu begrenzen, haben sich die Wissenschaftler am Hadley Center’s Climate Research Unit der University of East Anglia, UK, entschlossen, einige ihrer Dateien zu veröffentlichen, und zwar mit Temperaturaufzeichnungen von etwa 1000 Orten in der Welt. Die Absicht war es zu zeigen, dass es nichts zu verbergen gab, und hier konnte die ganze Welt Einsicht in die Rohdaten nehmen. Ich kopierte die Dateien auf meinen Computer und untersuchte sie.

Zunächst fiel auf, dass die sog. Rohdaten alles andere als roh waren. Ich kannte Rohdaten, habe ich mir doch als chemischer Ingenieurspraktikant Reihen auf Reihen von Rohdaten angeeignet, und zwar 20 Jahre lang in Chemiewerken und Raffinerien auf der ganzen Welt. Was die HdCRU veröffentlicht hat, waren bearbeitete Daten. Sie zeigten die mittlere monatliche Temperatur über einen Zeitraum von mehreren Jahrzehnten für die gewählten Städte. Das Monatsmittel wurde aus der täglichen Mitteltemperatur gebildet. Die tägliche Mitteltemperatur wurde aus dem Mittel zwischen Höchst- und Tiefsttemperatur eines jeden Tages gebildet. Die Höchst- und Tiefsttemperatur war manchmal adjustiert oder auch frisiert worden durch die Auswahl des Zeitpunktes der Temperaturablesung. Es gab auch keine Hinweise darauf, wie fehlende Daten ergänzt oder erzeugt worden waren. Instrumente sind nicht zu 100% zuverlässig und brauchen manchmal Wartung. Sie müssen gesäubert werden, brauchen Kalibrierungen, müssen manchmal ausgetauscht werden und so weiter. Sie können für eine Weile außer Betrieb sein, während jemand bemerkt, dass die Daten fehlen und das Instrument repariert wird.

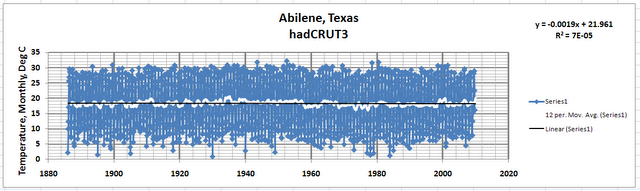

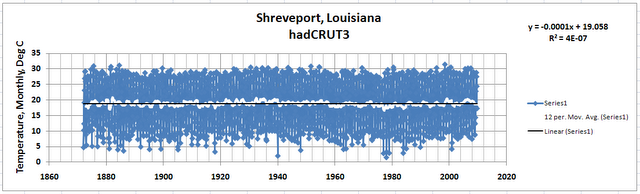

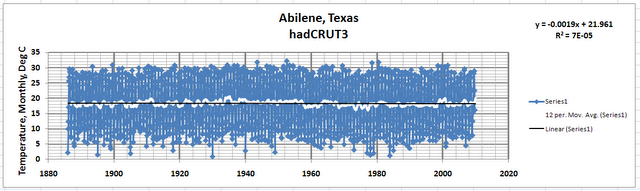

Und doch lag hier ein Datensatz von monatlichen Mittelwerten von etwa 1000 Städten vor. Ich beschloss, einmal zu schauen, was da aus den USA war. Da gab es 87 Aufzeichnungen, alle im Kernland. Die Daten stammten aus Städten in den gesamten USA, nicht in jedem [US-Bundes-]Staat, aber in fast jedem, und waren ziemlich gleichmäßig verteilt. Einige befanden sich in großen Städten wie New York, Los Angeles, San Francisco, Miami, einige in mittelgroßen Städten wie St. Louis, Spokane und Fresno. Andere befanden sich in kleinen Städten oder größeren Orten, wie Abilene, Texas und Meridian, Mississippi. Ich lud die Daten für jede Stadt in eine gängige Tabelle [vermutlich excel, A. d. Übers.] und erstellte Graphen der monatlichen Temperatur in Abhängigkeit von der Zeit. Ich fügte ein gleitendes Mittel hinzu, um zu sehen, welche Trends sich abzeichneten, wenn überhaupt, und danach noch eine lineare Trendlinie [a linear best-fit trend line]. Die Ergebnisse waren so faszinierend, dass ich alle Graphen in meinem Blog postete (hier) zusammen mit einigen Kommentaren. Was ich fand, bestätigte meinen von Anfang an gehegten Verdacht. CO2 kann nicht das tun, was die Wissenschaftler behaupten.

Die Graphen zeigten eine schlimme Inkonsistenz bei der Erwärmung von Städten in den USA. Einige Städte zeigten in der Tat einen ausgeprägten Erwärmungstrend während einer ungefähr 100-jährigen Periode von 1900 bis 2009. Nicht aus allen Städten lagen so weit zurückreichende Daten vor, und nur 62 hatten langzeitliche Aufzeichnungen. Und doch zeigten andere Städte unter diesen 62 Abkühlungs- oder neutrale Trends. Das schien eigenartig zu sein, denn falls das CO2 wirklich die Erde erwärmt, dann muss das für alle Gebiete gelten und nicht selektiv zu suchen, welche Stelle erwärmt werden muss und welche man ignorieren kann. Dies gilt insbesondere für benachbarte Städte oder solche, die in Nord-Süd-Richtung nicht allzu weit voneinander entfernt liegen. Vermutlich würde es Unterschiede geben zwischen Städten im hohen Norden und solchen in der Nähe des Äquators. Das Kernland der USA weist aber nur einen Nord-Süd-Durchmesser von 1500 Meilen [ca. 2400 km] auf. Verglichen mit der gesamten Entfernung von Pol zu Pol von etwa 12000 Meilen [fast 20000 km] ist das kaum mehr als 10%. Für Städte, die lediglich 100 oder 200 Meilen voneinander entfernt liegen, kam es mir sehr komisch vor, dass CO2 einige Städte ignoriert hatte und andere in den Brennpunkt der Erwärmung stellte. So funktioniert Physik nicht! Falls ein Phänomen wirklich auf einem physikalischen Effekt beruht, gilt dieser konsequent und gleichmäßig überall und in allen Zeiten. Die Schwerkraft beispielsweise hat in Houston, Texas, genau den gleichen Wert wie in Mumbai, Indien, oder Bora Bora. Man kann sich die Konfusion vorstellen, wenn sich Reisende an unterschiedliche Schwerkraft anpassen müssten, abhängig von der Stadt, in der sie gelandet waren. Nein, die Physik treibt keine solchen neckischen Spielchen.

Oder, man kann sich das Chaos in der Welt vorstellen, wenn die Eigenschaften von Stahl so unberechenbar wären wie das CO2. Ingenieure könnten eine Brücke in Kairo, Ägypten, bauen und mächtige Stahlträger mit einer Breite von 12 inches [ca. 30 cm] und 24 inches tief. Aber eine baugleiche Brücke über das Mittelmeer bei Rom würde leichtere Träger erfordern mit einer Breite von lediglich 4 inches [ca. 10 cm] und einer Tiefe von 12 inches. Ingenieure würden darüber lachen, weil das einfach so nicht ist. Eine gegebene Qualität von Stahl wird überall das gleiche Gewicht tragen, ganz egal wo in der Welt er verbaut wird. Puristen werden anmerken, dass dies nicht strikt gilt, da Stahl durch die Temperatur beeinflusst wird. Aber in den meisten Fällen erhitzen sich Brücken nicht stark genug, um den Stahl merklich zu schwächen.

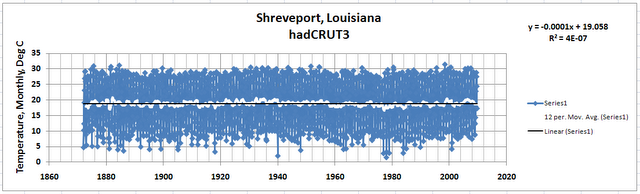

An diesem Punkt schaute ich auf benachbarte Städte und fand, dass einige davon, wie ich oben schrieb, einen abkühlenden oder neutralen Trend zeigten. Abilene, Texas, und Shreveport, Louisiana, sind zwei davon. In Abilene zeigt sich eine Abkühlung von 0,19°C pro Jahrhundert, während Shreveport eine solche von 0,01°C pro Jahrhundert, also fast gar keine Änderung, zeigt. Diese beiden Städte liegen etwa 250 Meilen [ca. 402 km] in Ost-West-Richtung voneinander entfernt. Sie liegen etwa auf gleicher geographischer Breite. Gleichzeitig zeigt sich in St. Louis, Missouri, eine Erwärmung von etwa 1°C pro Jahrhundert. St. Louis liegt nur etwa 300 Meilen [ca. 480 km] nördlich und ein wenig östlich von Shreveport und etwa 400 Meilen [ca. 640 km] von Abilene entfernt. Klarer Fall, bei der CO2-verursacht-globale-Erwärmung-Wissenschaft stimmt hier irgendetwas nicht. Woher weiß das CO2, dass es Shreveport außen vor lässt und seine Erwärmungswirkung auf St. Louis konzentriert?

Ein anderes Beispiel sprang mir ins Auge: San Francisco, Kalifornien, sowie deren Nachbarstadt Sacramento. Diese Städte liegen nur 50 Meilen [ca. 80 km] voneinander entfernt und auf etwa der gleichen geographischen Breite. Und doch verzeichnete San Francisco eine Erwärmung von 1,5°C pro Jahrhundert, während sich Sacramento um 0,3°C abkühlte.

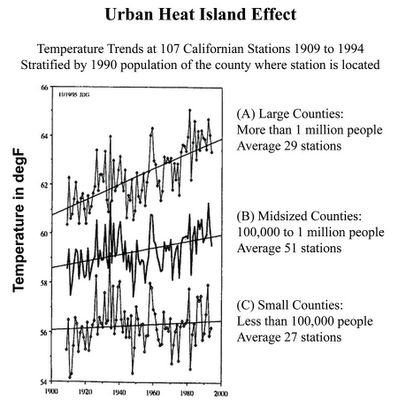

Eine Möglichkeit, diese Diskrepanz zu erklären, besteht darin, den Wärmeinseleffekt von Städten UHI dafür verantwortlich zu machen. Hier dachte ich zuerst, die Abkürzung bezöge sich auf die University of Hawaii, bis ich herausfand, für was sie wirklich steht. UHI ist ein Phänomen, bei dem Städte oder größere urbane Gebiete Tag und Nacht wärmer sind als die ländliche Umgebung. Der UHI-Effekt ist für kleine Städte gering und wird mit der Größe der Städte immer größer. Er setzt sich aus vielen verschiedenen Faktoren zusammen, einschließlich der Ausdehnung asphaltierter oder betonierter Flächen, Gebäude aus Stein, Ziegeln oder Stahl und Glas, ein großer Stromverbrauch zum Heizen oder Kühlen, Abwärme großer Industrien sowie die große Anzahl von Autos, Lastwagen, Bussen und Flugzeugen, die große Mengen fossiler Treibstoffe verbrauchen.

Aber selbst dabei gibt es Probleme. Zum Beispiel in Meridian, Mississippi. Das ist eine kleine Stadt und erwärmt sich mit der gleichen Rate wie die Großstadt San Antonio, Texas. Beide zeigen eine Rate von +0,26°C pro Jahrhundert. Wie kann das sein, wenn der UHI eine Rolle spielt?

Andere kleine Städte zeigen eine substantielle Erwärmung, wie Helena, Montana und Duluth, Minnesota, mit einer Rate von 2°C pro Jahrhundert. Die Bevölkerungszahl von Duluth in Höhe von etwa 80000 hat sich seit 1930 kaum verändert. Im Jahre 1960 wohnten dort 107000 Menschen, doch hat die Bevölkerung seitdem wider abgenommen. In Helena dagegen wuchs die Bevölkerung von 12 000 im Jahre 1910 bis 2010 auf 28 000.

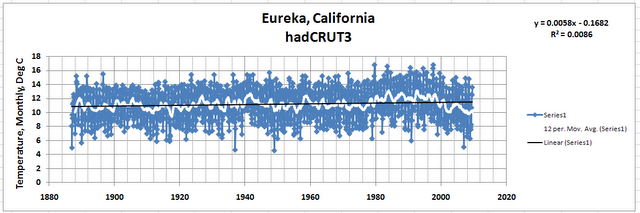

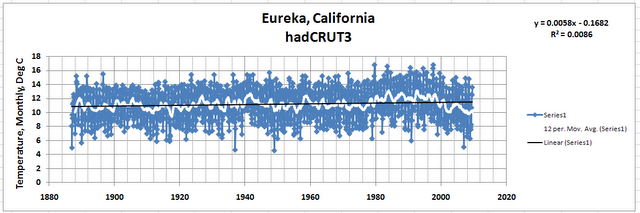

Ich möchte mich kurz zu der faszinierend kleinen Stadt Eureka in Kalifornien zuwenden. Ich war niemals dort, und es liegt an der Pazifikküste zwischen San Francisco und der Grenze zum [US-Bundesstaat] Oregon. Sollten dort 2075 olympische Winterspiele stattfinden, sollte das Städtchen im Angebot verlorener Städte stehen. Schon bald sollte dort nämlich das ganze Jahr über Schnee liegen und eine lokale Eiszeit ausbrechen, wenn sich der gegenwärtige Abkühlungstrend nicht umkehrt. Seit 1990 gab es nämlich dort eine Abkühlung mit einer Rate von 15°C pro Jahrhundert. Die Mitteltemperatur liegt gegenwärtig bei etwa 10°C und wird in 65 Jahren bei 0°C liegen. Man kann sich nur wundern, warum das CO2 die Kleinstadt Eureka übersehen hat. Falls irgendeine Stadt dringend eine globale Erwärmung braucht, wäre es Eureka.

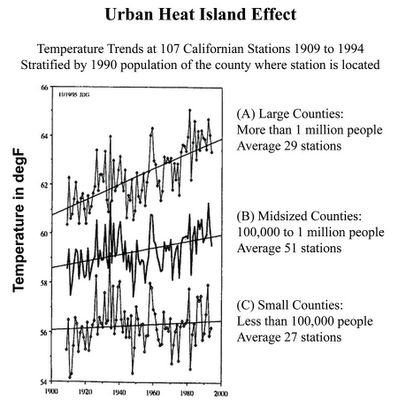

Scließlich wurde mein Augenmerk auf eine veröffentlichte Studie von Dr. James Goodbridge gelenkt, dem früheren staatlichen Klimatologen für Kalifornien, inzwischen im Ruhestand. Seine Arbeit zeigte, dass die Landkreise Kaliforniens in drei Gruppen hinsichtlich der Bevölkerungsdichte eingeteilt werden können. Dann hat er für jede der drei Gruppen den mittleren Temperaturtrend errechnet. Er zeigt, dass Landkreise mit großer Bevölkerungszahl deutlich zunehmende Temperaturen über 80 Jahre aufweisen, während jene mit geringer Bevölkerung überhaupt keine wesentliche Erwärmung zeigen. In Landkreisen mit mittlerer Bevölkerungszahl lag die Erwärmungsrate etwa in der Mitte. Man muss sich ernsthaft fragen, wie das CO2 das bewerkstelligen konnte. Typischerweise liegen die großen Städte alle an der Küste, z. B. San Diego, Los Angeles und San Francisco. Landkreise mit kleiner Bevölkerungszahl sind über den ganzen Staat verteilt, einschließlich in den küstennahen Gebieten ohne große Städte. Es ist höchst unwahrscheinlich, dass das CO2 schlau genug ist, um sich die Landkreise für seine Wärmestrahlung auszusuchen und andere zu ignorieren.

Zusammenfassend bis zu diesem Punkt kann ich über meine Reise Folgendes sagen: Ich habe herausgefunden, dass die Wissenschaftler eine Erwärmung der Erde in einer alarmierenden Größenordnung behaupteten. Doch gab es eine frühere Erwärmung ähnlicher Größenordnung von 1910 bis 1940 während einer Periode mit geringer CO2-Konzentration. Dann hörte diese Erwärmung auf und ging von 1940 bis 1975 in eine leichte Abkühlung über, bevor wieder Erwärmung einsetzte. Es ist unmöglich, dass das CO2 erst für eine Erwärmung, dann für eine Abkühlung und dann wieder für eine Erwärmung gesorgt haben könnte. Es verletzt nicht nur fundamentale physikalische Gesetze, sondern auch die Regeln der Prozesskontrolle. Und schließlich ignoriert das CO2 einige Städte in den USA und tatsächlich auch ganze Landkreise in Kalifornien vollständig, während benachbarte Städte und Landkreise mit großer Bevölkerungszahl eine alarmierende Erwärmungsrate aufweisen. CO2 ist ein einfaches Molekül mit einem Kohlenstoff- und zwei Sauerstoffatomen und kann unmöglich so smart sein.

Alles oben Gesagte war mehr als genug, um mich davon zu überzeugen, dass die Bedrohung durch eine menschengemachte globale Erwärmung falsch ist, dass sie eine leere Drohung ist, ohne jeden Gehalt. Und doch, wenn man die Zusammenfassungen für Politiker sowie die wissenschaftlichen Studien liest, lautet die Prämisse, dass das CO2 Erwärmung verursacht und mehr CO2 noch mehr und schnellere Erwärmung. Alles Weitere folgt aus dieser gescheiterten Prämisse.

Aber es steckt immer noch mehr in dieser Geschichte. Ich möchte beschreiben, was ich beim Betrachten der Temperaturaufzeichnung selbst herausgefunden habe, derjenigen, die von 1910 bis 1940 eine Erwärmung, dann bis 1975 eine Abkühlung und dann wieder eine Erwärmung bis etwa zum Jahr 2000 zeigte. Hierbei ist es wichtig zu wissen, dass es bei der Sammlung und Analyse von Ingenieursdaten, tatsächlich auch in jeder wissenschaftlichen Datensammlung und –analyse, nur selten angebracht ist, zurückliegende Daten zu verändern. Es ist extrem unangebracht, diese Daten wieder und immer wieder zu verändern. Dies erfordert einige Erklärungen.

Die Frage lautet: wie akkurat sind Daten überhaupt? Die Daten hier für Klimazwecke und ob die Welt sich erwärmt oder abkühlt, sind Temperaturdaten. Temperaturdaten kann man heutzutage sehr genau und sehr präzise ermitteln mit moderner Technologie. Nicht, dass ich hier zu technisch werden will, aber Akkuratesse und Präzision sind nicht das Gleiche. Akkuratesse bedeutet zu überlegen, wie nah an der Wahrheit die Messung ist, während Präzision die Frage danach stellt, auf wie viele Stellen nach dem Komma die Messung noch glaubhaft sind. In den Anfängen der Thermometermessungen war es schwierig, diese zu kalibrieren, und es war auch schwierig, Daten auf ein halbes Grad genau abzulesen. So kann es also durchaus sein, dass man an einem sonnigen Tag 80°F gemessen hat, die Temperatur aber tatsächlich nur 78°F betragen hatte [26,7°C bzw. 25,6°C]. Unbekannt ist, wie oft ein Thermometer kaputt gegangen und ersetzt worden ist. Unbekannt ist auch, ob dieses neue Thermometer in der gleichen Weise kalibriert war wie das vorherige. Und schließlich kommt es vor, dass verschiedene Ableser zu unterschiedlichen Messwerten kommen, so dass der eine 70,5°F, der andere aber nur 70°F abliest. Dies hört sich nach nur geringen Unterschieden an, und das sind sie auch. Jedoch heißt es, dass die gesamte Erwärmung im vergangenen Jahrhundert 0,7°C oder etwa 1,2°F betragen hätte.

Schließlich erregte eine interessante Arbeit von E. M. (Michael) Smith meine Aufmerksamkeit. Er betreibt einen Blog mit dem Titel chiefio.wordpress.com. Die einschlägigen Teile seines Blogs sind als „der Marsch der Thermometer“ (hier) bekannt. Michael ist ein ziemliches Genie bei der Programmierung von Computern und der Datenanalyse. Er konnte auf den öffentlich verfügbaren Daten- und Computercode zugreifen, der in der NASA von Dr. James Hansen verwendet wurde und als GISS-Code bekannt ist. Ich glaube, GISS steht für Goddard Institute for Space Studies. Michael entschlüsselte den Code und schrieb in vielen Beiträgen über seine Ergebnisse. Das Schlüsselergebnis war, dass der Code die Daten der Vergangenheit bei jedem Rechenlauf erneut schreibt. Auch gibt es darin fragwürdige Methoden, wie mit fehlenden Daten umgegangen wird, und wie Diskontinuitäten in den Daten eliminiert werden. Ein weiteres und, wie ich finde, sehr wesentliches Ergebnis war, dass Hansen große Teile der Stationen mit Temperaturmessungen in den letzten Jahren entfernt hat. Das sah nicht einmal wahllos aus, sondern vielleicht (wahrscheinlich?) wurden die weggelassenen Stationen so gewählt, dass die Erwärmung der letzten Jahre überbetont wird. Das bedeutet, dass der Temperaturtrend, der aus den Daten von NASA GISS folgt, falsch ist. Ich fordere jeden, der neugierig auf die Temperaturgeschichte der letzten 120 Jahre ist, nachdrücklich auf zu lesen, was E. M. Smith darüber geschrieben hat. Die vergangenen Daten wurden nicht nur verändert, sondern sie wurden oft verändert. Falls Datenlücken entdeckt werden, sucht sich der Computer einfach eine benachbarte Station aus, die bis zu 1200 km entfernt liegen kann (!!!) und benutzt deren Daten.

Dann spuckt das System eine globale mittlere Temperatur aus, die auf Anomalien tausender Temperaturmessstationen rund um die Welt beruht. Anomalien sind ein anderes Feld, in dem man sehr viel Unheil anrichten kann. Das Problem besteht darin, dass einige Städte an kalten Standorten messen und andere an wärmeren Standorten. Was die Klimawissenschaftler tun ist, dass sie jedem Monat eine mittlere Temperatur zuordnen, die auf einer vorbestimmten Periode von etwa 30 Jahren beruht. Einige benutzen jedoch 50 Jahre aus mir unbekannten Gründen. Außerdem ist die Bezugsperiode nicht immer die Gleiche, sondern wird alle 10 Jahre oder so erneuert. Und wieder haben wir bewegliche Ergebnisse mit Daten, die immer wieder neu angepasst werden. Das erinnert mich an das uralte Hütchenspiel mit der Erbse, bei dem unter einem von drei Hütchen eine Erbse liegt. Das Augenmerk versucht, auf dem Hütchen mit der Erbse darunter zu verbleiben, während einer die Hütchen wild hin und her schiebt.

Der Gebrauch von Anomalien ermöglicht es, Temperaturtrends aus verschiedenen Regionen übereinander zu legen, egal ob die absolute Mitteltemperatur 5 Grad (Alaska) oder 25 Grad (Bora Bora) beträgt. Und doch ist es ziemlich beunruhigend, eine andere Möglichkeit der Datenmanipulation zu erkennen. Eine bessere Methode ist meiner Ansicht nach, den Datentrend für jede Dekade und jede Station zu ermitteln. Sollte die Station einen Erwärmungstrend um 0,1 Grad pro Dekade zeigen, gehen diese 0,1 Grad in die Bildung des Gesamtmittels ein. Dabei würde es keine Anomalien geben, keine Bezugsperioden, keine Änderungen der Vergleichsbasis alle 10 Jahre, sondern einfach eine einmalige Berechnung eines Dekadentrends. Dieser Dekadentrend wäre dann fest und nicht Gegenstand von Änderungen.

Eine weitere sehr verstörende Enthüllung ist der exzellenten Arbeit von Anthony Watts zu verdanken, der schon früher hier in Zusammenhang mit seinem Blog erwähnt worden war. Anthony hat auch eine historische Leistung vollbracht, indem er die große Mehrheit der Klimamessstationen in den USA begutachtet hat (hier). Seine Untersuchung konzentrierte sich auf die Frage, wie gut oder schlecht die Stationen relativ zur Umgebung im Vergleich mit den Vorschriften aufgestellt waren. Beispielsweise muss eine gut positionierte Messstelle bestimmte Entfernungen von Bäumen, Gebäuden oder anderen Strukturen einhalten, sie muss in der korrekten Höhe über grasbewachsenem Boden messen und darf nicht von künstlichem Heizen oder Kühlen betroffen werden wie der Abluft von Air Condition. Was Athony fand, war erschreckend (hier). Er schrieb seine Ergebnisse zusammen mit vielen Mitautoren nieder und veröffentlichte seine Studie 2011 (Zusammenfassung hier). Viele Stationen wurden als sehr schlecht bewertet, und nur wenige waren gut positioniert. Einige Stationen standen tatsächlich an Mauern, auf asphaltierten Parkplätzen, nahe bei Entlüftungsanlagen oder Grillplätzen, auf asphaltierten Dächern und in der Nähe von Rollbahnen auf Flughäfen und den Abgasen der Düsenjets sowie an vielen anderen inakzeptablen Orten. Hier liegen die Quellen für die Temperaturrekorde in den USA, von welchen angenommen wird, dass es die besten und genauesten der ganzen Welt sind. Eine ländliche Umgebung würde in früheren Jahren vermutlich niedrigere Werte ergeben haben, aber wärmer und wärmer werden, wenn immer mehr Gebäude errichtet werden, Straßen und Parkplätze gebaut werden, sowie viele andere Dinge. Folglich bestand ein Teil der Arbeit von Anthony darin zu bestimmen, wie viel eines jeden gezeigten Erwärmungstrends auf die Positionierung der Stationen zurückzuführen war.

Es gibt noch einige weitere Punkte, und mit denen möchte ich schließen.

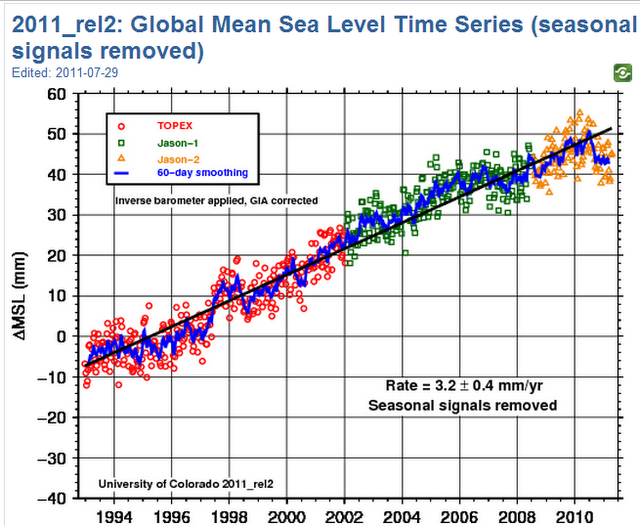

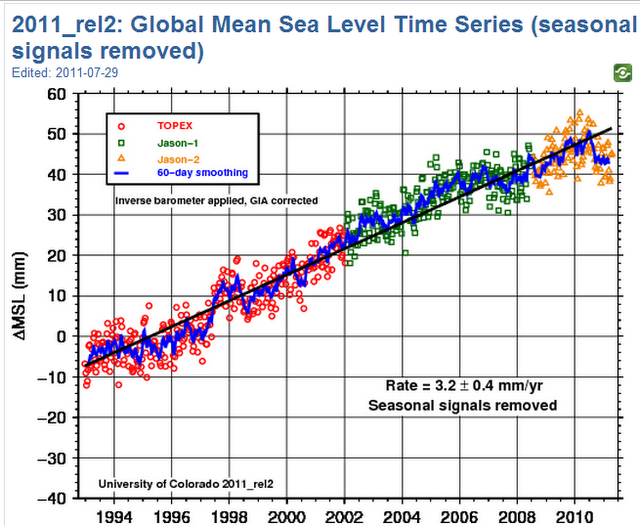

Zunächst einmal, der Meeresspiegel steigt nicht, und die Ozeane werden nicht wärmer. Dies allein widerlegt bereits den gesamten CO2-Erwärmungsunsinn. Dem Glauben der Warmisten zufolge müssten die Ozeane wärmer werden und der Meeresspiegel mit zunehmendem CO2-Niveau steigen. Nichts davon passiert. Die Daten von NASA und NOAA selbst zeigen das ganz klar. Die Graphik unten stammt von U. Colorado und basiert auf Satellitenmessungen des Meeresspiegels der Nasa. Man beachte den stark abnehmenden Trend seit 2005 und die plötzliche Abnahme Anfang 2010.

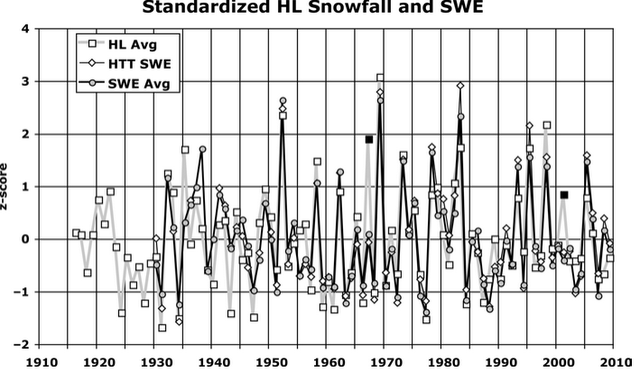

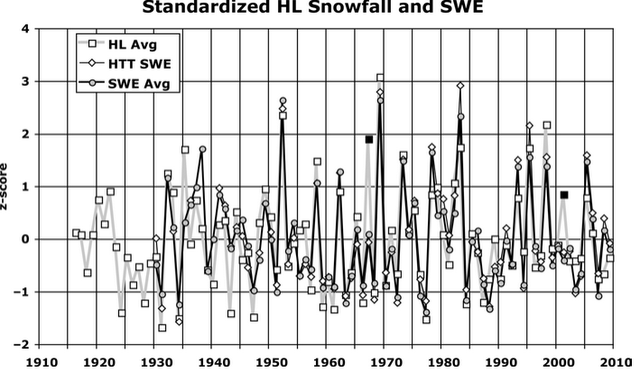

Die nächste Abbildung zeigt, dass sich die Schneebedeckung der Sierra Nevada und das Schnee-Wasser-Äquivalent während der letzten 100 Jahre nicht signifikant verändert hat. Dr. John Christy von der University of Alabama, Huntsville, hat 2010 hierzu eine Studie veröffentlicht. Seine Daten enden 2009. Seitdem hat es rekordverdächtige Schneefälle in den Sierras gegeben. Sein grundlegender Graph ist unten zu erkennen, geglättet, um die Abweichung der Schneebedeckung vom Mittel zu zeigen. Diese Studie bezieht sich auf die zentrale Schneemessstation am Huntington Lake HL. Die Studie gibt es hier.

Zweitens zeigt eine vor Kurzem erschienene, wissenschaftlich begutachtete Studie vom CERN, dass Wolken und Sonnenflecken zusammen hängen, und zwar dergestalt, dass es im 20. Jahrhundert eine hohe Sonnenfleckenaktivität gegeben hatte, während sich in der Kleinen Eiszeit nur wenige oder gar keine Flecken zeigten. Während der letzten 4 Jahre oder so, ist es auf der Sonne plötzlich wieder sehr, sehr ruhig geworden, und es wir kühler. Das Fehlen von Sonnenflecken kam als vollkommene Überraschung für Wissenschaftler weltweit. Die Beziehung besteht darin, dass mehr Sonnenflecken gleichbedeutend sind mit einem wärmeren Klima. Der Mechanismus dahinter: das Magnetfeld der Sonne ist immens und wird größer und intensiver, wenn die Aktivität von Sonnenflecken zunimmt. Das Magnetfeld schützt die Erde vor der kosmischen Hintergrundstrahlung GCR. Wenn jedoch die GCR auf die Atmosphäre trifft, erzeugen sie Kondensationskerne für Wolken, und es bilden sich mehr davon. Mehr Wolken reflektieren mehr Sonnenlicht, so dass es auf der Erde kälter wird. Ein weiteres Beweisstück dafür, dass die Wissenschaft alles andere als einig [settled] ist. Sie können ja nicht einmal die Anzahl der Sonnenflecken vorhersagen noch die Zeit, wann sie auftreten. Das CERN-Experiment und die veröffentlichte Studie erfolgten erst vor wenigen Wochen.

Drittens stimmen die Klimamodelle nicht überein, und deren Projektionen passen nicht zu den Satellitenmessungen. Dies zeigt, dass die Wissenschaft weit davon entfernt ist, sich einig zu sein, und wenn die Modelle die gemessenen Daten nicht abbilden können, sind sie falsch und müssen entweder verworfen oder verbessert werden, sofern das möglich ist. Eine eben erst erschienene Studie von Spencer and Braswell hat zu einem Aufruhr in der Klimaszene geführt, weil sie sehr klar zeigt, dass die Modelle mit ihren Prognosen weit von der Wirklichkeit entfernt sind. Die Satellitendaten passen nicht zu den Modellen.

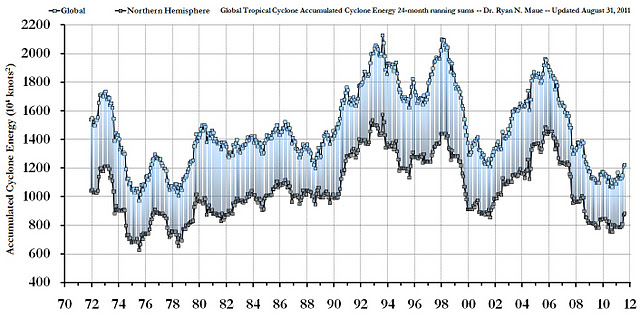

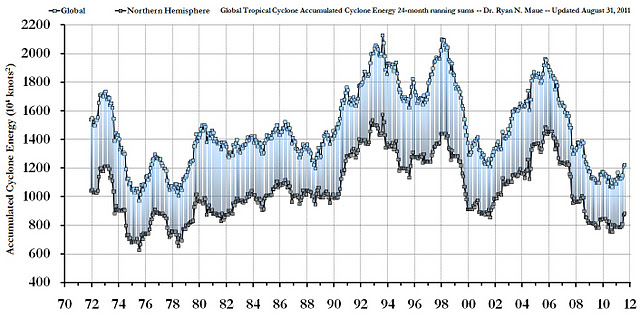

Viertens, Hurrikane werden nicht immer häufiger und stärker. Tatsächlich war die derzeitige Hurrikanaktivität seit Beginn von Satellitenbeobachtungen noch nie so gering. Inzwischen steigt der CO2-Gehalt immer weiter. Eine weitere Fehlvorhersage, die beweist, dass ihre Gedanken kompletter Unsinn sind. Die Karte unten stammt von Dr. Ryan Maue von der Florida State University und zeigt den gegenwärtigen Status der Tropischen Zyklone weltweit, gemessen als Accumulated Cyclone Energy von 1972 bis heute. Die obere Linie steht für die ganze Welt, die untere für die Nordhemisphäre. Die Gesamtenergie liegt jetzt wieder auf einem Niveau wie Mitte der siebziger Jahre, und der CO2-Gehalt steigt immer weiter.

Fünftens und letztens, die einzige zutreffende Prognose der Warmisten ist die fortgesetzte Abnahme der arktischen Eiskappe. Allerdings haben sie dabei Ursache und Wirkung aus folgenden Gründen komplett falsch angesetzt. Erstens behaupten die Warmisten, dass eine schrumpfende Eiskappe ein starker Beweis für eine Erwärmung der Arktis wäre und dass diese Erwärmung durch die Rückstrahlung des CO2 in der Atmosphäre kommt. In Wirklichkeit bildet Eis einen Isolator und verhindert die Abgabe der Wärme aus den Ozeanen in die Atmosphäre. In gleicher Weise wirkt das Eis auf Seen und verhindert, dass die Seen komplett zufrieren, solange sie nicht zu klein sind. Die wachsende und schrumpfende Eisbedeckung in der Arktis agiert als negative Rückkopplung auf den Wärmegehalt der Ozeane. Wenn sich die Ozeane erwärmen, schmilzt das Eis an den Rändern. So gibt es dann mehr offenes Wasser, das Strahlung aussendet. Normalerweise wird das Minimum der Eisbedeckung Mitte September erreicht, was in den langen Polarnächten die Ausstrahlung großer Wärmemengen zur Folge hat. Dadurch kühlen sich die Ozeane wieder ab, danach die Luft, so dass sich wieder mehr Eis bildet. Das System oszilliert dann zwischen mehr oder weniger Eis mit der Folge, dass auch Temperatur und Wärmegehalt der Ozeane oszillieren mit einer leicht verschobenen Phase.

Schlussfolgernd lässt sich also sagen, falls irgendjemand noch daran glaubt, dass das CO2 das macht, was die Wissenschaftler behaupten, schlage ich vor, dass Sie das nächste Mal daran denken, wenn Sie am Lagerfeuer sitzen oder neben einer Kerze oder jeder anderen stabilen Energiequelle. Bewegen Sie sich hin zu ihr, dann wieder zurück. Suchen Sie auch nach einer soliden Mauer, die von der Sonne beschienen worden ist. Legen Sie ihre Hand nach Sonnenuntergang an die Mauer und fühlen Sie deren Wärme. Entfernen Sie sich dann von der Mauer und beobachten, wie lange die Wärme noch fühlbar ist. Denken Sie dann an das kleine CO2-Molekül, das auch die Wärme fühlen muss, die Wärme absorbiert und sie dann wieder ausstrahlt. Man erinnere sich, dass die Wissenschaftler darauf bestehen, dass sich die Erde von 1910 bis 1940 erwärmt hat – obwohl der CO2-Gehalt sehr, sehr niedrig gelegen hatte.

Schauen Sie auch auf die Blogs von Anthony Watts und E. M. Smith. Überdenken Sie Folgendes: wenn sich die Wissenschaft einig ist und wir jetzt etwas tun müssen, wenn wir die Zukunft der Erde nicht an eine Wärmehölle verlieren wollen oder an steigende Ozeane oder an Monsterhurrikane und all die anderen Katastrophen, warum hat dann das CERN-Experiment gezeigt, dass die Wolken erheblich wichtiger sind als das CO2? Warum zeigen die Satellitenmessungen, dass die Modellvorhersagen alle falsch sind? Warum hat sich nie etwas zugunsten der Warmisten gezeigt? Das einzige, worauf die Warmisten zeigen können, ist das abnehmende Meereis in der Arktis, aber wie oben schon angesprochen, liegen sie damit völlig falsch.

Sehen Sie selbst, dass viele, viele Städte keine Erwärmung oder gar leichte Abkühlung zeigen. Dann fragen Sie sich, wie kann das sein? Wie kann das CO2 so schlau sein, dass es selektiv einige Städte außen vor lassen kann?

CO2 ist unschuldig. Das war es immer und wird es immer sein.

Roger E. Sowell, Esq.

Link: http://sowellslawblog.blogspot.com/2011/09/from-man-made-global-warmist-to-skeptic.html

Übersetzt von Chris Frey für EIKE