Öl und Benzin – der Faktencheck!

Tatsächlich ist nichts davon nachvollziehbar. Weder die Situationsbeschreibung, noch die Ideen zur Lösung eines Problems, das man zu sehen glaubt, ohne es wirklich zu erkennen.

Vor mir liegt die Studie “Reserven, Ressourcen und Verfügbarkeit von Energierohstoffen” der Bundesanstalt für Geowissenschaften und Rohstoffe (BGR) des Jahres 2006. Dieses Papier scheint nicht mehr zum Download zur Verfügung zu stehen. Es heißt darin auf Seite 16:

“Das verbleibende Potenzial an konventionellem Erdöl kann aus geologischer Sicht bei moderatem Anstieg des Erdölverbrauchs die Versorgung mit Erdöl über einen Zeitraum von etwa 10 bis 15 Jahren gewährleisten. Nach diesem Zeitraum muss infolge des zu erwartenden Rückgangs der Erdölförderung nach Überschreiten der weltweit maximal möglichen Förderung mit einer Versorgungslücke bei Erdöl gerechnet werden, die durch andere Energieträger oder Erdölsubstitute (aus Erdgas, Kohle oder Biomasse) ausgeglichen werden müsste.”

Nun wird diese Untersuchung durch das BGR jährlich durchgeführt. Die aktuellste Version von Ende 2011 enthält zur Frage der Verfügbarkeit von Erdöl die folgende Aussage:

“Für die nächsten Jahre kann aus geologischer Sicht bei einem moderaten Anstieg des Erdölverbrauchs die Versorgung mit Erdöl gewährleistet werden. Nach der als optimistisch anzusehenden BGR-Projektion könnte die globale Erdölförderung bis etwa 2036 gesteigert werden und 4,6 Mrd. t/a erreichen.”

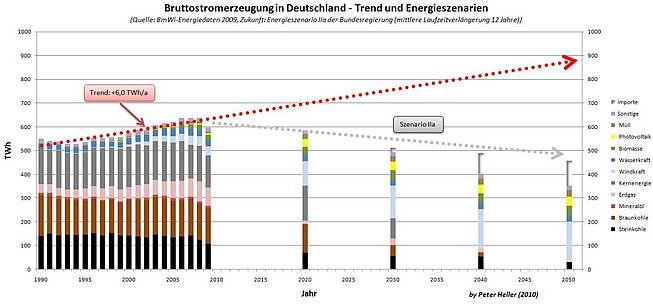

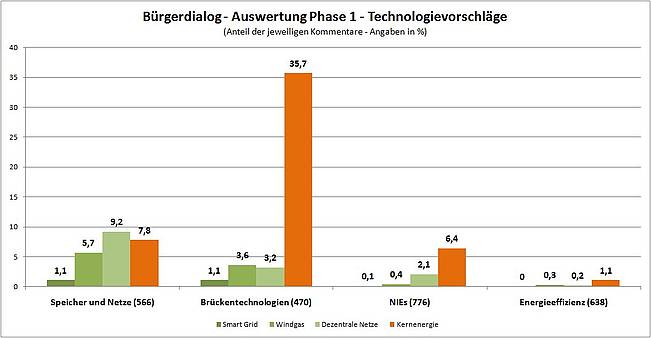

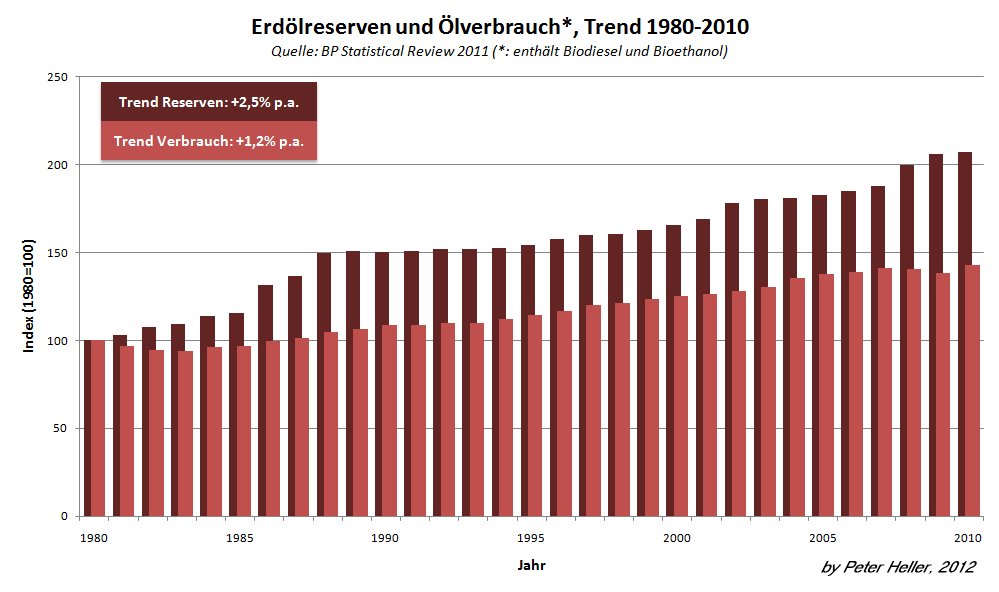

In nur fünf Jahren hat sich damit ein möglicher “Peak Oil” um fünfzehn Jahre nach hinten verschoben. Dies ist ein stabiler Trend in allen Prognosen dieser Art: Das erwartete Fördermaximum wandert schneller in die Zukunft, als die Zeit vergeht. Das erste Diagramm zeigt, warum das so ist. Bei nahezu gleichbleibender Produktion in den letzten Jahrzehnten steigt die Zahl der gesicherten Reserven immer weiter an. Die Erdölkonstante, die statische Reichweite, erhöht sich dadurch ständig. Lag sie 1980 noch bei etwa 30 Jahren (demzufolge hätten wir eigentlich schon seit zwei Jahren kein Benzin mehr), ist sie heute bei über 50 angekommen.

![]()

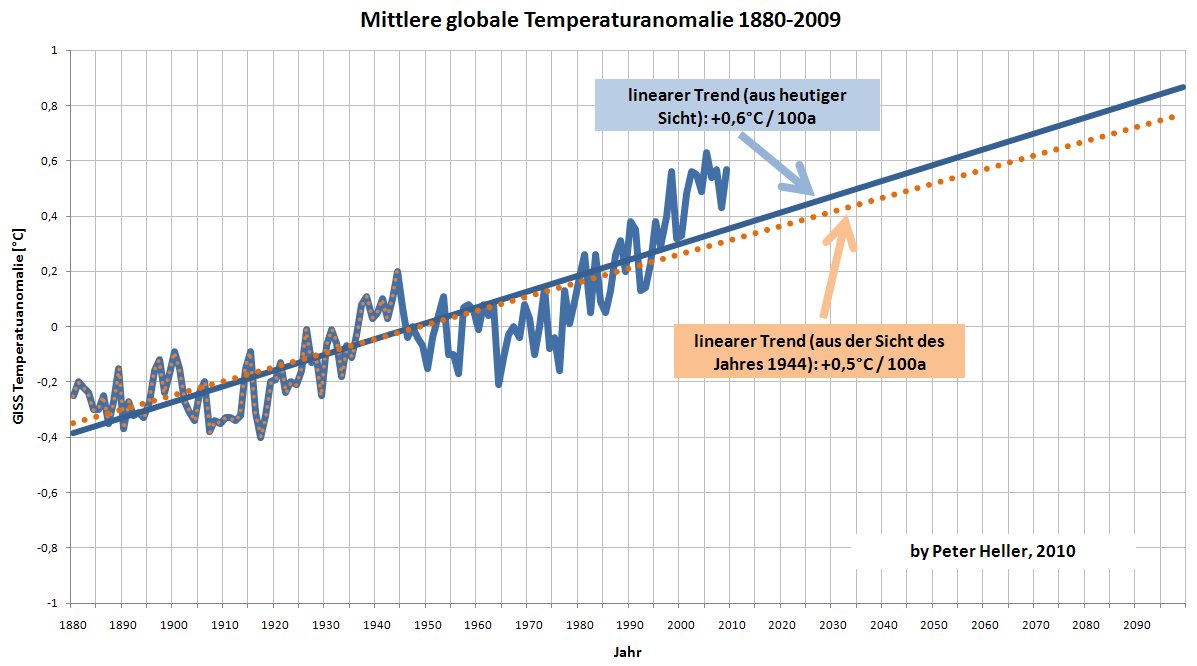

Oft kommt seitens der Peak-Oil-Vertreter an dieser Stelle das Argument, die Konstanz der Produktion wäre das eigentliche Problem. Viele der Reserven seien in Wahrheit nur mit hohem Aufwand und unter hohen Kosten zu erreichen. Die Ölförderung könne eben nicht mehr über das heute erreichte Niveau hinaus gesteigert werden. Das ist eine merkwürdige Argumentation. Warum sollte denn versucht werden, die Förderung zu erhöhen, wenn es keinen Bedarf gibt? Tatsächlich steigen die Ölreserven sogar doppelt so schnell, wie der Verbrauch (nachfolgende Abbildung – Leider enthält der “Ölverbrauch” in den mir vorliegenden Daten von BP auch Biodiesel und Bioethanol, auf die der moderate Anstieg von etwa 1 Prozent pro Jahr wesentlich entfällt.). Und wenn es eine Konstante im Ölgeschäft tatsächlich gibt, dann die, daß nur gefördert wird, was man auch verkaufen kann.

![]()

Die Reserven, die heute schon zu marktfähigen Kosten förderbaren Vorkommen, machen nur einen Bruchteil des Erdöls aus, das uns zur Verfügung steht. In den Diagrammen sind von den unkonventionellen Vorkommen nur geringe Mengen der kanadischen Ölsande enthalten. Vor allem hinsichtlich des Potentials von Schieferöl (nicht zu verwechseln mit “Ölschiefer”) gibt es noch keine belastbaren Aussagen. Alles, was ich dazu finden konnte, ist eine Studie des privaten Washingtoner Think Tanks “Institute for Energy Research”, in der man aus verschiedenen Quellen Ressourcen in einer Größenordnung von etwa 1.800 Milliarden Barrel allein für Nordamerika abgeleitet hat (Seite 15) – mehr als die globalen Reserven von derzeit etwa 1.500 Milliarden Barrel. Darf man vermuten, dieses Öl würde im Boden belassen, wenn es jemand kaufen möchte? Wohl eher nicht.

Es gibt keine Verknappung, noch ist eine solche für die kommenden Jahrzehnte absehbar. Die BGR sieht das fast ganz richtig, in ihrer Energiestudie von 2011:

“Insbesondere die fortschreitende Technologieentwicklung im vergangenen Betrachtungszeitraum hat die Trennung in konventionelle und nicht-konventionelle Vorkommen unschärfer werden lassen.”

Ich würde weiter gehen. Eine solche Trennung ergibt keinen Sinn mehr. Das Gerede von einer bevorstehenden Verknappung des Öls entbehrt damit jeder Grundlage.

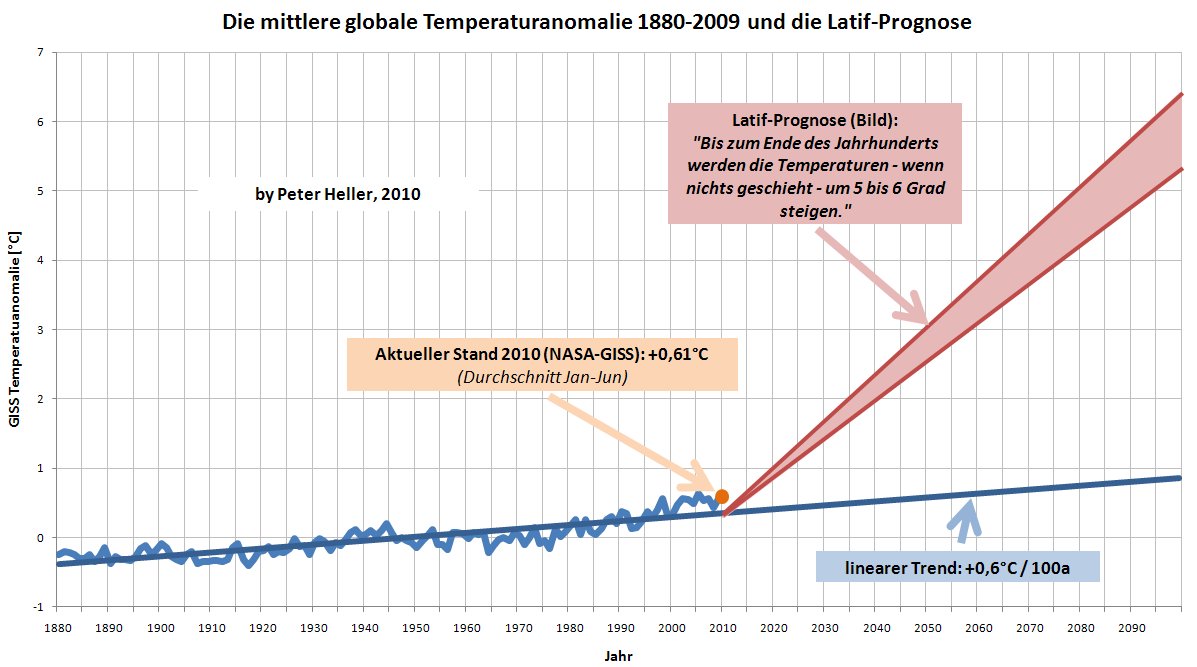

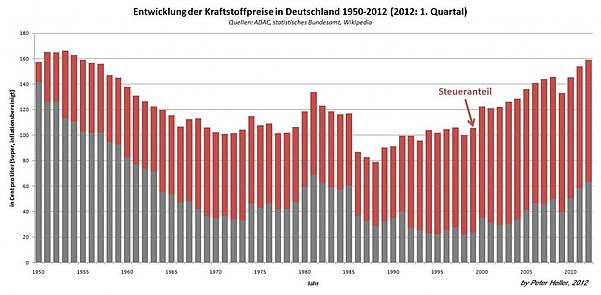

Trotzdem habe ich heute für 1,72 Euro pro Liter getankt. Das ist mehr, als ich im Laufe meines Autofahrerlebens bislang gewohnt war. Die dritte Abbildung zeigt: Es ist wohl mehr als zum historischen Höchststand des Jahres 1953. Moment mal, werden jetzt viele einwerfen, in den 1950er Jahren hat Benzin doch nur ein paar Pfennige gekostet. Stimmt natürlich, 1953 waren es im Jahresdurchschnitt etwa 37 Pfennig pro Liter. Aber diese 37 Pfennig waren damals so viel wert, wie heute 160 Cent. Das Diagramm ist mit den Daten zum Verbraucherpreisindex des statistischen Bundesamtes inflationsbereinigt. Die Spritpreise (Jahresmittelwerte) stammen vom ADAC und die jeweiligen Sätze für Mineralöl- und Umsatzsteuer kann man bei Wikipedia nachlesen. Für das Jahr 2012 sind die Monate Januar bis März berücksichtigt. Es wird deutlich, wer am Autofahrer wirklich verdient. Nicht die Ölmultis, sondern Wolfgang Schäuble.

Gerade mal 60-70 Cent kostet der Liter heutzutage. Das ist im Verlauf der Jahrzehnte nicht ungewöhnlich. Langfristig zeigt der Trend nach unten, von Schwankungen auf kürzeren Skalen überlagert. Die Rekordwerte entstehen, weil von jedem Liter der Staat mittlerweile fast einen Euro einkassiert. Der rote Bereich im Diagramm zeigt den Steueranteil.

Nichts ist es mit dem knappen Öl. Und Preiskartelle der Konzerne haben und hatten, wenn es sie denn gibt oder gab, nur Ausschläge von wenigen Cent hervorgerufen. Der Kostentreiber bei Benzin ist der Staat – und niemand sonst. Es hilft hier auch keine Energiewende, es hilft keine Erhöhung der Pendlerpauschale und schon gar nicht hilft eine Debatte über Unternehmensstrategien. Allein eine schnelle und substantielle Senkung der Steuerlast, der Mehrwert- und vor allem der Mineralölsteuer, könnte Entlastung bringen. Auch langfristig. Dieses Thema aber scheuen alle Parteien. Was nicht verwundert.

Unsere wirklichen Probleme mit dem Öl werden in zwanzig oder dreißig Jahren ganz andere sein. Nicht zu wenig wird es geben, sondern zu viel. Vor allem in Nordamerika, in den USA, in Kanada und in Mexiko. Angesichts des unaufhaltsamen technischen Fortschrittes haben sowohl Exxon, als auch BP analog zu den Analysten der Citigroup ihre neuesten Zukunftsszenarien gegenüber dem Jahr 2010 deutlich verändert. Die baldige Unabhängigkeit des nordamerikanischen Wirtschaftsraums von Importen ist nicht mehr hypothetisch, sondern wahrscheinlich. Es wird dann niemand mehr da sein, der ein Interesse daran hat, auch die Versorgung Europas aus politisch instabilen Regionen abzusichern. Die Navy wird sich fein heraushalten, wenn irgendein Potentat mal wieder die Straße von Hormus zu sperren droht. Ein neues Erdölzeitalter beginnt. Und wir sind nicht darauf vorbereitet.

Dr. Peter Heller; zuerst erschienen bei Science Sceptical