NCSE: Wann ist angebliche Wissenschaft keine Wissenschaft mehr?

Mark ist wahrscheinlich verantwortlich für wissenschaftlich so unhaltbare Statements wie:

„Viele unabhängige Wege der Beweisführung zeigen, dass menschliche Aktivität für das meiste der Klimaänderung der letzten Jahre verantwortlich ist, im Besonderen die Erwärmung der Atmosphäre und der Ozeane während der letzten 150 Jahre, … dass wir ‚dramatische Änderungen’ bzgl. … Klima … und Ökosystemen sehen, einschließlich der Verteilung der Regenmenge, der Aktivität von Stürmen, dem Aussterben von Tier- und Pflanzenarten sowie jahreszeitliche Änderungen“.

Nicht zu erwähnen seine Verantwortung für sachlich unhaltbare Statements wie:

„Leugner des Klimawandels sind Leute und Organisationen, die den wissenschaftlichen Konsens zur Klimaänderung leugnen oder bezweifeln, um politische Maßnahmen zum Klima zum Stehen zu bringen, sie zu verzögern oder herabwürdigen, (und welche) danach trachten, den wissenschaftlichen Konsens hinsichtlich der Klimaänderung zu verunglimpfen oder zu verschleiern“.

Wie auch immer, Ausgabe 31(5) der NCSE-Berichte, dem Hausjournal des NCSE, stellte einen Artikel von Dr. David Morrison vor, und zwar mit der moderaten Schlagzeile: „Wissenschaftliche Leugnung: Evolution und Klimaänderung“. Ich war viele Jahre lang Mitglied des NCSE gewesen, und durch diese Ausgabe der NCSE-Berichte merkte ich zum ersten Mal, dass sie das süsse AGW-Gift* getrunken hatten. „Erschrocken und bestürzt“ beschreibt meine Gefühle nur unzureichend.

[*Kool-Aid: Ein Erfrischungsgetränk in den USA mit sehr viel Zucker. Obwohl alkoholfrei, werden manche Leute süchtig danach. A. d. Übers.]

David Morrison ist Direktor des SETI-Institutes [SETI = Search for Extraterrestrial Intelligence] und ein sehr angesehener Astronom mit einer herausragenden Laufbahn. Nichtsdestotrotz schwappt sein 4,5 Seiten langer Artikel durch die Schwachstellen bzgl. des Klimas (mit ‚Spritzern’ wie „Die heutige Erwärmung geht viel schneller vonstatten als in jedwedem historischen Zyklus“ oder „wir brauchen keine (numerischen) Klimamodelle um zu sehen, dass sich die Welt rapide erwärmt“). Dann folgen weitere 4,5 Seiten knöcheltiefe Polemiken, in denen die AGW-Skeptiker gleichgesetzt werden mit den Kreationisten oder Lobbyisten der Tabakindustrie (wie z. B. „Das Marshall-Institut … ist das Gegenstück zum Discovery Institute“ (eine Organisation der Kreationisten. A. d. Autors) oder „Strategien, die von den Gegnern sowohl der Evolution als auch der globalen Erwärmung benutzt werden, basieren auf ausgestreuter Fehlinformation und Zweifel… oft als ‚Tabak-Strategie’ bezeichnet“. Im Artikel wimmelt es von Begriffen wie „Leugnern“ der globalen Erwärmung, „Leugnen“ und „Leugnung“. Dr. Morrison erzählt uns, dass „der einzige Weg (der Leugner der Erwärmung) darin besteht, den internationalen wissenschaftlichen Konsens hinsichtlich der Gründe des Klimawandels zu leugnen“. Ich wette, dass niemand auf WUWT das gewusst hat.

Nach der Lektüre von so viel Fehlinformationen und dem Austausch nichtssagender E-Mails mit Eugenie Scott (geschäftsführende Direktorin am NCSE) und Andrew Petto (Herausgeber der NCSE-Berichte) habe ich mich entschlossen, einen Brief an „NCSE Berichte“ zu senden als Reaktion auf David Morrisons Artikel. Abgeschickt habe ich ihn am 16. Januar 2012, und am 14. März wurde er zurückgewiesen. NCSE-Herausgeber Dr. Petto schrieb: „Wir haben entschieden, den Brief als Antwort auf Morrisons Artikel zurückzuweisen, da er wenig dazu beiträgt, Morrisons Hauptargument in diesem Falle zu stützen oder zu widerlegen, bei dem es ja darum ging, wie die Gegner der gegenwärtigen Modelle zur Klimaänderung ihre Informationen an Regierungen und Öffentlichkeit geben“.

Mit ausführlichen Zitaten, um meine Position zu stützen, wies ich darauf hin, dass „es beim Hauptargument in Dr. Morrisons Artikel um die Klimawissenschaft geht und erst in zweiter Linie auch um ‚Leugner’, von denen dann gesagt wird, dass sie darüber fehlinformieren, es ignorieren oder Lügen darüber verbreiten. Meine Einlassung beschäftigt sich mit dem ersten Teil – dem Hauptteil – der These von Dr. Morrison; welche eine wirkliche Verengung des Blickwinkels ist“. Und: „Falls Dr. Morrisons Wissenschaft falsch ist, ist seine These über die Kommunikation sinnlos und irrelevant“. Dr. Petto war davon nicht berührt.

Das ist der Hintergrund. Hier folgt gleich der (abgelehnte) Brief. Wirklich? Ich glaube, dass er unter einem Vorwand abgelehnt worden ist. Beurteilen Sie selbst, ob er „wenig dazu beiträgt, Morrisons Hauptargument zu stützen oder zu widerlegen“.

==============================================================

Wann ist angebliche Wissenschaft keine Wissenschaft?

Patrick Frank

In seinem exzellenten Buch „Galileo” (1) weist Stillman Drake auf Galileos sehr modernes Verständnis der wissenschaftlichen Praxis hin, wenn er schreibt: „In seinem Buch über Hydrostatik merkte Galileo an, dass die Autorität eines Archimedes nicht mehr wert war als die Autorität eines Aristoteles; Archimedes hatte recht, schreibt er, nur weil seine Ergebnisse zu [den Ergebnissen von] Experimenten passten“. Galileo hat das im Jahr 1612 geschrieben und drückte damit ein identisches Verständnis von Wissenschaft wie bei Albert Einstein aus, der sich dazu 300 Jahre später äußerte: „Falls die Rotverschiebung der Spektrallinien wegen des Potentials der Schwerkraft nicht existieren würde, wäre die Allgemeine Relativitätstheorie unhaltbar“.

Einsteins Feststellung zu Theorie und Beobachtung wird von Karl Popper aufgegriffen in seinem autobiographischen Werk „Unended Quest“ [etwa: unendliche Entdeckungsreise] (2). Popper fährt fort, dass Einsteins kritische Beobachtung eine Enthüllung war, und öffnete den Weg für sein eigenes, seine ganze Laufbahn durchziehendes Argument, dass Wissenschaft das Wechselspiel zwischen widerlegbaren Theorien und empirischen Ergebnissen sei (Vermutungen und Widerlegungen). Die Theorie muss zu einheitlichen und falsifizierbaren Vorhersagen mit Hilfe analytischer Ableitungen führen. Daten, die jederzeit und von jedermann überprüft werden können, sprechen das Urteil. Nur diese beiden Gegenpole machen echte Wissenschaft aus. Betrachtet man sie getrennt voneinander, ist das keine Wissenschaft.

Eine Folge dieser Beziehung ist, dass die Bedeutung empirischer Daten nur im Zusammenhang mit einer falsifizierbaren Theorie zu finden ist. Das stimmt, selbst wenn es bedeutet, dass die Daten der Vorhersage widersprechen und die Theorie widerlegen. Nur eine falsifizierbare physikalische Theorie grenzt die Bedeutung von Blitzen von der Hand Gottes ab. Nur die Kapazität der Falsifizierbarkeit erzeugt eine einheitliche Vorhersage und bietet eine eindeutige Bedeutung der Daten. (3)

In einer kürzlich erschienenen Ausgabe der NCSE-Berichte schrieb Dr. David Morrison einen Essay (4) über „Leugnung in der Wissenschaft“. Das war nichts weiter als ein sehr langer Versuch, Leugner der Evolution mit AGW-Skeptikern gleichzusetzen. Es gab kaum Wissenschaft in Dr. Morrisons Essay. Er lässt sich im Wesentlichen so zusammenfassen: „Klimamodelle sind wirklich komplex und stimmen auch nicht immer mit Details überein wie z. B. dem Timing der zukünftigen Erwärmung. Allerdings ist der Beweis für die Erwärmung empirisch, und deren zukünftige Trends sind in grundlegender Physik verankert, genauso wie der Treibhauseffekt und die Wärmekapazität der Ozeane“.

Dieses Bewusstsein der Bedeutung in der Wissenschaft zeigt sofort die Schwäche von Dr. Morrisons Position: Er schreibt der Klimaerwärmung kausale Bedeutung zu und räumt gleichzeitig das Fehlen einer Klimatheorie ein. Der Beweis für die Erwärmung ist feststellbar empirisch. Aber die Bedeutung dieser Erwärmung kann nur aus einer falsifizierbaren Theorie kommen, die einheitliche Aussagen über das Klima macht. Ist die Erwärmung Folge zusätzlichen CO2 in der Atmosphäre oder nicht? Keine Menge empirischer Daten kann diese Frage beantworten.

Dr. Morrison behauptet, dass der Treibhauseffekt (eine nicht korrekte Bezeichnung, aber lassen wir das jetzt) und die Wärmekapazität ausreichen um abzuschätzen, wie das Erdklima auf den steigenden Gehalt atmosphärischen CO2 reagieren wird. Aber der „Treibhauseffekt“ – im Wesentlichen Strahlungsphysik – und die Wärmekapazität bilden keine adäquate Klimatheorie. Sie machen keine Aussage darüber, wie sich die zusätzliche Energie in der Atmosphäre in den ganzen Klimaverhaltensweisen verteilt, wie z. B. ENSO-Zyklen, und vor allem dem globalen hydrologischen Zyklus von Schmelzen, Verdunstung, Wolkenbildung und Niederschlag.

Dr. Morrison machte den bemerkenswerten Einwand geltend, dass „wir keine numerischen Modelle brauchen, um uns zu sagen, dass (der höhere Gehalt von CO2) ein Vorbote noch deutlich schlimmerer Klimastörungen in Zukunft ist“. Aber natürlich brauchen wir Klimamodelle, die uns darüber Auskunft geben. Wie sonst können wir das wissen? Klimamodelle repräsentieren die physikalische Theorie des Klimas. Es ist ausschließlich deren Vorhersageaufschluss, die dem atmosphärischen CO2 eine kausale Bedeutung zukommen lässt. Das ist der felsenfeste Anker der Wissenschaft, und Dr. Morrison hat das nicht verstanden.

Werfen wir einen kurzen Blick auf die Klimamodelle. Sie tun viel weniger als lediglich „nicht immer mit den Details“ des zukünftigen Klimas überein zu stimmen. Sie stimmen nicht einmal mit der Wirklichkeit vergangener Klimaperioden überein. Zum Beispiel haben Demetris Koutsoyiannis et al. die erweiterten generellen Klimazirkulationsmodelle (GCMs) evaluiert, die für den Vierten Zustandsbericht des IPCC 2007 verwendet worden waren (5, 6). Das IPCC nutzte diese GCMs, um 100 Jahre des Klimas im 20. Jahrhundert „nachherzusagen“, und zwar an allen Gitterpunkten eines globalen Netzes. Die reproduzierte globale Temperatur sah großartig aus. Das sollte sie auch, weil die GCMs so angepasst worden sind, dass sie den bekannten globalen Temperaturverlauf reproduzieren (7).

Aber die Gruppe um Koutsoyiannis untersuchte das globale Klimamodell des IPCC im 20. Jahrhundert und rekonstruierte, was die Klimamodelle über die Temperaturaufzeichnungen im vorigen Jahrhundert in den kontinentalen USA gesagt haben. Die Klimamodelle lagen sehr daneben. Sie untersuchten auch die Nachhersage der GCMs hinsichtlich von Temperatur und Niederschlag an 58 Stationen rings um die Welt. Diese Rekonstruktion versagte kläglich im Vergleich mit den realen Daten. An die Durchführung eines solchen grundlegenden Tests der Verlässlichkeit der GCMs scheint während der letzten 20 Jahre des Klimaalarms niemand gedacht zu haben; ein Klimaalarm, der angeblich durch gerade diese GCMs glaubhaft gemacht worden ist. Klimamodelle können das bekannte Klima nicht reproduzieren. Warum sollte dann irgendjemand glauben, dass sie zuverlässig ein unbekanntes Klima vorhersagen können?

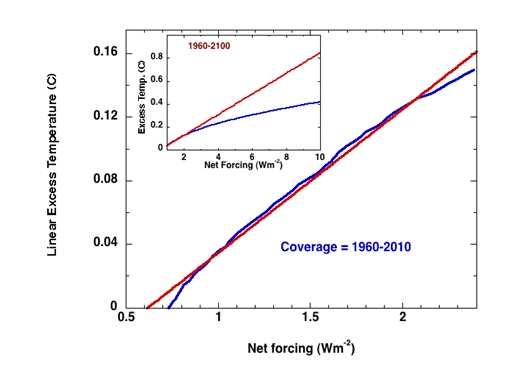

Dr. Morrison erwähnte, dass Klimamodelle die Wolken nicht richtig simulierten, qualifizierte dieses Problem aber gleich danach als irrelevant ab. Aber Wolken über den Tropen und Subtropen beeinflussen stark die in der Atmosphäre wirksame Energiemenge (8). Wolken haben insgesamt eine abkühlende Wirkung auf die Erde (9, 10). Ich habe den Wolkenfehler der GCMs evaluiert, wie er von den Wissenschaftlern am „Coupled Model Intercomparison Project“ beschrieben worden ist, und fand dabei, dass der Wolkenfehler der GCMs gemittelt über den ganzen Globus mindestens ±10.1 % betragen hatte (11).

Dieser Wolkenfehler bedeutete einen Fehler von mindestens ±2,8 W/m². Diese ±2,8 W/m² sind gleich der gesamten zusätzlichen Antriebskraft durch alle zusätzlichen, in die Atmosphäre gelangten Treibhausgase während des gesamten 20. Jahrhunderts. Das heißt, der Wolkenfehler der GCMs allein beläuft sich auf ±100% des zusätzlichen „Treibhauseffektes“. Es bedarf keines sehr klugen Menschen um zu erkennen, dass der Effekt unerkennbar ist, wenn der Fehler genauso groß ist wie der Effekt selbst.

Die Wissenschaftler, die mit den Projektionen der GCMs Vorhersagen über das zukünftige Klima machen, berücksichtigen den Wolkenfehler nicht. Kompetente Wissenschaftler würden diesen Fehler in ihre Vorhersagen einbeziehen. Aber die Klimamodellierer tun das nicht. Auch das IPCC tut das nicht. Eine Berücksichtigung des Wolkenfehlers würde zeigen, dass das Fehlerwachstum Klimavorhersagen sehr schnell nicht besser machen würde als zielloses Raten (11). GCMs können die globale Temperatur nicht einmal ein Jahr im Voraus vorhersagen, geschweige denn in 10 oder gar 100 Jahren. Aber Dr. Morrison sagt uns, dass das irrelevant ist, weil der zunehmende CO2-Anteil selbst ausreicht, um eine katastrophale Klimastörung auszulösen.

Erinnern Sie sich an das Kriterium der Wissenschaft? Nur aus falsifizierbaren Vorhersagen ergibt sich die Bedeutung von Beobachtungen. Klimamodelle liefern keine falsifizierbaren Vorhersagen, vor allem nicht hinsichtlich des Antriebs durch CO2. Daher können sie auch keine kausale Bedeutung hinsichtlich eines erhöhten CO2-Gehaltes in der Atmosphäre ergeben. Sie können das sich erwärmende Klima nicht erklären. Sie können nicht das zukünftige Klima vorhersagen. Die Beobachtung, dass der CO2-Gehalt der Atmosphäre zunimmt, reicht nicht aus, um irgendetwas anderes zu zeigen als einen zunehmenden CO2-Gehalt. Bekannte Kausalität und die Vorhersage von Ergebnissen erfordert eine falsifizierbare Theorie. Dr. Morrison hat keine, ebenso wie auch niemand sonst. Diejenigen, die eine verheerende Klimazukunft vorhersagen, wissen nicht, wovon sie reden. Aber das hindert sie nicht daran, überhaupt davon zu reden. Dr. Morrisons Haltung zum Klima ist nicht unterscheidbar von einem intuitiven Alarmruf, der auf subjektiven Gewissheiten beruht.

Wie der Lohn der Sünder unter den Gläubigen.

Eine Durchsicht der wissenschaftlichen Literatur zeigt viele Studien mit Aussagen über die Unzuverlässigkeit der GCMs. Aber diese Studien gerieren sich nicht alarmistisch. Ein verantwortungsbewusster Wissenschaftler würde die relevante Literatur studieren, bevor er öffentliche Verlautbarungen abgibt. Die AGW-Schlussfolgerungen täuschen Kausalität lediglich vor, weil es keine falsifizierbare, wissenschaftlich einheitliche Theorie zur Vorhersage des Klimas gibt.

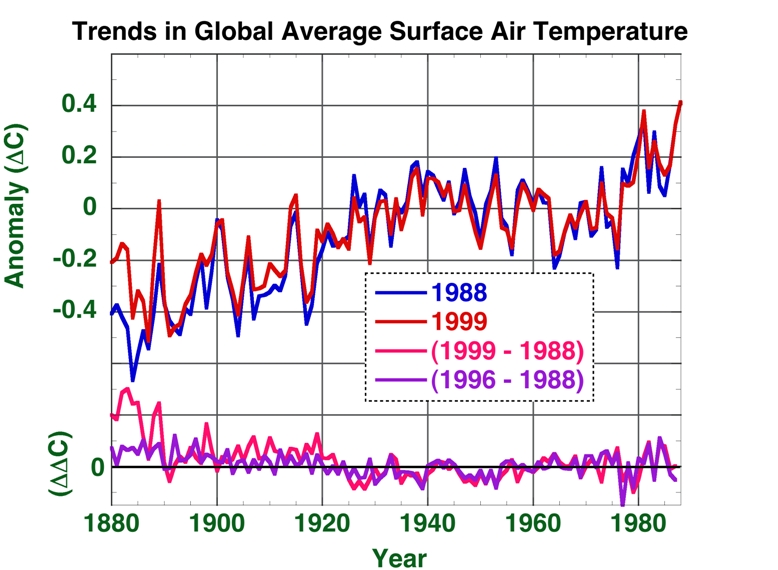

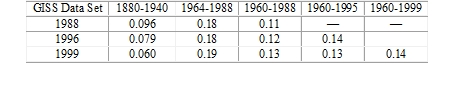

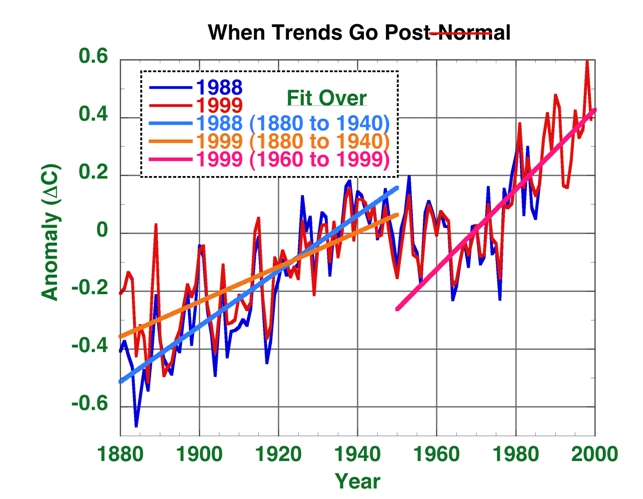

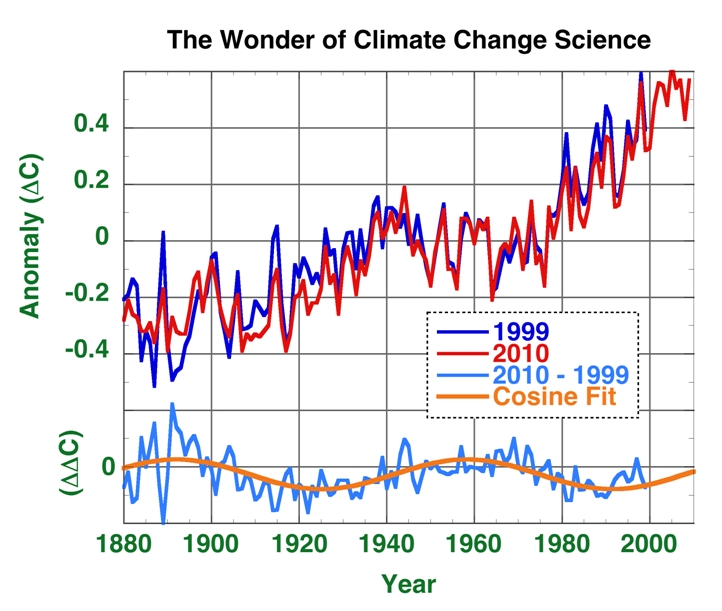

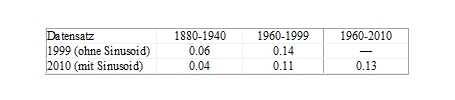

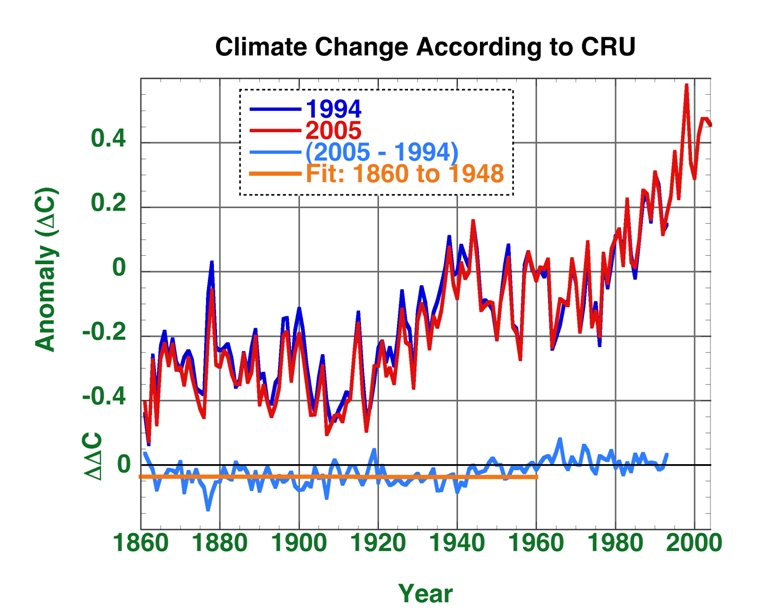

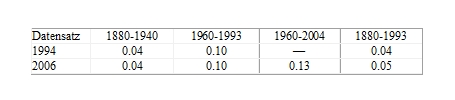

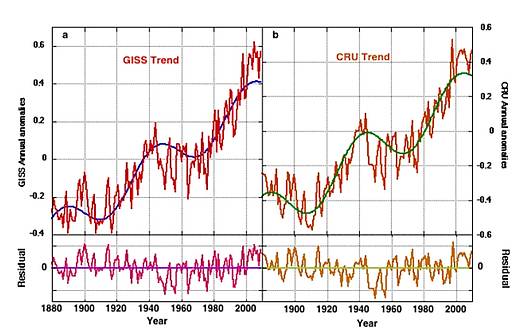

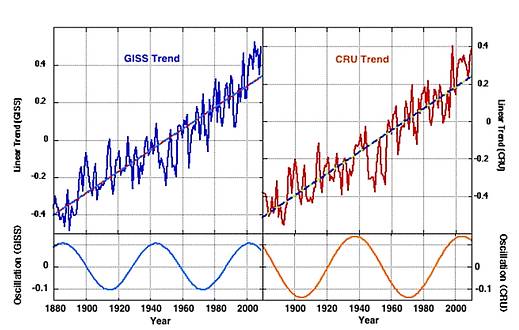

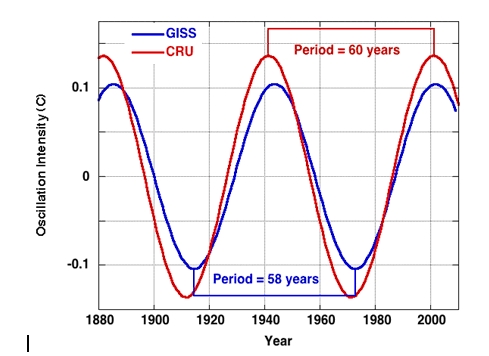

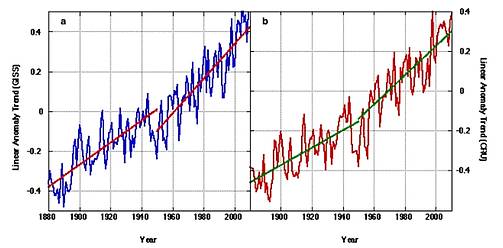

Man könnte noch viel mehr schreiben. Aber die grundlegende Aussage ist klar, so dass ich hier aufhöre. Die Antwort auf die Frage in der Überschrift lautet übrigens: ‚Wenn die Wissenschaft tendenziös wird’. Genau das ist die AGW-Wissenschaft, und das schließt die Temperaturaufzeichnungen ein (12, 13), auf die sich Dr. Morrison so sehr stützt.

References:

1. Drake, S., Galileo: a very short introduction, Oxford University, Oxford 2001.

2. Popper, K.R., Unended Quest, Open Court (pbk), La Salle 1976.

3. Frank, P. and Ray, T.H., Science is not Philosophy, Free Inquiry, 2004, 24 (6), 40-42.

4. Morrison, D., Science Denialism: Evolution and Climate Change, NCSE Reports, 2011, 31 (5), 10.

5. Anagnostopoulos, G.G., Koutsoyiannis, D., Christofides, A., Efstratiadis, A. and Mamassis, N., A comparison of local and aggregated climate model outputs with observed data, Hydrolog. Sci. J., 2010, 55 (7), 1094–1110; see also http://www.itia.ntua.gr/en/docinfo/978/ Last accessed 13 March 2011.

6. Koutsoyiannis, D., Efstratiadis, A., Mamassis, N. and Christofides, A., On the credibility of climate predictions, Hydrolog. Sci. J., 2008, 53 (4), 671-684; doi: 10.1623/hysj.53.4.671.

7. Kiehl, J.T., Twentieth century climate model response and climate sensitivity, Geophys. Res. Lett., 2007, 34 (22), L22710,1-4; doi:10.1029/2007GL031383.

8. Hartmann, D.L., Tropical Surprises, Science, 2002, 295 811-812.

9. Chen, T., Rossow, W.B. and Zhang, Y., Radiative Effects of Cloud-Type Variations, J. Clim., 2000, 13 (1), 264-286.

10. Hartmann, D.L., Ockert-Bell, M.E. and Michelsen, M.L., The Effect of Cloud Type on Earth’s Energy Balance: Global Analysis, J. Climate, 1992, 5 1281-1304.

11. Frank, P., A Climate of Belief, Skeptic, 2008, 14 (1), 22-30; open access: http://www.skeptic.com/the_magazine/featured_articles/v14n01_climate_of_belief.html.

12. Frank, P., Uncertainty in the Global Average Surface Air Temperature Index: A Representative Lower Limit, Energy & Environment, 2010, 21 (8), 969-989; open access: http://meteo.lcd.lu/globalwarming/Frank/uncertainty_in%20global_average_temperature_2010.pdf.

13. Frank, P., Imposed and Neglected Uncertainty in the Global Average Surface Air Temperature Index, Energy & Environment, 2011, 22 (4), 407-424; open access: http://multi-science.metapress.com/content/t8x847248t411126/fulltext.pdf (1 MB).

Link: http://wattsupwiththat.com/2012/03/27/ncse-when-is-purported-science-not-science/#more-60214

Übersetzt von Chris Frey EIKE

PIK Kolloqium aufzeigte kann sich die Konzentration von CO2 aufgrund von physikochemischen Gleichgewichtsprozessen bei sonst gleichen Umständen nur auf ca. max 500 ppm erhöhen.

PIK Kolloqium aufzeigte kann sich die Konzentration von CO2 aufgrund von physikochemischen Gleichgewichtsprozessen bei sonst gleichen Umständen nur auf ca. max 500 ppm erhöhen.