Stimmungsumschwung in Sachen Klimamodelle: Das Vertrauen der Fachwelt schwindet

Im August 2014 äußerte sich jetzt ein Leitautor des kürzlichen 5. IPCC-Klimazustandsberichts, Richard Betts, öffentlich in überraschender Weise. Betts leitet die Abteilung Klimafolgen des UK Met Office und auf seiner Webseite führt er als eine seiner Expertisen die Klimamodellierung an. In einem Kommentar auf Bishop Hill schrieb Betts:

Bish, wie immer bin ich etwas verwirrt, warum du glaubst, dass die GCMs so im Mittelpunkt der Klimapolitik stehen. Jeder* stimmt zu, dass der Treibhauseffekt real und das CO2 ein Treibhausgas ist. Jeder* stimmt zu, dass der CO2-Anstieg anthropogenen Ursprungs ist. Jeder** stimmt zu, dass wir die langfristige Reaktion des Klimas bei einem fortgesetzten CO2-Anstieg nicht hinreichend genau vorhersagen können. Sie kann groß sein, sie kann klein sein. Wir wissen es nicht. Das altgediente Energiebilanzmodell hat uns so weit gebracht. Wir können nicht sicher sein hinsichtlich großer Änderungen in der Zukunft, aber wir können sie auch nicht ausschließen.

In einer Fußnote erläutert Betts dann noch die beiden Sterne:

*OK, wohl nicht jeder, aber jeder, der darüber ausreichend nachgedacht hat.

**Mit Ausnahme einiger weniger, die glauben, dass Beobachtungen kleiner Antriebe über eine Dekade oder drei extrapoliert werden können, um die Reaktion auf einen langfristigen größeren Antrieb vertrauensvoll zu ermitteln.

Betts misst den Klimamodellen keine zentrale Rolle mehr in der Klimapolitik zu. Man weiß noch immer viel zu wenig, räumt er ein. Ganz offensichtlich bekommen jetzt sogar die IPCC-Autoren selber kalte Füße und können eine geringe Klimawirkung des CO2 nicht mehr ausschließen.

Einen Monat zuvor, im Juli 2014, hatte im Wall Street Journal der Computermodellierer Robert Caprara zugegeben, dass in den Modellen eine Vielzahl von frei wählbaren Parametern existiert, um ein gewünschtes Resultat zielgenau „hinzumodellieren“. Caprara schreibt [der gesamte Kommentar von ihm in deutscher Übersetzung steht hier]:

Mein erster Job war eine Beratertätigkeit bei der Environmental Protection Agency EPA. Ich wurde eingestellt, um ein Modell zu erstellen, das die Auswirkungen des Construction Grants-Programms der EPA abschätzen sollte, eine landesweite Bemühung in den siebziger und achtziger Jahren, Klärwerke aufzuwerten.

Als ich die Ergebnisse dem EPA-Funktionär vom Dienst präsentierte, sagte dieser, dass ich zurückgehen und gefälligst „meinen Bleistift spitzen“ sollte. Das habe ich getan. Ich habe Hypothesen begutachtet, Koeffizienten überarbeitet und Daten neu kalibriert. Aber nach einem erneuten Modelllauf nach diesen Änderungen hatte sich das Ergebnis nicht wesentlich geändert. Beim nächsten Treffen hieß mich dieser Funktionär die Zahlen noch einmal zu überarbeiten.

Nach drei weiteren Läufen platzte mir der Kragen: „Nach welcher Zahl suchen Sie eigentlich?“ Er zögerte nicht einen Moment: Er sagte mir, dass er Vorteile in Höhe von 2 Milliarden Dollar vorweisen müsse, damit das Programm verlängert wird. Also drehte ich schließlich an genug Knöpfen, um die von ihm gewünschte Antwort zu erzeugen, und alle waren glücklich.

In Richtung Klimadebatte empfiehlt Caprara, die Diskussion offen zu führen und die Argumente der anderen Seite anzuhören, anstatt die andere Seite mit Beschimpfungen abzuqualifizieren:

Hier also kommt mein Vorschlag: Jene, die überzeugt sind, dass die Menschen drastisch das Klima zum Schlechteren verändern, und jene, die das nicht sind, sollten ein dynamisches, robustes Hin und Her akzeptieren. Man lasse jede Seite ihren besten Fall machen und vertraue darauf, dass die Wahrheit auftauchen wird.

Jene, die wirklich glauben, dass die Menschen das Klima treiben, erwidern, dass die Wissenschaft ‚settled‘ ist und das jene, die dem nicht zustimmen, Leugner“ und „Flat-Earthers“ sind. Selbst der Präsident macht sich über diejenigen lustig, die dem nicht zustimmen. Aber ich habe das schon lange getan, und wenn ich eines gelernt habe, dann dies: wie schwer es ist, die Leute mit einem Computermodell zu überzeugen.

Bereits in einer Arbeit aus dem Oktober 2012 hatte eine Forschergruppe um Clara Deser in Nature Climate Change eingeräumt, dass die bislang unterschätzte starke natürliche Klimavariabilität von den Klimamodellen einfach noch zu schlecht abgebildet werden kann, so dass die Modelle die hohen Erwartungen der politischen Entscheider nicht erfüllen können. In der Kurzfassung der Studie heißt es:

Über die Rolle der natürlichen Variabilität im zukünftigen Klima Nordamerikas

Mit der Verbesserung der Klimamodelle wachsen auch die Erwartungen der Entscheidungsträger hinsichtlich akkurater Klimavorhersagen. Die natürliche Klimavariabilität jedoch setzt inhärent der Vorhersagbarkeit des Klimas Grenzen ebenso wie dem damit zusammenhängenden Ziel der Wegweisung in vielen Gebieten wie hier für Nordamerika dargestellt. Andere Stellen mit geringer natürlicher Variabilität zeigen eine besser vorhersagbare Zukunft, in der der anthropogene Antrieb besser identifiziert werden kann, selbst in kleinen Maßstäben. Wir fordern einen konzentrierteren Dialog zwischen Wissenschaftlern, Politikern und der Öffentlichkeit, um die Kommunikation zu verbessern und steigenden Erwartungen für genaue regionale Vorhersagen überall einen Riegel vorzuschieben.

Auch die bekannte Klimawissenschaftlerin Judith Curry hat wenig Vertrauen in die Klimamodelliererei. Im Oktober 2013 schrieb beklagte sich die Forscherin in ihrem Blog über die fehlende Wertschätzung klimahistorischer Untersuchungen zugunsten von Klimamodellen. Unsummen wären bislang in die Modelle investiert worden, ohne richtiges Ergebnis. Der vom IPCC fälschlicherweise behauptete Konsens hätte die Klimawissenschaften mindestens ein Jahrzehnt zurückgeworfen, sagt Curry:

Mein Punkt ist, dass ambitionierte junge Klimawissenschaftler unachtsam in die Richtung einer Analyse der Klimamodellsimulationen getrieben worden sind, und hier besonders Projektionen der Auswirkungen künftiger Klimaänderungen. Viel Geld fließt in dieses Gebiet zusätzlich zu einer hohen Wahrscheinlichkeit, in einem renommierten Journal veröffentlicht zu werden und mit garantierter Aufmerksamkeit seitens der Medien. Und die wahre Bedeutung dieser Forschung hinsichtlich unseres aktuellen Verständnisses der Natur ruht auf der Eignung und Zweckmäßigkeit dieser Klimamodelle. Und warum glauben die Wissenschaftler, dass Klimamodelle für diesen Zweck geeignet sind? Nun, weil das IPCC ihnen das so gesagt hat, und zwar mit sehr großer Sicherheit. Der fabrizierte Konsens des IPCC hat wohl unser wahres Verständnis des Klimasystems um mindestens eine Dekade zurückgeworfen, jedenfalls sehe ich das so. Die wirklich harte Arbeit der fundamentalen Klimadynamik sowie die Entwicklung und Verbesserung von Paläo-Proxys wird von den Klimawissenschaftlern vermieden, da sich dies viel weniger auszahlt (hinsichtlich Belohnungen und Förderung). Die Zeit und die Fördergelder, die hier durch den Gebrauch von Klimamodellen für Ziele verschwendet worden sind, für die sie gar nicht ausgelegt waren, könnte eventuell als kolossal eingestuft werden.

Eine genaue Kenntnis des Paläoklimas ist unverzichtbar und sollte absoluten Vorrang vor Freistil-Klimamodellierungen haben, denn die historischen Daten sind wichtige Kalibrierungs- und Überprüfungsdaten für Klimamodelle. Wenn die Formeln nicht stimmen, nützen auch die größten Supercomputer nichts.

Auch der US-amerikanische Atmosphärenphysiker Richard Lindzen vom Massachusetts Institute of Technology (MIT) hat kein Vertrauen in die Klimamodelle, wie er auf einer Veranstaltung der Sandia National Labs, einer Forschungs- und Entwicklungseinrichtung des US-Energieministeriums, erklärte.

Der ehemaligen deutschen Forschungsministerin Annette Schavan ist es dagegen ziemlich egal, ob die Klimamodelle Recht haben. Sie sieht die Klimakatastrophe als unverhandelbar an und fordert umgehendes Handeln. Kann man mit einer solch unwissenschaftlichen und eher ideologisch geprägten Grundhaltung überhaupt Forschungsministerin sein? Mangelndes Fingerspitzengefühl im Zusammenhang mit dem Verdacht auf Plagiarismus im Rahmen ihrer Doktorarbeit führte dann schließlich auch zur Entfernung von Schavan aus dem Amt. Nun ist sie Botschafterin beim Heiligen Stuhl in Rom, wo sie mit ihrer klimareligiösen Einstellung vermutlich letztendlich auch besser aufgehoben ist.

Ähnlich fragwürdig ist auch ein Ansatz einer US-amerikanisch-französischen Gruppe. Sie behaupteten 2012, ihr Modell hätte angeblich das Klima auf dem Mars korrekt vorhergesagt, und daraus würde folgen, dass das Modell auch für die Erde gültig sein müsse. Eine kuriose Geschichte.

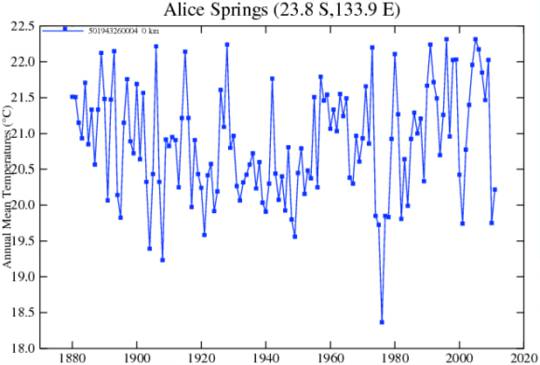

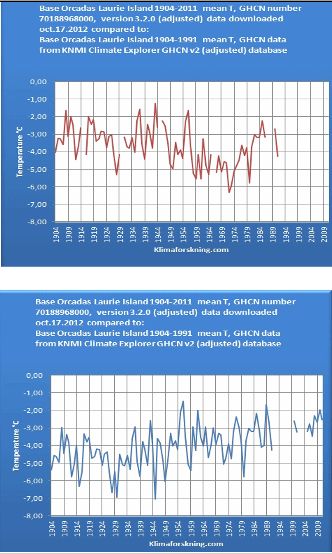

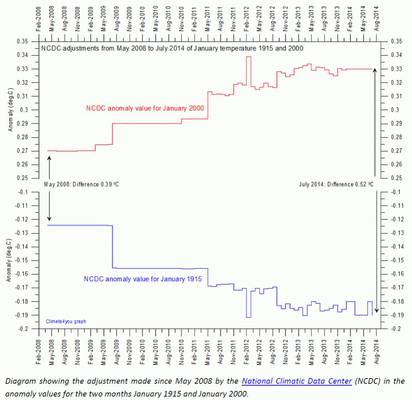

Der Weltklimarat sollte sich endlich alternativen Modellen öffnen. In unserem Buch „Die kalte Sonne“ stellten wir einen semiquantitativen Ansatz vor, in dem Sonnenaktivitätsschwankungen und Ozeanzyklen eine wichtige Rolle spielen. Die schlechte Trefferquote der IPCC-Prognosen spricht eindeutig für einen Wechsel. Es muss eine ernsthafte Überprüfung der Ideen der IPCC-Kritiker geben. Hierzu gehören auch Modelle von Nicola Scafetta und Frank Lemke, die den realen Temperaturverlauf besser abzubilden scheinen als die IPCC-Vorhersagen. Bei den Ozeanzyklen ist man bereits eingeknickt und hat mittlerweile damit begonnen, diese in Modelle mit einzubauen, da die Verlässlichkeit der Klimaprognosen damit nachweislich dramatisch angestiegen ist. Einen entsprechenden Ansatz verfolgten zum Beispiel DelSole et al. 2013 in einer Arbeit in den Geophysical Research Letters.

Dieser Artikel war erstmals auf der „Kalten Sonne“ erschienen. Die englischen Passagen dort wurden hier übersetzt von Chris Frey EIKE

Link: http://www.kaltesonne.de/?p=21053