Außerdem ist festzustellen, dass keiner der Autoren im NIPCC auch nur einen Cent an staatlicher Zuwendung erhalten hat! Intensive und ergebnisoffene Forschung wurde hier strikt ehrenamtlich betrieben.

Das ganze Dokument kann mit dem Link unten aufgerufen werden. Dort stehen alle Belege und Nachweise für die hier übersetzten Fakten. Aus Zeitgründen kann das gesamte Dokument aber nicht komplett übersetzt werden.

Chris Frey

Aufbau: Die NIPCC-SPM enthält eine Einführung (Introduction) sowie 5 Kapitel und ‚Conclusions’. Die 5 Kapitel tragen die Titel:

1.Methodology (Methodik)

2.Global Climate Models

3.Postulates (Forderungen)

4.Circumstancial Evidence

5.Policy Recommendations (Empfehlungen an die Politik)

Conclusions

In den Kapiteln werden jeweils zentrale Aussagen des IPCC Punkt für Punkt widerlegt. Am Ende eines jeden Kapitels findet sich eine Zusammenfassung von wenigen Zeilen. Diese Zusammenfassungen werden hier übersetzt. Außerdem gibt es 10 Kästen, in denen die zentralen Aussagen des NIPCC-Berichtes nach Themen sortiert rekapituliert werden. Die Kästen 1 und 3 sowie 5 bis 10 werden übersetzt, ebenso wie die ‚Conclusions’. Sie ergänzen sich natürlich mit den Zusammenfassungen am Ende der einzelnen Kapitel. Ich gehe davon aus, dass jede einzelne Aussage kreuzweise belegt ist, im Gegensatz zu den frisierten IPCC-Unterlagen, so dass ich auf die Übersetzung dieser Erläuterungen hier verzichte. Der Link zum Dokument ist unten angegeben.

Und noch eine Anmerkung: Im gesamten Text wird die korrekte Schreibweise CO2 beibehalten. Im Editor der EIKE-Website lässt sich diese Tiefstellung jedoch nicht darstellen.

Hier also zunächst der Inhalt der Kästen.

Kasten 1: Zusammenfassung der Ergebnisse vom NIPCC

● Das atmosphärische Kohlendioxid (CO2) ist ein mildes Treibhausgas, dessen Wärmewirkung mit steigender Konzentration immer weiter abnimmt.

● Eine Verdoppelung der atmosphärischen CO2-Konzentration verglichen mit dem vorindustriellen Niveau würde unter Ausblendung anderer Antriebe und Rückkopplungen wahrscheinlich eine Erwärmung zwischen 0,3°C und 1,1°C verursachen, wovon fast 50% bereits eingetreten sind.

● Wenige Zehntelgrad zusätzlicher Erwärmung würden, so sie wirklich eintritt, nicht zu einer Klimakrise führen.

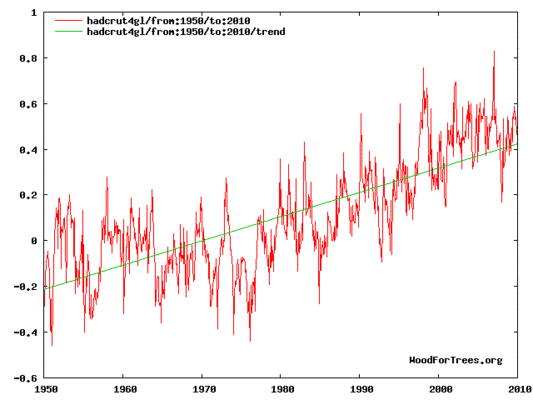

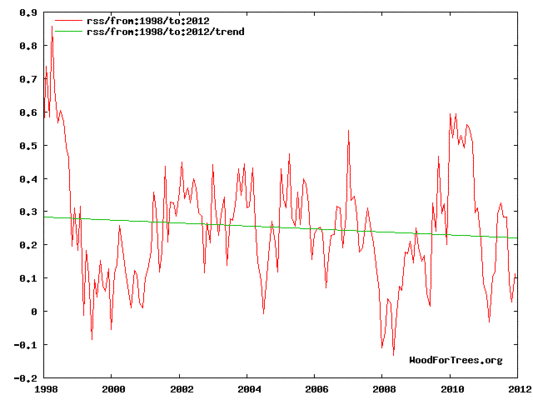

● Die Modellergebnisse in den seit 1990 veröffentlichten IPCC-Berichten projizieren bei einer Verdoppelung des CO2-Gehaltes eine Erwärmung bis zu 6°C bis zum Jahr 2100. Stattdessen hat sich die Erwärmung zum Ende des 20. Jahrhunderts abgeschwächt, gefolgt (ab 1997) von 16 Jahren mit stabilem Temperaturverlauf.

● In letzter geologischer Zeit hat die Temperatur der Erde aus natürlichen Gründen zwischen +4°C und -6°C Abweichung variiert, verglichen mit der Temperatur im 20. Jahrhundert. Eine Erwärmung um 2°C über die heutigen Werte, so sie wirklich eintritt, würde noch deutlich innerhalb der natürlichen Bandbreite liegen.

● Obwohl eine zukünftige Erwärmung von 2°C abhängig von der geographischen Breite ökologische Auswirkungen hätte, gibt es keine Beweise, dass diese Änderungen im Ganzen schädlich für die globale Umwelt oder das menschliche Wohlergehen sind.

● Mit dem gegenwärtigen Gehalt von rund 400 ppm leben wir immer noch in einer nach CO2 hungernden Welt. Während des Kambriums vor etwa 550 Millionen Jahren) war der Gehalt etwa 15 mal höher, ohne dass nachteilige Auswirkungen bekannt sind.

● Alles in allem korrespondiert die Erwärmung seit 1860 mit der Erholung aus der Kleinen Eiszeit. Sie wurde verursacht von natürlichen multidekadischen Zyklen, angetrieben durch Oszillationen zwischen Ozean und Atmosphäre oder auch durch solare Variationen wie dem de Vries-Zyklus (ca. 208 Jahre) und dem Gleissberg-Zyklus (ca. 80 Jahre) sowie kürzeren Periodizitäten.

● Die Erde hat sich während der letzten 60 Jahre nicht signifikant erwärmt trotz einer Zunahme des atmosphärischen CO2 um 8%, was 34% allen zusätzlichen CO2 repräsentiert, die seit dem Beginn der industriellen Revolution in die Atmosphäre gelangt sind.

● CO2 ist ein unabdingbar notwendiger Nährstoff für die Photosynthese der Pflanzen. Eine zunehmende CO2-Konzentration in der Atmosphäre lässt den Planeten „ergrünen“ und hilft, die wachsende menschliche Bevölkerung zu ernähren.

● Es gibt keine enge Korrelation zwischen der Temperatur-Variation der letzten 150 Jahre und mit dem Menschen in Verbindung stehenden CO2-Emissionen. Der parallele Verlauf von Temperatur und CO2 zwischen etwa 1980 und 2000 könnte Zufall sein und enthält nicht unbedingt Kausalität.

● Die Gründe für historische globale Erwärmungen bleiben ungewiss, aber es gibt signifikante Korrelationen zwischen Verhaltensmustern des Klimas und multidekadischen Variationen sowie der Sonnenaktivität während der letzten paar hundert Jahre.

● Projektionen der künftigen Entwicklung der Sonnenaktivität lassen während der kommenden Jahrzehnte eher eine globale Abkühlung als eine Erwärmung erwarten, trotz weiterer CO2-Emissionen.

Quelle: „Executive Summary“, Climate Change Reconsidered II: Physical Science (Chicago, IL: The Heartland Institute, 2013)

Kasten 3: Schlüsselfakten über Temperatur-Antriebe und Rückkopplungen

● Eine Verdoppelung des CO2-Gehaltes seit dem vorindustriellen Niveau (von 280 auf 560 ppm) würde wahrscheinlich einen Temperatur-Antrieb von 3,7 W/m² in der unteren Atmosphäre bringen, was etwa 1°C Erwärmung bedeutet.

● Die IPCC-Modelle betonen die Bedeutung der positiven Rückkopplung des zunehmenden Wasserdampfes und projizieren deshalb eine Erwärmung von etwa 3°C bis 6°C, während empirische Daten eine Größenordnung weniger zeigen, nämlich etwa 0,3°C bis 1,0°C.

● In Eisbohrkernen zeigt sich, dass Temperaturänderungen parallelen Änderungen des CO2-Gehaltes viele hundert Jahre voraus laufen. Sie zeigen auch, dass Temperatur und CO2 in langen Zeiträumen historischer und geologischer Aufzeichnungen nicht miteinander gekoppelt sind. Daher kann das CO2 nicht der Haupttreiber für die meisten Temperaturänderungen sein.

● Der atmosphärische Methan-Gehalt (CH4) fällt während der letzten beiden Jahrzehnte deutlich unter die in den IPCC-Berichten projizierten Werte. Diese viel zu hohen Schätzungen des Methangehaltes fließen in die IPCC-Temperaturprojektionen ein und müssen daher nach unten korrigiert werden.

● Der auftauende Permafrost oder untermeerische Gashydrate werden wahrscheinlich keine gefährlichen Mengen von Methan freisetzen, jedenfalls nicht bei der gegenwärtigen Erwärmungsrate.

● Es wird erwartet, dass die Stickstoffoxid-Emissionen (N2O) fallen, wenn der CO2-Gehalt und die Temperatur steigen, was bedeutet, dass sie als negative Rückkopplung fungieren.

● Andere negative Rückkopplungen der Klimasensitivität werden durch das IPCC entweder außen vor gelassen oder unterschätzt. Darunter ist die Zunahme tiefer Bewölkung als Folge des gestiegenen Wasserdampfgehaltes, eine steigende Aufnahme von Dimethylsulfid (DMS) seitens der Ozeane und das Vorhandensein und der Gesamt-Abkühlungseffekt durch sowohl natürliche als auch industrielle Aerosole.

Quelle: „Cahpter 2. Forcings and Feedbacks“, Climate Change Reconsidered II: Physical Science (Chicago, IL: The Heartland Institute, 2013)

Kasten 5: Schlüsselfakten im Vergleich zu globalen Klimamodellen

● Klimamodelle haben während der letzten 15 Jahre eine atmosphärische Erwärmung um 0,3°C simuliert. Tatsächlich war die Temperatur gleich geblieben, oder es hat sich sogar etwas abgekühlt.

● Klimamodelle haben eine Erwärmung der Ozeane um 0,2°C simuliert, tatsächlich wurde keinerlei Erwärmung beobachtet.

● Klimamodelle haben das Auftauchen eines hochtroposphärischen Hot Spots über den Tropen simuliert; ein solcher ist bis heute nicht gefunden worden.

● Klimamodelle haben projiziert, dass die Erwärmung zum Ende des vorigen Jahrhunderts an beiden Polen stattgefunden haben sollte, in Wirklichkeit konzentrierte sich die Erwärmung nur auf arktische Gebiete.

● Klimamodelle berechnen allgemein eine Klimasensitivität von 3°C bei einer Verdoppelung des CO2-Gehaltes verglichen mit dem vorindustriellen Niveau. Meteorologischen Beobachtungen zufolge beträgt diese Sensitivität aber nur 1°C oder weniger.

● Die Klimamodelle unterschätzen die Verdunstung an der Erdoberfläche infolge der gestiegenen Temperatur um den Faktor 3, was in der Konsequenz zu einer Unterschätzung des globalen Niederschlags führt.

● Die Klimamodelle repräsentieren durch Aerosole veränderte Infrarotstrahlung nicht angemessen, obwohl Studien zeigen, dass verschiedene Mineral-Aerosole (bei gleicher Konzentration) Unterschiede im bodennahen IR-Fluss zwischen 7 und 25 W/m² zeitigen können.

● Deterministische Klimamodelle haben inhärente Eigenschaften, die eine dynamische Vorhersagbarkeit unmöglich machen. Die Einführung von Methoden, um dem zu begegnen (vor allem Parameterisierung) bringt einen Bias in die Modellprojektionen.

● Grenzen der Rechenmöglichkeiten von Computern verhindern, dass die Klimamodelle wichtige Klimaprozesse auflösen; Modelle mit geringer Auflösung können viele wichtige regionale und niedriger skalige Phänomene wie beispielsweise Wolken nicht erfassen.

● Die Kalibrierung der Modelle ist fehlerhaft, nehmen sie doch an, dass der gesamte Temperaturanstieg seit Beginn der industriellen Revolution ausschließlich durch menschliche CO2-Emissionen verursacht wurde. In Wirklichkeit begannen menschliche Emissionen erst Mitte des 20. Jahrhunderts.

● Nichtlineare Klimamodelle zeigen ein chaotisches Verhalten. Als Folge zeigen verschiedene Modellläufe unterschiedliche Trendwerte.

● Interne Klima-Oszillationen (AMO, PDO usw.) sind wesentliche Faktoren in historischen Temperaturreihen. Die Klimamodelle versuchen nicht einmal, diese zu simulieren.

● Genauso gehen in die Klimamodelle nicht die Auswirkungen ein durch Veränderungen des solaren Magnetfeldes oder kosmischer Strahlen. Von beiden weiß man, dass sie das Klima signifikant beeinflussen.

Quelle: „Chapter 1. Global Climate Models and Their Limitations“, Climate Change Reconsidered II: Physical Science (Chicago, IL: The Heartland Institute, 2013)

Kasten 6: Schlüsselfakten zur Temperatur an der Erdoberfläche

● Ob die heutige Temperatur als Teil eines Erwärmungstrends gesehen werden kann, hängt von der betrachteten Zeitperiode ab.

● Im (Klima-)Zeitscale von mehreren tausend Jahren zeigt die Temperatur Abkühlung; im historischen (meteorologischen) Zeitscale im vorigen Jahrhundert Erwärmung. Während der letzten 16 Jahre gab es keine Erwärmung trotz einer Zunahme des atmosphärischen CO2-Gehaltes um 8% – das repräsentiert 34% der mit dem Menschen in Verbindung stehenden CO2-Emissionen seit der industriellen Revolution.

● Setzt man eine atmosphärische Durchmischung von etwa einem Jahr an, kann man mit den soeben erwähnten Fakten die Hypothese einer gefährlichen Erwärmung testen. Diesen Test hat sie nicht bestanden.

● Den vom IPCC bevorzugten HadCRUT-Daten zufolge war es im 20. Jahrhundert zu zwei Phasen mit Erwärmung gekommen, nämlich zwischen 1910 und 1940 sowie zwischen 1979 bis 2000, und zwar mit etwa den gleichen Raten von jeweils 1,5°C pro Jahrhundert. Die Erwärmung Anfang des 20. Jahrhunderts ging wesentlichen industriellen CO2-Emissionen voraus und muss natürlichen Ursprungs sein. Die Erwärmung in der zweiten Periode könnte eine kleine Auswirkung menschlicher CO2-Emissionen sein, aber die Erwärmung kann auch auf den Wärmeinseleffekt zurückgehen.

● Andere Temperatur-Datensätze zeigen die Erwärmung im HadCRUT-Datensatz zum Ende des vorigen Jahrhunderts nicht.

● Es war nichts Ungewöhnliches an der nur im HadCRUT-Datensatz erkennbaren Erwärmung zum Ende des vorigen Jahrhunderts, weder hinsichtlich der Größenordnung noch der Rate. Beides liegt deutlich innerhalb bekannter, natürlicher Variationen, die auch zuvor schon aufgetreten waren.

● Es gibt keine empirischen Beweise, die die Hypothese stützen, dass eine planetarische Erwärmung um 2°C insgesamt ökologisch oder ökonomisch schädlich wäre.

Quelle: Chapter 4. „Observations: Temperatures“, Climate Change Reconsidered II: Physical Science (Chicago, IL: The Heartland Institute, 2013)

Kasten 7: Schlüsselfakten über den solaren Antrieb

● Es gibt immer mehr Beweise dafür, dass Änderungen der Temperatur auf der Erde zum allergrößten Teil durch Variationen der Sonnenaktivität angetrieben werden. Beispiele von durch die Sonnenaktivität bestimmte Klimaepochen sind u. A. die Mittelalterliche Warmzeit, die Kleine Eiszeit und die Warmzeit des frühen 20. Jahrhunderts (1910 bis 1940).

● Die Sonne kann bis zu 66% zur Erwärmung im 20. Jahrhundert beigetragen haben, vielleicht sogar noch mehr.

● Berichte über starke empirische Korrelationen zwischen der solaren Variabilität und Klimaindizes einschließlich Temperatur, Niederschlag, Dürren, Überschwemmungen, Sturmfluten und Monsune kamen aus der ganzen Welt.

● Die IPCC-Modelle enthalten nicht wichtige solare Faktoren wie Fluktuationen der magnetischen Feldstärke, und sie überschätzen den Antrieb durch anthropogenes CO2.

● Das IPCC berücksichtigt nicht die Bedeutung der gezeigten empirischen Beziehungen zwischen Sonnenaktivität, dem Einfall galaktischer kosmischer Strahlen und der Bildung tiefer Wolken.

● Die jeweilige Bedeutung der Sonne und von CO2 als Antriebe des globalen Klimas bleiben ungelöst; die jetzigen Klimamodelle lassen eine Fülle von bekannten Verbindungen zwischen Sonne und Klima außen vor.

● Die seit einiger Zeit sehr ruhige Sonne und die Extrapolation solarer Zyklen in die Zukunft zeigen, dass es während der nächsten Jahrzehnte zu einer planetarischen Abkühlung kommen könnte.

Quelle: Chapter 3. Solar Forcing of Climate”, Climate Change Reconsidered II: Physical Science (Chicago, IL: The Heartland Institute, 2013)

Kasten 8: Schlüsselfaktoren zur Cryosphäre

● Mittels Satelliten und durch Luftüberwachung gewonnene Datensätze zur Quantifizierung des globalen Eishaushaltes sind kurz, und die Methoden stecken noch in den Kinderschuhen. Die Ergebnisse bis heute zeigen aber, dass sich die Eisverhältnisse sowohl in Grönland als auch in der Antarktis im Gleichgewicht befinden.

● Eisbohrkerne aus Grönland und der Antarktis zeigen, dass es zu Klimaänderungen sowohl in grundlegenden Eiszeiten/Zwischeneiszeiten gekommen war als auch zu kürzeren Ereignissen im Zeitraum von Jahrzehnten und Jahrhunderten mit starken Raten von Erwärmung und Abkühlung einschließlich abrupter Temperaturänderungen.

● Beobachtete Änderungen hinsichtlich Temperatur, Schneefall, Geschwindigkeit des Eisflusses sowie Kalben von Gletschern sowohl in Grönland als auch in der Antarktis scheinen innerhalb der Grenzen natürlicher Klimavariationen zu liegen.

● Die globale Eisbedeckung bleibt in der Fläche in etwa gleich seit Beginn von Satellitenbeobachtungen im Jahre 1979, wobei die Eisabnahme im Arktischen Ozean durch Eiswachstum um die Antarktis kompensiert wird.

● Während der letzten 25 000 Jahre (spätes Pleistozän und Holozän) zeigten die Gletscher in der ganzen Welt starke Fluktuationen, weitgehend in Übereinstimmung mit dem sich ändernden Klima. Dabei hatten sie sich zeitweise auf Positionen hinter ihrer heutigen Ausdehnung zurück gezogen.

● Trotz dieser Tatsache zeigen die Gebirgsgletscher der Welt eine große Vielfalt von Reaktionen auf lokale Klimavariationen. Sie reagieren auf die Temperaturänderung nicht in einfacher, gleichförmiger Weise.

● Tropische Gebirgsgletscher sowohl in Afrika als auch in Südamerika haben sich während der letzten 100 Jahre zurückgezogen, und zwar infolge geringerer Niederschläge und gesteigerter Sonnenstrahlung; aber auch anderswo haben sich die Gletscher seit dem Ende der Kleinen Eiszeit zurückgezogen.

● Die Daten zur globalen Geschichte der Eisverhältnisse und die Eismassenbilanz stützen nicht die IPCC-Behauptungen, denen zufolge CO2-Emissionen die Hauptursache für Gletscherrückzüge der heutigen Zeit sind.

Quelle: Chapter 5. „Observations: The Cryosphere“, Climate Change Reconsidered II: Physical Science (Chicago, IL: The Heartland Institute, 2013)

Kasten 9: Schlüsselfaktoren zur Hydrosphäre

Ozeane

● Die Kenntnis lokaler Änderungen des Meeresspiegels ist unabdingbar für das küstennahe Management; derartige Änderungen ereignen sich mit sehr stark variierenden Raten in der ganzen Welt, typischerweise zwischen +5 und -5 mm pro Jahr.

● Der globale Meeresspiegel, dessen Kenntnis nur begrenzt für das küstennahe Management genutzt werden kann, ist während des vorigen Jahrhunderts zwischen 1 und 2 mm pro Jahr gestiegen.

● Satelliten-Fernerkundungen der Änderungen des Meeresspiegels zeigen seit 1993 eine globale Anstiegsrate über 3 mm pro Jahr, aber wegen des komplizierten Prozesses und des Anfangsstadiums der verwendeten Methoden ist dieses Ergebnis als nicht sicher anzusehen.

● Raten der globalen Änderung des Meeresspiegels variieren in dekadischem und multidekadischem Maßstab und zeigen in jüngster Zeit weder eine Beschleunigung noch irgendeine andere simple Verbindung mit zunehmenden CO2-Emissionen.

● Die Korallenatolle im Pazifik versinken nicht im Meer; vielmehr sind die Küstenlinien der Atolle direkten Wetter- und seltenen Hochwasserereignissen ausgesetzt. Außerdem durch Änderungen des Meeresspiegels infolge von ENSO und Auswirkungen der zunehmenden menschlichen Besiedlung.

● Ein zusätzlicher Anstieg infolge Wärmeausdehnung ist ebenfalls unwahrscheinlich, zeigt doch das Netzwerk von ARGO-Bojen keine signifikante Erwärmung des Ozeans während der letzten 9 Jahre (Knox und Douglass 2010).

● Obwohl die ganze Bandbreite natürlicher Variationen noch nicht vollständig bekannt ist, fehlt jeder Beweis für Änderungen der globalen Ozeanzirkulation in letzter Zeit, die außerhalb der natürlichen Variation liegen oder durch menschliche CO2-Emissionen ausgelöst worden sind.

Monsun, Dürren und Überschwemmungen

● Es gibt kaum Beweise für eine Zunahme der globalen Niederschlagsmenge insgesamt während des 20. Jahrhunderts, unabhängig von multidekadischen natürlichen Klimarhythmen.

● Monsunregenfälle sind zum Ende des 20. Jahrhunderts nicht variabler oder intensiver geworden; stattdessen reagiert die Niederschlagsmenge hauptsächlich auf Änderungen der Sonnenaktivität.

● Der südamerikanische und der indische Monsun waren während der kalten Kleinen Eiszeit stärker ausgeprägt und schwächer während der Mittelalterlichen Warmperiode. Weder globale noch lokale Änderungen zeigen einen Zusammenhang mit CO2-Emissionen.

● Die Beziehung zwischen Dürre und globaler Erwärmung ist schwach, da es sowohl in der Mittelalterlichen Warmzeit als auch in der Kleinen Eiszeit zu ausgeprägten Dürren gekommen war.

Quelle: Chapter 6 „Observations: The Hydrosphere“, Climate Change Reconsidered II: Physical Science (Chicago, IL: The Heartland Institute, 2013)

Kasten 10: Schlüsselfakten zu Extremwetterereignissen

● In allen Zeitmaßstäben nimmt die Variabilität der Temperatur ab, wenn die mittlere Lufttemperatur steigt.

● Daher ist die Behauptung, dass die globale Erwärmung vermehrt zu Extremen hinsichtlich Wetter und Klima einschließlich der Temperatur selbst führen werde, theoretisch ohne Grundlage und wird auch durch empirische Beweise nicht gestützt.

● Obwohl es in einigen Gebieten zu signifikanten Änderungen der Intensität oder der Anzahl von Extremwetterereignissen im 20. Jahrhundert gekommen war, existiert für den Globus als Ganzes während der letzten 100 Jahre keine Relation zwischen derartigen Ereignissen und der globalen Erwärmung.

● Beobachtungen aus der ganzen Welt zeigen, dass Dürren nicht extremer oder erratischer als Folge der globalen Erwärmung geworden sind. In den meisten Fällen waren die schlimmsten Dürren in der durch Aufzeichnungen belegten meteorologischen Geschichte viel milder verlaufen als Dürren, zu denen es periodisch in Kaltzeiten gekommen war.

● Es gibt wenige oder gar keine Beweise dafür, dass Niederschläge in einer sich erwärmenden Welt variabler und intensiver werden; tatsächlich zeigen einige Beobachtungen das genaue Gegenteil.

● Es gab während der modernen Zeit keine Zunahme von Stürmen, weder nach Häufigkeit noch nach Intensität.

● Trotz der vermeintlich „beispiellosen“ Erwärmung des 20. Jahrhunderts gab es keine Zunahme tropischer Zyklone, weder hinsichtlich Intensität noch Häufigkeit, weder global noch konzentriert auf einzelne Ozeangebiete.

● Die allgemein verbreitete Auffassung, dass die Erwärmung des 20. Jahrhunderts begleitet war von einer Zunahme von Extremwetterereignissen ist eine Folge exzessiver Berichterstattung in den Medien und hat hinsichtlich der Fakten keine Grundlage (Khandekar 2013).

Quelle: Chapter 7 Obersavtions: Extreme Weather“, Climate Change Reconsidered II: Physical Science (Chicago, IL: The Heartland Institute, 2013)

Und hier die Zusammenfassungen:

Kapitel 2: Global Climate Models:

Wir kommen zu dem Ergebnis, dass die gegenwärtige Generation der globalen Klimamodelle (GCMs) nicht in der Lage ist, genaue Projektionen des Klimas auch nur für 10 Jahre im Voraus zu erstellen, geschweige denn für einen Zeitraum von 100 Jahren in der Zukunft, der von den politischen Planern übernommen worden ist. Das Output derartiger Modelle sollte daher nicht verwendet werden, um die Politik anzuleiten, bis sie validiert worden sind und gezeigt haben, dass sie prognostisch von praktischem Nutzen sind.

Kapitel 3: Postulates (Forderungen):

Wir kommen zu dem Ergebnis, dass weder die Rate noch die Größenordnung der Erwärmung zum Ende des 20. Jahrhunderts (1979 bis 2000) außerhalb der natürlichen Variabilität liegt. Auch war sie in keiner Weise ungewöhnlich im Vergleich zu früheren Epochen der Klimahistorie der Erde. Außerdem sind die solaren Antriebe wahrscheinlich viel wichtiger als gegenwärtig erkannt, und es fehlt jeder Beweis, dass eine Temperaturzunahme um 2°C (aus welchen Gründen auch immer) schädlich für den Planeten wäre.

Kapitel 4: Circumstantial Evidence (Detaillierte Beweise):

Wir kommen zu dem Ergebnis, dass es keinen eindeutigen Beweis gibt, dass es in der Umwelt zu nachteiligen Entwicklungen kommt durch die anthropogenen CO2-Emissionen. Insbesondere die Cryosphäre schmilzt nicht beschleunigt; der Anstieg des Meeresspiegels beschleunigt sich nicht. Es sind keine systematischen Änderungen hinsichtlich Verdunstung oder Regenmenge dokumentiert worden, auch nicht hinsichtlich der Größenordnung und der Intensität extremer meteorologischer Ereignisse. Die zunehmende Freisetzung von Methan in die Atmosphäre aus dem Permafrost oder untermeerischen Gashydraten ist unwahrscheinlich.

Kapitel 5: Policy Recommendations (Empfehlungen für die Politik):

Hier wird allgemein wiederholt, dass Klimawandel schon immer stattgefunden hat, dass nichts an der gegenwärtigen Lage ungewöhnlich oder noch nie da gewesen ist, und vor allem, dass sich die Politiker endlich aus unabhängigen Quellen informieren sollen, bevor sie Maßnahmen von einer Tragweite beschließen und einführen, wie es derzeit der Fall ist. Auf die Übersetzung im Einzelnen wird hier verzichtet.

Das letzte Kapitel in diesem Bericht mit dem Titel Conclusions wird hier wieder vollständig übersetzt:

Conclusions

Nur sehr wenige Wissenschaftler bestreiten, dass menschliche Aktivitäten einen Einfluss auf das lokale Klima haben können oder dass die Summe solcher lokalen Auswirkungen hypothetisch zu einem beobachtbaren globalen Signal werden kann. Die Schlüsselfragen jedoch, die beantwortet werden müssen, lauten, ob das menschliche globale Signal groß genug ist, um gemessen werden zu können, und falls ja, stellt dieses Signal eine gefährliche Änderung außerhalb der bandbreite der natürlichen Variabilität dar, oder wird es dies in Zukunft tun?

Die Antwort des NIPCC, abgeleitet aus der umfassenden Begutachtung der wissenschaftlichen Beweise, lautet, dass jedwedes menschliches Klimasignal so klein ist, dass es innerhalb der Bandbreite der natürlichen Variabilität liegt und nicht gefährlich ist. Gleichzeitig ändert sich die globale Temperatur, wie sie es aus natürlichen Gründen schon immer getan hat. Eine Phase des Temperaturstillstands oder einer leichten Abkühlung hat die moderate Erwärmung des 20. Jahrhunderts abgelöst. Mit Sicherheit wird es weiterhin zu derartigen natürlichen Klimaänderungen kommen.

Angesichts dieser Tatsachen wäre die umsichtigste Klimapolitik, sich auf extreme Klimaereignisse vorzubereiten oder sich an diese anzupassen, unabhängig von den Gründen. Angemessene Planungen für gefährliche Klimaereignisse und –änderungen in der Zukunft sollten sofort stattfinden, um Antworten auf die [Auswirkungen] bekannten Raten, Größenordnungen und Risiken natürlicher Änderungen zu finden. Gibt es solche Pläne erst einmal, stellen sie auch eine Grundlage für jedwede anthropogene Klimaänderung dar, ob diese nun eintritt oder nicht.

Politische Entscheidungsträger sollten dem Druck von Lobbygruppen widerstehen, die Wissenschaftler zum Schweigen bringen, die die Autorität des IPCC in Frage stellen sowie dessen Behauptung, für die „Klimawissenschaft“ zu sprechen. Climate Change Reconsidered II: Physical Science enthüllt eine wissenschaftliche Gemeinschaft, die zutiefst verunsichert ist hinsichtlich der Zuverlässigkeit der IPCC-Computermodelle, dessen Forderungen und seiner Interpretation der Beweise. Diese Kritik stammt nicht von einer „Randgruppe“ der Gemeinschaft der Klimawissenschaftler: Sie wird direkt und wiederholt in tausenden Artikeln der begutachteten Literatur geübt.

Der berühmte britische Biologe Conrad Waddington schrieb im Jahre 1941:

Es ist … wichtig, dass Wissenschaftler darauf vorbereitet sind, dass sich ihre Lieblingstheorien als falsch herausstellen. Wissenschaft als Ganzes kann niemals zulassen, dass die Beurteilungen der Fakten durch Ideologie verzerrt werden können, die festlegt, was zu stimmen hat und was nicht; oder was man hofft, das zutreffend ist.

Dieses zukunftweisende Statement verdient eine genaue Betrachtung jener, die weiterhin den Mode-Glauben verbreiten, dass menschliche CO2-Emissionen zu einer gefährlichen globalen Erwärmung führen – trotz starker empirischer Beweise des Gegenteils.

Es folgt eine ausführliche Liste mit Literaturhinweisen, gefolgt von einer Auflistung aller am Bericht beteiligten Autoren.

Link zum gesamten Werk: http://heartland.org/media-library/pdfs/CCR-II/Summary-for-Policymakers.pdf

Zusammengefasst und in Auszügen übersetzt von Chris Frey EIKE