Illustre Namen von Leuten – die sonst kein Mikrophon ohne Statement zum Thema Klima an sich vorbeigehen lassen – waren kontaktiert worden. Es hagelte reihenweise Absagen. So auch die vom bereits fest gebuchten Dr. Oliver Geden von der Stiftung Politik & Wissenschaft. Die Redakteure telefonierten sich die Finger wund, bis schließlich drei Freiwillige gefunden waren. Nun sollten Prof. Dr. Andreas Bott (Meteorologe, Uni Bonn), Severin Fischer (Klimaexperte am Institut für Europäische Politik), sowie Stefan Krug, ein Aktivist von Greenpeace die Runde vervollständigen. Die Moderation der Sendung hatte Alexander Kähler von Phoenix.

Kurz vor der vorgesehenen Aufzeichnung platzte der Betreuer der Sendung mit der Hiobsbotschaft herein, jetzt hätte auch der Aktivist des Medienkonzerns Greenpeace abgesagt. Guter Rat war teuer, man hätte alle NGO´s abtelefoniert, WWF, Greenpeace, BUND, etc. – dann endlich, wenige Minuten vor Aufzeichnung, erwischte man die attac Aktivistin Kathrin – „ich bin die Kathrin- Henneberger“ -. nach eigener Bekundung freie Klimaschützerin und als Aktivistin und Frau schon zwei mal bei Frau Illner zu Gast. Die sagte spontan zu. Eine illustre Runde.

Die Sendung kann man sich hier anschauen. Wir danken Phoenix für die Genehmigung sie auf unserem Blog zu zeigen. In dieser Sendung wurden viele Behauptungen aufgestellt, die wichtigsten werden einem Faktencheck unterzogen.

Sendung vom 9.12.10 „Ist die Welt noch zu retten“ (Mit freundlicher Erlaubnis von Phoenix)

Lüge ist vielleicht nicht das richtige Wort…..

Die Runde sprang schnell von Thema zu Thema. Mitunter wurde auch schon mal der EIKE Vertreter als Lügner bezeichnet, und der Moderator hielt mäßig – aber immerhin – dagegen, als er meinte „Lüge ist vielleicht nicht das richtige Wort, wenn man gegensätzlicher Meinung ist“. Doch zugegeben, bei soviel kontroversen Themen und Behauptungen ist es für niemanden leicht den Überblick zu behalten, oder sich gar ein Urteil zu bilden. Wir haben uns deshalb zu einem ausführlichen Faktencheck entschlossen. Zur leichteren Überprüfung haben wir die Minuten (die Zahlen in Klammern) aufgeführt, in deren Nähe die Behauptung (nicht immer wörtlich wiedergegeben) geäußert wurde.

1. Behauptung: Kähler (0:53) „Das Eis an den Polen schmilzt dennoch. „

Diese Behauptung ist schlicht falsch.

Beispiel Arktis: Das Eis in der Arktis schrumpft und wächst rythmisch, z.Zt. wächst es wieder, im natürlichen Rythmus der Jahreszeiten. Gegenüber einem langjährigen Tiefstand im Sommer 2007 – wie er ähnlich zuvor auch schon in den 50er und 30 Jahren des vorigen Jh. vorhanden war – hat die Eisbedeckung in der Arktis um fast die doppelte Fläche der Bundesrepublik zugenommen. Im November 2010 erreichte die arktische Eisbedeckung sogar den höchsten Stand seit Ende der siebziger Jahre. Ein Umstand der weder vom Moderator noch von den Qualitätsmedien zur Kenntnis genommen noch über den berichtet wurde.

Die Abbildung 1 zeigt – übereinander gelegt – die jährlichen saisonalen Schwankungen der Eisbedeckungen der Arktis aus der AMSR Datenbank. Man erkennt die Zunahme gegenüber 2007 um ca. 500.000 km2

Beispiel Antarktis: Schaut man sich die Antarktis an, ist dort sogar von irgendeiner Schmelze überhaupt keine Rede. Bei einer Durchschnittstemperatur von -35°C auch schlecht möglich. Das Eis der Antarktis wächst, weil die Antarktis (in ihrem Winter) noch nie so kalt war [1]. Die auf Stelzen erbaute neue Neumeyerstation musst deswegen schon mal angehoben werden.

(Meldung Faktum hier 19. Juli 2010/fa.)

– Zum ersten Mal seit dem Bestehen der deutschen Antarktisstation Neumayer fiel die Temperatur am 8. Juli 2010 unter die -50°C-Marke. Es ist die extremste Winterkälte in der Region seit mindestens 29 Jahren. Eine solche Kälte erlebten die elf Wissenschaftler vom „Alfred-Wegener-Institut für Polarforschung“ in Bremen auf ihrer Forschungsstation „Neumayer III“ in der Antarktis noch nie. Minus 50,2 Grad Celsius unter Null erschweren die Arbeiten auf der Forschungsstation. Solche Extremereignise sind eine Herausforderung an Mannschaft und Material. So lassen sich bei dieser Kälte Motoren kaum mehr betreiben. Bereits im Jahr 2008 erlebten die elf Forscher eine vergleichbare Extremkälte. Die Minus-50-Grad-Grenze wurde damals aber nicht erreicht, der tiefste Kältepunkt lag bei Minus 48,8 Grad Celsius. Der bisherige Kälterekord vom Juni 2008 wurde jetzt um 1.4°C unterschritten.“

Mit Dank an Leser T. Lutz

2. Waren die Änderungen der (Anomalien der) globalen Mitteltemperatur ungewöhnlich, oder gar dramatisch?

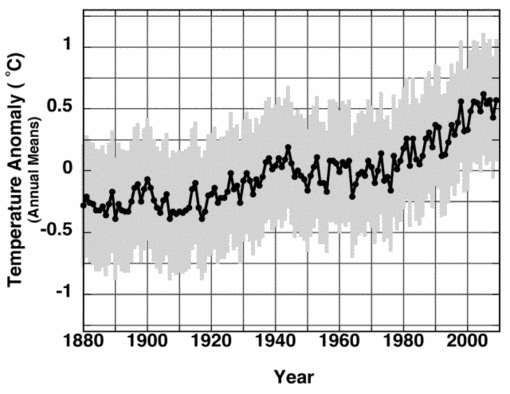

O-Ton Bott : Die Zeichen große Klimaänderungen sind erkennbar. Dies wird seit Jahren von Klima-Wissenschaftlern „prophezeit“ (1:43) …. ihn „ängstigt“ ein dramatischer Anstieg … in den letzten 20 – 30 Jahren definitiv ein anthropogener Effekt. (5:40) … eine rasante Zunahmen (6:15)

Dagegen Limburg (6:40): der Mittelwert der globalen Welttemperatur (7:19) zeigt 3 Anstiege, (alle) gleich hoch und gleich (steil) in den vergangenen 150 Jahren.

Will man überhaupt auf die Aussagekraft eines globalen Mittelwertes mit Änderungen im zehntel Grad Bereich bauen – bei Extremwerten auf eben dieser Erde von -89 ° C in der Antarktis, bis zu + 70 °C in der iranischen Wüste, mit Durchschnittswerten von ca. 30 ° C in manchen Tropen- und Subtropengebieten -, dann sollte man sich zumindest den gesamten Verlauf ansehen.

Abbildung 2: offizielle IPCC Grafik AR4 des Verlaufs des Temperaturanomalie, bezogen auf 1961-1990 der globalen Mitteltemperatur. Man sieht deutlich gleich steile Anstiege von 1860 – 1880, von 1910-1940 und von 1975-1998. Letzterer ist überaus strittig, weil ihn. 1. Die Satelliten nicht zeigen, und 2. Weil die terrestrischen Stationen, die ihn zeigen, stark daraufhin selektiert (manipuliert!) wurden.

Die globale Mitteltemperatur ist in Abbildung 2 gezeigt. Die eingezeichneten Graden sprechen für sich.

| Period |

Length |

Trend

(Degrees C per decade) |

Significance |

| 1860-1880 |

21 |

0.163 |

Yes |

| 1910-1940 |

31 |

0.15 |

Yes |

| 1975-1998 |

24 |

0.166 |

Yes |

| 1975-2009 |

35 |

0.161 |

Yes |

Die Tabelle (aus Watts up with that hier) zeigt die Werte nochmals als Trends errechnet.

Der Anstieg von 1975-1998 ist strittig, weil ihn. 1. Die Satelliten nicht zeigen, und 2. Weil die terrestrischen Stationen, die ihn zeigen, stark daraufhin selektiert (manipuliert!) (Eine ausführliche Untersuchung von A. Watts & J. Dá leo darüber – Surface Temperature Records: Policy Driven Deception?- finden Sie hier) wurden. Diese Ansicht stützen auch die Arbeiten des Geologen  Prof. F.K. Ewert (EIKE), der über 800 weltweite Temperaturganglinien auf ihren absoluten Temperaturtrend hin untersucht hat, und dabei nur klärte: a) ist ein Trend vorhanden? Wenn ja? b) War er positiv oder negativ? Sein Ergebnis: Von 1990-2010 zeigten 50% aller Stationen weltweit keine Erwärmung oder Abkühlung, 28.8 % eine Erwärmung (ohne Stadterwärmungseffekt) und 16,4% eine Abkühlung. Die Arbeit betrachtete auch den gesamten Trend. Sein Ergebnis: Von 1880-2010 zeigten 74% aller Stationen weltweit keine Erwärmung oder Abkühlung, 5,1 % eine Erwärmung (ohne Stadterwärmungseffekt) und 3,8% eine Abkühlung [2].

Prof. F.K. Ewert (EIKE), der über 800 weltweite Temperaturganglinien auf ihren absoluten Temperaturtrend hin untersucht hat, und dabei nur klärte: a) ist ein Trend vorhanden? Wenn ja? b) War er positiv oder negativ? Sein Ergebnis: Von 1990-2010 zeigten 50% aller Stationen weltweit keine Erwärmung oder Abkühlung, 28.8 % eine Erwärmung (ohne Stadterwärmungseffekt) und 16,4% eine Abkühlung. Die Arbeit betrachtete auch den gesamten Trend. Sein Ergebnis: Von 1880-2010 zeigten 74% aller Stationen weltweit keine Erwärmung oder Abkühlung, 5,1 % eine Erwärmung (ohne Stadterwärmungseffekt) und 3,8% eine Abkühlung [2].

Limburg weiter: (7:40) Den letzten Anstieg zeigen Satelliten nicht. Terrestrische Daten zeigen ihn, die Auswahl der Stationen war sehr selektiv.

Abbildung 3 zeigt den Temperaturverlauf der UAH Satelliten in der mittleren Troposphäre zusammen mit dem Anstieg der CO2 Konzentration. Man sieht im Mittel einen geraden Verlauf bis 1998, dann 1198 sowie 2010 die El Niño Anstiege.

Die Abbildung 3 spricht für sich. Nach 1998 geht es sprunghaft auf leicht höherem Niveau ohne Trend* weiter Warum terrestrische Stationen trotzdem einen Anstieg zeigen, der nicht nur Prof. Bott so ängstigt, beantwortet die nächste Grafik. Sie zeigt die Zahl der weltweiten Stationen des Global Historical Network (GHCN) die – und das ist wichtig – von den ausführenden Instituten CRU, GISS und NOAA in die Auswahl genommen und dann zur Berechnung des statistischen Konstruktes Globaltemperatur herangezogen wurden (werden)

Abbildung 4: Anzahl und globaler Mittelwert (man beachte auch die Werte der linken Achse) der GHCN Stationen (von über 8000 Stationen, die Daten liefern), deren Daten in die Berechnung des globalen Mittelwertes der Temperatur einfließen. Deutlich zu sehen der starke Abfall der Zahl der Stationen ab 1990 (Zusammenbruch der Sowjetunion), bei zeitgleichem sprunghaften Anstieg der globalen Mitteltemperatur (Quelle, siehe Bild).

Wie in Abbildung 4 zu sehen, steigt die globale Mitteltemperatur ab 1990 sprunghaft an. Zeitgleich sinkt die Zahl der ausgewerteten Stationen ebenso sprunghaft. Die Ursache liegt einerseits in einer (aus wirtschaftlichen Gründen) erfolgte Aufgabe ländlicher (ruraler) Stationen, zum anderen in einer bevorzugten Auswahl von Stationen in wärmeren Gebieten und dort überwiegend in Städten und/oder Flughäfen. Diese Selektion wurde bis heute fortgesetzt, so dass heute nur noch ca. 1100 Stationen weltweit beitragen. Davon stehen über 40 % auf Flughäfen unter dem Einfluss der Erwärmung durch die Turbinen startender Fluszeuge. Man hat also in erster Linie die Zunahme des weltweiten Flugverkehrs seit 1960 gemessen. Mit Klimaerwärmung hat das nichts zu tun.

3. Wenn es die NGO´s nicht gegeben hätte dann wäre es noch schrecklicher

O-Ton Henneberger: Wenn es die NGO´s nicht gegeben hätte, dann wäre es noch schrecklicher (4:07).

Kähler (43:35): Wann haben wir einen echten Klimaschutz? (43: 48)

Bott: Es werden viele große Schäden angerichtet, viele Menschenleben, die es kosten wird, weil zu wenig getan wird.

Fischer: (44:23) Das Risiko ist viel zu groß, wenn wir Herrn Limburg und seinen Kollegen trauen…

Hier wird in beredten Worten von überstandenen Katastrophen (wäre alles noch viel schrecklicher…) bzw. der großen Gefahr zukünftiger Katastrophen das Wort geredet. Diese gilt es unter allen Umständen zu vermeiden, so der gemeinsame Nenner von Bott, Henneberger, Fischer.

Gemeint sind vermutlich Wetterextreme, wie Stürme, Überschwemmungen und/oder Sturmfluten, Dürren (auch mit Waldbränden), wie wir sie immer wieder – auch in jüngster Zeit – erlebt haben. Keine Frage: Extreme Wetter sind für die Betroffenen immer schlimm. Und mit zunehmender Zahl der Menschen, sowie rasanter Zunahme ihres Wohlstandes, werden diese auch immer teurer, sowohl was die Zahl der Betroffenen angeht, als auch in der Höhe der Schäden. Die Frage muss aber lauten: Werden sie auf Grund des postulierten Klimawandels mehr und/oder stärker, oder ist eher das Gegenteil der Fall? Niemand, schon gar nicht Prof. Bott, hat hierzu die Sachstandsberichte des IPCC konsultiert, die von jedermann aus dem Internet heruntergeladen werden können (www.ipcc.ch). Im Sachstandsbericht vom Jahre 2001 ist ein sehr umfangreiches Kapitel 2.7 genau der hier diskutierten Problematik gewidmet, Ergebnis: „Nichts!“. Es gibt die von Prof. Bott beschworenen Znahmen nicht, was im Übrigen die gesamte meteorologische Literatur bestätigt. Und bis heute hat sich daran nichts geändert, 7 Jahre sind ohnehin bezogen auf Klimazeiträume (30 Jahre mindestens) zu kurz für neue Aussagen über die des IPCC-Berichts von 2001 hinaus.

Auch der Meteorologe und Physiker K.E. Puls (EIKE Pressesprecher) forscht seit langem über das Thema: Gibt es eine anthropogen bedingte Zunahme von Extremwettern? Gibt es überhaupt eine Zunahme?

Die Antwort wurde u.a. auf dem III. Internationalen Klima- und Energiekongress in Berlin gegeben. Schade nur, dass keiner der andern Gäste von Phoenix dort anwesend war. Die Antwort ist unmissverständlich. Es gibt keine Zunahme, weder anthropogen, noch generell. In vielen Fällen ist sogar eine Abnahme zu verzeichnen. Dies ganz im Gegensatz zu immer wiederkehrenden Medienberichten. Abbildung 5 zeigt einen Auszug aus diesem Vortrag.

Abbildung 5 : Auszug aus dem Vortrag von K. E. Puls über den Verlauf von Stürmen in der deutschen Bucht, dem Winter NAO Index des Lufdruck Gradienten etc. Überall sind Abnahmen erkennbar. Wer den Vortrag liest, wird erkennen, dass dies für alle Teile der Welt, also auch für Tornados, Hurricanes und anderes gleichermaßen gilt. Den gesamten Vortrag von K.E. Puls mit dem treffenden Titel:

„Klimawandel : Katastrophe ohne Wetter-Signale ?“

finden Sie hier:  Puls

Puls

Auch Jochem Marotzke, Direktor MPI HH Max-Planck-Instituts[8] (Hamburg):, befand in DER SPIEGEL, 7.5.2007, „Abschied vom Weltuntergang“, S.145 „In unserem Computermodell brauen sich weder mehr Stürme noch stärkere Stürme über uns zusammen„.

Wird fortgesetzt:

Michael Limburg EIKE

* Einige Leser werfen mir vor, nicht die „Lower Troposphere Grafik“ gezeigt zu haben. Darin ist der Sprung ab 1998 höher (0,2K statt ca. 0,04 K) Es kam mir jedoch darauf an, zu zeigen, dass kein Trend vor und nach 1998 zu verzeichnen ist. Durch den sehr starken El Niño 1998, sorgte die Trägheit der Ozeane für das höhere Niveau für die Zeit danach.

Ederer

Ederer

…

… Begründung hier herunterladen. Wer an seine Abgeordnete oder Abgeordneten eine Mail schreiben will findet hier

Begründung hier herunterladen. Wer an seine Abgeordnete oder Abgeordneten eine Mail schreiben will findet hier

Prof. F.K. Ewert (EIKE), der über 800 weltweite Temperaturganglinien auf ihren absoluten Temperaturtrend hin untersucht hat, und dabei nur klärte: a) ist ein Trend vorhanden? Wenn ja? b) War er positiv oder negativ? Sein Ergebnis: Von 1990-2010 zeigten 50% aller Stationen weltweit keine Erwärmung oder Abkühlung, 28.8 % eine Erwärmung (ohne Stadterwärmungseffekt) und 16,4% eine Abkühlung. Die Arbeit betrachtete auch den gesamten Trend. Sein Ergebnis: Von 1880-2010 zeigten 74% aller Stationen weltweit keine Erwärmung oder Abkühlung, 5,1 % eine Erwärmung (ohne Stadterwärmungseffekt) und 3,8% eine Abkühlung

Prof. F.K. Ewert (EIKE), der über 800 weltweite Temperaturganglinien auf ihren absoluten Temperaturtrend hin untersucht hat, und dabei nur klärte: a) ist ein Trend vorhanden? Wenn ja? b) War er positiv oder negativ? Sein Ergebnis: Von 1990-2010 zeigten 50% aller Stationen weltweit keine Erwärmung oder Abkühlung, 28.8 % eine Erwärmung (ohne Stadterwärmungseffekt) und 16,4% eine Abkühlung. Die Arbeit betrachtete auch den gesamten Trend. Sein Ergebnis: Von 1880-2010 zeigten 74% aller Stationen weltweit keine Erwärmung oder Abkühlung, 5,1 % eine Erwärmung (ohne Stadterwärmungseffekt) und 3,8% eine Abkühlung

richter.c@zdf.de

richter.c@zdf.de