Von Korrelationen, Trends und Anomalien!

Dazu gehört die Klärung der Frage: Wie hängen also – wenn überhaupt- Korrelationen mit Trends zusammen? Wie Trends mit Anomalien? Wie Korrelationen mit Anomalien? Und das noch über längere Zeiträume? Zugegeben kein besonders spannendes Thema, wenn man nicht gerade ein Statistiker, Mathematiker oder ja, besonders engagierter Klimaforscher ist. Ich muss auch gestehen, dass mich erst der auch in diesen Kreisen bekannte Willis Eschenbach auf die Verknüpfung dieser Themen gebracht hat, der ein Meister darin ist, dass Offensichtliche zu hinterfragen. Er zeigt dabei häufig genug auf, dass das Offensichtliche nicht das Wahre und schon gar nicht das Wirkliche ist.

Was steuert unser Klima? Oder –genauer- was steuert unsere Temperatur?

Da Klimatologen es oft nicht unter „Weltklima“ machen –dabei es tunlichst unterlassen diesen Begriff zu definieren- muss die Frage lauten: Was steuert unsere Welttemperatur? Die einfachste Antwort müsste lauten: Nichts! Denn, da es eine Welttemperatur nicht gibt, kann sie auch nicht gesteuert werden! So einfach!

Damit würde man aber keine Forschungsmilliarden loseisen, der Politik kein 2° Ziel einreden und die (westliche) Welt nicht in Angst und Schrecken versetzen können. Also wird eine Welttemperatur per definitionem frei geschaffen. Sie soll der arithmetische Durchschnitt aller lokalen Jahresdurchschnittstemperaturen sein und die sollten zuvor möglichst genau und gleichmäßig über den Globus verteilt, täglich mehrmals genau gemessen und dann aus diesen Werten bestimmt werden.

Nun wissen wir aus vielen Berichten, dass dies zwar oft behauptet wird, man aber in der Realität weit davon entfernt ist eine gleichmäßige Abdeckung zumindest für die Vorsatellitenzeit jemals erreicht zu haben. Von genauer Messung erst gar nicht zu reden. Und was die terrestrischen Stationen anbelangt, ist dieser Zustand nicht besser, sondern sehr viel schlechter geworden. Zwar behauptet das britische Metoffice[1] ungerührt auf seiner Website:

„Die Untergruppe von Messstationen ist gleichmäßig über den Globus verteilt und gibt einen faire Übersicht über die Mitteltemperaturen in globalem Maßstab über Land“.

Nun, dass das die Übertreibung des Jahrhunderts – wenn nicht Jahrtausends- ist, pfeifen inzwischen die Spatzen von den Dächern. Die Verteilung der einbezogenen Messstationen ist weit davon entfernt gleichmäßig und/oder gleichförmig über den Erdball, oder auch nur die Landfläche, verteilt zu sein.

Abbildung 1: Reale Anzahl und Verteilung der einbezogenen GHCN Messstationen 2006. Blau dargestellt mit kontinuierlicher Messung, rot mit diskontinuierlicher Messung. Deren Verteilung in der Vergangenheit sehen Sie hier.

Aber, die Frage sei erlaubt: Wie kommen die wackeren Wissenschaftler vom Metoffice zu dieser ebenso falschen wie naiven Behauptung? Nun, hier kommen vermutlich die oben erwähnten Korrelationen[2] ins Spiel. Sie beziehen sich evtl. auf einen grundlegenden Aufsatz des damals noch jungen, aber schon sehr aggressiven Klimaforschers James Hansen und seines Kollegen Lebedeff aus dem Jahre 1987. Hansen ist auch derjenige, der 1988 dem amerikanischen Senat bei drückend heißem Wetter und unter tatkräftiger Mithilfe seines Kumpels -des Politprofis Al Gore- die Nachteile der künftigen vermutlich katastrophalen Erwärmung näherbrachte.

In einem Aufsatz von 1987 [3] im damals noch angesehenen JOURNAL OF GEOPHYSICAL RESEARCH durften die Autoren „peer reviewed“ verkünden, dass es dank ihrer Forschung möglich sei, aus der Not eine Tugend zu machen. Nämlich aus der Not keine flächenmäßig ausreichende Abdeckung mit Klimamessstationen zu haben, die Tugend, diese auch gar nicht zu brauchen. Und nur weil man nun die Vorzüge von Korrelationen für unbekannte Trends einzusetzen imstande sei.

In der Zusammenfassung des Aufsatzes steht:

“..Wir zeigen, dass die Temperaturen von Messstationen mittlerer und hoher Breite über 1000 km miteinander hoch korreliert sind. Bei Stationen in niederer Breite fällt die Korrelation mit der Entfernung stärker ab“ Und etwas später ebenda: “.. Fehlerabschätzungen basieren in Teilen auf Studien wie genau die derzeitigen Stationsverteilungen in der Lage sind Temperaturänderungen in einem globalen Datensatz zu repoduzieren, die von einem dreidimensionalen GCM (General Circulation Model) mit realistischer Variabilität erzeugt wurden.“

In diesem hochtrabenden, etwas verschwurbelten Satz steht also im Klartext:

“ Wir haben eine Fehlerabschätzung (in Teilen? Welche Teile?) gemacht, indem wir die Ergebnisse mit Modellen, die „realistische“ Temperaturvariationen zuvor errechnet hatten, verglichen haben.“

Also nix mit Realitätsvergleich, nix mit Überprüfung der Daten der einbezogenen Stationen, sondern stattdessen Überprüfung mit Modellen! Der künftige modellverliebte Kurs der Klimaforschung des IPCC wurde hier schon vorgezeichnet.

Und so sah das Ergebnis dann auch aus. Dank der großzügigen 1000 km Regel, die im Text dann nochmals auf noch großzügigere 1200 km Radius erweitert wurde, schaffte man

Abbildung 2: Verteilung der einbezogenen GHCN Messstationen nach Hansen & Lebedeff von 1870 bis 1960 sowie deren postulierte Abdeckung

das Kunststück aus einer unvollständigen auf die Nordhalbkugel bezogenen Abdeckung eine weltweite zu machen. Die Welt wurde überall schwarz. Dabei meint man, dass es genüge wenn in mittleren und hohen Breiten ein „mittlerer“ Korrelationskoeffzient von 0,5 nicht unterschritten wird und (nur noch) von 0,33 in niederen Breiten. Mit diesem trefflichen Handwerkszeug ausgestattet und abgesichert durch „präzise“ Vergleiche mit Modellrechnungen der damaligen GCM´s wurde die Welttemperatur bzw. ihre Abweichung vom gedachten Normal, die Anomalie und deren Trend bestimmt.

Diese Methode wird vom GISS unter seinem Chef James Hansen bis heute angewendet und niemand in der IPCC Klimatologenbranche hat bisher öffentlich Zweifel an diesem überaus groben und unbestimmten, daher oft falschen Verfahren[4] angemeldet.

So auch jüngst wieder in einer Studie über die Temperaturentwicklung in der Arktis. Auch dort wurden die wenigen Messstationen am Rand der Arktis benutzt, um die Temperaturtrends der ganzen Arktis zu berechnen. Und die steigen natürlich.

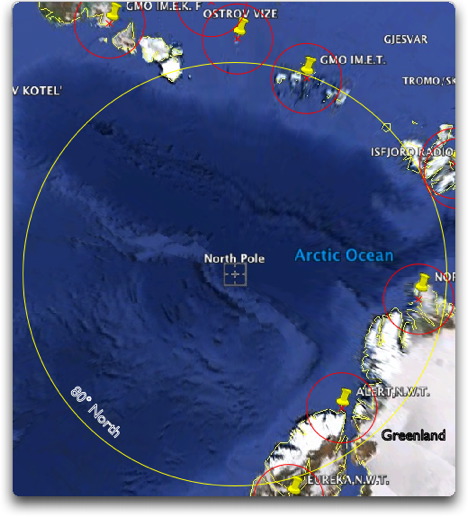

Abbildung 3 Satellitendarstellung der Arktis mit Nordpol und nächstgelegenen Messstationen. Die Kreise um die Stationen haben einen Durchmesser von 250 km! Der 80 ° Breitenkreis hat ca. einen Radius von 1200 km. Also wie von Hansen et al 1987 vorgeschlagen

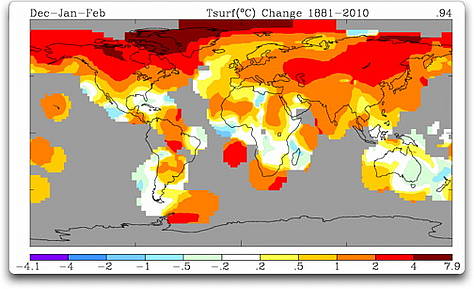

Und hier die Temperaturtrends, die das GISS veröffentlicht, obwohl es dort keine Messstationen gibt.

Abbildung 4 GISS Darstellung der Temperaturtrends weltweit von 1881-2010, Man beachte die braune Färbung im Norden am Pol – dort wo es keine Messstationen gibt.

Der Ingenieur Willis Eschenbach hat sich von dieser „schwarzen Kunst“ nicht beeindrucken lassen und sich die Frage gestellt, inwieweit sich denn aus Korrelationen stichhaltige Trends ableiten lassen, oder umgekehrt. Er zeigte sich darüber verwundert, wie man Temperaturen und deren Trends für weite Teile der Welt berechnen kann, wo es keinerlei Temperaturmessstationen gibt?

Wie immer geht er die Sache grundsätzlich an und erzeugt zuerst beliebige Trends, errechnet deren Korrelationen und geht dann weiter zu natürlichen Temperaturverläufen und deren Anomalien und Trends sowie Korrelationen.

wir sehen sie in Abbildung 5

Abbildung 5: Trendverläufe künstlich erzeugter Pseudotemperaturen.

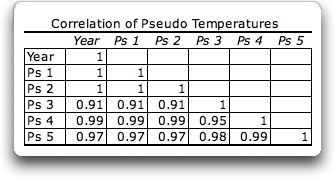

Die zugehörigen Korrelationen sehen wir in der folgenden Tabelle:

Abbildung 6: Korrelationen der in Abbildung 5 erzeugten Pseudotemperaturen

Allen gemeinsam ist, dass die Korrelation sehr hoch ist. Keine ist kleiner als 0,9!

Wir erinnern uns: Die Korrelation die Hansen & Lebedeff noch zuließen lagen bei > 0,5 in mittleren und hohen Breiten und nur noch 0,33 in niederen Breiten. Es fällt aber jetzt schon auf, dass diese sehr hoch korrelierten Pseudotemperaturen doch sehr, sehr verschieden (mehrere Grad Unterschied) und trotzdem hoch korreliert sind. Und (nicht nur) Eschenbach [5] folgert daraus:

„.Die unausweichliche Folgerung daraus ist, dass hohe Korrelationswerte zwischen Temperatur-Historien nicht bedeuten, dass deren Trends sich ähneln.

In Ordnung, ich kann schon hören, was Sie denken: „Ja, stimmt, für einige imaginäre kurze 20-jährige Pseudo-Temperatur-Historien kann man einige wilde Daten finden, die unterschiedliche Trends aufweisen. Doch was ist mit den realen 50-jährigen Temperatur-Historien, wie sie Hansen und Lebedeff benutzten?“

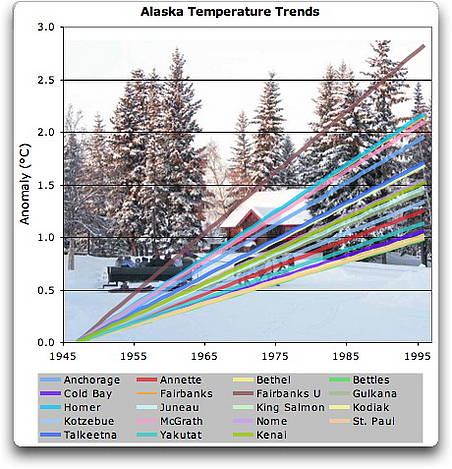

Abbildung 7: Natürliche Trends in Alaska mit Korrelationen zwischen 0,51 bis 0,94 im Mittel 0,75 bezogen auf Anchorage

Gut, dass diese Frage kommt … hier sind neunzehn 50-jährige Temperatur-Historien von Alaska. Alle korrelieren mit Anchorage höher als 0,5 (max 0.94, min 0.51, Durchschnitt 0.75).

Man sieht, die Trends rangieren von etwa einem Grad in 50 Jahren bis nahe drei Grad. Trotz dieser riesigen Spannweite (ca. 300%) bei den Trends haben alle eine gute Korrelation (größer +0,5) mit Anchorage. Das zeigt klar, dass eine gute Korrelation zwischen den Temperatur-Historien nichts aussagt über deren korrespondierende Trends.

Was ergibt sich daraus?

Hansen und Lebedeff lagen richtig damit, dass die jährlichen Temperatur-Historien von weit auseinander liegenden Messstationen dazu neigen, gut korreliert zu sein. Allerdings lagen sie nicht richtig mit ihrer Meinung, dass dies für die Trends der gut korrelierten Temperatur-Historien gälte. Deren Trends können völlig ungleich sein. Im Ergebnis ist die Extrapolation von Trends aus einer bis zu 1200 km entfernten Messstation ein unzulässiges Verfahren ohne jegliche mathematische Basis.

Soweit der pfiffig, misstrauische Willis Eschenbach. Er unterzieht dann gleich die kühnen Angaben des GISS über die Temperaturerhöhung der Arktis einer kritischen Betrachtung.( http://wattsupwiththat.com/2010/03/25/gisscapades/#more-17728) Denn dort wird so gut wie nirgends gemessen:

„Macht nichts sagen die GISS Leute: Wo keine Temperaturen bekannt sind, erfinden wir eben welche“

Richtige seriöse Klimaforschung sollte anders aussehen.

Meint

Michael Limburg EIKE, unter Verwendung von Texten von Willis Eschenbach

[1] Met Office(Quelle: http://www.metoffice.gov.uk/corporate/pressoffice/2009/pr20091205.html)…The subset of stations is evenly distributed across the globe and provides a fair representation of changes in mean temperature on a global scale over land.

[2]„Korrelation“ ist ein mathematisches Maß für die Ähnlichkeit zweier Datenbestände. Sie rangiert von „null“, d. h. keine Ähnlichkeit, bis plus oder minus “eins”, d. h. völlig gleich. Ein negatives Vorzeichen bedeutet Gleichheit, aber wenn der Wert eines Datenbestandes nach oben geht, nimmt der andere ab.

[3] HANSEN, JAMES LEBEDEFF, SERGEJ (1987) Global Trends of Measured Surface Air Temperature. JOURNAL OF GEOPHYSICAL RESEARCH 92:13345 13372.

[4] Damit sind nicht die Klimarealisten, Ross McKittrick, MacIntyre, Watts um nur diese zu nennen gemeint. Die schießen seit Jahren gegen diese zu grobe und zu falschen Schlüssen führenden Methode

[5] Quelle mit vielen weiteren Beispielen und Anmerkungen hier: http://wattsupwiththat.com/2010/03/25/gisscapades/#more-17728