1.) These lt. Focus der Klimarealisten

„Das Klima wandelt sich schon immer“

dazu im Text von Focus Redakteurin Christina Steinlein

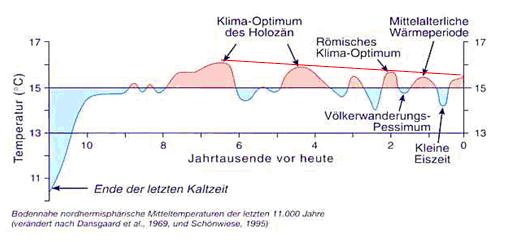

Die Erde ist 4,6 Milliarden Jahre alt, Eiszeiten folgten auf Warmzeiten und umgekehrt – alles ohne menschliches Zutun. Erstens heißt das aber nicht, dass der momentane Klimawandel nicht vom Menschen verursacht wird. Zweitens, so Jochem Marotzke vom Max-Planck-Institut für Meteorologie, sollte jeder, der diese These vertritt, sich mit den Größenordnungen vertraut machen: „Der heutige Klimawandel läuft zehnmal schneller ab als jeder andere zuvor – wenn man singuläre Ereignisse wie Asteroideneinschläge oder Supervulkanausbrüche ausschließt.“ Beispielsweise habe es 5000 Jahre gedauert, aus der letzten Eiszeit herauszukommen: Pro 1000 Jahre erwärmte sich das globale Klima um etwa ein Grad.

Heute findet der gleiche Temperaturanstieg in 100 Jahren, einem Zehntel der Zeit, statt. „Diese Zahlen sind sehr grob, aber das sind die Größenordnungen, von denen wir sprechen.“ Es ist ausgeschlossen, dass natürliche Prozesse einen so schnellen globalen Wandel bewirken.

EIKE zu Punkt 1

„Der heutige Klimawandel läuft zehnmal schneller ab als jeder andere zuvor – wenn man singuläre Ereignisse wie Asteroideneinschläge oder Supervulkanausbrüche ausschließt.“

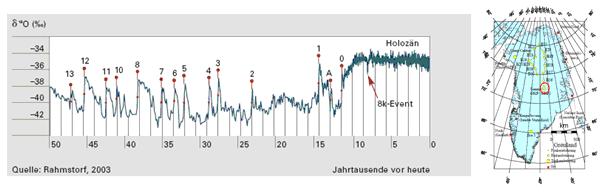

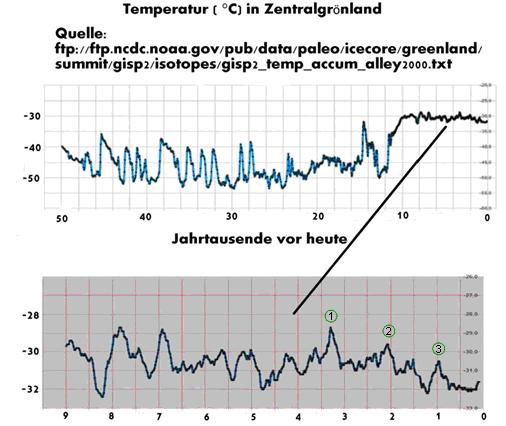

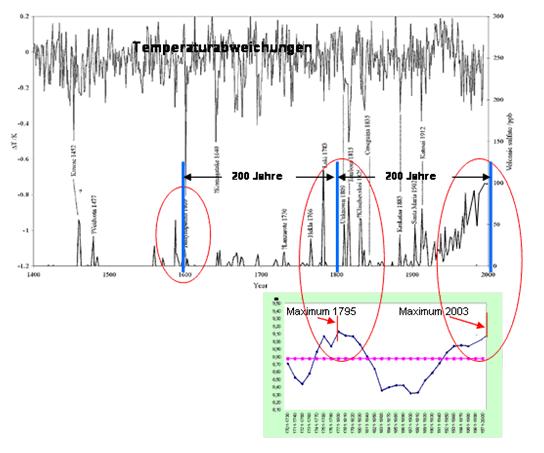

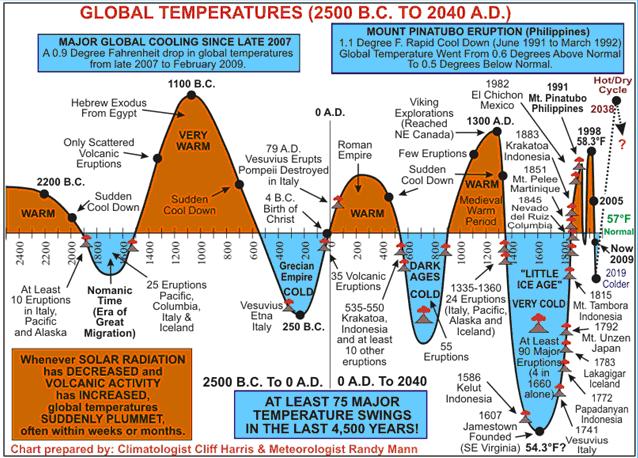

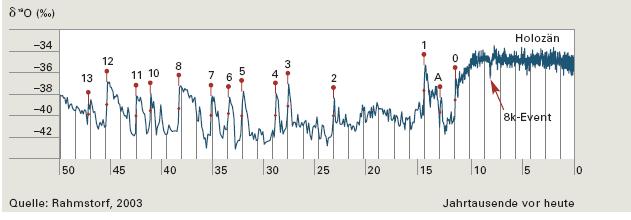

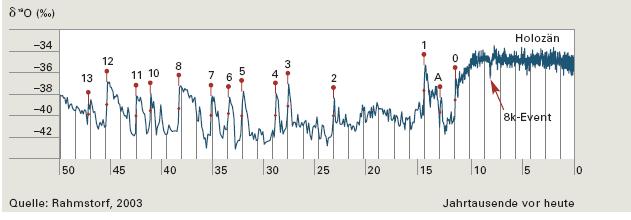

Dies ist definitiv eine Falschaussage, wie die Untersuchungen von Rahmstorf (2003, siehe Abbildung) zeigen. In dieser Untersuchung ist zu sehen, dass es Klimawandel mit einer Temperaturänderung von mehr als 6°C innerhalb von wenigen Jahrzehnten gab. In Spektrum der Wissenschaft, 11/09, S. 70 steht zu diesen krassen Klimawandel: “Die Schwankungen vollzogen sich bisweilen so schnell, dass einzelne Individuen sogar im Lauf ihres Lebens beobachten konnten, wie Pflanzen und Tiere, mit denen sie noch aufgewachsen waren, verschwanden und durch eine ihnen unvertraute Flora und Fauna ersetzt wurden.“ Und da die damaligen Individuen ein sehr kurzes Leben hatten (mit 30 Jahren war man alt), fand dieser Klimawandel von 6°C und mehr innerhalb von 2-3 Jahrzehnten statt. Selbst wenn die Temperaturreihen, die eine Erwärmung in den letzten 100 Jahren zeigen, nicht gefälscht wären, das IPCC redet heute lediglich von einem Temperaturanstieg von 0,7°C im 20. Jahrhundert.

Aber wir brauchen gar nicht soweit zurückzugehen, um die obigen Aussage zu falsifizieren.

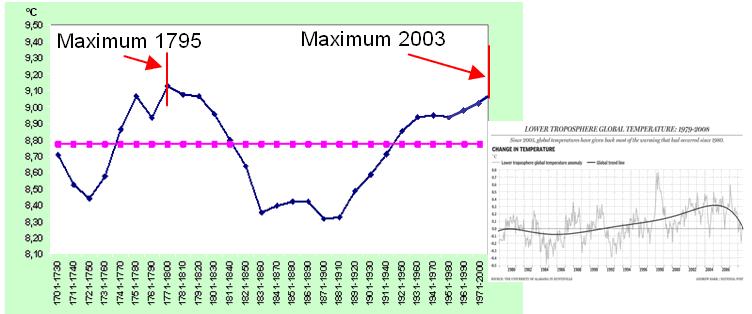

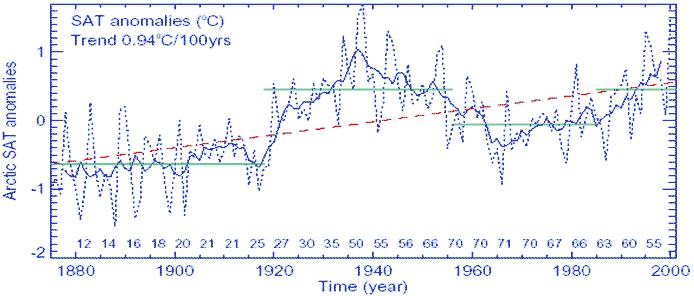

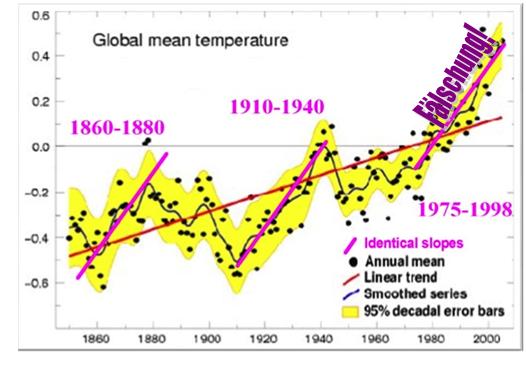

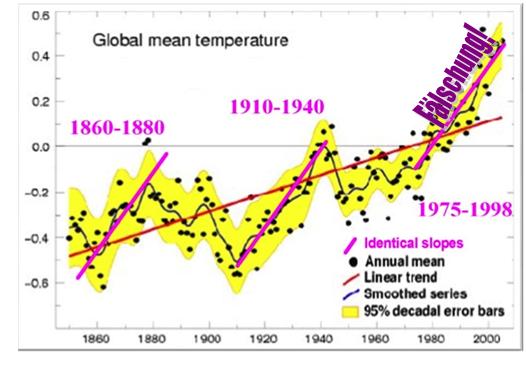

Nehmen wir die letzten 100 Jahre: Steiler Temperaturanstieg seit 1920 bis 1942 (der steile Anstieg der Temperaturen nach 1960 ist, wie seit Climategate Gewissheit, durch manipulierte Temperaturdaten des GISS und CRU zustande gekommen. Temperaturen ohne Fälschungen zeigen keine nennenswerte Erwärmung). Nehmen wir weiter die letzten 200 Jahre: Der Temperaturanstieg seit 1815 bis 1825 (Angell et al. 1985: http://ams.allenpress.com/archive/1520-0450/24/9/pdf/i1520-0450-24-9-937.pdf) ist steiler als der (gefälschte) Anstieg seit 1960 bis heute nach CRU und GISS, bzw. IPCC.

Die folgende Abbildung, aus dem IPCC Bericht und statistisch im Auftrag von Lord Monkton analysiert, zeigt, dass es bereits in den letzten 150 Jahren, zwei vergleichbare Temperaturanstiege mit gleicher Steigungsrate gab, wie der, zwischenzeitlich als Fälschung entlarvte Temperaturanstieg seit den 1980-Jahre, den Herr Marotzke als einzigartig zu erkennen glaubt.

Fazit: Zum einen scheinen die befragten “Klimaforscher“ um Herrn Marotzke ihre eigenen Untersuchungen nicht zu kennen(!) und zum anderen fügt sich der Temperaturanstieg im 20. Jahrhundert in die Temperaturschwankungen der letzten 200 Jahre ein und liegt innerhalb der natürlichen Variabilität.

2.) These lt. Focus der Klimarealisten

Die Ozeane sind schuld

dazu im Text von Focus Redakteurin Christina Steinlein

Das Kohlendioxid in der Atmosphäre stamme hauptsächlich aus den Ozeanen, argumentieren die Leugner.

„Fakt ist: Jährlich werden etwa 100 Gigatonnen Kohlenstoff zwischen Ozeanen und Atmosphäre ausgetauscht. Das ist ein sehr dynamischer Prozess. In manchen Regionen gibt der Ozean CO2 ab, in anderen nimmt er es auf“, erklärt Jochem Marotzke, Direktor des Max-Planck-Instituts für Meteorologie. Die Menschen blasen jährlich etwa sieben Gigatonnen in die Atmosphäre – das mag im Vergleich wenig klingen, aber was zählt, ist der Netto-Effekt: „Das Netto ist beim Austausch zwischen Ozean und Atmosphäre ungefähr bei null, ein bis zwei Gigatonnen nehmen die Meere sogar auf. Im Gegensatz dazu führen die Menschen der Atmosphäre kontinuierlich Kohlendioxid zu.“ Von den sieben Gigatonnen jährlich, die die Menschheit verursacht, bleibt etwa die Hälfte in der Atmosphäre.

„Netto gibt der Ozean gar kein CO2 ab, sondern nimmt seit Jahrzehnten welches auf“, stellt Stefan Rahmstorf vom Potsdam-Institut für Klimafolgenforschung klar. „Das ist durch rund 10 000 CO2-Messungen im Ozean von Forschungsschiffen belegt.“ In der Folge steigt die CO2-Konzentration in den Meeren, was zur Versauerung des Meerwassers führt.

Ein weiteres Argument führt Rahmstorf an: „Wir wissen ja, wie viele fossile Brennstoffe gefördert und verbrannt wurden und wie viel CO2 dabei in die Atmosphäre gelangt ist.“ Drittens hat Hans Suess in den 50er-Jahren eine Untersuchung durchgeführt, die belegt, dass das CO2 in der Atmosphäre nicht aus den Ozeanen stammt, sondern aus der Verbrennung von Erdöl, Erdgas oder Kohle. Anhand der Isotope der Kohlenstoffatome konnte der Forscher nachvollziehen, ob sie aus den Ozeanen oder aus der Verbrennung fossiler Stoffe stammen.

EIKE zu Punkt 2

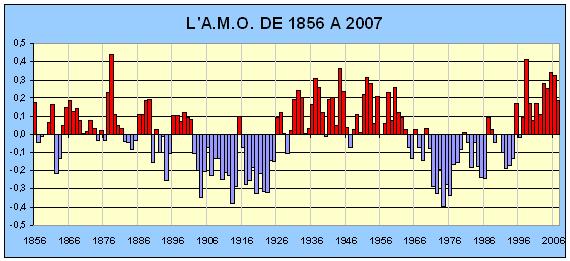

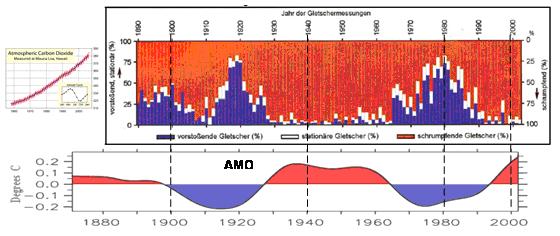

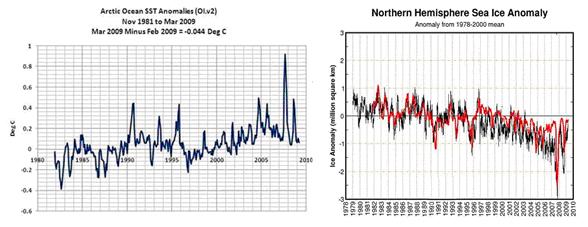

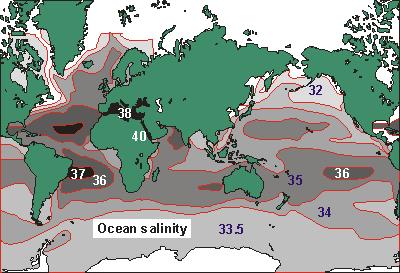

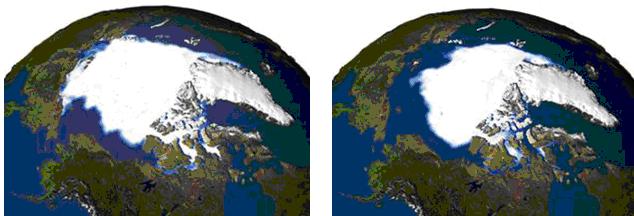

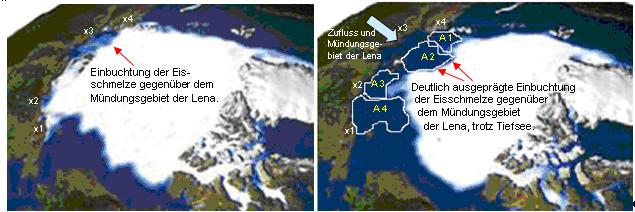

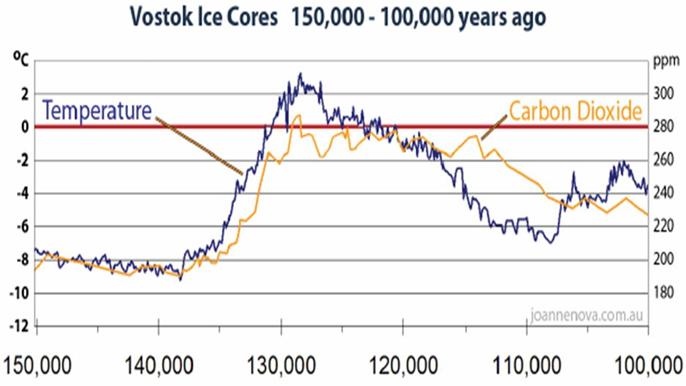

Die Werte, die Herr Marotzke angibt, beruhen auf spekulativen Abschätzungen der CO2-Kreisläufe (was es mit der Genauigkeit der IPCC-Werte auf sich hat, ist spätestens seit den Himalaya-Gletschern bekannt), die einer wissenschaftlichen Überprüfung nicht standhalten: Die Abschätzung, die zur Anreicherung von anthropogenem CO2 in der Atmosphäre führt, beruht auf den 13C Isotopenanalysen. Hier liegt ein einfacher Rechenfehler vor (siehe E. Schulze), wie auch die Arbeit von Knorr bestätigt. Anthropogenes CO2 ist seit 200 Jahren gleichbleibend und nicht vom Rauschen zu unterscheiden, E. Schulze in "Über den Anteil am atmosphärischen Kohlendioxyd durch Verbrennungsvorgänge", August 2009, sowie Knorr, W. “Is the airborne fraction of anthropogenic CO2 emissions increasing? Geophysical Research Letters, 2009; 36 (21). Des Weiteren ist das Statement von Herrn Marotzke nicht hilfreich, der Bedeutung der Meere für die atmosphärische CO2-Konzentration auch nur annähernd gerecht zu werden, wie die folgende Abbildung zeigt.

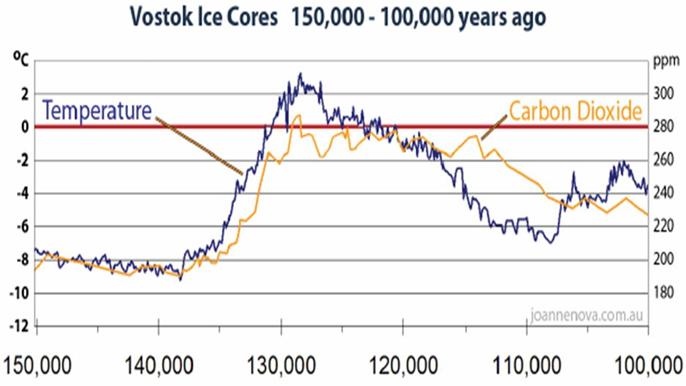

Die Abbildung zeigt den aus Eisbohrkernen rekonstruierten Temperaturverlauf und dazu die atmosphärische CO2-Konzentration. Zum einen ist überdeutlich zu erkennen, dass das CO2 der Temperatur folgt und nicht umgekehrt und zum anderen handelt es sich um einen linearen Zusammenhang. Beide Kurven stehen in einem linearen Verhältnis zueinander, was in der folgenden Datenreihe, die einen längeren Zeitraum abdeckt, verdeutlicht wird (http://tucsoncitizen.com/wryheat/2009/06/24/al-gores-favorite-graph/). Jeder Wissenschaftler oder wissenschaftlich Interessierte weiß, wenn die Temperatur dem CO2-Gehalt der Atmosphäre folgen würde, müsste der Zusammenhang nicht linear, sondern logarithmisch sein! Es handelt sich demnach um Ausgasungserscheinungen des Ozeans (und der Böden). Im umgekehrten Fall (wird es kälter) nimmt der Ozean das CO2 auf. In der Physik ist bekannt, dass der CO2-Gehalt des Wassers neben dem Druck, vor allem von der Temperatur abhängt. Bei zunehmenden Temperaturen gast folglich gebundenes CO2 aus, wodurch die maßgebliche Rolle der Ozeane belegt ist. Noch ein paar Zahlen unsererseits: Nach Angaben der NASA sind in den Meeren ca. 40.000 GT C gespeichert, in den Böden nach den Angaben des IPCC gar die unvorstellbare Menge von 66.000.000 – 100.000.000 GT C. Aus beiden Senken gast CO2 temperaturabhängig aus.

Die Aussage “Netto gibt der Ozean gar kein CO2 ab, sondern nimmt seit Jahrzehnten welches auf“ ist demnach eine Falschaussage.

Fazit: Rahmstorf und Marotzke scheinen grundlegende physikalische Zusammenhänge aus dem Blickfeld gerückt zu sein. Die atmosphärische CO2-Konzentation folgt der Temperatur. Beide stehen in einem linearen Verhältnis zu einander, was nur den Rückschluss auf Ausgasungsvorgänge (Ozean/Land) zu lässt.

3.) These lt. Focus der Klimarealisten :

Vulkane stoßen viel mehr CO2 aus als menschliche Aktivität

dazu im Text von Focus Redakteurin Christina Steinlein

Vulkane und Gestein, vor allem in Vulkangebieten, geben tatsächlich CO2 ab. Die Menge ist schwer zu messen, „aber garantiert deutlich niedriger als die vom Menschen verursachte Menge“, stellt Marotzke klar. Das Umweltbundesamt geht davon aus, dass die CO2-Emissionen durch Vulkane ungefähr zwei Prozent der vom Menschen verursachten Emissionen ausmachen würde. Eine sehr viel höhere Emissionsrate aus Vulkanen und Gesteinen gilt als unwahrscheinlich: Vor der Industrialisierung war die CO2-Konzentration in der Atmosphäre relativ konstant.

Wäre der Vulkanismus der Hauptemittent, hätte der CO2-Gehalt der Atmosphäre auch vor der Industrialisierung kontinuierlich ansteigen müssen.

EIKE zu Punkt 3

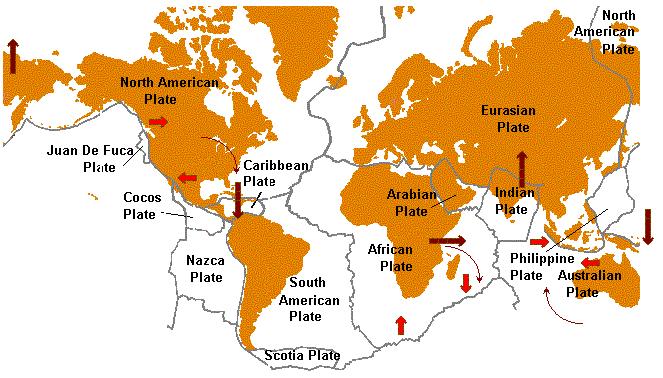

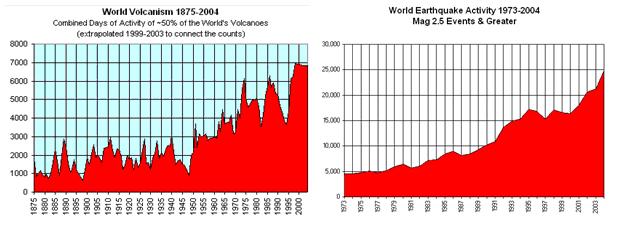

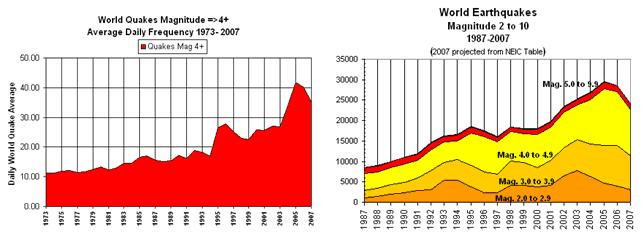

Zu dieser Behauptung verweisen die Autoren auf die Arbeiten des Instituts für Angewandte-Geologie der Uni-Erlangen: “Insgesamt stammt der Hauptteil des CO2 in der Erdatmosphäre aus dem Erdinneren, kommt aber nicht nur aus den Vulkanen, sondern tritt als sog. "juveniles Kohlendioxid" aus einer Vielzahl von Stellen, die teilweise recht unspektakulär aussehen. Es ist dies eine natürliche Folge der Plattentektonik,… Eine exakte Quantifizierung der gesamten, aus dem Erdinneren ausströmenden CO2-Mengen ist heute noch nicht möglich. Dies liegt einfach darin begründet, daß es unmöglich ist, an einer genügend großen Anzahl von Stellen (so z.B. an den Ozeanböden) kontinuierlich zu messen“ (http://www.angewandte-geologie.geol.uni-erlangen.de/klima1.htm).

Noch ein paar weitere Zahlen, die die Dominanz der durch vulkanische Aktivität austretenden sog. Treibhausgase zeigt. Das Wissenschaftsmagazin “scinexx“ schreibt: “Denn egal ob an Land oder am Grund der Ozeane: Schlammvulkane stoßen jährlich Millionen Megatonnen an Methan aus und nehmen dadurch Einfluss auf das Weltklima.“ Bisher hatten Wissenschaftler den mittleren Gesamtanteil von Methan auf der Basis von 160 Schlammvulkanen aus 15 verschiedenen Gebieten mit 30 bis 35 Megatonnen/Jahr beziffert, was anhand der jüngsten Untersuchungen des Alfred Wegener Instituts und der obige Meldung von scinexx deutlich zu niedrig ist. Prof. Dr. Achim J. Kopf (Marine Geotechnik am DFG Forschungszentrum der Universität Bremen) gibt folgende Werte an, die aus den Schlammvulkanen entweichen: 1,97 . 1011 bis 1,23 . 1014 m³ Methan/Jahr, wovon 4,66 . 107 bis 3,28 . 1011 m³ aus Oberflächenvulkanen stammen. Dies entspricht einer Gewichtsmenge von 141 – 88.000 Tg/Jahr (1Tg = 1 Million metrische Tonnen).

Selbst von den etwa ca. 1.400 aktiven Vulkanen (ein Vulkan gilt als aktiv, wenn er in den letzten 10.000 Jahren ausgebrochen ist) sind derzeit erst 24*) vermessen, wobei die Bodenausgasungen um die Vulkane kaum berücksichtigt sind.

*) Die Angaben schwanken je nach Literatur um ein paar Vulkane.

Fazit: Die befragten “Klimaforscher“ sind ganz offensichtlich in ihren Erkenntnissen nicht auf der Höhe der Zeit. Die vulkanisch bedingten Ausgasungen sind nicht einmal zu 1% vermessen und damit bekannt und der Hauptanteil des atmosphärischen CO2-Gehalts stammt aus tektonischen Prozessen und ist somit weitgehend vulkanischen Ursprungs.

4.) These lt. Focus der Klimarealisten

Der Wasserdampf

dazu im Text von Focus Redakteurin Christina Steinlein

„Klar ist Wasserdampf das wichtigste Treibhausgas“, sagt Martin Claußen, Mitdirektor des Max-Planck-Instituts für Meteorologie und Vorsitzender der Deutschen Meteorologischen Gesellschaft: „Er wirkt wie ein Verstärker.“ Der Wasserdampf ist aber nicht der Grund für die Erwärmung, sondern die Folge: Die Temperatur bestimmt, wie viel Wasserdampf in der Atmosphäre ist und nicht umgekehrt.

Im Gegensatz zum Kohlendioxid bleibt Wasserdampf meist nur wenige Tage in der Atmosphäre – und kehrt dann als Regen auf die Erdoberfläche zurück. Je wärmer allerdings die Atmosphäre ist, umso mehr Wasserdampf kann sie aufnehmen. Damit spielt der Wasserdampf tatsächlich eine sehr große Rolle beim natürlichen Treibhauseffekt. Die Wasserdampf-Moleküle in der Erdatmosphäre können wiederum Wärmestrahlung absorbieren und die Temperatur so weiter erhöhen.

EIKE zu Punkt 4

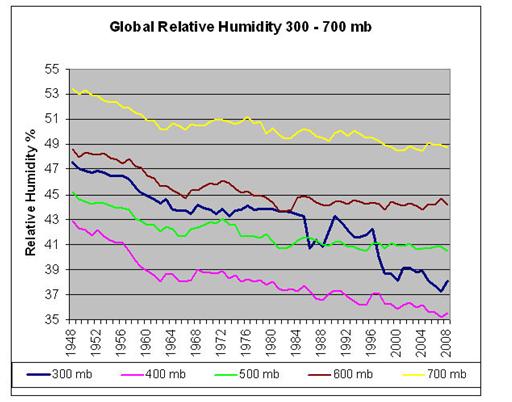

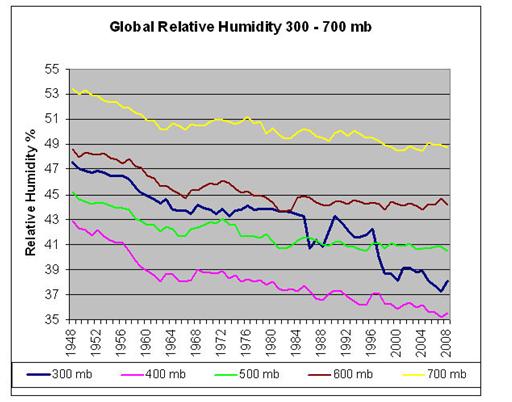

„Leider“ gibt es kein Wasserdampf-Feedback, auch wenn dies noch so sehr beschwört wird, wie die folgende Abbildung zeigt.

Die Abbildung zeigt die Änderung der globalen relativen Luftfeuchte für unterschiedliche Höhen anhand von NASA-Satellitendaten. Entgegen der Aussage von Herrn Claußen, ist keine Zunahme des Wasserdampfgehalts, sondern eine globale Abnahme zu verzeichnen. Die Studie kommt zu dem Schluss, dass es in den letzten 60 Jahren keinen Anhaltspunkt für eine treibhausgasbasierte Erwärmung gibt.

700 mbar entspricht ca. 3.000 m-Höhe

600 mbar entspricht ca. 4.000 m-Höhe

500 mbar entspricht ca. 5.500 m-Höhe

400 mbar entspricht ca. 7.000 m-Höhe

300 mbar entspricht ca. 9.000 m-Höhe

Auch stellte die NASA bereits 2004 fest, dass die Klimamodelle den Einfluss von Wasserdampf überbewerten: “A NASA-funded study found some climate models might be overestimating the amount of water vapor entering the atmosphere as the Earth warms. They found the increases in water vapor were not as high as many climate-forecasting computer models have assumed.” (http://www.nasa.gov/centers/goddard/news/topstory/2004/0315humidity.html).

Zur Wirkung des sog. Wasserdampf-Feedback hat EIKE in ihrem Artikel “Das wissenschaftliche Ende des Treibhauseffekts“ (http://www.eike-klima-energie.eu/lesezeichen-anzeige/das-wissenschaftliche-ende-der-klimakatastrophe/) eingehend Stellung genommen. Wir zitieren: “Die unbefriedigende Situation änderte sich nun schlagartig mit zwei neuen Arbeiten, von denen die eine im Feb. 2009 bei Theoretical and Applied Climatology [2], die andere im Sept. 2009 bei Geophysical Research Letters erschien [1].

G. Paltridge, A. Arking und M. Pook zeigten in der Zeitschrift Theoretical and Applied Climatology, dass die spezifische und relative Feuchte in der mittleren und oberen Troposphäre (oberhalb 850 hPa) im Gegensatz zu den Voraussagen der Klimamodelle des IPCC in den Jahren 1973 bis 2007 mit den steigenden Temperaturen in dieser Zeit abnimmt, was einer negativen Rückkopplung entspricht.”

Und genau diese neg. Rückkopplung, die das IPCC geflissentlich unterlassen hat zu erwähnen, hat der Atmosphärenforscher am MIT, Prof. Dr. Lindzen, beschrieben. Eine deutsche Zusammenfassung findet sich unter (http://wetterjournal.wordpress.com/2009/05/21/die-argumente-der-klimaskeptiker-i-treibhauseffekt-und-wolken/)

Weitere Fachliteratur:

Paltridge, G., Arking, A. and Pook, M. 2009. Trends in middle- and upper-level tropospheric humidity from NCEP reanalysis data. Theoretical and Applied Climatology: 10.1007/s00704-009-0117-x. A comparison of tropical temperature trends with model predictions”, by Douglass, D.H., J.R. Christy, B.D. Pearson, and S.F. Singer, 2007 – International Journal of Climatology

Fazit: In den Aussagen der befragten “Klimaforscher“ kommt zum Vorschein, dass Vermutungen mit der Realität, die längst das Postulat der Wasserdampfverstärkung widerlegte und einen Schritt weiter ist, verwechselt werden.

5.) These lt. Focus der Klimarealisten

Die Sonne beeinflusst das Klima

dazu im Text von Focus Redakteurin Christina Steinlein

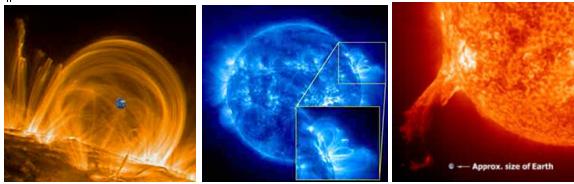

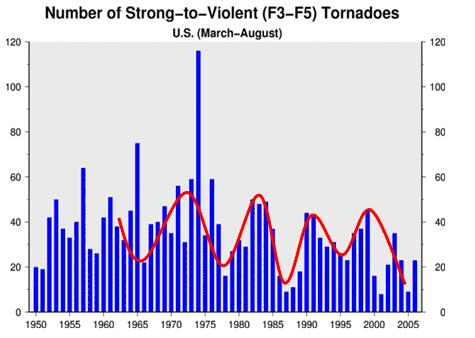

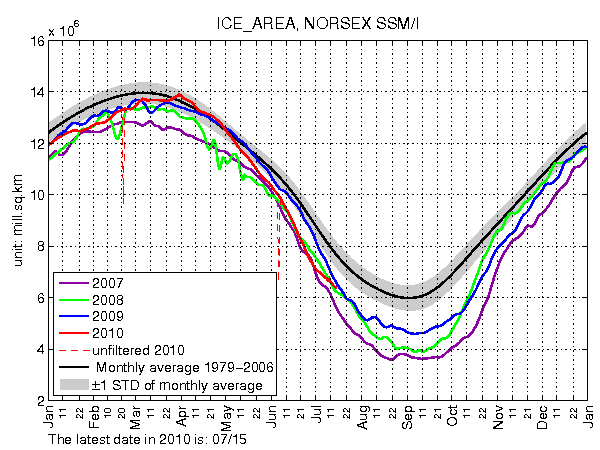

Die Sonne ist der Energielieferant der Erde. Ihre Aktivität schwankt in einem ungefähr elfjährigen Zyklus. Es ist unbestritten, dass diese Schwankungen des Sonnenzyklus in der Vergangenheit das Klima verändert haben. Sie können aber aus zwei Gründen die Erwärmung im 20. Jahrhundert nicht erklären. Erstens: Seit Ende der 70er-Jahre wird die Sonnenstrahlung direkt von Satelliten aus gemessen. Diese Beobachtungen zeigten, dass der Unterschied zwischen Maximum und Minimum der Sonnenstrahlung während eines Zyklus etwa 0,1 Prozent der Strahlungsintensität ausmachen. „Die Stärke der Schwankungen ist zu gering. Die Strahlungswirkung der vom Menschen verursachten Treibhausgase ist inzwischen um ein Mehrfaches stärker“, Rahmstorf.

Und zweitens: Hätte der Zyklus der Sonne tatsächlich einen signifikanten Einfluss auf das Klima, dann ist es nicht zu erklären, dass sich die Erde in den letzten dreißig Jahren erwärmt und nicht im Takt mit der Sonne wieder abgekühlt hat. Eine aktuelle Studie, die im Magazin „Nature“ veröffentlicht wurde, kam gar zu dem Ergebnis, dass die Sonnenaktivität seit über 50 Jahren nicht zugenommen, in den letzten 20 sogar abgenommen hat.

EIKE zu Punkt 5

“Erstens… Die Stärke der Schwankungen ist zu gering. Die Strahlungswirkung der vom Menschen verursachten Treibhausgase ist inzwischen um ein Mehrfaches stärker“, Rahmstorf.

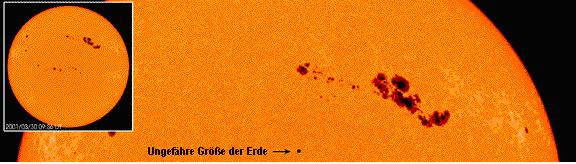

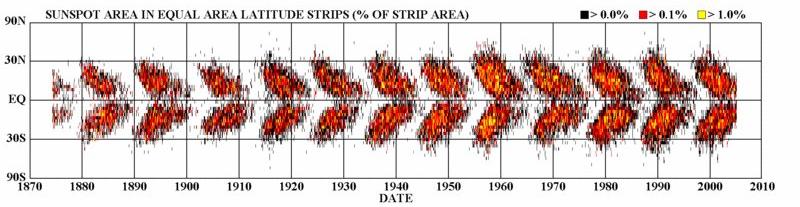

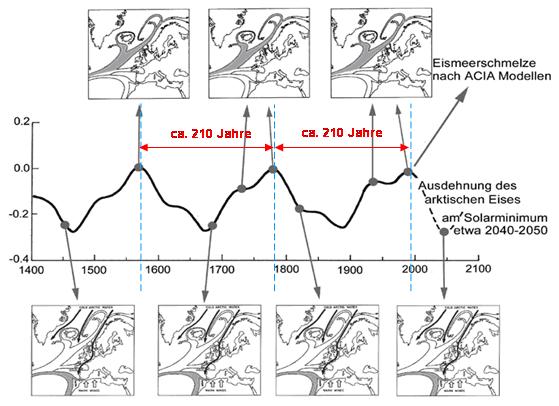

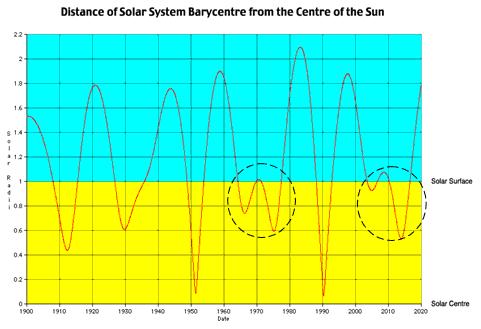

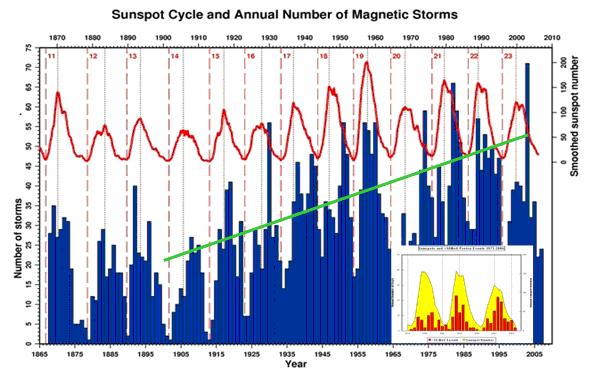

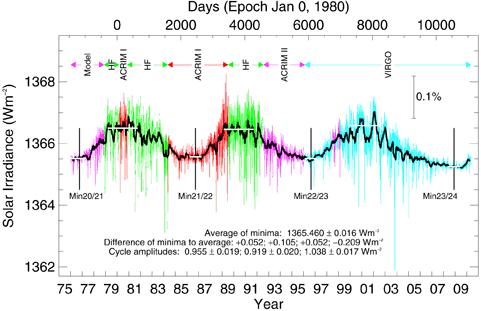

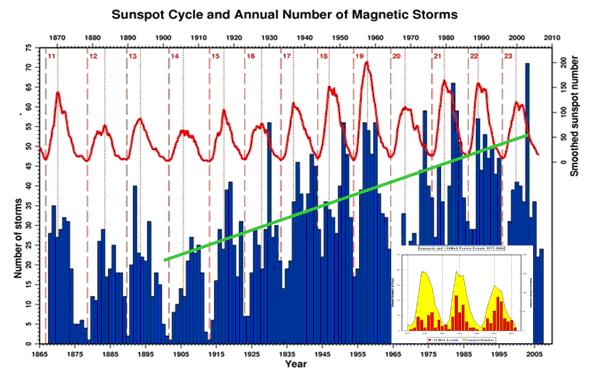

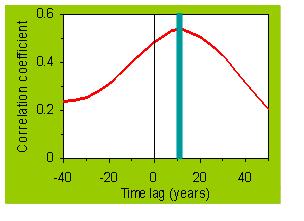

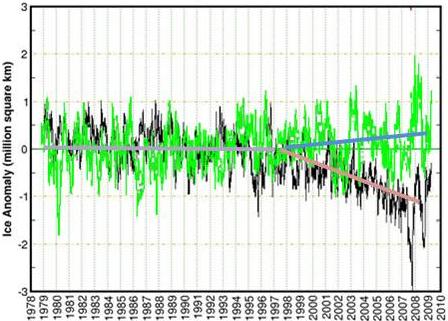

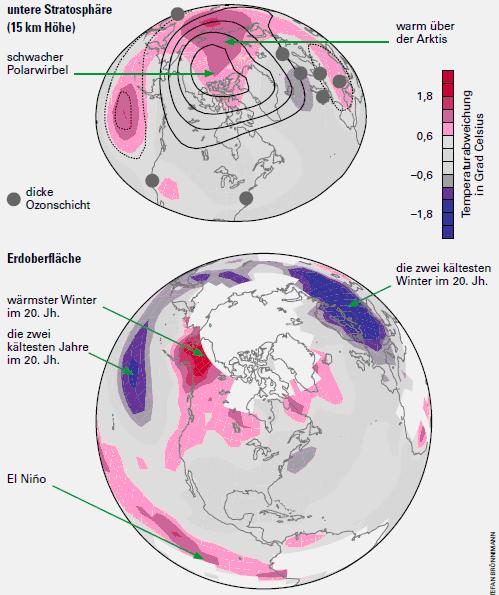

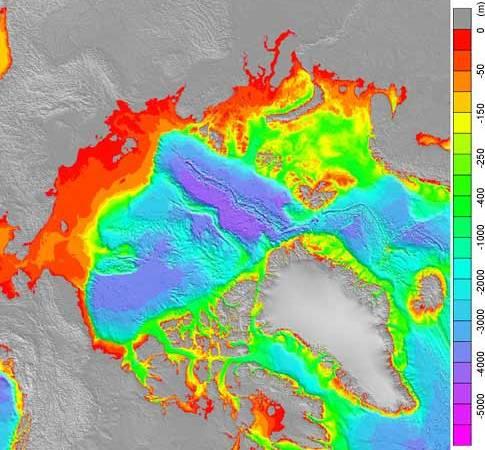

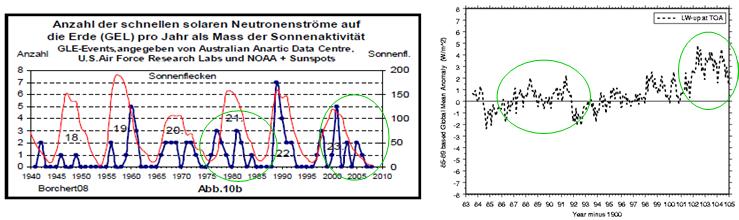

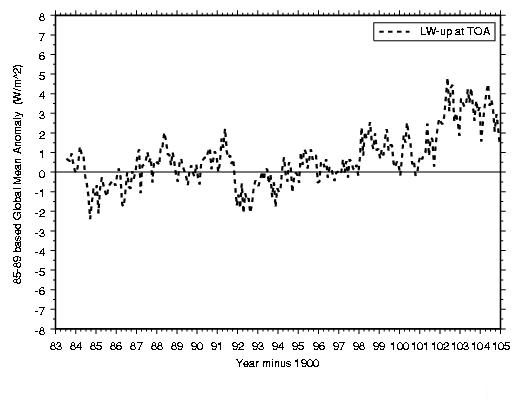

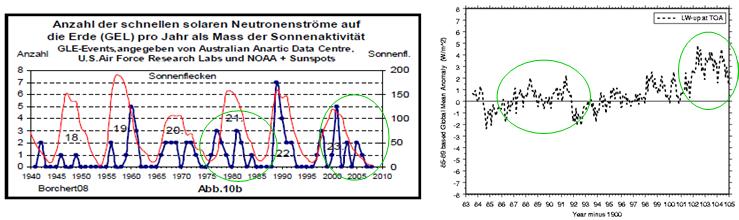

Dies ist eine Falschaussage, bezogen auf die solaren Aktivitätsschwankungen, wie die folgende Abbildung belegt.

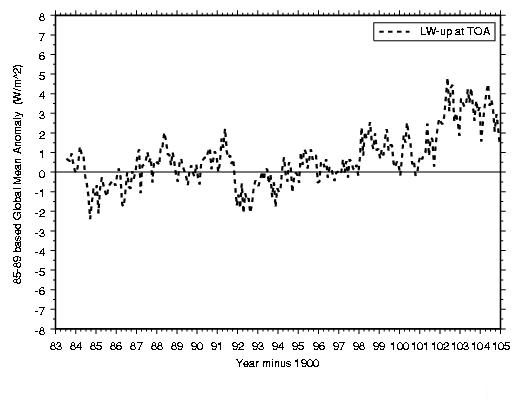

Die Abbildung, Quelle: GISS, zeigt die sich ändernde Strahlungsabgabe (Variabilität, TOP = Top Of Atmosphere) der Erde im Zeitraum 1984 – 2005. Anmerkung: Dem GISS ist bei der Beschriftung der Zeitachse ein Fehler unterlaufen, es muss natürlich heißen, Year plus 1900. Der Hub zwischen Min. – Max. beträgt 7 W/m2.

Dazu noch die solare Aktivitätskurve, aus der ersichtlich wird, wie stark die Strahlungsabgabe der Erde mit der Sonnenaktivität korreliert – die Kurven sind nahezu in ihrer Form deckungsgleich.

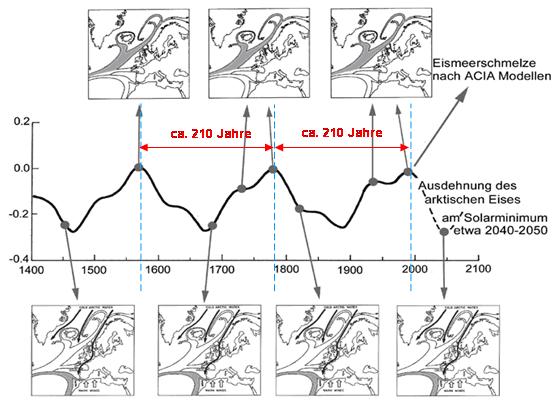

“Und zweitens: Hätte der Zyklus der Sonne tatsächlich einen signifikanten Einfluss auf das Klima,… dass die Sonnenaktivität seit über 50 Jahren nicht zugenommen, in den letzten 20 sogar abgenommen hat.“ Rahmstorf

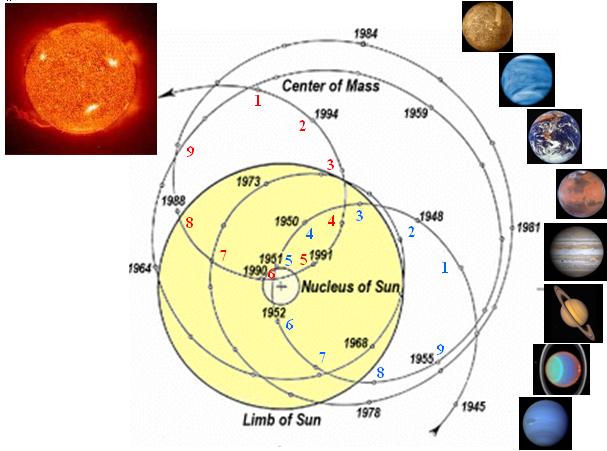

Auch dies ist leider eine Falschaussage. Der Hauptsonnenzyklus, der im Mittel 208-jährige de Vries/Suess-Zyklus hatte um 2003 sein langjähriges Maximum, als in Deutschland die Presse vom “Hitzesommer“ redete. In 2005 (der de Vries/Suess-Zyklus hat, wie der im Mittel 11-jährige, „untergeordnete“ Schwabe-Zyklus, oft eine Doppelspitze in der Aktivität), als überall von den “Hitzetoten“ in der Presse zu lesen war, sagte der Chef-Sonnenforscher der NASA, Hathaway: “Das Solare Minimum explodiert – Das Solare Minimum sieht seltsamerweise aus wie ein solares Maximum.“ (http://science.nasa.gov/headlines/y2005/15sep_solarminexplodes.htm)

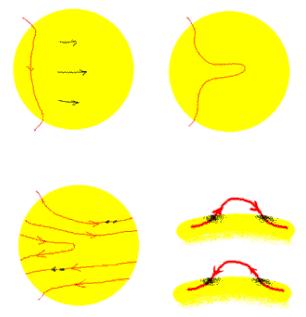

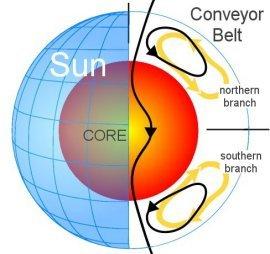

Rahmstorf hebt bei seinen Aussagen auf die Satellitendaten ab, die seit 1979 die solare Aktivität messen. Satelliten sind hierfür sicherlich das geeignete Instrument, nur muss der Satellit auch die „Augen“ dafür haben, die solare Aktivität zu sehen. Genau die hat er aber nicht! Die solaren Aktivitätsschwankungen werden im sog. TSI (Total Solar Irradiance) zusammengefasst. Das Messsystem ist aber nur in der Lage, den Wellenlängenbereich von 200 nm – 2.000 nm aufzunehmen, also nur einen Bruchteil des solaren Aktivitätsspektrums. Von “Total“ kann demnach gar keine Rede sein. Insbesondere die Berieche, die zwischen Sonnenminimum und Sonnenmaximum am stärksten variieren, werden gar nicht aufgezeichnet. So variiert im Schwabe-Zyklus die solare Aktivität im sichtbarem Bereich lediglich um <1%, im UVB-Bereich (205 nm) um ca. 7%, bei 150 nm bereits um 15%, im EVU (<150 nm) sogar um 35% und im Röntgenbereich gar um das 100-fache. Über die kosmische Strahlung*) (Svensmark-Effekt) und die Stratosphäre, übt die Sonne jedoch auch in dem nicht aufgezeichneten Energiebereich indirekt, bzw. direkt Einfluss auf das irdische Wettergeschehen und somit auf das Klima.

*) Die solare Aktivität im Hauptsonnenzyklus, dem de Vries/Suess-Zyklus lässt sich denn auch nicht im TSI erkennen.

Die wegweisenden Arbeiten von Svensmark und Veizer, die Rahmstorf, Schellnhuber und Marotzke offensichtlich nicht bekannt sind (Höhe der Zeit?) finden Sie z.B. unter (http://www.sciencedirect.com/..). Die Welt widmete Svensmark im Dezember 2009 folgenden Titel “Ein Physiker erschüttert die Klimatheorie“ (http://www.welt.de/wissenschaft/umwelt/article5528858/Ein-Physiker-erschuettert-die-Klimatheorie.html). Weiteres wissenschaftliches Material findet sich unter (http://www.pro-physik.de/Phy/leadArticle.do?laid=2547). Die Liste lässt sich beliebig fortsetzen.

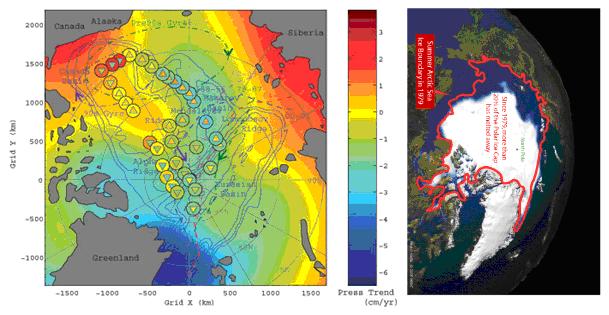

Fazit: Bei den Sonnenaktivitätskurven des TSI handelt es sich um eine Mogelpackung, bzw. um eine irreführende Bezeichnung. Die solare Aktivität hat bis zum Maximum des Hauptsonnenzyklus, dem im Mittel 208-jährige de Vries/Suess-Zykluss (ca. 2003) kontinuierlich zugenommen, synchron zur leichten Temperaturerhöhung, die die Satellitendaten ausweisen. Seit dem Rückgang der solaren Aktivität (de Vries/Suess-Zyklus) und dem Ausbleiben des 24. Schwabezyklus, rauschten die Erdtemperaturen in den Keller, wie wir dies gegenwärtig in weiten Teilen auf der Nordhalbkugel anhand des strengen und langen Winters zu spüren bekommen.

6.) These lt. Focus der Klimarealisten

Alle Klimavorhersagen sind Quatsch

dazu im Text von Focus Redakteurin Christina Steinlein

Die Wissenschaftler werden häufig als Klimapropagandisten oder Klimahysteriker beschimpft. Gleichzeitig wird ihnen vorgeworfen, nur ungenaue Aussagen zu treffen.

Zum Beispiel die, dass sich die Temperatur bis Ende des Jahrhunderts um einen Wert zwischen 1,1 und 6,4 Grad erwärmen wird. Konkretere Prognosen lassen sich nicht treffen, sie wären unseriös. Die genannte Spanne stellt keine Unsicherheit dar. Sie entsteht aus der Arbeit der Klimaforscher, die eine ganze Reihe von Szenarien durchrechnen, nach dem Prinzip: „Wenn wir soundso viel CO2 ausstoßen, dann wird es soundso warm.“ So kommen die Differenzen zustande.

Dass die Vorhersagen aber alles andere als Unsinn sind, kann man der Landkarte unten entnehmen. Die einzelnen Grafiken des Weltklimarats IPCC zeigen die Prognosen von Modellen, die nur natürliche Einflüsse auf die Temperaturentwicklung berücksichtigt haben (blau) und von Modellen, die auch den Einfluss der Menschen miteinbezogen (rot). Die Linie zeigt jeweils die tatsächlichen Messwerte an.

Häufig behaupten Skeptiker auch, dass die Prognosen bislang alle zu pessimistisch ausgefallen sind. Auch das widerlegt die Karte des IPCC.

EIKE zu Punkt 6

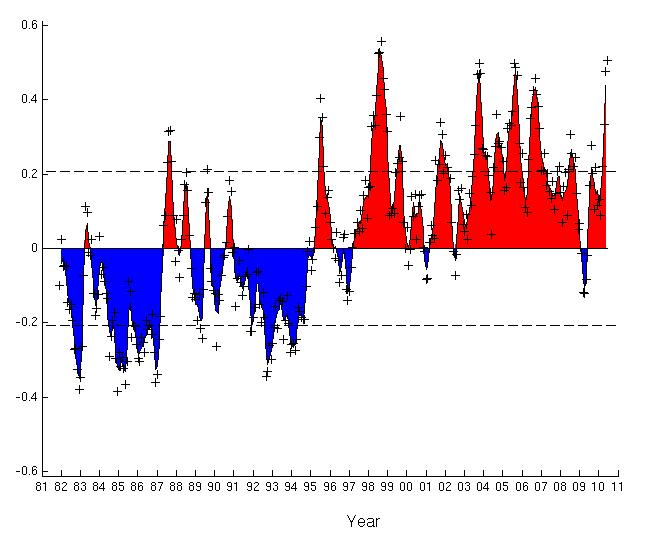

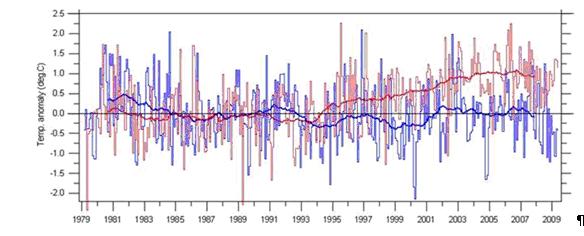

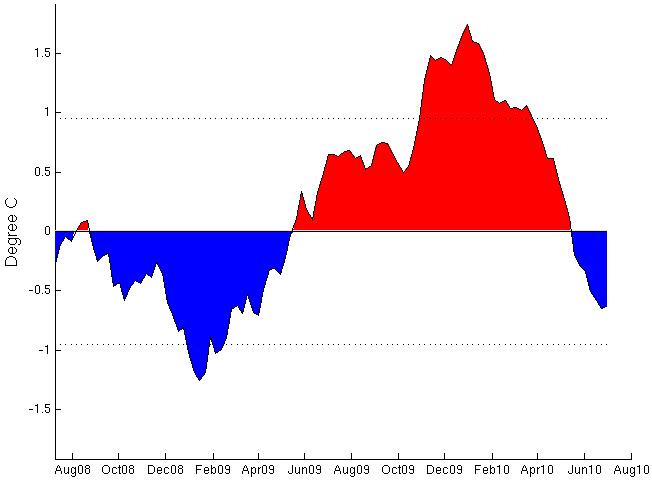

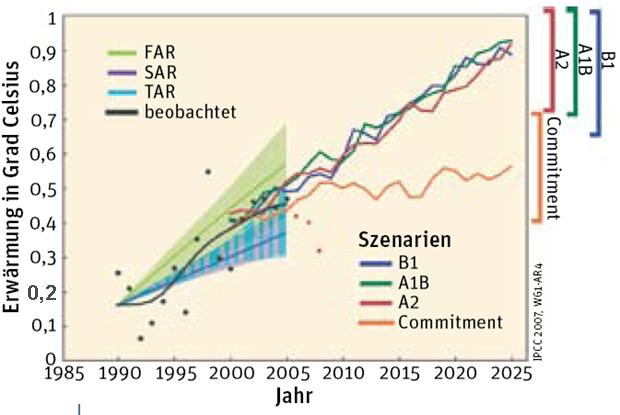

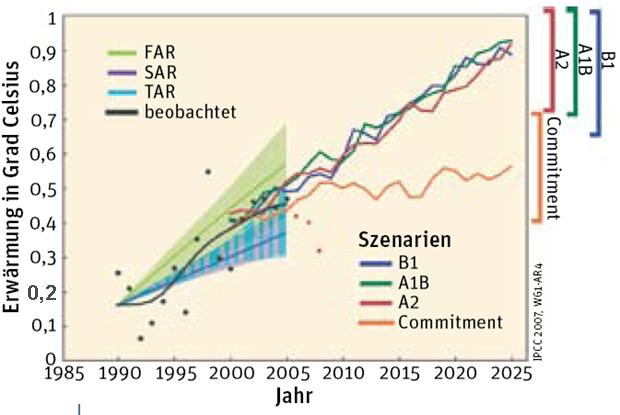

Klimamodelle sind grundsätzlich nicht dazu geeignet, dass Geschehen für die nächsten Jahre auch nur annähernd richtig wiederzugeben, wäre die treffende Bezeichnung. Da sich jedes Modell/Vorhersage an der Realität messen muss, zeigt die folgende Abbildung, dass selbst für kurze Zeiträume, Klimamodelle fulminant an der Realität vorbei gehen. Die globalen Temperaturen fallen deutlich, das IPCC meldet anhand seiner Modelle, steigende Temperaturen.

Die Abbildung zeigt die vier Temperatur-Szenarien (B1, A1B, A2, Commitment) aus dem IPCC-Bericht 2007, die aus den IPCC-Klimamodellen ermittelt wurden. Das Szenario “Commitment“, welches die niedrigste Temperaturentwicklung angibt, geht dabei von einer gleich bleibenden CO2-Konzentration wie im Jahr 2000 aus! Bei den drei anderen Szenarien steigt indes die CO2-Konzentration weiter an, wie dies z.B. die Mauna Loa-Daten wiedergeben, Quelle: S.d.W. 02/09, “Kalt erwischt“, S. 21 – 22. Die roten Punkte geben die tatsächliche Temperaturentwicklung bis 2008 wieder (schwarze Punkte, sind die gemessenen Temperaturwerte bis 2005). Seit 2005 fallen die Temperaturen deutlich. Die grün, blau und violett schraffierten Bereiche zeigen die Szenarien der früheren IPCC-Vorhersagen (FAR = First Assessment Report, 1990; SAR = Second Assessment Report, 1995; TAR = Third Assessment Report, 2001).

Schellnhuber zeigte jüngst in beeindruckender Weise, was von Klimamodellen zu halten ist: “Wir sind in der Lage, mit Modellen zu erkennen, dass bei fortschreitender Erwärmung in 100 Jahren alle Himalaya-Gletscher verschwunden sein dürften.” Diese Aussage machte der „Forscher“ Schellnhuber kürzlich im Bayerischen Rundfunk (BR5). Seit Glaciergate wissen wir, was es mit dem vermeintlichen Ergebnis aus Klimamodellen zum Himalaya-Gletscherschwund auf sich hat. Herr Schellnhuber schiebt dieses "katastrophale" Abschmelzen auf den Rußausstoß chinesischer Kohle-Kraftwerke. Kein weiterer Kommentar zu den Klimamodellen!!

Zum Abschluss lassen wir das IPCC selbst zu den Klimamodellen Stellung nehmen. Im dritten Sachstandsbericht 2001 Sec. 14.2.2.2., S. 774 heißt es: ”… we are dealing with a coupled non-linear chaotic system, and therefore that the long-term prediction of future climate states is not possible”

Fazit: Wissenschaft ist die Lehre der Exaktheit. Klimamodelle haben nichts mit Exaktheit, sondern lediglich etwas mit Vermutungen und Gewichtungen zu tun, durch welche die Endergebnisse in beabsichtigter Weise getrimmt werden. Vermutungen, bzw. Vermutungswissenschaftler sollten in der seriösen Wissenschaft keinen Einzug halten. Darüber hinaus kennen die “Klimaforscher“ ganz offensichtlich nicht die eigenen Klimamodelle, was den Anschein hat, dass die befragten “Klimaforscher“ nicht wissen, wovon sie reden!

7.) These lt. Focus der Klimarealisten

Die IPCC-Berichte sind politisch beeinflusst

dazu im Text von Focus Redakteurin Christina Steinlein

Das IPCC sei eine interessengeleitete Kungelrunde, behaupten Klimaskeptiker. „Das ist eine Verschwörungstheorie. Den Verschwörungstheoretikern kann man Fakten vorlegen, so viel man will, das kommt bei denen nicht an“, sagt Marotzke. „In der gesamten Geowissenschaft gibt es nichts Vergleichbares zu den IPCC-Berichten, nichts, das so sorgfältig begutachtet wird. An der Erstellung sind über 1000 Wissenschaftler beteiligt. Es gehen nur Studien in die Berichte ein, die zuvor veröffentlicht und damit von der Fachwelt beurteilt wurden. Die IPCC-Berichte, die aus diesen begutachteten Studien entstehen, werden wiederum begutachtet, und das mehrfach.“ Davon auszugehen, dass über 1000 Wissenschaftler die Wahrheit unterdrücken und nicht ein einziger ausschert, ist abwegig. „Jeder Wissenschaftler, der stichhaltig belegen könnte, dass die menschengemachte Erwärmung kein Problem ist, wäre auf einen Schlag der berühmteste Wissenschaftler der Welt. Das würde sich doch kein Forscher entgehen lassen“, argumentiert Marotzke weiter.

Außerdem werden die Berichte des IPCC-Berichts anschließend noch zusammengefasst – und von Regierungsvertretern verabschiedet. Dass all die Regierungen mit den unterschiedlichsten Interessenlagen der Zusammenfassung des IPCC-Berichts Satz für Satz einstimmig zugestimmt haben, ist nur „deshalb möglich, weil an den enthaltenen wissenschaftlichen Ergebnissen beim besten Willen nicht zu rütteln ist. Die Bush-Administration hätte dem Bericht sonst wohl kaum zugestimmt“, stellt Rahmstorf klar.

EIKE zu Punkt 7

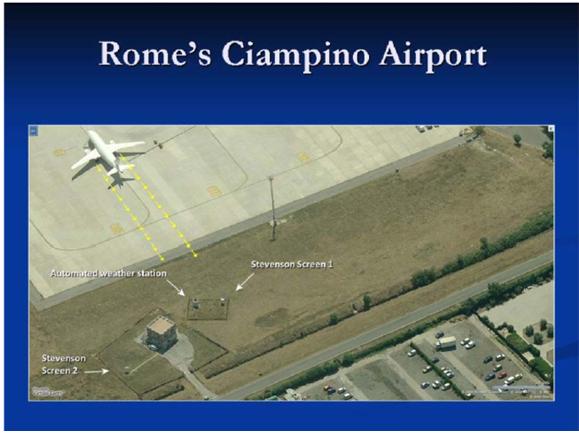

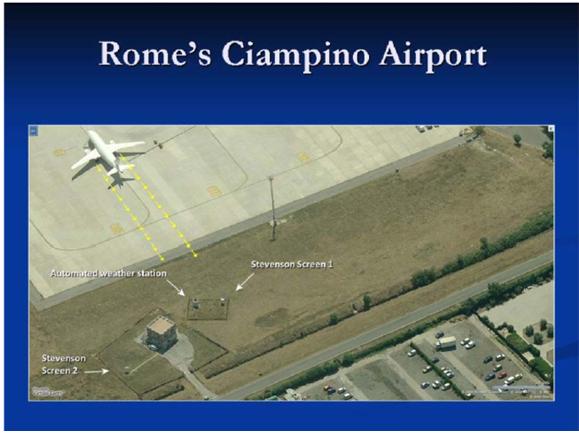

Das IPCC sollte sich nicht hinter Politikern verstecken, sondern für seine Arbeiten und die seiner Leader selbst gerade stehen. Climategate ist real. Glaciergate ebenfalls und beides ist nur die Spitze des Eisbergs, wie die Temperaturmanipulationen diverser Institute, darunter das GISS, schließen lassen. Die Herren haben, um zu steigenden Temperaturen zu gelangen, einfach die Stationen heraus genommen, die fallende Temperaturen ausweisen und die Stationen, die in Ballungszentren liegen und somit steigende Temperaturen ausweisen, betrachtet (SURFACE TEMPERATURE RECORDS: POLICY DRIVEN DECEPTION? by Joseph D’Aleo and Anthony Watts). Ein Beispiel für die Güte der verbliebenen Messstationen.

Fazit: Climategate ist traurige Gewissheit. Der Rücktritt von Phil Jones, der den Betrug zugibt oder der Himalaya-Betrug der zugegeben wurde, beweisen: Es gibt ein Klimakartell von korrupten Klimaforschern, die Daten fälschen, Kollegen diffamieren und Begutachtungen manipulieren.

8.) These lt. Focus der Klimarealisten

Der Mensch ist nur für drei Prozent des CO2 verantwortlich

dazu im Text von Focus Redakteurin Christina Steinlein

Wer das sagt, vergleicht Äpfel mit Birnen. Die 97 Prozent CO2-Emissionen, für die angeblich die Natur zuständig ist, gehören zu einem geschlossenen Kreislauf: Menschen, Tiere und Pflanzen atmen Milliarden von Tonnen CO2 aus. Allerdings stehen auf der anderen Seite Pflanzen, die das CO2 (zusammen mit anderen Stoffen) durch die Photosynthese wieder in Blätter und Holz umwandeln. Der biologische Kohlenstoffkreislauf ist geschlossen. „Die CO2-Konzentration in der Atmosphäre war jahrtausendelang praktisch konstant und steigt erst an, seit wir dem System riesige Mengen an zusätzlichem Kohlenstoff aus fossilen Lagerstätten zuführen“, erklärt Rahmstorf.

Diese vom Menschen verursachten Emissionen machen zwar tatsächlich etwa die oben genannten drei Prozent aus – dabei handelt es sich aber um Milliarden Tonnen Kohlendioxid, die dem eigentlich stabilen Kohlenstoffkreislauf netto hinzugefügt werden.

EIKE zu Punkt 8

Es gibt in der Natur keine stationären Prozesse, allenfalls periodisch-instationäre, wie z.B. den Tag/Nacht-Rythmus. Dies sollte einem Physiker, wie Rahmstorf eigentlich bekannt sein.

Mit zunehmender Erwärmung gast nicht nur zusätzliches CO2 aus, welches vorher, z.B. in den Weltmeeren gebunden war (siehe unter Punkt 2). Auch das Leben überall auf der Welt nimmt an Vielzahl und Vielfalt zu. Nicht umsonst gelten tropische Regenwälder als das Dorado der Artenvielfalt. Das CO2 wird per Photosynthese nur zum Teil in Biomasse umgewandelt, ca. 30 % gehen als Hydrogencarbonat in die Böden (siehe Fachbücher der Pflanzenphysiologie). Ein nicht weiter wachsender Pflanzenbestand scheidet durch die Photosynthese (O2) und durch Atmung (CO2) die gleiche Menge ab, wie er für die Atmung (O2) und Photosynthese (CO2) verbraucht. Während der Wachstumsphase der Pflanzen wird im Zuge der Photosynthese so viel CO2 in organische Substanz eingebaut und O2 an die Atmosphäre abgegeben wie die Konsumenten dieser organischen Substanz (Bakterien, Pilze, Weidetiere, der Mensch, ja die Pflanzen selbst durch ihre Atmung) im Zuge der Verdauung, Atmung, Verrottung, Verwesung an CO2 freisetzen und an O2 verbrauchen. Dieser Prozess ist jedoch dynamisch und somit nicht für einen betrachteten Zeitabschnitt, wie z.B. 30 Jahre (internationale Definition für Klimazeitraum) konstant oder geschlossen. Mit zunehmendem Wachstum, z.B. durch bessere klimatische Bedingungen, wozu auch CO2 gehört, nicht umsonst ist CO2 ein effektiver Pflanzendünger, ergibt sich bildlich gesprochen, eine Spirale nach oben. Es gibt in einer offenen Atmosphäre mit ständiger Durchmischung keinen geschlossenen Kreislauf. CO2 schwankt mit der Temperatur und war nie konstant. Mit zunehmender Artenvielfalt steigen z.B. auch deren CO2-Emissionen (siehe unter Punkt 9).

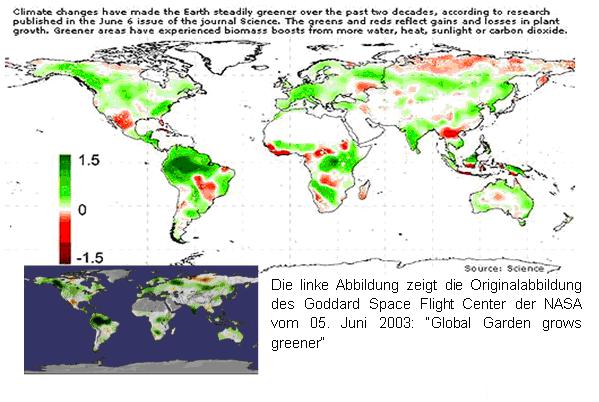

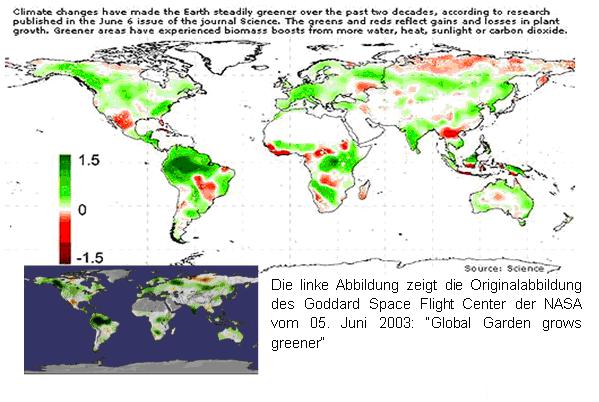

Wer behauptet, natürliches CO2 wäre konstant, also ohne Einfluss auf die atmosphärischen CO2-Schwankungen, der hat entweder sein Metier verfehlt, oder sagt bewusst Falsches, wie die folgende Abbildung zeigt.

Die Abbildung zeigt, wie sich laut NASA/Science die Artenvielfalt seit Beginn der 1980-Jahre steigerte, was folglich auch Auswirkungen auf die C-Kreisläufe der Natur hat. Von konstanten Kreisläufen kann also gar keine Rede sein.

Fazit: Der atmosphärische CO2-Gehalt war in der Atmosphäre nie konstant, sondern schwankte ganz erheblich. Anhand der gigantischen natürlichen CO2-Mengen, die allein durch eine Erwärmung freigesetzt werden und den CO2-Pegel triggern (Abbildung unter Punkt 2), gehen die wenigen GT anthropogenem CO2 im Hintergrundrauschen natürlicher Fluktuationen unter.

9.) These lt. Focus der Klimarealisten

Wir atmen zu viel

dazu im Text von Focus Redakteurin Christina Steinlein

Es stimmt, dass Menschen, Pflanzen und Tiere Kohlendioxid ausatmen – und zwar die unvorstellbare Menge von etwa 120 Milliarden Tonnen pro Jahr. Aber: Wie schon erwähnt, gehören diese zum geschlossenen Kohlenstoffkreislauf. Das ausgeatmete CO2 entsteht bei der Verbrennung von Nahrungsmitteln im Körper. Es ist also Kohlendioxid, das vorher der Atmosphäre durch die Photosynthese entzogen wurde.

Das Gleiche gilt für die Verbrennung von Holz: Wird immer nur so viel Holz verbrannt wie auch wieder aufgeforstet wird, trägt die Holzverbrennung nicht zusätzlich zum Treibhauseffekt bei.

EIKE zu Punkt 9

Mit jedem Atemzug CO2 (385 ppm), dass wir einatmen, atmen wir die fast 150-fache Menge CO2 wieder aus. Jeder Mensch fast 1 Tonne und Jahr. Die von allen Menschen im Atmungsprozess erzeugte CO2-Menge ist beispielsweise mit der des weltweiten automobilen Verkehrs in etwa gleich zu setzen. Gottlob ist beim IPCC noch niemand mit der Forderung an die Menschheit herangetreten, dass diese, oder bestimmte Länder, jetzt nicht mehr atmen dürfen oder zumindest der Sport einzuschränken ist, bei dem bekanntermaßen die Atmung auf Hochtouren läuft.

Wie bereits geschildert, gibt es in der Natur weder stationäre Systeme, noch geschlossene Kreisläufe. Die Menge CO2, die die Menschheit im Jahr durch den Citrat-Zyklus produziert und in die Umwelt abgibt, ist vernachlässigbar, mit der Menge, die Bakterien oder Insekten als Beitrag zusteuern. Nach Brefeld beträgt allein die Biomasse der landlebenden Mikroorganismen 400 Milliarden Tonnen, die alle über den Citratzyklus Energie gewinnen und dabei CO2 freisetzen. Die Biomasse der Menschen liegt mit 0,4 Milliaden Tonnen bei 1/1000 und ist damit vernachlässigbar klein. Wie ein jeder weiß, steigen mit zunehmender Temperatur die Lebensbedingungen für Bakterien und sonst. Mikroorganismen. Nicht umsonst werden in der medizinischen Forschung die dort ablaufenden Prozesse mit dem Katalysator Wärme beschleunigt. D.h. aber, dass mit zunehmender Erwärmung die Biomasse entsprechend, teils explosionsartig steigt und damit natürlich auch deren Stoffwechsel und mit diesem die Atmung, wodurch sich die ausgebrachte CO2-Menge dieser Spezies deutlich erhöht.

Die genannten 120 GT beruhen denn auch nur auf den Abschätzungen des IPCC: 60 GT/Jahre durch Respiration von Pflanze und Tier und 60 GT/Jahr durch Bodenatmung (Bakterien). Diese Schätzung ist mehr als fragwürdig (auch ohne Glaciergate). Allein die Insektenatmung einer Spezies (Drosophila) beträgt im halben Jahr 2.000 GT!!! (Fachbücher der Tierphysiologie).

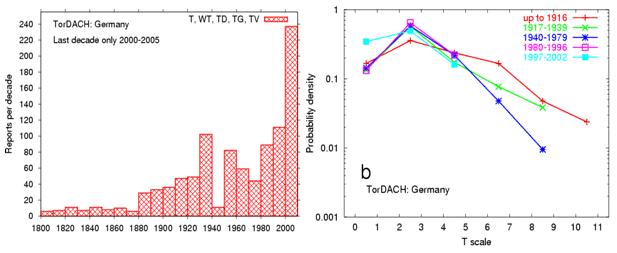

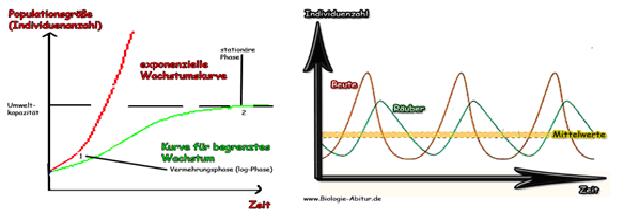

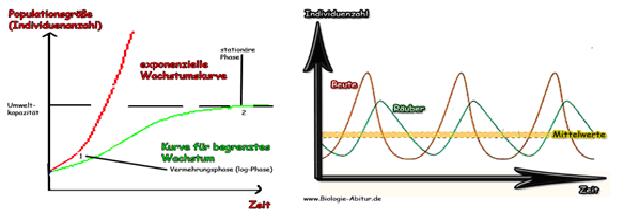

Die folgende Abbildung zeigt, wie sich dynamische Populationsmodelle verhalten. Es sind keine stationären oder in sich geschlossenen Systeme, sondern stark dynamische und offene.

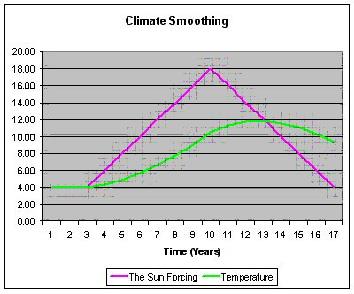

Die Abbildung links zeigt den Unterschied zwischen begrenztem und exponentiellem Wachstum bei optimalen Bedingungen. Populationen bewegen sich, je nach Rahmenbedingungen zwischen diesen Kurven. Die rechte Abbildung zeigt anhand der Räuber/Beute-Beziehung das Schwingverhalten der Individuenanzahl. Durch die derzeitige Schwingung nach oben, zu mehr CO2 (auf Grund von Ausdünstungen aus Ozean/Land und erhöhter Biodervisität) wird das Pflanzenwachstum angetrieben, wie es die Untersuchungen der NASA (Abbildung unter Punkt 8) zeigt.

Der weltweit anerkannte Prof. Veizer sagt hierzu folgendes: "CO2 reitet quasi Huckepack auf dem Wasserkreislauf, denn bei der Photosynthese müssen Pflanzen fast 1000 Wassermoleküle ausatmen, um ein einziges CO2-Molekül aufzunehmen." Wenn es wärmer wird, beschleunigt sich der irdische Wasserkreislauf, die Bioproduktivität erhöht sich, Bodenorganismen atmen vermehrt CO2 aus (http://www.pro-physik.de/Phy/leadArticle.do?laid=2547).

Fazit: Die befragten “Klimaforscher“ wandern auf ihnen unbekanntem Terrain und kommen dabei mächtig ins Straucheln. Deren genannte Zahlenangaben sind reine Spekulation (Vermutungen). Die Aussage, es gäbe stationäre Systeme, die somit keinen Einfluss auf die atmosphärische CO2-Konzentration hätten, ist wissenschaftlicher Mumpitz.

10.) These lt. Focus der Klimarealisten

Das wird alles nicht so schlimm, weil es Rückkopplungen gibt

dazu im Text von Focus Redakteurin Christina Steinlein

Seit der Industrialisierung hat die Menschheit die CO2-Konzentration in der Atmosphäre um ein Drittel erhöht. Werden unvermindert Treibhausgase emittiert, wird sich der CO2-Gehalt bis etwa 2050 verdoppelt haben. Der jüngste Bericht des Weltklimarats nennt eine Spanne von 1,1 bis 6,4 Grad Celsius, je nachdem, wie sich die CO2-Emissionen entwickeln.

Schon eine leichte Erwärmung kann Vorgänge in Bewegung setzen, die den Treibhauseffekt verstärken oder abschwächen. Die Klimaforscher sprechen von positiven oder negativen Rückkopplungen. Es sind etliche dieser Rückkopplungen bekannt – das Problem ist, dass es sich dabei fast ausschließlich um solche Effekte handelt, die den Klimawandel beschleunigen. Die Wissenschaftler nennen solche Ereignisse „Kipppunkte“.

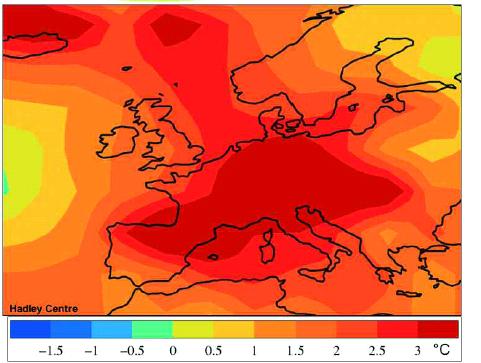

Die Erfahrung der Erdgeschichte zeigt, dass schon für Laien recht moderat klingende Klimaveränderungen immer massive Auswirkungen gehabt haben. Sie lehrt, dass in der Vergangenheit die Veränderung des Meeresspiegels pro Grad Celsius globaler Temperaturänderung zwischen 10 und 30 Metern lag. Wenn die Temperatur sich bis 2050 um zwei Grad erhöht, im Vergleich zu der Zeit vor der Industrialisierung, werden die Meeresspiegel langfristig um 20 Meter ansteigen. Venedig, New York und Bombay können wir vergessen“, warnt Hans-Joachim Schellnhuber, Leiter des Potsdam-Instituts für Klimafolgenforschung.

Ob er die Folgen des Klimawandels als „nicht so schlimm“ einschätzt, bleibe jedem selbst überlassen, sagt Marotzke. „Die Fakten sprechen jedenfalls für sich.“

EIKE zu Punkt 10

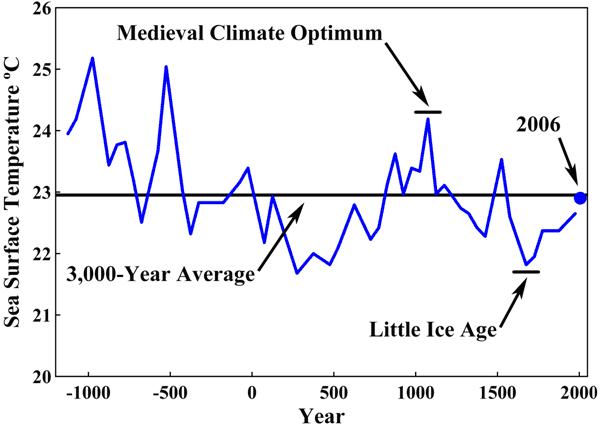

Die meisten Rückkopplungen sind spekulativ und nicht nachgewiesen, bzw. widerlegt (siehe Punkt 4). Nie sind Kipppunkte in der Natur beobachtet worden. Dagegen verlaufen alle geophysikalischen Vorgänge in Zyklen. Es gibt keinen beschleunigten Klimawandel (siehe oben und folgende Abbildung). Die Konzentration des CO2 hat sich gemäß direkten Messungen um ca. 2,6 % seit 1826 erhöht. Dies liegt innerhalb der Fehlergrenze und somit im natürlichen Rauschen (Beck E.G., Reconstruction of atmospheric CO2 Background levels since 1826, unpublished manuscript; ww.realCO2.de). Der vorindustrielle CO2-Wert lag deutlich höher, als das IPCC dies angibt und war wesentlich volatiler, wie aus dem Bericht der amerikanischen Akademie der Wissenschaft zu entnehmen ist, dortige Figur 2 (http://www.ncbi.nlm.nih.gov/pmc/articles/PMC129389/).

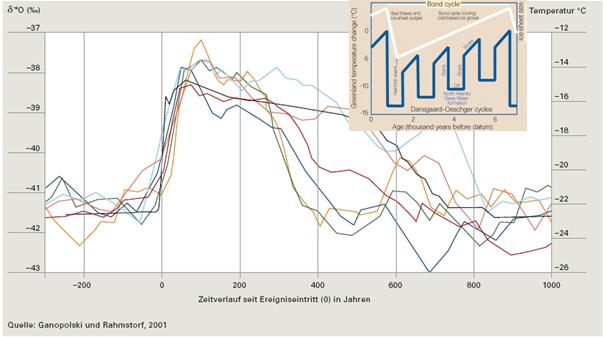

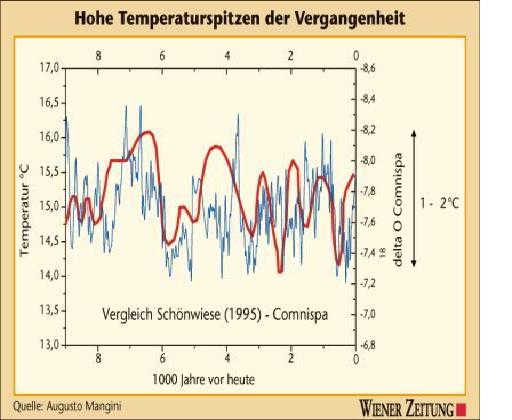

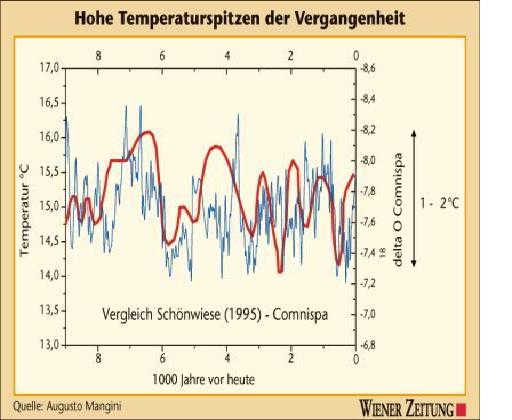

Prof. Augusto Mangini (Universität Heidelberg) hat in Zusammenarbeit mit Prof. Spötl von der Universität Innsbruck Stalagmiten der Spannagel-Höhle (Tirol) ausgewertet. Mittels weiterer Proxys (13C, Strontium, Barium, Yttrium, Blei, Schwefel, sowie ins Meer gespülte Sedimente) hat das Forscherteam seine Temperaturreihen abgesichert, so dass aus Sicht von Mangini et al. die Temperaturwerte (blaue Kurve) genauer, als mit Vergleichsmethoden (rote Kurve) angegeben werden konnte, Quelle: Wiener Zeitung vom 19.04.2009. Es fällt auf, dass die Temperaturwerte sehr viel variabler sind, als vom IPCC ausgewiesen. So stiegt im 4. Jahrhundert nChr. die Temperatur um 1,6°C in 120 Jahren. Hierzu ist der heutige Temperaturanstieg von 0,7°C im 20. Jahrhundert (der teilweise noch gefälscht ist) vergleichsweise gering.

Fazit: Wissenschaft ist die Lehre der Exaktheit! Marotzke, Rahmstorf und Schellnhuber sind dieser Maxime offensichtlich nicht verpflichtet und betätigen sich lieber als Vermutungswissenschaftler, deren Thesen mit schriller Propaganda und immer phantastischeren Horrorszenarien zum Sieg verholfen werden soll. Wir möchten den o.g. Professoren deshalb die Aussage eines gestandenen und seriösen Wissenschaftlers, Herrn Prof. Dr. John S. Mattick, der in Spektrum der Wissenschaft 03/05 (in einem anderen Zusammenhang, die Aussage aber umso passender beim Klimaspektakel) folgende Worte fand, zum Nachdenken entgegen und mit auf den Weg geben:

“Unbewiesene Annahmen entwickeln manchmal ein Eigenleben, was besonders in der Naturwissenschaft unangenehme Folgen haben kann. Am Anfang geht es gewöhnlich nur um eine plausible oder einfache Erklärung der Befunde. Wenn sie keine offensichtlichen Mängel aufweist und ihr Wahrheitsgehalt nicht unmittelbar überprüfbar ist, mutiert sie aber oft zum Glaubenssatz. Neue Beobachtungen werden dann passend interpretiert. Irgendwann aber muss das Dogma unter der Last eklatanter Widersprüche zusammenbrechen.“

Zusammengetragen von Dipl.-Ing. Michael Limburg, Dipl.-Biologe Ernst Georg Beck, Dipl.-Ing. Raimund Leistenschneider – EIKE