Welche Rolle spielen Treibhausgase ?- Teil 1

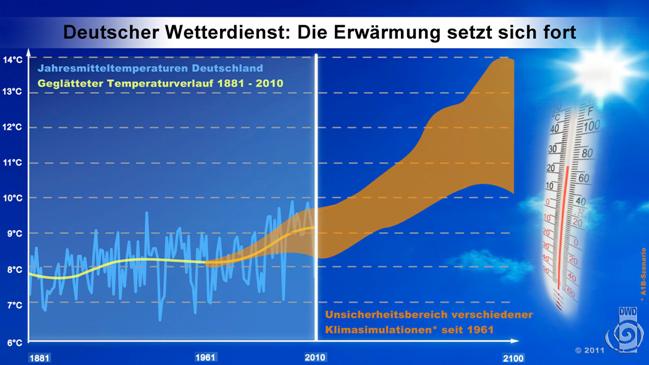

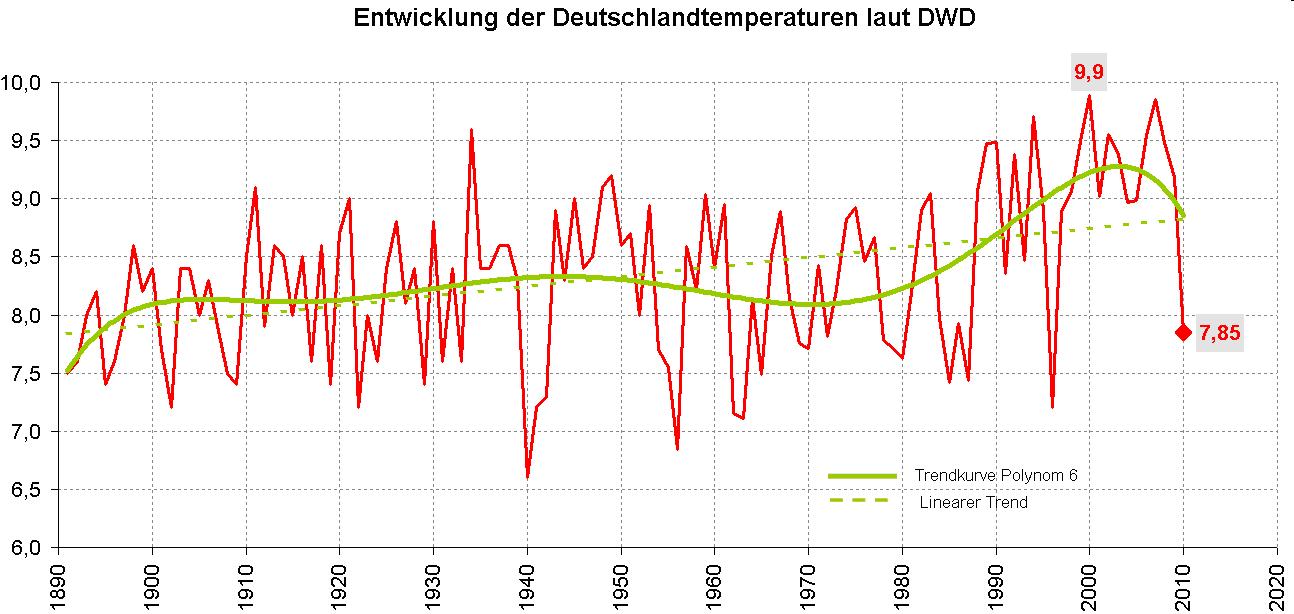

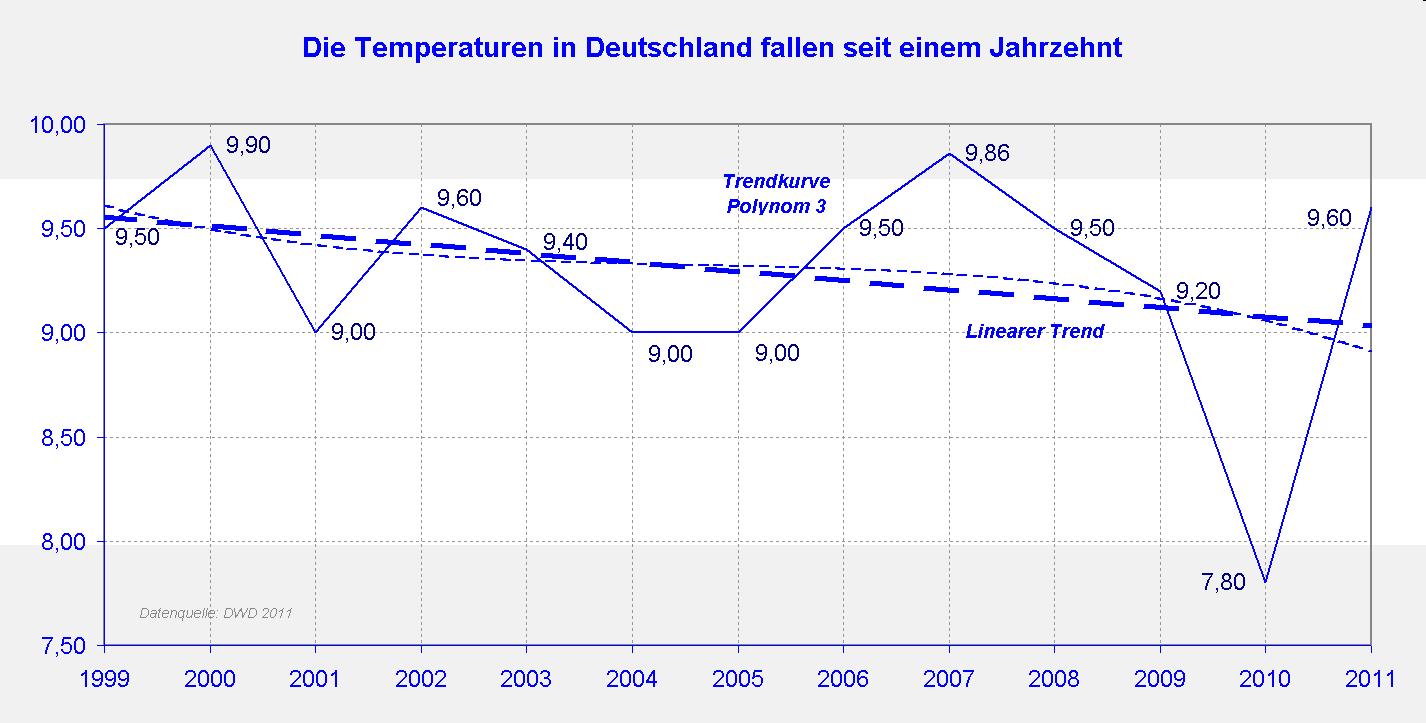

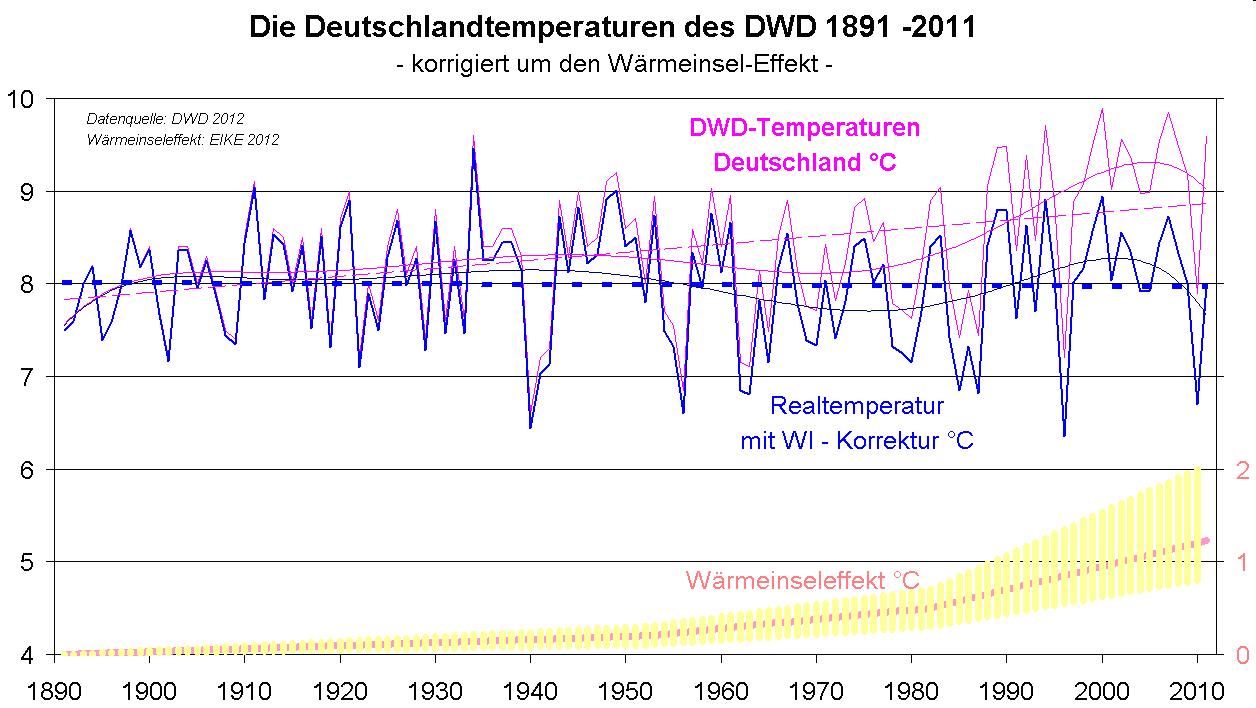

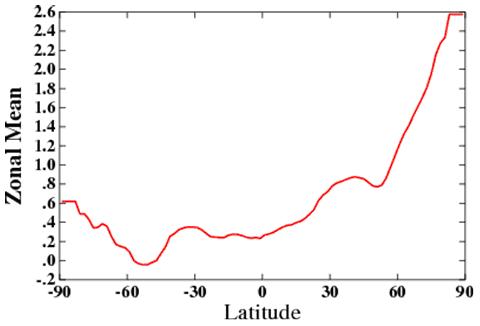

Seit gut 20 Jahren erzählen das IPCC und deren Anhänger, Treibhausgase (THG), die wir Menschen ausbringen, würden den Temperaturgang maßgeblich beeinflussen und damit das Klima auf der Erde steuern, weil Sonnenaktivität und Temperaturgang seit 30 Jahren auseinander laufen würden. Noch jüngst behauptete der Direktor des MPI-M, Prof. Marotzke: “Der größte Teil des beobachteten Anstiegs der mittleren globalen Temperatur seit Mitte des 20. Jahrhunderts ist sehr wahrscheinlich (Wahrscheinlichkeit höher als 90%) durch den beobachteten Anstieg der anthropogenen Treibhausgaskonzentrationen verursacht.“ Die Sonne kommt als Verursacher der Erwärmung nicht mehr vor und findet keine Erwähnung. Vielleicht sollte Herrn Prof. Marotzke eine Studienreise in die Sahara und zum Nordpol spendiert werden, um zu erfahren, welche Kraft in der Sonne steckt und welche Erwärmung von ihr ausgeht. Der folgende Artikel, der auch als Lernbeitrag in Meteorologie für Herrn Prof. Marotzke dient, wird zeigen, dass zur Erklärung des Temperaturgangs, sowohl der leichten Erwärmung bis zum Ende des 20. Jahrhunderts, als auch die seit 10 Jahren zu verzeichnete Abkühlung, keine THG notwendig sind, sondern die Sonne über die Hadley-Zellen und von dort über die globalen Windsysteme das Wetter und die Temperaturen bis in die Gegenwart allein steuert.

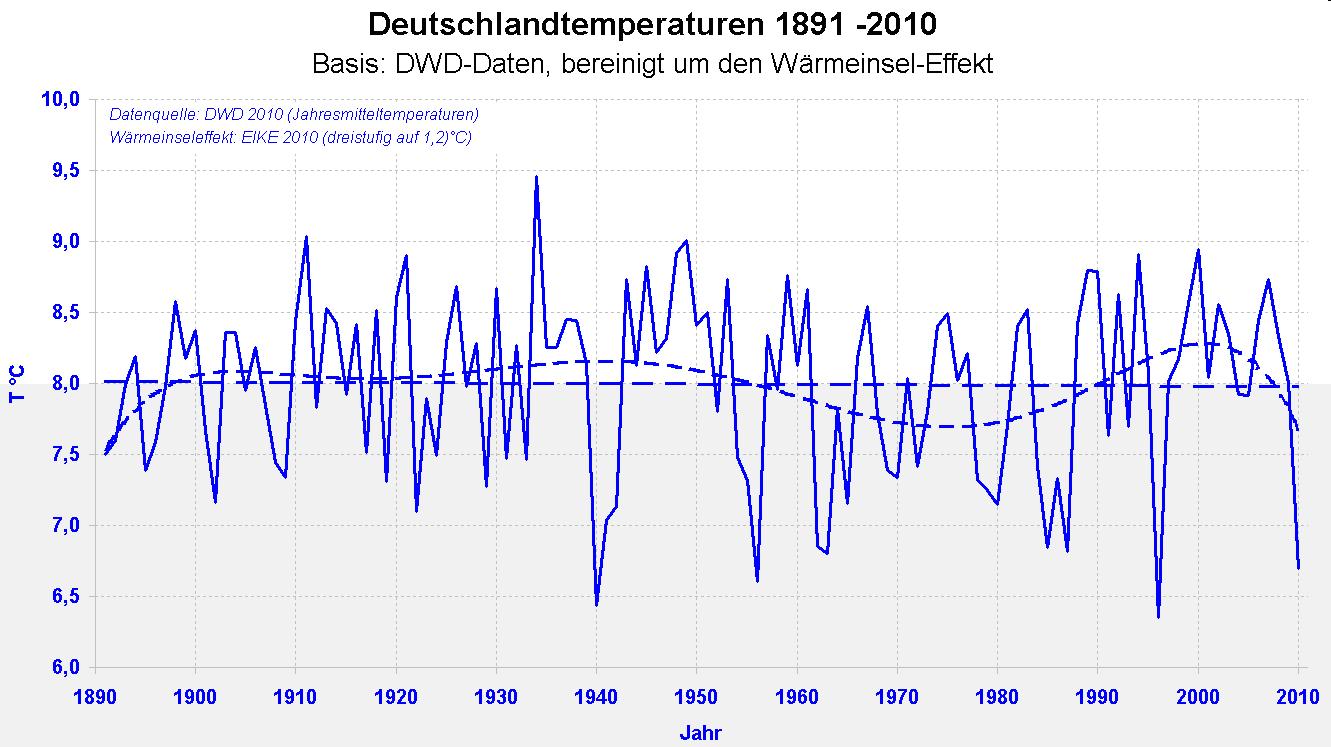

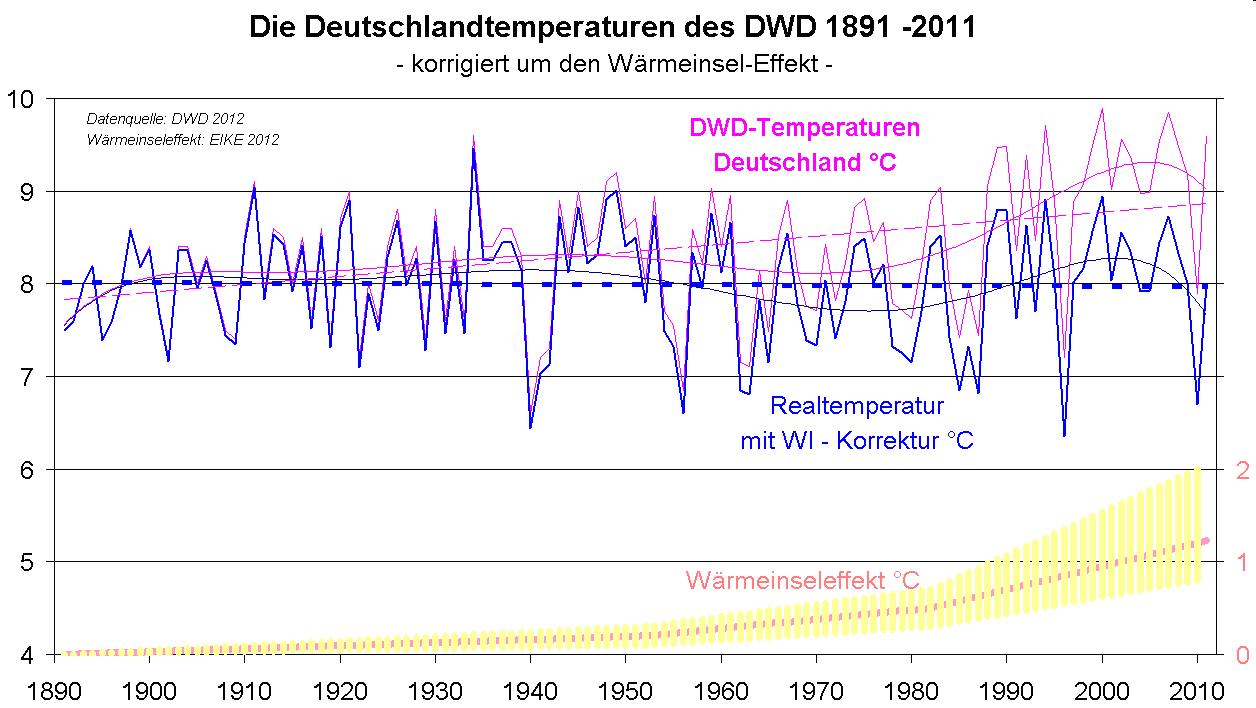

Teil 1: Manipulationen zur Aufrechterhaltung der behaupteten Rolle der THG und deren Aufdeckung – globaler Temperaturgang

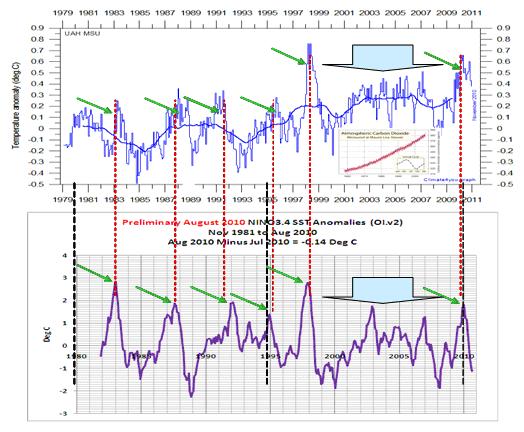

In seinem EIKE-Beitrag "La Niña und El Niño, was sich dahinter verbirgt und was sie, wann auslöst – Die Sonne ist an allem schuld" vom 24.01.2011 (http://www.eike-klima-energie.eu/climategate-anzeige/la-nina-und-el-nino-was-sich-dahinter-verbirgt-und-was-sie-wann-ausloest-die-sonne-ist-an-allem-schuld/) hatte der Autor folgende Abbildung gezeigt und textlich wie folgt hinterlegt.

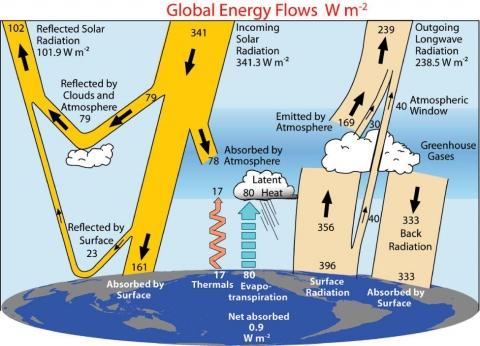

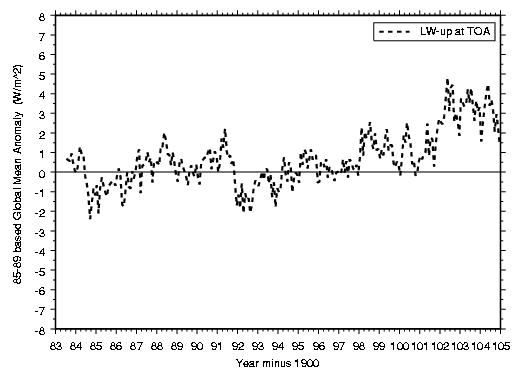

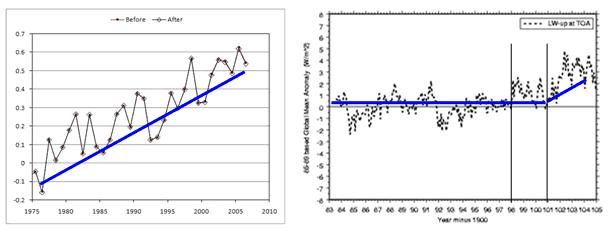

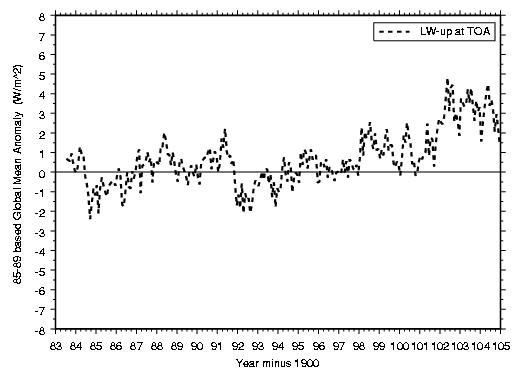

Abbildung 1 “zeigt die sich ändernde Strahlungsabgabe (Variabilität, TOP = Top Of Atmosphäre) der Erde im Zeitraum 1984 – 2005 aus Satellitensicht. Der Hub zwischen Min. – Max. beträgt 7 W/m2. Die Abbildung ist übrigens ein eindeutiger Beweis, dass die globalen Temperaturreihen, wie sie jüngst wieder medienwirksam veröffentlicht wurden und das Jahr 2010 als wärmstes ausweisen wollen, gefälscht sind, weil die Temperaturreihen nicht zur langwelligen Abstrahlung (Wärmeabstrahlung) der Erde, die sich aus ihrer Temperatur ergeben, passen. Siehe hierzu (http://www.eike-klima-energie.eu/klima-anzeige/waermstes-jahr-2010-flugverkehr-in-europa-festgefroren-lebt-die-un-organisation-wmo-auf-einem-anderen-planeten/?tx_ttnews[pointer]=1).“ Anmerkung: Dieser Beitrag zeigte, dass die Temperaturreihen 2010 der WMO auf Manipulationen beruhen.

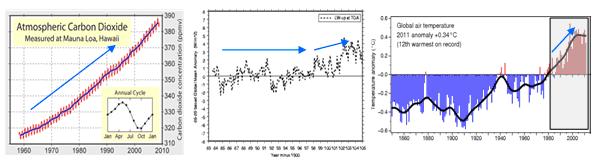

Da Abbildung 1 die sich ändernde Wärmeabstrahlung der Erde zeigt und nach Planck und Newton die Wärmeabstrahlung im direkten Zusammenhang zur Temperatur des abstrahlenden/abgebenden Körpers steht, zeigt die Abbildung, dass sie weder zum globalen Temperaturgang, noch zum globalen atmosphärischen CO2-Pegel passt (Abbildung 2).

Während sich die Abstrahlung der Erde und damit ihr Temperaturniveau von 1984 – 1997 in der Tendenz nicht ändern und erst ab 1997 – 2005 ansteigen, zeigt die Zeitreihe der globalen ermittelten (berechneten) Temperaturzeitreihe nach Jones, die als Grundlage der IPCC-Betrachtungen gilt, ab 1960 steil nach oben (Pfeil). THG als Erklärung scheiden von vorneherein aus, da diese nicht das volatile Verhalten, sprich die Schwankungen in der Abstrahlung erklären können. Dass es sich bei der Zeitreihe nach Jones um keine wahrheitsgemäße Wiedergabe des globalen Temperaturgangs handelt, dazu gleich mehr.

Anmerkung:

Ungeachtet der Trendverläufe muss erwähnt werden, dass globale Temperaturen generell nicht real sind – die Sahara-Temperaturen sind bekanntlich anders als die unsrigen – sondern statistisch berechnet werden, wozu komplexe Algorithmen (Formeln) verwendet werden. Wenn in diesem Artikel von Globaltemperaturen die Rede ist, so handelt es sich stets, wie auch beim IPCC, um statistisch ermittelte Werte.

Wenn die Abstrahlung der Erde als Maß ihrer Erwärmung, bzw. Abkühlung nicht dem vom IPCC ausgewiesenen globalem Temperaturgang folgt, durch was wird sie bestimmt? Die Antwort gibt Abbildung 3.

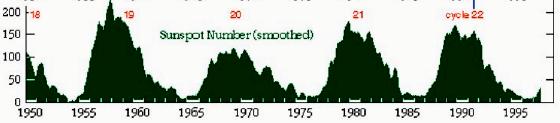

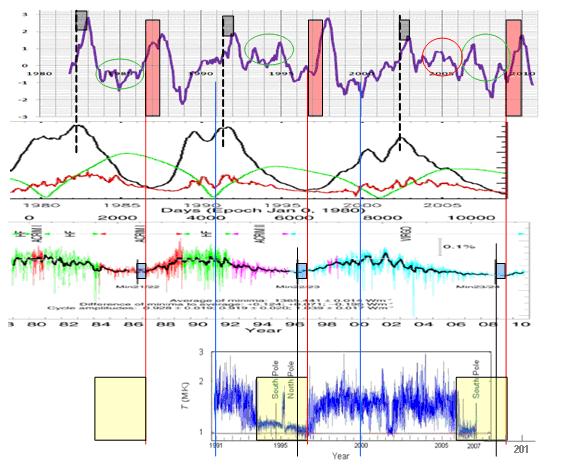

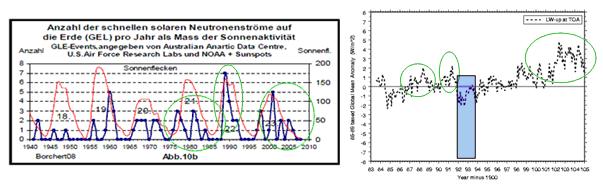

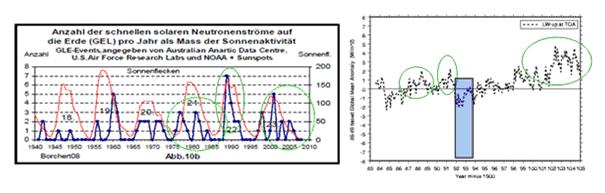

Abbildung 3 links zeigt die Häufigkeit der solaren Neutronenströme pro Jahr als Maß solarer Aktivität, Quelle: Dr. Borchert (Uni Mainz), “Klima, Sonnenflecken und kosmische Strahlung“. Deutlich ist das gleiche Muster (Fingerabdruck, grüne Kreise) zu erkennen. Weiter ist sehr transparent zu sehen, wie der Ausbruch des Pinatubo in 1991 (blauer Balken), der die Erdtemperaturen für ca. 2 Jahre um bis zu 0,8°C senkte, die langwellige Erdabstrahlung (abhängig von der Temperatur) ebenfalls ins "Minus" lenkt, obwohl die Neutronenströme und damit die solare Aktivität hoch ist. Bereits Abbildung 3 gibt die entscheidenden Hinweise, was die Wärmeabstrahlung der Erde und damit ihr Temperaturniveau steuert.

Abbildung 3 links zeigt die Häufigkeit der solaren Neutronenströme pro Jahr als Maß solarer Aktivität, Quelle: Dr. Borchert (Uni Mainz), “Klima, Sonnenflecken und kosmische Strahlung“. Deutlich ist das gleiche Muster (Fingerabdruck, grüne Kreise) zu erkennen. Weiter ist sehr transparent zu sehen, wie der Ausbruch des Pinatubo in 1991 (blauer Balken), der die Erdtemperaturen für ca. 2 Jahre um bis zu 0,8°C senkte, die langwellige Erdabstrahlung (abhängig von der Temperatur) ebenfalls ins "Minus" lenkt, obwohl die Neutronenströme und damit die solare Aktivität hoch ist. Bereits Abbildung 3 gibt die entscheidenden Hinweise, was die Wärmeabstrahlung der Erde und damit ihr Temperaturniveau steuert.

Fälschungen der Temperaturreihen haben eine lange Tradition.

Schon mehrfach wurde bekannt, dass weltweite Zuträger des IPCC die Temperaturganglinien passend machten. Die bekanntesten Beispiele sind der sog. Hockey-Stick von Prof. Mann und die “Tricks“ die angewendet wurden, das heutige Temperaturniveau als besonders hoch ausfallen zu lassen (Climategate – EIKE berichtete ausführlich darüber). Ein Beispiel zur Erinnerung. Die Daten aus Baumringen, die bis weit ins 20. Jahrhundert keine Erwärmung auswiesen, wurden einfach ab Anfang des 20. Jahrhunderts abgeschnitten und durch gemessene Werte ersetzt. Was auf den ersten Blick manchem vielleicht harmlos erscheinen mag oder gar korrekt, ist jedoch dreiste Fälschung, da aus einer Methodik zum ermitteln des Temperaturganges (Baumringe) nur die Werte genommen wurden, die zum gewünschten Ergebnis passen (niedrige vorindustrielle Werte) und die Werte, die nicht passten (niedrige industrielle Werte), durch passende Werte ersetzt wurden. Die Messreihe aus Baumringen, ging bis ca. 1980 und nur die daraus ermittelten Werte sind auch miteinander vergleichbar (!) und zeigten, wie gesagt, keine Erwärmung. Die ab 1900 angesetzten, gemessenen Werte sind nicht (!!) mit den Werten aus den Baumringen vergleichbar, da sie vollkommen anders ermittelt werden. So etwas wird Manipulation genannt. Prof. Mann ging noch dreister vor, indem er zum einen Datenauswahl und statistische „Tricks“ vornahm und zum anderen, Bäume (Proxys) auswählte, die nur eine Wachstumsperiode von 6-8 Wochen im Jahr haben und daher auch nur 6-8 Wochen von 52 Wochen die Temperatur „sehen“. An mindestens 44 Wochen im Jahr daher für eine Temperaturaussage „blind“ sind. Der Autor mag sich jetzt ein Wortspiel zum IPCC und deren Mitläufern verkneifen.

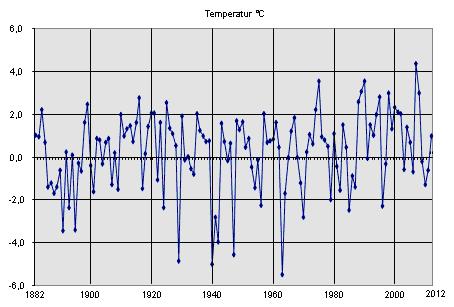

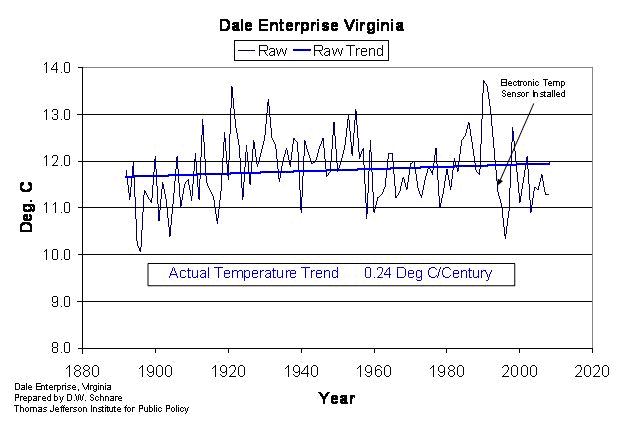

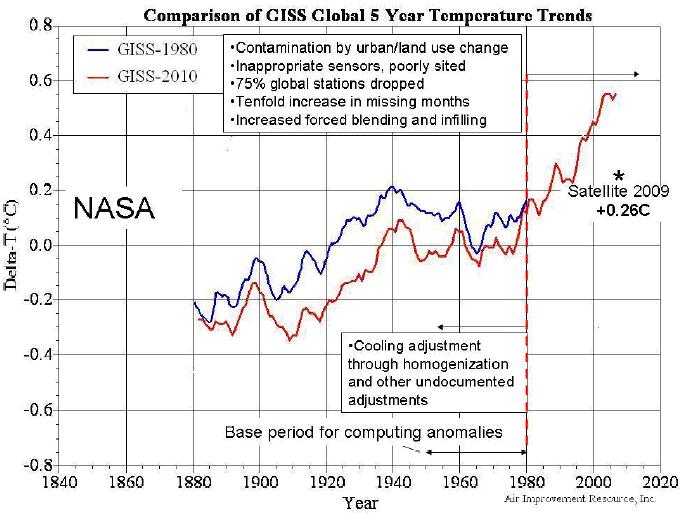

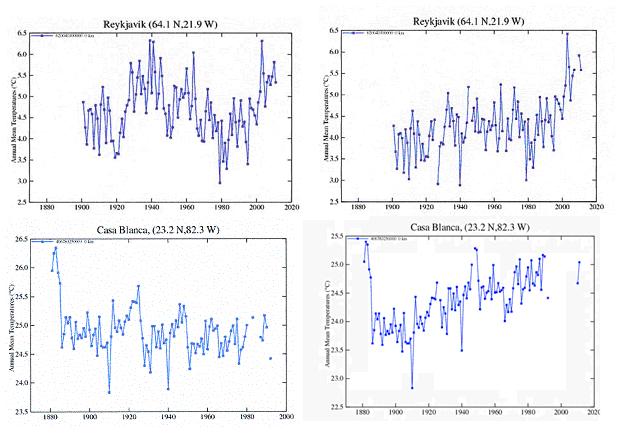

Dank Herrn Prof. Ewert wurde weiter bekannt, dass das GISS (Goddard Institute for Space Science) in Abwandlung, sich weiter dieser Fälschungsmethodik verschreibt: Die Werte, die für das gewünschte Ergebnis brauchbar sind, werden belassen und die, die unbrauchbar sind, entfernt. Prof. Ewert fasste dies in seiner Untersuchung, GISS „korrigiert“ seine Temperaturdaten, zusammen. Die Manipulation wurde vom GISS in 2011, also knapp zwei Jahre nach Climategate vorgenommen. Nun verwundert es nicht mehr, dass ich zu dem angeblich so warmen Jahr 2010 auf EIKE schrieb, dass die Aussage der WMO zur andauernden Erwärmung, nicht der Realität entspricht. Herr Prof. Ewert konnte anhand der Überprüfung von über 800 Messstationen, massive Fälschungen beim GISS nachweisen. Hier zwei Beispiele:

Abbildung 4, Quelle: Prof. Ewert. Nur zwei Beispiele, wie durch Datenmanipulation das GISS eine künstliche Erwärmung zaubert. Links die Werte, die noch 2010 ausgewiesen wurden, rechts der neu designte Temperaturgang der „Künstler“ der Global-Warming-Fraktion. Diese Erwärmung ist in der Tat menschen-gemacht! 2011, knapp zwei Jahre nach Climatgate: “Ist der Ruf erst ruiniert, regiert sich´s völlig ungeniert.“ Ein wohl jedem geläufiges Sprichwort.

Wir Naturforscher unter den Klimaforschern oder besser gesagt, unter den Klimatricksern, brauchen weder THG, Tricks, Manipulationen oder gar Fälschungen, noch Wahrscheinlichkeiten, um den Temperaturgang zu erklären. Hierzu reichen allein Naturbeobachtungen. Im Besonderen, die der Sonne und der globalen Wettersysteme.

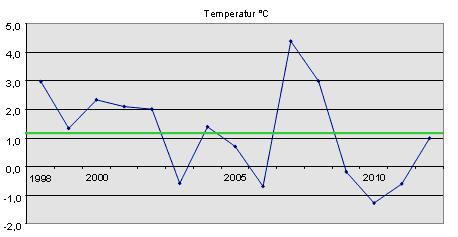

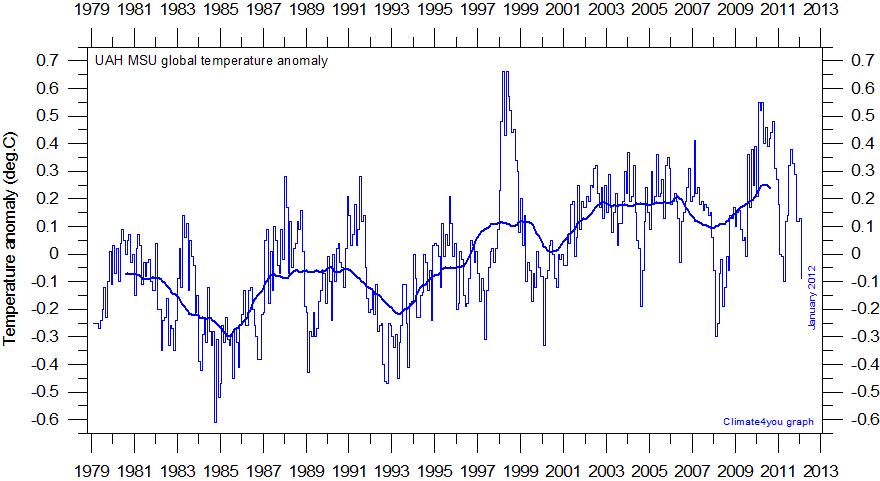

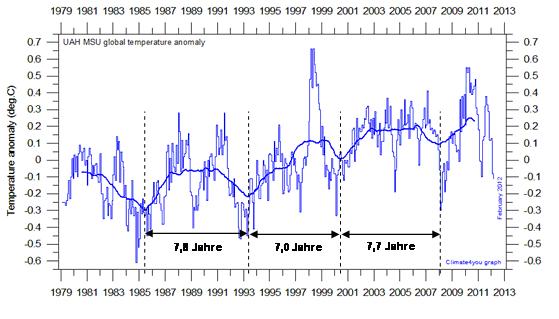

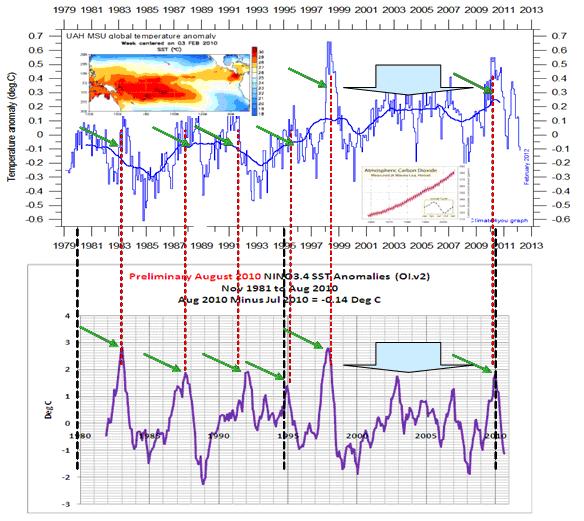

Abbildung 5 zeigt die gemittelte, globale Temperaturentwicklung im Zeitraum von 1979 – Januar 2012. Der geglättete Kurvenverlauf zeigt eine Wellenform mit einer Periode von im Mittel 7,5 Jahren (http://www.climate4you.com/GlobalTemperatures.htm). Dies spricht für einen natürlichen Einfluss. Um es vorweg zu nehmen, es ist der "Kleine-Landscheidt-Zyklus" der Sonne. Der Autor berichtete in seiner 8-teiligen EIKE-Reihe “Dynamisches Sonnensystem – die tatsächlichen Hintergründe des Klimawandels“ (Teil 3, Abbildung 43) darüber.

Abbildung 5 zeigt die gemittelte, globale Temperaturentwicklung im Zeitraum von 1979 – Januar 2012. Der geglättete Kurvenverlauf zeigt eine Wellenform mit einer Periode von im Mittel 7,5 Jahren (http://www.climate4you.com/GlobalTemperatures.htm). Dies spricht für einen natürlichen Einfluss. Um es vorweg zu nehmen, es ist der "Kleine-Landscheidt-Zyklus" der Sonne. Der Autor berichtete in seiner 8-teiligen EIKE-Reihe “Dynamisches Sonnensystem – die tatsächlichen Hintergründe des Klimawandels“ (Teil 3, Abbildung 43) darüber.

Weiter zeigte ich bereits am 24.01.2011 (http://www.eike-klima-energie.eu/climategate-anzeige/la-nina-und-el-nino-was-sich-dahinter-verbirgt-und-was-sie-wann-ausloest-die-sonne-ist-an-allem-schuld/), dass der globale Temperaturgang El Niño-Ereignissen unmittelbar folgt und welche solaren Ereignisse diese, wann auslösen. Dazu habe ich den Zeitraum betrachtet, der angeblich von der Sonnenaktivität abgekoppelt sein soll.

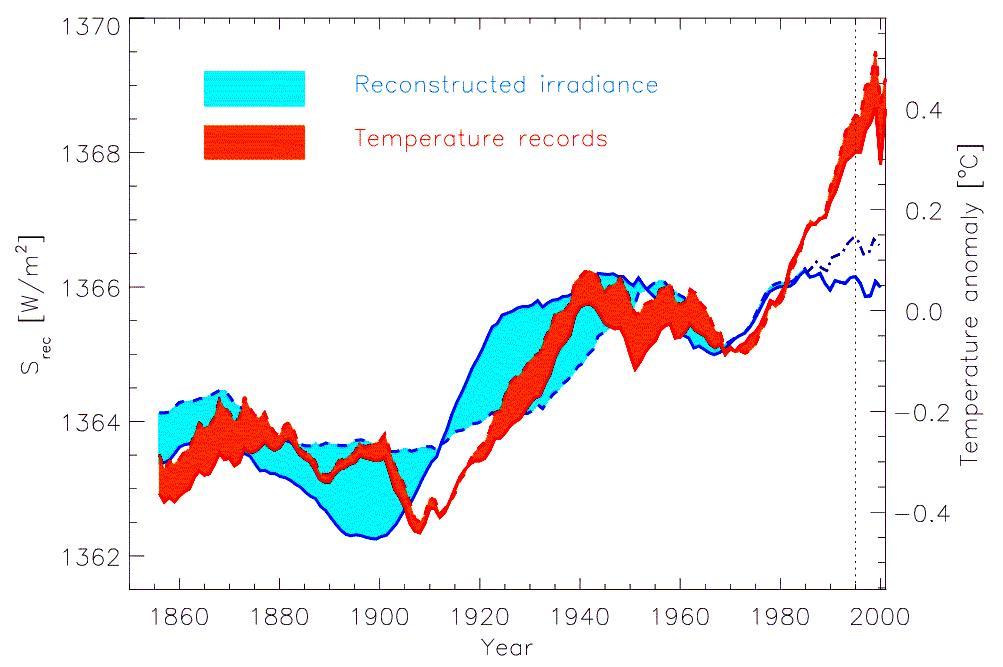

Abbildung 6 zeigt nach Solanki et al., dass anhand des TSI (Total Solar Irradiance) ab ca. 1980 Sonnenaktivität und globaler Temperaturgang (rot) auseinanderlaufen würden.

Abbildung 6 zeigt nach Solanki et al., dass anhand des TSI (Total Solar Irradiance) ab ca. 1980 Sonnenaktivität und globaler Temperaturgang (rot) auseinanderlaufen würden.

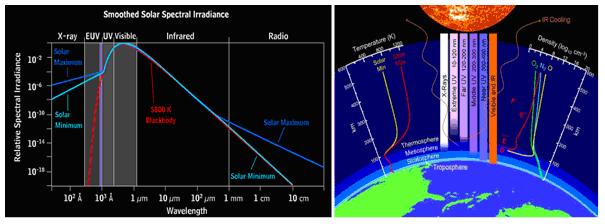

Nun ist der TSI grundsätzlich ungeeignet, eine Aussage über die solare Aktivität anzugeben. Dies mag auf den ersten Blick verwundern, da der TSI doch auch von Satelliten gemessen wird. Die Lösung ist jedoch denkbar einfach. Die Satelliten können nur das aufnehmen, wofür das Messgerät ausgelegt ist und die Messgeräte der Satelliten nehmen nur den Wellenlängenbereich zwischen 200 nm und 2.000 nm auf. Also nur einen kleinen Energiespektralbereich der Sonne. Dies ist der Teil, der auf die Erdoberfläche gelangt. Will man heutige, gemessene Werte des TSI mit rekonstruierten vergleichen, so bietet sich diese Vorgehensweise an, da der Proxy, der sich logischerweise auf der Erde befindet, natürlich auch nur den Teil der Sonnenaktivität sieht, der auf die Erdoberfläche gelangt. Nun ist das Wetter bekanntlich der Teil aus dem sich das Klima zusammen setzt und das Wetter wird nun einmal nicht auf der Erdoberfläche „gemacht“, sondern in der Tropo- und Stratosphäre und dorthin gelangt ein größeres Energiespektrum der Sonne. Von den indirekten Einsflüssen der Sonne auf die Erde (Wolkenbedeckung = Svensmark-Effekt) ganz zu schweigen. Der TSI blendet darüber hinaus gerade die Energiespektren aus der Sonne aus, die besonders variabel sind. So ändert sich der TSI über den Sonnenzyklus (Schwabe-Zyklus) kaum – nur 0,1 bis 0,2%. Beim UV-Anteil ist dies bereits gänzlich anders. Er ändert sich um bis zu 35% und beim Röntgenanteil, aus dem auf die indirekten Einflüsse der Sonne auf die Wolkenbedeckung geschlossen werden kann, um das 100-fache! Abbildung 7 zeigt das Sonnenspektrum und seine Reichweite in die Erdatmosphäre.

Abbildung 7 links zeigt das Sonnenspektrum nach Daten des High Altitude Observatory am NCAR (National Center for Atmospheric Research) und rechts, neben den Temperatur- und Dichtegradienten der Erdatmosphäre, die wirksamen Wellenlängenbereiche der Sonnenstrahlung und deren Eindringtiefe in die Atmosphäre, Quelle: (http://www.physorg.com/news198429352.html).

Abbildung 7 links zeigt das Sonnenspektrum nach Daten des High Altitude Observatory am NCAR (National Center for Atmospheric Research) und rechts, neben den Temperatur- und Dichtegradienten der Erdatmosphäre, die wirksamen Wellenlängenbereiche der Sonnenstrahlung und deren Eindringtiefe in die Atmosphäre, Quelle: (http://www.physorg.com/news198429352.html).

Von „Total“ kann also beim TSI keine Rede sein. Sein Wording ist demnach eine bewusste Mogelpackung. Soll die ganze Sonnenaktivität betrachtet werden, müssen andere Parameter ausgewertet werden. Einer davon ist die Korona, also die Sonnenatmosphäre. Diese zeigt im Aktivitätszyklus der Sonne interessante Eigenschaften. So springt sie plötzlich auf ihren nahezu doppelten Temperaturwert (Abbildung 9). Da die Korona der Teil der Sonne ist, der über den Sonnenwind direkt mit der Erde verbunden ist, liegt es nahe, sie mit dem Wettergeschehen der Erde in Relation zu setzen.

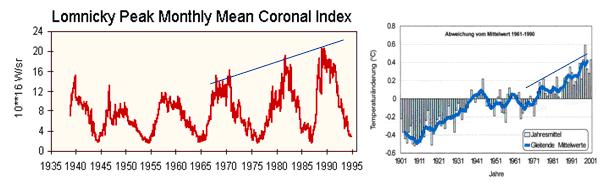

Abbildung 8 links (Quelle: http://www.ngdc.noaa.gov/stp/SOLAR/solarda3.html) zeigt die gesamte Strahlungsleistung der Korona von 1938 – 1995 in W/sr, mit r = 2.800 MHz Radio flux. Deutlich ist zu sehen, dass parallel zum (leichten) Temperaturanstieg auf der Erde, die Strahlungsleistung der Korona stark (ca. 25%) ansteigt. Der TSI-Wellenlängenbereich bildet die Koronatemperatur und damit ihr Energiespektrum gar nicht ab. Die NASA beweist damit, dass die Sonne bis zum ausgehenden 20. Jahrhundert immer aktiver wurde. Die rechte Abbildung zeigt die fragwürdige globale Temperaturentwicklung nach Jones. In der Satelliten-gestützen Zeitreihe aus Abbildung 5 ist der Anstieg in der Temperatur im Betrachtungszeitraum von 1979 – 1995 ebenfalls vorhanden, jedoch moderater.

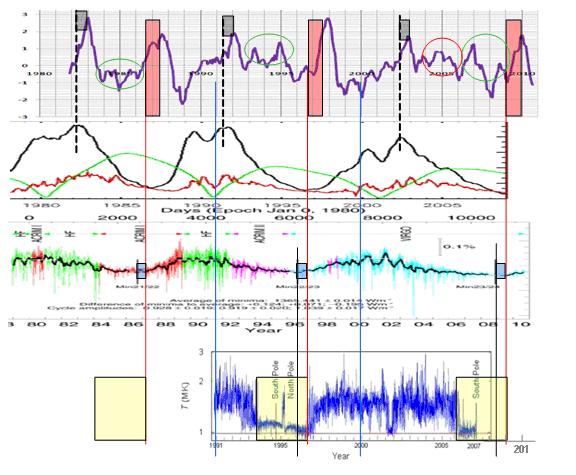

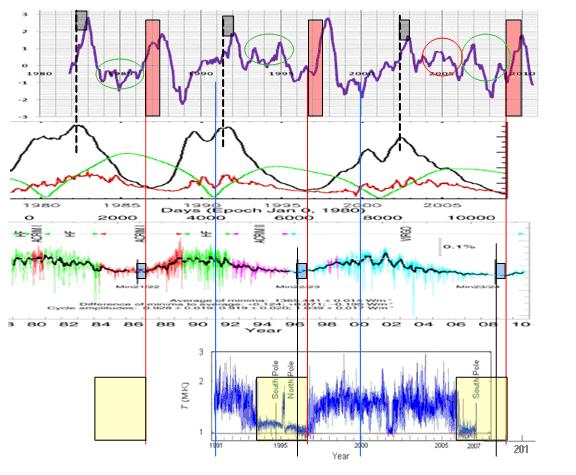

Abbildung 9 unten zeigt die sich ändernde Koronatemperatur der Sonne. Deutlich zu sehen, dass nach dem Einschalten der Koronazusatzheizung (wenn die Koronatemperatur auf nahezu ihren doppelten Wert „springt“) ein El Niño ausgelöst wird und zwar innerhalb eines festen Zeitraumes und weiter, nach ca. 11 Monaten der El Niño sein Maximum erreicht. Das blaue Rechteck gibt den Zeitpunkt an, ab wann nach einem Sonnenminimum im Schwabe-Zyklus, die Koronatemperatur auf nahezu ihren doppelten Wert (ca. 2 Millionen Kelvin springt). Da die Koronatemperatur nur aus dem Weltraum aufnehmbar ist und kontinuierliche Daten deshalb erst seit gut 20 Jahren vorliegen, wurden ihre „Schaltpunkte“ rekonstruiert. Dabei wurden die Zeitabstände (blaue und grüne Rechtecke) exakt beibehalten und betrachtet, ob diese mit weiteren El Nino-Ereignissen zusammen fallen. Dies ist eindeutig der Fall und zwar nach exakten Zeiten (!) 11 Monate, nachdem sich die Temperatur der Korona verdoppelte, erreicht ein starker El Niño sein Maximum.

Abbildung 9 unten zeigt die sich ändernde Koronatemperatur der Sonne. Deutlich zu sehen, dass nach dem Einschalten der Koronazusatzheizung (wenn die Koronatemperatur auf nahezu ihren doppelten Wert „springt“) ein El Niño ausgelöst wird und zwar innerhalb eines festen Zeitraumes und weiter, nach ca. 11 Monaten der El Niño sein Maximum erreicht. Das blaue Rechteck gibt den Zeitpunkt an, ab wann nach einem Sonnenminimum im Schwabe-Zyklus, die Koronatemperatur auf nahezu ihren doppelten Wert (ca. 2 Millionen Kelvin springt). Da die Koronatemperatur nur aus dem Weltraum aufnehmbar ist und kontinuierliche Daten deshalb erst seit gut 20 Jahren vorliegen, wurden ihre „Schaltpunkte“ rekonstruiert. Dabei wurden die Zeitabstände (blaue und grüne Rechtecke) exakt beibehalten und betrachtet, ob diese mit weiteren El Nino-Ereignissen zusammen fallen. Dies ist eindeutig der Fall und zwar nach exakten Zeiten (!) 11 Monate, nachdem sich die Temperatur der Korona verdoppelte, erreicht ein starker El Niño sein Maximum.

Jedoch zeigt die El Niño 3.4-Reihe, dass im betrachteten Zeitraum, in dem laut IPCC-Anhängern, die Erdtemperaturen von der solaren Aktivität abgekoppelt sein sollen, noch mehr El Niño-Ereignisse stattfanden. Demnach muss es noch eine weitere solare Aktivität geben, die auf der Erde einen El Niño auslöst. Die Antwort, um welche solare Aktivität es sich handelt, gibt die Abbildung 10. Es ist die unmittelbare magnetische Aktivität der Sonne. Ihr solares magnetische Maximum.

Abbildung 10 zeigt nochmals die Abbildung 9. Darüber hinaus die magnetische solare Aktivität (zweite Datenreihe von oben, Quelle: Max Planck Gesellschaft http://www.mps.mpg.de/projects/solar-mhd/research_new.html). Wie unschwer festzustellen, wird nach jedem Maximum im Schwabe-Zyklus ebenfalls ein El Niño-Ereignis ausgelöst. Auch hier wird das Maximum im El Niño-Ereignis nach einer exakt festen Zeitspanne erreicht (graue Rechtecke).

Bleibt noch die Frage zu beantworten, was die grün und rot umrundeten schwächeren El-Niño-Ereignisse auslöst. Die Antwort für das rot-umrundete in 2005 lässt der Autor die NASA und zwar deren Sonnenforscher David Hathaway vom September 2005 geben: “http://science.nasa.gov/headlines/y2005/15sep_solarminexplodes.htm)

Die Antwort für die grün umrundeten gibt bereits die Datenreihe von der Max Planck Gesellschaft und zwar die grüne Datenreihe, die das magnetische Polarfeld der Sonne zeigt. Der Autor möchte Ihnen dieses anhand der Sonnenwindaktivität weiter belegen (Abbildung 11).

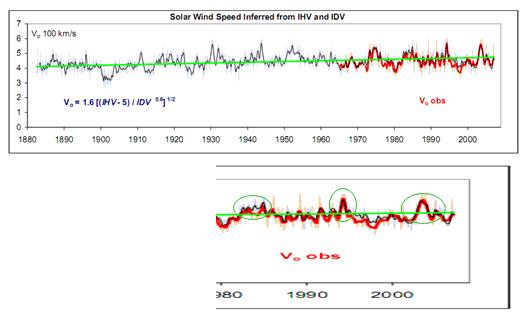

Abbildung 11 (Quelle: http://www.leif.org/research/files.htm) zeigt den 27-Tage-Durchschnitt der Sonnenwindgeschwindigkeit in 100 km/s von 1880 – 2009, nach Leif Svalgaard. Blau, aus dem IHV (Inter-Hour Variability-Index) und IDV (Inter Diurnal Variability) rekonstruiert, rot sind direkt gemessene Werte. Nun muss man wissen, dass der schnelle Sonnenwind entweder aus dem Nonaxisymmetric Open Flux, dort von starker solarer magnetischer Aktivität (z.B. ño-Datenreihe verglichen, so ist Übereinstimmung festzustellen.

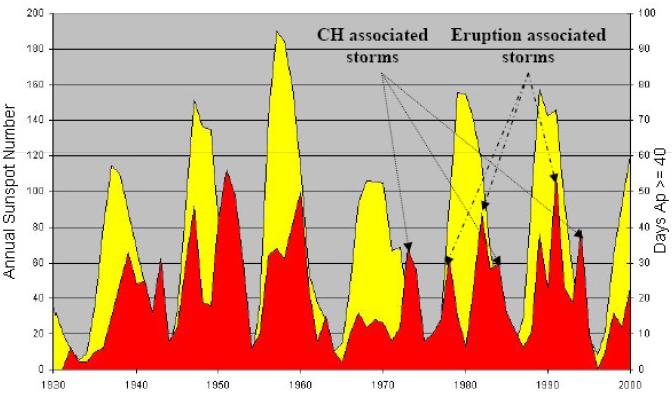

Das Max Planck-Institut für Sonnensystemforschung (MPS) nennt die Polfeldaktivität Coronal Hole associated storms (“Physikalische Grundlagen des Weltraumwetters – Der Sonnenwind“), Abbildung 12.

Abbildung 12 zeigt die solare magnetische Aktivität im Zeitraum von 1930 – 2000 (Quelle: MPS).

Abschließend ist festzuhalten, dass El Niño-Ereignisse durch drei solare Ereignisse unmittelbar ausgelöst werden:

1) Dem Einschalten der Koronaturboheizung, wenn deren Temperatur verdoppelt wird

2) Nach jedem Maximum im magnetischen solaren Zyklus.

3) Dem Polarfeld der Sonne (schwache El-Niño)

Was hat nun ein im Pazifik stattfindendes El Niño-Ereignis mit den globalen Temperaturen zu tun? Wie Abbildung 13 zeigt, sehr viel, um nicht zu sagen, so gut wie alles. Warum dies so ist, gleich mehr.

Abbildung 13 zeigt nochmals den in Abbildung 5 gezeigten gemittelten, globalen Temperaturgang und dazu den El Niño 3.4, wie er von der NOAA (amerikanische Wetterbehörde) für La Niña/El Niño-Ereignisse verwendet wird. Deutlich ist zu sehen, dass jedes El Niño-Ereignis exakt mit den positiven Ausschlägen (Erwärmungsphasen) in der globalen Temperatur übereinstimmt. Das Gleiche gilt im umgekehrten Fall für seine Schwester La Niña.

Abbildung 13 zeigt nochmals den in Abbildung 5 gezeigten gemittelten, globalen Temperaturgang und dazu den El Niño 3.4, wie er von der NOAA (amerikanische Wetterbehörde) für La Niña/El Niño-Ereignisse verwendet wird. Deutlich ist zu sehen, dass jedes El Niño-Ereignis exakt mit den positiven Ausschlägen (Erwärmungsphasen) in der globalen Temperatur übereinstimmt. Das Gleiche gilt im umgekehrten Fall für seine Schwester La Niña.

Im Teil 2 erfahren Sie, dass El Niño-Ereignisse auf der ganzen Erde Auswirkungen haben und warum dies so ist und, wie die solaren Aktivitätsschwankungen die Hadley-Zellen moderieren und wie dies Auswirkungen auf der ganzen Erde hat. Weiter werden dazu die Erklärungen gegeben, warum dies ist und aus physikalischen Grundgesetzen gar nicht anders sein kann. THG werden zur Erklärung einer Erwärmungs- oder Abkühlungsphase nicht benötigt, da sie erkennbar keine Rolle spielen. In der Naturbeobachtung treten sie nicht in Erscheinung, einzig in Computerspielen des PIK oder sonstiger, am Fördertropf hängender Institute.

Raimund Leistenschneider – EIKE

Zum Abschluss mochte ich unseren Lesern noch ein anschauliches Beispiel zukommen lassen, welches von einem Vorkämpfer der wissenschaftlichen Aufklärung in Sachen THE und THG stammt und den Autor erreichte. Das Beispiel zeigt anschaulich, dass es in der Physik und damit Realität keinen THE gibt, da der Boden die Atmosphäre erwärmt und nicht die Atmosphäre – die dortigen sog. THG – den Boden:

"Sehr geehrter Herr Leistenschneider,

besten Dank für Ihre Überlegungen. Darf ich als kleiner Wetterfrosch eine Anmerkung machen, denn als Frosch kann man nur überleben, wenn man die Natur genauestens beobachtet und daraus Schlüsse zieht.

Heute am 27. März hatten wir in Oppenheim (128 m über NN) folgende Temperaturwerte:

07 Uhr: 200 cm 8,4 °C, 20 cm 7,7°C und -5 cm (Bodentemperatur) 9,4°C

10 Uhr: 200 cm 10,6°C, 20 cm 11,6°C und -5 cm 9,9°C

12 Uhr. 200 cm 14,1°C, 20 cm 16,2°C und -5 cm 12,6°C

Um 7 Uhr betrug die Globalstrahlung 9,0, um 10 Uhr 386,0 und um 12 Uhr 1352,0 Wh/m2. Diese Werte nach klarer Nacht lassen nur einen Schluss zu: Einen Treibhauseffekt gibt es nicht!

Die Bodenoberfläche ist nachts die Kühlfläche und am Tage die Heizfläche für die aufliegende Luft. Die Energiequelle ist die Sonne. Sie strahlt aber nur am Tage, während die Erde rund um die Uhr strahlt!

Und nun noch der Nachmittag. Während die 200 cm Temp. Von 19,3°C um 16 Uhr noch auf 19,7°C um 17 Uhr stieg, sank die 20 cm Temp. von 20,7°C auf 20,6°C. Kurz vor 17 Uhr wurde die Ausstrahlung größer als die Einstrahlung, die Bildung einer Bodeninversion hatte begonnen.

Dies noch zur Abrundung! Jedenfalls für eine Gegenstrahlung kein Hinweis, geschweige denn ein Beweis!

Mit freundlichen Grüßen

Wolfgang Thüne

Teil 2 finden Sie hier

Der vollständige Beitrag ist im Anhang als pdf herunter ladbar