Starker Temperaturanstieg seit 1979 in Erfurt- warum CO2 dabei nur eine unbedeutende Nebenrolle spielt! Teil 1

Abstract

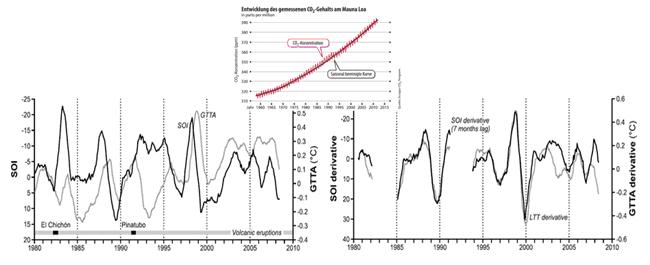

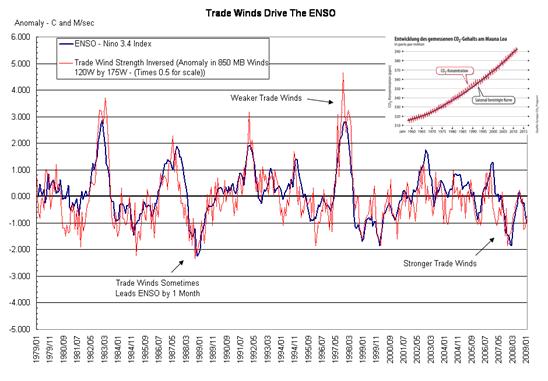

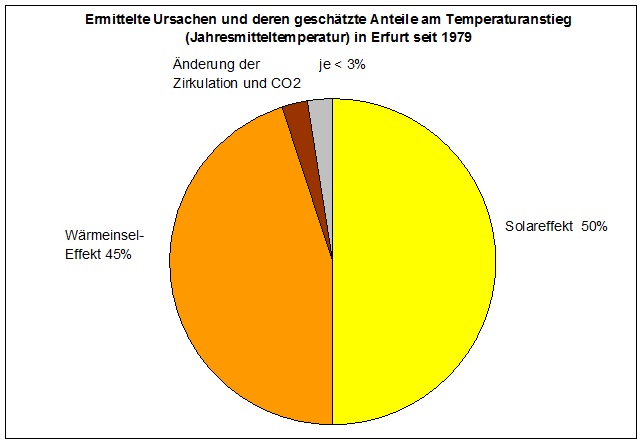

Die hier durchgeführte Untersuchung zu den Erwärmungsursachen anhand amtlicher Messwerte der DWD- Station Erfurt- Bindersleben verdeutlicht die Schwierigkeiten bei der Abschätzung möglicher Erwärmungseffekte. Es konnte jedoch gezeigt werden, dass allein etwa die Hälfte des seit 1979 in Erfurt beobachteten Temperaturanstiegs auf eine bloße Zunahme der Sonnenscheindauer zurückführen lässt. Wegen der Kopplung der Wettersysteme (El Niño), muss davon ausgegangen werden, dass der solare Einfluss noch größer ist.

Einen wesentlichen, aber noch weiter zu untersuchenden Teil von etwa 0,6K, hat auch der „Urbanisierungs- und Flächenhafte Wärmeinseleffekt“ beigetragen. Weiterhin deuten sich zumindest leichte Erwärmungseffekte durch Zirkulationsänderungen an, besonders im Frühjahr. Auch hierzu sind noch tiefere Untersuchungen notwendig. Möglicherweise tritt der Zirkulationseffekt dann deutlicher hervor.

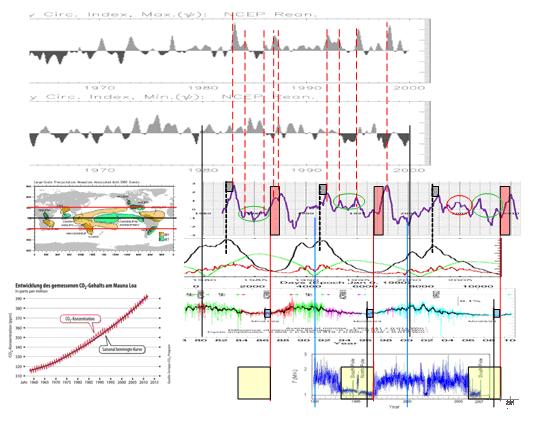

Anhand der gezeigten Korrelation am Langzeittrend, kann auch eine leichte Erwärmung durch „Treibhausgase“ nicht völlig ausgeschlossen werden. Deren Betrag fällt jedoch gegenüber den „Hauptakteuren“ Solar- und Wärmeinseleffekten sehr gering aus, sofern er überhaupt vorhanden ist, da keine Ursache-Wirkung besteht (Korrelation seit mehr als 10 Jahren divergierend, d.h. nicht vorhanden). So zeigt das folgende Diagramm die möglichen Einflüsse anhand der Korrelationsergebnisse. Es deutet grob an, wie sich die Erwärmung danach zusammensetzt. Außerdem sind weitere, hier nicht untersuchte scheinbare Erwärmungsursachen, wie etwa die Verfälschung der Tageswerte durch Umstellung auf stündliche Lufttemperaturmessungen seit 2001 und halbstündige seit 2009, nicht ausgeschlossen.

Teil 1: Vorstellung der Hauptakteure

Teil 2: „Trittbrettfahrer“ CO2 – Das Phantom der Klimawissenschaft

Teil 1 Vorstellung der Hauptakteure

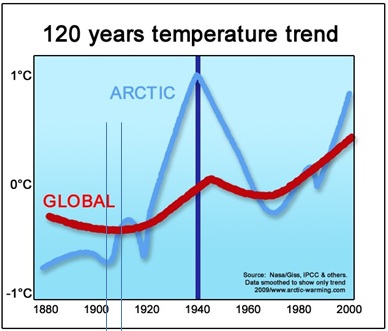

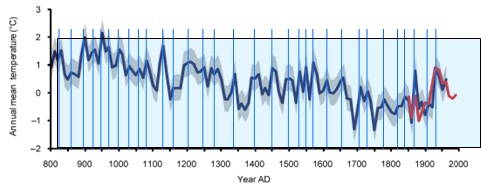

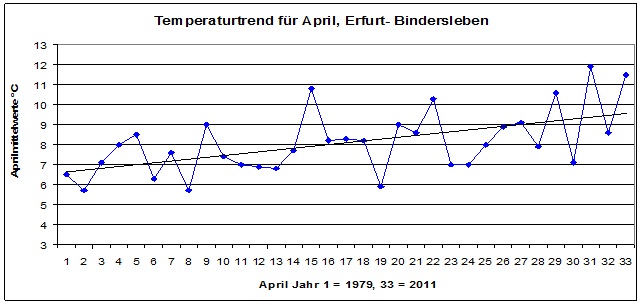

Seit 1979 sind die Lufttemperaturen in Erfurt um etwa 1,3°C beziehungsweise 1,3 Kelvin (K) gestiegen- in nur 33 Jahren um fast das Doppelte der angeblich seit etwa 150 Jahren stattfindenden „Erderwärmung“ von etwa 0,8K. Da lohnt es sich, einmal genauer hinzuschauen- schließlich könnte sich ja die „globale Erwärmung, angeblich durch CO2 verursacht“, in Thüringen viel schlimmer auswirken, als bislang angenommen. Es könnte aber auch alles ganz anders sein. Die folgende Arbeit erhebt keinen Anspruch auf Vollständigkeit und soll vor allem zum unvoreingenommenen Nachdenken über mögliche Erwärmungsursachen anregen.

Mehr Sonnenschein- Mehr Wärme!

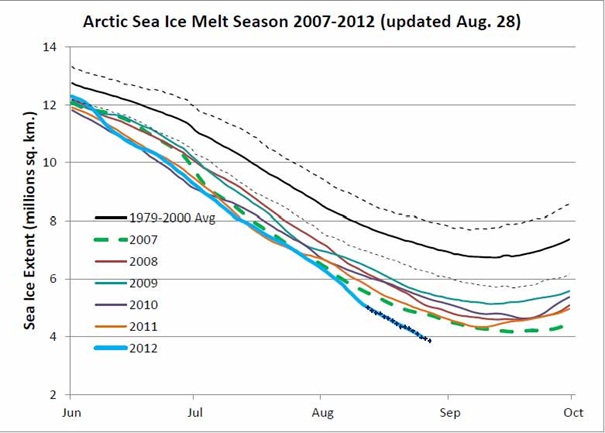

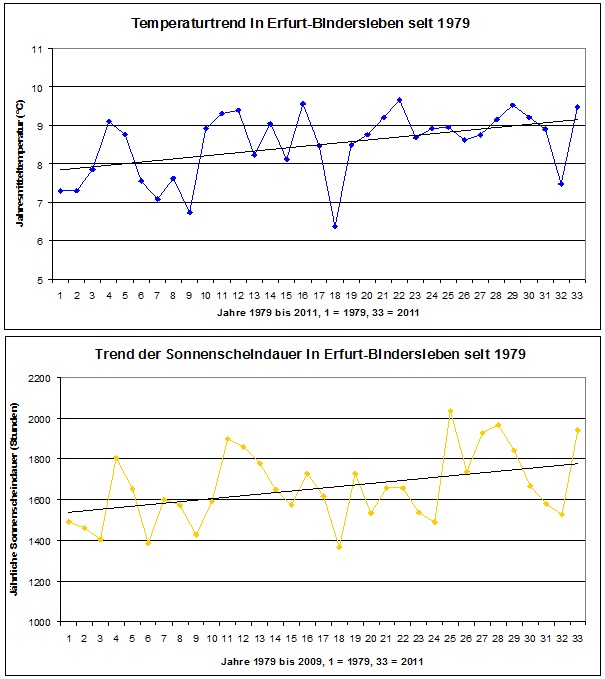

Die folgenden zwei Abbildungen zeigen den Temperaturtrend (oben) und den Trend der Sonnenscheindauer (unten).

Abbildung 2. Die Ähnlichkeit beider Verläufe ist unverkennbar. Die höhere Sonnenscheindauer wirkt erwärmend. Eine Korrelationsberechnung zwischen jährlicher Sonnenscheindauer und den Jahresmitteltemperaturen bestätigt diesen Verdacht (folgende Abbildung).

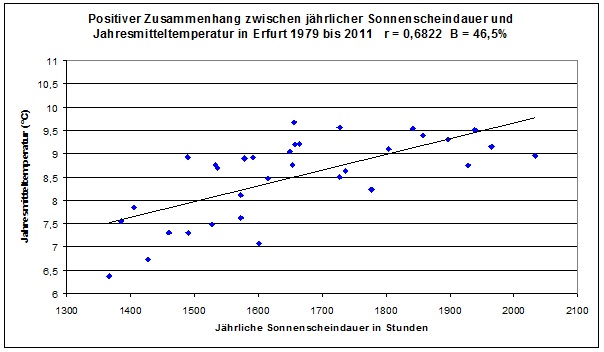

Abbildung 3

Das Bestimmtheitsmaß von fast 47% sagt aus, dass knapp 47 Prozent der Variabilität der Lufttemperaturen im Betrachtungszeitraum von der Variabilität der Sonnenscheindauer verursacht wurden. Anmerkung: Eine positive Korrelation ist für sich allein zwar kein eindeutiger Beweis für den Zusammenhang zwischen beiden Faktoren. Dass jedoch eine längere Sonnenscheindauer mehr Energiezufuhr bedeutet, welche die Erdoberfläche und über diese dann auch die unteren Luftschichten stärker erwärmt, dürfte niemand anzweifeln.

Erstes Ergebnis: Mehr Sonnenstunden, mehr Wärme. Etwa zur Hälfte lässt sich der Erwärmungstrend mit der seit 3 Jahrzehnten zunehmenden Sonnescheindauer erklären! Die Sonne scheint heute in Erfurt gut 200 Stunden länger pro Jahr, als noch Ende der 1970er Jahre, was in etwa der Sonnenscheindauer eines ganzen Sommermonats entspricht!

Untersuchungen anderer europäischer Stationen, unter anderem von Berlin- Dahlem, Potsdam, Horben (Schwarzwald), Observatorium Modena (Norditalien), sowie mehrerer Stationen aus der Schweiz, deuten in die gleiche Richtung. Seit etwa 2000 stagniert die Temperatur auf hohem Niveau.

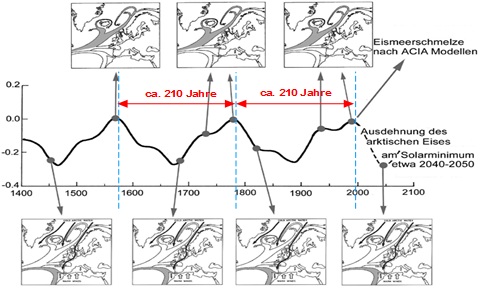

Dieser Erwärmungseffekt durch längere und intensivere Besonnung ist wegen strenger Umweltauflagen (Luftreinhaltemaßnahmen) in Europa besonders deutlich ausgefallen und ist eine Erklärung, warum die Temperaturen hier so viel stärker als im „globalen Mittel“ angestiegen sind. Seit mehr als 10 Jahren stagnieren sie jedoch auf hohem Niveau oder sinken gar wieder leicht, zumal die „Luftreinhalteeffekte“ weitgehend ausgereizt sind. Außerdem lässt die Sonnenaktivität, welche ebenfalls wesentliche Einflüsse auf die Sonnenscheindauer und die Intensität der Einstrahlung hat (z.B. „Svensmark- und Aerosoleffekte“) aktuell stark nach.

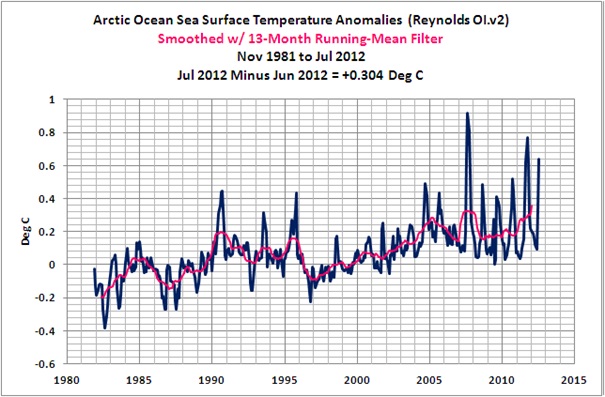

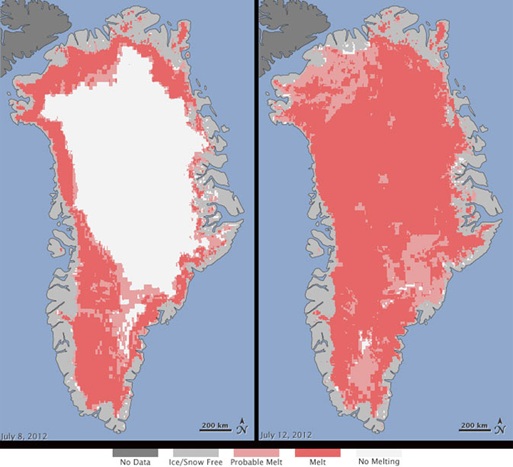

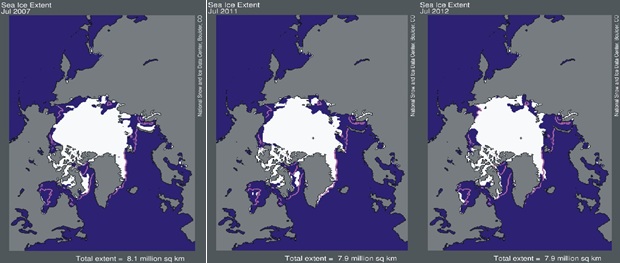

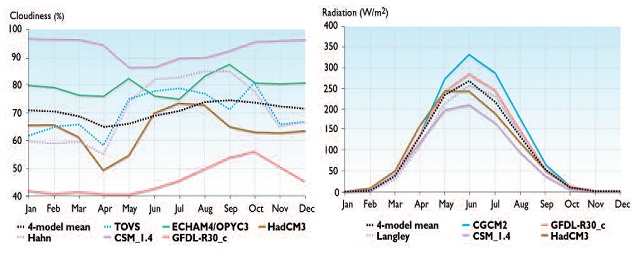

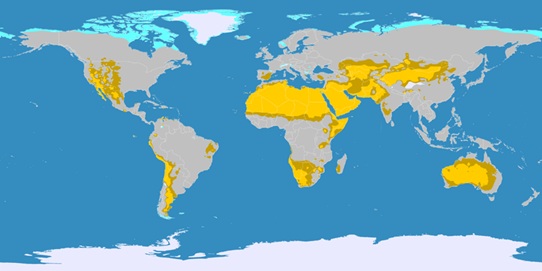

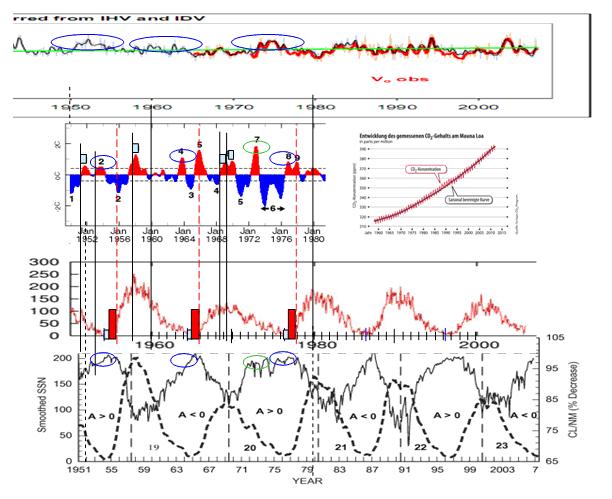

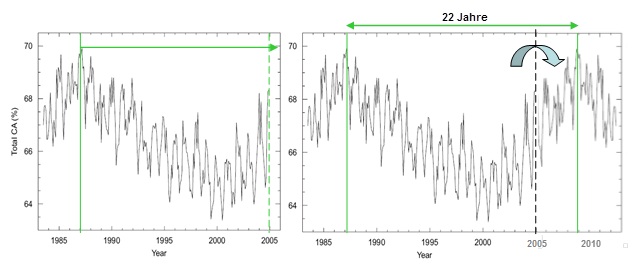

Die folgende Abbildung zeigt, wie sich die globale Wolkenbedeckung, also nicht nur die von Städten, seit Beginn des Erwärmungstrends änderte.

Abbildung 4 links zeigt die globale Wolkenbedeckung von Juli 1983 – Juni 2005, nach Daten des ISCCP (International Satellite Cloud Climatology Project). Die Abbildung stammt aus der Arbeit von Evan et al. “Arguments against a physical long-term trend in global ISCCP cloud Amounts“. Bereits die linke Abbildung deutet auf eine periodische Schwingung von größer 18 Jahren (grüner Pfeil) hin. Dass Kurvenminimum liegt im Maximum des 23. Schwabe- Zyklus im Jahr 2000. Rechts ist der Kurvenverlauf an der gestrichelten Linie gespiegelt und ab 2005 (Datenende) angesetzt. Dabei wurde darauf geachtet, dass das Verhältnis zwischen Anstieg und Rückgang im Schwabe-Zyklus etwa 2 zu 3 beträgt (die Anstiegszeit eines solaren Zyklus ist nicht exakt fix, sondern davon abhängig, wie stark der kommende Zyklus ist – starker Zyklus = schnelle Anstiegszeit, schwacher Zyklus = langsame Anstiegszeit, insofern stellt das Verhältnis 2 zu 3 einen Mittelwert dar). Das Maximum der globalen Bewölkung folgt in eindeutiger Weise vom Hale-Zyklus (Polaritätszyklus der Sonne) und damit der Polarität des magnetischen Sonnenzyklusses. Weitere Untersuchungen sind notwendig, den komplexen Einfluss der Sonne auf unser Wetter/Klima, hier der Wolkenbildung, besser zu verstehen und die obigen Erkenntnisse abzusichern. Denn der Einfluss der Wolken auf die Wetter- und damit Temperaturverhältnisse sind elementar.

Nach Angaben des DLR (Deutsches Zentrum für Luft- und Raumfahrt) bedeutet eine Reduzierung des mittleren Wolkenbedeckungsgrades von wenigen Prozent, bereits eine globale Temperaturänderung, die einer Verdoppelung des CO2-Gehaltes nach den Modellvorstellungen des IPCC entspricht. Im obigen Chart beträgt die Reduzierung des Wolkenbedeckungsgrades ca. 6% bis zum Jahr 2000.

Anmerkungen: Es ist zu erwarten, dass durch die etwa 60%ige Abnahme der Luftschadstoffe seit 1980 („Aerosol- Effekt“) und die hohe Sonnenaktivität um 1990, eben auch die Intensität der Sonnenstrahlung deutlich zunahm, was zusätzlich erwärmend wirkt, da mehr direkte Sonnenstrahlung mit einem höheren (energiereicheren) Blauanteil die Erdoberfläche trifft, was aber hier nicht zum Ausdruck kommt, da ja nur der Einfluss der Sonnenscheindauer, nicht aber deren Intensität, untersucht wurde. So ist noch ein zusätzlicher Erwärmungseffekt durch die höhere Intensität der Sonnenstrahlung selbst (in der Literatur als „Solar brightening“ = Aufhellung der Sonnenstrahlung) zu erwarten, der sich ohne Strahlungsmessungen am Standort Erfurt aber nicht quantifizieren lässt. Mit sinkenden Luftschadstoffgehalten nahmen auch Dauer und Häufigkeit von Nebel (und womöglich auch der Bedeckungsgrad mit Tiefen Wolken) deutlich ab.

Weiterhin muss erwähnt werden, dass die monatliche Sonnenscheindauer im Sommerhalbjahr mit Bestimmtheitsmaßen von 35 bis über 70% die Monatsmitteltemperaturen wesentlich stärker beeinflusst als im Winterhalbjahr mit Bestimmtheitsmaßen von nur 6 bis kaum 14%. Kurzum- mehr als zwei Drittel der vergangenen Erwärmung in den Sommermonaten lassen sich aus der Sonnenscheindauer erklären, während besonders für das Winterhalbjahr nach weiteren Ursachen gesucht werden muss.

Bedingt durch die anthropogene (menschliche) Veränderung der Beschaffenheit der Erdoberfläche gibt es verschiedene Erwärmungseffekte; am bekanntesten ist der städtische („urbane“) „Wärmeinseleffekt“ (im Englischen mit UHI = Urban Heat Island Effect abgekürzt). Siedlungen und Städte sind aus folgenden Gründen wärmer als ihr Umland; hier sollen nur die wichtigsten aufgezählt werden:

Es gibt direkte Wärmequellen, und zwar

Verbrennungsmotoren (Verkehr im weitesten Sinne).

Heizungen, Klimaanlagen und Kühlschränke.

Beleuchtung (besonders Glühlampen) und Widerstandsverluste im Stromnetz.

Kanalisation und Müll (die darin enthaltenen Mikroorganismen erzeugen Wärme).

Viele Menschen und Haustiere auf engstem Raum (jeder Mensch erzeugt durch seinen Stoffwechsel in etwa soviel Wärme wie eine 100- Watt- Glühbirne).

Mindestens genauso wichtig, vielleicht sogar wichtiger, sind indirekte Erwärmungseffekte:

Einschränkung der stark kühlend wirkenden Verdunstung durch Bodenversiegelungen (Pflaster, Asphalt, Beton) und Ableitung des Regenwassers aus der Stadt.

Fehlender oder geringerer Pflanzen- und Gehölzwuchs als im unbebauten Umland. Die Vegetation „kühlt“ durch Beschattung, durch Verdunstung sowie durch Aufnahme eines Teils der Sonnenenergie zur Photosynthese.

Die Stadt empfängt durch ihre höhere Rauhigkeit und besondere Bodenbeschaffenheit mehr Sonnenstrahlung als das Freiland (dunkler Asphalt, außerdem absorbieren Steildächer und senkrechte Hauswände besonders die Strahlung der tief stehenden Sonne, welche im Freiland kaum erwärmend wirkt). Besonders spätabends und nachts wirkt das deutlich erwärmend, weil die Baumaterialien dann die tagsüber gespeicherte Wärme an die Luft abgeben („Wärmespeicherkapazität der Straßen und Häuser).

Die Bebauung bremst den kühlend und belüftend wirkenden Wind. Ganz nebenbei: Wer Windräder aufstellt, um „das Klima zu schützen“ muss diesen Effekt ebenfalls in Kauf nehmen. Die Bremsung des Windes durch große „Windparks“ ist erheblich und trägt so ebenfalls zum Temperaturanstieg in Bodennähe auch außerhalb von Städten bei – willkommen in Absurdistan!

Horizonteinengungen und Mehrfachreflexionen behindern die nächtliche Ausstrahlung. Luftverschmutzungen (die berüchtigte „Dunstglocke“ aus Staub und Nebeltröpfchen) wirken nachts und daher besonders im Winterhalbjahr erwärmend, weil sie die Wärmeabstrahlung stärker zum Boden zurück reflektieren, als saubere Luft. Tagsüber mindern sie zwar die Intensität der Sonnenstrahlung und wirken dadurch kühlend, aber alle direkten, nur im urbanen Bereich konzentriert auftretenden Erwärmungsquellen können sie nicht überkompensieren.

Leider liegen zur genauen Entwicklung der Bebauung und Bodenversiegelung im Umfeld des Erfurter Flughafens keine genauen Angaben vor. Nach eigenen Beobachtungen nahmen diese besonders seit 1990 stark zu (mehr Flug- und Straßenverkehr, zahlreiche gewerbliche Neuansiedlungen und Wohnungsneubauten). Auch fehlen Messwerte einer vom Urbanisierungseffekt weniger beeinflussten Freilandstation, so dass man den Effekt der zunehmenden Verstädterung auf die Entwicklung der Temperaturen nur schwer ermitteln kann. Ein mögliches Verfahren zur Berechnung dieser Erwärmungseffekte hat einer der Autoren entwickelt und basiert auf dem Strahlungsgesetz nach Planck und dem Abkühlungsgesetz nach Newton.

Anhand dieser Berechnung beträgt der Urbanisierungs- und Flächenhafte Wärmeinseleffekt bei der vom DWD für Deutschland ausgewiesenen Erwärmung für die letzten 120 Jahre +1,1°C von +1,9°C, d.h. der größte Anteil der Erwärmung geht auf den WI zurück. Insbesondere in der ehemaligen DDR sind nach der Wende 1989/90 aus einstigen kleinen Wärmeinseln durch die Ausbreitung der Bebauung großflächige Wärmeregionen entstanden, und der Trend hält an. Das gilt auch für Erfurt. Die Wetterstation liegt heute am Flughafengelände Erfurt/Weimar, das nach der Wende erheblich erweitert wurde. Diese zusätzlichen erwärmenden Wirkungen der freien Fläche haben wir durch den Begriff flächenhafter Wärmeinseleffekt abgedeckt, den wir mit WI abkürzen.

Unsere Untersuchungen zeigen, dass im Schnitt der 2100 Stationen Deutschlands der Wärmeinseleffekt etwa 0,1 Grad pro Jahrzehnt über die letzten 120 Jahre beträgt. Jedoch betrug er anfangs weniger, in den letzten 30 Jahren aber das Doppelte. Das bedeutet, dass mindestens 0,6K des in Erfurt beobachteten Temperaturanstiegs seit 1979 auf das Konto der (noch immer andauernden) Urbanisierung (Verstädterung) und auf die Umgestaltung der einstigen freien Fläche gehen. Da Erfurt eine „Boomtown“, mit im Vergleich zu Gesamtdeutschland überdurchschnittlich zunehmender Bebauung ist, muss von einem noch etwas höheren Urbanisierungs- und Flächenhaften Wärmeinseleffekt als den 0,6K Temperaturzunahme ausgegangen werden, wobei der Urbanisierungseffekt dominant ist.

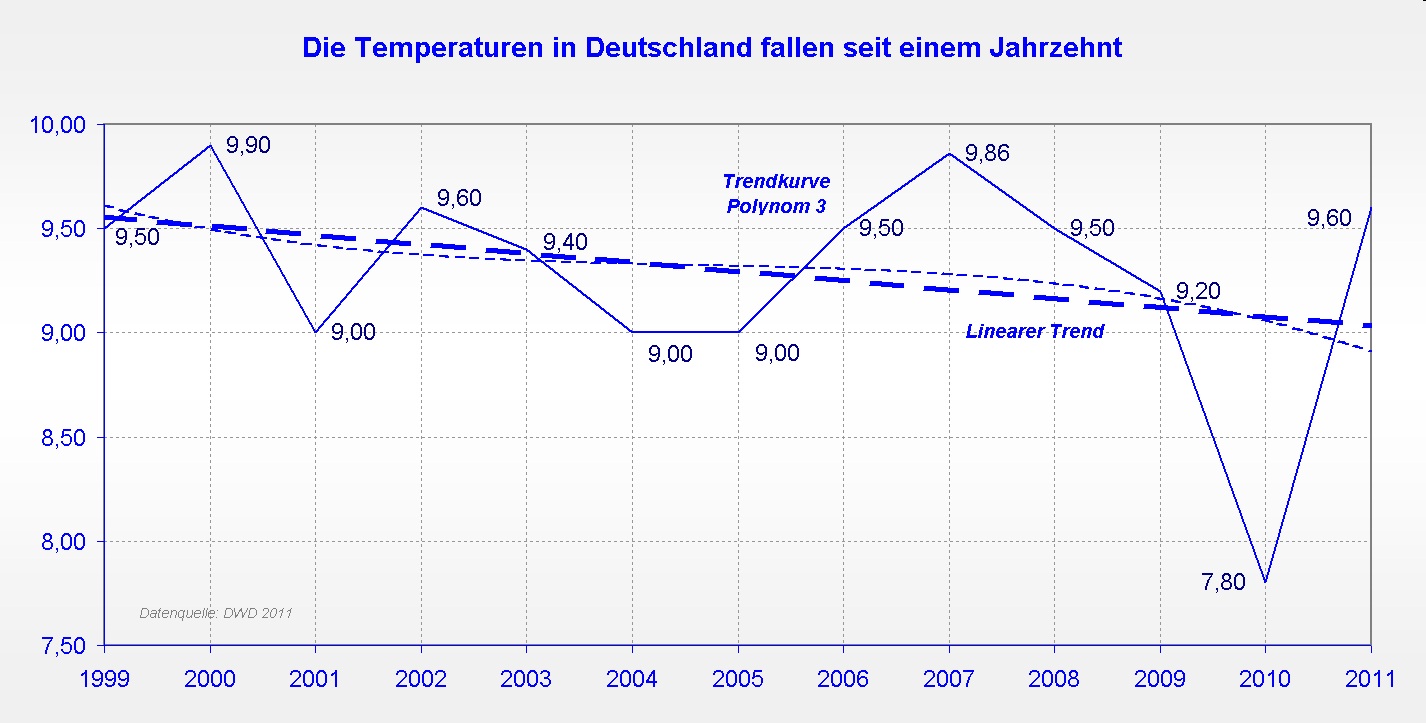

Die linearen, nach dem Jahr 2000 etwas fallenden Trendlinien von Deutschland und Bindersleben verhalten sich ähnlich (Abbildungen 5 und 6). Das Jahr 2000 war jeweils das wärmste Jahr. Der Temperaturrückgang der letzten 11 Jahre war in Bindersleben jedoch nicht so stark wie der Gesamtschnitt der deutschen Messstationen. In den letzten Jahren nähert sich Bindersleben langsam dem Deutschlandschnitt. Allerdings ist der betrachtete Zeitraum von 11 Jahren zu kurz für endgültige Schlussfolgerungen. Allgemein gilt jedoch: Urbanisierungs- und flächenhafte Wärmeinseleffekte wirken einer Abkühlung entgegen. Je mehr eine Station durch diese Effekte beeinflusst wird, desto weniger stark kühlt sie ab.

Abbildung 5

Abbildung 6

Weiter ist anzuführen, dass es in der verbleibenden freien Landschaft (beispielsweise durch Trockenlegung = Melioration, geänderte Anbaumethoden und die Umwandlung naturnaher Laubmischwälder in Fichten- oder Kiefernmonokulturen, aber auch durch Straßenneubau und Splittersiedlungen) weitere Erwärmungseffekte gibt, die ebenfalls unter den Begriff „Flächenhafter Wärmeinseleffekt“ fallen. Bei der Station Erfurt dürften allerdings Urbanisierungseffekte dominant sein, da hier vor allem Bebauung und Verkehr zunahmen. Außerdem ist zu beachten, dass die in den Städten erzeugte Wärme natürlich auch in die freie Landschaft „eingetragen“ wird und dort eine (mit wachsendem Abstand zur Stadt kleiner werdende) Erwärmung bewirkt.

Zweites Ergebnis: Die Urbanisierungs- und Flächenhaften Wärmeinseleffekte bewirkten ebenfalls einen Teil des Temperaturanstiegs, der aber leider aufgrund des Fehlens vergleichbarer Zahlen für Erfurt nur geschätzt werden konnte und seit 1979 mindestens 0,6K, betragen dürfte. Unsere Untersuchungen legen jedoch den Schluss nahe, dass bei der Station Erfurt- Bindersleben die urbanen Erwärmungseffekte überwiegen.

Anmerkungen: Gerade bei der Quantifizierung der „Urbanisierungs- und Flächenhaften Wärmeinseleffekte“ ergibt sich ein weites Feld für die Forschung. Folgende Fragestellungen wären interessant:

- Wie stark tragen die verschiedenen Wärmequellen und Erwärmungseffekte im Einzelnen zur Erwärmung bei?

- Gibt es- ähnlich, wie bei der Sonnenscheindauer, jahreszeitliche Unterschiede? Zumindest bei den durch Insolation (Einstrahlung) und Verdunstungsminderung verursachten Effekten ist dies zu erwarten. Im Sommer dominieren die indirekten Erwärmungseffekte und im Winter die direkten Wärmequellen. Dadurch sind möglicherweise deren Beträge der Erwärmung im Sommer und Winter annähernd gleich. In Städten etwa vergleichbarer Größe und Struktur wächst außerdem der Erwärmungseffekt mit zunehmender geografischer Breite oder der Höhe über dem Meeresspiegel, weil aus dem Strahlungsgesetz nach PLANCK folgt, dass sich ein kühlerer Körper (damit auch eine kühlere Region) bei derselben Energiezufuhr pro Zeiteinheit stärker erwärmt, als ein wärmerer.

- Was passiert in Städten, die in den vergangenen Jahrzehnten eine gravierende Deindustrialisierung und einen massiven Bevölkerungsrückgang zu verzeichnen hatten (Ruhrgebiet, Eisenhüttenstadt, Suhl und andere)? Ist dort die Erwärmung durch den Wärmeinseleffekt geringer ausgefallen, vielleicht sogar ausgeblieben oder gar rückläufig? Dies dürfte auch von der Intensität und Qualität der Rückbaumaßnahmen abhängen (bei Konversion in intensive Grün- oder Wasserflächen ist der Kühleffekt am größten).

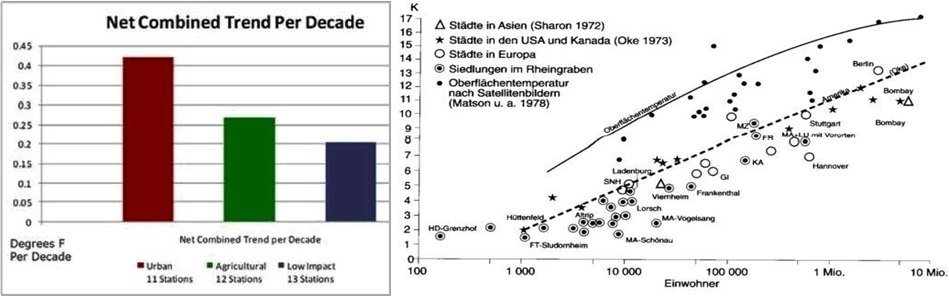

Abbildung 7 links entstammt einer Untersuchung aus den USA (Utah) und zeigt, wie sich die Erwärmungstrends mehrerer in Städten befindlicher Messstationen pro Jahrzehnt (linke, rotbraune Säule) von solchen in rein landwirtschaftlich genutzten Arealen (mittlere Säule) und von solchen in vom Menschen weitgehend unbeeinflussten („naturnahen) Arealen unterscheiden (rechte Säule).

Die Differenz der Höhen linke minus rechte Säule ist der Urbanisierungseffekt der Städte, hier in Fahrenheit dargestellt (0,4 Fahrenheit entsprechen etwa 0,22°C). Im Vergleich zu vom Menschen weitgehend unbeeinflussten Landschaften verlief die Erwärmung in den Städten also etwa doppelt so schnell (zusätzlich gut 0,1°C pro Jahrzehnt), was mit den erwähnten Wärmeeffekt- Berechnungen für Deutschland gut übereinstimmt. Die rechte Abbildung zeigt den Einfluss der Größe einer Siedlung auf deren bislang erfolgte zusätzliche Erwärmung in Kelvin (1K = 1°C). Allerdings hängt die Erwärmungsrate auch von der Besiedlungsdichte und der Art der Bebauung ab. Je dichter Bebauung und Besiedelung, desto höher ist die Erwärmungsrate. Gute Durchgrünung und Durchlüftungsschneisen mindern die Erwärmung.

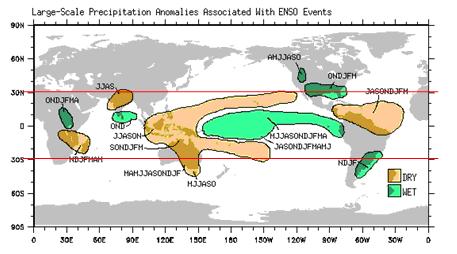

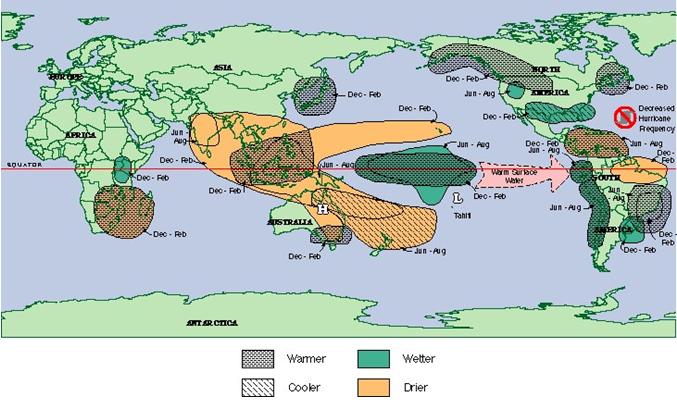

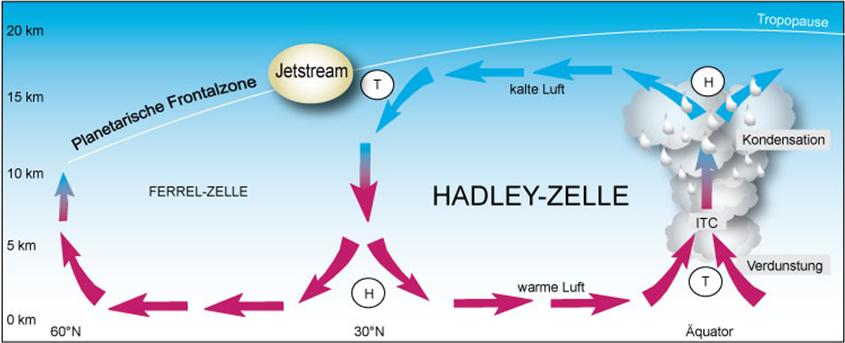

3. Wirkten sich auch Änderungen in der Zirkulation aus?

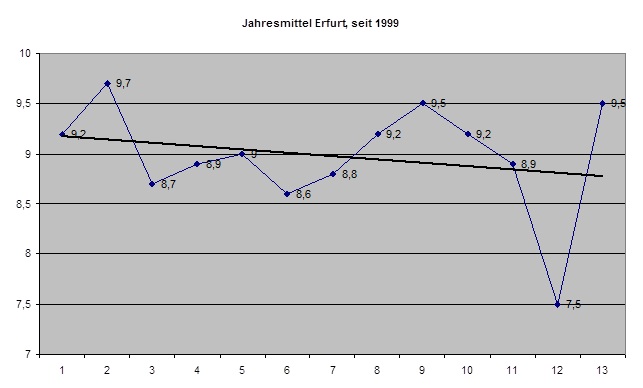

Berühmt wurde der sogenannte „Klimasprung“ am Ende der 1980er Jahre, als es deutlich wärmer wurde. Auch in Erfurt ist dieser- wenngleich undeutlich- zu erkennen. Dem, mit Ausnahme der Jahre 1982 und 1983, recht kühlen Zeitraum von 1979 bis 1987 (7 Jahre mit weniger als 8°C Jahresmitteltemperatur), folgte ab 1988 eine regelrechte „Kleine Warmzeit“ mit einem ersten Höhepunkt 1989/90, den absoluten Höhepunkten 1994 und um 2000, danach gab es bei Stagnation weitere Höhepunkte 2007 und 2011, während die Einbrüche (1996, 2010) zwar sehr markant, aber nie von Dauer waren. Nun lohnt es sich, die 5 wärmsten und die 5 kältesten Jahre einmal etwas genauer unter die Lupe zu nehmen.

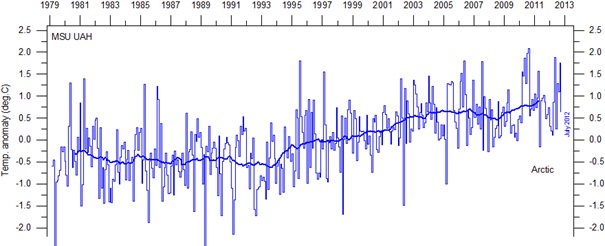

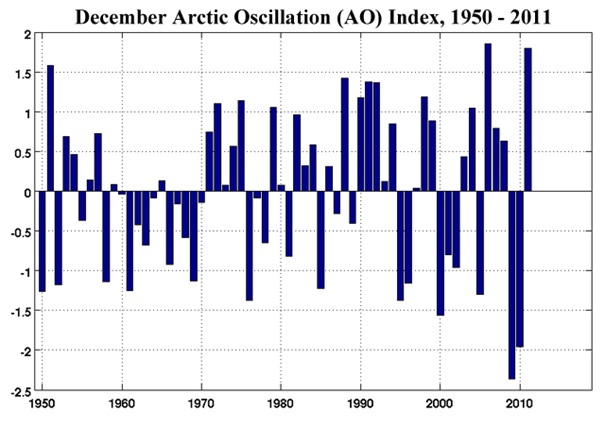

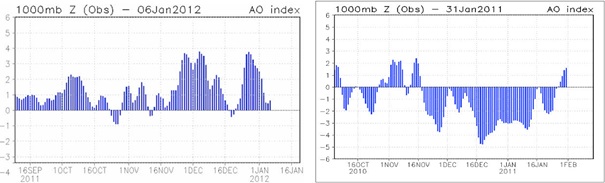

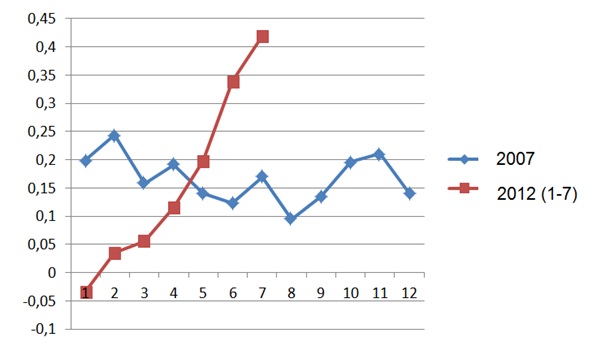

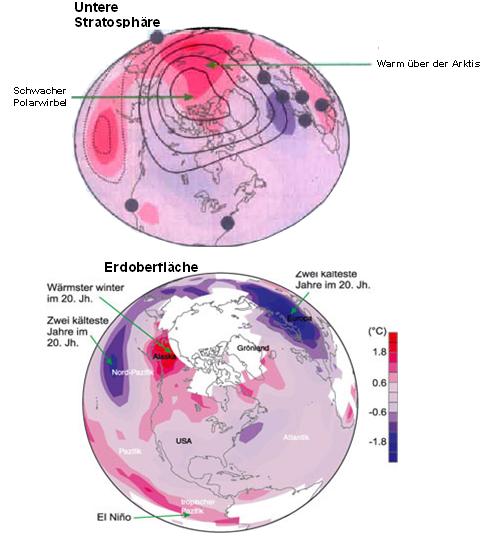

Die 5 wärmsten Jahre (2000, 1994, 2007, 2011, 1990) zeichneten sich durch eine Häufung kräftiger Westwetterlagen im Januar, Februar und im Dezember aus, während im Sommer ebenfalls wechselhaftes Westwetter überwog (lediglich im heißen Sommer 1994 dominierten Hochdruckwetterlagen). In den kältesten Jahren (1996, 1987, 1985, 1979 und 1980) gab es in den Wintermonaten markante Kälteeinbrüche aus Ost bis Nordost, die zumindest einige Wochen, mitunter gar über Monate (1996) dominierten, während alle Sommer dieser Jahre wechselhaft und mehr oder weniger zu kühl ausfielen. Es fällt auf, dass Jahre mit sehr warmen Sommern (1982, 1983, 1992, 1994, 2003, teilweise auch 1991, 1995, 2006 und 2010) nur einmal unter den „Extremjahren“ vertreten sind, was man so erklären kann, dass ihnen teilweise mäßig- kalte Winter oder Frühjahre vorausgingen, mitunter folgte auch ein zeitiger und kalter Herbst. Insgesamt scheinen sich „sommerwarme“ Jahre durch eine im Jahresmittel leicht geschwächte Westwindzirkulation auszuzeichnen. Nun ergibt sich die Frage, ob sich aus den Monats- und Jahresmittelwerten der standardisierten NAO (Nord- Atlantische Oszillation) eine Beziehung zur Jahresmitteltemperatur und zu den Mitteltemperaturen der Hauptjahreszeiten ableiten lässt? (Anmerkung: Hohe, positive NAO- Indizes drücken eine überdurchschnittlich kräftige westliche Strömung über dem Ostatlantik aus, während diese bei negativen Indizes abgeschwächt ist. Bei stark negativen Werten „tauschen“ Azorenhoch und Islandtief gar ihre Plätze. Die NAO wird maßgeblich durch die solare Aktivität moderiert, wie die folgenden Abbildungen belegen.

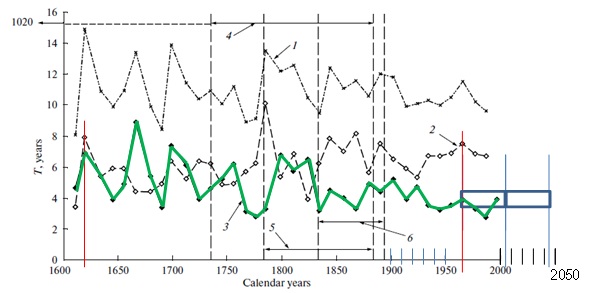

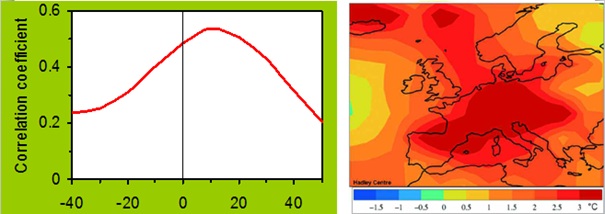

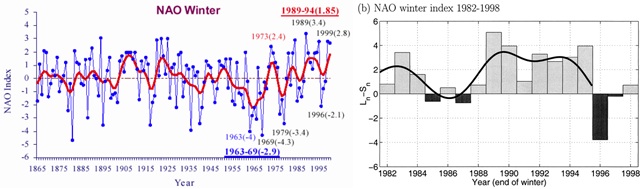

Abbildung 8 links zeigt den NAO-Winterindex von 1865 – 2000 (Quelle: Deutscher Wetterdienst). Deutlich ist in der Wellenform ein 10-Jahres-Zyklus abgebildet, der zeitlich exakt mit dem Schwabezyklus der Sonne korreliert. Hohe Indexwerte sind mit einer intensiven nordatlantischen Westdrift und damit milderen Temperaturen verbunden. Rechts ist der NAO-Winterindex von 1982 – 1998 abgebildet (ergänzt nach Quelle: American Meteorological Society Journal Online, Volume 13, Issue 5, März 2000).

Die kleine Abbildung ist hineinkopiert und zeigt den Schwabezyklus der Sonne im selben Zeitraum. Er stimmt exakt mit dem NAO-Winterindex überein. Dass die Sonne maßgeblich die NAO bestimmt, zeigt bereits die Arbeit ”Length of the solar cycle influence on the relationship NAO-Northern Hemisphere Temperature”, L. Torre, L. Gimeno, M. Tesouro, J. A. Añel, R. Nieto, P. Ribera, R. García, E. Hernández, Geophysical Research Abstracts, Vol. 5, 30-1-2003, European Geophysical Society.

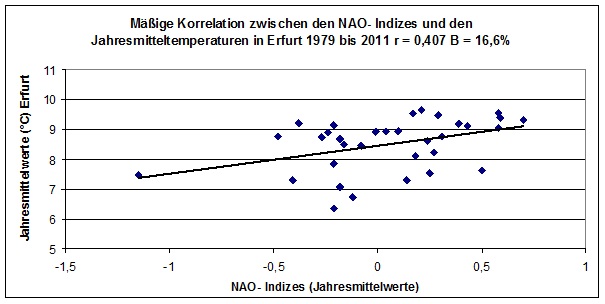

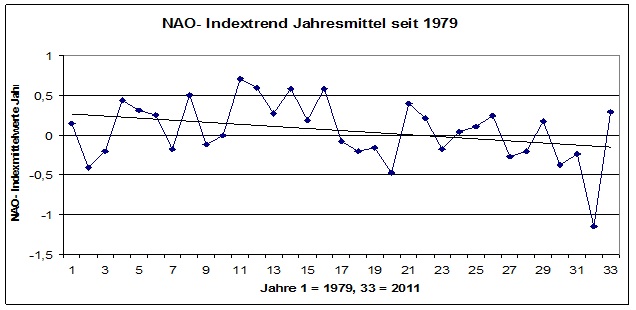

Der NAO- Index wird täglich mit Hilfe der 00- UTC- 500- Hektopascal- Anomalien über der Nordhemisphäre berechnet). Der Zusammenhang zwischen den NAO- Indizes (Jahresmittelwerte) und den Jahresmitteltemperaturen ist aber allenfalls mäßig (Abbildung 9):

Abbildung 9

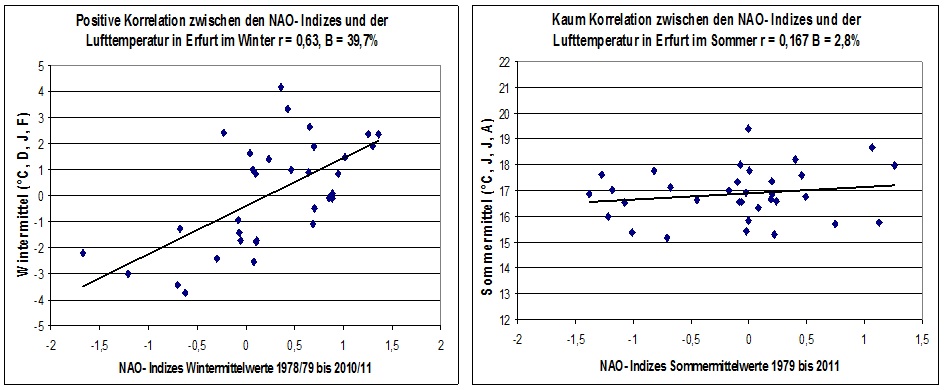

Ein Jahreszeitenvergleich zeigt, dass die NAO- Indizes im Winter einen deutlichen, im Sommer aber praktisch keinen Einfluss auf die Temperaturen haben (Abbildungen 10):

Abbildung 10

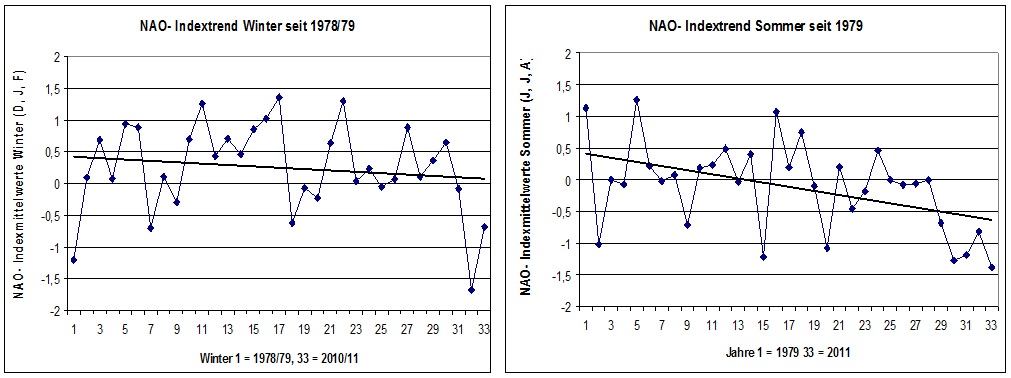

Man könnte nun den voreiligen Schluss ziehen, dass vielleicht zunehmende NAO- Werte für einen Teil des Temperaturanstiegs seit 1979 verantwortlich sind, denn auch zurzeit des „Klimasprungs“ um 1990 herrschten positive NAO- Werte vor. Dem ist aber nicht so, denn die NAO- Indizes zeigen (wie dargelegt, von der Sonnenaktivität moderiert), eine leicht fallende Tendenz:

Abbildung 11

Allerdings war der Rückgang im Winter weniger deutlich als im Sommer:

Abbildung 12

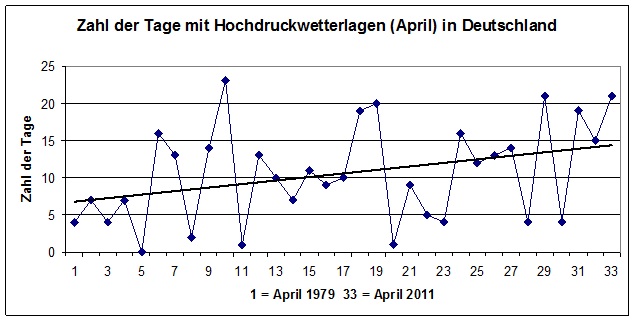

Auswertungen lassen den Schluss zu, dass die Häufung trocken- warmer Hochdruckwetterlagen zwischen Anfang April und Ende Mai, welche sich jedoch in den NAO- Werten kaum ausdrückt, ganz wesentlich zum Temperaturanstieg beigetragen haben. Weil der April den stärksten Temperaturanstieg aller Monate in Erfurt aufwies, wurde für ihn die Anzahl der Tage mit Hochdruckwetterlagen (alle vom Deutschen Wetterdienst als „antizyklonal“ eingestuften Großwetterlagentage plus die Tage mit den Großwetterlagen „Hochdruckgebiet über Mitteleuropa“ und „Hochdruckbrücke über Mitteleuropa“) ermittelt. Es ergibt sich eine deutliche Zunahme der Tage mit Hochdruckwetter seit 1979:

Abbildung 13

Es gibt momentan etwa 7 Tage mehr Hochdruckwetterlagen im April, als Ende der 1970er Jahre. Die Monatsmitteltemperaturen stiegen im April in Erfurt ebenfalls deutlich an:

Abbildung 14

Obwohl beide Trendlinien ähnlich verlaufen, ist der berechnete Zusammenhang mit r = 0,32 und dem daraus resultierenden Bestimmtheitsmaß von 10% alles andere als gut. Man muss allerdings bedenken, dass nicht alle Hochdruckwetterlagen im April „erwärmend“ wirken, denn bei nördlicher bis nordöstlicher Luftströmung kann selbst anhaltender Sonnenschein die heranwehende Kaltluft nicht immer ausreichend aufheizen. Möglicherweise nahmen aber auch andere, „erwärmend“ wirkende Wetterlagen zu, was noch einer genaueren Untersuchung bedarf. So erhöhte sich seit den 1960er Jahren die Häufigkeit der Westwetterlagen im Winterhalbjahr deutlich, dafür treten diese im Sommerhalbjahr seltener auf, was insgesamt ebenfalls erwärmend wirkt („Westwetter“ geht im Winter mit deutlich positiven, im Sommer mit leicht negativen Temperaturanomalien in Mitteleuropa einher).

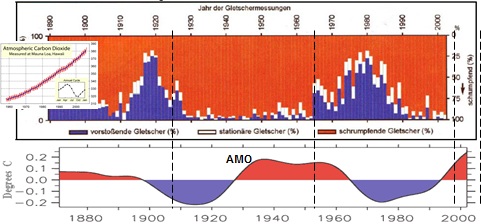

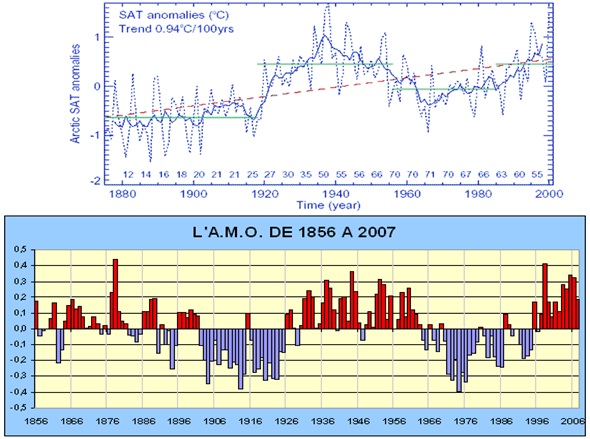

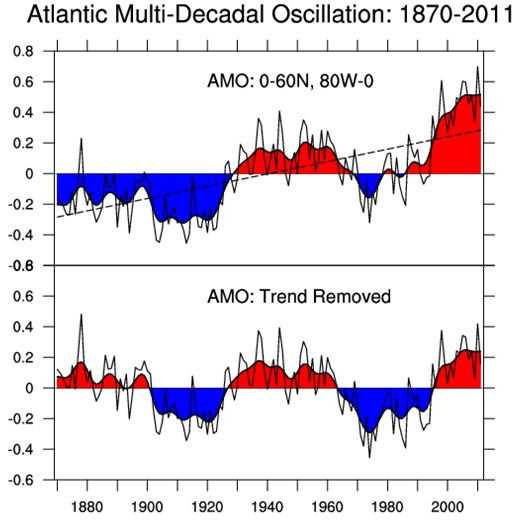

Die genaue Quantifizierung dieser Erwärmungseffekte durch die Veränderung der Häufigkeiten der Großwetterlagen ist jedoch schwierig. Wie noch gezeigt wird, werden diese Zirkulationsänderungen von der Sonnenaktivität wesentlich beeinflusst und über die Schwankungen der NAO (Nordatlantische Oszillation der Luftdruckverteilung) und der AMO (Atlantische Multidekaden- Oszillation der Wassertemperaturen) direkt gesteuert. Damit wird klar, dass auch hier eine „Trendumkehr“ möglich ist. In den Wintern 2008/09 bis 2011/12 kam es- zumindest monatsweise- schon zu einer deutlichen Abschwächung der Westwetterlagen, was auf eine beginnende Trendumkehr hindeuten könnte.

Drittes Ergebnis: Aus Zirkulationsänderungen lässt sich der Temperaturanstieg zumindest für Erfurt nicht zweifelsfrei erklären. Die Westwind- Zirkulation, deren Maß der NAO- Index ist, beschleunigte sich bis in die 1990er Jahre hinein, was den „Klimasprung“ um 1990 mit erklären kann. Danach ging sie besonders nach Beginn der 2000er Jahre zurück, so dass im Gesamtzeitraum ein negativer Trend überwiegt, der im Gegensatz zum positiven Temperaturtrend steht. Im Winter beeinflussen steigende NAO- Werte die Lufttemperaturen relativ deutlich positiv (von Westlagen dominierte Winter sind tendenziell milder), während im Sommer fast kein Zusammenhang zur NAO erkennbar ist.

Der Rückgang der NAO- Indizes ging hauptsächlich auf Kosten der Sommermonate. Eine gewisse, nicht in allen Jahreszeiten vorhandene Erwärmung durch häufiger auftretende Hochdruckwetterlagen, besonders im Frühling und mehr Westwetterlagen im Winter, dafür weniger Westwetterlagen im Sommer, deutet sich jedoch an. Insgesamt kann der Betrag des Erwärmungseffekts durch Zirkulationsänderungen nur grob geschätzt und in der Größenordnung von 0,1 bis höchstens 0,3K seit 1979 für Erfurt angesetzt werden.

Verfasst und zusammengestellt (2012) von

Stefan Kämpfe, Weimar

Josef Kowatsch, Hüttlingen

Raimund Leistenschneider, EIKE