Fukushima-Jubiläum: Die Welt zieht mit Kernenergie am „Vorreiter” Deutschland vorbei. Ein Bericht über die „Fast Reactor”-Konferenz der IAEA in Paris, 4.-7. März 2013

Zweifellos ist dies ein weiterer Erfolg grün-roter Ideologen auf ihrem Weg zur Umgestaltung unserer Republik in eine Ökodiktatur. Selbst seriösere Medienberichte, als Beispiel sei die ARTE TV-Sendung „Chronik eines Desasters“ vom 7.3.2013 (22-15 h) genannt, wagen es hierzulande nicht mehr, die Öffentlichkeit korrekt über die Kernkraft und das Fukushima-Unglück zu informieren – von bemerkenswerten Einzelfällen abgesehen, wie in der Zeitschrift "Die Junge Freiheit" (hier und hier). So war in der ARTE-Sendung über die folgenden maßgebenden Fakten so gut wie nichts zu vernehmen, was nach Meinung besser informierter Zuschauer als Unterschlagung empfunden wurde.

1) Es gab in Fukushima keinen einzigen „Strahlentoten“.

2) Die Ursache der Katastrophe von Fukushima war der Tsunami, nicht eine angebliche Unsicherheit der Kernkraftnutzung.

3) Es wurden haarsträubende Fehler bei der Auslegung des Kernkraftwerke in Fukushima gemacht, die bei deutschen Kernkraftwerken unmöglich sind.

4) Es gab massive (nach unseren Gesetzen vermutlich sogar strafrechtlich relevante) Schlampereien der Betreiberfirma TEPCO sowie der japanischen Behörden.

5) Die unzureichenden Sicherheitssysteme der Anlagen in Fukushima sind mit dem weltweit einzigartigen Sicherheitsstandard deutscher Kernkraftwerke überhaupt nicht vergleichbar.

Ausführliche Beschreibungen, was in Fukushima wirklich vorfiel, finden sich zum Beispiel hier und hier. Trotz der wohl schon als kriminell anzusehenden Unterlassungen der japanischen Betreiberfirma TEPCO – stellvertretend seien unzureichende Schutzmauern gegen Tsunamis und fehlende Wasserstoffrekombinatoren zur Vermeidung von Knallgasexplosionen genannt – blieben die Folgen dieses Unfalls relativ gering. Die radioaktive Belastung der Anrainer hat sich als ungefährlich herausgestellt (s. auch hier). Japan, aber auch die Ukraine denken in sachgemäßer Beurteilung nicht daran, die Kernenergie aufzugeben. Zeitgenossen, die noch einigermaßen klar bei Verstand sind, geben schließlich nach einem Flugzeug- oder einem Eisenbahnunglück auch nicht die Fliegerei oder das Bahnfahren auf.

Im Zuge der grünen Volkstäuschung über Fukushima im Speziellen und über die Nutzung der Kernenergie im Allgemeinen war es den deutschen Medien folgerichtig kein Wort der Erwähnung wert, dass der Rest der Welt an der Markteinführung der neuen Generation-IV-Reaktoren arbeitet. Rund 650 Vertreter aus Wissenschaft, Wirtschaft und Technik trafen sich vom 4. bis 7. März in Paris zur 13. „Fast Reactors and Related Fuel Cycles”-Konferenz in Paris (FR13).

Bild 1: Poster auf der "Fast Reactors and Related Fuel Cycles”-Konferenz in Paris

Diese findet alle 4 Jahre unter der Federführung der Internationalen Atomenergie-Organisation IAEA statt. Knapp 30 Länder waren diesmal vertreten, wobei Frankreich mit 40% die mit Abstand größte Teilnehmerzahl stellte, gefolgt von Russland (14%), dem angeblichen Aussteigerland Japan (9%) und den USA (8%). Deutschland war mit lediglich 24 Teilnehmern vertreten, davon die Hälfte an deutschen Institutionen arbeitenden Ausländern. In diesem Zusammenhang darf an folgende Fakten erinnert werden: Aktuell werden 437 Kernreaktoren in 30 Ländern betrieben. Die Länder mit den meisten Reaktoren sind: USA 103, Frankreich 58, Japan 50, Russland 33, Korea 23, Indien 20, Kanada 19, China 18, England 16, Schweden 10, Deutschland 9, Spanien 8, Belgien 7, Tschechien 6, Schweiz 5, Ungarn 4, Slowakei 4 und Finnland 4. Im Neubau befinden sich insgesamt 64 Anlagen (Quelle: International Atomic Energy Agency).

Allerdings beruhen die heute üblichen Kernreaktoren im Wesentlichen immer noch auf den völlig veralteten Konzepten der ehemals militärisch genutzten Reaktoren, bei denen bekanntlich die Herstellung von Kernwaffenmaterial im Vordergrund stand. Diese wurden nach und nach in Anlagen zu rein ziviler Nutzung umgewandelt, was etwa mit dem Umbau eines Panzers in ein Familienauto vergleichbar ist. In diesen alten Kernreaktorsystemen, die immer noch die Basis fast aller weltweit zivil genutzten Reaktoren bilden, werden die die Kernspaltung induzierenden Neutronen bis auf thermische Energien abgebremst („moderiert“). Man spricht daher von thermischen Reaktoren. Die modernen Konzepte der „schnellen Reaktoren”, oder besser „Schnellspaltreaktoren (Fast Reactors)”, moderieren dagegen nicht, sondern sie arbeiten mit schnellen Neutronen. Ihr Nachteil ist das aufwendigere Kühlsystem, denn zur Abfuhr der Nutzwärme eignen sich eigentlich nur Flüssigmetalle. Der weit überwiegende Vorteil dieser neuen Systeme gegenüber den thermischen Reaktoren ist dagegen das günstigere Verhältnis von Neutroneneinfang zu Spaltung. Dieses sorgt dafür, dass kein Überschuss an Plutonium verbleiben muss und bereits vorhandenes Plutonium abgebaut werden kann. Plutonium macht zusammen mit den sogenannten minoren Aktiniden 99,99% der Langzeittoxizität des nuklearen Abfalls aus. „Schnelle Reaktoren” stellen daher die ultimative Lösung des sogenannten „nuklearen Abfallproblems” dar. Nebenbei: da die Lösung des nuklearen Abfallproblems der politischen grünen Bewegung einen entscheidenden Stützpfeiler entzieht, ist sie bei diesen Leuten höchst unerwünscht. Das Jahrzehnte lange Hinauszögern (Moratorium) und Verhindern bei der Suche nach einem Endlager, das immer wieder erfolgreich am Leben erhalten werden konnte, darf als Beleg für diese Einschätzung gelten.

Das Konzept von Schnellspaltreaktoren ist nicht einmal neu, Demonstrationsanlagen wurden bereits in den 50er Jahren gebaut. Ihr Hauptproblem entstand freilich darin, dass man sich – bedingt durch die historische Entwicklung – bis heute auf flüssiges Natrium als Kühlmittel festgelegt hatte. Natrium ist ein notorischer „Neutronendieb”, leicht entflammbar, daher gefährlich und hat überdies ungünstige nukleare Reaktivitätseigenschaften. Flüssiges Blei ist ungleich besser geeignet, es vermeidet alle Nachteile von Natrium. Der einzige Grund für die Verwendung von Natrium bestand in der damals noch beabsichtigten Anwendung natriumgekühlter Reaktoren als Antrieb für Militärflugzeuge. Obwohl diese Anwendung nicht mehr diskutiert wird, hat sich das Konzept der Kühlung mit Natrium bis heute erhalten. Es ist natürlich nachvollziehbar, dass es für die großen Kernreaktorunternehmen aus Kosten-, Genehmigungs- und Planungsgründen problematisch ist, in ihren Entwicklungslinien sehr schnell zu große Änderungen zu realisieren (oft sind Abteilungen oder ganze Unternehmen mit einer bestimmten Linie „verheiratet“ und fürchten um ihre Stellung, wenn etwas Neues zum Zuge kommt). Gründe dieser Art, aber auch jahrelang sich hinziehende Genehmigungsverfahren bei der Einführung neuer Konzepte erklären den hohen Zeitverzug bei Innovationen von Kernkraftwerkstypen.

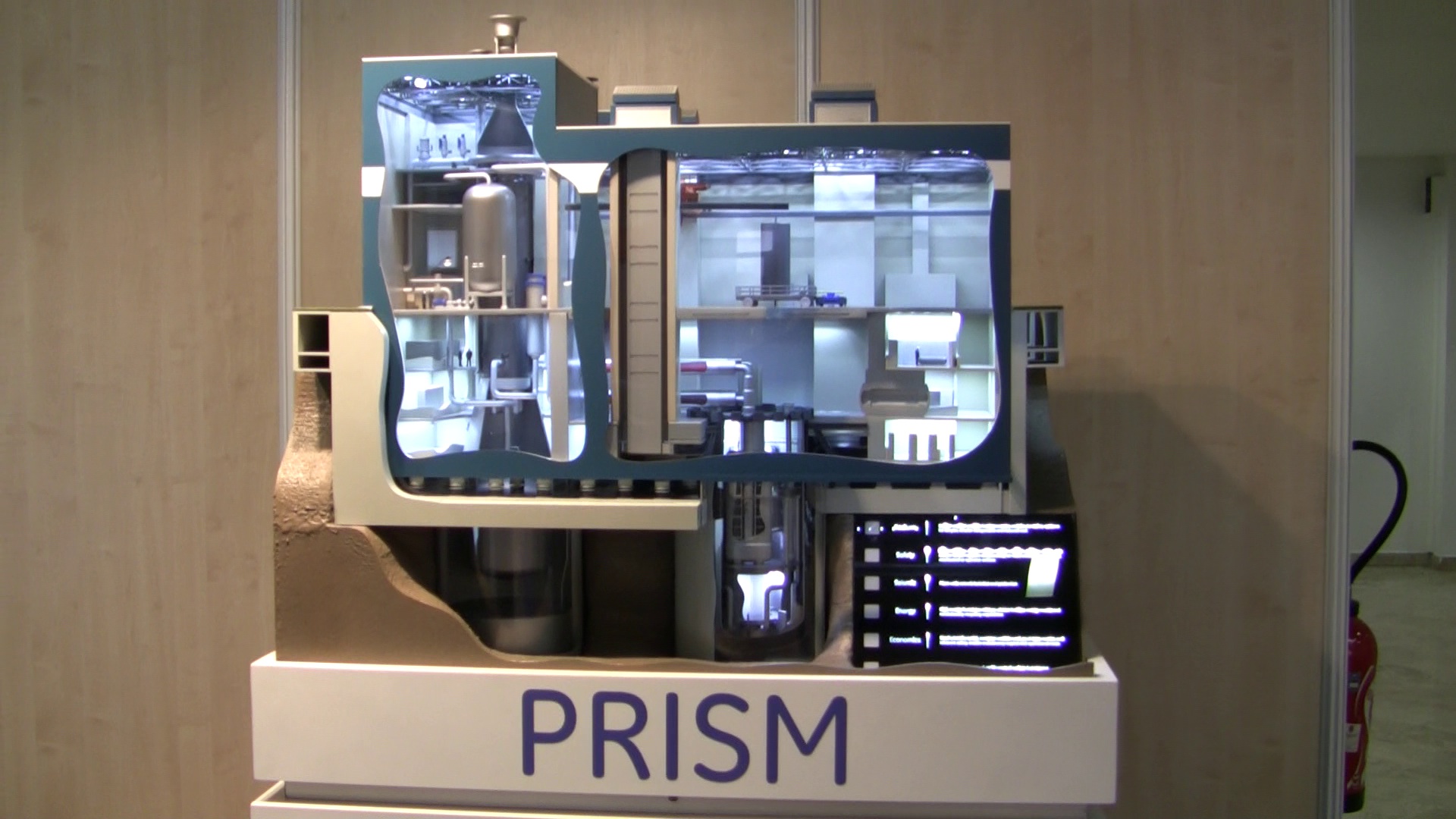

Die Pariser Konferenz FR13 war dementsprechend auch noch ganz auf natriumgekühlte Systeme ausgerichtet. Man darf sich die Konferenz aber keineswegs als rein akademische Veranstaltung vorstellen. Die Industrie reagiert auf die erhöhten Sicherheitsanforderungen mit neuen, interessanten Konzepten und arbeitet Hand in Hand mit der IAEA und den nationalen Aufsichtsbehörden. Neben zahlreichen Vorträgen zu Sicherheitskonzepten, internationalen Generation-IV Roadmaps und ausgeklügelten Wiederaufarbeitungsmethoden abseits des üblichen PUREX-Verfahrens, wie z.B. neue praktisch rückstands- und emissionsfreie Flüssigsalz-Verfahren, warben Firmen aus verschiedenen Ländern an Ständen mit konkreten neuen Verfahren und Systemen. So bietet beispielsweise die amerikanisch-japanische GE Hitachi mit dem S-PRISM-Reaktor ein bereits schlüsselfertiges Kraftwerk an, das sich in der Lizensierungsphase und unmittelbar vor der Markteinführung befindet. Sogar ein beeindruckendes Modell des Kraftwerks konnte auf einer Fläche von 1/2 m2 begutachtet werden – mit Knöpfen zum Herumspielen.

Bild 2: Modell des S-PRISM-Reaktors

Ähnlich imposant war Modell der französischen natriumgekühlten 600-MWe-Demonstrationsanlage ASTRID, die gerade von Areva und der „cea” geplant wird.

Bild 3: Modell des ASTRID-Reaktors

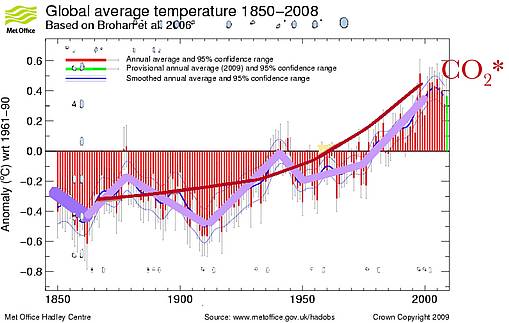

ASTRID war denn auch das Hauptthema der Veranstaltung, denn man will der Öffentlichkeit anschaulich vermitteln, dass derartige System sicher und wirtschaftlich sind und dass sie funktionieren. Mit schnellen Reaktoren wird eine doppelte Strategie verfolgt: zum einen für die "Treibhausphoben" die CO2-freie Energiebereitstellung, was allerdings für die Kernenergie ganz allgemein gilt und für die "Radiophoben" die Entschärfung und Nutzung des sogenannten „nuklearen Abfalls”. Bedingt durch hindernde politischen Einflüsse ziehen sich Projekte zu Schnellspaltreaktoren aber leider entsetzlich lange hin. ASTRIDs Vorgänger Superphenix wurde bereits 1998 stillgelegt. Auch das russische Gegenstück, die BN-Serie, läuft bereits über Jahrzehnte. Wissen droht verloren zu gehen, deshalb ist es erklärtes Ziel der IAEA, die erworbenen Kenntnisse über Schnellspaltreaktoren in die nächste Generation hinein zu retten.

Das „Young Generation Event” war somit ein Highlight der Veranstaltung. Im Vorfeld gab es bereits einen 5-Minuten-Videowettbewerb auf Youtube, dessen Gewinner unter Erstattung von Reisekosten und Unterbringung eingeladen wurden. Während der Konferenz haben junge interessierte Kerntechniker, Ingenieure und Wissenschaftler in Arbeitsgruppen zu Themen wie Wirtschaftlichkeit und Sicherheit insgesamt 7 Vorträge erarbeitet, die im Plenarsaal, dem „Amphiteatre” des Palais de Congress, wo die FR13 stattfand, in einer Podiumsdiskussion vorgetragen wurden. Die zentrale Botschaft an die „Alten” war: Hört mehr auf die Öffentlichkeit, nehmt Leute mit Bedenken ernst, klärt auf! So steigt die Akzeptanz der Kernenergie, insbesondere der Generation IV. Eine zweite Botschaft an die „Alten” war, auf die Wirtschaftlichkeit zu achten. Die Ausbeute heutiger Kernreaktoren, mit einem Erntefaktor (EROI) gerade vier mal so hoch wie der von fossilen Kraftwerken, ist mikrig, verglichen mit dem 100 Millionenfach höheren Energiegehalt von Kernbrennstoff gegenüber Kohle. Eine dritte Botschaft war schließlich, eine stärkere Zusammenarbeit mit der Wissenschaft zu erreichen.

Eines der Videos kam übrigens aus Deutschland, nicht aber von den großen Forschungsinstituten (die waren ohnehin kaum vertreten), sondern von dem kleinen unabhängigen „Institut für Festkörper-Kernphysik” (IFK) in Berlin. Man mag es kaum glauben, aber im Land der ultimativen Ökospinner und Kernkraftverweigerer wird tatsächlich ein neues nukleares Reaktorkonzept entwickelt, der „Dual Fluid Reactor” (DFR). Er lässt die Probleme der heutigen Leichtwasserreaktoren, aber auch die der Generation-IV-Konzepte weit hinter sich. Und er ist dabei auch noch extrem kosteneffizient – glaubt man den Entwicklern. Zwei Doktoranden aus Berlin, Mitglieder des IFK, stellten den DFR in einem Video vor und wurden prompt nach Paris eingeladen. Hier konnte das Konzept auf einem Poster propagiert und erläutert werden. Es gibt eben neben dem ideologisch verblendeten deutschen Mainstream auch noch echte Entwicklungen, folgerichtig ohne einen Cent staatlicher oder industrieller Unterstützung. Wenn man vom „Energiewende”-Rausch irgendwann einmal mit einem schlimmen Kater wieder aufwachen wird, wird man sich solcher Konzepte sicher wieder entsinnen – falls es für Deutschland bis dahin nicht zu spät ist.

Prof. Dr. Kondo, Chairman der japanischen Atomenergiekommission, betonte übrigens in der Eröffnungssitzung, dass die japanische Regierung keineswegs eine Aufgabe der Kernenergie plant, sondern lediglich einen Energiefahrplan erarbeitet, in dem der zukünftige, anzustrebende Energiemix festgelegt wird. „Fukushima” war auf der FR13 ansonsten so gut wie kein Thema. Allen Anwesenden war es schließlich bewusst, dass hier eher ein Kommunikations- als ein medizinisch-physikalisches Problem vorliegt, siehe Statement der „Young Generation” oben. Dass der deutschen Presse das makabere Spiel gelungen ist, die Erdbebenopfer zu Strahlenopfern umzumünzen, ist allerdings ein Musterbeispiel dafür, wie man Kommunikationskanäle missbrauchen kann.

Auf der FR13-Konferenz wollte niemand, der nicht gerade aus Deutschland kam, die hiesigen Verhältnisse wirklich glauben, so weit ist es mit Deutschland wieder gekommen. In vergangenen Zeiten waren es abstruse Theorien über Wert oder Minderwert von biologischen Rassen mit den bekannt katastrophalen Folgen. Heute ist der Unsinn leider nicht geringer geworden. Das anthropogene CO2, der Klimaschutz, der „Nutzen“ von Windturbinen und Biomais für die deutsche Energieversorgung und für die Rettung der Welt vor dem Wärmetod sowie schließlich die unabdingbar aufzugebende Kernkraft vernebeln wieder einmal die deutschen Gehirne und bringen die restliche Welt zum Lachen oder zum Fürchten. Unaufgeregtes, kühles Handeln auf technisch-rationaler Basis, gesundes Selbstbewusstsein, Furchtlosigkeit und positives Denken an Stelle von irrationalen Ideologien und angstgesteuerten Wunschvisionen waren noch nie deutsche Stärken.

von Prof. Dr. Horst-Joachim Lüdecke und Michael Limburg.

Der Beitrag wurde mit fachlicher Beratung des Instituts für Festkörper-Kernphysik erstellt.

Weiterführender link:

Deutschland verpasst den neuen Atomkraft-Boom

Zwei Jahre nach Fukushima ist die Kernenergie im Aufschwung. Mehrere Staaten steigen in die Atomkraft ein, während Deutschland laufende AKW stilllegte. Dabei wurde die Sicherheitstechnik verbessert. Von Daniel Wetzel

Abbildung 7: Verlauf von Proxydaten der Temperatur und der CO2 Konzentrationen aus Eisbohrkernmessungen für letzten 400.000 Jahre. Darin eingezeichnet die höher aufgelöste Graphik der letzen 8000 bis 22.000 Jahre. Deutlich ist die Nach-Eilung der CO2 Konzentration im Vergleich zu den Temperaturen zu erkennen.

Abbildung 7: Verlauf von Proxydaten der Temperatur und der CO2 Konzentrationen aus Eisbohrkernmessungen für letzten 400.000 Jahre. Darin eingezeichnet die höher aufgelöste Graphik der letzen 8000 bis 22.000 Jahre. Deutlich ist die Nach-Eilung der CO2 Konzentration im Vergleich zu den Temperaturen zu erkennen.