erschienen im Reviertransfer, Seite 44 (hier)

„Wir müssen die Energiewende vom Grundsatz her neu denken“

Interview mit Prof. Dr.-Ing. Harald Schwarz, Lehrstuhlinhaber Energieverteilung und Hochspannungstechnik an der BTU Cottbus-Senftenberg

Im Frühjahr 2018 war Prof. Harald Schwarz Mitautor einer BTU-Kurzstudie des brandenburgischen Wirtschaftsministeriums zu den technischen Zusammenhängen zur sicheren Stromversorgung. Wir suchten mit ihm das Gespräch zu seiner Sicht auf die Ergebnisse des Abschlussberichts der

WSB-Kommission. Daraus wurde eine umfangreiche Aufklärung zu den Unzulänglichkeiten der Umsetzung von Deutschlands Energiewende.

Die Kommission wurde mit den Begriffen Wachstum, Strukturwandel und Beschäftigung ins Rennen geschickt, was entnehmen Sie dem Abschlussbericht in diesen Themenbereichen für die Lausitz?

Ich habe den Bericht nur auszugsweise gelesen und mich auf die Absätze zur Versorgungssicherheit konzentriert. Es gibt eine logische Reihenfolge: Wir müssen zuerst die Versorgung sicherstellen und können dann schauen, wie wir CO2-Emissionen reduzieren. Erst dann brauchen wir uns über Themen wie Wachstum, Strukturwandel und Beschäftigung Gedanken machen. Wenn die Versorgungssicherheit als Primat nicht gegeben ist, brauchen wir über den

Rest nicht zu reden. Da ich in dem Bericht hierzu keinen Ansatz erkennen konnte, ist die Debatte um den Strukturwandel meines Erachtens obsolet.

Stehen Sie mit dieser Meinung nicht recht allein?

Das ist nicht meine Denke. Es gibt seit zehn Jahren ausreichend Studien dazu.

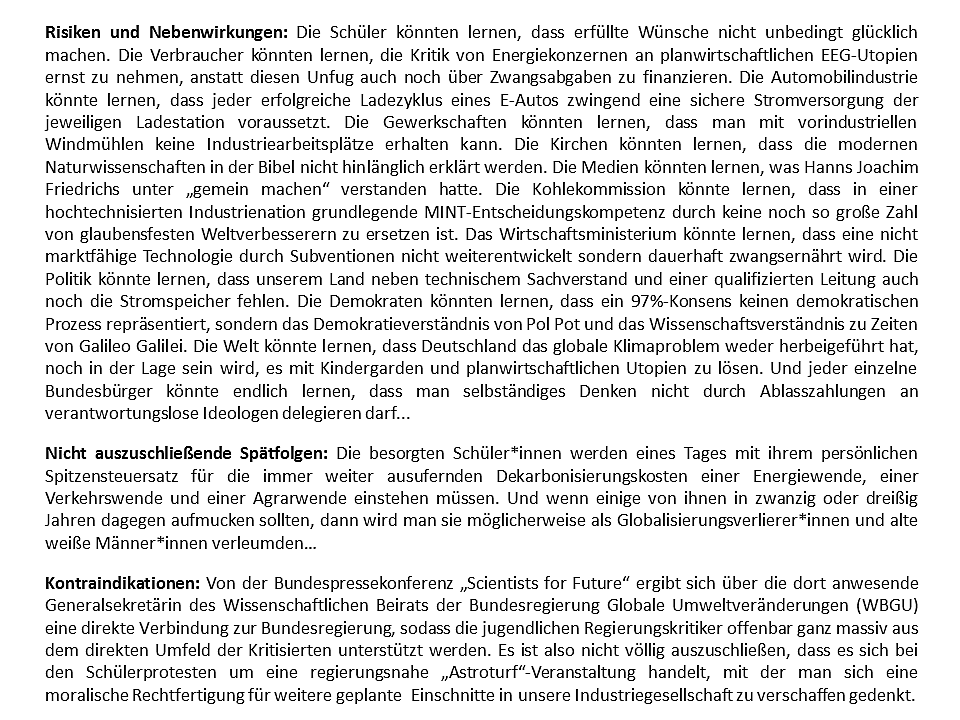

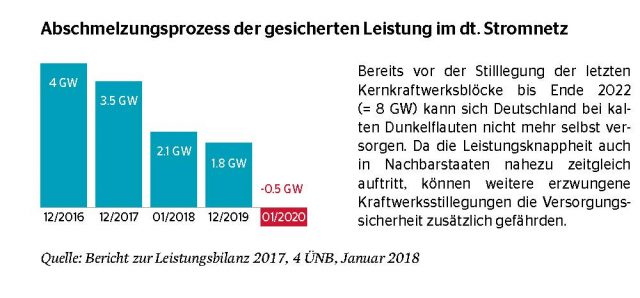

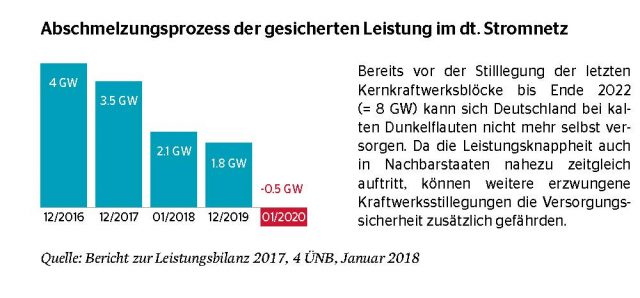

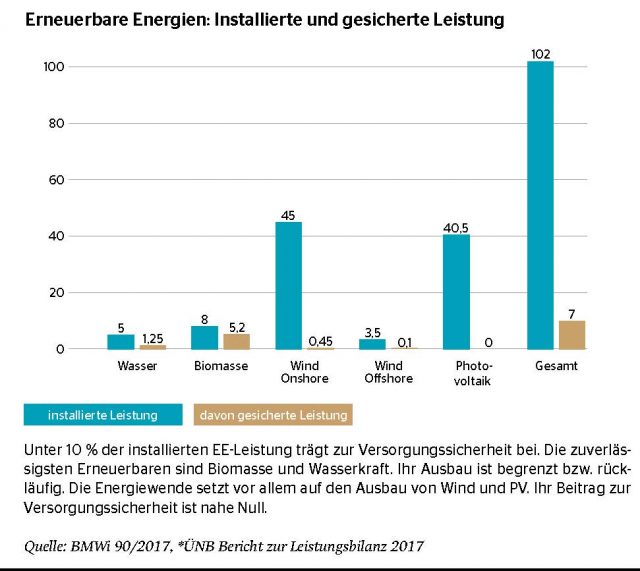

Möchte man in einem Land sichere Stromversorgung, benötigt man gesicherte Kraftwerksleistung. Seit hundert Jahren heißt die Regel, dass die gesicherte Leistung die mögliche Höchstlast in einem Stromnetz übersteigen muss. Schauen wir uns die letzten zehn bis 15 Jahre Energiewende in

Deutschland an, so haben wir um die 120 Gigawatt PV- und Windstrom aufgebaut. Die gesicherte Leistung von PV ist aber 0%, bei Wind onshore ist es 1%, bei Wind offshore 2%. Im Klartext liefern die 120 GW, die wir in den letzten 15 Jahren aufgebaut haben, nahezu null Beitrag zur gesicherten

Leistung. Wir werden ausschließlich mit Wind und PV nie eine gesicherte Stromversorgung aufbauen. Vor zehn Jahren standen uns deshalb rund 100 GW Kraftwerksleistung aus sicheren Energieträgern zur Verfügung, das sind Kohle, Gas, Atom, Biomasse und Laufwasser. Die mögliche Höchstlast in Deutschland liegt derzeit bei ca. 85 GW. Inzwischen ist die gesicherte

Leistung auf knapp 90 GW abgeschmolzen – und der Kohlekommissionsbericht sieht vor, dass wir davon bereits in drei Jahren weitere 20 GW gesicherte Leistung abschalten. Das soll dann noch weiter fortgesetzt werden. Wir geben in drei Jahren also unsere sichere Stromversorgung „aus eigener Kraft“ auf und haben dann nur noch 80% der notwendigen gesicherten Kraftwerkleistung im eigenen Land, die wir

brauchen, um uns verlässlich zu versorgen. 2030 sinkt das weiter auf 60%. Wo soll der Rest herkommen? Es gibt kein Konzept und bei unseren Planungshorizonten kann ich mir keine reale Lösung vorstellen. Fest steht, dass bis 2022 definitiv gar nichts passiert. Was heute im Bau ist, ist 2022 fertig, sonst nichts. Wir werden in drei Jahren die Abschaltung von Kohle und Atom nicht verkraften und können nur darauf hoffen, dass im angrenzenden Ausland noch genügend Reserven im Bereich Kohle und Atom vorhanden sind, um Deutschland mit zu versorgen, wenn wir es selbst nicht mehr

können.

Wie sieht es mit der Hilfe der Nachbarn aus?

Das ist die bislang einzige Hoffnung der Bundesregierung: Der europäische Strommarkt wird schon liefern. Aber was ist dieser Markt? Das sind Kraftwerke in den Nachbarstaaten. Hier stellt man schnell fest, dass Windflauten bei uns auch mit Windflauten bei den Nachbarn einhergehen. Dazu gibt es Fakten und Zahlen. Laufen unsere Kraftwerke unter Höchstlast, tun sie das in Polen und Tschechien auch. Die Wahrscheinlichkeit, dass uns die Nachbarn in einer kalten Dunkelflaute, bei weitgehendem Ausbleiben von Strom aus Wind und PV, mal eben 20 GW über den Strommarkt verkaufen können, halte ich für unrealistisch. Genau an diesem Punkt hat sich der Abschlussbericht der Kommission für mich wegen Realitätsferne erledigt.

Viele Wissenschaftler untermauern die Notwendigkeit und Möglichkeit des Kohleausstiegs – handelt es sich schlicht um unterschiedliche Sichtweisen oder einen unterschiedlichen Grad der wissenschaftlichen Expertise?

Die Aussagen zur gesicherten Leistung sind physikalische Fakten. An denen kann kein Wissenschaftler etwas ändern. Wir leben allerdings seit längerem in einer Phase der Energiewende, bei der physikalische Fakten und Naturgesetze ausgeblendet werden. Das Motto lautet: Es muss einfach gehen. Wir betreiben die Energiewende schon seit 20 Jahren. Das EEG ist Mitte der 1990er-Jahre erstmals wirksam geworden und vor der Jahrtausendwende

wurden dann die ersten Anlagen für Erneuerbare installiert. Das

Ziel der Energiewende besteht aber nicht im Aufbau regenerativer Energien, sondern im Senken der CO2-Emissionen. Bis heute erleben wir bei vielen Beteiligten einen wahren Rausch, was die jährliche Steigerung des prozentualen Anteils der Erneuerbaren an der Stromproduktion angeht. Daraus ist der Glaube entstanden, dass ein „weiter so“ bei der Steigerung

dieses Anteils die Lösung bringt.

In den Medien wird suggeriert, dass mit 40% Quote der Erneuerbaren auch 40% Deutschlands mit regenerativem Strom gesichert versorgt werden. Dem ist nicht so. Das physikalische Grundverständnis energietechnischer Zusammenhänge in den Medien und der Bevölkerung ist leider sehr gering. Schaut man hingegen auf die CO2-Emissionen in der Energiewirtschaft, so wurde in den letzten 20 nichts erreicht. Lediglich Anfang der 1990er-Jahre gab es einen starken Abfall, der mit der Deindustrialisierung der ehemaligen DDR einherging. Von 1994 bis 2013 waren die Emissionen der Energiewirtschaft dann trotz Energiewende konstant. Sie betrugen jedes Jahr 360 Mio. Tonnen CO2 plus minus 5 Prozent. Der Aufbau von PV und Windenergie gefördert über das EEG zeigte keine Wirkung bei den CO2-Emissionen.

Seit 2015 gibt es wieder einen leichten Abwärtstrend, allerdings sind das noch unbestätigte Daten des Umweltbundesamts aus dem Sommer 2018. Da war noch von Hochrechnungen und Expertenschätzungen die Rede, das ist also nicht belastbar. Vielleicht gibt es hier tatsächlich einen kleinen Abwärtstrend, aber über 20 Jahre haben sich die Emissionen gar nicht verändert und selbst jetzt wäre das nur sehr geringfügig. Trotzdem sind alle glücklich und feiern den Ausbau der Erneuerbaren. Das kann ich nicht verstehen.

Woraus resultiert der fehlende Effekt auf die Emissionen?

Parallel zum Aufbau der Erneuerbaren haben wir CO2-freie Kernenergie abgebaut. Was wir auf einer Seite aufgebaut haben, wurde auf der anderen Seite abgebaut. Zudem wurden Kohle- und Gaskraftwerke durch die volatile Einspeisung der Erneuerbaren zu einem extrem fluktuierenden Betrieb gezwungen, um so die ständigen Einspeiseschwankungen von Wind und PV

mit dem Strombedarf in Übereinstimmung zu bringen. Das ist wie Stop and Go mit dem Auto in der Stadt. Das führt auch zu höheren Emissionen pro Kilometer, als auf der gleichen Strecke mit konstanter Geschwindigkeit

auf der Autobahn oder Bundesstraße zu fahren. Wir haben im Ergebnis über 20 Jahre hinweg in blindem Aktionismus im dreistelligen Milliardenbereich Steuergelder ausgegeben, ohne nennenswert etwas bei den Emissionen zu erreichen.

Wie weit sind wir bei der Verstetigung der Erneuerbaren, damit wäre ja ein Effekt auf die Emissionen gegeben?

Wir wissen schon lange, dass überschüssige regenerative Energien gespeichert werden müssen. Das hat in den letzten 15 Jahren aber niemanden interessiert. Es gab bereits 2008 und 2010 Konzepte, die vor der kommenden Phase einer massiven Unterdeckung mit gesicherter Leistung warnten. Die Energiewende wurde trotzdem blind vorangetrieben. Hier müssen wir dringend umsteuern und die Energiewende neu denken, um zu einer nachhaltigen Stromversorgung mit deutlich geringeren CO2-Emissionen zu kommen.

Es wird dennoch viel über grünes Gas gesprochen, wie weit sind wir in der Praxis?

Im Jahr 2006 gab es eine Pilotanlage mit 6 MW und weitere im Bereich um 2 MW. Seitdem ist bundesweit nichts mehr passiert. Aktuell plant RWE nach meiner Kenntnis eine Anlage mit 50 bis 100 MW. Um von dieser Größe in den Bereich von mehreren 10.000MW zu kommen, brauchen wir nicht nur einen, sondern mehrere Schritte zum Hochskalieren und das dauert mehrere Jahrzehnte, zumal wir ja auch die Kosten dafür irgendwie verteilen müssen. Es rächt sich, dass wir 15 Jahre nichts getan haben.

Was müsste jetzt getan werden?

Wir reden inzwischen bei Phasen mit Überspeisung regenerativer Energien über hunderte Gigawattstunden. Die Big Batterie der LEAG wird 0,05 Gigawattstunden bringen, das macht die Dimensionen des regenerativen

Überschusses deutlich. Batterien werden in Zukunft zwar mehr im Netz auftauchen, aber als Elemente, über die man schnelle Regelleistung bereitstellen kann, um einem kritischen Frequenzabfall oder –anstieg in wenigen Minuten entgegenzuwirken. Bei einer mehrtägigen Überspeisung

der Netze, so wie wir es schon heute in Ostdeutschland im Winter teils mehrfach in der Woche haben, können wir nur abregeln, oder wir müssten diese Überschüsse in Wasserstoff umwandeln und als grünes Gas ins Gasnetz einspeisen. Das ist für Deutschland m.E. die einzige Option, den massiven EE-Überschuss zu verstetigen und nachhaltig zu nutzen. Das ist aber ein weiter, sehr weiter und auch teurer Weg.

Was kann bis dahin Kohle und Atom ersetzen?

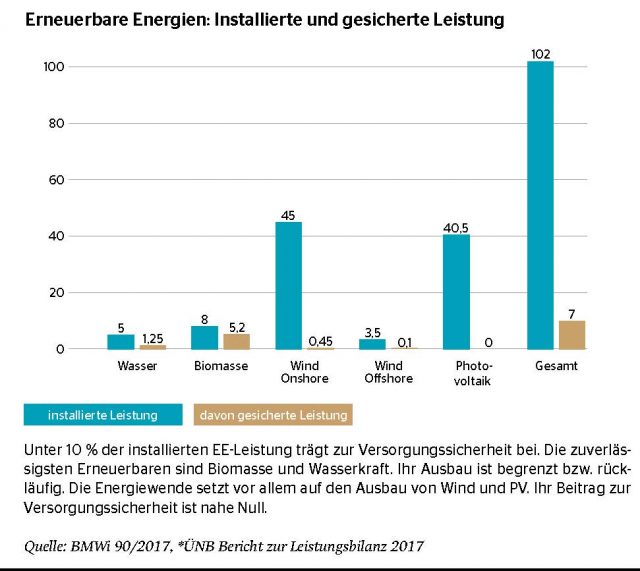

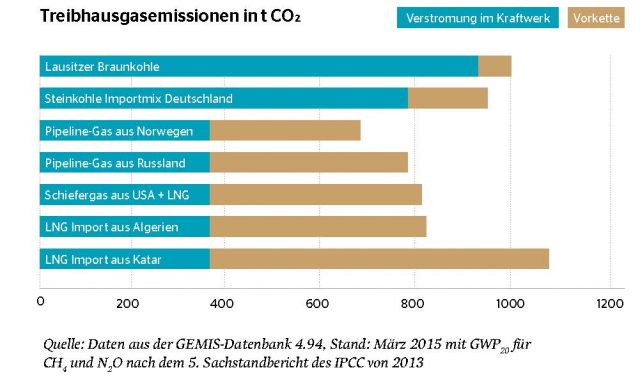

Wenn wir auf Kohle und Atom verzichten, bleibt nur Gas als Ersatz für gesicherte Leistung.Auch hier lügen wir uns seit Jahren in die Tasche. Wir betrachten die CO2-Emissionen nur im Wandlungsprozess vor Ort, in diesem Fall ist Gas deutlich günstiger als Kohle. Das ist zwar statistisch korrekt,

aber CO2 ist nun mal ein globales Problem. Wenn die tatsächlichen CO2-Emissionen durch Erzeugung und Transport mitbetrachtet werden, dann nimmt das bei Braunkohle aufgrund des geringen Abstandes zwischen Tagebau und Kraftwerk nur wenig zu, Steinkohle geht deutlich nach

oben, da viel Steinkohle für unsere Kraftwerke heute aus Australien kommt und bei Gas explodieren die Emissionswerte geradezu. Es gibt Gasfelder wie das amerikanische Schiefergas samt Transport nach Deutschland, bei dem die Gesamtemissionen dann weit über der Braunkohle liegen. Denken wir aber tatsächlich über globalen Klimaschutz nach, sind diese Gesamtemissionen

der entscheidende Wert.

Wenn wir über Klimaschutz reden, dann leistet

Gas als einziger möglicher Lückenfüller für Atom und Kohle also wenig Beitrag?

Klimaschutz ist ein globales Thema. Da hilft es nicht, wenn wir nur den Wandlungsprozess in Deutschland betrachten. Wir müssen die regenerativen Überschüsse umwandeln, das ist der einzig richtige Weg. Der Netzentwicklungsplan 2030 sieht 200 GW Wind und PV vor, die uns das Netz gigantisch belasten werden. Diese Überschüsse müssen ins Gasnetz. Der notwendige Prozess der Elektrolyse ist aber immens teuer und müsste dringend vorangetrieben werden, anstelle riesige Summen in die Verkabelung

der großen Nord-Süd Leitungstrassen zu stecken – nur mit dem Effekt, dass

man die Leitung dann nicht mehr sieht. Alles in allem sind wir in Deutschland dabei leider ohne Konzept.

Entspricht das inzwischen oft beschworene Szenario eines Blackouts einem realen Problem?

Nach Köpenick muss man den Begriff Blackout leider oft klarstellen. Es handelt sich dabei um eine lang anhaltende und großflächige Versorgungsunterbrechung. Das entspricht mehreren Tagen auf einer Fläche von mehreren hundert Quadratkilometern. Köpenick war eine zwar unschöne,

aber lokal und auch zeitlich noch sehr begrenzte Versorgungsunterbrechung.

Über die „Blaulichtorganisationen“ konnte man das locker von außen versorgen. Zur Notversorgung eines Stromausfalles im gesamten Berliner Stadtgebiet müsste das Technische Hilfswerk vermutlich alle in Deutschland verfügbaren Ressourcen zusammenziehen – und wenn die Fläche noch größer wird, dann wird es richtig hart. Insgesamt betreiben wir das Stromnetz in den letzten Jahren immer stärker am Limit. Anfang der 2000er-Jahre gab es zwei größere Blackouts (Italien bzw. Teile Westeuropas), weil der neu eingeführte Stromhandel über das europäische Verbundnetz und die physikalischen

Randbedingungen für den Netzbetrieb plötzlich nicht zusammenpassten.

Auch im Winter 2011 auf 2012 war das Gleichgewicht zwischen Verbrauch und Erzeugung empfindlich gestört, als es durch den Konflikt zwischen Russland und der Ukraine zur verminderten Gasdurchleitung und damit einem Gasmangel in Süddeutschland kam. Wir waren kurz vor dem kritischen Punkt der Unterfrequenz, bei dem dann alle verfügbaren Kraftwerksreserven ans Netz gebracht werden und bereits erste große Verbraucher abgeschaltet werden, um ein weiteres Absinken der Frequenz zu verhindern, das ungebremst nach sehr kurzer Zeit zu einem Netzzusammenbruch führen

kann. Es gab helle Aufregung in der Politik, daraufhin wurde eine Regelung zur Abschaltung energieintensiver Industrie im Falle besonderer Herausforderungen geschaffen. Allein in 2018 wurden Teile der Aluminiumindustrie über diese Maßnahme 78 Mal abgeschaltet. Das waren

zwar keine Katastrophenszenarien, aber man hat in diesen Zeiten gemerkt, dass die Regelleistung nicht mehr ausreicht und der Markt die Lücke nicht schließen kann. Zum vergangenen Jahreswechsel gab es auch eine plötzlich auftretende Unterdeckung von 6 GW, die man ausgleichen konnte, weil die Kraftwerke nicht auf Höchstlast waren. Am 10. Januar gab es eine Situation, in der die Frequenz in wenigen Minuten, quasi aus dem Nichts, bis auf 49,8 Hertz abgesunken ist. 14 Tage später gab es das gleiche Phänomen in die

andere Richtung. Bis heute weiß in diesen Fällen niemand, worin genau die Ursachen lagen. Der Netzbetrieb in Europa ist durch die beliebige Ein- und Ausspeisung hochgradig wacklig geworden. Das wird weiter zunehmen.

Im Kommissionsbericht steht, dass auch die Nachbarländer aus der Kohle aussteigen, ist ganz Europa auf dem Holzweg?

Die Nachbarn weniger. Um einen deutlichen Vergleich zu bedienen, schauen wir mal etwas weiter nach China. Dort gibt es auch viel Kohle und eine ähnliche EEGQuote wie in Deutschland. Es gibt aber einen wesentlichen Unterschied. Dreiviertel von Chinas EEG-Quote entstammen sicherer

Wasserkraft und nur ein Viertel Wind und PV. Bei uns sind es 90 % Wind und PV. Andere Länder haben einen anderen Mix, Deutschlands Weg folgt niemand.

Ist einmal durchgerechnet worden, was die

Energiewende kostet?

Was immer man rechnet, es gibt einfach zu viele Unklarheiten und aktuell läuft man bei der Energiewende in Deutschland Lemmingen gleich einer Religion hinterher. Die Politik wird die Physik erst akzeptieren, wenn 2022 eine Situation eintritt, in der der Markt nicht liefern kann. Man sagt da immer schnell, dass so ein größerer Blackout vielleicht auch „heilsam“ wäre, man darf aber nicht vergessen, dass ein großflächiger und langanhaltender Blackout

in Deutschland unvorstellbar schlimm werden würde. Der Bundestag hat hierzu mal 2011 eine große Studie in Auftrag gegeben, die man auch mit etwas Suchen herunterladen kann. Dort wurde alles zumindest für den ersten Tag des Blackouts sehr detailliert untersucht – und wer das gelesen hat, möchte das nicht erleben.

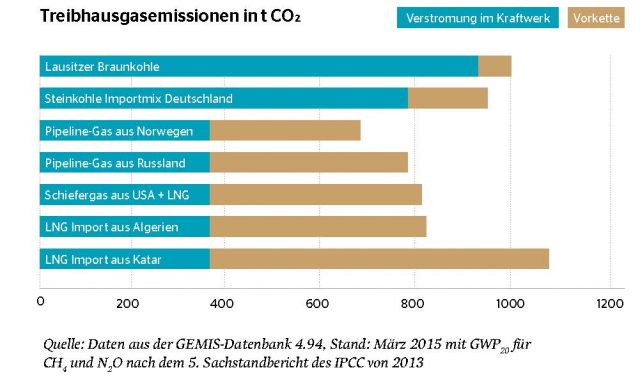

Warum gibt es keinen Aufstand aus der Wissenschaft?

Das Thema ist zu komplex für die heutige Medienlandschaft, es fehlt in unserem Land

der Resonanzboden. Große Teile der Gesellschaft sind darauf eingeschworen, die Welt zu retten, auch wenn unser Anteil an den globalen Emissionen nur 2,7 % beträgt.

Was würden Sie vorschlagen?

Im Abschlussbericht der Kommission sind Jahreszahlen für ein Monitoring festgelegt worden. Man müsste allerdings definieren, wie man genau ein Monitoring ansetzt, um die Sicherheit der Stromversorgung im Allgemeinen

und der Netze im Besonderen zu bewerten. Bei der Stromversorgung ist

das m.E. die gesicherte Kraftwerksleistung und bei den Netzen z.B. die Eingriffe nach §13 und 14 EnWG, da diese dann aktiviert werden, wenn eine Überlastung der Netze durch regenerative Überspeisung verhindert werden muss. Dazu braucht es eine Kommission, in der tatsächlich Experten zur Versorgungssicherheit zusammenkommen. Die bisherige WSB-Kommission ist dafür fachlich nicht qualifiziert. Ich habe aber wenig Hoffnung für ein Umdenken. Über das Lockmittel „Strukturhilfen“ wird das Thema „Versorgungssicherheit“ völlig ausgeblendet.

Eine große Bedeutung misst der Bericht der Kommission der Lausitzer Hochschullandschaft als Motor des Strukturwandels bei. Teilen Sie diese Ansicht?

Hier sollen die neuen Institute Impulse liefern. Das Fraunhofer und das DLR-Institut werden wohl bis Ende 2019 formal vor Ort sein und dann in zwei bis

drei Jahren hochfahren. Wir können da sicher sehr gut kooperieren. In drei Jahren sollte die Mannschaft pro Institut um die 50 Personen betragen. Mit Blick auf den WSB-Bericht geht es sicher darum, wie eine Hochschule Arbeitsplätze in der Industrie induzieren kann. Bis aus einer Idee eine Fertigung wird, das dauert. Ernsthaften Ersatz für Industriearbeitsplätze

in Größenordnungen allein aus der Hochschule heraus sehe ich als unrealistisch. Da brauchen wir Investoren, für die eine Hochschule, die Ideen und gut qualifizierte Absolventen liefert zwar ein positives Add-on ist. Entscheidungen zu Investitionen in neue Fertigungsstandorte in der Lausitz werden aber nach anderen Kriterien gefällt.

Dennoch erhält die BTU mit den Instituten Rückenwind, gibt es derzeit eine Aufbruchstimmung?

Wir müssen erst einmal schauen, was konkret hinter den neuen Einrichtungen steckt. Fraunhofer muss später Drittmittel einwerben und eigenes Geld verdienen. Da muss man schauen, ob sie in Konkurrenz zu Aktivitäten bestehender BTU-Lehrstühle arbeiten. Da die beiden neuen Institute in

den Bereich der thermischen Energietechnik gehen wollen, können die BTU-Lehrstühle der elektrischen Energietechnik hier sehr gut anknüpfen, der gerade in der Wiederbesetzung befindliche Lehrstuhl für Thermische Energietechnik an der BTU ist allerdings im gleichen Feld wie die neuen

Institute aktiv. Hier kann es zu Überschneidungen kommen.

Sehen Sie die BTU für eine Begleitung des Lausitzer Wandels gut aufgestellt?

Wir haben einen extrem geringen Wert bei wissenschaftlichen Mitarbeitern. Die RWTH Aachen hat meinen Bereich „Energieverteilung und Hochspannungstechnik“ z.B. in zwei Institute mit je sechs wissenschaftlichen und von der Uni bezahlten Mitarbeitern aufgesplittet. Diesen zwölf Wissenschaftlern im Mittelbau stehen bei mir zwei gegenüber, wir reden

also über ein Verhältnis 1:6! Daran merkt man, welchen Vorteil das Rheinische Revier beim Strukturwandel mit der RWTH Aachen gegenüber dem Lausitzer Revier auch in diesem Bereich hat. Wir haben mangels Manpower nicht die Option, viele Anträge vorzubereiten. Gemeinsam mit DRL und Fraunhofer sind Lösungen denkbar, aber auch hier wird es mit dem schmalen Mittelbau schwer.

Welchem Projekt Ihres Lehrstuhls trauen Sie für den Strukturwandel den größten Effekt zu?

Es gibt viele spannende Themen, am Ende geht es aber schlicht darum, für welche wir Geld erhalten. Deshalb machen wir aktuell viel zur Netzintegration Erneuerbarer Energien und Elektromobilität. Ein weiteres Thema ist der BTU Smart Campus. Aber was kann ein Lehrstuhl mit zwei wissenschaftlichen Mitarbeitern für die Lausitz bewegen? Es wäre sicher sinnvoll, den Power System Simulator an meinem Lehrstuhl mit dem LEAG-Kraftwerkstrainer

zu verknüpfen, um so ein singuläres Kompetenzzentrum aufzubauen. Dazu braucht es aber Geld, Zeit und Personal – oder einen externen Partner, der in das Projekt mit einsteigt.

Was müsste sich an der BTU verändern?

Das neue Fraunhofer bzw. DLR-Institut haben je einen Umfang von 50 Mitarbeitern. Dem steht bei uns ein Professor mit zwei wissenschaftlichen Mitarbeitern gegenüber. Viele Planstellen für den wissenschaftlichen

Mittelbau sind hier verschwunden und irgendwo im Stab der Hochschulleitung gelandet. Wenn nun alle oben koordinieren und unten keiner mehr zum Arbeiten da ist, wird das problematisch. Fraunhofer und DLR

marschieren mit 100 Planstellen in einen Bereich, in dem die BTU aktuell zwei Professoren mit jeweils zwei Mitarbeitern einsetzt.

Wir danken für das Gespräch.

EIKE dankt dem Reviertransfer für die Genehmigung, seinen Beitrag ungekürzt auch in unseren News zu bringen.