Auf WATTSUPWITHTHAT hatte der amerikanische Physiker und Dozent an der Duke Universität von North Carolina, Dr. Robert Brown, den Beitrag "Was wir über den Energiefluss der Erde nicht wissen" veröffentlicht, der eine rege Diskussion auslöste. Auf viele Einwände jener Diskussion schrieb Dr. Robert Brown einen längeren Aufsatz. Anthony Watts hält Dr. Browns Ausführungen zur angeblich vom CO2 bedrohten Klimastabilität für so kenntnisreich, dass er den gesamten Beitrag auf WATTSUPWITHTHAT gesondert veröffentlichte.

Im einleitenden Satz zitiert Dr. Brown eine Behauptung aus einem der vielen Kommentare zu "Was wir über den Energiefluss der Erde nicht wissen".

Keine neuen „strange attractors“: Aussagekräftige Indizien gegen die positive Rückkoppelung und die Katastrophe

von Dr. Robert Brown

Man muss schon feststellen, dass beide Systeme innerhalb der gleichen Parameter oszillieren, aber die Wahrscheinlichkeit der Synchronisation zwischen ihnen ist nil?

Leider nein, nicht über lange Zeiträume. Systeme können so verschieden sein, wie ein magnetisierter Ferromagnet, der in einer Richtung magnetisiert ist, sich von einem identischen Ferromagneten unterscheidet, der in umgekehrter Richtung magnetisiert ist. Oder im Falle der Erde, die als eiszeitliche Erde völlig unterschiedlich sein kann von einer zwischeneiszeitlichen Erde. Der Punkt ist, dass beide Zustände “stabil” sein können, bei genau der gleichen Einstrahlung, weil die Rückkoppelung im globalen System sie zu einem stabilen Zustand rekonfigurieren kann.

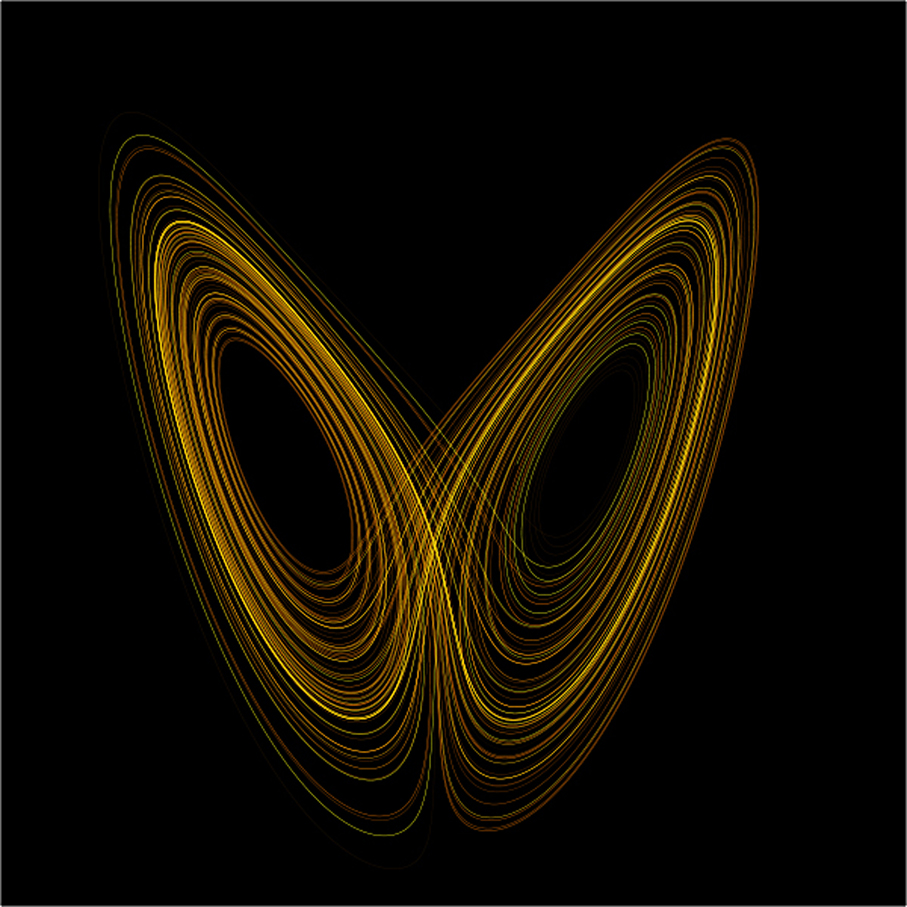

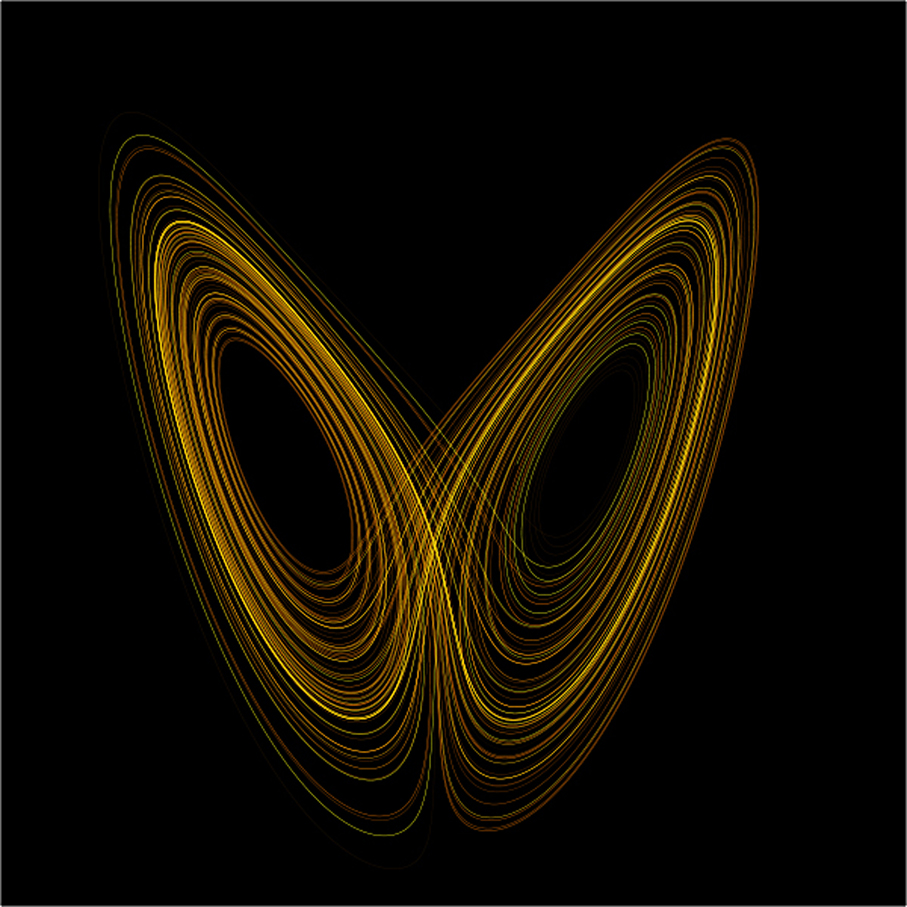

Wenn Sie in dem hier angegebenen Link to chaos theory die beiden Figuren mit den geschlossenen Linienbündeln anschauen, sehen Sie ein heuristisches Bild der Art von Möglichkeiten, die ein gekoppeltes nichtlineares Differential-System hat.

Eine Darstellung der Lorenz-Attractoren für Werte r = 28, σ = 10, b = 8/3 (aus Wikipedia

Mitten in jeder Schleife ist ein sogenannter “strange attractor“, der typischerweise ein „limit point“ ist. Die x und y – Achsen sind Koordinaten in einem generalisierten (Phasen-) Raum, der den Zustand des Systems zu jedem gegebenen Zeitpunkt repräsentiert: x(t), y(t). Die Linien selbst sind der Bahnverlauf des Systems über die Zeit, wie es sich unter der Einwirkung der zugrundeliegenden Dynamiken entwickelt. Mit der Figur soll illustriert werden, dass es keinen einzigartigen Umlauf gibt, mit dem die Erde einen regulären Attractor wie die Sonne umkreist: Das System oszilliert eine Zeitlang um einen Attractor, dann um den anderen, dann um beide. Anstelle von schönen geschlossenen Bahnverläufen haben wir Verläufe, die fast niemals gleich sind.

Zwei Bahnverläufe, die in kurzem Abstand hintereinander gestartet wurden, werden normalerweise die Attractoren anfänglich auf diese generelle Art umkreisen. Aber allmählich, oft schon bemerkenswert rasch, werden beide Bahnverläufe voneinander abweichen. Eine Bahn wird auf den anderen Attractor überspringen, eine andere nicht. Nach erstaunlich kurzer Zeit werden die beiden Bahnverläufe fast völlig de-korreliert sein, dergestalt, dass das Wissen um die Lage der einen Bahn (im allgemein zugänglichen Raum der Phase) überhaupt keine Hinweise zur Lage der anderen gibt.

Nur in diesem Sinne trifft die eingangs zitierte Behauptung zu. Jedes der Systeme muss im Raum der physikalisch konsistenten Zustände durch Differenzierung vom Startpunkt aus aufgefunden werden. Es gibt keine Garantie, dass die Bahnen den “Phasenraum füllen” werden. Nur in diesem Sinne können beide in dem von den Ausgangspunkten aus zugänglichen Phasenraum gefunden werden. Wenn die beiden Startpunkte dicht genug beieinander liegen, werden sie vermutlich zu sehr ähnlichen Phasenräumen führen, aber es gibt keine Garantie, dass diese identisch sein werden – besonders, wenn es (viel) mehr als zwei Attractoren gibt und irgendeinen einfachen Parameter. In der Statistischen Mechanik gibt es ein Theorem hierzu, aber meines Wissens nicht für den allgemeinen Fall der offenen Systemdynamik eines chaotischen Systems.

Wen es interessiert – das Herumspielen damit kann ganz spaßig sein – sollte mal bei den “predator-prey differential equations” vorbeischauen.

Wenn ich mich recht erinnere, befindet sich dort eines der einfachsten Systeme mit einem Attractor und begrenztem Durchlauf und es zeigt viele der Eigenschaften von komplizierteren dynamischen Systemen. Der Attractor/fixed point in diesem Falle ist die Population von z. B. Füchsen und Kaninchen, die von Jahr zu Jahr in perfektem Gleichgewicht bleibt. Man beachte wohl, dass diese Gleichung deterministisch ist. In einer echten Population – selbst wenn sie modelliert ist – gibt es natürlich immer zufällige (oder zumindest “unvorhersehbare”) Variationen – das ist ein gewisser Anteil von Rauschen -, der in diskreten, nicht in stetigen Werten angegeben wird, weil es z.B. keinen Geparden geben kann, der pi Paviane frißt.

Eine bessere stetige “Form” einer Differentialgleichung zur Beschreibung von Systemen mit Rauschen ist die Langevin-Gleichung in der Physik – ein System mit “schnellen” mikroskopisch kleinen Freiheitsgraden, auf das man sich verlässt bei der Durchschnittsbildung mit einem stochastischen Term und langsameren Freiheitsgraden, die man herausintegriert wie bei der „predator prey“- Gleichung. In der Physik gibt es den speziellen limitierenden Fall von etwas, was dann die verallgemeinerte „Master-Gleichung“ genannt wird. Das ist die vollständige integro-differentiale Beschreibung eines „many body open quantum systems”; Sie ist wirklich sehr sehr schwierig. Der allgemeinere Ansatz ist hier aber gangbar – vermutlich ist er Teil der meisten vereinfachten Klimamodelle. Wenn man die Temperaturverläufe “glättet”, z. B. mit Hilfe eines laufenden Durchschnitts, verliert man Information (die Variationen über kurze Zeitspannen) und man reduziert die Komplexität des Systems durch die Konzentration auf eine langsamere Dynamik auf der Zeitskala.

Das ist zulässig, wenn das System wirklich einfach ist: d.h. es gibt nur einen einzigen Attractor und das System oszilliert um ihn, das Ausglätten des “Rauschens” ist irrelevant und fügt dem einzigen Bahnverlauf nur kleine Variationen zu. Wenn aber das System multistabil mit vielen örtlichen Stabilitätspunkten ist; oder noch schlimmer, wenn einige der Freiheitsgrade Dinge wie die Sonne sind, deren zeitliche Entwicklung völlig außerhalb “des Systems” liegt, dessen Zukunft unversagbar ist, und dessen Auswirkung man nicht genau kennt, dergestalt, dass sich die Attractoren selbst umherbewegen, wenn sich das System lokal entwickelt, – dann ist das wahrscheinlich nicht zulässig.

Das Symptom eines multistabilen Systems der letzteren unzulässigen Art ist eine Folge von durchbrochenen Gleichgewichten, sichtbar in den geglätteten Daten. Die 30-jährigen Satellitendaten und die Meeresoberflächendaten (Sea Surface Temperatures) zeigen dieses Bild ziemlich klar.

Und hier ein sehr wichtiger Punkt: oszillierende Systeme haben fast immer negative Rückkoppelung. Das ist die grundlegende Eigenschaft, die ein oszillierendes System bestimmt: es besitzt selbst eigene Attractoren. Die eigenen Attractoren sind Stabilitäts-(Gleichgewichts-)Punkte dergestalt, dass das System immer wieder zurück in den Gleichgewichtszustand gezogen wird und nicht weg davon, wenn es von ihnen gestört wird.

Im allgemeinen Falle von Attractoren in hochdimensionalen Räumen führt das zu (Poincare-) Zyklen um die Attractoren herum, wie sie in den “predator-prey”-Gleichungen sichtbar werden, oder in der Chaos-Figur mit zwei „strange attractors“, mit der Ausnahme, dass diese in 3+ dimensionalen Räumen sehr, sehr kompliziert werden können (nur schwierig zu veranschaulichen). Mit dimensionalen Räumen sind keine physikalischen Räume gemeint, sondern parametrische “Phasen”-Räume (Zustandsräume).

In der Nachbarschaft eines Attractors gibt es im Allgemeinen viel lokale Stabilität – Bahnverläufe in solcher Nachbarschaft schwingen eng angelehnt um den Attractor und springen relativ selten auf andere Attractoren um. Deshalb tendieren eiszeitliche und zwischeneiszeitliche Perioden zu recht langen Zeiträumen (im Vergleich zu all den vielen kürzeren Zeitspannen, die im System verfügbar sind).

Das Bewegen eines zugrundeliegenden externen Parameters – z. B. der anthropogenen CO2-Konzentration, des Zustands der Sonne, des geomagnetischen Zustands – kann als Verschiebung der Festpunkte des multistabilen Systems gedacht werden. Wenn wir das linearisieren, können wir oft wenigstens die Richtung der ersten Ordnung der Bewegung abschätzen. Mehr CO2 z. B., sollte unter der Annahme des Treibhauseffekts zum Einfangen von mehr Wärme führen und damit die globale Temperatur erhöhen. Der stabile Festpunkt sollte sich daher ein wenig in Richtung „wärmer“ verschieben.

Fast das gesamte Argument bewegt sich um zwei einfache Probleme herum (und das in mehr als einer Weise). Beachten Sie, dass ich diese Probleme ganz anders als gewohnt darstelle:

a) Ist die Vermutung eines linearen Verhaltens gültig?

Das ist keine triviale Frage. Erhöhtes CO2 in einem multistabilen System bewegt nicht nur den lokalen Attractor, es bewegt alle Attractoren, und das nicht notwendigerweise auf simple lineare Art in einem wirklich komplizierten System mit vielen negativen Rückkoppelungen (die Hypothese erfordert eine Bewegung über den gesamten Ort, weil das System von Attractoren bestimmt wird). In vielen Systemen befinden sich bewahrende Prinzipien (nicht notwendigerweise bekannte), die als Beschränkungen derart wirken, dass durch die Aufwärtsbewegung eines Attractors ein anderer nach unten bewegt wird. Oder die “Schwellenhöhe” zwischen zwei Attractoren wird erhöht und damit alle begrenzenden Zyklen deformiert.

b) Liegt die Systemreaktion in der Größenordnung der mittleren Differenz zwischen den Attractoren, die vorwiegend schon vom System „gesampled“ sind?

Falls sie größer ist, wird das System wahrscheinlich nicht den wirkenden Attractor bewegen, sondern auf einen anderen Attractor überkippen. Das muss nicht der erwartete Attractor auf der wärmeren Seite des vorhergehenden sein. Mehr Erwärmung – wie die Warmisten in eher heuristischen Termini sagen – kann das System zu mehr unkontrolliertem Schwingen bringen und dabei wärmer als der wärmste Teil der Schwingung sein und kälter als der kälteste. Falls der neue Ausschlag der Schwingung groß genug ist, kann er das System auf beiden Seiten zum Schwingen um einen neuen Attractor stoßen.

Man beachte, dass die letzte Behauptung noch zu einfach ist, weil sie danach klingt, als ob es nur zwei Richtungen gäbe: wärmer oder kälter. Das ist nicht der Fall. Es gibt wärmer mit mehr Wasserdampf in the Atmosphäre, wärmer mit weniger Wasserdampf in the Atmosphäre, wärmer mit aktiver Sonne, wärmer mit nicht aktiver Sonne, wärmer mit zunehmendem Meereis, wärmer mit abnehmendem Meereis, wärmer mit mehr Wolken, wärmer mit weniger Wolken, und die Wolken können Tages- oder Nachtwolken sein, arktische or antarktische Wolken, im Sommer, Herbst, Winter oder Frühling, monats- oder tageweise, überall mit Rückkoppelungen – das Herumfingern an jedem beliebigen Aspekt des Zyklus wirkt auf alles Andere. Das war erst der Anfang einer Auflistung der gesamten wichtigen Dimensionen. Beachten Sie auch, dass es wirklich wichtige zeitliche Skalen mit fast periodischen Oszillationen von vielen dieser Treiber gibt, und auch, dass die zu Grunde liegende Dynamik auf einem rotierenden Globus stattfindet, der im ständigen Verlauf Luftwirbel erzeugt, deren Beständigkeit von Tagen bis zu Jahrzehnten reicht.

Ich habe in früheren Beitragen argumentiert, dass das in der Klimahistorie erkennbare durchbrochene Quasi-Equilibrium es sehr wahrscheinlich macht, dass die Antwort auf b) JA ist. Das anthropogene CO2 verschiebt das System um die Größenordnung des Abstands von einem oder mehr Attractoren, weil das System um die Attractoren herumspringt, sogar zu Zeiten, als es noch kein anthropogenes CO2 gab. Und weiter, die Ausreißer des Systems bei seinem Wechsel zwischen den Attractoren waren ebenso groß wie heute und qualitativ nicht anders.

Dies ist ein starkes Indiz, dass der Effekt geringer, und nicht größer ist als die natürliche Schwingungsbreite. Die negativen Rückkoppelungsfaktoren, die die multistabilen Attractoren (lokal) zur Wirkung bringen, wirken auch als negative Rückkoppelung auf die CO2-induzierte Verschiebung! Diese Aussage steht, ob nun die Annahme der Gültigkeit der Existenz einer linearen Antwort (pro Attractor) in a) zutrifft oder nicht, und die zusätzlich noch mit dem riesigen Problem der Beweisführung behaftet ist.

Das letztere ist das Fluktuations-Dissipations-Theorem, wie ich schon in dem einen oder anderen Beitrag gesagt habe. In einem offenen System in lokal stabiler Phase koppeln sich die Oszillationen (fluctuations) mit der Dissipation dergestalt, dass erhöhte Fluktuation zu mehr Dissipation führt – das ist negative Rückkoppelung. Falls das nicht zuträfe, wäre die lokal stabile Phase nicht stabil.

Das ist ein starkes Argument gegen die Katastrophe! Wenn es unter der Annahme, dass CO2 nur kleine, langsame, lokale Verschiebungen der Attractoren untereinander bewirkt im Vergleich zu den großen Schwüngen des Systems; wenn es einen Punkt gäbe, wo das System wahrscheinlich auf einen viel wärmeren stabilen Punkt überspringen würde (die von den Warmisten angedrohte “Katastrophe”), dann hätte das fast mit Sicherheit bereits geschehen müssen. Denn die Phasenschwingungen der vergangenen zehntausend Jahre haben schon viele Male zur gleichen Wärme geführt wie heute.

Die Tatsache, dass es nicht geschehen ist, ist wirklich ein ganz starker Beleg gegen die Behauptung einer positiven Rückkoppelung und einer Katastrophe. Ja. anthropogenes CO2 könnte die Attractor-Temperaturen ein wenig nach oben geschoben haben, es könnte auch kleinere Anpassungen in der Anordnung der Attractoren verursacht haben, aber es gibt kein Indiz dafür, dass es wahrscheinlich und plötzlich einen neuen Attractor außerhalb der normalen, von der Klimahistorie gezeigten Variationsbreite, erzeugen würde. Wäre es unmöglich? Natürlich nicht, aber nicht wahrscheinlich.

Ich möchte eine kleine Analogie anschließen

Als die Physiker sich auf den Test der ersten Atombombe vorbereiteten, wurden damals von weniger begabten Physikern Bedenken geäußert, dass die Erdatmosphäre „in Brand gesetzt”, oder die Erde in eine Sonne verwandelt werden könnte (Das war, bevor die Kernfusion verstanden war – auch der Energie-Zyklus der Sonne war noch unbekannt). Jüngst habe ich von Befürchtungen gelesen, das Kollisionen im Großen Hadronen-Speicherring den gleichen Effekt haben könnten – nämlich die Erzeugung eines Mini-Schwarzen Lochs oder so ähnlich, das die Erde verschlingen würde.

Das sind törichte Ängste (obgleich sie von wirklichen Wissenschaftlern geäußert werden, weil sie Derartiges für möglich und vorstellbar halten).

Warum sind solche Ängste töricht

Die von einer Atombombe erzeugten Temperaturen und Drücke sind nicht einzigartig! Wenn auch selten, so fallen doch Asteroiden auf die Erde und erzeugen dabei viel höhere Drücke und Temperaturen als Atombomben. Ein kleinerer Asteroid kann in wenigen Millisekunden mehr Energie freisetzen als das Zehntausendfache der gesamten Sprengkraft aller menschengemachten Explosivmittel auf der Erde, einschließlich der Kernwaffen. Kurz gesagt: wenn etwas mit einer gewissen vernünftigen Wahrscheinlichkeit passieren könnte, wäre es schon passiert.

Das gleiche gilt für die Furcht vor dem Großen Hadronen-Speicherring, oder anderen “Super-” Teilchenbeschleunigern. Ja, sie erzeugen Kollisionen in der Größenordnung von Elektronen-Teravolt, aber diese Art von Energie bei nuklearen Kollisionen ist nicht einzigartig! Die Erde wird ständig von hochenergetischen Partikeln bombardiert, die von energetischen Extrem-Ereignissen hervorgerufen wurden, wie den Supernovae, die sich vor langer Zeit ereigneten. Die Energien dieser kosmischen Strahlen sind viel höher als alles, was wir jemals in Labors produzieren können, es sei denn, wir könnten eine Supernova machen. Das bislang höchstenergetische beobachtete kosmische Teilchen war (vermutlich) ein Proton mit der kinetischen Energie eines wuchtig geschlagenen Baseballs, der rund 150 Km/h erreicht. Weil wir eins davon während mehrerer Beobachtungs-Jahrzehnte entdeckt haben, müssen wir annehmen, dass sie ständig kommen – buchstäblich trifft jede Sekunde ein kosmischer Strahl mit dieser Energie die Erde irgenwo (Die Erde ist ein RIESIGES Ziel. Wenn solch eine Kollision mit einer gewissen Wahrscheinlichkeit ein Schwarzes Loch mit der Kraft zur Planetenzerstörung erzeugen könnte, dann wären wir schon vor langer Zeit zu Staub geworden.

Es bleibt daher töricht, den Großen Hadronen-Speicherring oder nukleare Brandstiftung zu fürchten. Falls dies wahrscheinlich wäre, gäbe es uns nicht, die wir einen Großen Hadronen-Speicherring oder Atombomben bauen.

Die Furcht vor dem Klimawandel ist nicht ganz so töricht

Es ist aber nicht ganz so töricht den CO2-anthropogenen Klimawandel zu fürchten. Es stimmt: Wir haben noch nicht lange genug das Klimasystem erforscht, um zu wissen, welche Arten von Rückkoppelungen und Faktoren die multistabilen Klima-Attractoren strukturieren. Deshalb kann man sich seine Weltuntergangsszenarien basteln – Erwärmung bis auf einen kritischen Punkt, der massive Mengen von Methan freisetzt, was zu einer schlagartigen Erderwärmung führt. Das Meer wird sein gesamtes CO2 freisetzen, die Eiskappen werden schmelzen und die Meere kochen. Plötzlich wäre unsere Erde wie die Venus mit einer mittleren Außentemperatur von 200 oC.

Wenn wir uns so etwas ausdenken und niederschreiben können, dann muss es möglich sein, nicht wahr? Science-Fiction Romane in Massen beschäftigen sich genau damit. Oder Filme mit dem Gegenteil: dem Auftauchen von Attractoren, die irgendwie und sofort die gesamte Erde zum Einfrieren bringen und eine Eiszeit verursachen. Schaut, es kann passieren!

Aber ist es wahrscheinlich?

Das oben Gesagte sollte uns ruhig schlafen lassen. Es gibt kaum etwas in der Klimahistorie das auf einen anderen großen stabilen Zustand hindeutet, auf einen anderen Haupt-Attractor, der weit über dem derzeitigen Warmphasen-Attractor läge. Ganz im Gegenteil: die Klima-Geschichte der vergangenen zig Millionen Jahre deutet darauf hin, dass wir uns mitten in einer verlängerten Abkühlungsphase des Planeten befinden, wie sie sich wiederholt während geologischer Zeiträume ereignete, und wir befinden uns im Haupt-Attractor der warmen Phase. Darüber gibt es nichts mehr. Wenn da noch etwas wäre, hätten wir es schon erlebt.

Stattdessen: Die lokalen Variationen und die Oszillation um sie herum hat den vielen kleinen Warmphasen-Attractoren erlaubt, wiederholt Bedingungen zu zeigen, die einen Sprung hätten hervorrufen können, wenn ein solcher überhaupt wahrscheinlich gewesen wäre.

Zumindest müsste es eine Spur von so etwas in der Temperaturhistorie der vergangenen Millionen Jahre geben, aber sie gibt es nicht. Wir sind in einer der längsten und wärmsten der uns bekannten fünf Zwischeneiszeiten. Wir befinden uns nicht am wärmsten Punkt der gegenwärtigen Zwischeneiszeit, dem Holozän. Wenn es wirklich einen wärmeren Attractor gäbe, hätte er sich wahrscheinlich bereits am wärmsten Punkt des Holozäns gezeigt.

Weil das nun wirklich nicht geschehen ist, können wir davon ausgehen, dass die gesamte Rückkoppelung sicher negativ ist, und dass alle “Katastrophe-Hypothesen“ relativ unwahrscheinlich sind.

Wir sollten uns stattdessen eher wegen einer katastrophalen globalen Abkühlung Sorgen machen. Wir wissen, dass es einen Kaltphasen-Hauptattractor von etwa 5-10 oC kühler als heute gibt. Die menschliche Zivilisation ist im Holozän entstanden, und wir sind noch nicht so weit, dass wir einen Umschwung zu eiszeitlichen Konditionen überleben könnten, jedenfalls nicht ohne den Tod von 5 Mrd Menschen und einem wahrscheinlichen Fast-Kollaps der Zivilisation. Wir wissen, dass dieser Übergang nicht nur vorkommen kann, sondern dass dies geschehen wird. Wann, wissen wir nicht, auch nicht, warum, oder wie wir seine generelle Wahrscheinlichkeit abschätzen könnten. Wir wissen ganz bestimmt, dass die Kleine Eiszeit – nurmehr 400-500 Jahre her – die kälteste Periode im gesamten Holozän nach dem jüngeren Trias-Ausreißer war. Ganz allgemein sieht es so aus, dass sich das Holozän von seiner wärmsten Periode her abzukühlen scheint, und das 20. Jh. hat ein Großes Solares Maximum mit der aktivsten Sonne seit 11.000 Jahren erlebt. Dieses Maximum ist nun vorbei.

Eher Kälte als Wärme

Ich fürchte, wir befinden uns in einer Instabilität, in welcher ein vollständiger Umschwung zu einer kalten Phase wahrscheinlicher ist als uns lieb sein kann, als dass wir uns einer superwarmen Phase näherten, für die es keine Anzeichen in der Klimageschichte gibt. Die Wahrscheinlichkeit für Kälte ist aus zwei Gründen höher:

(1) Anders als für eine superwarme Phase wissen wir: die Kaltphase existiert tatsächlich, und sie ist viel stabiler als die Warmphase. Die “Größe” der quasistabilen Poincare-Zyklus-Schwingungen um den Hauptattractor der Kaltphase ist viel größer als die um die Warmphasen-Attractoren, und kurze Erwärmungsphasen werden oft zequetscht, bevor sie sich in tatsächliche Zwischeneiszeiten wandeln können – daran kann man erkennen, wie stabil sie sind.

(2) Wir haben 90% unserer Zeit in einer eiszeitlichen Phase verbracht, nur 10% in einer Zwischeneiszeit. Das Holozän ist eine der längeren Zwischeneiszeiten! Wir verstehen die über lange Zeitskalen wirkenden Dynamiken noch nicht. Wir haben gerade mal eine erste unklare Idee, was den (im Wesentlichen chaotischen) Übergang von einer warmen in eine kalte Phase oder umgekehrt bewirkt – es gibt sehr vorläufige Ideen über Kombinationen von Milankovich-Zyklen, Neigungen der Ekliptik, Polwanderung, Erdumlauf-Resonanzen, usw. Aber es gibt eine deutliche starke Rückkoppelung innerhalb des Klimazyklus, die das „Umkippen“ in eine Kaltphase bewirken kann, vermutlich hat das etwas mit der Albedo zu tun.

Das könnte etwas so Einfaches wie eine stille Sonne sein; das Maunder-Minimum der Kleinen Eiszeit legt nahe, dass wir eine stille Sonne wirklich fürchten sollten, weil irgend etwas im nicht-linearen Differential-System kältere Attractoren während eines Maunder-artigen Minimums zu bevorzugen scheint (während man sich noch in der Phase des warmen Attractors befindet). Man muss sich vergegenwärtigen, dass der Übergang zur Vereisungszeit wahrscheinlicher am Tiefpunkt von z. B. einer Kleinen Eiszeit liegt, als zu irgend einem anderen Zeitpunkt. Das Holozän lebt vermutlich mit "geborgter" Zeit an einem Punkt, wo es ein Intervall von der Art einer verlängerten Kleinen Eiszeit umkippen könnte.

Eine neue KLEINE EISZEIT wäre schlimmer als eine Erwärmung

Auch nur eine KLEINE EISZEIT wäre eine weit größeres Unglück als alle Katastrophenvorstellungen der Warmisten. Die Weltbevölkerung ist enorm gewachsen seit der letzten Eiszeit. Eine riesiger Anteil lebt in gemäßigten Breiten und kultiviert dort das Land. Frühe Winter mit spätem Frühlingsanfang könnten das verfügbare kultivierbare Land vermindern und die Anzahl der Ernten halbieren, und das bereits vor der totalen Vereisung. Kalte (Warme) Phasen sind oft auch verbunden mit hitzebedingten und tropischen Dürren, zumindest in gewissen Weltteilen. Meines Erachtens könnte der “rasche” Beginn einer KLEINEN EISZEIT eine Milliarde Menschen umbringen, weil es Miss-Ernten in Sibirien, China, Canada und den nördlichen Vereinigten Staaten gäbe. Dies könnte leicht die angespannte politische Weltlage destabilisieren. Ein Weltkrieg würde unsere großen Übel noch mehr verschlimmern.

Wir könnten dann vielleicht wirklich erkennen, dass ein menschengemachter Klimawandel unsere Rettung wäre. Das durch unseren Zivilisationssprung emittierte CO2 könnte die nächste KLEINE EISZEIT abmildern oder verschieben, es könnte den Ausreißer in die Kalt-Phase verhindern und den Beginn der nächsten jahrzehnte- oder jahrhundertelangen WIRKLICHEN Eiszeit verhindern. Inzwischen könnten wir vielleicht zusammenarbeiten und uns Gedanken darüber machen, wie wir in einer zivilisierten Welt zusammenleben könnten, nicht nur in einigen zivilisierten Ländern mit Menschen im Wohlstand und den übrigen Ländern, wo die Menschen arm sind und von einer Handvoll Tyrannen oder religiösen Oligarchen versklavt werden.

Wohlgemerkt, letzteres ist “spekulative Fiktion”. Auch ich verstehe die Klimazyklen nicht völlig (Sie sind ein großes Problem). Aber zumindest kann ich Indizien für eine in der tatsächlichen Klimaaufzeichnung lauernde Katastrophe liefern, sie ist viel weniger “fiktiv” als ein CO2-verursachter Klimawandel.

Dr. Robert Brown; Universität von North Carolina,

Originalbeitrag hier

Übersetzung: Helmut Jäger, EIKE