Klimawissenschaft: Fehler von Fehlverhalten trennen

In einem kürzlich bei Climate Audit erschienenen Artikel wird untersucht, ob eine Graphik absichtlich oder unabsichtlich verkehrt herum dargestellt worden ist. In der Einleitung wird gefragt:

Spielt es eine Rolle, ob Proxys verkehrt herum verwendet werden oder nicht?

Vielleicht nicht in der Welt von Michael Mann (in der er als Erwiderung auf unsere Kritik bei PNAS behauptete, dass es für ihn unmöglich sei, Reihen verkehrt herum zu verwenden). Aber anders als Mann räumt Darrell Kaufman die Verantwortung ein, Proxy-Reihen in der richtigen Reihenfolge zu verwenden. Unglücklicherweise scheinen er und die PAGES2K-Autoren nicht sehr erpicht darauf zu sein sicherzustellen, dass sie das auch so machen.

Diese Story läuft parallel zur Tijander-Graphik, einer früheren Verkehrt-Herum-Präsentation in dem Debakel um den „Hockeyschläger“, der dazu erdacht worden ist, die Klima-Historie umzuschreiben dergestalt, dass die Mittelalterliche Warmzeit MWP aus den Statistiken eliminiert wird. Bei Climate Audit hat man sich auch die Tijander-Graphik vorgenommen und erschöpfend untersucht.

McIntyre und McKitrick (M&M) kommt der Verdienst zu, die von Mann et al. angewendeten ungeeigneten statistischen Methoden bloßgestellt zu haben, mit denen die Hockeyschlägergraphik erstellt worden ist. Diese hat ja den Missbrauch der Klimawissenschaft seitens des IPCC an das Tageslicht gebracht. Allerdings hat der große australische Skeptiker John Daly das größere Problem erkannt, bevor M&M die falschen Methoden bloßgestellt hatten. Ich empfehle dringend allen Menschen Dalys bemerkenswerte Analyse in seinem Artikel „The ‘Hockey Stick’: A New Low in Climate Science” zu lesen. Man beachte, dass dieser Artikel vor M&M erschienen war, findet sich doch darin keinerlei Querverweis auf deren Arbeit. Stattdessen handelt es sich dabei um eine synoptische Klimaanalyse dessen, was falsch ist.

Ich verstehe es so, dass McIntiyre den „Hockeyschläger“ auf einer Konferenz gesehen und ohne zu wissen, dass es eine Darstellung der globalen Temperatur sein sollte, aus seiner Erfahrung mit Statistik heraus sofort erkannt hat, dass es sich um eine potentiell manipulierte Darstellung handelt. Aus der Analyse von M&M geht klar hervor, mit welchen spezifischen Mitteln diese Graphik erzeugt worden ist. Eine Zeitlang kritisierten Kommentatoren auf der Website von McIntyre, dass dieser unwillig war zu sagen, dass Manns Aktionen absichtlich irreführend waren. Korrekterweise billigte ihm McIntyre zunächst das Recht auf Zweifel zu und ging davon aus, dass es bei ihm fehlendes Wissen und Verständnis war. Ethisch gibt es einen Unterschied zwischen einem Fehler und einem vorsätzlichen Fehler. Dies war Thema meiner Präsentation auf der 6. Heartland-Klimakonferenz in Washington D.C., aber dort kam das Argument, dass der gesamte IPCC-Prozess vorsätzlich war ebenso wie die Ergebnisse ihrer Computermodelle.

Der Missbrauch spezialisierter Methoden und Verfahren ist ein fundamentales Problem wegen der allgemeinen wissenschaftlichen Natur der Klimatologie. Die meisten sind Spezialisten nur in einer einzelnen Hinsicht und nennen sich dann fälschlich Klimawissenschaftler. Wenn sie versuchen, Stücke des riesigen Systems zusammenzufügen, müssen sie unvermeidlich zu unvertrauten Methoden und Verfahren greifen. Die Wahrscheinlichkeit eines Fehlers ist hoch. Dies ist höchst problematisch für Computer-Modellierer.

Das IPCC hat solche Spezialisten zusammengebracht und sie damit beauftragt, die Hypothese zu beweisen (anstatt sie zu widerlegen), dass die Menschen Grund für die globale Erwärmung (AGW) sind. Es war eine unheilige Allianz, die ein Umfeld von Missbrauch schuf. Sie fabrizierten wissenschaftliche Beweise in Fachbereichen, von denen sie kaum Ahnung hatten, und zwar mit Methoden und Verfahren, von denen sie sogar noch weniger Ahnung hatten. Mit massiven Finanzzuwendungen und politischer Unterstützung wurde dies zu einem Rezept für Katastrophen, wie es in den durchgesickerten E-Mails der Climate Research Unit (CRU) offenbar geworden ist. Das Ergebnis rechtfertigt die Mittel: man tue alles, was immer notwendig ist, um zu zeigen, dass menschliches CO2 die Ursache der globalen Erwärmung ist und dass die derzeitigen Temperaturen die höchsten jemals waren. CRU war eine kleine Gruppe und ein klassisches Beispiel von Gruppendenken, befeuert durch die Politik, wie ich seinerzeit hier erklärt habe.

Irving Janis erklärt das Konzept von Gruppendenken, welches Einmütigkeit erfordert auf Kosten von Entscheidungen hinsichtlich der Qualität. Ein kürzlich bei WUWT erschienener Beitrag befasste sich mit dem Problem des Gruppendenkens im Gebiet der Physik (hier):

Vom Gruppendenken betroffene Gruppen ignorieren Alternativen und tendieren dazu, irrationale Aktionen durchzuführen, die andere Gruppen entseelen. Eine Gruppe ist besonders verwundbar durch Gruppendenken, wenn deren Mitglieder einen ähnlichen Hintergrund haben, wenn die Gruppe abgeschirmt ist von externen Meinungen und wenn es keine klaren Regeln für die Entscheidungsfindung gibt.

Lubos Motl berichtete über den Kommentar von Benjamin Santer vom 25. April, in dem er sagte:

Ich schaute mir Einiges von dem Zeug bei Climate Audit an. Ich hatte wirklich das Gefühl, dass ich mal mit einigen dieser „Auditoren“ in einer dunklen Ecke reden sollte.

Dies ist der gleiche Santer, der als Leitautor einen zuvor abgesegneten IPCC-Bericht noch verändert hat. Avery und Singer schrieben im Jahre 2006:

„Santer hat im Alleingang die ,Klimawissenschaft‘ des gesamten IPCC-Berichtes auf den Kopf gestellt und damit auch den politischen Prozess bzgl. der globalen Erwärmung! Der vom IPCC proklamierte vermeintliche ,erkennbare menschliche Einfluss‘ wurde tausende Male in Medien auf der ganzen Welt zitiert und war der ,Stopper‘ in Millionen Diskussionen unter Nichtwissenschaftlern“.

Es ist kaum vorstellbar, dass Santer nicht wusste, was er tat. Als seine Änderungen öffentlich gemacht worden waren, wurde eine rapide Antwort erzeugt, die eine Vertuschung zu sein scheint. Zu den diesbezüglichen Aktionen folgt hier noch einmal mit kleinen Änderungen, was ich seinerzeit dazu geschrieben habe:

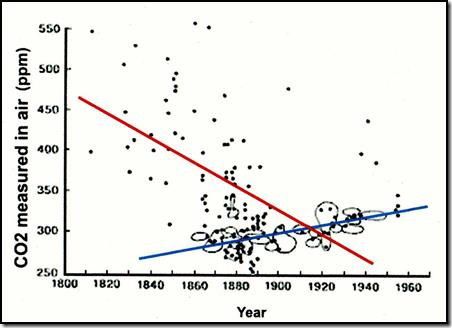

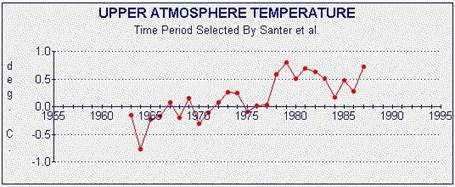

Am 4. Juli 1996, kurz nach der Enthüllung, wartete das offensichtlich willfährige Journal Nature mit einem Artikel auf unter der Überschrift A Search for Human Influences On the Thermal Structure of the Atmosphere”. Mitgeliefert wurde eine nur allzu bekannte Liste von Autoren – Santer, Wigley, Mitchell, Oort und Stouffer. Er bot beobachtbare Beweise, die zeigten, dass die Modelle akkurat waren. Eine Graphik ist so viel wert wie tausend Worte, wie Manns „Hockeyschläger“ zeigte, und genauso war es mit Santers ,erkennbarem menschlichen Einfluss‚. John Daly reproduzierte die Graphik von Santer et al. (Abbildung 1) mit dem aufwärts gerichteten Temperaturtrend in der oberen Atmosphäre:

Abbildung 1

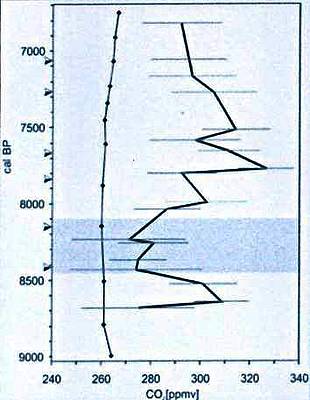

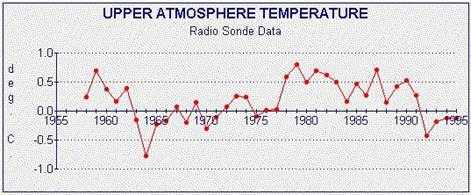

Dann erstellte Daly eine Graphik mit dem größeren Datensatz in Abbildung 2 und erklärte: „Wir erkennen, dass die in Santers Version erkennbare Erwärmung einfach das Ergebnis der ausgewählten Daten ist“ (Fettdruck von Daly):

Abbildung 2

Fast sofort wurden Fehler entdeckt, aber Nature hat sich mit der Veröffentlichung der Widerlegungen 5 Monate Zeit gelassen (bis zum 12. Dezember 1996), nachdem der oben besprochene Artikel veröffentlicht worden war. Einer erkannte die Rosinenpickerei, ein anderer stellte eine natürliche Erklärung für das Phänomen vor. Allerdings war zu jener Zeit die PR-Verschleierung bereits im Gange. Am 25. Juli 1996 sandte die American Meteorological Society AMS eine Brief der Verteidigung an Santer. Der Brief scheint den CRU-Einfluss zu beweisen und ist ein PR-Meisterstück. Es hieß darin, dass es zwei Fragen gebe, die Wissenschaft und was die Gesellschaft hinsichtlich der wissenschaftlichen Ergebnisse und der Debatte tun muss, die sie ausgelöst haben. Wissenschaft sollte nur in wissenschaftlich begutachteten Fachjournalen besprochen werden und nicht in den Medien. Dies war die in einer durchgesickerten E-Mail bestätigte Strategie von Mann. „Das war die Gefahr, die Skeptiker immer zu kritisieren, weil sie nichts in der ,begutachteten Literatur‘ veröffentlichen“. Darauf schrieb die AMS: Was zählt, ist wissenschaftliche Information und wie diese in politischen Debatten interpretiert wird. Das ist ein wichtiger Teil unserer Aufgaben. Das sind schließlich die wirklichen Gründe für die Vermischung von Wissenschaft und Politik im IPCC. Daly nannte das zu Recht „Wissenschaftismus“ [scientism].

Die Zurückweisung scheint zu belegen, dass Santer wusste, was er tat mit seinen Original-Änderungen des IPCC-Berichtes. Er wusste eindeutig um den willkürlich gewählten Start- und Endzeitpunkt der Graphik. Jeder Graph muss einen Start- und einen Endzeitpunkt haben, aber dieses Beispiel fand sich in einem Artikel, der geschrieben worden war, um die Bloßstellung seiner Umformulierungen zu verwerten.

Die Verteidigung von Santer erfolgte offensichtlich konzertiert und folgte einem Muster, das immer dann zur Anwendung kam, wenn Fehlverhalten ans Tageslicht gekommen war. Das Einspannen offizieller Agenturen zur Abdeckung des Fehlverhaltens erklärt vieles, warum das immer weiter betrieben wurde. Es erklärt auch, warum die Täter weiterhin glauben, dass sie nichts Falsches getan haben.

Phil Jones hat nach der Veröffentlichung der E-Mails die Polizei gerufen. Um die Behauptung eines Hacker-Angriffs zu stützen, musste er zugeben, dass sie echt waren. Die Ergebnisse waren bedeutungslos, weil sich die Untersuchung hinzog, bis das Statute of Limitations [?] ausgelaufen war. In einer dem widersprechenden Schlussfolgerung sagte die Polizei:

„Besonders die internationale Dimension, das World Wide Web zu untersuchen, hat sich als extreme Herausforderung erwiesen … Als Ergebnis unserer Ermittlungen können wir jedoch sagen, dass der Datendiebstahl das Ergebnis eines ausgeklügelten und sorgfältig orchestrierten Angriffs auf die Datensätze der CRU war, durchgeführt via Internet“.

Das ist einfach unglaubwürdig angesichts des Ausmaßes, mit dem gewöhnliche Bürger ausspioniert werden, und angesichts des Ausmaßes an Wissen, das erforderlich ist, um aus 220.000 E-Mails 1000 herauszufiltern. Es gibt drei Möglichkeiten: Sie sind inkompetent, absichtlich irreführend oder beides. Wie auch immer, es war zu langsam, um dem Glaubwürdigkeitsverlust der gesamten IPCC-Operation zu begegnen.

Als Folge wurden blitzartig fünf kontrollierte Untersuchungen initiiert, alle orchestriert, um irrezuführen und abzulenken. Hans von Storch schrieb über die 3 Untersuchungen in UK:

„Wir müssen uns selbstkritisch fragen, was da geschehen ist. Nichts darf unter den Teppich gekehrt werden. Einige der Untersuchungen wie in UK haben genau das getan. Sie haben eine Gelegenheit, Vertrauen wiederherzustellen, verpasst“*

[*Rückübersetzung aus dem Englischen].

Lord Oxburgh wurde berufen, eine der Untersuchungen zu leiten.

Oxburgh war kompromittiert, weil er ein Mitglied der Royal Society ist. Wichtiger aber ist, dass er leitender Direktor der Carbon Capture and Storage Association und Vorsitzender of Falck Renewable Resources ist, die sehr von der Behauptung profitieren, dass menschliches CO2 Erwärmung verursacht. Er befürwortete auch die Erwärmungs-Behauptung als Vizevorsitzender von GLOBE International in UK, einem Konsortium von Industrie, NGOs und der Regierung, die für die Politik zur globalen Erwärmung Lobbyarbeit leistet.

Es folgt eine Liste der Probleme bei der Oxburgh-Untersuchung:

Die Oxburgh-Untersuchung sollte die CRU-Wissenschaft untersuchen, aber um das zu tun, gab es a) keine öffentlichen Anhörungen und b) keine Anforderung von Beweisen.

Nur 11 akademische Studien wurden untersucht, eine Liste, die von Phil Jones unter die Lupe genommen worden war. Er war Direktor der CRU, also der Agentur, die untersucht werden sollte.

Interviews mit CRU-Mitarbeitern wurden nur hinter verschlossenen Türen durchgeführt.

Es gab keine Zusammenkunft mit CRU-Kritikern.

Die UEA hatte die effektive Kontrolle über die gesamte Untersuchung.

Das Select Committee des Unterhauses in UK hat Oxburgh hinsichtlich der Oberflächlichkeit seiner Studie und seines Berichtes sowie seiner versprochenen Begutachtung der Wissenschaft in die Mangel genommen.

Mehr Informationen hierzu gibt es in der detaillierten Zusammenfassung der Grenzen aller Untersuchungen bei Andrew Montford. Die Untersuchung von Muir Russell war so schlecht, dass selbst Guardian’s Fred Pearce schrieb:

„Geheimniskrämerei stand bei der CRU auf der Tagesordnung. Wir fanden, dass es dort ein konsistentes Verhalten gab, nicht dem gebotenen Grad an Offenheit zu folgen, heißt es in dem Bericht. Diese Kritik richtet sich nicht nur an Jones und sein Team an der CRU. Sie richtet sich genauso an die Universität selbst, die empört sein könnte, sich selbst genauso im Schlamassel zu finden wie die Wissenschaftler, über die zu richten Russell beauftragt worden war“.

Jeder macht Fehler in der Wissenschaft, aber normalerweise werden diese im idealerweise unpersönlichen und professionellen Begutachtungsprozess gefunden. In Santers Fall haben seine Mitautoren die Begutachtung durchgeführt. Er hat beschlossen, deren Bedenken beiseite zu schieben und wurde erwischt. Der Artikel zum Hockeyschläger war begutachtet, aber wie Prof. Wegman in seinem Bericht an ein Komitee des Kongresses schrieb:

In unserer weiteren Erkundung des Netzwerkes der Autoren der Temperatur-Rekonstruktion fanden wir, dass mindestens 43 Autoren direkte Verbindungen zu Dr. Mann haben, und zwar in Gestalt der Mitautorenschaft seiner Studien. Unsere Ergebnisse dieser Analyse zeigen, dass Autoren im Fachgebiet Paläoklima eng verbandelt sind und dass daher ,unabhängige Studien‘ nicht so unabhängig sein könnten, wie sie an der Oberfläche aussehen.

Dieses Ergebnis wurde durch die durchgesickerten CRU-E-Mails bestätigt. Die Korruption dieses Prozesses seitens der CRU bedeutete Fehler, die absichtlich oder unabsichtlich Eingang in die wissenschaftliche Aufzeichnung fanden. Außerdem wurde die Verschleierung und die Ablehnung der Veröffentlichung von Daten zum Standard. Wegman dazu:

Es ist nicht klar, dass Mann und seine Verbündeten den Fehler in ihrer Verfahrensweise zur Zeit der Veröffentlichung erkannt haben. Infolge fehlender vollständiger Dokumentation ihrer Daten und Computer-Codes waren wir nicht in der Lage, ihre Forschungen nachzuvollziehen. Wir haben jedoch bei der Reproduktion der Verfahren von M&M ähnliche Ergebnisse wie diese erzielt. Dieses Nachvollziehen stützt die Kritik der MBH98-Methoden, wo der Offset* des mittleren Wertes eine künstlich große Abweichung vom gewünschten mittleren Wert Null erzeugt.

[*Original: „as the offset of the mean value creates an artificially large deviation from the desired mean value of zero“. Das habe ich inhaltlich nicht verstanden. Im LEO werden für ,offset‘ so viele Bedeutungen angezeigt, dass ich deswegen da ratlos war. Anm. d. Übers.]

Sie wussten, warum man die Daten in Erfahrung bringen wollte. Phil Jones antwortete am 21. Februar 2005 auf die Datenanforderung von Warwick Hughes so:

„Wir haben etwa 25 Jahre in die Arbeit gesteckt. Warum sollte ich Ihnen die Daten zugänglich machen, wenn es Ihr Ziel ist zu versuchen, Fehler darin zu finden?“

Später sagte Jones dass er die Daten verloren habe. Werden auch andere Daten im Nirwana verschwinden?

Bedeutsam ist hier die Natur des Fehlers. Falls er entscheidend war für eine These oder eine wissenschaftliche Schlussfolgerung, wurde der Fehler aus Inkompetenz oder mit Absicht gemacht. Wie auch immer, die dafür verantwortliche Person ist auf seiner Position wegen seiner Behauptungen fehl am Platze.

Entscheidend für die IPCC-Objetive war die Notwendigkeit zu beweisen, dass die menschliche Erzeugung von CO2 zu Temperaturzunahmen führte und Temperaturen zeitigte, die in der gesamten Historie höher denn je lagen. Ist es Zufall, dass dies die Bereiche sind, wo die Wissenschaft geschaffen wurde, um das vorbestimmte Ergebnis zu bekommen? Es scheint, dass sich eine Verteilung von Fehlern heraus kristallisiert, die Fehlverhalten beweisen. Unglücklicherweise weiß ich nicht um die Verantwortlichkeiten, aber dies ist allgemein die Lage mit den verbundenen Punkten des Fehlverhaltens in der heutigen Gesellschaft.

Link: http://wattsupwiththat.com/2014/10/12/climate-science-separating-mistakes-from-malfeasance/

Übersetzt von Chris Frey EIKE