Wladimir Putin: Politik- und Klima-Realist?

Erfahrungen

Ich habe während des Kalten Krieges mit vielen sowjetischen Klimatologen gearbeitet. Alles fing damit an, dass ich ein Kapitel in einem Buch mit dem Titel Climate Science AD 1500 geschrieben hatte. Der Herausgeber hat Autoren von Kapiteln andere Kapitel begutachten lassen. Ein Kapitel, das mir zur Begutachtung vorgelegt wurde, trug die Überschrift „Documentary evidence from the USSR“ von E. P. Borisenkov. Darin ging es um den Wert russischer Chroniken. Ich wurde sehr vertraut mit der Arbeit von Mikhail Budyko, der einen grundlegenden Übergang vollzog von synoptischer Klimatologie zu einer Energiebilanz-Klimatologie. Sein Werk beeinflusste die gegenwärtige Klimawissenschaft. Ironischerweise war dieser Herausgeber Phil Jones, in dessen Klimagate-E-Mails zum einzigen Mal mein Name auftauchte. Im Mai 2008 schrieb er:

PPS Unser Web-Server hat dieses Stück Müll gefunden – so falsch, dass es unglaublich ist, dass Tim Ball ein vernünftiges Kapitel in Climate Science AD 1500 geschrieben hat.

Michael Mann schrieb dazu:

p.s. Was Tim Ball betrifft – er ist so vollständig diskreditiert (auch weil er ein Gerichtsverfahren verloren hat, indem er der Lüge hinsichtlich seiner wissenschaftlichen Laufbahn überführt wurde), dass niemand außer den wirklichen Leugnern sich auch nur mit dem Gedanken trägt, seinen Erguss zu lesen. Siehe z. B. hier:

Ich finde, es ist eine erheiternde Kuriosität, dass er tatsächlich ein Kapitel hat bei Bradley und Jones.

Am besten geheim halten!

Das Problem: Ich habe kein Gerichtsverfahren verloren, und es gibt auch keine Veröffentlichung mit falschen Angaben zu meiner Laufbahn. Der Calgary Herald veröffentlichte eine Korrektur zusammen mit einer Entschuldigung. Man beachte die Informationsquelle von Mann. Und außerdem, wissen wir nicht inzwischen, wer den wirklichen Müll veröffentlicht hat?

Unterschiedliche Verfahren und Konflikte

Während des Kalten Krieges waren die meisten wissenschaftlichen Veröffentlichungen der Sowjetunion nicht verfügbar, bis es zu einer bedeutenden Änderung kam, als jüdische Wissenschaftler, die aus der Sowjetunion geflohen waren, in Israel einen Übersetzungsservice ins Leben riefen. Etwa im Jahre 1990 ergab sich eine Divergenz im Bereich Klimawissenschaft zwischen den Ländern des Ostblocks und des Westens. Die Sowjets glauben, das Klima sei zyklisch, die Summe einer Vielfalt von Zyklen. Die Herausforderung bestand darin, diese Zyklen zu identifizieren und die Wechselwirkungen zwischen ihnen herauszufinden. [Die zyklische Natur von] Klimaereignissen begann die russische Denkweise zu durchdringen besonders nach der Veröffentlichung des Artikels „Long Waves in Economic Life“ von Nikolai Kondratieff im Jahre 1926. Das Konzept von Klimazyklen hat seitdem in der Ökonomie und Vorhersagen des Aktienmarktes eine Blüte erreicht. Das Buch von Michael Zahorack „Climate: The Key to Understanding Business Cycles“ ist ein gutes Beispiel. Die westliche Denkweise entfaltete sich um die Chaos-Theorie, der zufolge das Wetter nach ein paar Tagen unvorhersagbar war wegen Rauschens; Lorenz und der Schmetterling. Dies führte zu einem nach wie vor andauernden Widerspruch zu AGW-Befürwortern. Falls man keine genaue Vorhersagen mehr als ein paar Tage im Voraus machen kann, wie kann man sich dann so sicher sein hinsichtlich Vorhersagen für 50 und 100 Jahre?

Das Faszinierende an diesem wissenschaftlichen, intellektuellen und philosophischen Unterschied zwischen West und Ost war der Umstand, dass er ausschließlich politisch und ideologisch interpretiert worden ist. Das war er nicht, und Putins Position ist eine Manifestation dieses Unterschieds. Faszinierend ist auch seine Erkenntnis, dass das IPCC und Kyoto eine politische Agenda war, um Entwicklung zu unterdrücken, außer dass er glaubt, dies sei nur auf Entwicklungsländer anwendbar. Tatsächlich lief die Agenda darauf hinaus, gleiche und begrenzte Entwicklung voranzubringen, indem entwickelte Länder geschwächt und Entwicklungsländer minimal gestärkt werden. All dies soll kommen, nachdem die entwickelten Länder für ihre Sünden bezahlt haben und das Geld an die leidenden Entwicklungsländer geflossen ist. Es braucht einen Kommunisten, um den Versuch der Installation einer Eine-Welt-Regierung zu erkennen. Putin hat nichts gegen eine solche, solange nur Russland alles unter Kontrolle hat.

Zu einer weiteren Illustration der russischen Position kam es, als Lord May wissenschaftliche Gesellschaften zur Promotion der globalen Agenda des IPCC benutzte. Er begann mit der UK Royal Society und nutzte deren Prestige, andere nationale Gesellschaften zu überreden, die öffentliche Wahrnehmung mit öffentlichen Erklärungen zu manipulieren. Die meisten Gesellschaften machten da mit. Was immer noch ein Zankapfel für Viele ist, wie der Rückzug von Professor Emeritus Hal Lewis aus der American Physical Society illustrierte [auch das EIKE berichtete ausführlich darüber. Anm. d. Übers.] Eine Gruppe jedoch, nämlich die Russische Academy, widerstand dieser Propaganda unter der Leitung des Klimatologen Prof. Yuri Izrael. Auf einer Konferenz des UK Met.-Office an der Exeter University unter dem Motto „Avoiding Dangerous Climate Change“ zahlten Prof. Izrael und Andrej Illarionov den Preis für ihre Aktionen. Benny Peiser berichtete:

Nach zwei Tagen ununterbrochener Untergangs-Prophezeiungen [doom and gloom predictions] auf der Konferenz des Met.-Office „Avoiding Dangerous Climate Change“ reichte es mir. Genug ist genug. Die ungemilderte Zur-Schau-Stellung unmittelbar bevorstehender Eiszeiten, Höllenfeuer, Massen-Hungersnöte, Mega-Dürren, globalen Epidemien und Massen-Aussterben ist eine Erfahrung, die ich niemandem empfehlen kann, der dünnhäutig veranlagt ist (obwohl die Nachrichtenmedien gar nicht genug davon bekommen können). Aber das Spektakel drohender Katastrophen war derart, dass jeder, der es gewagt hat – oder dem es erlaubt worden ist – zu hinterfragen, ob der Himmel wirklich drauf und dran ist, auf uns herabzufallen (und es waren mindestens ein halbes Dutzend gemäßigter Anti-Alarmisten zugegen) wurde gebrandmarkt als der „übliche Verdächtige“. Gegen Andrei Illarionov (Putins Wirtschaftsberater) wurde eine üble Verleumdungskampagne durch Martin Perry vom IPCC losgetreten.

Peiser berichtete, was nach der Präsentation von Prof. Izrael geschehen war:

Der russische Wissenschaftler bekam augenblicklich despektierlich einen Verweis des Vorsitzenden, dem früheren IPCC-Chef Sir John Houghton, weil er viel zu optimistisch sei. Solch ein moderater Vorschlag sei lächerlich, da er „mit der Politik des IPCC nicht kompatibel“ sei. Eindeutig gab das Treffen am Met.-Office den Ton an für den nächsten IPCC-Bericht.

Es war zutiefst empörend, die ungezogene und unhöfliche Art und Weise zu erleben, mit der über Prof. Izrael und Dr. Illarionov gleichermaßen hergezogen worden ist – von vielen Delegierten und IPCC-Funktionären.

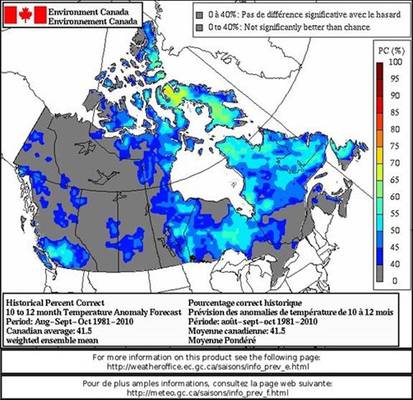

This is the same UKMO that get weather and climate forecasts wrong so often they lost their contract to the fellow public agency the British Broadcasting Corporation (BBC).

Es handelt sich hier um das gleiche UKMO, das bei Wetter- und Klimavorhersagen schon so oft falsch lag, dass sein größter Kunde, die öffentliche Agentur BBC, den Vertrag mit dem UKMO gekündigt hat.

Putins Klima-Repräsentant

Putin war immer gegen Kyoto und der so genannten Wissenschaft dahinter eingestellt. Er sandte seinen Wirtschaftsberater Andrej Illarionov auf eine Weltreise, um zu erklären, was mit der Wissenschaft nicht stimmte. Eine Kopie seiner Präsentation in Washington im Jahre 2004 ist hier verfügbar. Nach der Tour änderte sich Putins politische Lage.

Das Kyoto-Protokoll benötigte die Ratifizierung durch eine ausreichende Anzahl von Ländern, die für 55% des CO2-Ausstoßes verantwortlich waren. Als die USA es ablehnten mitzumachen, war Russland zu jener Zeit das einzige Land, dass genug CO2 erzeugte, um Kyoto am Laufen zu halten. Illarionov beendete seine Weltreise und kehrte nach Russland zurück. Einen Monat später ließ Putin verlauten, dass er Kyoto ratifizieren werde. Illarionov trat zurück. Einige argumentierten, dass Putin größere Vorteile mit dem Verkauf von Emissions-Zertifikaten erzielen würde. Er erklärte die Realitäten hinter seinem Vorgehen. Sein Ziel war es, dass russische BIP zu verdoppeln, und seiner Ansicht nach war dies leichter zu erreichen durch eine Mitgliedschaft in der Welthandelsorganisation WTO.

Tatsache war, dass viele Nationen hauptsächlich in Europa Putin effektiv hintergangen haben, indem sie ihm sagten, dass sie definitiv seinen Antrag auf Mitgliedschaft Russlands in der WTO nicht unterstützen werden. Illarionov erzählte, was vor seinem Abgang von der Bühne los gewesen war. Putin betrachtete eine Mitgliedschaft als wertvoller als das Kyoto-Abkommen zu jener Zeit. Dieser Punkt wurde treffend von einem Polnischen Kommentator beschrieben:

Es gibt eine andere populäre Hypothese, die Ratifizierung mit der Unterstützung der EU für Russlands WTO-Beitritt zu verknüpfen. Obwohl hochrangige Funktionäre wie Außenminister Igor Ivanov und Energieminister Igor Iusofov diesen Vorwurf zurückwiesen, gab Präsident Putin höchstselbst einen Hinweis darauf, als er sagte: „Die EU ist uns auf halbem Wege in den Gesprächen über die WTO entgegen gekommen, und das kann nichts anderes tun als unsere Position hinsichtlich des Kyoto-Protokolls positiv zu beeinflussen“. Allerdings ist unklar, ob Russlands Zögern Teil einer Strategie des Verhandelns mit der EU war oder ob der Kreml „einfach“ nur seine Spezialposition zu seinem Vorteil ausnutzte, um der WTO-Mitgliedschaft näher zu kommen – was eines der Hauptziele von Putins Präsidentschaft war.

Inzwischen ist es ein Vorteil für Putin, gegen den Green Climate Fund GCF zu sein, der Kyoto ersetzen soll.

Wird Putin in den GCF einzahlen?

Auf der Konferenz COP16 wurde der Green Climate Fund ins Leben gerufen, mit der Weltbank als zwischenzeitlicher Sachwalter. Im September 2015 beschlossen die EU und Südkorea, den GCF zu einem Hauptthema auf der COP in Paris zu machen.

SONGDO, 17. September 2015 – Auf dem Achten Bilateralen Treffen haben die Führer der Republik Korea und der EU die Notwendigkeit betont, gegen den Klimawandel vorzugehen, und ihre Entschlossenheit bekräftigt, ihren Teil zu einem erfolgreichen universellen Klimaabkommen in Paris beizutragen.

Die drei Führer unterstrichen ihren Willen, den „GCF voll operationell zu machen mitsamt den hauptsächlichen Unternehmungen für das finanzielle Verfahren“ unter dem UNFCCC für das Klima-Regime nach 2020.

Dennoch, viele zahlen nicht:

Friends of the Earth International forderten heute, dass entwickelte Länder den GCF mit den im Jahre 2014 versprochenen Mitteln endlich ausstatten, und warnten, dass die bislang eingegangenen Beiträge alarmierend niedrig seien.

Tausende werden nach Paris pilgern, über die Hälfte davon Personen von NGOs. Sie werden eine Agenda vorantreiben, von der Putin weiß, dass sie komplett überflüssig ist. Wie die französische mathematische Gesellschaft ocietedeCalculMathematiqueSA in einer Studie aus jüngster Zeit schrieb, von der Putin Kenntnis hat, und die den Titel trägt [übersetzt] „Die Schlacht gegen globale Erwärmung: ein absurder, kostspieliger und sinnloser Kreuzzug“:

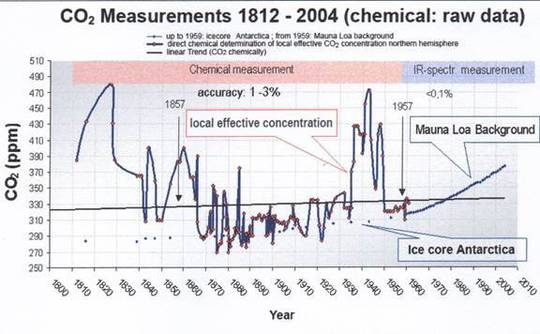

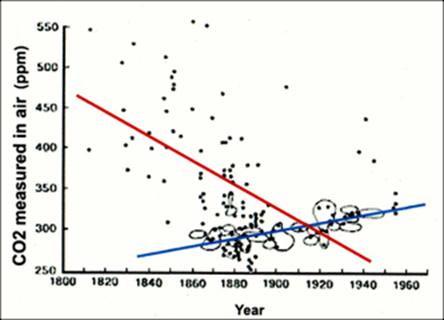

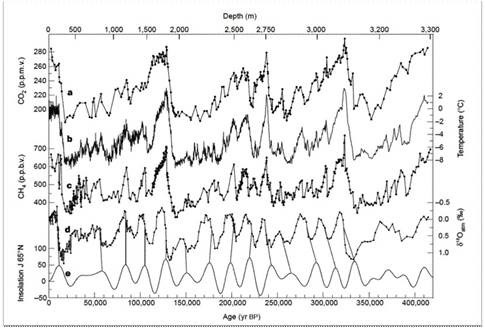

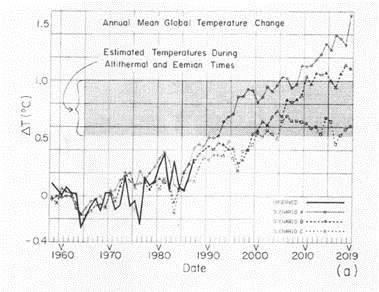

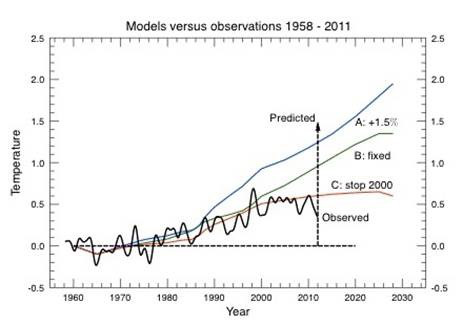

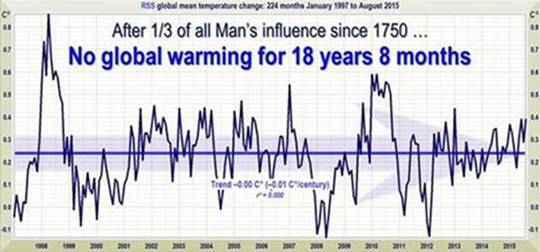

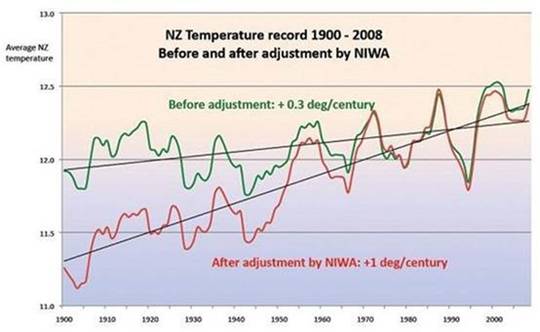

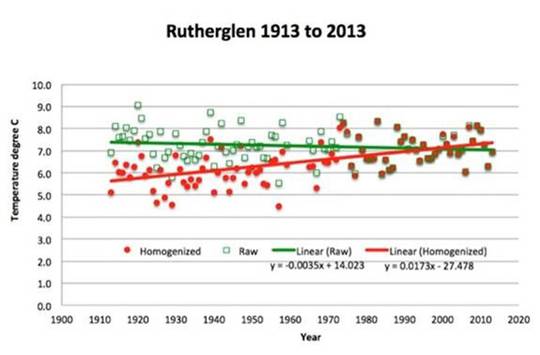

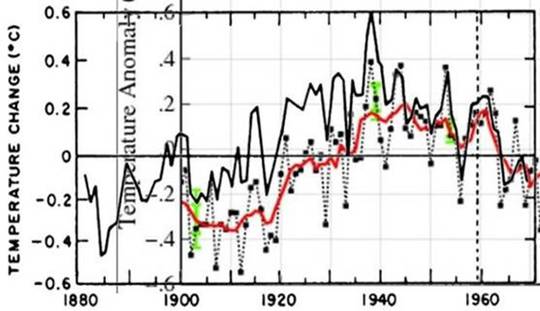

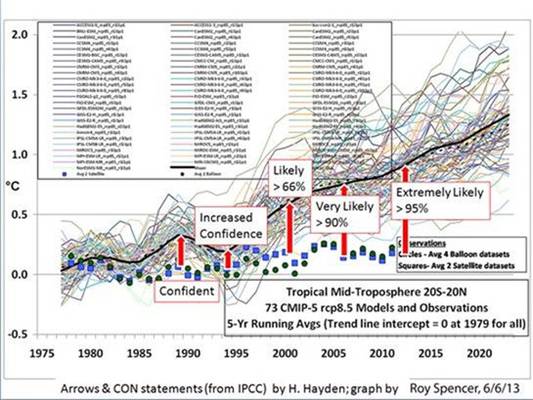

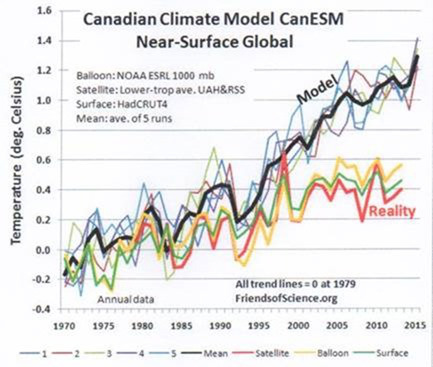

Es gibt nicht eine einzige Tatsache, Graphik oder Beobachtung, die uns folgern lässt, dass das Klima der Welt in irgendeiner Weise ,gestört‘ ist. Es ist variabel, wie es schon immer war, aber derzeit um Einiges geringer als während gewisser Perioden oder geologischer Zeiträume. Moderne Verfahren sind selbst heute noch weit davon entfernt, die globale Temperatur genau zu vermessen. Darum sind Messungen vor 50 oder 100 Jahren sogar noch unzuverlässiger.

Die CO2-Konzentrationen variieren, wie das schon immer der Fall war; die hierzu veröffentlichten Graphiken sind verzerrt und unehrlich. Ein steigender Meeresspiegel ist ein normales Phänomen, verbunden mit upthrust buoyancy [wie kann man das übersetzen? Anm. d. Übers.]; er hat nichts zu tun mit der so genannten globalen Erwärmung. Hinsichtlich von Extremwetterereignissen – sie sind derzeit nicht zahlreicher als sie es in der Vergangenheit waren.

Die Unterstützung der politischen Objektive der Agenda 21 gründet sich auf falsche Wissenschaft, die vom IPCC geschaffen worden ist. Der deutsche Physiker und Meteorologe Klaus-Eckart Puls erklärte hier, warum viel zu viele Wissenschaftler das nicht verstehen. Einfach deshalb, weil sie nie gelesen haben, was das IPCC sagt:

Bis vor zehn Jahren habe auch ich ungeprüft nachgeplappert, was das IPCC uns so erzählt. Irgendwann dann habe ich angefangen, die Behauptungen nachzuprüfen. Das Ergebnis: Es begann mit Zweifeln und mündete dann in Entsetzen und in der Erkenntnis, dass ganz viel von dem, was der IPCC und die Medien bezüglich des Klimawandels sagen, nicht stimmt und gar nicht durch naturwissenschaftliche Fakten und Messungen gedeckt ist. Für das, was ich früher als Naturwissenschaftler ungeprüft auch in eigenen Vorträgen "nach-erzählt“ habe, dafür schäme ich mich heute. – Naturwissenschaftlich ist es schier absurd, durch ein paar Drehungen an irgendwelchen CO2-Stellschrauben „ein schön angenehmes stabiles Klima“ festhalten zu wollen.

[Originalzitat – keine Rückübersetzung! Ball verlinkt einen Artikel bei Notrickszone, aber dieser bezieht sich auf den von mir eingefügten Hyperlink. Anm. d. Übers.]

Russische Wissenschaftler wissen genau, was das IPCC gesagt hat. Daher weiß Putin, dass die Klimawissenschaft des IPCC völlig falsch ist. Er weiß es, weil sowjetische und jetzt russische Klimatologen transparente, offene Wissenschaft betreiben, was eine Ironie angesichts des Umstandes ist, dass dies in einem System so ist, das alles kontrolliert. Er weiß auch, dass das IPCC erschaffen worden ist, das Klima für politische Ziele einzusetzen, weil er das besser kann als fast alle anderen. Wie man so sagt, man braucht einen Dieb, um einen Dieb zu fangen. Wie viel Geld wird Putin in den GCF einzahlen?

Link: http://wattsupwiththat.com/2015/10/30/vladimir-putin-climate-and-political-realist/

Übersetzt von Chris Frey EIKE