Kollaps des CAGW-Wahns: Nach 2020 nicht mehr haltbar

1. Die Probleme des IPCC mit Globalen Vorhersagemodellen

Harrison und Stainforth schreiben hier:

„Dem Reduktionismus zufolge sind deterministische Annäherungen an die Wissenschaft und positivistische Ansichten von Kausalität geeignete Verfahren, um komplexe, multivariable Systeme zu erkunden … wobei das Verhalten eines komplexen Systems abgeleitet werden kann aus dem fundamentalen reduktionistischem Verständnis. Große komplexe Systeme können besser verstanden werden und vielleicht nur verstanden werden hinsichtlich beobachtetem auftretendem Verhalten. Die praktische Auswirkung ist, dass es Verhaltensweisen des und Strukturen im System gibt, die mit Erklärungen oder Prophezeiungen durch reduktionistische Verfahren nicht zugänglich sind … das Globale Zirkulationsmodell GCM ist die numerische Lösung eines komplexen, jedoch rein deterministischen Satzes nichtlinearer Differentialgleichungen über ein definiertes zeitliches und räumliches Netz, und kein Versuch wird unternommen, irgendeine Quantifizierung der Unsicherheit in das System einzuführen … Das reduktionistische Argument, dass großräumiges Verhalten repräsentiert werden kann durch kumulierende Effekte von Prozessen in kleinerem Scale wurde im Zusammenhang mit natürlichen umweltlichen Systemen niemals validiert.

Das Modellierungs-Verfahren ist inhärent wertlos bei der Vorhersage zukünftiger Temperaturen mit irgendeiner berechenbaren Sicherheit, und zwar wegen der Schwierigkeit, die initialen Bedingungen zu spezifizieren in einem hinreichend engmaschigen räumlichen und zeitlichen Netz einer großen Anzahl von Variablen mit hinreichender Präzision vor multiplen Iterationen. Mehr dazu hier und hier.

In Abschnitt IPCC AR4 WG1 8.6 geht es um Antriebe, Rückkopplungen und Klimasensitivität. Die Unzulänglichkeiten der Modelle werden erkannt. Die Schlussfolgerungen finden sich in Abschnitt 8.6.4, wo es unter Anderem heißt:

„Außerdem ist noch nicht klar, welche Tests kritisch sind hinsichtlich der Zukunfts-Projektionen, konsequenterweise mit einem Satz von Modellmetrik, der herangezogen werden könnte, um die Bandbreite plausibler Klimawandel-Rückkopplungen und der Klimasensitivität einzuengen. Ein solcher Satz muss noch entwickelt werden“.

Was könnte klarer sein. Im Jahre 2007 sagte das IPCC selbst, dass es noch nicht einmal weiß, welche Metriken man in die Modelle stecken muss, um ihre Zuverlässigkeit zu testen (d. h. wir wissen nicht, wie die Temperatur in der Zukunft sein wird, und wir können nicht die Klimasensitivität hinsichtlich CO2 berechnen). Dies enthält außerdem die Frage, welche irrigen Hypothesen (z. B. dass CO2 der Haupt-Klimatreiber ist) in die „plausiblen“ Modelle eingegangen sind, die auf irgendeine Weise getestet werden sollen.

Selbst das IPCC hat jetzt aufgegeben, die Klimasensitivität CS zu schätzen – im AR5 heißt es (versteckt in einer Fußnote):

Kein Best Estimate für die Gleichgewichts-Klimasensitivität kann angegeben werden wegen fehlender Übereinstimmung bei Werten über abgeschätzte Beweislinien und Studien hinweg“.

Paradoxerweise behaupten sie immer noch, dass das UNFCCC eine gewünschte Temperatur einstellen kann mittels Kontrolle des CO2-Niveaus. Dies ist so extrem unsinnig, dass es irrational ist. Es gibt keine empirischen Beweise dafür, dass das CO2 mehr als nur vernachlässigbare Auswirkungen auf die Temperaturen hat.

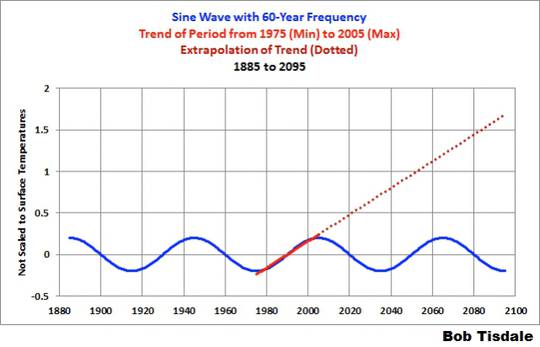

Was genauso wichtig ist: Die Klimamodelle, auf denen der gesamte CAGW-Wahn beruht, sind strukturiert ohne jede Berücksichtigung der natürlichen Periodizitäten über ±60 und – noch wichtiger – 1000 Jahre (beobachtetes Verhalten), welche sich so deutlich in den Temperaturaufzeichnungen zeigen. Das Verfahren der Modellierer ist einfach nur eine wissenschaftliche Katastrophe, dem sogar jeder gesunde Menschenverstand fehlt. Es ist genauso, als ob man die Temperaturentwicklung von Februar bis Juli nimmt und diese linear 20 Jahre oder so in die Zukunft projiziert. Die Modelle sind nur für weniger als 100 Jahre zurück ausgelegt, während doch der relevante Zeitrahmen Jahrtausende beträgt.

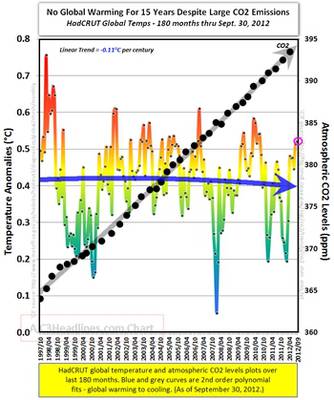

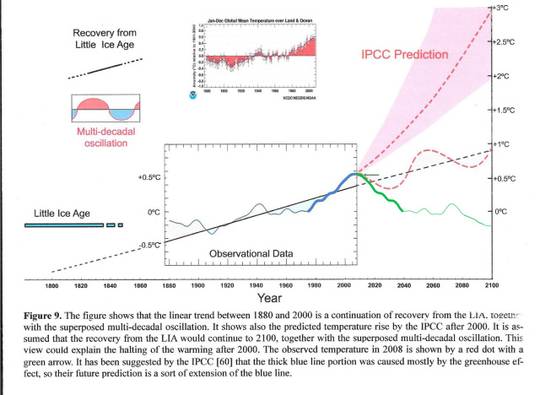

Abbildung 1: (überarbeitet {grüne Linie hinzugefügt} von Syun_Ichi Akasofu) aus: http://www.scirp.org/journal/PaperInformation.aspx?paperID=3217

Bildinschrift: Die Abbildung zeigt, dass der lineare Trend zwischen 1880 und 2000 eine Fortsetzung der Erholung aus der Kleinen Eiszeit ist, zusammen mit der überlagerten multidekadischen Oszillation. Sie zeigt auch den vom IPCC prophezeiten Temperaturanstieg nach dem Jahr 2000. Es wird angenommen, dass die Erholung aus der Kleinen Eiszeit sich bis zum Jahr 2100 fortsetzen wird, zusammen mit der überlagerten multidekadischen Oszillation. Dies könnte den Stopp der Erwärmung nach dem Jahrtausendwechsel erklären. Die im Jahre 2008 gemessene Temperatur wird mit einem roten Punkt dargestellt mit einem grünen Pfeil. Das IPCC hat vorgegeben, dass der Anteil der dicken blauen Linie hauptsächlich dem Treibhauseffekt geschuldet ist, so dass deren Zukunfts-Prophezeiung eine Art Ausdehnung der blauen Linie ist. – Ende der Bldinschrift.

Abbildung 1 vergleicht die IPCC-Vorhersage mit der Vorhersage aus der Akasofu-Studie und mit der einfachen, aber höchst ökonomischen Arbeitshypothese dieses Beitrages (grüne Linie), dass nämlich der Spitzenwert um das Jahr 2003 der jüngste Spitzenwert im Milleniums-Zyklus ist, der so offensichtlich aus den Temperaturdaten hervorgeht. Die Daten zeigen außerdem, dass der gut dokumentierte 60-Jahre-Temperaturzyklus zufällig etwa zur gleichen Zeit seinen Spitzenwert erreicht.

Die Temperatur-Projektionen der Modelle des IPCC und des UK Met.-Office sowie alle Studien bzgl. der Auswirkungen, die sich daraus ableiten, haben in der empirischen Wissenschaft keine solide Grundlage, sind sie doch aus inhärent nutzlosen und im Besonderen strukturell falschen Modellen abgeleitet. Sie sind keine Grundlage für die Diskussion über zukünftige Klimatrends und repräsentieren eine gewaltige Verschwendung von Zeit und Geld. Als Grundlage für die Klima- und Energiepolitik der Regierungen muss man diese Vorhersagen als umfangreich falsch und daher schlimmer als nutzlos ansehen.

Ein neues Vorhersage-Paradigma muss her.

2. Die Vergangenheit ist der Schlüssel zu Gegenwart und Zukunft. Herausfinden, wie man die natürlichen Quasi-Periodizitäten vorhersagen kann, die das Erdklima regieren – die geologische Annäherung

2.1 Allgemeine Prinzipien

Die Kern-Kompetenz in den geologischen Wissenschaften ist die Fähigkeit, die sich mit Zeit und Raum ändernden Verteilungen von Ereignissen zu erkennen und zu korrelieren. Dies erfordert eine Denkweise und vielfältige Erfahrung, die sich sehr unterscheidet von der reduktionistischen Annäherung an die Natur, welche jedoch angemessen und notwendig ist, um das Klima der Vergangenheit zu untersuchen und zukünftige Klimatrends vorherzusagen. Wissenschaftler und Modellierer mit physikalischem und mathematischem Hintergrund haben wenig Erfahrung, multiple und oft fragmentarische Datensätze multipler Variablen miteinander zu korrelieren.

Es ist notwendig, das Verständnis dieser Vorgänge zu entwickeln, ebenso wie ein Narrativ allgemeiner Trends aus der tatsächlichen individuellen lokalen und regionalen Zeitreihe bestimmter Variablen. Das Erdklima ist das Ergebnis von Resonanz und Berührungen verschiedener quasi-zyklischer Prozesse mit variierender Wellenlänge.

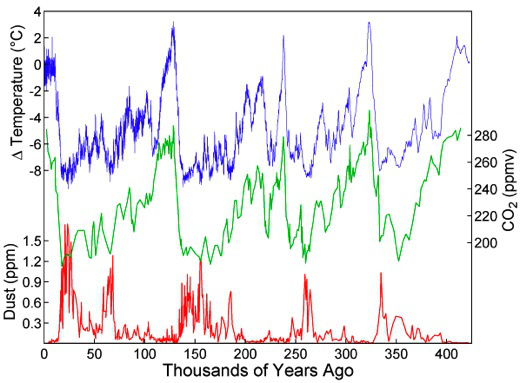

Die Zukunft vorherzusagen ist nicht möglich, solange wir nicht verstehen, wo sich die Erde gerade befindet relativ zu den gegenwärtigen Phasen dieser unterschiedlichen und in Wechselwirkung stehenden natürlichen Quasi-Periodizitäten, die sich in zwei Hauptkategorien unterteilen:

a) Die orbitalen langwelligen Milankovitch-Zyklen, also Exzentrizität, Schiefe und Präzession, welche moduliert werden durch

b) Solare „Aktivitäts“-Zyklen in möglichen Zeitrahmen von vielen Jahrtausenden, Jahrtausenden, Jahrhunderten und Jahrzehnten.

2.2 Die gegenwärtige Erwärmung in Relation zu den Milankovitch-Zyklen:

Abbildung 2 (aus Wiki-Milankovitch)

Wir haben den Höhepunkt der jüngsten Zwischeneiszeit-Erwärmung überschritten (Abbildung 2) mit einem abnehmenden Trend während der letzten 3500 Jahre (Abbildung 3).

2.3 Die Quasi – Millennial Solar Cycle -Periodicity:

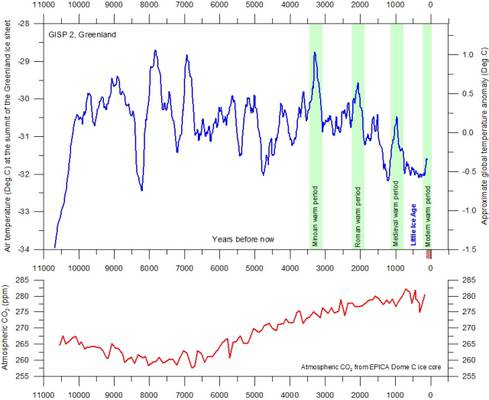

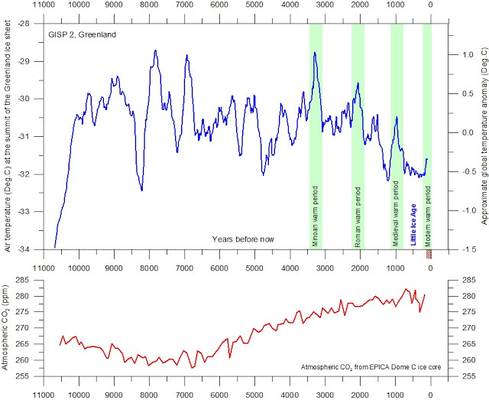

Abbildung 3: (von http://www.climate4you.com/). Siehe auch den Übersichts-Abschnitt von Humlum)

Man beachte die Spitzen vor 10.000; 9000; 8000; 7000; 2000 und 1000 Jahren vor heute und dann die jüngste Spitze um das Jahr 900, die sich klarer in Abbildung 4 zeigt, und diejenige das Jahres 2003 in Abbildung 5.

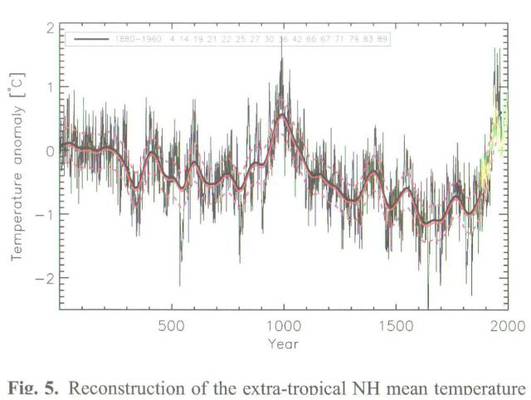

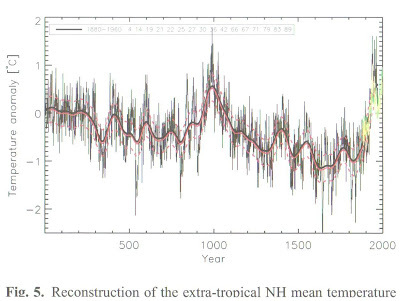

Abbildung 4: (Christiansen and Ljungqvist 2012 (Fig 5) http://www.clim-past.net/8/765/2012/cp-8-765-2012.pdf)

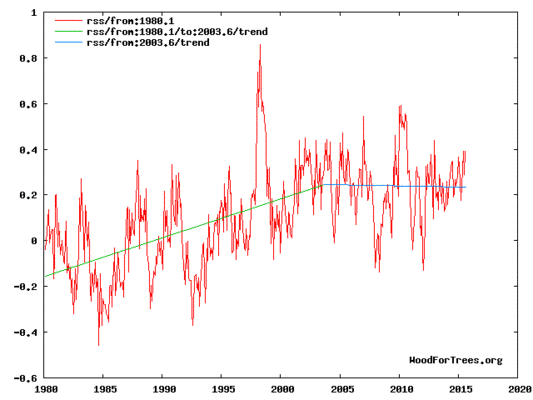

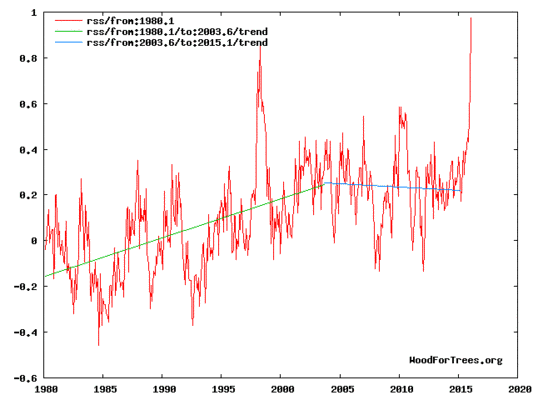

Abbildung 5

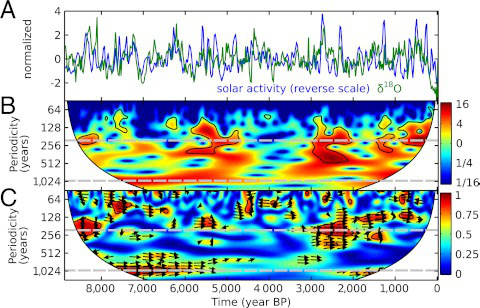

Den Abbildungen 4 und 5 zufolge erstreckt sich der jüngste Milleniums-Zyklus von etwa 900 bis 2003, also über 1013 Jahre. Dies ist bemerkenswert konsistent mit der Periodizität von 1024 Jahren, die sich in der Analyse der Wellenlänge der Sonnenaktivität abzeichnet (hier). Es ist von Interesse, dass die quasi-millenialen Spitzen in Abbildung 3 aus Grönland stammen, während die 1024-Jahre-Periodizitäten in Abbildung 6 aus der Antarktis stammen:

Abbildung 6

2.4 Der quasi-milleniale Temperaturzyklus – Amplitude

Eine nützliche empirische Schätzung der Amplitude des millenialen Temperaturzyklus‘ auf der Nordhemisphäre kann man mit dem über 50 Jahr gleitenden Mittel (rote Kurve in Abbildung 4) vornehmen. Sie beträgt etwa 1,7°C vom Spitzenwert um das Jahr 900 bis zum Minimum um das Jahr 1640 während der Kleinen Eiszeit. Dies ist übereinstimmend mit der Schätzung von Shindell, Schmidt, Mann et al. (2001) mit dem Thema [übersetzt] Solarer Antrieb der regionalen Klimaänderung während des Maunder-Minimums (hier).

2.5 Der solare Treiber

Der wichtigste Faktor bei der Klimavorhersage ist, wo sich die Erde hinsichtlich des quasi-millenialen natürlichen solaren Aktivitätszyklus‘ befindet, der eine Periode von 960 bis 1024 Jahren aufweist. Aus Abbildung 4 geht trivial hervor, dass die Erde sich unmittelbar vor oder nach einem Spitzenwert im Milleniums-Zyklus befindet.

Das beste Proxy für die Sonnenaktivität sind die Neutronenzählung und die 10 Be-Daten.

Die allgemeine Zunahme der Sonnenaktivität, die für den Temperaturanstieg seit der Kleinen Eiszeit ursächlich ist, zeigt sich offensichtlich in den 10 Be-Flussdaten im Eisbohrkern zwischen etwa dem Jahr 1700 und dem Ende des 20.Jahrhunderts.

Abbildung 7 (von Berggren et al) http://www.eawag.ch/forschung/surf/publikationen/2009/2009_berggren.pdf

Mein Standpunkt auf der Grundlage der Oulu-Neutronenzählung (Abbildung 8) in Kombination mit den Abbildungen 4, 5, 6 und 7 lautet, dass das milleniale Maximum der Sonnenaktivität im Zyklus 22 um das Jahr 1991 erfolgte.

Abbildung 8.

Es gibt eine variierende Verzögerung zwischen dem Höhepunkt der Sonnenaktivität und dem korrespondierenden Spitzenwert der verschiedenen Temperatur-Metriken. Es gibt eine Verzögerung von 12 Jahren zwischen dem solaren Aktivitäts-Höhepunkt und dem millenialen Temperatur-Spitzenwert, wie aus den RSS-Daten im Jahre 2003 hervorgeht (Abbildung 5).

3. Vorhersagen

3.1 Langfristig

Ich glaube fest an den Wert von Ockhams Rasierer. Daher lautet die einfachste Arbeitshypothese auf der Grundlage der Wichtung aller Daten, dass der milleniale Temperaturzyklus um das Jahr 2003 seinen Spitzenwert erreicht hat und dass sich die allgemeinen Trends von 990 bis 2003 (Abbildung 4) von 2003 bis 3016 wiederholen, wobei der Tiefpunkt der nächsten Kleinen Eiszeit um das Jahr 2640 erreicht werden wird.

3.2 Mittelfristig

Betrachtet man die kürzere ±60-Jahre-Wellenlänge, lautet die einfachste Hypothese, dass der Abkühlungstrend seit 2003 einfach ein Spiegelbild des Anstiegs-Trends ist. Dies wird illustriert durch die grüne Kurve in Abbildung 1, welche Abkühlung bis zum Jahr 2038 zeigt, dann eine leichte Erwärmung bis 2073, gefolgt von einer weiteren Abkühlung bis zum Ende dieses Jahrhunderts.

3.3 Gegenwärtige Trends

Der Abkühlungstrend seit dem millenialen Höhepunkt im Jahre 2003 wird in Abbildung 5 in blau illustriert. Ab dem Jahr 2015 ist der dekadische Abkühlungstrend verschleiert durch den gegenwärtigen El Nino. Der SOI erreichte Ende 2015 seinen Höhepunkt. Die Temperaturspitze läuft dem SOI-Höhepunkt gewöhnlich um 6 bis 7 Monate hinterher, so dass es bis April 2016 zu einer weiteren moderaten Erwärmung kommen kann. Danach jedoch, also von 2017 bis 2019 können wir mit guten Gründen eine Abkühlung erwarten, die mindestens so stark ist wie Abkühlung nach dem El Nino im Jahre 1998, wie es aus Abbildung 5 hervorgeht – etwa 0,9°C.

Erwähnenswert ist, dass die Zunahme der Neutronenzählung im Jahre 2007 (Abbildung 8) eine mögliche Änderung des Sonnen-Regimes zeigt, welche eine unerwartet scharfe Abnahme der RSS-Temperaturen 12 Jahre später erzeugen könnte um das Jahr 2019 auf ein signifikant niedrigeres Niveau, als die blaue Linie in Abbildung 5 zeigt.

4. Conclusions

Zum Schaden des Rufes der Wissenschaft allgemein haben die etablierten Klimawissenschaftler zwei ungeheuerliche Fehler der Beurteilung gemacht mit ihrem Verfahren zur Klimavorhersage und folglich mit ihren Ratschlägen an Politiker in den folgenden SPMs. Erstens, sie stellten ihre Analysen auf die Grundlage von inhärent nicht überprüfbarer und vor allem strukturell falscher Modelle, welche viele fragwürdige Hypothesen enthalten. Zweitens, sie haben vollständig die natürlichen, solar angetriebenen millenialen und multidekadischen Quasi-Zyklen ignoriert. Solange wir nicht wissen, wo wir uns relativ dazu befinden und die Phase des millenialen Zyklus‘ im Einzelnen nicht einbeziehen, ist eine sinnvolle Vorhersage schlicht unmöglich.

Es ist in etablierten Klimakreisen Mode, Klimavorhersage als ein „verzwicktes“ [wicked] Problem darzustellen. Ich würde im Gegensatz dazu den Standpunkt verfechten, dass bei einer Berücksichtigung geeigneter Zeit-Scales und Analyseverfahren dies vollständig machbar ist, so dass mit dem gesunden Menschenverstand folgenden Arbeitshypothesen mit hinreichender Genauigkeit und Erfolgschancen eine Anleitung für die Politik formuliert werden kann.

Falls die wirklichen Ergebnisse den kurzfristigen Vorhersagen in Abschnitt 3.3 oben folgen, dann folgere ich daraus, dass die Position des Establishments nach dem Jahr 2020 nicht mehr haltbar ist. Dies ist hinsichtlich Klima unmittelbar bevorstehend. Der wesentliche Punkt dieses Beitrages lautet, dass der Spitzenwert des Jahres 2003 in Abbildung 1 einen millenialen Spitzenwert markiert, der komplett in allen IPCC-Projektionen ignoriert wird.

Link: http://wattsupwiththat.com/2016/03/24/collapse-of-the-cagw-delusion-untenable-past-2020/

Übersetzt von Chris Frey EIKE